Périphériques technologiques

Périphériques technologiques

IA

IA

À l'ère post-Sora, comment les praticiens du CV choisissent-ils leurs modèles ? Convolution ou ViT, apprentissage supervisé ou paradigme CLIP

À l'ère post-Sora, comment les praticiens du CV choisissent-ils leurs modèles ? Convolution ou ViT, apprentissage supervisé ou paradigme CLIP

À l'ère post-Sora, comment les praticiens du CV choisissent-ils leurs modèles ? Convolution ou ViT, apprentissage supervisé ou paradigme CLIP

La précision d'ImageNet était autrefois le principal indicateur d'évaluation des performances du modèle, mais dans le domaine de la vision informatique d'aujourd'hui, cet indicateur apparaît progressivement incomplet.

À mesure que les modèles de vision par ordinateur sont devenus plus complexes, la variété des modèles disponibles a considérablement augmenté, des ConvNets aux Transformateurs de Vision. Les méthodes de formation ont également évolué vers l'apprentissage auto-supervisé et la formation par paires image-texte comme CLIP, et ne se limitent plus à la formation supervisée sur ImageNet.

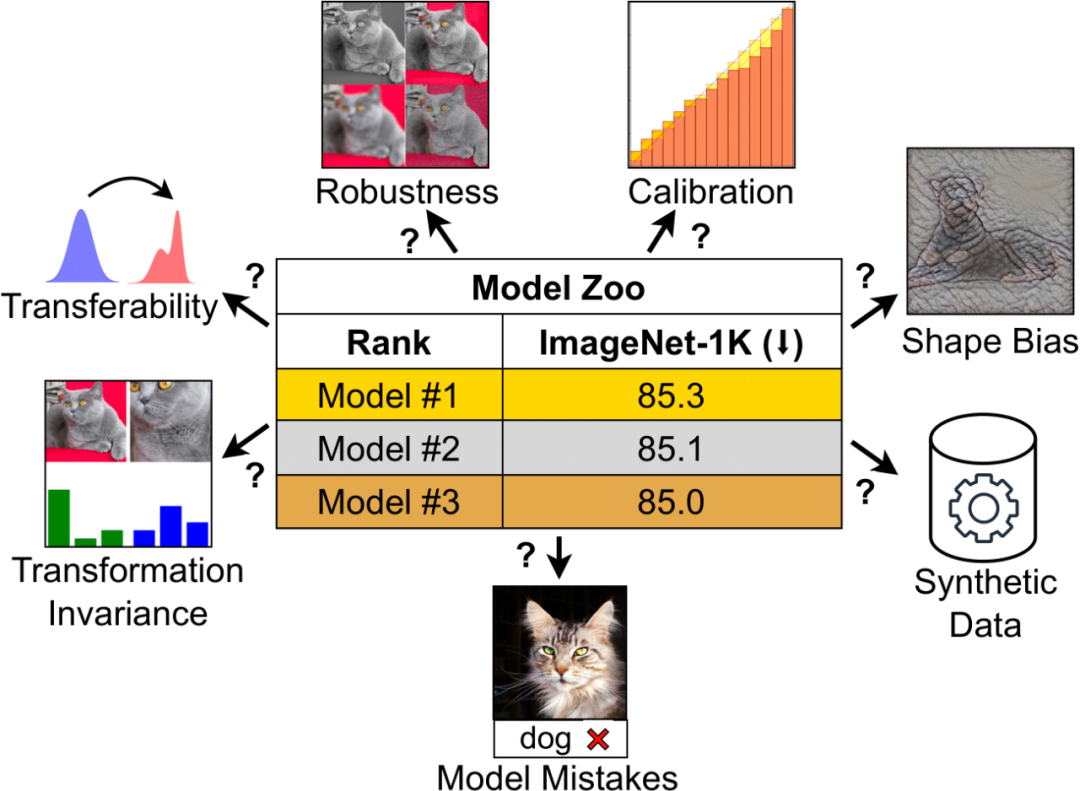

Bien que la précision d'ImageNet soit un indicateur important, elle ne suffit pas pour évaluer pleinement les performances du modèle. Différentes architectures, méthodes de formation et ensembles de données peuvent entraîner des performances différentes des modèles sur différentes tâches. Par conséquent, se fier uniquement à ImageNet pour juger les modèles peut présenter des limites. Lorsqu'un modèle surajuste l'ensemble de données ImageNet et atteint une saturation en termes de précision, la capacité de généralisation du modèle sur d'autres tâches peut être négligée. Par conséquent, plusieurs facteurs doivent être pris en compte pour évaluer les performances et l’applicabilité du modèle.

Bien que la précision ImageNet de CLIP soit similaire à celle de ResNet, son encodeur visuel est plus robuste et transférable. Cela a incité les chercheurs à explorer les avantages uniques de CLIP qui n'étaient pas évidents en considérant uniquement les métriques ImageNet. Cela souligne l’importance d’analyser d’autres propriétés pour aider à découvrir des modèles utiles.

En outre, les benchmarks traditionnels ne peuvent pas évaluer pleinement la capacité d'un modèle à gérer les défis visuels du monde réel, tels que les différents angles de caméra, les conditions d'éclairage ou les occlusions. Les modèles formés sur des ensembles de données tels qu'ImageNet ont souvent du mal à exploiter leurs performances dans des applications pratiques, car les conditions et les scénarios du monde réel sont plus diversifiés.

Ces questions ont apporté une nouvelle confusion aux praticiens du domaine : Comment mesurer un modèle visuel ? Et comment choisir un modèle visuel adapté à vos besoins ?

Dans un article récent, des chercheurs de MBZUAI et Meta ont mené une discussion approfondie sur cette question.

- Titre de l'article : ConvNet vs Transformer, Supervised vs CLIP : Au-delà de la précision d'ImageNet

- Lien de l'article : https://arxiv.org/pdf/2311.09215 pdf.

La recherche se concentre sur le comportement des modèles au-delà de la précision d'ImageNet, en analysant les performances des principaux modèles dans le domaine de la vision par ordinateur, notamment ConvNeXt et Vision Transformer (ViT), qui fonctionnent tous deux sous les paradigmes de formation supervisée et CLIP Performance.

Les modèles sélectionnés ont un nombre similaire de paramètres et presque la même précision sur ImageNet-1K sous chaque paradigme de formation, garantissant une comparaison équitable. Les chercheurs ont exploré en profondeur une série de caractéristiques du modèle, telles que le type d'erreur de prédiction, la capacité de généralisation, l'invariance des représentations apprises, l'étalonnage, etc., en se concentrant sur les caractéristiques du modèle sans formation supplémentaire ni réglage fin, dans l'espoir de directement fournir des références. par des praticiens utilisant des modèles pré-entraînés.

Dans l'analyse, les chercheurs ont découvert qu'il existe de grandes différences dans le comportement des modèles entre les différentes architectures et paradigmes de formation. Par exemple, les modèles formés sous le paradigme CLIP ont produit moins d'erreurs de classification que ceux formés sur ImageNet. Cependant, le modèle supervisé est mieux calibré et surpasse généralement le benchmark de robustesse ImageNet. ConvNeXt présente des avantages sur les données synthétiques, mais est plus orienté texture que ViT. Pendant ce temps, ConvNeXt supervisé fonctionne bien sur de nombreux benchmarks, avec des performances de transférabilité comparables à celles du modèle CLIP.

On peut constater que différents modèles démontrent leurs avantages de manière unique, et ces avantages ne peuvent pas être capturés par un seul indicateur. Les chercheurs soulignent que des mesures d'évaluation plus détaillées sont nécessaires pour sélectionner avec précision les modèles dans des contextes spécifiques et pour créer de nouveaux points de référence indépendants d'ImageNet.

Sur la base de ces observations, Yann LeCun, scientifique en chef de Meta AI, a retweeté l'étude et l'a aimée :

Sélection du modèle

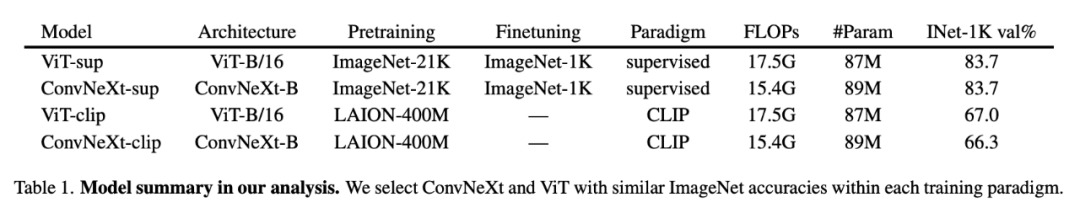

Pour le modèle supervisé, les chercheurs ont utilisé le DeiT3-Base/16 pré-entraîné de ViT, qui a la même architecture que ViT-Base/16, mais la méthode d'entraînement a en outre été améliorée, ConvNeXt ; -La base a été utilisée. Pour le modèle CLIP, les chercheurs ont utilisé les encodeurs visuels de ViT-Base/16 et ConvNeXt-Base dans OpenCLIP.

Veuillez noter que les performances de ces modèles sont légèrement différentes de celles du modèle OpenAI d'origine. Tous les points de contrôle du modèle peuvent être trouvés sur la page d'accueil du projet GitHub. La comparaison détaillée des modèles est présentée dans le tableau 1 :

Pour le processus de sélection du modèle, le chercheur a donné une explication détaillée :

1 Étant donné que le chercheur utilise un modèle pré-entraîné, il ne peut pas contrôler le modèle. période de formation. La quantité et la qualité des échantillons de données consultés.

2. Pour analyser les ConvNets et les Transformers, de nombreuses études antérieures ont comparé ResNet et ViT. Cette comparaison n'est généralement pas propice à ConvNet, car ViT est généralement formé avec des recettes plus avancées et atteint une plus grande précision ImageNet. ViT comporte également certains éléments de conception architecturale, tels que LayerNorm, qui n'étaient pas intégrés à ResNet lors de son invention il y a de nombreuses années. Par conséquent, pour une évaluation plus équilibrée, nous avons comparé ViT avec ConvNeXt, un représentant moderne de ConvNet qui fonctionne à égalité avec Transformers et partage de nombreuses conceptions.

3. En termes de mode entraînement, les chercheurs ont comparé le mode supervisé et le mode CLIP. Les modèles supervisés ont maintenu des performances de pointe en matière de vision par ordinateur. Les modèles CLIP, en revanche, fonctionnent bien en termes de généralisation et de transférabilité et fournissent des propriétés permettant de connecter les représentations visuelles et linguistiques.

4. Étant donné que le modèle auto-supervisé a montré un comportement similaire à celui du modèle supervisé lors des tests préliminaires, il n'a pas été inclus dans les résultats. Cela peut être dû au fait qu’ils ont fini par être supervisés et peaufinés sur ImageNet-1K, ce qui affecte l’étude de nombreuses fonctionnalités.

Ensuite, examinons comment les chercheurs ont analysé différents attributs.

Analyse

Erreur de modèle

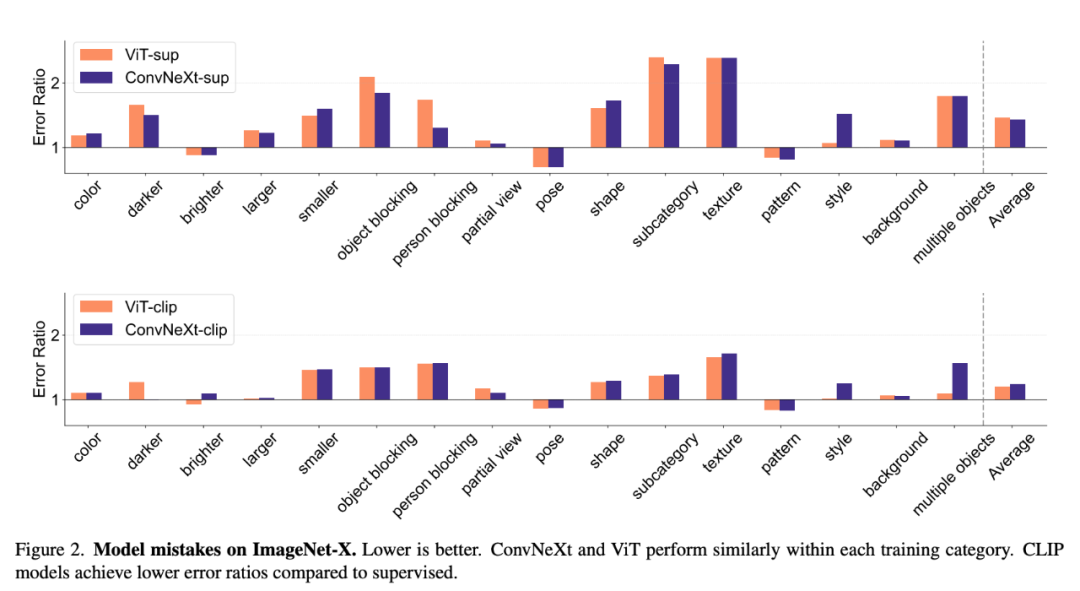

ImageNet-X est un ensemble de données qui étend ImageNet-1K et contient des annotations humaines détaillées de 16 facteurs changeants pour classer les images Effectuer une analyse approfondie des erreurs de modèle dans . Il utilise une mesure du taux d'erreur (le plus faible est le mieux) pour quantifier les performances d'un modèle sur des facteurs spécifiques par rapport à la précision globale, permettant une analyse nuancée des erreurs du modèle. Les résultats sur ImageNet-X montrent :

1. Par rapport aux modèles supervisés, les modèles CLIP font moins d'erreurs dans la précision d'ImageNet.

2. Tous les modèles sont principalement affectés par des facteurs complexes tels que l'occlusion.

3. La texture est le facteur le plus difficile de tous les modèles.

Biais de forme/texture

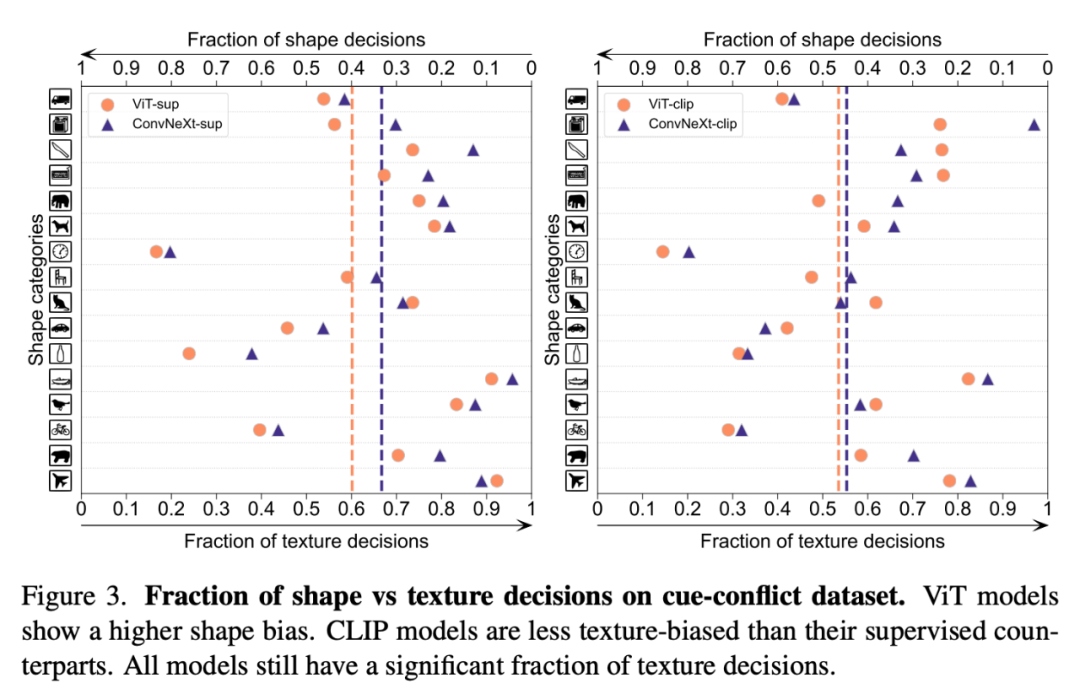

Le biais de forme-texture détecte si un modèle s'appuie sur des raccourcis de texture fragiles au lieu d'indices de forme de haut niveau. Ce biais peut être étudié en combinant des images contradictoires de différentes catégories de forme et de texture. Cette approche permet de comprendre dans quelle mesure les décisions d'un modèle sont basées sur la forme par rapport à la texture. Les chercheurs ont évalué le biais de forme-texture sur l'ensemble de données de conflit de signaux et ont constaté que le biais de texture du modèle CLIP était inférieur à celui du modèle supervisé, tandis que le biais de forme du modèle ViT était supérieur à celui des ConvNets.

Calibrage du modèle

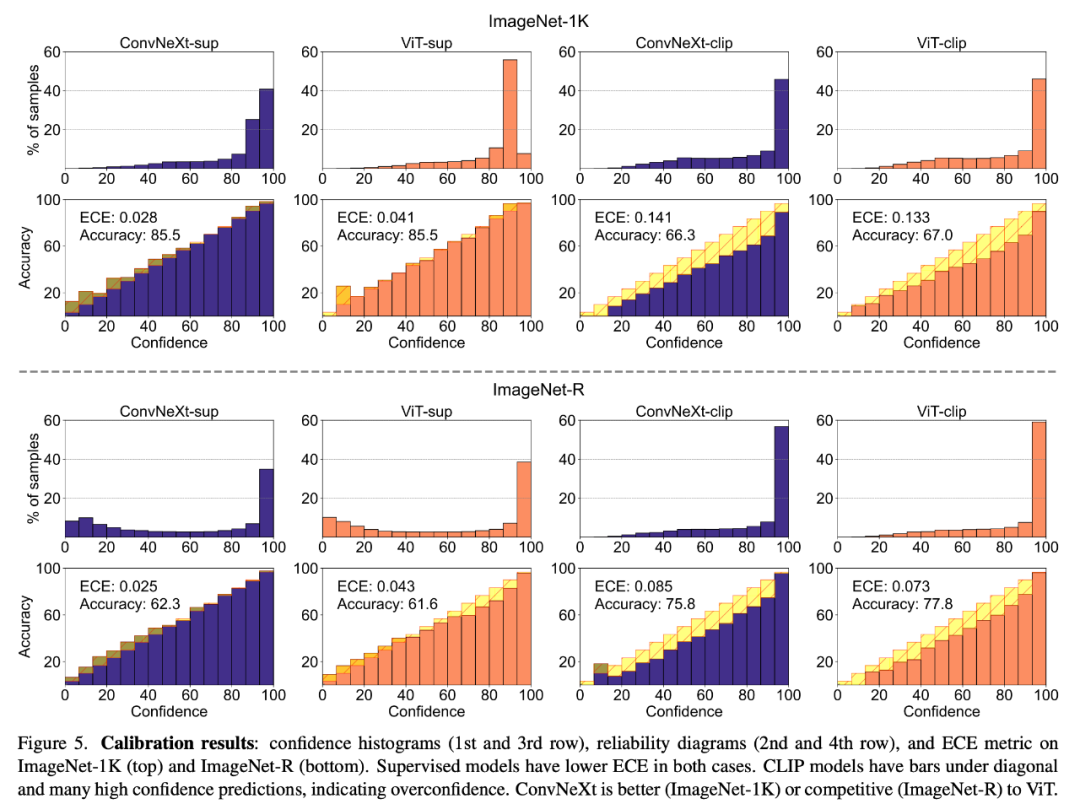

Le calibrage peut quantifier si la confiance de prédiction du modèle est cohérente avec sa précision réelle, qui peut être mesurée au moyen d'indicateurs tels que l'erreur d'étalonnage attendue (ECE), ainsi que tracés de fiabilité et histogrammes de confiance. Outils visuels pour l’évaluation. L'étalonnage a été évalué sur ImageNet-1K et ImageNet-R, classant les prédictions en 15 niveaux. Au cours de l'expérience, les chercheurs ont observé les points suivants :

1. Le modèle CLIP est trop confiant, tandis que le modèle supervisé est légèrement sous-confiant.

2. Supervised ConvNeXt effectue un meilleur étalonnage que Supervised ViT.

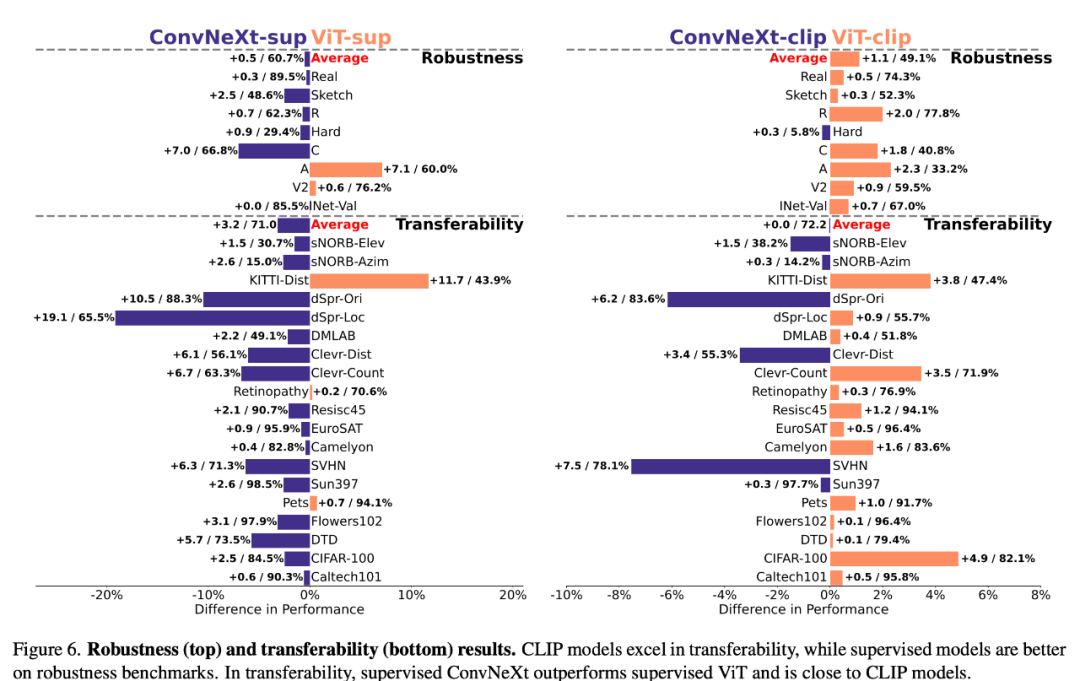

Robustesse et transférabilité

La robustesse et la transférabilité des modèles sont cruciales pour s'adapter aux changements dans la distribution des données et aux nouvelles tâches. Les chercheurs ont évalué la robustesse à l'aide de diverses variantes d'ImageNet et ont constaté que même si les performances moyennes des modèles ViT et ConvNeXt étaient comparables, à l'exception d'ImageNet-R et ImageNet-Sketch, les modèles supervisés surpassaient généralement CLIP en termes de robustesse. En termes de transférabilité, ConvNeXt supervisé surpasse ViT et est presque à égalité avec les performances du modèle CLIP, telles qu'évaluées sur le benchmark VTAB à l'aide de 19 ensembles de données.

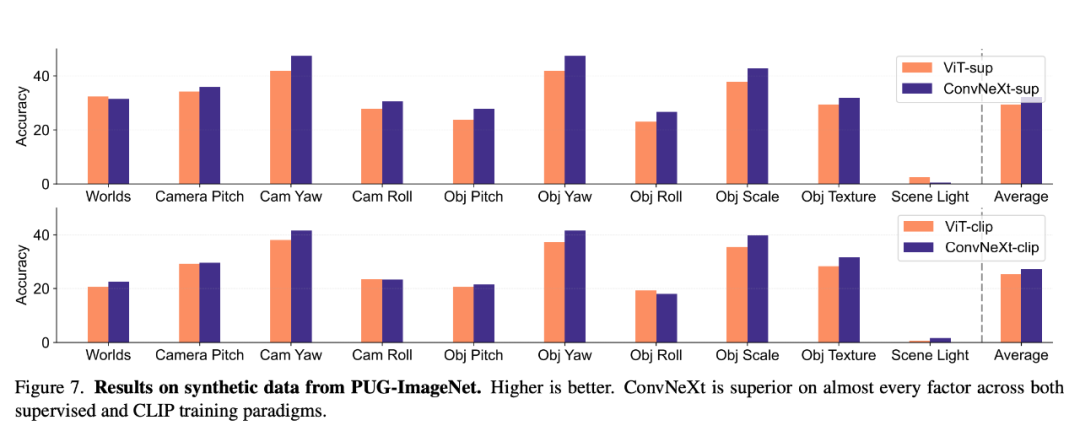

Données synthétiques

PUG-ImageNet et d'autres ensembles de données synthétiques peuvent contrôler avec précision des facteurs tels que l'angle et la texture de la caméra. Il s'agit d'une voie de recherche prometteuse, les chercheurs ont donc analysé l'utilisation du modèle en synthèse. Performances sur les données. PUG-ImageNet contient des images ImageNet photoréalistes avec une variation systématique de facteurs tels que la pose et l'éclairage, et les performances sont mesurées avec une précision absolue de premier ordre. Les chercheurs fournissent des résultats sur différents facteurs dans PUG-ImageNet et constatent que ConvNeXt surpasse ViT dans presque tous les facteurs. Cela montre que ConvNeXt surpasse ViT sur les données synthétiques, tandis que l'écart pour le modèle CLIP est plus petit car la précision du modèle CLIP est inférieure à celle du modèle supervisé, ce qui peut être lié à la précision moindre de l'ImageNet d'origine. L'invariance de transformation fait référence à la capacité du modèle à produire des représentations cohérentes qui ne sont pas affectées par les transformations d'entrée telles que la mise à l'échelle ou le mouvement, conservant ainsi la sémantique. Cette propriété permet au modèle de bien se généraliser sur des entrées différentes mais sémantiquement similaires. Les méthodes utilisées incluent le redimensionnement des images pour l'invariance d'échelle, le déplacement des cultures pour l'invariance de position et l'ajustement de la résolution des modèles ViT à l'aide d'intégrations positionnelles interpolées.

Ils ont évalué l'invariance de l'échelle, du mouvement et de la résolution sur ImageNet-1K en faisant varier l'échelle/la position du recadrage et la résolution de l'image. ConvNeXt surpasse ViT en matière de formation supervisée. Globalement, le modèle est plus robuste aux transformations d’échelle/résolution qu’aux mouvements. Pour les applications qui nécessitent une grande robustesse en matière de mise à l’échelle, de déplacement et de résolution, les résultats suggèrent que ConvNeXt supervisé peut être le meilleur choix.

Ils ont évalué l'invariance de l'échelle, du mouvement et de la résolution sur ImageNet-1K en faisant varier l'échelle/la position du recadrage et la résolution de l'image. ConvNeXt surpasse ViT en matière de formation supervisée. Globalement, le modèle est plus robuste aux transformations d’échelle/résolution qu’aux mouvements. Pour les applications qui nécessitent une grande robustesse en matière de mise à l’échelle, de déplacement et de résolution, les résultats suggèrent que ConvNeXt supervisé peut être le meilleur choix.

Résumé

Dans l'ensemble, chaque modèle a ses propres avantages uniques. Cela suggère que le choix du modèle devrait dépendre du cas d’utilisation cible, car les mesures de performances standard peuvent ignorer les nuances critiques d’une tâche spécifique. De plus, de nombreux benchmarks existants sont dérivés d'ImageNet, ce qui biaise également l'évaluation. Le développement de nouveaux benchmarks avec différentes distributions de données est crucial pour évaluer les modèles dans un environnement plus représentatif du monde réel.

Ce qui suit est un résumé des conclusions de cet article :

ConvNet avec Transformer

1. Supervised ConvNeXt surpasse le ViT supervisé sur de nombreux benchmarks : il est mieux calibré, il est plus invariant à. transformations de données et présente une meilleure portabilité et robustesse.

2. ConvNeXt fonctionne mieux que ViT sur les données synthétiques.

3. ViT a un écart de forme plus important.

Supervision vs CLIP

1 Bien que le modèle CLIP soit supérieur en termes de transférabilité, ConvNeXt supervisé est performant dans cette tâche. Cela démontre le potentiel des modèles supervisés.

2. Les modèles supervisés fonctionnent mieux sur les tests de robustesse, probablement parce que ces modèles sont tous des variantes d'ImageNet.

3. Le modèle CLIP présente un plus grand biais de forme et moins d'erreurs de classification par rapport à la précision d'ImageNet.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Écrit précédemment, nous discutons aujourd'hui de la manière dont la technologie d'apprentissage profond peut améliorer les performances du SLAM (localisation et cartographie simultanées) basé sur la vision dans des environnements complexes. En combinant des méthodes d'extraction de caractéristiques approfondies et de correspondance de profondeur, nous introduisons ici un système SLAM visuel hybride polyvalent conçu pour améliorer l'adaptation dans des scénarios difficiles tels que des conditions de faible luminosité, un éclairage dynamique, des zones faiblement texturées et une gigue importante. Notre système prend en charge plusieurs modes, notamment les configurations étendues monoculaire, stéréo, monoculaire-inertielle et stéréo-inertielle. En outre, il analyse également comment combiner le SLAM visuel avec des méthodes d’apprentissage profond pour inspirer d’autres recherches. Grâce à des expériences approfondies sur des ensembles de données publiques et des données auto-échantillonnées, nous démontrons la supériorité du SL-SLAM en termes de précision de positionnement et de robustesse du suivi.

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.