Périphériques technologiques

Périphériques technologiques

IA

IA

Le modèle RNN défie l'hégémonie des Transformers ! 1 % de coût et des performances comparables à celles du Mistral-7B, prenant en charge plus de 100 langues, le plus grand nombre au monde

Le modèle RNN défie l'hégémonie des Transformers ! 1 % de coût et des performances comparables à celles du Mistral-7B, prenant en charge plus de 100 langues, le plus grand nombre au monde

Le modèle RNN défie l'hégémonie des Transformers ! 1 % de coût et des performances comparables à celles du Mistral-7B, prenant en charge plus de 100 langues, le plus grand nombre au monde

Alors que de grands modèles sont déployés, le statut de Transformer est également remis en question les uns après les autres.

Récemment, RWKV a publié le modèle Eagle 7B, basé sur la dernière architecture RWKV-v5.

Eagle 7B excelle dans les benchmarks multilingues et est à égalité avec les meilleurs modèles dans les tests d'anglais.

Dans le même temps, Eagle 7B utilise une architecture RNN Par rapport au modèle Transformer de même taille, le coût d'inférence est réduit de plus de 10 à 100 fois. On peut dire qu'il s'agit du 7B le plus respectueux de l'environnement. modèle au monde.

Étant donné que l'article sur RWKV-v5 ne sera peut-être pas publié avant le mois prochain, nous fournissons d'abord l'article sur RWKV, qui est la première architecture non Transformer à adapter les paramètres à des dizaines de milliards.

Photos

Photos

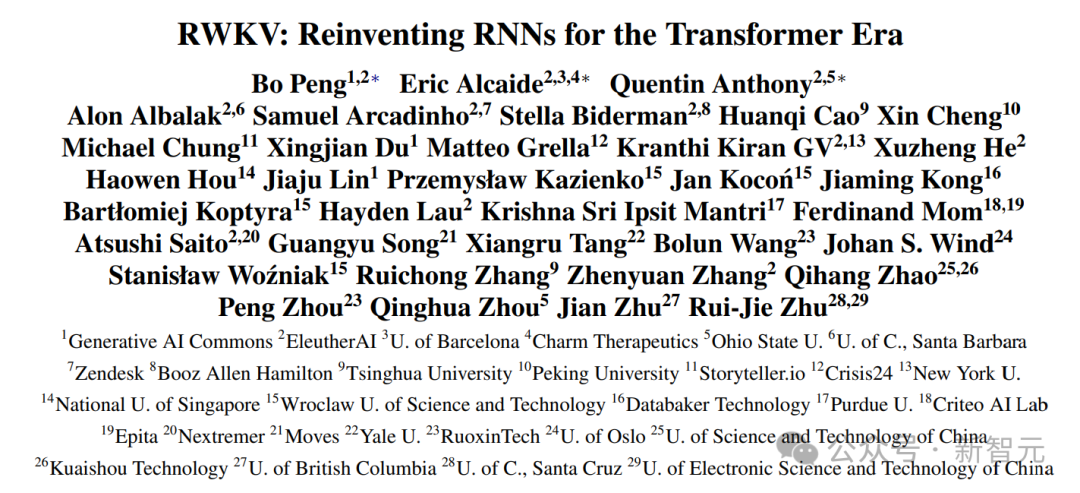

Adresse papier : https://arxiv.org/pdf/2305.13048.pdf

EMNLP 2023 a accepté ce travail. Les auteurs viennent des meilleures universités, instituts de recherche et technologies du monde entier. entreprise mondiale.

Ce qui suit est la photo officielle d'Eagle 7B, qui montre que cet aigle survole Transformers.

Photos

Photos

Eagle 7B

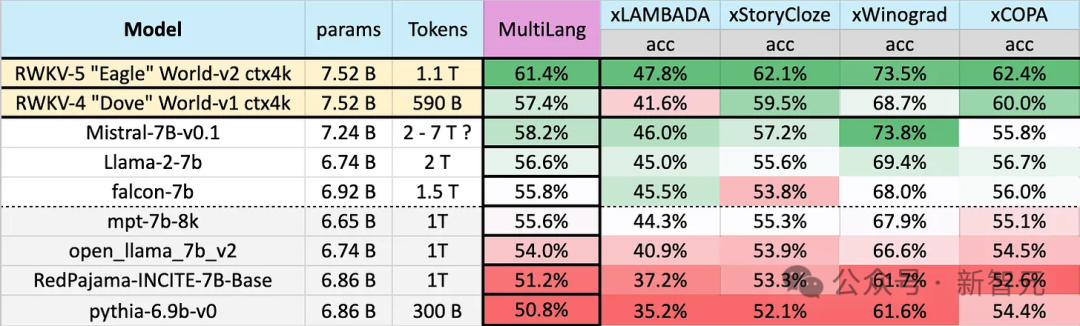

Eagle 7B utilise des données d'entraînement de 1,1T (billion) de jetons provenant de plus de 100 langues dans le test de référence multilingue ci-dessous, Eagle 7B se classe en moyenne en premier.

Les benchmarks incluent xLAMBDA, xStoryCloze, xWinograd et xCopa, couvrant 23 langues, ainsi que le raisonnement de bon sens dans leurs langues respectives.

Eagle 7B a remporté la première place dans trois d'entre eux. Bien que l'un d'entre eux n'ait pas battu Mistral-7B et se soit classé deuxième, les données d'entraînement utilisées par l'adversaire étaient bien supérieures à celles d'Eagle.

Photos

Photos

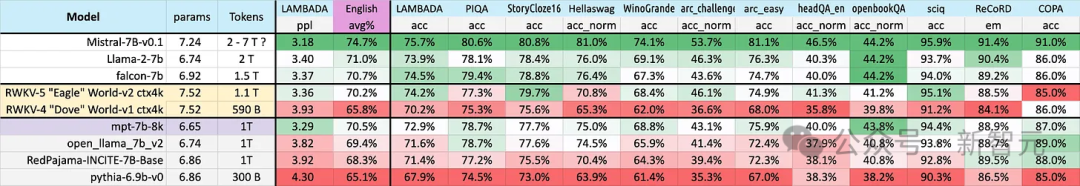

Le test d'anglais illustré ci-dessous contient 12 points de repère distincts, un raisonnement de bon sens et une connaissance du monde.

Dans le test de performance en anglais, le niveau d'Eagle 7B est proche de Falcon (1,5T), LLaMA2 (2T), Mistral (>2T) et est comparable à MPT-7B, qui utilise également environ 1T d'entraînement. données.

Photos

Photos

Et, dans les deux tests, la nouvelle architecture v5 a fait un énorme bond en avant par rapport à la précédente v4.

Eagle 7B est actuellement hébergé par la Linux Foundation et est sous licence Apache 2.0 pour une utilisation personnelle ou commerciale sans restriction.

Support multilingue

Comme mentionné précédemment, les données de formation d'Eagle 7B proviennent de plus de 100 langues, tandis que les 4 benchmarks multilingues utilisés ci-dessus n'incluent que 23 langues.

Photos

Photos

Bien qu'il ait obtenu la première place, en général, Eagle 7B a subi une perte. Après tout, le test de référence ne peut pas évaluer directement les performances du modèle dans plus de 70 autres langues.

Le coût supplémentaire de la formation ne vous aidera pas à améliorer votre classement. Si vous vous concentrez sur l'anglais, vous obtiendrez peut-être de meilleurs résultats qu'aujourd'hui.

——Alors, pourquoi RWKV fait-il ça ? Le responsable a déclaré :

Construire une IA inclusive pour tout le monde dans ce monde —— pas seulement pour les Anglais

Parmi les nombreux retours sur le modèle RWKV, le plus courant est :

L'approche multilingue nuit Le score d'évaluation en anglais du modèle a ralenti le développement du Transformer linéaire

Il est injuste de comparer les performances multilingues avec un modèle anglais pur

Déclaré officiellement : "Dans la plupart des cas, nous sommes d'accord avec ces avis,"

"Mais nous n'avons pas l'intention de changer cela, car nous construisons l'IA pour le monde - et ce n'est pas seulement un monde anglophone." L'anglais est parlé dans la population mondiale (environ 1,3 milliard de personnes), mais en prenant en charge les 25 principales langues du monde, le modèle peut atteindre environ 4 milliards de personnes, soit 50 % de la population mondiale.

L'équipe espère que l'intelligence artificielle du futur pourra aider tout le monde, par exemple en permettant aux modèles de fonctionner sur du matériel bas de gamme à bas prix, par exemple en prenant en charge davantage de langues.

L'équipe espère que l'intelligence artificielle du futur pourra aider tout le monde, par exemple en permettant aux modèles de fonctionner sur du matériel bas de gamme à bas prix, par exemple en prenant en charge davantage de langues.

L'équipe étendra progressivement l'ensemble de données multilingues pour prendre en charge un plus large éventail de langues et étendra progressivement la couverture à 100 % des régions du monde, en veillant à ce qu'aucune langue ne soit oubliée.

Ensemble de données + architecture évolutive

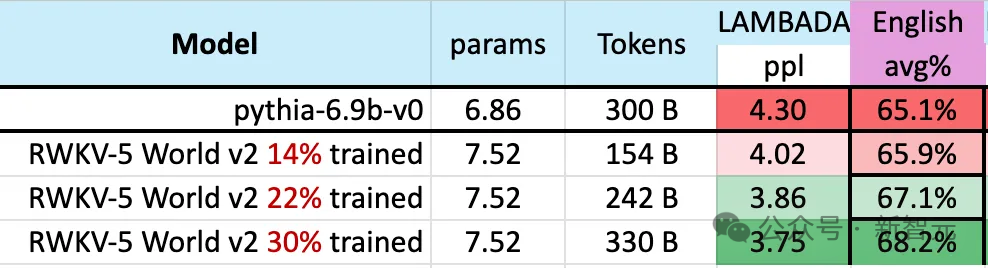

Pendant le processus de formation du modèle, il convient de noter un phénomène :

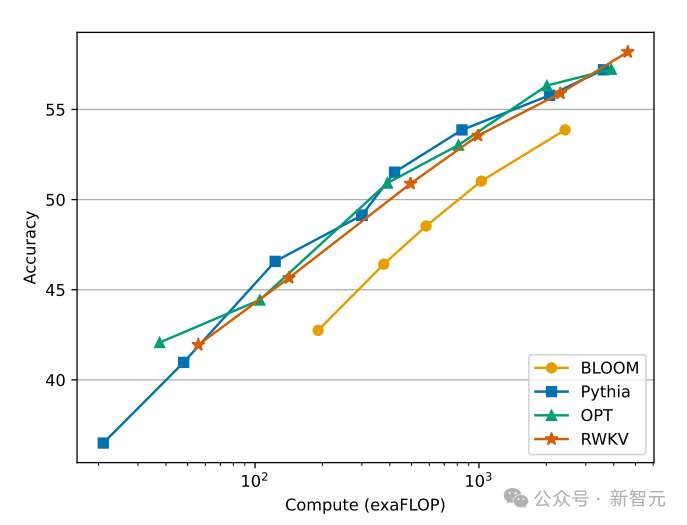

À mesure que l'échelle des données de formation continue d'augmenter, les performances du modèle s'améliorent progressivement. Lorsque les données d'entraînement atteignent environ 300 B, le modèle affiche des performances similaires à celles de python-6.9b, qui a une taille de données d'entraînement de 300 B.

Picture

Ce phénomène est le même qu'une expérience précédemment menée sur l'architecture RWKV-v4 - c'est-à-dire que lorsque la taille des données d'entraînement est la même, les performances d'un transformateur linéaire comme RWKV Ce sera similaire à Transformateur.

Nous ne pouvons donc pas nous empêcher de nous demander : si tel est effectivement le cas, les données sont-elles plus importantes pour l'amélioration des performances du modèle que l'architecture exacte ?

Nous ne pouvons donc pas nous empêcher de nous demander : si tel est effectivement le cas, les données sont-elles plus importantes pour l'amélioration des performances du modèle que l'architecture exacte ?

Photo

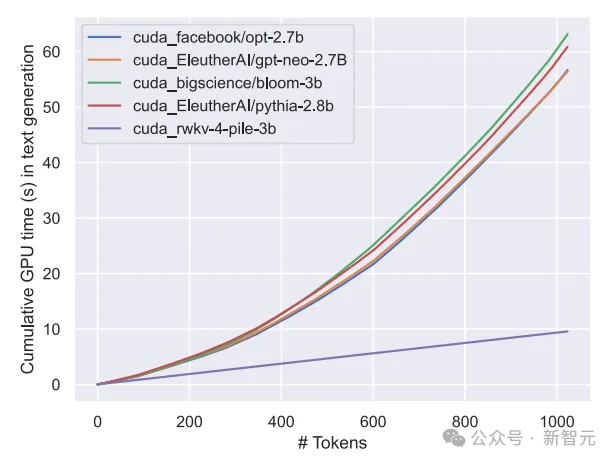

Nous savons que le coût de calcul et de stockage du modèle de classe Transformer est de niveau carré, alors que dans la figure ci-dessus, le coût de calcul de l'architecture RWKV n'augmente que linéairement avec le nombre de Tokens.

Peut-être devrions-nous nous tourner vers des architectures plus efficaces et évolutives pour accroître l'accessibilité, réduire le coût de l'IA pour tous et réduire l'impact environnemental.

Peut-être devrions-nous nous tourner vers des architectures plus efficaces et évolutives pour accroître l'accessibilité, réduire le coût de l'IA pour tous et réduire l'impact environnemental.

RWKV

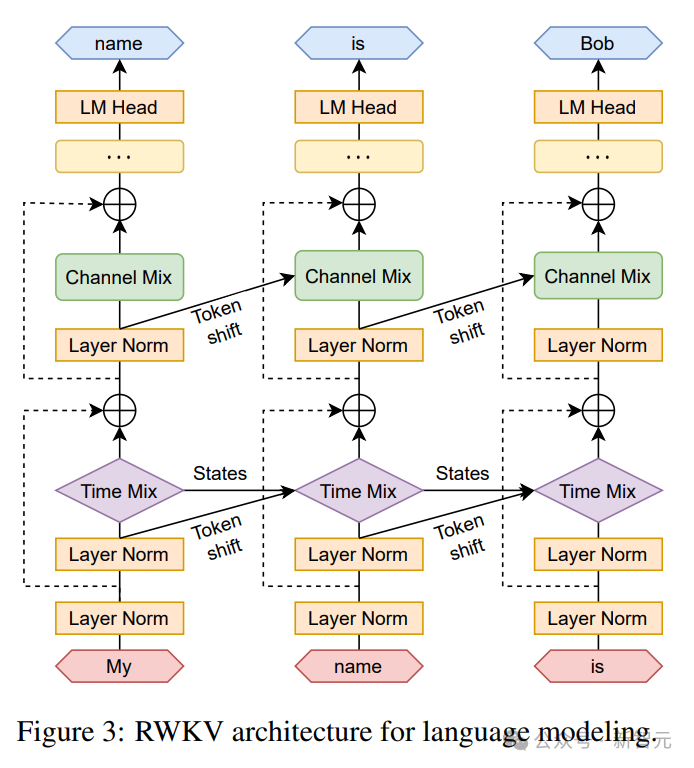

L'architecture RWKV est un RNN avec des performances LLM de niveau GPT, tout en pouvant être formé en parallèle comme Transformer.

RWKV combine les avantages de RNN et Transformer - excellentes performances, inférence rapide, formation rapide, sauvegarde de la VRAM, longueur de contexte "illimitée" et intégration de phrases gratuite. RWKV n'utilise pas le mécanisme d'attention.

La figure suivante montre la comparaison des coûts de calcul entre les modèles RWKV et Transformer :

Photos

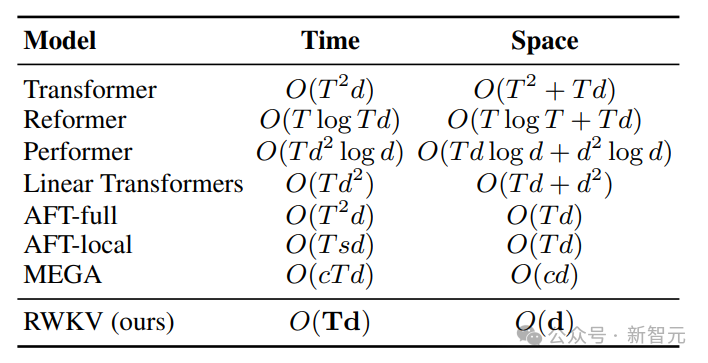

Afin de résoudre les problèmes de complexité temporelle et spatiale de Transformer, les chercheurs ont proposé diverses architectures :

Picture

Picture

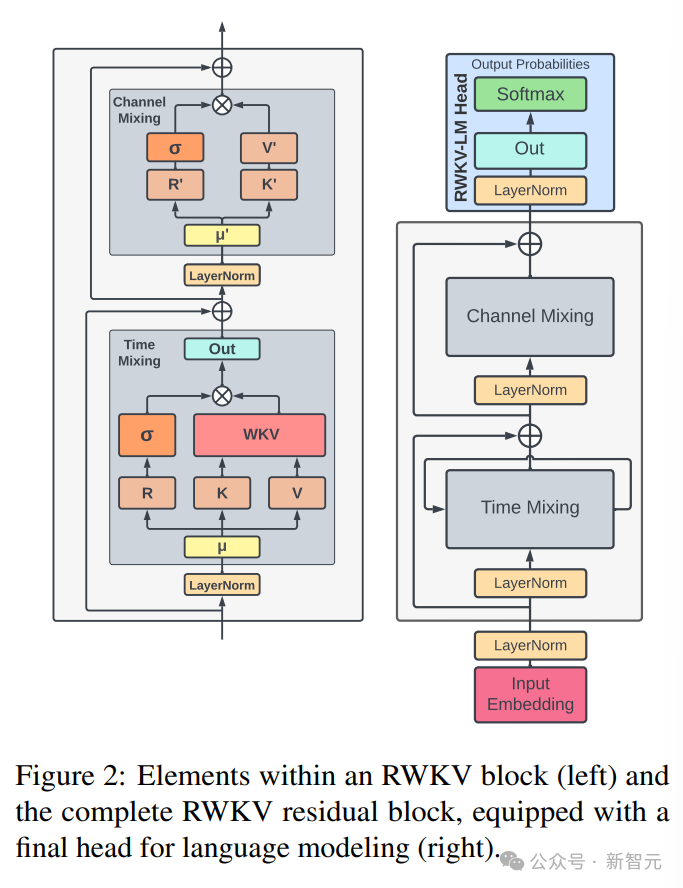

L'architecture RWKV se compose d'une série de blocs résiduels empilés. Chaque bloc résiduel se compose d'un sous-bloc de mélange temporel et d'un sous-bloc de mélange de canaux avec une structure en boucle

Le côté gauche du L'image ci-dessous représente les éléments du bloc RWKV, avec le bloc résiduel RWKV à droite et l'en-tête final pour la modélisation du langage.

Le côté gauche du L'image ci-dessous représente les éléments du bloc RWKV, avec le bloc résiduel RWKV à droite et l'en-tête final pour la modélisation du langage.

Picture

La récursion peut être exprimée comme une interpolation linéaire entre l'entrée actuelle et l'entrée du pas de temps précédent (comme le montre la ligne diagonale dans la figure ci-dessous), qui peut être indépendante pour chaque linéaire projection de l'intégration d'entrée Ajustement.

Un vecteur qui gère le jeton actuel séparément est également introduit ici pour compenser la dégradation potentielle.

Un vecteur qui gère le jeton actuel séparément est également introduit ici pour compenser la dégradation potentielle.

Images

Images

RWKV peut être efficacement parallélisé (multiplication matricielle) dans ce que nous appelons le mode de parallélisme temporel.

Dans un réseau récurrent, la sortie du moment précédent est généralement utilisée comme entrée du moment actuel. Cela est particulièrement évident dans l'inférence de décodage autorégressif pour les modèles de langage, qui nécessite que chaque jeton soit calculé avant de saisir l'étape suivante, permettant à RWKV de tirer parti de sa structure de type RNN, appelée mode temporel.

Dans ce cas, RWKV peut être facilement formulé de manière récursive pour le décodage lors de l'inférence. Il tire parti de chaque jeton de sortie en s'appuyant uniquement sur le dernier état. La taille de l'état est constante, contrairement à la longueur de la séquence.

agit ensuite comme un décodeur RNN, produisant une vitesse et une empreinte mémoire constantes par rapport à la longueur de la séquence, permettant de traiter plus efficacement des séquences plus longues.

En revanche, le cache KV de l'auto-attention augmente continuellement par rapport à la longueur de la séquence, ce qui entraîne une diminution de l'efficacité et une augmentation de l'empreinte mémoire et du temps à mesure que la séquence s'allonge.

Référence :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Comment affiner la profondeur localement

Feb 19, 2025 pm 05:21 PM

Comment affiner la profondeur localement

Feb 19, 2025 pm 05:21 PM

Le réglage fin local des modèles de classe Deepseek est confronté au défi des ressources informatiques insuffisantes et de l'expertise. Pour relever ces défis, les stratégies suivantes peuvent être adoptées: quantification du modèle: convertir les paramètres du modèle en entiers à faible précision, réduisant l'empreinte de la mémoire. Utilisez des modèles plus petits: sélectionnez un modèle pré-entraîné avec des paramètres plus petits pour un réglage fin local plus facile. Sélection des données et prétraitement: sélectionnez des données de haute qualité et effectuez un prétraitement approprié pour éviter une mauvaise qualité des données affectant l'efficacité du modèle. Formation par lots: pour les grands ensembles de données, chargez les données en lots de formation pour éviter le débordement de la mémoire. Accélération avec GPU: Utilisez des cartes graphiques indépendantes pour accélérer le processus de formation et raccourcir le temps de formation.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

Pour seulement 250$, le directeur technique de Hugging Face vous apprend étape par étape comment peaufiner Llama 3

May 06, 2024 pm 03:52 PM

Pour seulement 250$, le directeur technique de Hugging Face vous apprend étape par étape comment peaufiner Llama 3

May 06, 2024 pm 03:52 PM

Les grands modèles de langage open source familiers tels que Llama3 lancé par Meta, les modèles Mistral et Mixtral lancés par MistralAI et Jamba lancé par AI21 Lab sont devenus des concurrents d'OpenAI. Dans la plupart des cas, les utilisateurs doivent affiner ces modèles open source en fonction de leurs propres données pour libérer pleinement le potentiel du modèle. Il n'est pas difficile d'affiner un grand modèle de langage (comme Mistral) par rapport à un petit en utilisant Q-Learning sur un seul GPU, mais le réglage efficace d'un grand modèle comme Llama370b ou Mixtral est resté un défi jusqu'à présent. . C'est pourquoi Philipp Sch, directeur technique de HuggingFace

Que faire si le navigateur Edge prend trop de mémoire Que faire si le navigateur Edge prend trop de mémoire

May 09, 2024 am 11:10 AM

Que faire si le navigateur Edge prend trop de mémoire Que faire si le navigateur Edge prend trop de mémoire

May 09, 2024 am 11:10 AM

1. Tout d’abord, entrez dans le navigateur Edge et cliquez sur les trois points dans le coin supérieur droit. 2. Ensuite, sélectionnez [Extensions] dans la barre des tâches. 3. Ensuite, fermez ou désinstallez les plug-ins dont vous n'avez pas besoin.

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Afin d'aligner les grands modèles de langage (LLM) sur les valeurs et les intentions humaines, il est essentiel d'apprendre les commentaires humains pour garantir qu'ils sont utiles, honnêtes et inoffensifs. En termes d'alignement du LLM, une méthode efficace est l'apprentissage par renforcement basé sur le retour humain (RLHF). Bien que les résultats de la méthode RLHF soient excellents, certains défis d’optimisation sont impliqués. Cela implique de former un modèle de récompense, puis d'optimiser un modèle politique pour maximiser cette récompense. Récemment, certains chercheurs ont exploré des algorithmes hors ligne plus simples, dont l’optimisation directe des préférences (DPO). DPO apprend le modèle politique directement sur la base des données de préférence en paramétrant la fonction de récompense dans RLHF, éliminant ainsi le besoin d'un modèle de récompense explicite. Cette méthode est simple et stable

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.