Périphériques technologiques

Périphériques technologiques

IA

IA

L'Université Tsinghua et Ideal ont proposé DriveVLM, un grand modèle de langage visuel pour améliorer les capacités de conduite autonome

L'Université Tsinghua et Ideal ont proposé DriveVLM, un grand modèle de langage visuel pour améliorer les capacités de conduite autonome

L'Université Tsinghua et Ideal ont proposé DriveVLM, un grand modèle de langage visuel pour améliorer les capacités de conduite autonome

Dans le domaine de la conduite autonome, les chercheurs explorent également l'orientation des grands modèles tels que GPT/Sora.

Par rapport à l'IA générative, la conduite autonome est également l'un des domaines de recherche et développement les plus actifs dans le domaine de l'IA récente. Un défi majeur dans la construction d'un système de conduite entièrement autonome est la compréhension de la scène par l'IA, qui implique des scénarios complexes et imprévisibles tels que des conditions météorologiques extrêmes, des tracés routiers complexes et un comportement humain imprévisible.

Le système de conduite autonome actuel se compose généralement de trois parties : la perception 3D, la prédiction de mouvement et la planification. Plus précisément, la perception 3D est principalement utilisée pour détecter et suivre des objets familiers, mais sa capacité à identifier des objets rares et leurs attributs est limitée, tandis que la prédiction et la planification de mouvements se concentrent principalement sur les actions de trajectoire des objets, mais ignorent généralement la relation entre les objets et les véhicules. . interactions au niveau décisionnel entre Ces limitations peuvent affecter la précision et la sécurité des systèmes de conduite autonome lors de la gestion de scénarios de trafic complexes. Par conséquent, la future technologie de conduite autonome doit être encore améliorée pour mieux identifier et prédire différents types d'objets, et pour planifier plus efficacement la trajectoire de conduite du véhicule afin d'améliorer l'intelligence et la fiabilité du système

La clé pour parvenir à une conduite autonome L'objectif est transformer une approche basée sur les données en une approche basée sur les connaissances, ce qui nécessite de former de grands modèles dotés de capacités de raisonnement logique. Ce n'est qu'ainsi que le système de conduite autonome pourra véritablement résoudre le problème de la longue traîne et évoluer vers les capacités L4. Actuellement, alors que des modèles à grande échelle tels que GPT4 et Sora continuent d'émerger, l'effet d'échelle a également démontré de puissantes capacités de tir à peu de tirs/zéro tir, ce qui a conduit les gens à envisager une nouvelle direction de développement.

Le dernier document de recherche provient du Tsinghua University Cross Information Institute et de Li Auto, dans lequel ils présentent un nouveau modèle appelé DriveVLM. Ce modèle s'inspire du modèle de langage visuel (VLM) émergeant dans le domaine de l'intelligence artificielle générative. DriveVLM a démontré d'excellentes capacités en matière de compréhension visuelle et de raisonnement.

Ce travail est le premier dans l'industrie à proposer un système de contrôle de la vitesse de conduite autonome. Sa méthode combine pleinement le processus de conduite autonome traditionnel avec un processus de modèle à grande échelle doté de capacités de réflexion logique, et c'est la première fois qu'un grand projet est déployé avec succès. -maquette à l'échelle d'un terminal pour tests (basé sur la plateforme Orin).

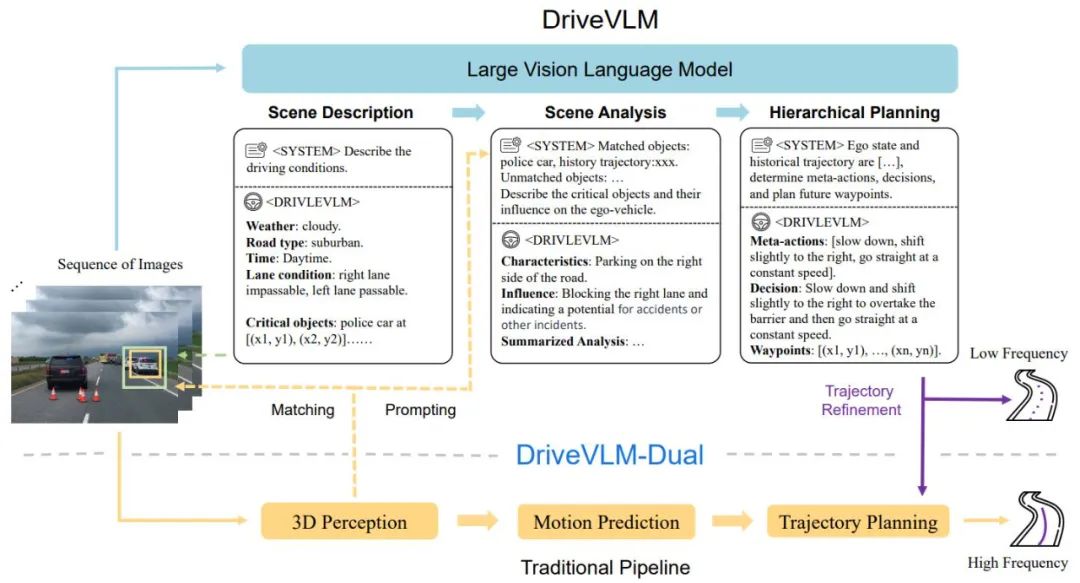

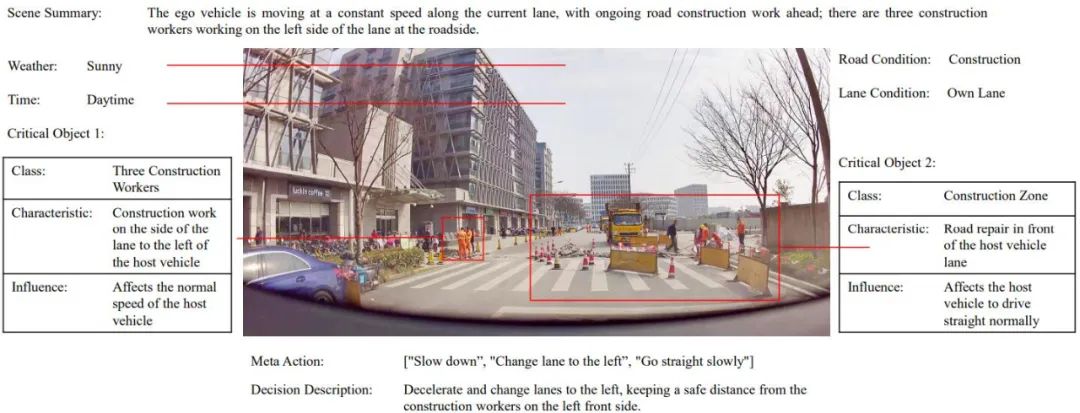

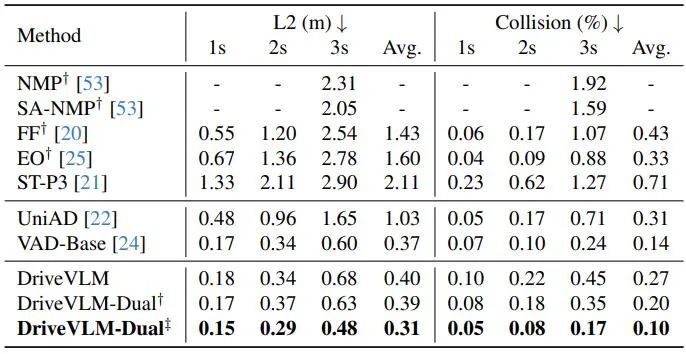

DriveVLM couvre un processus de Chain-of-Though (CoT), comprenant trois modules principaux : description du scénario, analyse du scénario et planification hiérarchique. Dans le module de description de scène, le langage est utilisé pour décrire l'environnement de conduite et identifier les objets clés de la scène ; le module d'analyse de scène étudie en profondeur les caractéristiques de ces objets clés et leur impact sur les véhicules autonomes tandis que le module de planification hiérarchique formule progressivement des plans à partir de les éléments Les actions et les décisions sont décrites par des waypoints.

Ces modules correspondent aux étapes de perception, de prédiction et de planification des systèmes de conduite autonome traditionnels, mais la différence est qu'ils gèrent la perception des objets, la prédiction au niveau de l'intention et la planification au niveau des tâches, qui ont été très difficiles dans le passé.

Bien que les VLM fonctionnent bien en compréhension visuelle, ils ont des limites en termes de base spatiale et de raisonnement, et leurs besoins en puissance de calcul posent des défis en termes de vitesse de raisonnement final. Par conséquent, les auteurs proposent en outre DriveVLMDual, un système hybride qui combine les avantages de DriveVLM et des systèmes traditionnels. DriveVLM-Dual intègre en option DriveVLM aux modules traditionnels de perception et de planification 3D tels que les détecteurs d'objets 3D, les réseaux d'occupation et les planificateurs de mouvement, permettant au système d'atteindre des capacités de mise à la terre 3D et de planification haute fréquence. Cette conception à double système est similaire aux processus de réflexion lents et rapides du cerveau humain et peut s'adapter efficacement aux différentes complexités des scénarios de conduite.

La nouvelle recherche clarifie également la définition des tâches de compréhension et de planification de scène (SUP) et propose de nouvelles mesures d'évaluation pour évaluer les capacités de DriveVLM et DriveVLM-Dual en matière d'analyse de scène et de planification de méta-actions. En outre, les auteurs ont effectué un travail approfondi d’exploration de données et d’annotation pour créer un ensemble de données SUP-AD interne pour la tâche SUP.

Des expériences approfondies sur l'ensemble de données nuScenes et nos propres ensembles de données démontrent la supériorité de DriveVLM, notamment avec un petit nombre de prises de vue. De plus, DriveVLM-Dual surpasse les méthodes de planification de mouvement de bout en bout de pointe.

Article "DriveVLM : La convergence de la conduite autonome et des modèles de langage à grande vision"

Lien article : https://arxiv.org/abs/2402.12289

Lien du projet : https://tsinghua-mars- lab.github.io/DriveVLM/

Le processus global de DriveVLM est illustré dans la figure 1 :

Encoder des images visuelles à cadre continu, interagir avec LMM via le module d'alignement des fonctionnalités

Démarrer à partir de la description de la scène Guider le ; en pensant au modèle VLM, en guidant d'abord les scènes statiques telles que le temps, la scène, l'environnement de la voie, etc., puis en guidant les principaux obstacles qui affectent les décisions de conduite

-

Analysez les principaux obstacles et faites-les correspondre grâce à la détection 3D traditionnelle et les obstacles compris par VLM, confirment davantage l'efficacité des obstacles et éliminent les illusions, décrivent les caractéristiques des obstacles clés de cette scène et leur impact sur notre conduite

; Donne des "méta-décisions" clés, telles que ralentir, se garer, tourner à gauche et à droite, etc., puis donne une description de la stratégie de conduite basée sur les méta-décisions, et enfin donne la future trajectoire de conduite de le véhicule hôte.

Figure 1. Pipeline des modèles DriveVLM et DriveVLM-Dual. Une séquence d'images est traitée par un grand modèle de langage visuel (VLM) pour effectuer un raisonnement spécial en chaîne de pensée (CoT) afin d'en dériver des résultats de planification de conduite. Le grand VLM implique un encodeur de transformateur visuel et un grand modèle de langage (LLM). Un encodeur visuel produit des balises d'image ; un extracteur basé sur l'attention aligne ensuite ces balises avec un LLM et enfin, le LLM effectue une inférence CoT ; Le processus CoT peut être divisé en trois modules : description du scénario, analyse du scénario et planification hiérarchique.

DriveVLM-Dual est un système hybride qui utilise la compréhension globale de DriveVLM de l'environnement et les suggestions de trajectoires de décision pour améliorer les capacités de prise de décision et de planification du pipeline de conduite autonome traditionnel. Il intègre les résultats de la perception 3D dans des signaux verbaux pour améliorer la compréhension de la scène 3D et affine davantage les points de cheminement de la trajectoire avec un planificateur de mouvement en temps réel.

Bien que les VLM soient efficaces pour identifier les objets à longue traîne et comprendre des scènes complexes, ils ont souvent du mal à comprendre avec précision l'emplacement spatial et l'état de mouvement détaillé des objets, une lacune qui pose un défi important. Pour aggraver les choses, la taille énorme du modèle VLM entraîne une latence élevée, ce qui entrave la capacité de réponse en temps réel de la conduite autonome. Pour relever ces défis, l'auteur propose DriveVLM-Dual, qui permet à DriveVLM et aux systèmes de conduite autonomes traditionnels de coopérer. Cette nouvelle approche implique deux stratégies clés : l'analyse d'objets clés combinée à la perception 3D pour fournir des informations de décision de conduite en haute dimension, et un raffinement de trajectoire à haute fréquence.

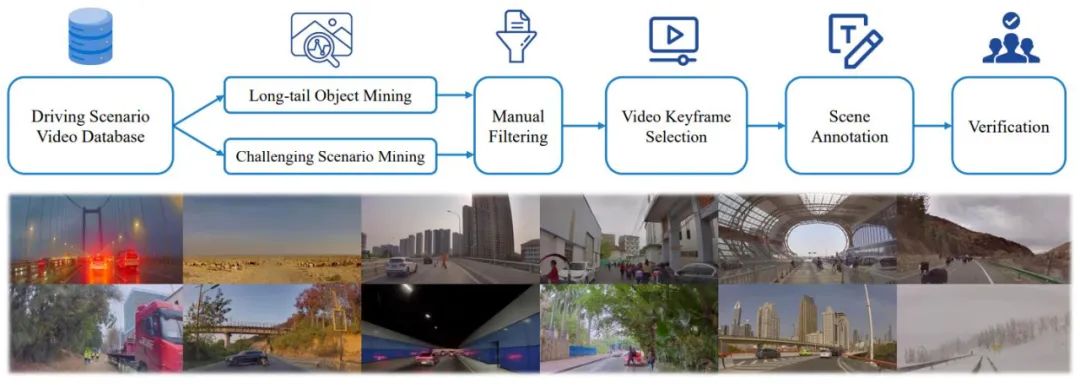

De plus, pour exploiter pleinement le potentiel de DriveVLM et DriveVLMDual dans la gestion de scénarios de conduite complexes et à longue traîne, les chercheurs ont formellement défini une tâche appelée planification de compréhension de scène, ainsi qu'un ensemble de mesures d'évaluation. De plus, les auteurs proposent un protocole d’exploration de données et d’annotation pour gérer les ensembles de données de compréhension et de planification des scènes.

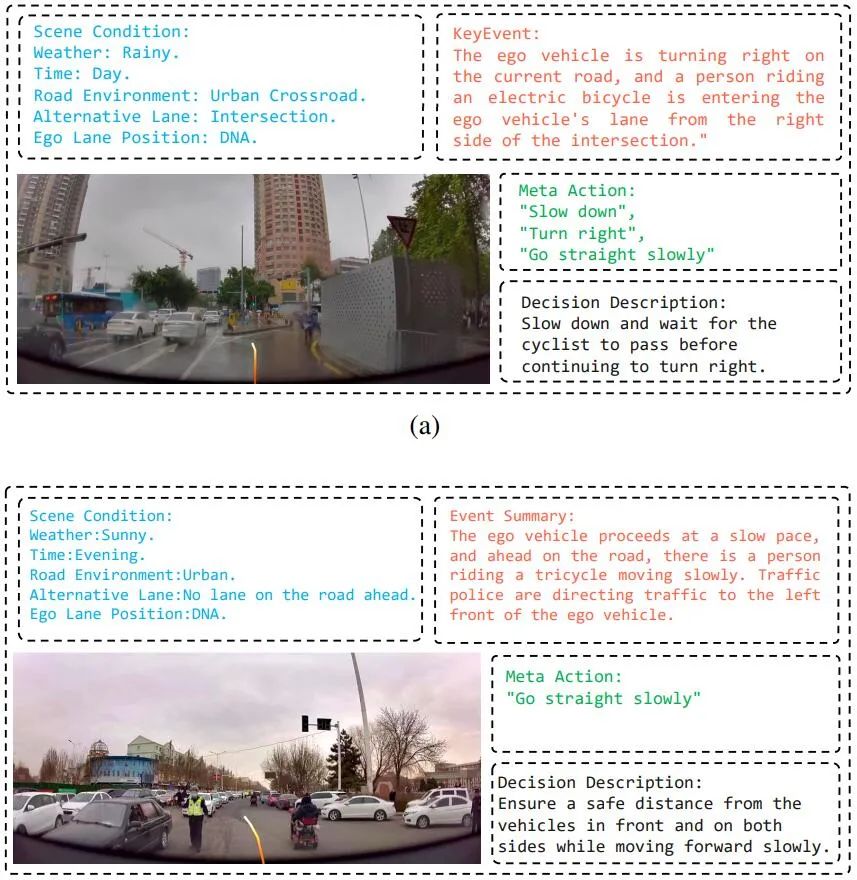

Afin d'entraîner complètement le modèle, l'auteur a récemment développé un ensemble d'outils d'annotation et de solutions d'annotation Drive LLM grâce à une combinaison d'exploration automatisée, de pré-brossage d'algorithmes de perception, de résumé de grand modèle GPT-4 et d'annotation manuelle. Le modèle actuel a été formé. Avec ce schéma d'annotation efficace, chaque donnée Clip contient des dizaines de contenus d'annotation.

L'auteur a également proposé un pipeline complet d'exploration de données et d'annotation, comme le montre la figure 3, pour créer un ensemble de données de compréhension de scène pour la planification en conduite autonome (SUP-AD) pour la tâche proposée, contenant plus de 100 000 images et plus de 1 000 000 images. paires de textes. Plus précisément, les auteurs effectuent d’abord une exploration d’objets à longue traîne et une exploration de scènes difficiles à partir d’une grande base de données pour collecter des échantillons, puis sélectionnent une image clé de chaque échantillon et effectuent ensuite une annotation de scène.

Figure 3. Pipeline d'exploration de données et d'annotation pour créer une compréhension de scénarios et planifier des ensembles de données (ci-dessus). Des exemples de scénarios échantillonnés aléatoirement à partir de l’ensemble de données (ci-dessous) démontrent la diversité et la complexité de l’ensemble de données.

SUP-AD est divisé en parties de formation, de vérification et de test, avec un ratio de 7,5 : 1 : 1,5. Les auteurs entraînent le modèle sur la répartition de formation et utilisent la description de scène et les métriques de méta-action nouvellement proposées pour évaluer les performances du modèle sur la répartition validation/test.

L'ensemble de données nuScenes est un ensemble de données de conduite de scènes urbaines à grande échelle avec 1 000 scènes, chacune d'une durée d'environ 20 secondes. Les images clés sont annotées uniformément à 2 Hz sur l’ensemble de l’ensemble de données. Ici, les auteurs adoptent l'erreur de déplacement (DE) et le taux de collision (CR) comme indicateurs pour évaluer les performances du modèle en matière de segmentation de vérification.

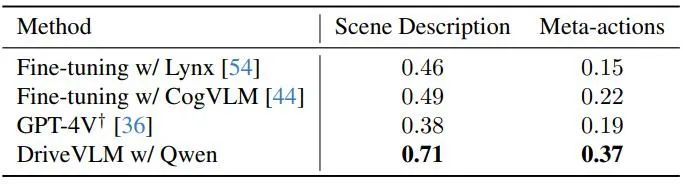

Les auteurs démontrent les performances de DriveVLM avec plusieurs modèles de langage visuel à grande échelle et les comparent avec GPT-4V, comme le montre le tableau 1. DriveVLM utilise Qwen-VL comme épine dorsale, qui atteint les meilleures performances par rapport aux autres VLM open source et se caractérise par une réactivité et une interaction flexible. Les deux premiers grands modèles ont été open source et ont utilisé les mêmes données pour affiner la formation. GPT-4V utilise des invites complexes pour une ingénierie rapide.

Tableau 1. Résultats de l'ensemble de tests sur l'ensemble de données SUP-AD. L'API officielle de GPT-4V est utilisée ici, et pour Lynx et CogVLM, les divisions de formation sont utilisées pour le réglage fin.

Comme le montre le tableau 2, DriveVLM-Dual atteint des performances de pointe sur les tâches de planification nuScenes lorsqu'il est associé à VAD. Cela montre que la nouvelle méthode, bien que conçue pour comprendre des scènes complexes, fonctionne également bien dans les scènes ordinaires. Notez que DriveVLM-Dual s'améliore considérablement par rapport à UniAD : l'erreur moyenne de déplacement de planification est réduite de 0,64 mètres et le taux de collision est réduit de 51 %.

Tableau 2. Résultats de la planification pour l'ensemble de données de validation nuScenes. DriveVLM-Dual atteint des performances optimales. †Représente les résultats de perception et de prévision d'occupation à l'aide d'Uni-AD. ‡ Indique le travail avec VAD, où tous les modèles prennent les états du moi en entrée. Figure 4. Résultats qualitatifs de DriveVLM. La courbe orange représente la trajectoire future prévue du modèle au cours des 3 prochaines secondes.

. -Figure 9. Concentration des données Sup-AD des grappes et troupeaux de vaches. Un troupeau de bovins se déplace lentement devant la voiture, ce qui oblige la politique à raisonner sur le fait que la voiture se déplace lentement et à garder une distance de sécurité avec le bétail. Figure 16. Visualisation de la sortie DriveVLM. DriveVLM peut détecter avec précision les arbres tombés et leur emplacement, puis planifier un détour approprié.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Mais peut-être qu’il ne pourra pas vaincre le vieil homme dans le parc ? Les Jeux Olympiques de Paris battent leur plein et le tennis de table suscite beaucoup d'intérêt. Dans le même temps, les robots ont également réalisé de nouvelles avancées dans le domaine du tennis de table. DeepMind vient tout juste de proposer le premier agent robot apprenant capable d'atteindre le niveau des joueurs amateurs humains de tennis de table de compétition. Adresse papier : https://arxiv.org/pdf/2408.03906 Quelle est la capacité du robot DeepMind à jouer au tennis de table ? Probablement à égalité avec les joueurs amateurs humains : tant en coup droit qu'en revers : l'adversaire utilise une variété de styles de jeu, et le robot peut également résister : recevoir des services avec des tours différents : Cependant, l'intensité du jeu ne semble pas aussi intense que le vieil homme dans le parc. Pour les robots, le tennis de table

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

Le 21 août, la Conférence mondiale sur les robots 2024 s'est tenue en grande pompe à Pékin. La marque de robots domestiques de SenseTime, "Yuanluobot SenseRobot", a dévoilé toute sa famille de produits et a récemment lancé le robot de jeu d'échecs Yuanluobot AI - Chess Professional Edition (ci-après dénommé "Yuanluobot SenseRobot"), devenant ainsi le premier robot d'échecs au monde pour le maison. En tant que troisième produit robot jouant aux échecs de Yuanluobo, le nouveau robot Guoxiang a subi un grand nombre de mises à niveau techniques spéciales et d'innovations en matière d'IA et de machines d'ingénierie. Pour la première fois, il a réalisé la capacité de ramasser des pièces d'échecs en trois dimensions. grâce à des griffes mécaniques sur un robot domestique et effectuer des fonctions homme-machine telles que jouer aux échecs, tout le monde joue aux échecs, réviser la notation, etc.

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

La rentrée scolaire est sur le point de commencer, et ce ne sont pas seulement les étudiants qui sont sur le point de commencer le nouveau semestre qui doivent prendre soin d’eux-mêmes, mais aussi les grands modèles d’IA. Il y a quelque temps, Reddit était rempli d'internautes se plaignant de la paresse de Claude. « Son niveau a beaucoup baissé, il fait souvent des pauses et même la sortie devient très courte. Au cours de la première semaine de sortie, il pouvait traduire un document complet de 4 pages à la fois, mais maintenant il ne peut même plus produire une demi-page. !" https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/ dans un post intitulé "Totalement déçu par Claude", plein de

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference qui se tient à Pékin, l'exposition de robots humanoïdes est devenue le centre absolu de la scène. Sur le stand Stardust Intelligent, l'assistant robot IA S1 a réalisé trois performances majeures de dulcimer, d'arts martiaux et de calligraphie. un espace d'exposition, capable à la fois d'arts littéraires et martiaux, a attiré un grand nombre de publics professionnels et de médias. Le jeu élégant sur les cordes élastiques permet au S1 de démontrer un fonctionnement fin et un contrôle absolu avec vitesse, force et précision. CCTV News a réalisé un reportage spécial sur l'apprentissage par imitation et le contrôle intelligent derrière "Calligraphy". Le fondateur de la société, Lai Jie, a expliqué que derrière les mouvements soyeux, le côté matériel recherche le meilleur contrôle de la force et les indicateurs corporels les plus humains (vitesse, charge). etc.), mais du côté de l'IA, les données réelles de mouvement des personnes sont collectées, permettant au robot de devenir plus fort lorsqu'il rencontre une situation forte et d'apprendre à évoluer rapidement. Et agile

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Les contributeurs ont beaucoup gagné de cette conférence ACL. L'ACL2024, d'une durée de six jours, se tient à Bangkok, en Thaïlande. ACL est la plus grande conférence internationale dans le domaine de la linguistique informatique et du traitement du langage naturel. Elle est organisée par l'Association internationale pour la linguistique informatique et a lieu chaque année. L'ACL s'est toujours classée première en termes d'influence académique dans le domaine de la PNL, et c'est également une conférence recommandée par le CCF-A. La conférence ACL de cette année est la 62e et a reçu plus de 400 travaux de pointe dans le domaine de la PNL. Hier après-midi, la conférence a annoncé le meilleur article et d'autres récompenses. Cette fois, il y a 7 Best Paper Awards (deux inédits), 1 Best Theme Paper Award et 35 Outstanding Paper Awards. La conférence a également décerné 3 Resource Paper Awards (ResourceAward) et Social Impact Award (

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

Intégration profonde de la vision et de l'apprentissage des robots. Lorsque deux mains de robot travaillent ensemble en douceur pour plier des vêtements, verser du thé et emballer des chaussures, associées au robot humanoïde 1X NEO qui a fait la une des journaux récemment, vous pouvez avoir le sentiment : nous semblons entrer dans l'ère des robots. En fait, ces mouvements soyeux sont le produit d’une technologie robotique avancée + d’une conception de cadre exquise + de grands modèles multimodaux. Nous savons que les robots utiles nécessitent souvent des interactions complexes et exquises avec l’environnement, et que l’environnement peut être représenté comme des contraintes dans les domaines spatial et temporel. Par exemple, si vous souhaitez qu'un robot verse du thé, le robot doit d'abord saisir la poignée de la théière et la maintenir verticalement sans renverser le thé, puis la déplacer doucement jusqu'à ce que l'embouchure de la théière soit alignée avec l'embouchure de la tasse. , puis inclinez la théière selon un certain angle. ce

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Cet après-midi, Hongmeng Zhixing a officiellement accueilli de nouvelles marques et de nouvelles voitures. Le 6 août, Huawei a organisé la conférence de lancement de nouveaux produits Hongmeng Smart Xingxing S9 et Huawei, réunissant la berline phare intelligente panoramique Xiangjie S9, le nouveau M7Pro et Huawei novaFlip, MatePad Pro 12,2 pouces, le nouveau MatePad Air, Huawei Bisheng With de nombreux nouveaux produits intelligents tous scénarios, notamment la série d'imprimantes laser X1, FreeBuds6i, WATCHFIT3 et l'écran intelligent S5Pro, des voyages intelligents, du bureau intelligent aux vêtements intelligents, Huawei continue de construire un écosystème intelligent complet pour offrir aux consommateurs une expérience intelligente du Internet de tout. Hongmeng Zhixing : Autonomisation approfondie pour promouvoir la modernisation de l'industrie automobile intelligente Huawei s'associe à ses partenaires de l'industrie automobile chinoise pour fournir

Testé 7 artefacts de génération vidéo « de niveau Sora ». Qui a la capacité de monter sur le « Trône de fer » ?

Aug 05, 2024 pm 07:19 PM

Testé 7 artefacts de génération vidéo « de niveau Sora ». Qui a la capacité de monter sur le « Trône de fer » ?

Aug 05, 2024 pm 07:19 PM

Editeur du Machine Power Report : Yang Wen Qui peut devenir le roi du cercle vidéo de l'IA ? Dans la série télévisée américaine "Game of Thrones", il y a un "Trône de Fer". La légende raconte qu'il a été fabriqué par le dragon géant « Black Death » qui a fait fondre des milliers d'épées abandonnées par les ennemis, symbolisant l'autorité suprême. Pour s'asseoir sur cette chaise de fer, les grandes familles ont commencé à se battre et à se battre. Depuis l'émergence de Sora, un vigoureux "Game of Thrones" a été lancé dans le cercle vidéo de l'IA. Les principaux acteurs de ce jeu incluent RunwayGen-3 et Luma de l'autre côté de l'océan, ainsi que Kuaishou Keling, ByteDream, national. et Zhimo. Spectre Qingying, Vidu, PixVerseV2, etc. Aujourd'hui, nous allons évaluer et voir qui est qualifié pour siéger sur le « Trône de fer » du cercle vidéo IA. -1-Vincent Vidéo