Périphériques technologiques

Périphériques technologiques

IA

IA

La vidéo IA explose à nouveau ! Photo + voix transformée en vidéo, Alibaba a demandé à l'héroïne Sora de chanter et rapper avec Li Zi.

La vidéo IA explose à nouveau ! Photo + voix transformée en vidéo, Alibaba a demandé à l'héroïne Sora de chanter et rapper avec Li Zi.

La vidéo IA explose à nouveau ! Photo + voix transformée en vidéo, Alibaba a demandé à l'héroïne Sora de chanter et rapper avec Li Zi.

Après Sora, il existe en fait un nouveau modèle vidéo IA, qui est incroyable et qui fait que tout le monde l'aime comme un fou !

Photos

Photos

Avec lui, Gao Qiqiang, le méchant de "Dépêchez-vous" se transforme en Luo Xiang, et il peut éduquer tout le monde (tête de chien).

Il s'agit du dernier cadre de génération de vidéos de portraits audio d'Alibaba, EMO (Emote Portrait Alive).

Avec lui, vous pouvez générer une vidéo IA avec des expressions vives en saisissant une seule image de référence et un morceau d'audio (discours, chant ou rap). La durée finale de la vidéo dépend de la longueur de l'audio d'entrée.

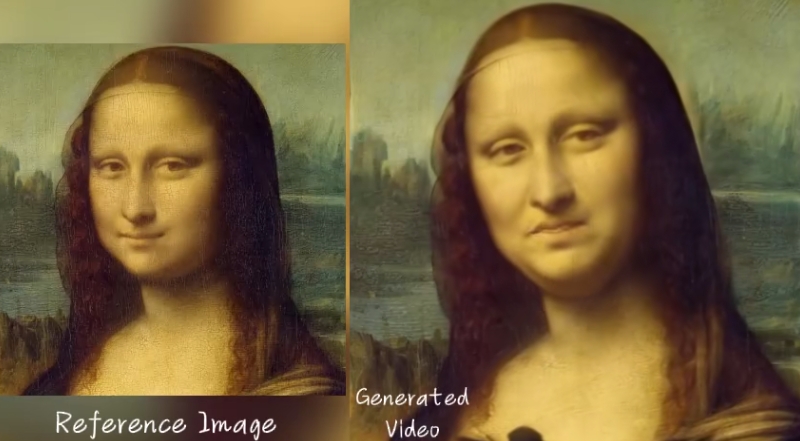

Vous pouvez demander à Mona Lisa, une candidate expérimentée en effets d'IA, de réciter un monologue :

Le jeune et beau DiCaprio présente un spectacle de talents rap au rythme effréné, et la forme de sa bouche ne peut pas être maintenue. Question :

Je peux même tenir le lip sync cantonais, alors j'ai demandé à mon frère Leslie Cheung de chanter "Unconditional" d'Eason Chan :

Bref, si c'est pour laisser le portrait chanter (différents styles de portraits et de chansons), laisser parler les portraits (dans différentes langues), ou réaliser diverses performances inter-acteurs. L'effet EMO nous a un instant stupéfiés.

Les internautes se sont exclamés : "Nous entrons dans une nouvelle réalité !"

La version 2019 de "Joker" reprend les lignes de la version 2008 de "The Dark Knight"

La version 2019 de "Joker" reprend les lignes de la version 2008 de "The Dark Knight"

Certains internautes ont même commencé à générer des vidéos de EMO Tirez sur la languette et analysez l'effet image par image.

Comme le montre la vidéo ci-dessous, la protagoniste est la dame IA générée par Sora. La chanson qu'elle a chantée pour vous cette fois est "Don't Start Now".

Tweeters analysés :

La cohérence de cette vidéo est encore meilleure qu'avant !

Dans la vidéo de plus d'une minute, les lunettes de soleil sur le visage de Mme Sora bougent à peine, et ses oreilles et ses sourcils bougent indépendamment.

Le plus excitant, c'est que la gorge de Mme Sora semble vraiment respirer ! Son corps tremblait et bougeait légèrement en chantant, ce qui m'a choqué !

Photos

Photos

Cela dit, EMO est une nouvelle technologie en vogue, et il est inévitable de la comparer avec des produits similaires -

Hier encore, la société de génération vidéo IA Pika a également lancé le doublage de vidéo les personnages et la fonction de synchronisation labiale "lip sync" se sont écrasés.

Qu'en est-il de l'effet spécifique ?Nous le mettrons directement ici

Après comparaison, les internautes de la zone de commentaires sont arrivés à la conclusion qu'ils avaient été battus par Ali.

Pictures

Pictures

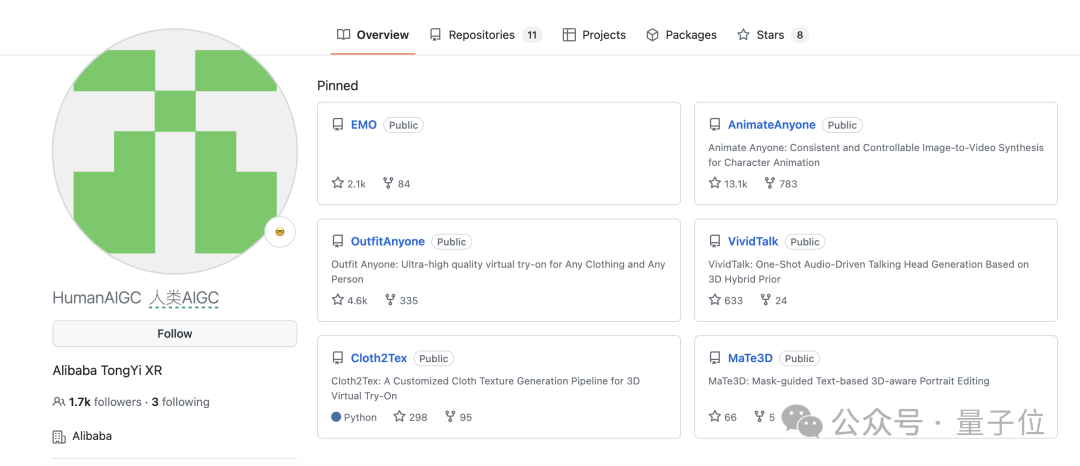

EMO a publié le document et a annoncé qu'il était open source.

Mais ! Bien qu’il soit open source, il existe encore des positions courtes sur GitHub.

Mais encore une fois ! Bien qu'il s'agisse d'une position courte, le nombre d'étoiles a dépassé 2,1 000.

Photos

Photos

ont rendu les internautes vraiment anxieux, aussi anxieux que le roi Gigi.

Architecture différente de Sora

Dès que le document EMO est sorti, de nombreuses personnes dans le cercle ont poussé un soupir de soulagement.

C'est différent du parcours technique de Sora, qui montre que copier Sora n'est pas le seul moyen.

EMO n'est pas basé sur une architecture de type DiT, c'est-à-dire qu'il n'utilise pas Transformer pour remplacer le UNet traditionnel. Son réseau fédérateur est modifié par rapport à Stable Diffusion 1.5.

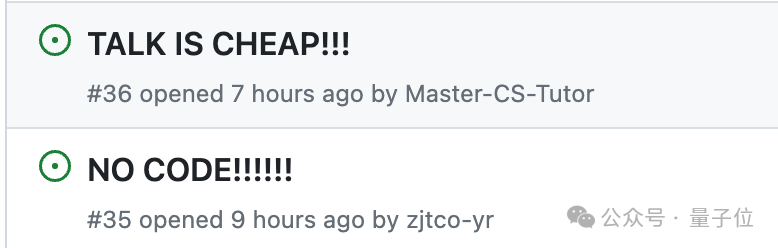

Plus précisément, EMO est un cadre de génération vidéo de portrait expressif piloté par audio qui peut générer des vidéos de n'importe quelle durée en fonction de la longueur de la vidéo d'entrée.

Pictures

Pictures

Le framework se compose principalement de deux étapes :

- Étape d'encodage de trame

déploie un réseau UNet appelé ReferenceNet, qui est responsable de l'extraction des fonctionnalités des images de référence et des images de vidéos.

- Étape de diffusion

Tout d'abord, l'encodeur audio pré-entraîné traite l'intégration audio et le masque de région du visage est combiné avec un bruit multi-images pour contrôler la génération d'images de visage.

Ensuite, le réseau fédérateur mène l’opération de débruitage. Deux types d'attention sont appliqués dans le réseau fédérateur, l'attention de référence et l'attention audio, qui servent respectivement à maintenir la cohérence identitaire du personnage et à réguler son mouvement.

De plus, le module temps est utilisé pour manipuler la dimension temporelle et ajuster la vitesse de déplacement.

En termes de données de formation, l'équipe a construit un ensemble de données audio et vidéo vaste et diversifié contenant plus de 250 heures de vidéo et plus de 15 millions d'images.

Les caractéristiques spécifiques de l'implémentation finale sont les suivantes :

- Peut générer des vidéos de n'importe quelle durée en fonction de l'audio d'entrée tout en garantissant la cohérence de l'identité du personnage (la vidéo la plus longue donnée dans la démonstration est de 1 minute et 49 secondes).

- Prend en charge le fait de parler et de chanter dans différentes langues (la démo comprend le mandarin, le cantonais, l'anglais, le japonais et le coréen)

- Prend en charge différents styles de peinture (photos, peintures traditionnelles, bandes dessinées, rendus 3D, personnes numériques IA)

Images

Images

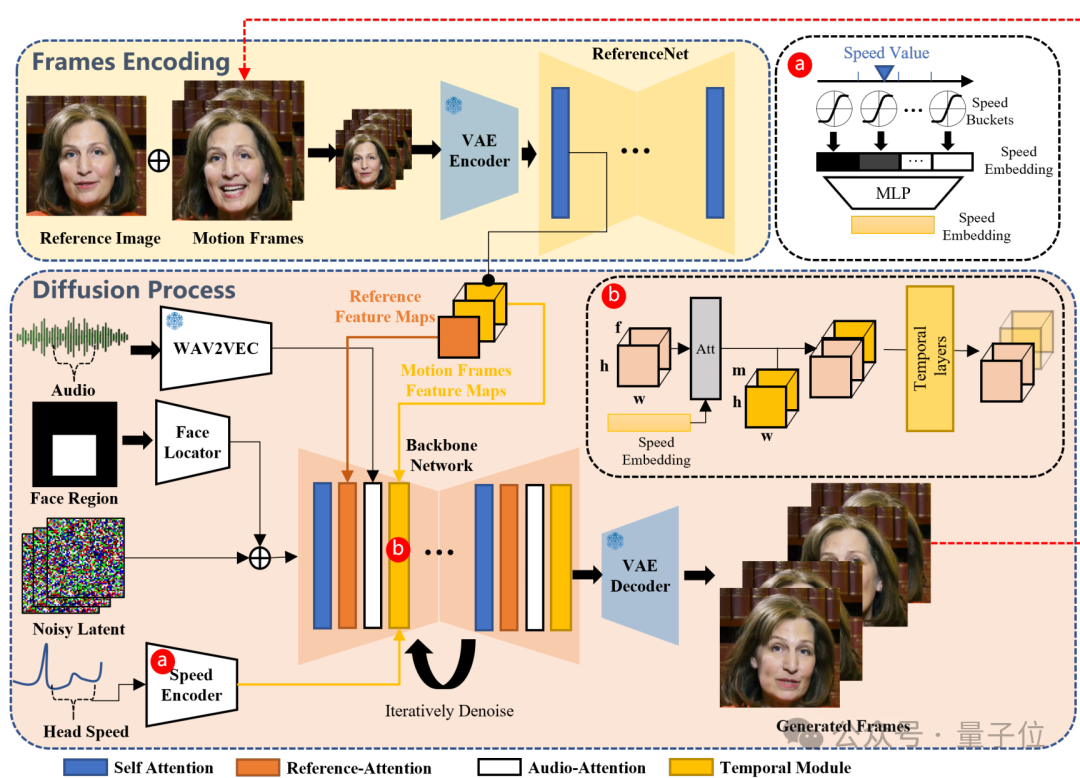

La comparaison quantitative est également grandement améliorée par rapport à la méthode précédente, atteignant SOTA, et n'est que légèrement inférieure à l'indicateur SyncNet qui mesure la qualité de la synchronisation labiale.

Images

Images

Par rapport à d'autres méthodes qui ne reposent pas sur des modèles de diffusion, l'EMO prend plus de temps.

Et comme aucun signal de contrôle explicite n'est utilisé, ce qui pourrait conduire à la génération involontaire d'autres parties du corps telles que les mains, une solution potentielle consiste à utiliser des signaux de contrôle spécifiquement pour les parties du corps.

L'équipe d'EMO

Enfin, jetons un coup d'œil aux membres de l'équipe derrière EMO.

Le document montre que l'équipe EMO vient de l'Alibaba Intelligent Computing Research Institute.

Il y a quatre auteurs, à savoir Linrui Tian, Qi Wang, Bang Zhang et Liefeng Bo.

Photos

Photos

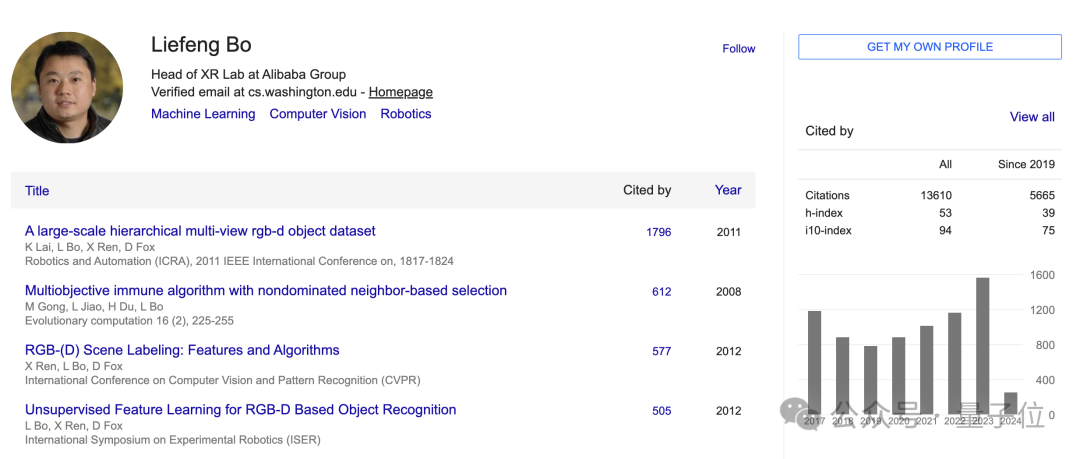

Parmi eux, Liefeng Bo est l'actuel chef du laboratoire XR du laboratoire Alibaba Tongyi.

Le Dr Bo Liefeng est diplômé de l'Université des sciences et technologies électroniques de Xi'an. Il a effectué des recherches postdoctorales au Toyota Research Institute de l'Université de Chicago et à l'Université de Washington. Ses domaines de recherche sont principalement le ML, le CV et la robotique. Ses citations Google Scholar dépassent les 13 000.

Avant de rejoindre Alibaba, il a d’abord occupé le poste de scientifique en chef au siège d’Amazon à Seattle, puis a rejoint le laboratoire d’IA de JD Digital Technology Group en tant que scientifique en chef.

En septembre 2022, Bo Liefeng rejoint Alibaba.

Photos

Photos

EMO n'est pas la première fois qu'Alibaba réussit dans le domaine de l'AIGC.

Photos

Photos

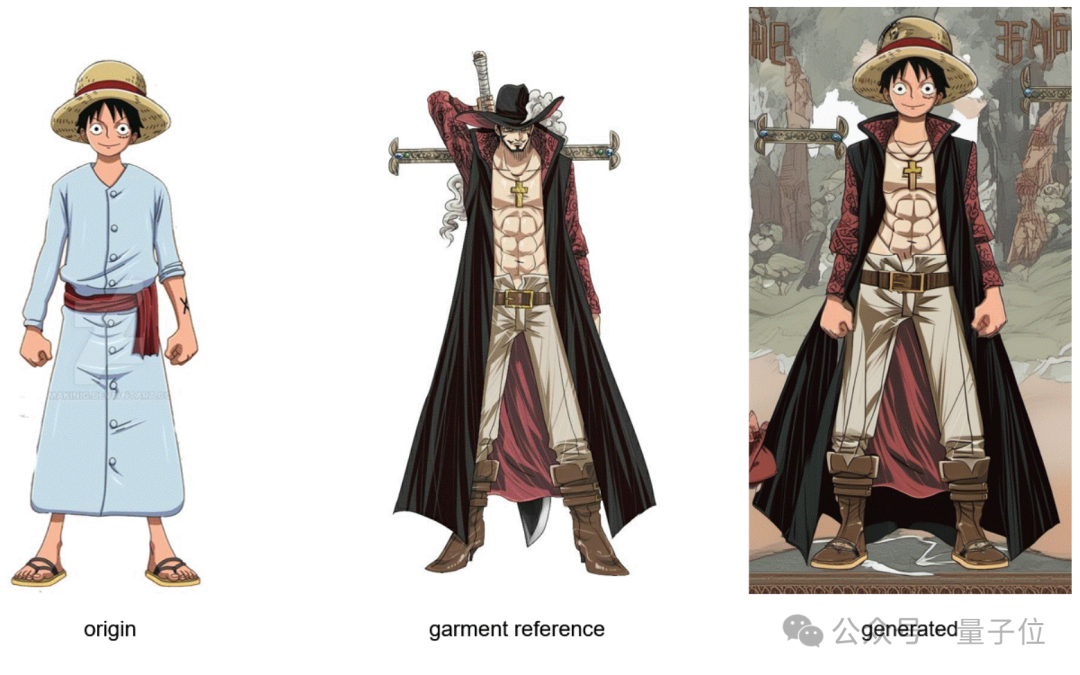

TenueToute personne disposant d'un changement de tenue en un clic grâce à l'IA.

Pictures

Pictures

De plus, AnimateAnyone fait danser les chats et les chiens du monde entier dans la danse du bain.

Voici celui ci-dessous :

Photos

Photos

Maintenant que l'EMO est lancé, de nombreux internautes déplorent qu'Alibaba ait accumulé une certaine technologie dessus.

Photos

Photos

Si toutes ces technologies sont combinées maintenant, l'effet...

Je n'ose pas y penser, mais j'ai hâte d'y être.

Photos

Photos

En bref, nous nous rapprochons de "envoyer un script à l'IA et sortir le film entier".

Pictures

Pictures

One More Thing

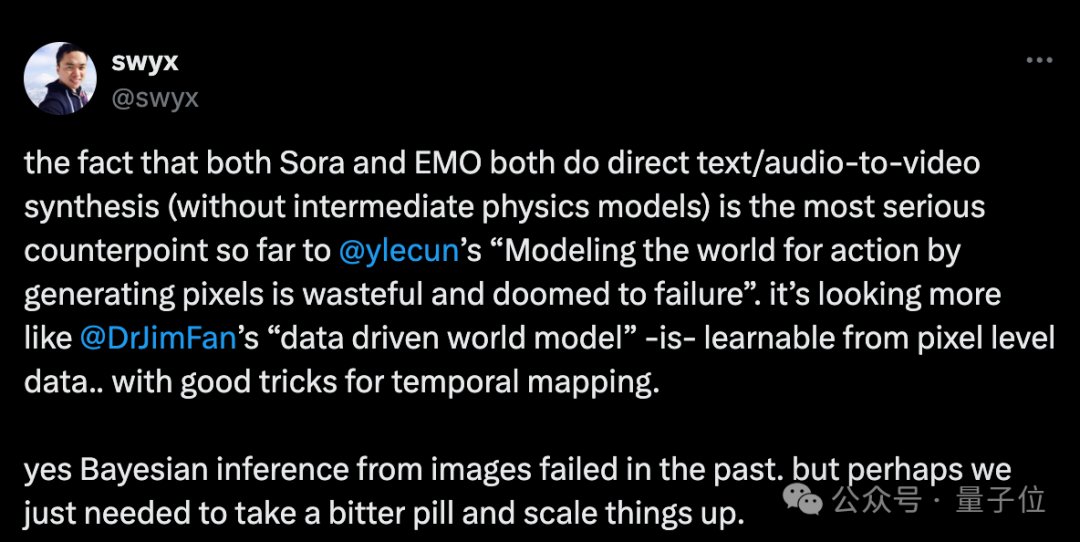

Sora, représente une percée dans la synthèse vidéo basée sur le texte.

EMO représente également un nouveau niveau de synthèse vidéo audio.

Bien que les deux aient des tâches différentes et des architectures spécifiques, ils ont quand même une chose importante en commun :

Il n'y a pas de modèle physique explicite au milieu, mais ils simulent tous les deux dans une certaine mesure les lois physiques.

Certaines personnes pensent donc que cela est contraire à l'insistance de Lecun selon laquelle « modéliser le monde pour des actions en générant des pixels est un gaspillage et est voué à l'échec », et soutient l'idée de « modèle mondial basé sur les données » de Jim Fan.

Photos

Photos

Diverses méthodes ont échoué dans le passé, mais le succès actuel vient peut-être en réalité des « Leçons amères » écrites par Sutton, le père de l'apprentissage par renforcement, où de grands efforts peuvent produire des miracles.

Permettre à l'IA de découvrir comme les gens, plutôt que de contenir ce que les gens découvrent

Des progrès révolutionnaires sont finalement réalisés en élargissant l'échelle de l'informatique

Article : https://www.php.cn/link/ a717f41c203cb970f96f706e4b12617bGitHub :https://www.php.cn/link/e43a09ffc30b44cb1f0db46f87836f40

Lien de référence :

[1]https://www.php.cn/link /0dd4f2526c7c874d06f19523264f6552

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1359

1359

52

52

Comment afficher correctement le 'Jingnan Mai Round Body' installé localement sur la page Web?

Apr 05, 2025 pm 10:33 PM

Comment afficher correctement le 'Jingnan Mai Round Body' installé localement sur la page Web?

Apr 05, 2025 pm 10:33 PM

En utilisant récemment des fichiers de police installés localement dans les pages Web, j'ai téléchargé une police gratuite à partir d'Internet et je l'ai installée avec succès dans mon système. Maintenant...

La production de pages H5 nécessite-t-elle une maintenance continue?

Apr 05, 2025 pm 11:27 PM

La production de pages H5 nécessite-t-elle une maintenance continue?

Apr 05, 2025 pm 11:27 PM

La page H5 doit être maintenue en continu, en raison de facteurs tels que les vulnérabilités du code, la compatibilité des navigateurs, l'optimisation des performances, les mises à jour de sécurité et les améliorations de l'expérience utilisateur. Des méthodes de maintenance efficaces comprennent l'établissement d'un système de test complet, à l'aide d'outils de contrôle de version, de surveiller régulièrement les performances de la page, de collecter les commentaires des utilisateurs et de formuler des plans de maintenance.

Où obtenir le matériel pour la production de pages H5

Apr 05, 2025 pm 11:33 PM

Où obtenir le matériel pour la production de pages H5

Apr 05, 2025 pm 11:33 PM

Les principales sources de matériel H5 Page sont: 1. Site Web de matériel professionnel (payé, de haute qualité, Copyright clair); 2. Matériel fait maison (unicité élevée, mais qui prend du temps); 3. Bibliothèque de matériaux open source (gratuit, doit être soigneusement dépisté); 4. site Web d'image / vidéo (le droit d'auteur vérifié est requis). De plus, le style de matériau unifié, l'adaptation de la taille, le traitement de la compression et la protection des droits d'auteur sont des points clés auxquels il faut faire attention.

Comment sélectionner un élément enfant avec l'élément de nom de première classe via CSS?

Apr 05, 2025 pm 11:24 PM

Comment sélectionner un élément enfant avec l'élément de nom de première classe via CSS?

Apr 05, 2025 pm 11:24 PM

Lorsque le nombre d'éléments n'est pas fixé, comment sélectionner le premier élément enfant du nom de classe spécifié via CSS. Lors du traitement de la structure HTML, vous rencontrez souvent différents éléments ...

Comment utiliser CSS et Flexbox pour implémenter la disposition réactive des images et du texte à différentes tailles d'écran?

Apr 05, 2025 pm 06:06 PM

Comment utiliser CSS et Flexbox pour implémenter la disposition réactive des images et du texte à différentes tailles d'écran?

Apr 05, 2025 pm 06:06 PM

Implémentation de dispositions réactives à l'aide de CSS lorsque nous voulons implémenter des modifications de mise en page sous différentes tailles d'écran dans la conception Web, CSS ...

Pourquoi les marges négatives ne prennent-elles pas effet dans certains cas? Comment résoudre ce problème?

Apr 05, 2025 pm 10:18 PM

Pourquoi les marges négatives ne prennent-elles pas effet dans certains cas? Comment résoudre ce problème?

Apr 05, 2025 pm 10:18 PM

Pourquoi les marges négatives ne prennent-elles pas effet dans certains cas? Pendant la programmation, les marges négatives dans CSS (négatif ...

Quels scénarios d'application conviennent à la production de pages H5

Apr 05, 2025 pm 11:36 PM

Quels scénarios d'application conviennent à la production de pages H5

Apr 05, 2025 pm 11:36 PM

H5 (HTML5) convient aux applications légères, telles que les pages de campagne de marketing, les pages d'affichage des produits et les micro-Websites de promotion d'entreprise. Ses avantages résident dans la plateformité multi-plateaux et une riche interactivité, mais ses limites résident dans des interactions et des animations complexes, un accès aux ressources locales et des capacités hors ligne.

Comment utiliser l'attribut de forme-extérieur de CSS pour réaliser l'effet d'affichage du raccourcissement progressivement du texte?

Apr 05, 2025 pm 10:54 PM

Comment utiliser l'attribut de forme-extérieur de CSS pour réaliser l'effet d'affichage du raccourcissement progressivement du texte?

Apr 05, 2025 pm 10:54 PM

Implémentation de l'effet d'affichage du raccourcissement progressivement du texte dans la conception Web, comment réaliser un effet d'affichage de texte spécial pour faire raccourcir progressivement la longueur du texte? Cet effet ...