Comment mener une évaluation LLM basée sur Arthur Bench ?

Bonjour à tous, je m'appelle Luga, aujourd'hui nous allons parler des technologies liées au domaine écologique de l'intelligence artificielle (IA) - évaluation LLM.

1. Défis rencontrés par l'évaluation de texte traditionnelle

Ces dernières années, avec le développement et l'amélioration rapides des grands modèles de langage (LLM), les méthodes traditionnelles d'évaluation de texte peuvent ne plus être applicables à certains égards. Dans le domaine de l'évaluation de texte, nous avons peut-être entendu parler de méthodes telles que les méthodes d'évaluation basées sur « l'occurrence de mots », telles que BLEU, et les méthodes d'évaluation basées sur des « modèles de traitement du langage naturel pré-entraînés », telles que BERTScore.

Bien que ces méthodes aient bien fonctionné dans le passé, avec le développement continu de la technologie écologique LLM, elles semblent légèrement incapables de répondre pleinement aux besoins actuels.

Avec le développement rapide et l'amélioration continue de la technologie LLM, nous sommes confrontés à de nouveaux défis et opportunités. LLM continue d'améliorer ses capacités et ses niveaux de performances, ce qui rend les méthodes d'évaluation basées sur la fréquence des mots (telles que BLEU) potentiellement incapables de capturer pleinement la qualité et l'exactitude sémantique du texte généré par LLM. Le LLM peut générer un texte plus fluide, cohérent et sémantiquement riche, alors que les méthodes traditionnelles d'évaluation basées sur la fréquence des mots sont difficiles à évaluer avec précision ces avantages.

De plus, les méthodes d'évaluation basées sur des modèles pré-entraînés, tels que BERTScore, sont également confrontées à certains défis. Bien que les modèles pré-entraînés fonctionnent bien sur de nombreuses tâches, ils peuvent ne pas prendre pleinement en compte les caractéristiques particulières du LLM et ses performances sur des tâches spécifiques. Les LLM peuvent présenter un comportement et des performances différents de ceux des modèles pré-entraînés lors de la gestion de tâches spécifiques, donc s'appuyer uniquement sur des méthodes d'évaluation basées sur des modèles pré-entraînés peut ne pas évaluer pleinement les capacités des LLM.

2. Pourquoi l'évaluation d'orientation LLM est-elle nécessaire ? Et quels défis cela apporte-t-elle ?

De manière générale, dans les environnements professionnels réels, la valeur de la méthode LLM se reflète principalement dans sa « rapidité » et sa « sensibilité ». sont l'indicateur d'évaluation le plus important.

1. Efficace

Tout d’abord, de manière générale, la mise en œuvre est plus rapide. Par rapport à la quantité de travail requise par les pipelines d'évaluation précédents, la création d'une première mise en œuvre d'une évaluation guidée par LLM est relativement rapide et facile. Pour l'évaluation guidée par LLM, il nous suffit de préparer deux choses : décrire les critères d'évaluation avec des mots et fournir quelques exemples à utiliser dans le modèle d'invite. Par rapport à la quantité de travail et de collecte de données nécessaires pour créer votre propre modèle PNL pré-entraîné (ou affiner un modèle PNL existant) pour servir d'estimateur, l'utilisation d'un LLM pour accomplir ces tâches est plus efficace. Avec LLM, l’itération des critères d’évaluation est beaucoup plus rapide.

2. Sensibilité

LLM présente généralement une sensibilité plus élevée. Cette sensibilité peut avoir son côté positif, car LLM est plus flexible dans la gestion de diverses situations que les modèles PNL pré-entraînés et les méthodes d'évaluation évoquées précédemment. Cependant, cette sensibilité élevée peut également rendre les résultats de l’évaluation LLM difficiles à prédire. De petits changements dans les données d'entrée de LLM peuvent avoir des effets significatifs, ce qui permet de présenter une plus grande volatilité lors du traitement de tâches spécifiques. Par conséquent, lors de l’évaluation du LLM, une attention particulière doit être accordée à sa sensibilité afin de garantir la stabilité et la fiabilité des résultats.

Comme nous en avons discuté précédemment, les évaluateurs LLM sont plus sensibles que les autres méthodes d'évaluation. Il existe de nombreuses façons différentes de configurer LLM en tant qu'évaluateur, et son comportement peut varier considérablement en fonction de la configuration choisie. Parallèlement, un autre défi est que les évaluateurs LLM peuvent se retrouver bloqués si l'évaluation implique trop d'étapes d'inférence ou nécessite de traiter trop de variables simultanément.

En raison des caractéristiques de LLM, ses résultats d'évaluation peuvent être affectés par différentes configurations et réglages de paramètres. Cela signifie que lors de l'évaluation des LLM, le modèle doit être soigneusement sélectionné et configuré pour garantir qu'il se comporte comme prévu. Différentes configurations peuvent conduire à des résultats différents, l'évaluateur doit donc consacrer du temps et des efforts pour ajuster et optimiser les paramètres du LLM afin d'obtenir des résultats d'évaluation précis et fiables.

De plus, les évaluateurs peuvent être confrontés à certains défis lorsqu'ils sont confrontés à des tâches d'évaluation qui nécessitent un raisonnement complexe ou le traitement simultané de plusieurs variables. En effet, la capacité de raisonnement du LLM peut être limitée lorsqu'il s'agit de situations complexes. Le LLM peut nécessiter des efforts supplémentaires pour accomplir ces tâches afin de garantir l'exactitude et la fiabilité de l'évaluation.

3. Qu'est-ce qu'Arthur Bench ?

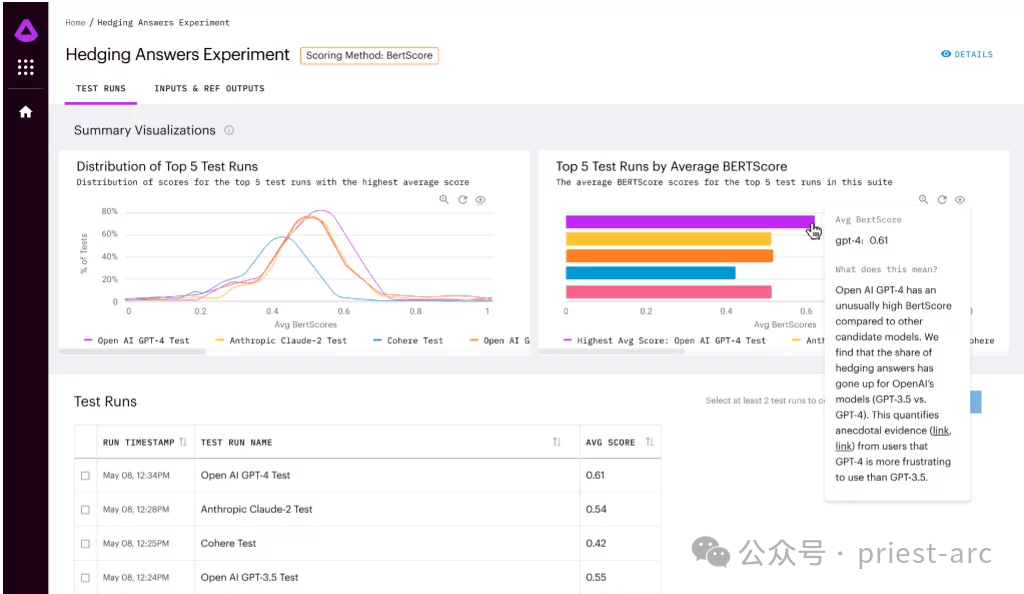

Arthur Bench est un outil d'évaluation open source utilisé pour comparer les performances des modèles de texte génératifs (LLM). Il peut être utilisé pour évaluer différents modèles, indices et hyperparamètres LLM et fournir des rapports détaillés sur les performances LLM sur diverses tâches.

Les principales fonctionnalités d'Arthur Bench incluent : Les principales fonctionnalités d'Arthur Bench incluent :

- Comparez différents modèles LLM : Arthur Bench peut être utilisé pour comparer les performances de différents modèles LLM, y compris des modèles de différents fournisseurs, différentes versions de modèles et des modèles utilisant différents ensembles de données de formation.

- Évaluer les conseils : Arthur Bench peut être utilisé pour évaluer l'impact de différents conseils sur les performances du LLM. Les invites sont des instructions utilisées pour guider LLM dans la génération de texte.

- Test des hyperparamètres : Arthur Bench peut être utilisé pour tester l'impact de différents hyperparamètres sur les performances du LLM. Les hyperparamètres sont des paramètres qui contrôlent le comportement de LLM.

De manière générale, le flux de travail d'Arthur Bench implique principalement les étapes suivantes, et l'analyse détaillée est la suivante :

1 Définition de la tâche

À ce stade, nous devons clarifier nos objectifs d'évaluation, Arthur. Bench Prend en charge une variété de tâches d'évaluation, notamment :

- Question et réponse : testez la capacité de LLM à comprendre et à répondre à des questions ouvertes, difficiles ou ambiguës.

- Résumé : évaluez la capacité de LLM à extraire des informations clés d'un texte et à générer des résumés concis.

- Traduction : examinez la capacité du LLM à traduire avec précision et fluidité entre différentes langues.

- Génération de code : testez la capacité de LLM à générer du code basé sur des descriptions en langage naturel.

2. Sélection du modèle

A cette étape, le travail principal consiste à sélectionner les objets d'évaluation. Arthur Bench prend en charge une variété de modèles LLM, couvrant les technologies de pointe d'institutions bien connues telles que OpenAI, Google AI, Microsoft, etc., telles que GPT-3, LaMDA, Megatron-Turing NLG, etc. Nous pouvons sélectionner des modèles spécifiques à évaluer en fonction des besoins de recherche.

3. Configuration des paramètres

Après avoir terminé la sélection du modèle, l'étape suivante consiste à effectuer un contrôle affiné. Pour évaluer plus précisément les performances de LLM, Arthur Bench permet aux utilisateurs de configurer des astuces et des hyperparamètres.

- Astuce : Guidez LLM dans la direction et le contenu du texte généré, tel que des questions, des descriptions ou des instructions.

- Hyperparamètres : paramètres clés qui contrôlent le comportement du LLM, tels que le taux d'apprentissage, le nombre d'étapes de formation, l'architecture du modèle, etc.

Grâce à une configuration raffinée, nous pouvons explorer en profondeur les différences de performances de LLM sous différents paramètres et obtenir des résultats d'évaluation avec plus de valeur de référence.

4. Exécution d'évaluation : processus automatisé

La dernière étape consiste à effectuer une évaluation des tâches à l'aide d'un processus automatisé. En règle générale, Arthur Bench fournit un processus d'évaluation automatisé qui nécessite une configuration simple pour exécuter les tâches d'évaluation. Il effectuera automatiquement les étapes suivantes :

- Appelez le modèle LLM et génèrez une sortie texte.

- Pour des tâches spécifiques, appliquez les indicateurs d'évaluation correspondants pour l'analyse.

- Générez des rapports détaillés et présentez les résultats de l'évaluation.

4. Analyse du scénario d'utilisation d'Arthur Bench

En tant que clé d'une évaluation LLM rapide et basée sur les données, Arthur Bench fournit principalement les solutions suivantes, impliquant spécifiquement :

1. est une étape cruciale dans le domaine de l’intelligence artificielle et revêt une grande importance pour garantir la validité et la fiabilité du modèle. Dans ce processus, le rôle d'Arthur Bench a été crucial. Son objectif est de fournir aux entreprises un cadre de comparaison fiable pour les aider à prendre des décisions éclairées parmi les nombreuses options de grands modèles de langage (LLM) grâce à l'utilisation de mesures et de méthodes d'évaluation cohérentes.

Arthur Bench utilisera son expertise et son expérience pour évaluer chaque option LLM et veillera à ce que des mesures cohérentes soient utilisées pour comparer leurs forces et leurs faiblesses. Il prendra en compte des facteurs tels que les performances du modèle, la précision, la rapidité, les besoins en ressources et bien plus encore pour garantir que les entreprises puissent faire des choix éclairés et clairs.

Arthur Bench utilisera son expertise et son expérience pour évaluer chaque option LLM et veillera à ce que des mesures cohérentes soient utilisées pour comparer leurs forces et leurs faiblesses. Il prendra en compte des facteurs tels que les performances du modèle, la précision, la rapidité, les besoins en ressources et bien plus encore pour garantir que les entreprises puissent faire des choix éclairés et clairs.

En utilisant des mesures et des méthodologies d'évaluation cohérentes, Arthur Bench fournira aux entreprises un cadre de comparaison fiable, leur permettant d'évaluer pleinement les avantages et les limites de chaque option LLM. Cela permettra aux entreprises de prendre des décisions éclairées pour maximiser les progrès rapides de l’intelligence artificielle et garantir la meilleure expérience possible avec leurs applications.

2. Optimisation du budget et de la confidentialité

Lors du choix d'un modèle d'IA, toutes les applications ne nécessitent pas les grands modèles de langage (LLM) les plus avancés ou les plus coûteux. Dans certains cas, les exigences de la mission peuvent être satisfaites à l’aide de modèles d’IA moins coûteux.

Cette approche d'optimisation budgétaire peut aider les entreprises à faire des choix intelligents avec des ressources limitées. Au lieu d’opter pour le modèle le plus cher ou le plus moderne, choisissez celui qui convient en fonction de vos besoins spécifiques. Les modèles les plus abordables peuvent être légèrement moins performants que les LLM de pointe à certains égards, mais pour certaines tâches simples ou standard, Arthur Bench peut toujours fournir une solution qui répond aux besoins.

De plus, Arthur Bench a souligné que l'intégration du modèle en interne permet un meilleur contrôle sur la confidentialité des données. Pour les applications impliquant des données sensibles ou des problèmes de confidentialité, les entreprises préféreront peut-être utiliser leurs propres modèles formés en interne plutôt que de s'appuyer sur des LLM externes tiers. En utilisant des modèles internes, les entreprises peuvent mieux contrôler le traitement et le stockage des données et mieux protéger la confidentialité des données.

3. Traduire les références académiques en performances réelles

Les références académiques font référence aux mesures et aux méthodes d'évaluation des modèles établies dans la recherche universitaire. Ces indicateurs et méthodes sont généralement spécifiques à une tâche ou un domaine spécifique et peuvent évaluer efficacement les performances du modèle dans cette tâche ou ce domaine.

Cependant, les références académiques ne reflètent pas toujours directement les performances d’un modèle dans le monde réel. En effet, les scénarios d'application dans le monde réel sont souvent plus complexes et nécessitent la prise en compte de davantage de facteurs, tels que la distribution des données, l'environnement de déploiement du modèle, etc.

Arthur Bench aide à traduire les références académiques en performances réelles. Il atteint cet objectif des manières suivantes :

- Fournit un ensemble complet d'indicateurs d'évaluation couvrant plusieurs aspects de la précision, de l'efficacité, de la robustesse du modèle, etc. Ces mesures peuvent refléter non seulement les performances du modèle selon des critères académiques, mais également les performances potentielles du modèle dans le monde réel.

- Prend en charge plusieurs types de modèles et peut comparer différents types de modèles. Cela permet aux entreprises de choisir le modèle qui convient le mieux à leurs scénarios d'application.

- Fournit des outils d'analyse visuelle pour aider les entreprises à comprendre intuitivement les différences de performances des différents modèles. Cela permet aux entreprises de prendre des décisions plus facilement.

5. Analyse des fonctionnalités d'Arthur Bench

En tant que clé d'une évaluation LLM rapide et basée sur les données, Arthur Bench possède les fonctionnalités suivantes :

1. Ensemble complet d'indicateurs de notation

Arthur Bench dispose d'un ensemble complet d'indicateurs de notation. indicateurs, couvrant tout, depuis la synthèse de tous les aspects de la qualité jusqu'à l'expérience utilisateur. Il peut utiliser ces mesures de notation à tout moment pour évaluer et comparer différents modèles. L’utilisation combinée de ces mesures de notation peut l’aider à pleinement comprendre les forces et les faiblesses de chaque modèle.

La portée de ces indicateurs de notation est très large, incluant, mais sans s'y limiter, la qualité du résumé, l'exactitude, la fluidité, l'exactitude grammaticale, la capacité de compréhension du contexte, la cohérence logique, etc. Arthur Bench évaluera chaque modèle par rapport à ces mesures et combinera les résultats dans un score complet pour aider les entreprises à prendre des décisions éclairées.

De plus, si l'entreprise a des besoins ou des préoccupations spécifiques, Arthur Bench peut également créer et ajouter des mesures de notation personnalisées en fonction des exigences de l'entreprise. Ceci est fait pour mieux répondre aux besoins spécifiques de l'entreprise et garantir que le processus d'évaluation est conforme aux objectifs et aux normes de l'entreprise.

2. Versions locales et basées sur le cloud

Pour ceux qui préfèrent le déploiement local et le contrôle autonome, vous pouvez accéder depuis le référentiel GitHub et déployer Arthur Bench dans votre propre environnement local. De cette manière, chacun peut maîtriser et contrôler pleinement le fonctionnement d’Arthur Bench et le personnaliser et le configurer selon ses propres besoins.

D'autre part, pour les utilisateurs qui préfèrent la commodité et la flexibilité, des produits SaaS basés sur le cloud sont également proposés. Vous pouvez choisir de vous inscrire pour accéder et utiliser Arthur Bench via le cloud. Cette méthode élimine le besoin d’une installation et d’une configuration locales fastidieuses et vous permet de profiter immédiatement des fonctions et services fournis.

3. Complètement open source

En tant que projet open source, Arthur Bench présente ses caractéristiques open source typiques en termes de transparence, d'évolutivité et de collaboration communautaire. Cette nature open source offre aux utilisateurs une multitude d’avantages et d’opportunités pour mieux comprendre le fonctionnement du projet, ainsi que pour le personnaliser et l’étendre en fonction de leurs besoins. Dans le même temps, l'ouverture d'Arthur Bench encourage également les utilisateurs à participer activement à la collaboration communautaire, à collaborer et à se développer avec d'autres utilisateurs. Ce modèle de coopération ouverte contribue à promouvoir le développement continu et l'innovation du projet, tout en créant davantage de valeur et d'opportunités pour les utilisateurs.

En bref, Arthur Bench fournit un cadre ouvert et flexible qui permet aux utilisateurs de personnaliser les indicateurs d'évaluation, et a été largement utilisé dans le domaine financier. Les partenariats avec Amazon Web Services et Cohere font progresser le cadre, encourageant les développeurs à créer de nouvelles métriques pour Bench et contribuant aux progrès dans le domaine de l'évaluation des modèles de langage.

Référence :

- [1] https://github.com/arthur-ai/bench

- [2] https://neurohive.io/en/news/arthur-bench-framework-for-evaluating- modèles de langage/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

Selon les informations de ce site le 1er août, SK Hynix a publié un article de blog aujourd'hui (1er août), annonçant sa participation au Global Semiconductor Memory Summit FMS2024 qui se tiendra à Santa Clara, Californie, États-Unis, du 6 au 8 août, présentant de nombreuses nouvelles technologies de produit. Introduction au Future Memory and Storage Summit (FutureMemoryandStorage), anciennement Flash Memory Summit (FlashMemorySummit) principalement destiné aux fournisseurs de NAND, dans le contexte de l'attention croissante portée à la technologie de l'intelligence artificielle, cette année a été rebaptisée Future Memory and Storage Summit (FutureMemoryandStorage) pour invitez les fournisseurs de DRAM et de stockage et bien d’autres joueurs. Nouveau produit SK hynix lancé l'année dernière

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Selon les informations de ce site Web du 5 juillet, GlobalFoundries a publié un communiqué de presse le 1er juillet de cette année, annonçant l'acquisition de la technologie de nitrure de gallium (GaN) et du portefeuille de propriété intellectuelle de Tagore Technology, dans l'espoir d'élargir sa part de marché dans l'automobile et Internet. des objets et des domaines d'application des centres de données d'intelligence artificielle pour explorer une efficacité plus élevée et de meilleures performances. Alors que des technologies telles que l’intelligence artificielle générative (GenerativeAI) continuent de se développer dans le monde numérique, le nitrure de gallium (GaN) est devenu une solution clé pour une gestion durable et efficace de l’énergie, notamment dans les centres de données. Ce site Web citait l'annonce officielle selon laquelle, lors de cette acquisition, l'équipe d'ingénierie de Tagore Technology rejoindrait GF pour développer davantage la technologie du nitrure de gallium. g

Iyo One : en partie casque, en partie ordinateur audio

Aug 08, 2024 am 01:03 AM

Iyo One : en partie casque, en partie ordinateur audio

Aug 08, 2024 am 01:03 AM

A tout moment, la concentration est une vertu. Auteur | Editeur Tang Yitao | Jing Yu La résurgence de l'intelligence artificielle a donné naissance à une nouvelle vague d'innovation matérielle. L’AIPin le plus populaire a rencontré des critiques négatives sans précédent. Marques Brownlee (MKBHD) l'a qualifié de pire produit qu'il ait jamais examiné ; David Pierce, rédacteur en chef de The Verge, a déclaré qu'il ne recommanderait à personne d'acheter cet appareil. Son concurrent, le RabbitR1, n'est guère mieux. Le plus grand doute à propos de cet appareil d'IA est qu'il ne s'agit évidemment que d'une application, mais Rabbit a construit un matériel de 200 $. De nombreuses personnes voient l’innovation matérielle en matière d’IA comme une opportunité de renverser l’ère des smartphones et de s’y consacrer.

Premier système d'IA de découverte scientifique entièrement automatisé, la startup auteur de Transformer, Sakana AI, lance AI Scientist

Aug 13, 2024 pm 04:43 PM

Premier système d'IA de découverte scientifique entièrement automatisé, la startup auteur de Transformer, Sakana AI, lance AI Scientist

Aug 13, 2024 pm 04:43 PM

Editeur | ScienceAI Il y a un an, Llion Jones, le dernier auteur de l'article Transformer de Google, a quitté son entreprise pour créer une entreprise et a cofondé la société d'intelligence artificielle SakanaAI avec l'ancien chercheur de Google, David Ha. SakanaAI prétend créer un nouveau modèle de base basé sur une intelligence inspirée de la nature ! Désormais, SakanaAI a remis sa feuille de réponses. SakanaAI annonce le lancement d'AIScientist, le premier système d'IA au monde pour la recherche scientifique automatisée et la découverte ouverte ! De la conception, l'écriture de code, la réalisation d'expériences et la synthèse des résultats, à la rédaction d'articles entiers et à la réalisation d'examens par les pairs, AIScientist ouvre la voie à la recherche et à l'accélération scientifiques basées sur l'IA.

Comment convertir les fichiers XML en PDF sur votre téléphone?

Apr 02, 2025 pm 10:12 PM

Comment convertir les fichiers XML en PDF sur votre téléphone?

Apr 02, 2025 pm 10:12 PM

Il est impossible de terminer la conversion XML à PDF directement sur votre téléphone avec une seule application. Il est nécessaire d'utiliser les services cloud, qui peuvent être réalisés via deux étapes: 1. Convertir XML en PDF dans le cloud, 2. Accédez ou téléchargez le fichier PDF converti sur le téléphone mobile.