Périphériques technologiques

Périphériques technologiques

Industrie informatique

Industrie informatique

Bibliothèque d'accélération NPU open source Intel, processeur Core Ultra AI PC peut exécuter de grands modèles de langage légers

Bibliothèque d'accélération NPU open source Intel, processeur Core Ultra AI PC peut exécuter de grands modèles de langage légers

Bibliothèque d'accélération NPU open source Intel, processeur Core Ultra AI PC peut exécuter de grands modèles de langage légers

Selon les informations du 4 mars, Intel a récemment publié sa bibliothèque d'accélération NPU sur GitHub. Cette décision permet aux PC IA équipés de processeurs Core Ultra d'exécuter plus facilement des modèles de langage légers à grande échelle tels que TinyLlama et Gemma-2b.

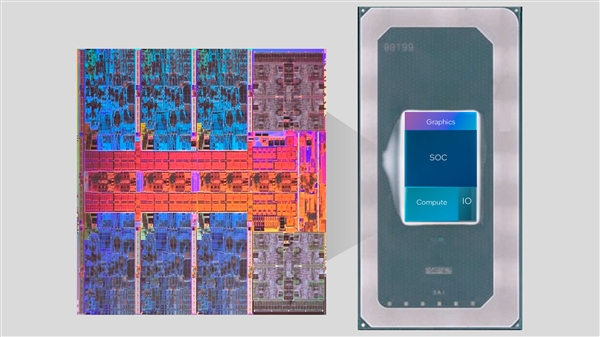

La série Core Ultra intègre pour la première fois le moteur NPU AI. Ce moteur peut gérer certaines tâches d'inférence d'IA légères et fonctionner avec le CPU et le GPU pour répondre aux exigences de diverses applications d'IA.

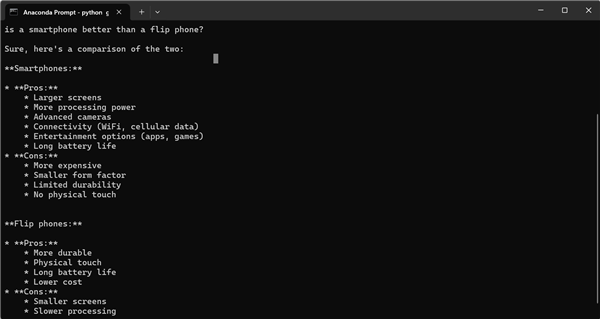

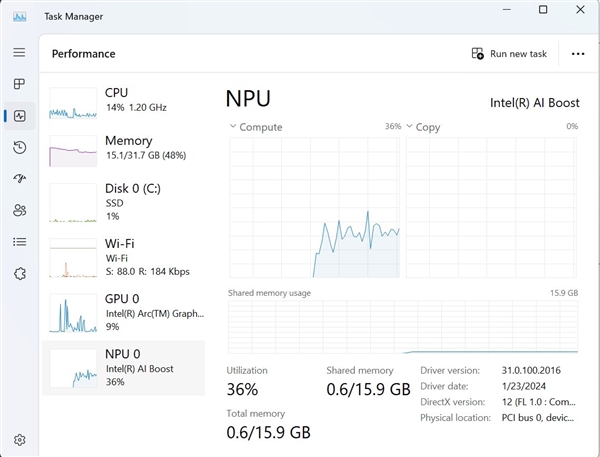

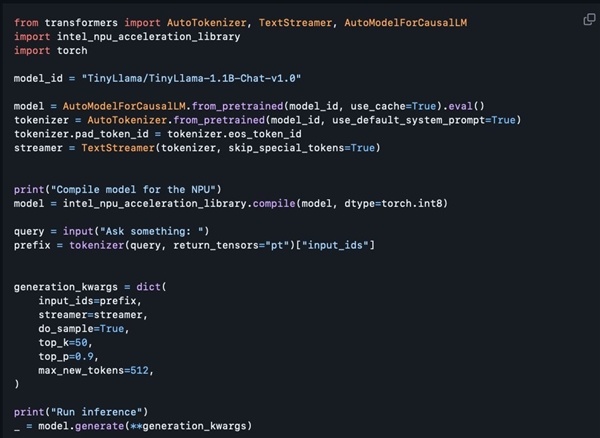

Il est entendu que bien que la bibliothèque d'accélération NPU publiée cette fois soit principalement préparée pour les développeurs, les utilisateurs ayant une certaine expérience en programmation peuvent également essayer de l'utiliser. Tony Mongkolsmai, architecte logiciel chez Intel, a montré comment exécuter un chatbot IA basé sur le grand modèle TinyLlama à 1,1 milliard de paramètres sur un ordinateur portable MSI Monarch 14 AI Evo, capable de mener des conversations simples. Dans le même temps, le Gestionnaire des tâches de Windows affiche également les appels valides vers le NPU.

Cependant, la bibliothèque d'accélération NPU open source actuelle présente encore quelques lacunes en termes de fonctionnalités. Elle prend en charge la quantification 8 bits et la précision FP16, mais ne prend pas encore en charge les fonctions avancées telles que la quantification 4 bits, la précision BF16 et la précision NPU. /GPU hybride, et la documentation technique pertinente n'a pas encore été fournie. Cependant, Intel a promis d'étendre progressivement ses fonctions à l'avenir, ce qui devrait doubler les fonctions existantes, ce qui apportera sans aucun doute plus de commodité et de possibilités aux développeurs d'IA.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Une fuite révèle les spécifications clés des Intel Arrow Lake-U, -H, -HX et -S

Jun 15, 2024 pm 09:49 PM

Une fuite révèle les spécifications clés des Intel Arrow Lake-U, -H, -HX et -S

Jun 15, 2024 pm 09:49 PM

Intel Arrow Lake devrait être basé sur la même architecture de processeur que Lunar Lake, ce qui signifie que les tout nouveaux cœurs de performance Lion Cove d'Intel seront combinés avec les cœurs d'efficacité économiques Skymont.

Beelink EQi12 se lance comme un mini PC plus puissant que l'EQ12

Aug 21, 2024 pm 08:37 PM

Beelink EQi12 se lance comme un mini PC plus puissant que l'EQ12

Aug 21, 2024 pm 08:37 PM

Beelink a lancé un nouveau mini PC, le EQi12. Il s'agit d'une version améliorée de l'EQ12 que la marque a introduite l'année dernière, fournie avec l'Intel N100. L'ordinateur le plus récent peut être équipé d'un processeur Intel Core i7 12650H, l'une des puces haut de gamme.

LG dévoile l'ordinateur portable Intel Lunar Lake le plus fin et le plus léger à ce jour avec le rafraîchissement LG Gram 16 Pro

Sep 10, 2024 am 06:44 AM

LG dévoile l'ordinateur portable Intel Lunar Lake le plus fin et le plus léger à ce jour avec le rafraîchissement LG Gram 16 Pro

Sep 10, 2024 am 06:44 AM

LG propose déjà le Gram 16 Pro avec des processeurs Intel Meteor Lake (prix actuel : 1 699,99 $ sur Amazon). Cependant, la société a décidé de remplacer l'architecture Meteor Lake d'Intel par Lunar Lake, qu'Intel a présentée à l'IFA 2024 à Berlin la semaine dernière. Ème

Qu'est-ce qu'Intel TXT ?

Jun 11, 2023 pm 06:57 PM

Qu'est-ce qu'Intel TXT ?

Jun 11, 2023 pm 06:57 PM

IntelTXT est une technologie de sécurité assistée par matériel lancée par Intel. Elle peut garantir l'intégrité et la sécurité du serveur lors du démarrage en établissant un espace protégé entre le processeur et le BIOS. Le nom complet de TXT est TrustedExecutionTechnology, qui signifie Trusted Execution Technology. En termes simples, TXT est une technologie de sécurité qui fournit une protection au niveau matériel pour garantir que le serveur n'a pas été modifié par des programmes malveillants ou des logiciels non autorisés lors de son démarrage. celui-ci

Bibliothèque d'accélération NPU open source Intel, processeur Core Ultra AI PC peut exécuter de grands modèles de langage légers

Mar 05, 2024 am 11:13 AM

Bibliothèque d'accélération NPU open source Intel, processeur Core Ultra AI PC peut exécuter de grands modèles de langage légers

Mar 05, 2024 am 11:13 AM

Selon des informations du 4 mars, Intel a récemment publié sa bibliothèque d'accélération NPU sur GitHub. Cette décision permet aux AIPC équipés de processeurs Core Ultra d'exécuter plus facilement des modèles de langage légers à grande échelle tels que TinyLlama et Gemma-2b. La série Core Ultra intègre pour la première fois le moteur NPUAI. Ce moteur peut gérer certaines tâches d'inférence d'IA légères et fonctionner avec le CPU et le GPU pour répondre aux exigences de diverses applications d'IA. Il est entendu que bien que la bibliothèque d'accélération NPU publiée cette fois soit principalement préparée pour les développeurs, les utilisateurs ayant une certaine expérience en programmation peuvent également essayer de l'utiliser. L'architecte logiciel Intel, Tony Mongkolsmai, montre comment

Yoga Slim 7i Aura Edition : Lenovo devance Samsung avec la nouvelle version d'un ordinateur portable léger Intel Lunar Lake

Sep 11, 2024 am 06:41 AM

Yoga Slim 7i Aura Edition : Lenovo devance Samsung avec la nouvelle version d'un ordinateur portable léger Intel Lunar Lake

Sep 11, 2024 am 06:41 AM

Lenovo a lancé le Yoga Slim 7i Aura Edition, moins d'une semaine après la présentation initiale de l'ordinateur portable basé sur Intel Lunar Lake. Veuillez noter que même si la société a révélé de nombreux détails sur l'ordinateur portable lors de l'IFA 2024 à Berlin, elle a choisi

Arc Battlemage : des fuites font allusion à trois GPU pour les cartes graphiques de jeu de nouvelle génération d'Intel

Jul 02, 2024 am 09:44 AM

Arc Battlemage : des fuites font allusion à trois GPU pour les cartes graphiques de jeu de nouvelle génération d'Intel

Jul 02, 2024 am 09:44 AM

L'architecture GPU de nouvelle génération d'Intel devrait être lancée en septembre dans le cadre d'Intel Lunar Lake. Comme l'iGPU Arc Alchemist de Meteor Lake, l'iGPU possède jusqu'à 8 cœurs Xe, mais la nouvelle architecture devrait atteindre des performances 50 % plus élevées.

IFA2024 | Lenovo ThinkPad X1 Carbon Gen 13 Aura Edition : le premier ThinkPad Lunar Lake de Lenovo presque aussi léger que le X1 Nano

Sep 06, 2024 am 06:50 AM

IFA2024 | Lenovo ThinkPad X1 Carbon Gen 13 Aura Edition : le premier ThinkPad Lunar Lake de Lenovo presque aussi léger que le X1 Nano

Sep 06, 2024 am 06:50 AM

Treize est connu pour être un grave manque. La superstition n’est cependant pas une vertu dans le secteur de la technologie. Pour Lenovo, la 13e génération de cet ordinateur portable haut de gamme devrait connaître le même succès que les douze prédécesseurs. A l'IFA, le plus grand fabricant de PC