Claude3 est sorti, dépassera-t-il complètement GPT-4 ?

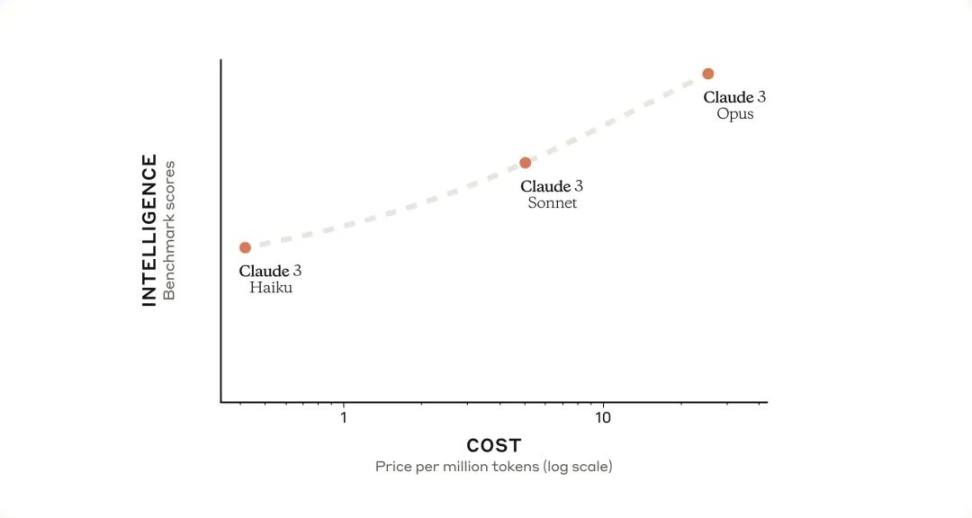

Tout à l'heure, Anthropic a annoncé le lancement de la série de modèles Claude 3, qui établit une nouvelle référence dans l'industrie pour un large éventail de tâches cognitives. La gamme comprend trois modèles de pointe, classés par ordre croissant de capacités : Claude 3 Haiku, Claude 3 Sonnet et Claude 3 Opus. Chaque modèle suivant offre des performances de plus en plus puissantes, permettant aux utilisateurs de choisir le meilleur équilibre entre intelligence, vitesse et coût pour leurs applications spécifiques.

Opus et Sonnet sont désormais disponibles dans claude.ai et dans l'API Claude, cette dernière étant désormais entièrement disponible dans 159 pays. Haïku sera bientôt disponible.

Série de modèles Claude 3

Une nouvelle norme en matière d'intelligence

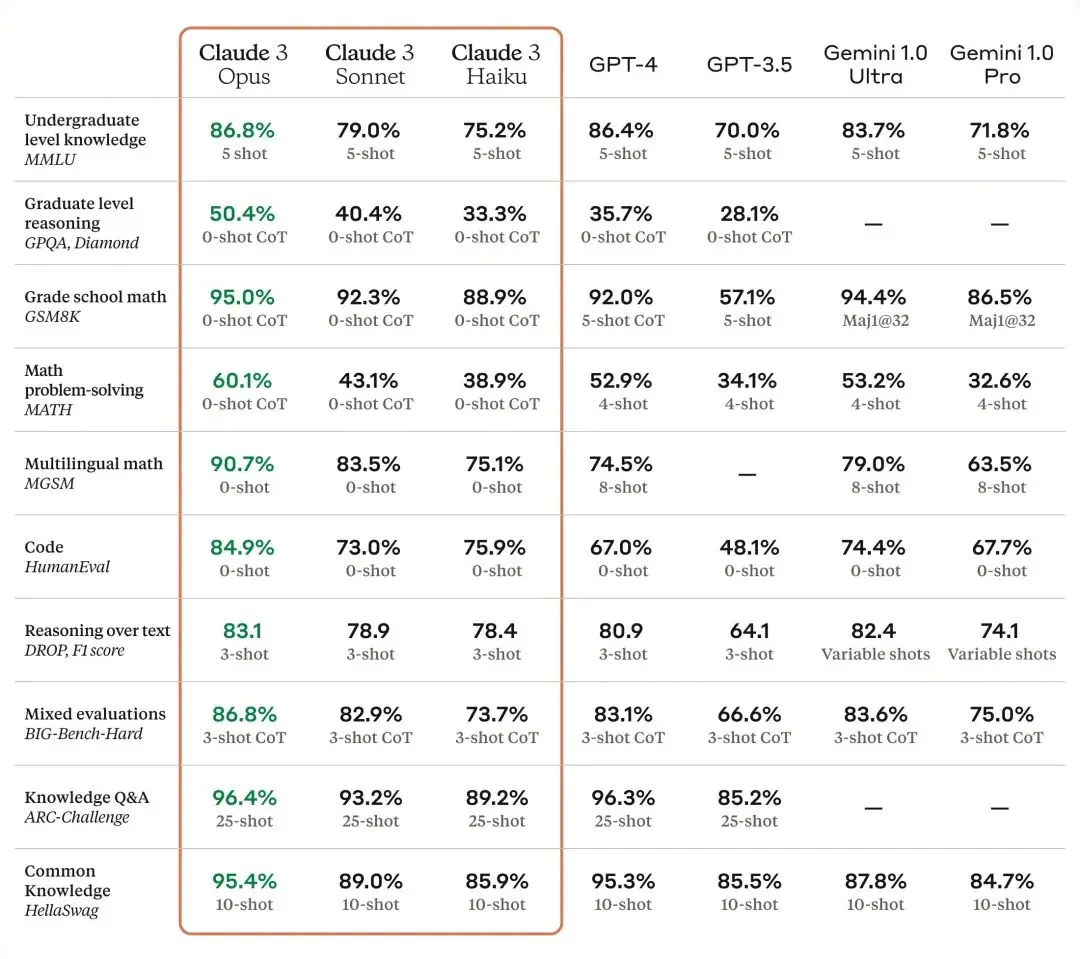

Opus, le modèle le plus intelligent d'Anthropic, fonctionne bien sur la plupart des critères d'évaluation courants des systèmes d'IA, y compris les connaissances expertes de premier cycle (MMLU) et le raisonnement expert de niveau supérieur (GPQA). ), mathématiques de base (GSM8K), etc. Il démontre une compréhension et une maîtrise proches du niveau humain sur des tâches complexes, à la pointe de l’intelligence générale.

Le modèle Claude 3 démontre de fortes capacités d'analyse et de prédiction, de création de contenu, de génération de code et de conduite de conversations dans des langues autres que l'anglais telles que l'espagnol, le japonais et le français.

Voici comment le modèle Claude 3 se compare à ses homologues Anthropic sur plusieurs tests de capacités[1] :

Résultats quasi instantanés

Le modèle Claude 3 peut prendre en charge les tâches de chat client instantané, de saisie semi-automatique et d'extraction de données, pour lesquelles les réponses doivent être immédiat et en temps réel.

Dans le domaine de l'intelligence, Haiku est un modèle extrêmement rentable avec la vitesse la plus rapide du marché. Il a été capable de déchiffrer un document de recherche arXiv riche en informations (~ 10 000 jetons) contenant des tableaux et des graphiques en moins de trois secondes. Anthropic optimisera encore ses performances dans un avenir proche, et les performances de Haiku seront également améliorées.

Sonnet est plus de 2 fois plus rapide que Claude 2 et Claude 2.1 pour la grande majorité des charges de travail, et possède un niveau d'intelligence plus élevé. Il excelle dans les tâches qui nécessitent des réponses rapides, telles que la récupération de connaissances ou l'automatisation des ventes. L'Opus est similaire en vitesse aux Claude 2 et 2.1, mais avec un niveau d'intelligence plus élevé.

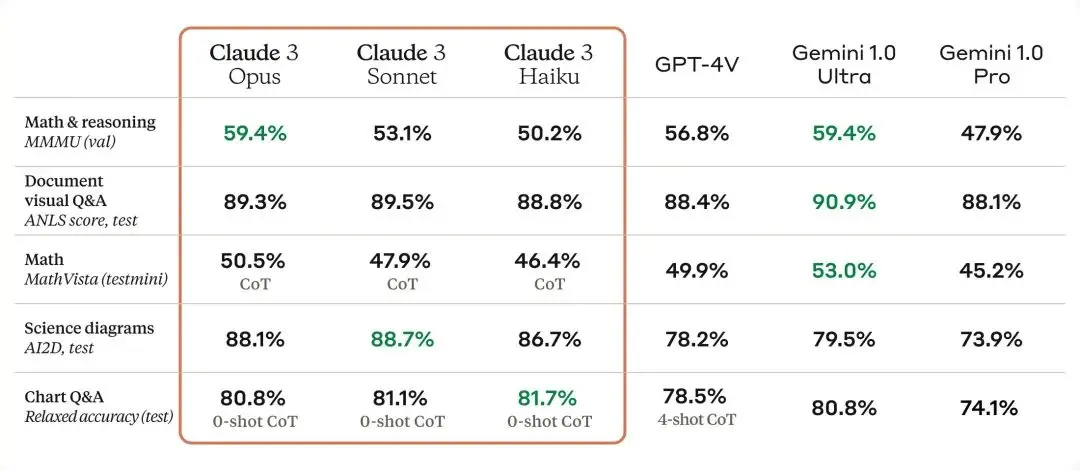

Capacités visuelles puissantes

Le modèle Claude 3 possède des capacités visuelles sophistiquées qui sont comparables à celles des autres modèles leaders. Ils peuvent gérer une variété de formats visuels, notamment des photos, des tableaux, des graphiques et des diagrammes techniques. Anthropic est particulièrement enthousiaste à l'idée de proposer cette nouvelle modalité aux entreprises clientes, dont certaines ont jusqu'à 50 % de leurs bases de connaissances encodées dans divers formats tels que des PDF, des organigrammes ou des diapositives de présentation.

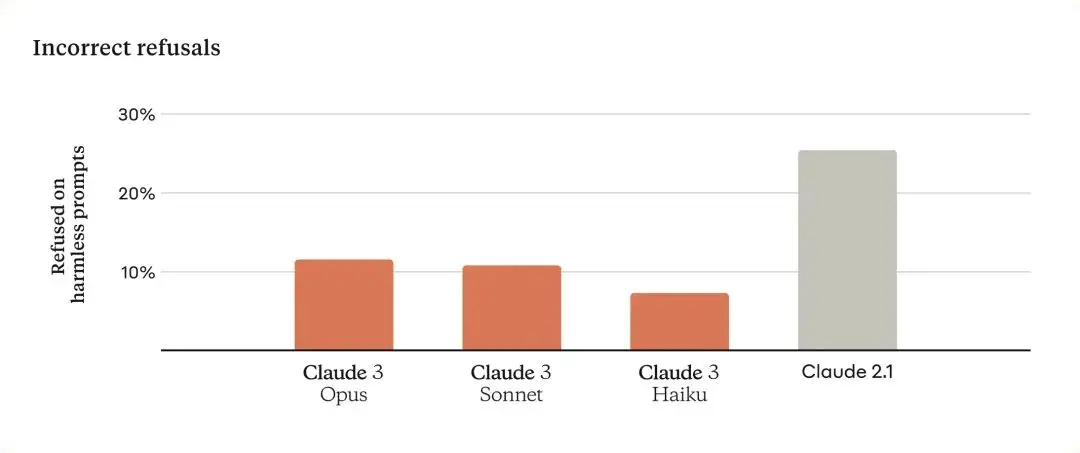

Réduction des rejets

Le modèle Claude précédent faisait souvent des rejets inutiles, indiquant un manque de compréhension contextuelle. Anthropic a fait des progrès substantiels à cet égard : Opus, Sonnet et Haiku sont nettement moins susceptibles de refuser de répondre aux invites qui s'approchent de la ligne d'alerte du système, bien moins que les modèles précédents. Comme le montre la figure ci-dessous, le modèle Claude 3 a une compréhension plus nuancée des demandes, identifie les préjudices réels et refuse beaucoup moins souvent de répondre à des invites inoffensives.

Précision améliorée

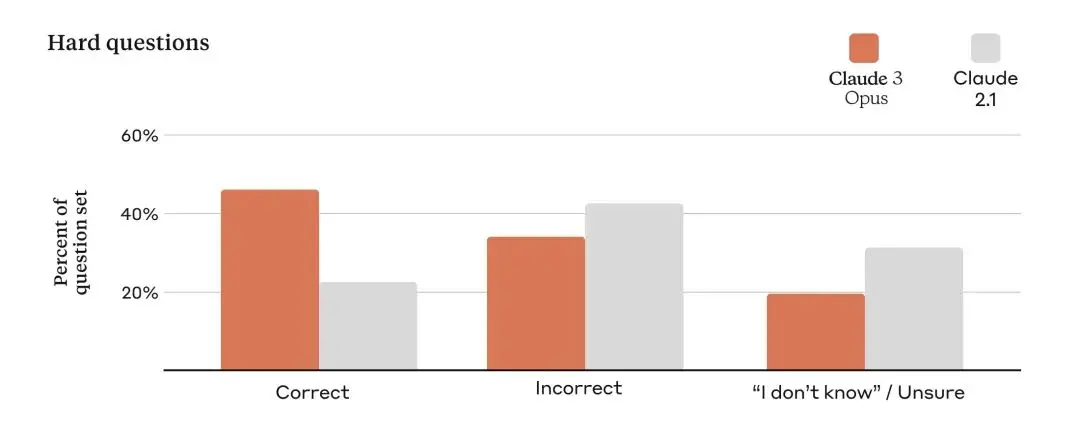

Les entreprises de toutes tailles s'appuient sur les modèles d'Anthropic pour servir leurs clients, il est donc essentiel que la sortie du modèle d'Anthropic reste très précise à grande échelle. Pour évaluer cela, Anthropic a utilisé un large ensemble de questions factuelles complexes ciblant les faiblesses connues des modèles actuels. Anthropic classe les réponses en réponses correctes, réponses incorrectes (ou hallucinations) et admissions d'incertitude, où le modèle exprime le fait de ne pas connaître la réponse plutôt que de fournir de fausses informations. Par rapport à Claude 2.1, Opus a obtenu une double amélioration de la précision (ou des réponses correctes) sur ces questions ouvertes difficiles tout en réduisant également le niveau de réponses incorrectes.

En plus de produire des réponses plus fiables, Anthropic permettra bientôt les citations dans les modèles Claude 3 d'Anthropic afin qu'ils puissent pointer vers des phrases précises dans les références pour vérifier leurs réponses.

Contexte long et rappel presque parfait

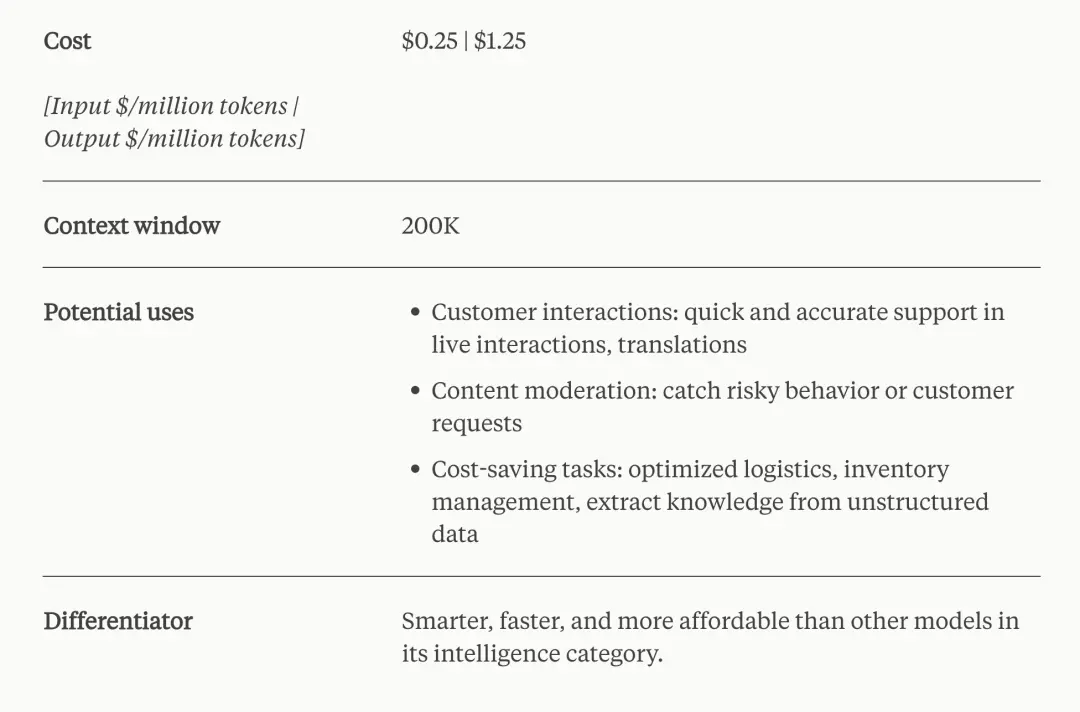

Les modèles Claude de la série 3 offriront une fenêtre contextuelle de 200 000 marques au lancement. Cependant, les trois modèles sont capables d'accepter des entrées de plus d'un million de jetons, qu'Anthropic peut proposer à des clients spécifiques qui ont besoin d'une puissance de traitement accrue.

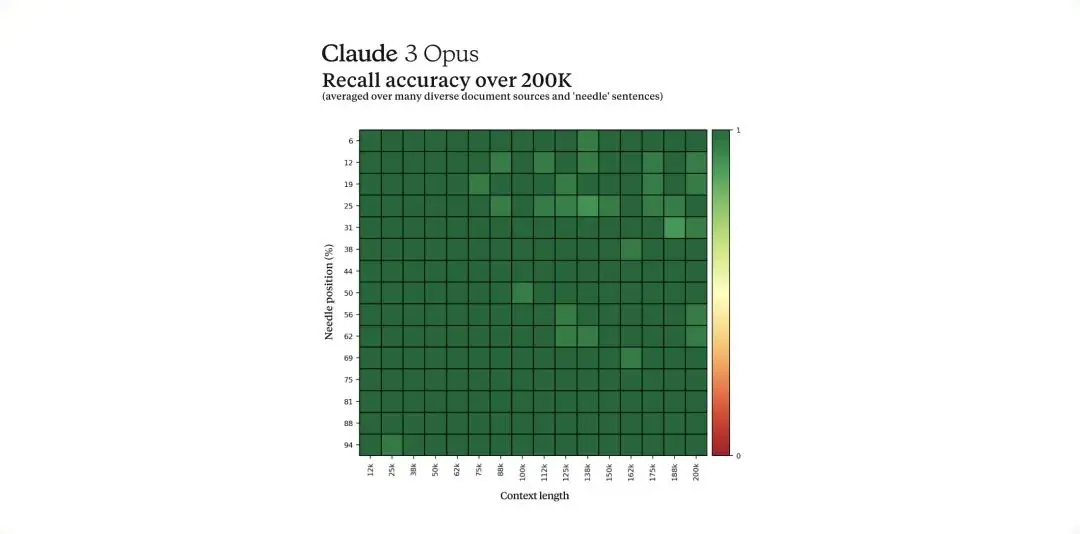

Afin de gérer efficacement les longs signaux contextuels, le modèle a besoin de fortes capacités de rappel. "Needle In A Haystack" (NIAH) évalue la capacité d'un modèle de mesure à rappeler avec précision les informations d'un vaste corpus de données. Anthropic améliore la robustesse de ce benchmark en utilisant l'une des 30 paires aléatoires d'épingles/questions pour chaque invite et en testant sur un corpus diversifié de documents issus du crowdsourcing.

Claude 3 Opus atteint non seulement un rappel presque parfait, dépassant 99 % de précision, mais dans certains cas, il identifie même les limites de l'évaluation elle-même en identifiant des phrases « aiguilles » qui semblent avoir été artificiellement insérées dans le texte original.

Conception responsable

Anthropic a développé la série de modèles Claude 3 pour offrir fiabilité et capacité. Anthropic dispose de plusieurs équipes dédiées au suivi et à l'atténuation des risques allant de la désinformation et du CSAM aux bioabus, en passant par l'ingérence électorale et les compétences de réplication autonome. Anthropic continue de développer des méthodes, telles que l'IA constitutionnelle, pour améliorer la sécurité et la transparence des modèles d'Anthropic, et pour ajuster les modèles d'Anthropic pour atténuer les problèmes de confidentialité qui peuvent découler des nouvelles modalités.

La lutte contre les biais dans des modèles de plus en plus complexes est un effort continu, et Anthropic progresse avec cette nouvelle version. Comme le montre la fiche modèle, Claude 3 montre moins de biais que le modèle précédent d'Anthropic selon le Bias Question Answering Benchmark (BBQ). Anthropic reste déterminé à faire progresser la technologie qui réduit les préjugés et favorise une plus grande neutralité dans les modèles, en garantissant qu'ils ne sont pas biaisés en faveur d'une position partisane particulière.

Bien que la série de modèles Claude 3 offre des améliorations en termes de connaissances biologiques, de connaissances liées à la cybersécurité et d'autonomie par rapport aux modèles précédents, elle reste au niveau de sécurité IA 2 (ASL-2) conformément à la politique de mise à l'échelle responsable d'Anthropic. L’évaluation de l’équipe rouge d’Anthropic (menée conformément aux engagements d’Anthropic à la Maison Blanche et au décret américain de 2023) a conclu que les modèles actuels présentent un potentiel négligeable de risque catastrophique. Anthropic continuera à surveiller de près les futurs modèles pour évaluer leur proximité avec le seuil ASL-3. Des détails de sécurité supplémentaires sont fournis sur la carte modèle Claude 3.

Plus facile à utiliser

Le modèle Claude 3 fonctionne mieux pour suivre des instructions complexes en plusieurs étapes. Ils sont particulièrement doués pour suivre les directives de voix et de réponse de la marque et pour développer des expériences client auxquelles les utilisateurs peuvent avoir confiance. De plus, le modèle Claude 3 est plus performant pour générer des sorties structurées populaires, telles que les formats JSON, ce qui facilite le coaching de Claude pour des cas d'utilisation tels que la classification du langage naturel et l'analyse des sentiments.

Détails du modèle

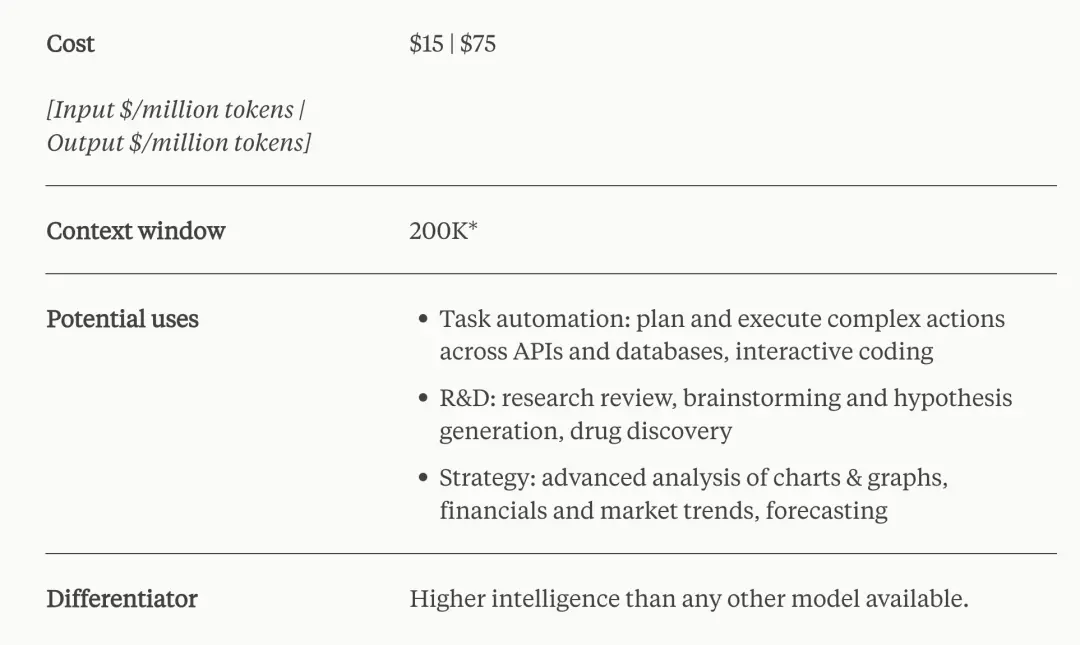

Claude 3 Opus est le modèle le plus intelligent d'Anthropic, affichant les meilleures performances du marché sur des tâches très complexes. Il se déroule brillamment dans des invites ouvertes et des situations invisibles, avec une compréhension humaine. Opus montre à Anthropic les limites de ce qui est possible avec l'IA générative.

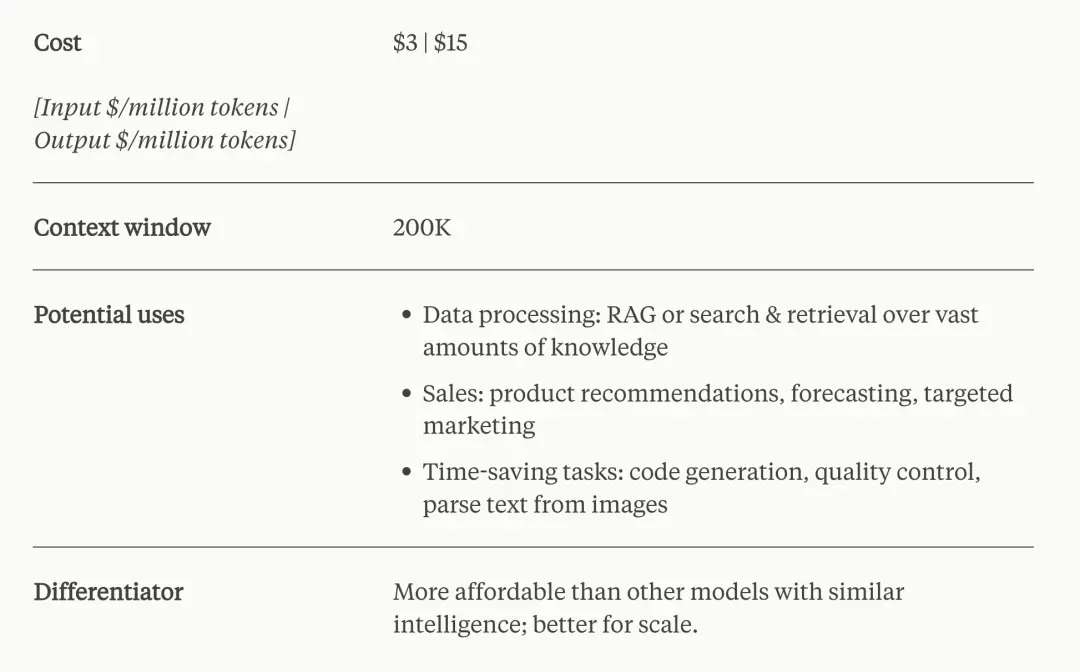

Claude 3 Sonnet atteint l'équilibre idéal entre intelligence et vitesse, en particulier pour les charges de travail d'entreprise. Il offre des performances puissantes à un coût inférieur à celui de ses pairs et est conçu pour offrir une durabilité élevée pour les déploiements d'IA à grande échelle.

Claude 3 Haiku est le modèle Anthropic le plus rapide et le plus compact, permettant une réponse presque instantanée. Il répond aux requêtes et requêtes simples avec une rapidité inégalée. Les utilisateurs pourront créer des expériences d’IA transparentes qui simulent les interactions humaines.

Disponibilité des modèles

Opus et Sonnet sont disponibles aujourd'hui dans l'API d'Anthropic, qui est désormais généralement disponible et les développeurs peuvent s'inscrire et commencer à utiliser ces modèles immédiatement. Haïku sera bientôt disponible. Sonnet alimente l'expérience gratuite sur claude.ai, tandis qu'Opus est disponible pour les abonnés Claude Pro.

Sonnet est également disponible via Bedrock d'Amazon et Vertex AI Model Garden de Google Cloud, avec Opus et Haiku à venir.

Plus intelligent, plus rapide, plus sûr

Anthropic estime que l'intelligence des modèles est loin d'atteindre ses limites et prévoit de mettre à jour fréquemment la série de modèles Claude 3 au cours des prochains mois. Anthropic est également heureux de publier une série de fonctionnalités visant à améliorer les capacités des modèles Anthropic, en particulier pour les cas d'utilisation en entreprise et les déploiements à grande échelle. Ces nouvelles fonctionnalités incluront l'utilisation d'outils (également appelés appels de fonction), le codage interactif (également appelé REPL) et des capacités d'agent plus avancées.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelles sont les dix principales plateformes de trading de devises virtuelles?

Feb 20, 2025 pm 02:15 PM

Quelles sont les dix principales plateformes de trading de devises virtuelles?

Feb 20, 2025 pm 02:15 PM

Avec la popularité des crypto-monnaies, des plateformes de trading de devises virtuelles ont émergé. Les dix principales plateformes de trading de devises virtuelles au monde sont classées comme suit selon le volume des transactions et la part de marché: Binance, Coinbase, FTX, Kucoin, Crypto.com, Kraken, Huobi, Gate.io, Bitfinex, Gemini. Ces plateformes offrent un large éventail de services, allant d'un large éventail de choix de crypto-monnaie à la négociation des dérivés, adapté aux commerçants de niveaux différents.

Comment ajuster l'échange ouvert en sésame en chinois

Mar 04, 2025 pm 11:51 PM

Comment ajuster l'échange ouvert en sésame en chinois

Mar 04, 2025 pm 11:51 PM

Comment ajuster l'échange ouvert en sésame en chinois? Ce didacticiel couvre des étapes détaillées sur les ordinateurs et les téléphones mobiles Android, de la préparation préliminaire aux processus opérationnels, puis à la résolution de problèmes communs, vous aidant à changer facilement l'interface d'échange Open Sesame aux chinois et à démarrer rapidement avec la plate-forme de trading.

Dois-je utiliser Flexbox au centre de l'image bootstrap?

Apr 07, 2025 am 09:06 AM

Dois-je utiliser Flexbox au centre de l'image bootstrap?

Apr 07, 2025 am 09:06 AM

Il existe de nombreuses façons de centrer des photos de bootstrap, et vous n'avez pas à utiliser Flexbox. Si vous avez seulement besoin de centrer horizontalement, la classe de cent texte est suffisante; Si vous devez centrer verticalement ou plusieurs éléments, Flexbox ou Grid convient plus. Flexbox est moins compatible et peut augmenter la complexité, tandis que Grid est plus puissant et a un coût d'enseignement supérieur. Lorsque vous choisissez une méthode, vous devez peser les avantages et les inconvénients et choisir la méthode la plus appropriée en fonction de vos besoins et préférences.

Top 10 des plates-formes de trading de devises virtuelles 2025 Applications de trading de crypto-monnaie classée top dix

Mar 17, 2025 pm 05:54 PM

Top 10 des plates-formes de trading de devises virtuelles 2025 Applications de trading de crypto-monnaie classée top dix

Mar 17, 2025 pm 05:54 PM

Top dix plates-formes de trading de devises virtuelles 2025: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. BitFinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Top 10 des plates-formes de trading de crypto-monnaie, les dix principales applications de plate-forme de trading de devises recommandées

Mar 17, 2025 pm 06:03 PM

Top 10 des plates-formes de trading de crypto-monnaie, les dix principales applications de plate-forme de trading de devises recommandées

Mar 17, 2025 pm 06:03 PM

Les dix principales plates-formes de trading de crypto-monnaie comprennent: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. BitFinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Quelles sont les plates-formes de monnaie numérique sûres et fiables?

Mar 17, 2025 pm 05:42 PM

Quelles sont les plates-formes de monnaie numérique sûres et fiables?

Mar 17, 2025 pm 05:42 PM

Une plate-forme de monnaie numérique sûre et fiable: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. Bitfinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Comment calculer C-SUBScript 3 Indice 5 C-SUBScript 3 Indice Indice 5 Tutoriel d'algorithme

Apr 03, 2025 pm 10:33 PM

Comment calculer C-SUBScript 3 Indice 5 C-SUBScript 3 Indice Indice 5 Tutoriel d'algorithme

Apr 03, 2025 pm 10:33 PM

Le calcul de C35 est essentiellement des mathématiques combinatoires, représentant le nombre de combinaisons sélectionnées parmi 3 des 5 éléments. La formule de calcul est C53 = 5! / (3! * 2!), Qui peut être directement calculé par des boucles pour améliorer l'efficacité et éviter le débordement. De plus, la compréhension de la nature des combinaisons et la maîtrise des méthodes de calcul efficaces est cruciale pour résoudre de nombreux problèmes dans les domaines des statistiques de probabilité, de la cryptographie, de la conception d'algorithmes, etc.

Applications de logiciels de monnaie virtuels sûrs recommandés Top 10 des applications de trading de devises numériques classement 2025

Mar 17, 2025 pm 05:48 PM

Applications de logiciels de monnaie virtuels sûrs recommandés Top 10 des applications de trading de devises numériques classement 2025

Mar 17, 2025 pm 05:48 PM

Recommandés Applications logicielles de monnaie virtuelle recommandées: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. Bitfinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.