Périphériques technologiques

Périphériques technologiques

IA

IA

Anything in Any Scene : Insertion d'objets réalistes (pour aider à la synthèse de diverses données de conduite)

Anything in Any Scene : Insertion d'objets réalistes (pour aider à la synthèse de diverses données de conduite)

Anything in Any Scene : Insertion d'objets réalistes (pour aider à la synthèse de diverses données de conduite)

Titre original : Anything in Any Scene : Photorealistic Video Object Insertion

Lien papier : https://arxiv.org/pdf/2401.17509.pdf

Lien code : https://github.com/AnythingInAnyScene/anything_in_anyscene

Affiliation de l'auteur : Xpeng Motors

Idée de thèse

La simulation vidéo réaliste a montré un grand potentiel dans divers domaines d'application, de la réalité virtuelle à la production cinématographique. Surtout lorsque la capture vidéo dans le monde réel est peu pratique ou coûteuse. Les méthodes existantes de simulation vidéo ne parviennent souvent pas à modéliser avec précision les environnements d'éclairage, à représenter la géométrie des objets ou à atteindre des niveaux élevés de photoréalisme. Cet article propose Anything in Any Scene, un cadre de simulation vidéo réelle novateur et polyvalent qui peut insérer de manière transparente n'importe quel objet dans des vidéos dynamiques existantes et mettre l'accent sur le réalisme physique. Le cadre global proposé dans cet article contient trois processus clés : 1) intégrer des objets réels dans une scène vidéo donnée et les placer dans des emplacements appropriés pour garantir le réalisme géométrique ; 2) estimer la distribution de l'éclairage du ciel et de l'environnement et simuler des ombres réelles et améliorer le réalisme de la lumière ; 3) Utilisez un réseau de transfert de style pour affiner la sortie vidéo finale afin de maximiser le réalisme photo. Cet article prouve expérimentalement que le framework Anything in Any Scene peut générer des vidéos de simulation avec un excellent réalisme géométrique, réalisme d'éclairage et réalisme photo. En atténuant considérablement les défis associés à la génération de données vidéo, notre cadre fournit une solution efficace et rentable pour obtenir des vidéos de haute qualité. De plus, ses applications s'étendent bien au-delà de l'amélioration des données vidéo, montrant un potentiel prometteur dans la réalité virtuelle, le montage vidéo et diverses autres applications centrées sur la vidéo.

Contribution principale

Cet article présente un cadre de simulation vidéo novateur et extensible Anything in Any Scene, capable d'intégrer n'importe quel objet dans n'importe quelle vidéo de scène dynamique.

Cet article est structuré de manière unique et se concentre sur le maintien de la géométrie, de l'éclairage et du photoréalisme dans les simulations vidéo afin de garantir une haute qualité et l'authenticité des résultats de sortie.

Après une vérification approfondie, les résultats montrent que le framework a la capacité de produire des simulations vidéo très réalistes, élargissant ainsi considérablement la portée d'application et le potentiel de développement de ce domaine.

Conception de thèse

Les simulations d'images et de vidéos sont utilisées avec succès dans une variété d'applications allant de la réalité virtuelle à la production cinématographique. La capacité de générer un contenu visuel diversifié et de haute qualité grâce à la simulation d’images et de vidéos photoréalistes a le potentiel de faire progresser ces domaines, en introduisant de nouvelles possibilités et applications. Même si l’authenticité des images et des vidéos capturées dans le monde réel est inestimable, elles sont souvent limitées par des distributions à longue traîne. Cela conduit à une surreprésentation des scénarios courants et à une sous-représentation de situations rares mais critiques, ce qui présente un défi connu sous le nom de problème de non-distribution. Les méthodes traditionnelles permettant de remédier à ces limitations via la capture et le montage vidéo se sont révélées peu pratiques ou d'un coût prohibitif, car il était difficile de couvrir tous les scénarios possibles. L'importance de la simulation vidéo, notamment en intégrant des vidéos existantes avec des objets nouvellement insérés, devient cruciale pour surmonter ces défis. En générant un contenu visuel à grande échelle, diversifié et réaliste, la simulation vidéo contribue à enrichir les applications de réalité virtuelle, de montage vidéo et d'augmentation des données vidéo.

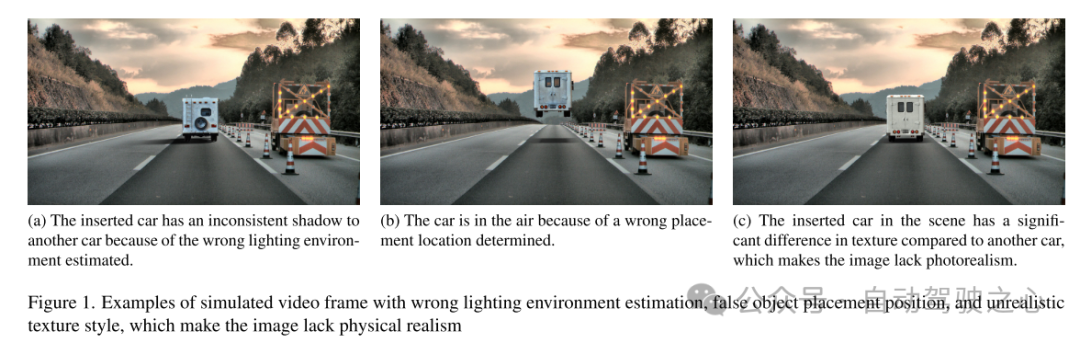

Cependant, générer des vidéos de simulation réalistes en tenant compte du réalisme physique reste un problème ouvert et difficile. Les méthodes existantes présentent souvent des limites en se concentrant sur des paramètres spécifiques, en particulier les environnements intérieurs [9, 26, 45, 46, 57]. Ces méthodes peuvent ne pas répondre de manière adéquate à la complexité des scènes extérieures, notamment aux conditions d'éclairage variables et aux objets en mouvement rapide. Les méthodes reposant sur l'enregistrement de modèles 3D se limitent à intégrer des classes limitées d'objets [12, 32, 40, 42]. De nombreuses méthodes ignorent des facteurs importants tels que la modélisation de l'environnement lumineux, le placement correct des objets et l'obtention du réalisme [12, 36]. Le cas d’échec est illustré à la figure 1. Par conséquent, ces limitations limitent considérablement leur application dans les domaines qui nécessitent des simulations vidéo de scènes hautement évolutives, géométriquement cohérentes et réalistes, telles que la conduite autonome et la robotique.

Cet article propose Anything in Any Scene, un cadre complet pour l'insertion d'objets vidéo photoréalistes qui répond à ces défis. Le cadre est conçu pour être polyvalent et adapté aux scènes intérieures et extérieures, garantissant une précision physique en termes de réalisme géométrique, de réalisme d'éclairage et de photoréalisme. L'objectif de cet article est de créer des simulations vidéo qui sont non seulement utiles pour l'augmentation des données visuelles dans l'apprentissage automatique, mais également adaptées à diverses applications vidéo telles que la réalité virtuelle et le montage vidéo.

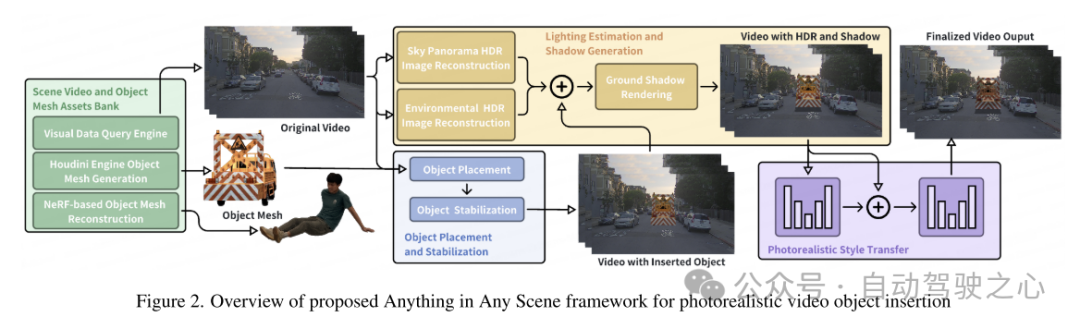

L'aperçu du cadre Anything in Any Scene de cet article est présenté dans la figure 2. Cet article détaille notre pipeline novateur et évolutif pour créer une bibliothèque d'actifs diversifiée de vidéos de scène et de maillages d'objets dans la section 3. Cet article présente un moteur de requête de données visuelles conçu pour récupérer efficacement des clips vidéo pertinents à partir de requêtes visuelles à l'aide de mots-clés descriptifs. Ensuite, cet article propose deux méthodes pour générer des maillages 3D, en tirant parti des ressources 3D existantes ainsi que de la reconstruction d'images multi-vues. Cela permet l'insertion sans restriction de n'importe quel objet souhaité, même s'il est très irrégulier ou sémantiquement faible. Dans la section 4, l'article détaille les méthodes d'intégration d'objets dans des vidéos de scènes dynamiques, en se concentrant sur le maintien du réalisme physique. Cet article conçoit la méthode de placement et de stabilisation d'objet décrite dans la section 4.1 pour garantir que l'objet inséré est ancré de manière stable sur des images vidéo consécutives. Pour relever le défi de la création d'effets d'éclairage et d'ombre réalistes, cet article estime l'éclairage du ciel et de l'environnement et génère des ombres réalistes pendant le rendu, comme décrit dans la section 4.2. Les images vidéo simulées générées contiennent inévitablement des artefacts irréalistes qui diffèrent de la vidéo capturée dans le monde réel, tels que des différences de qualité d'image en termes de niveaux de bruit, de fidélité des couleurs et de netteté. Cet article utilise un réseau de transfert de style pour améliorer le réalisme photographique dans la section 4.3.

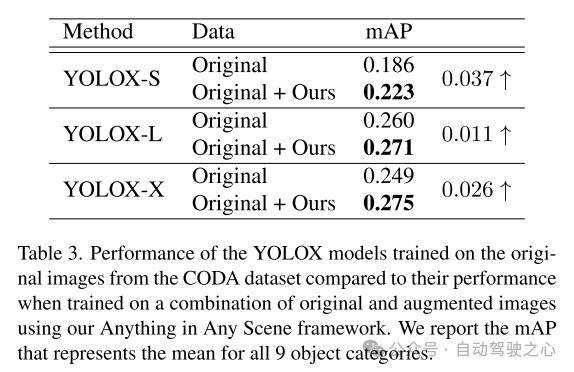

Les vidéos de simulation générées à partir du cadre proposé dans cet article atteignent un degré élevé de réalisme d'éclairage, de réalisme géométrique et de réalisme photo, surpassant les autres vidéos en qualité et en quantité, comme le montre la section 5.3. Cet article démontre en outre l'application de la vidéo de simulation de cet article dans les algorithmes de perception de formation dans la section 5.4 pour vérifier sa valeur pratique. Le cadre Anything in Any Scene permet la création d'ensembles de données vidéo à grande échelle et à faible coût pour l'augmentation des données avec un gain de temps et une qualité visuelle réaliste, allégeant ainsi le fardeau de la génération de données vidéo et améliorant potentiellement la longue traîne et les sorties. défis de distribution. Grâce à sa conception générale, le framework Anything in Any Scene peut facilement intégrer des modèles améliorés et de nouveaux modules, tels que des méthodes améliorées de reconstruction de maillage 3D, pour améliorer encore les performances de simulation vidéo.

Figure 1. Exemples d'images vidéo simulées avec des erreurs dans l'estimation de l'environnement d'éclairage, des erreurs dans le placement des objets et des styles de texture irréalistes. Ces problèmes font que l'image manque de réalisme physique.

Figure 1. Exemples d'images vidéo simulées avec des erreurs dans l'estimation de l'environnement d'éclairage, des erreurs dans le placement des objets et des styles de texture irréalistes. Ces problèmes font que l'image manque de réalisme physique.  Figure 2. Présentation du cadre Anything in Any Scene pour l'insertion d'objets vidéo photoréalistes

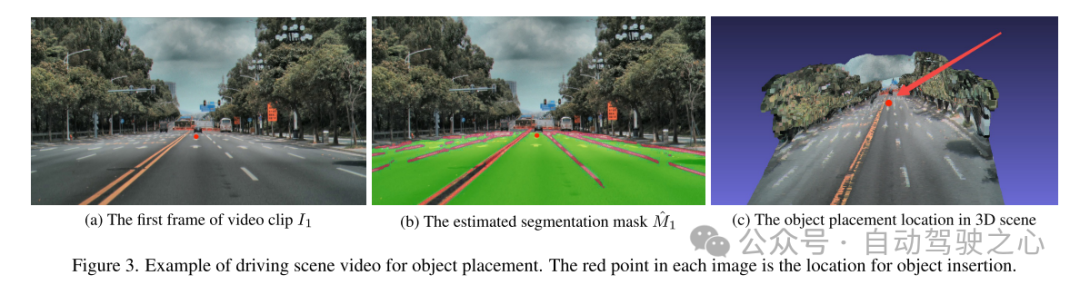

Figure 2. Présentation du cadre Anything in Any Scene pour l'insertion d'objets vidéo photoréalistes  Figure 3. Exemple de vidéo de scène de conduite pour le placement d'objets. Les points rouges sur chaque image correspondent à l'endroit où les objets ont été insérés.

Figure 3. Exemple de vidéo de scène de conduite pour le placement d'objets. Les points rouges sur chaque image correspondent à l'endroit où les objets ont été insérés.

Résultats expérimentaux

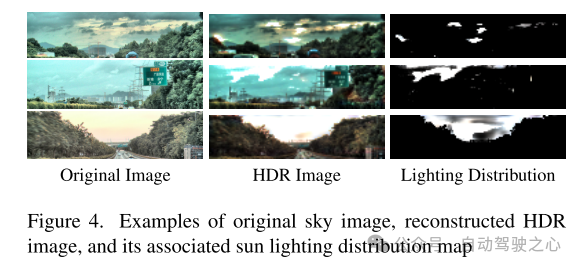

Figure 4. Exemples d'images originales du ciel, d'images HDR reconstruites et de leurs cartes de répartition de l'éclairage solaire associées

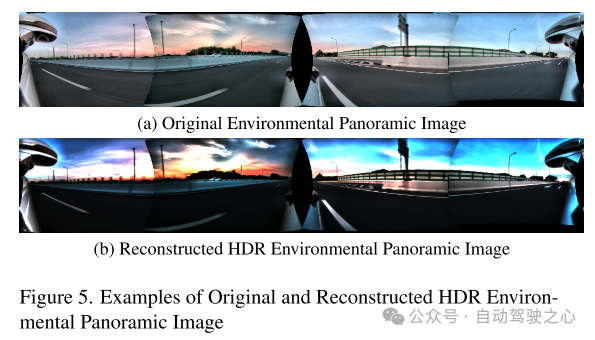

Figure 5. Exemples d'images panoramiques d'environnement HDR originales et reconstruites

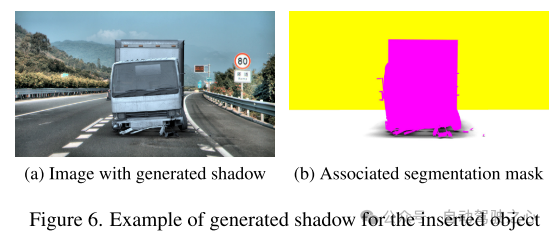

Figure 6. Exemple de génération d'ombres pour les objets insérés

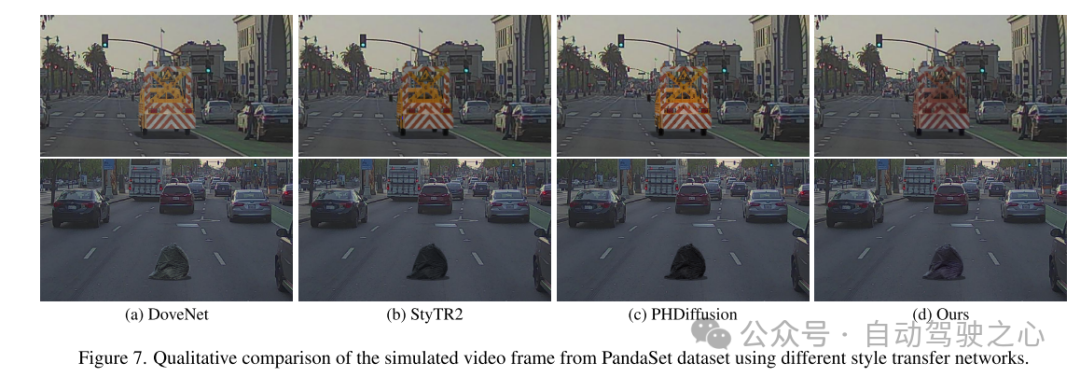

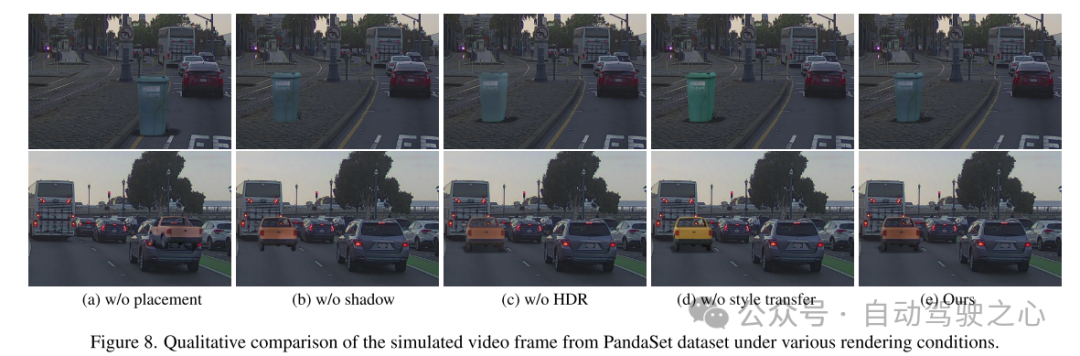

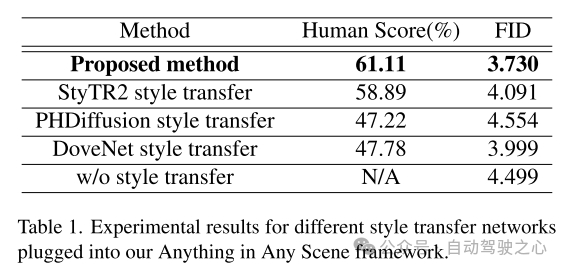

Figure 7. Comparaison qualitative des images vidéo simulées à partir de l'ensemble de données PandaSet à l'aide de réseaux de transfert de différents styles.

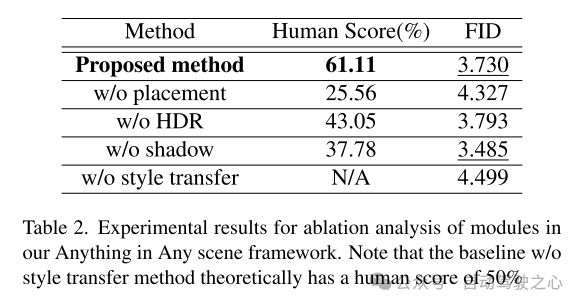

Figure 8. Comparaison qualitative des images vidéo simulées à partir de l'ensemble de données PandaSet dans diverses conditions de rendu.

Résumé :

Cet article propose un cadre innovant et extensible, "Anything in Any Scene", conçu pour la simulation vidéo réaliste. Le cadre proposé dans cet article intègre de manière transparente divers objets dans différentes vidéos dynamiques, garantissant ainsi la préservation du réalisme géométrique, du réalisme de l'éclairage et du photoréalisme. Grâce à de nombreuses démonstrations, cet article démontre son efficacité pour atténuer les défis associés à la collecte et à la génération de données vidéo, en fournissant des solutions rentables et permettant de gagner du temps pour une variété de scénarios. L'application de notre cadre montre des améliorations significatives dans les tâches de perception en aval, en particulier dans la résolution du problème de distribution à longue traîne dans la détection d'objets. La flexibilité de notre framework permet l'intégration directe de modèles améliorés pour chaque module, et notre framework pose une base solide pour l'exploration et l'innovation futures dans le domaine de la simulation vidéo réaliste.

Citation :

Bai C, Shao Z, Zhang G et al. Tout dans n'importe quelle scène : insertion d'objet vidéo photoréaliste [J].

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1662

1662

14

14

1418

1418

52

52

1311

1311

25

25

1261

1261

29

29

1234

1234

24

24

Comment enregistrer une vidéo d'écran avec un téléphone OPPO (opération simple)

May 07, 2024 pm 06:22 PM

Comment enregistrer une vidéo d'écran avec un téléphone OPPO (opération simple)

May 07, 2024 pm 06:22 PM

Compétences de jeu ou démonstrations pédagogiques, dans la vie quotidienne, nous avons souvent besoin d'utiliser des téléphones portables pour enregistrer des vidéos d'écran afin de montrer certaines étapes de fonctionnement. Sa fonction d'enregistrement vidéo sur écran est également très bonne et le téléphone mobile OPPO est un smartphone puissant. Vous permettant d'effectuer la tâche d'enregistrement facilement et rapidement, cet article présentera en détail comment utiliser les téléphones mobiles OPPO pour enregistrer des vidéos d'écran. Préparation - Déterminer les objectifs d'enregistrement Vous devez clarifier vos objectifs d'enregistrement avant de commencer. Voulez-vous enregistrer une vidéo de démonstration étape par étape ? Ou souhaitez-vous enregistrer un merveilleux moment d'un jeu ? Ou souhaitez-vous enregistrer une vidéo pédagogique ? Seulement en organisant mieux le processus d’enregistrement et en fixant des objectifs clairs. Ouvrez la fonction d'enregistrement d'écran du téléphone mobile OPPO et recherchez-la dans le panneau de raccourcis. La fonction d'enregistrement d'écran se trouve dans le panneau de raccourcis.

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

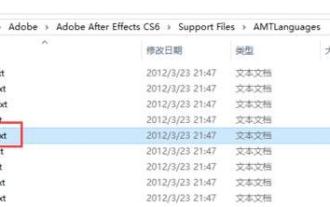

Comment changer de langue dans Adobe After Effects cs6 (Ae cs6) Étapes détaillées pour basculer entre le chinois et l'anglais dans Ae cs6 - Téléchargement ZOL

May 09, 2024 pm 02:00 PM

Comment changer de langue dans Adobe After Effects cs6 (Ae cs6) Étapes détaillées pour basculer entre le chinois et l'anglais dans Ae cs6 - Téléchargement ZOL

May 09, 2024 pm 02:00 PM

1. Recherchez d’abord le dossier AMTLanguages . Nous avons trouvé de la documentation dans le dossier AMTLanguages. Si vous installez le chinois simplifié, il y aura un document texte zh_CN.txt (le contenu du texte est : zh_CN). Si vous l'avez installé en anglais, il y aura un document texte en_US.txt (le contenu du texte est : en_US). 3. Par conséquent, si nous voulons passer au chinois, nous devons créer un nouveau document texte de zh_CN.txt (le contenu du texte est : zh_CN) sous le chemin AdobeAfterEffectsCCSupportFilesAMTLanguages . 4. Au contraire, si on veut passer à l'anglais,

Comment filmer des vidéos sur TikTok ? Comment allumer le microphone pour l'enregistrement vidéo ?

May 09, 2024 pm 02:40 PM

Comment filmer des vidéos sur TikTok ? Comment allumer le microphone pour l'enregistrement vidéo ?

May 09, 2024 pm 02:40 PM

En tant que l’une des plateformes de vidéos courtes les plus populaires aujourd’hui, la qualité et l’effet des vidéos de Douyin affectent directement l’expérience visuelle de l’utilisateur. Alors, comment filmer des vidéos de haute qualité sur TikTok ? 1. Comment filmer des vidéos sur Douyin ? 1. Ouvrez l'application Douyin et cliquez sur le bouton « + » au milieu en bas pour accéder à la page de tournage vidéo. 2. Douyin propose une variété de modes de prise de vue, notamment la prise de vue normale, le ralenti, la vidéo courte, etc. Choisissez le mode de prise de vue approprié en fonction de vos besoins. 3. Sur la page de prise de vue, cliquez sur le bouton « Filtre » en bas de l'écran pour choisir différents effets de filtre afin de rendre la vidéo plus personnalisée. 4. Si vous devez ajuster des paramètres tels que l'exposition et le contraste, vous pouvez cliquer sur le bouton « Paramètres » dans le coin inférieur gauche de l'écran pour le définir. 5. Pendant la prise de vue, vous pouvez cliquer sur le côté gauche de l'écran

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Afin d'aligner les grands modèles de langage (LLM) sur les valeurs et les intentions humaines, il est essentiel d'apprendre les commentaires humains pour garantir qu'ils sont utiles, honnêtes et inoffensifs. En termes d'alignement du LLM, une méthode efficace est l'apprentissage par renforcement basé sur le retour humain (RLHF). Bien que les résultats de la méthode RLHF soient excellents, certains défis d’optimisation sont impliqués. Cela implique de former un modèle de récompense, puis d'optimiser un modèle politique pour maximiser cette récompense. Récemment, certains chercheurs ont exploré des algorithmes hors ligne plus simples, dont l’optimisation directe des préférences (DPO). DPO apprend le modèle politique directement sur la base des données de préférence en paramétrant la fonction de récompense dans RLHF, éliminant ainsi le besoin d'un modèle de récompense explicite. Cette méthode est simple et stable

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : cet article est dédié à la résolution des principaux défis des grands modèles de langage multimodaux (MLLM) actuels dans les applications de conduite autonome, c'est-à-dire le problème de l'extension des MLLM de la compréhension 2D à l'espace 3D. Cette expansion est particulièrement importante car les véhicules autonomes (VA) doivent prendre des décisions précises concernant les environnements 3D. La compréhension spatiale 3D est essentielle pour les véhicules utilitaires car elle a un impact direct sur la capacité du véhicule à prendre des décisions éclairées, à prédire les états futurs et à interagir en toute sécurité avec l’environnement. Les modèles de langage multimodaux actuels (tels que LLaVA-1.5) ne peuvent souvent gérer que des entrées d'images de résolution inférieure (par exemple) en raison des limitations de résolution de l'encodeur visuel et des limitations de la longueur de la séquence LLM. Cependant, les applications de conduite autonome nécessitent