Périphériques technologiques

Périphériques technologiques

IA

IA

Tsinghua NLP Group a publié InfLLM : Aucune formation supplémentaire requise, « 1024K contexte ultra-long » rappel à 100 % !

Tsinghua NLP Group a publié InfLLM : Aucune formation supplémentaire requise, « 1024K contexte ultra-long » rappel à 100 % !

Tsinghua NLP Group a publié InfLLM : Aucune formation supplémentaire requise, « 1024K contexte ultra-long » rappel à 100 % !

Les grands modèles ne peuvent mémoriser et comprendre qu'un contexte limité, ce qui est devenu une limitation majeure dans leurs applications pratiques. Par exemple, les systèmes d'IA conversationnelle sont souvent incapables de mémoriser de manière persistante le contenu des conversations de la veille, ce qui se traduit par des agents construits à l'aide de grands modèles présentant un comportement et une mémoire incohérents.

Pour permettre aux grands modèles de mieux gérer des contextes plus longs, les chercheurs ont proposé une nouvelle méthode appelée InfLLM. Cette méthode, proposée conjointement par des chercheurs de l'Université Tsinghua, du MIT et de l'Université Renmin, permet aux grands modèles linguistiques (LLM) de traiter des textes extrêmement longs sans formation supplémentaire. InfLLM utilise une petite quantité de ressources informatiques et de mémoire graphique pour obtenir un traitement efficace de textes très longs.

Adresse papier : https://arxiv.org/abs/2402.04617

Référentiel de codes : https://github.com/thunlp/InfLLM

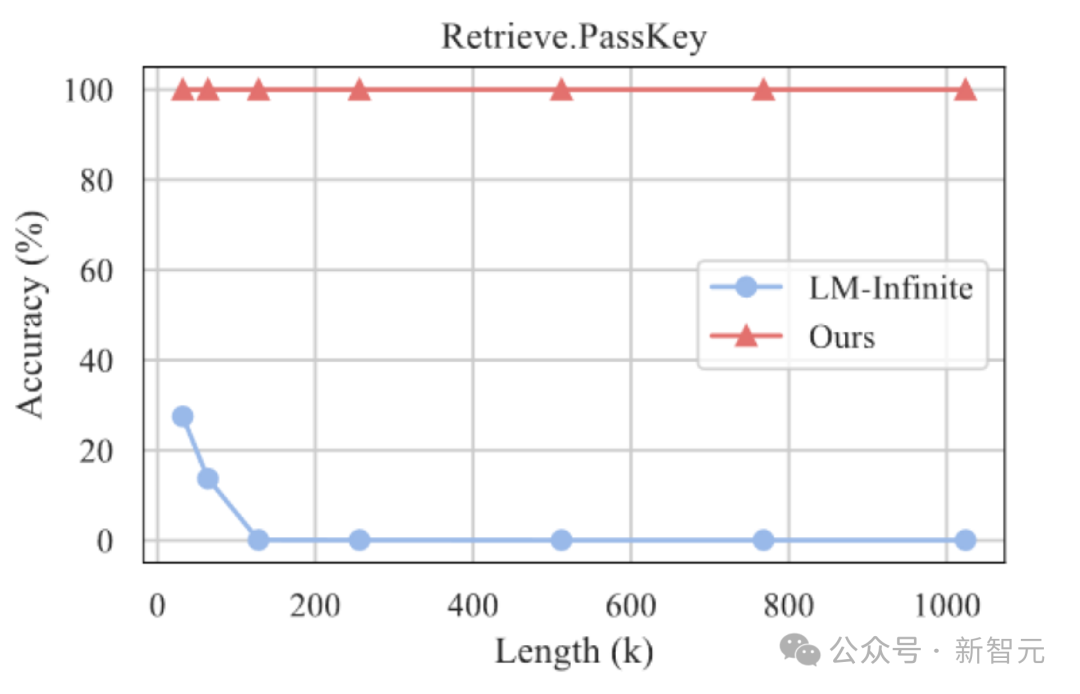

Les résultats expérimentaux montrent qu'InfLLM peut être efficace Il élargit considérablement la fenêtre de traitement du contexte de Mistral et LLaMA et atteint un rappel à 100 % dans la tâche de recherche d'une aiguille dans une botte de foin de 1024 000 contextes.

Contexte de recherche

Les modèles linguistiques pré-entraînés (LLM) à grande échelle ont fait des progrès révolutionnaires dans de nombreuses tâches ces dernières années et sont devenus le modèle de base pour de nombreuses applications.

Ces applications pratiques posent également des défis plus importants quant à la capacité des LLM à traiter de longues séquences. Par exemple, un agent piloté par LLM doit traiter en permanence les informations reçues de l’environnement externe, ce qui nécessite qu’il dispose de capacités de mémoire plus puissantes. Dans le même temps, l’IA conversationnelle doit mieux mémoriser le contenu des conversations avec les utilisateurs afin de générer des réponses plus personnalisées.

Cependant, les modèles à grande échelle actuels ne sont généralement pré-entraînés que sur des séquences contenant des milliers de jetons, ce qui entraîne deux défis majeurs lorsqu'ils sont appliqués à des textes très longs :

1. length : L'application directe de LLM à des textes plus longs nécessite souvent que les LLM traitent l'encodage de position au-delà de la plage de formation, ce qui entraîne des problèmes de non-distribution et un échec de généralisation

2. Un contexte trop long entraînera une distraction excessive de l'attention du modèle vers des informations non pertinentes, rendant impossible la modélisation efficace des dépendances sémantiques à long terme dans le contexte. Introduction à la méthode

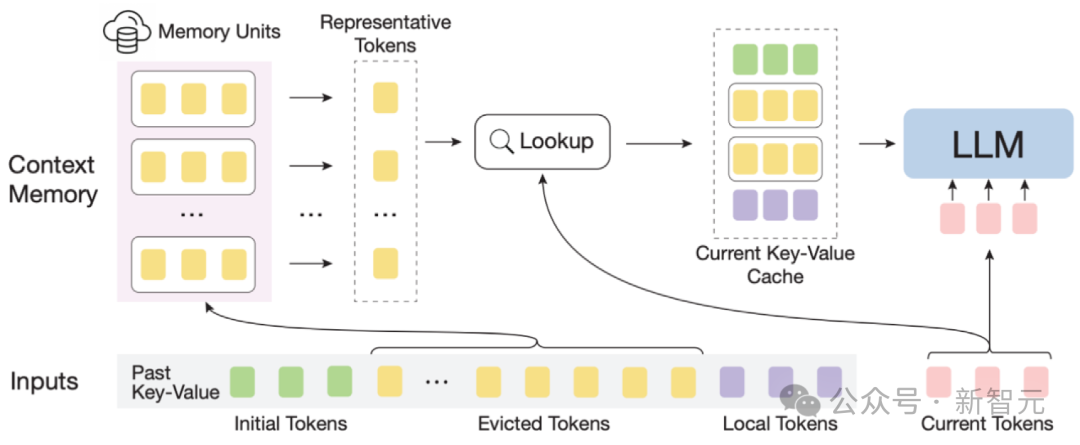

Schéma InfLLM

Schéma InfLLM

Afin d'atteindre efficacement la capacité de généralisation de la longueur des grands modèles, l'auteur a proposé une méthode d'amélioration de la mémoire sans formation, InfLLM, pour le traitement en streaming de séquences super longues.

InfLLM vise à stimuler la capacité intrinsèque des LLM à capturer les dépendances sémantiques à longue distance dans des contextes ultra-longs avec un coût de calcul limité, permettant ainsi une compréhension efficace de textes longs.

Cadre global : compte tenu de la rareté de l'attention portée aux textes longs, le traitement de chaque jeton ne nécessite généralement qu'une petite partie de son contexte.

L'auteur a construit un module de mémoire externe pour stocker des informations contextuelles ultra longues ; à l'aide d'un mécanisme de fenêtre coulissante, à chaque étape de calcul, seuls les jetons (jetons locaux) proches du jeton actuel sont liés à une petite quantité dans les informations du module de mémoire externe sont impliquées dans le calcul de la couche d'attention, tandis que les autres bruits non pertinents sont ignorés.

Ainsi, les LLM peuvent utiliser une taille de fenêtre limitée pour comprendre l'intégralité de la longue séquence et éviter d'introduire du bruit.

Cependant, le contexte massif dans les séquences ultra-longues pose des défis importants en termes de localisation efficace des informations associées et d'efficacité de la recherche en mémoire dans le module de mémoire.

Afin de relever ces défis, chaque unité de mémoire du module de mémoire contextuelle est constituée d'un bloc sémantique, et un bloc sémantique est constitué de plusieurs Tokens consécutifs.

Plus précisément, (1) Afin de localiser efficacement les unités de mémoire pertinentes, la sémantique cohérente de chaque bloc sémantique peut répondre plus efficacement aux besoins des requêtes d'informations associées que les jetons fragmentés.

De plus, l'auteur sélectionne le Token sémantiquement le plus important de chaque bloc sémantique, c'est-à-dire le Token qui reçoit le score d'attention le plus élevé, comme représentation du bloc sémantique. Cette méthode permet d'éviter les inexactitudes dans le calcul de corrélation. . Interférence provenant de jetons importants.

(2) Pour une recherche de mémoire efficace, l'unité de mémoire au niveau du bloc sémantique évite les calculs de corrélation jeton par jeton et attention par attention, réduisant ainsi la complexité de calcul.

De plus, les unités de mémoire sémantiques au niveau des blocs garantissent un accès continu à la mémoire et réduisent les coûts de chargement de la mémoire.

Grâce à cela, l'auteur a conçu un mécanisme de déchargement efficace (Offloading) pour le module de mémoire contextuelle.

Considérant que la plupart des unités de mémoire sont rarement utilisées, InfLLM décharge toutes les unités de mémoire vers la mémoire du processeur et conserve dynamiquement les unités de mémoire fréquemment utilisées dans la mémoire du GPU, réduisant ainsi considérablement l'utilisation de la mémoire vidéo.

InfLLM peut être résumé comme suit :

1 Sur la base de la fenêtre coulissante, ajoutez un module de mémoire contextuelle à longue portée.

2. Divisez le contexte historique en morceaux sémantiques pour former des unités de mémoire dans le module de mémoire contextuelle. Chaque unité de mémoire détermine un jeton représentatif par l'intermédiaire de son score d'attention dans le calcul d'attention précédent, en tant que représentation de l'unité de mémoire. Évitant ainsi les interférences sonores dans le contexte et réduisant la complexité des requêtes de mémoire

Analyse expérimentale

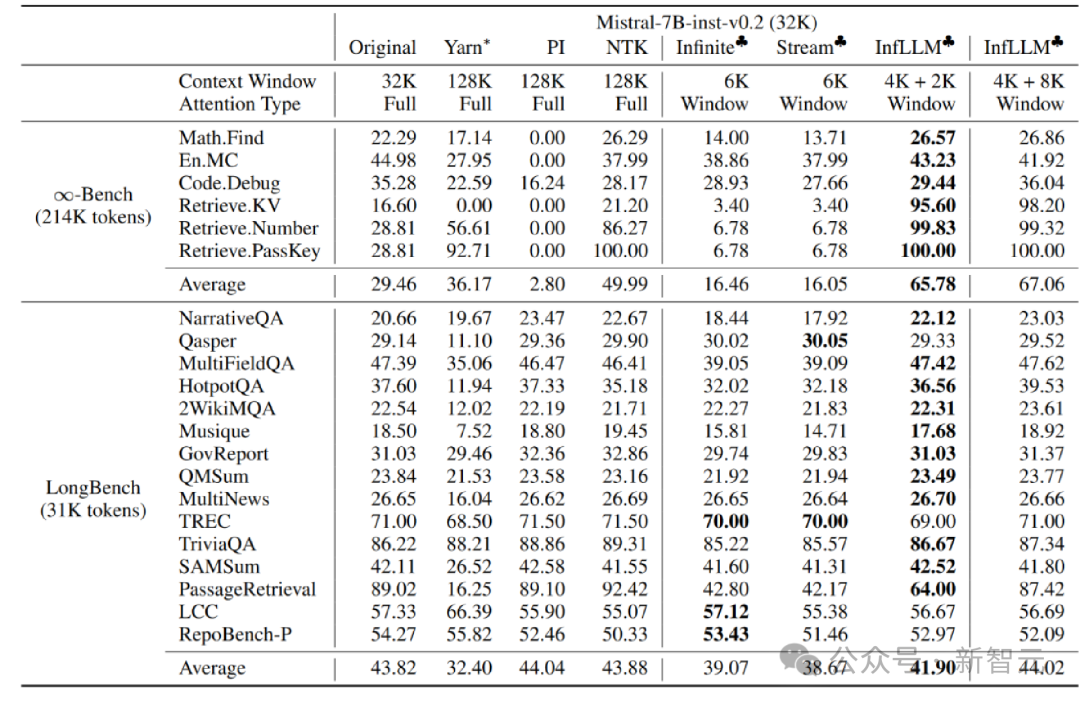

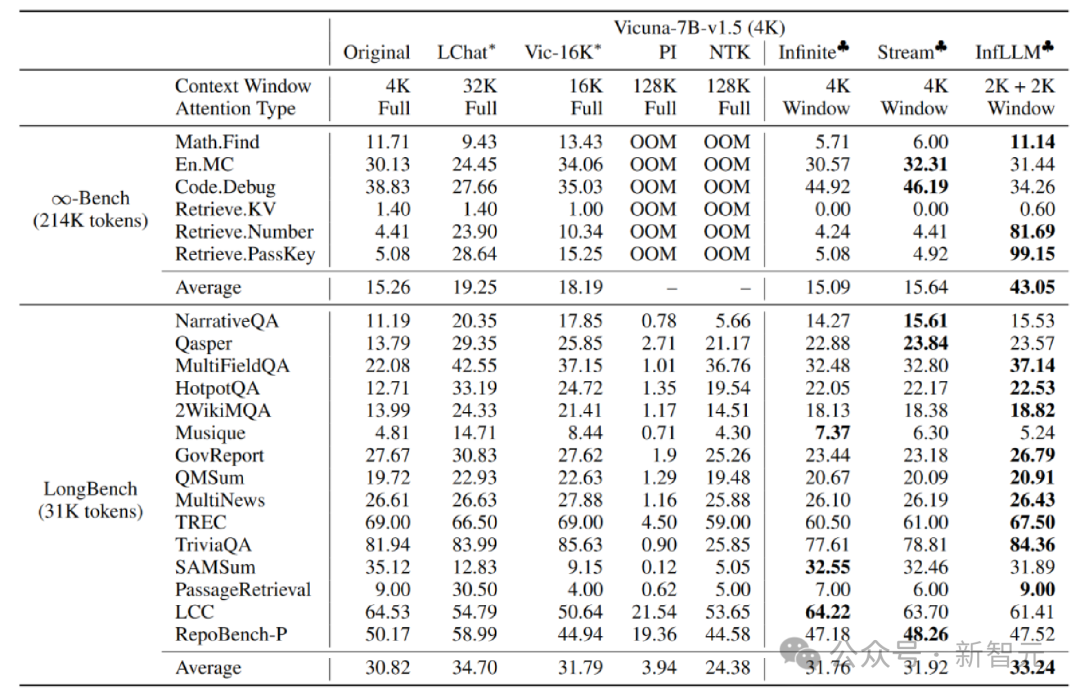

L'auteur l'a appliqué sur les modèles Mistral-7b-Inst-v0.2 (32K) et Vicuna-7b-v1.5 (4K) InfLLM , utilise des tailles de fenêtre locales de 4K et 2K respectivement.

Par rapport au modèle original, à l'interpolation de codage positionnel, à Infinite-LM et à StreamingLLM, des améliorations significatives des performances ont été obtenues sur les données de texte long Infinite-Bench et Longbench.

Expérience sur des textes très longs

De plus, l'auteur a continué à explorer la capacité de généralisation d'InfLLM sur des textes plus longs, et il peut toujours fonctionner dans le style "une aiguille dans une botte de foin". " tâche d'une longueur de 1 024 Ko Maintenir un taux de rappel de 100 %.

Résultats expérimentaux de la recherche d'une aiguille dans une botte de foin

Résumé

Dans cet article, l'équipe a proposé InfLLM, qui peut étendre le traitement de texte ultra-long de LLM sans formation et peut capturer la sémantique longue distance information .

InfLLM ajoute un module de mémoire contenant des informations contextuelles longue distance basées sur la fenêtre coulissante et utilise le mécanisme de cache et de déchargement pour implémenter un raisonnement de texte long en streaming avec une petite quantité de calcul et de consommation de mémoire.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu