Aujourd'hui, Cohere, une startup d'intelligence artificielle cofondée par Aidan Gomez, l'un des auteurs de Transformer, s'est félicitée de la sortie de son propre grand modèle.

Le dernier modèle publié par Cohere s'appelle « Command-R », comporte 35 B de paramètres et est conçu pour gérer des charges de travail de production à grande échelle. Ce modèle entre dans la catégorie « évolutif », avec un équilibre entre haute efficacité et haute précision, aidant les utilisateurs en entreprise à aller au-delà de la preuve de concept vers la production.

Command-R est un modèle génératif spécifiquement optimisé pour la génération augmentée de récupération (RAG) et d'autres tâches contextuelles longues. En combinant des API et des outils externes, ce modèle vise à améliorer les performances des applications RAG. Il fonctionne avec des modèles d'intégration et de réorganisation de pointe pour offrir des performances exceptionnelles et les meilleures capacités d'intégration de leur catégorie pour les cas d'utilisation en entreprise.

Command-R adopte une architecture de transformateur optimisée et est un modèle de langage autorégressif. Une fois la pré-formation terminée, il est assuré que le modèle est conforme aux préférences humaines grâce à un réglage fin supervisé (SFT) et à une formation aux préférences pour obtenir une meilleure utilité et sécurité.

Plus précisément, Command-R présente les caractéristiques fonctionnelles suivantes :

Command-R est actuellement disponible sur l'API gérée de Cohere, avec des plans qui seront bientôt disponibles sur les principaux fournisseurs de cloud. Cette version est la première d'une série de modèles conçus pour faire progresser les fonctionnalités essentielles à l'adoption massive par les entreprises.

Actuellement, Cohere a ouvert des poids modèles sur Huggingface.

Adresse Huggingface : https://huggingface.co/CohereForAI/c4ai-command-r-v01

Récupération : recherchez un corpus d'informations pertinentes pour l'utilisateur de la réponse.

Pour la génération augmentée, en identifiant les informations les plus pertinentes, Command-R peut résumer, analyser et regrouper ces informations, et aider les employés à améliorer l'efficacité du travail ou à créer de nouvelles expériences de produits. Command-R est unique dans le sens où le résultat du modèle est accompagné de citations claires, réduisant le risque d'hallucinations et restituant davantage de contexte à partir du matériel source.

Même sans utiliser ses propres modèles Embed et Rerank, Command-R surpasse les autres modèles de la catégorie des modèles génératifs évolutifs. Mais lorsqu'elles sont utilisées ensemble, l'avance s'étend considérablement, permettant des performances supérieures dans des domaines plus complexes.

L'image ci-dessous à gauche montre Command-R et Mixtral effectuant une évaluation globale des préférences humaines face à face sur une série d'applications RAG liées à l'entreprise, en tenant compte de la maîtrise, de l'aspect pratique des réponses et des citations. Le côté droit de la figure montre les résultats de comparaison de Command-R (Embed+Rerank), Command-R et Llama 2 70B (chat), Mixtral, GPT3.5-Turbo et d'autres modèles sur des benchmarks tels que Natural Questions, TriviaQA et HotpotQA. Le grand modèle de Cohere prend la tête.

Les grands modèles de langage devraient être des moteurs d'inférence de base capables d'automatiser des tâches et d'entreprendre des actions réelles, et pas seulement des machines qui extraient et génèrent du texte. Command-R atteint cet objectif en utilisant des outils (API) tels que des interpréteurs de code et d'autres outils définis par l'utilisateur qui permettent aux modèles d'automatiser des tâches très complexes.

La fonctionnalité d'utilisation des outils permet aux développeurs d'entreprise de transformer Command-R en un moteur pour prendre en charge les tâches et les flux de travail qui nécessitent l'utilisation d'une « infrastructure interne telle que des bases de données et des outils logiciels » ainsi que « d'outils externes tels que des CRM et des moteurs de recherche ». " automatisation. Cela nous permet d'automatiser des tâches manuelles chronophages qui s'étendent sur plusieurs systèmes et nécessitent un raisonnement et une prise de décision complexes.

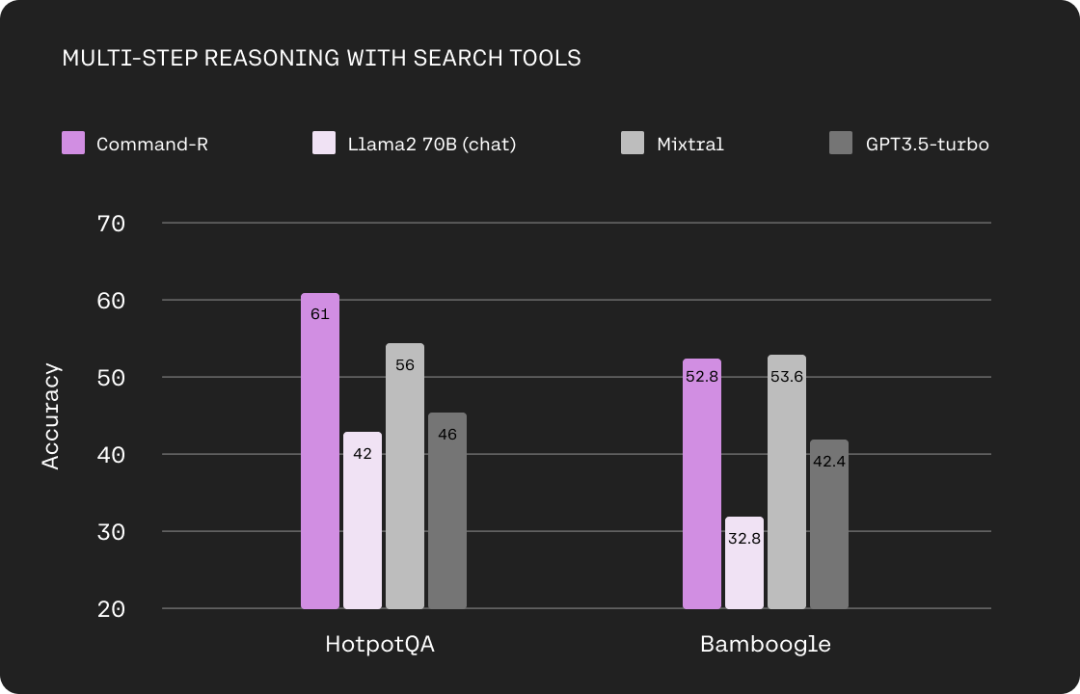

L'image ci-dessous montre la comparaison des capacités de raisonnement en plusieurs étapes entre Command-R et Llama 2 70B (chat), Mixtral et GPT3.5-turbo lors de l'utilisation d'outils de recherche. Les ensembles de données utilisés ici sont HotpotQA et Bamboogle.

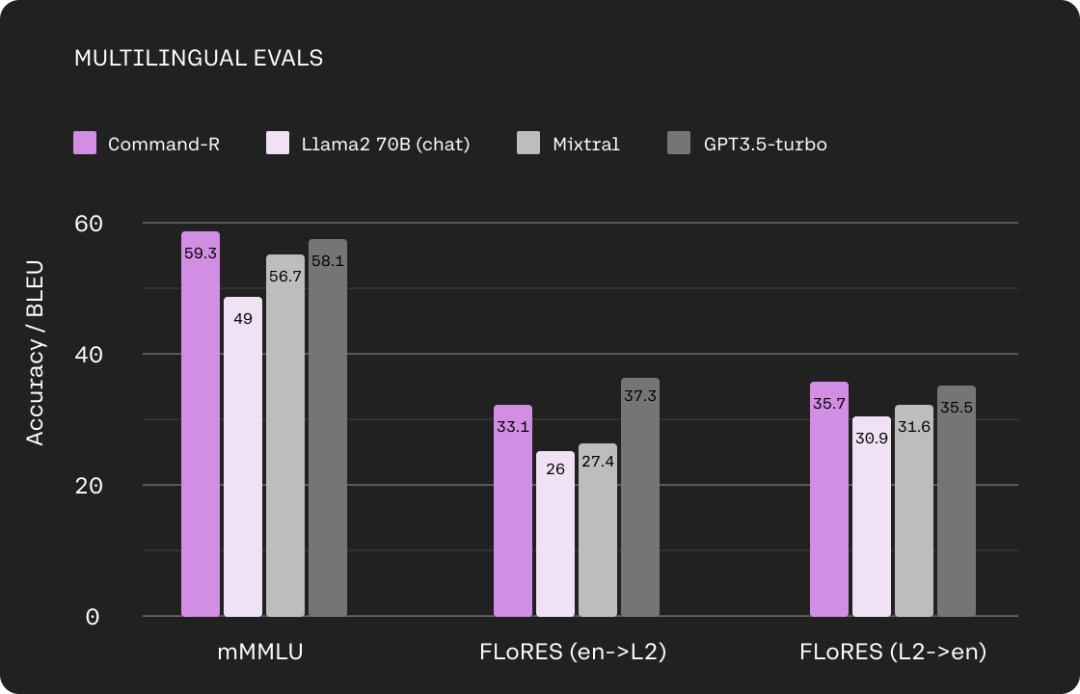

Le modèle Command-R est efficace dans 10 principales langues commerciales à travers le monde, dont l'anglais, le français, l'espagnol, l'italien, l'allemand, le portugais, le japonais, le coréen, Arabe et chinois.

De plus, les modèles Embed et Rerank de Cohere prennent en charge nativement plus de 100 langues. Cela permet aux utilisateurs de tirer des réponses à partir d'un large éventail de sources de données, offrant ainsi des conversations claires et précises dans leur langue maternelle, quelle que soit la langue.

L'image ci-dessous montre la comparaison entre Command-R et Llama 2 70B (chat), Mixtral, GPT3.5-turbo sur MMLU multilingue et FLORES.

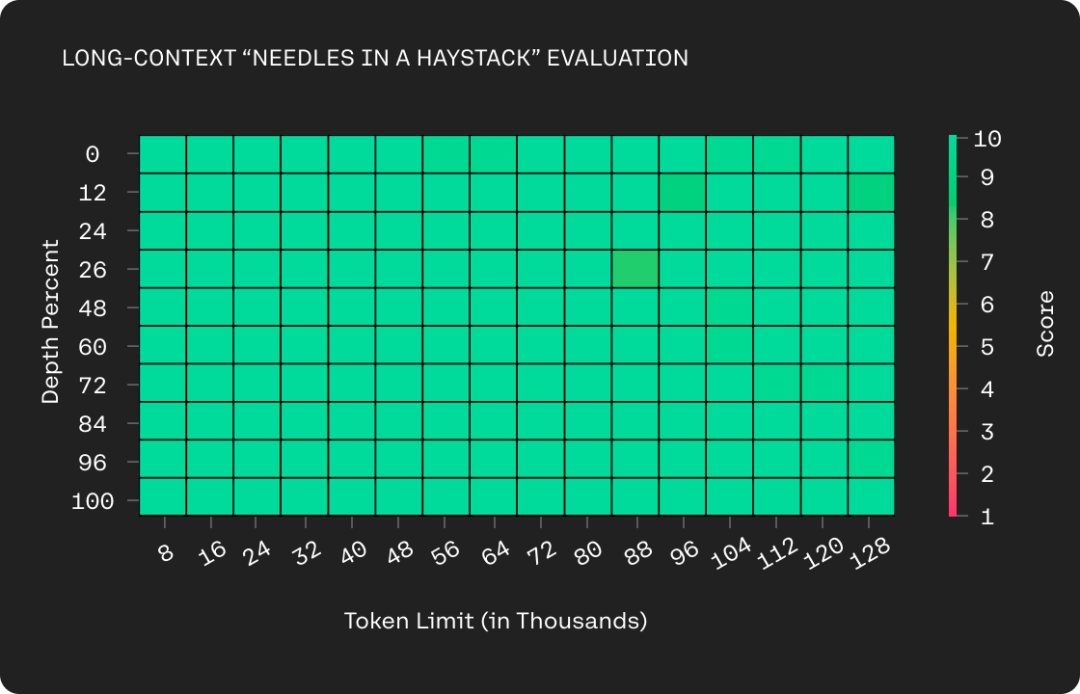

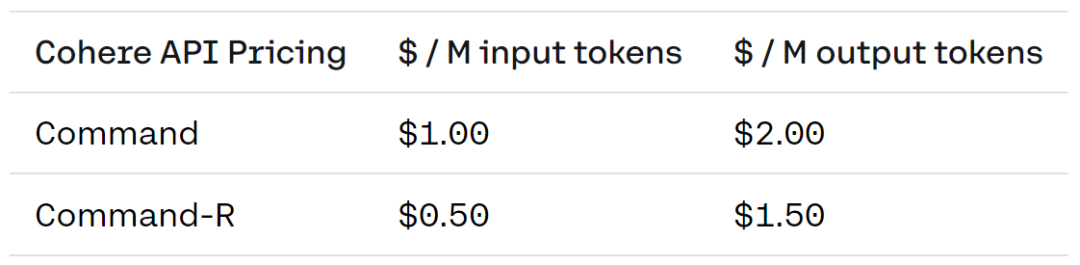

Command-R prend en charge une fenêtre de contexte plus longue - 128 000 jetons. La mise à niveau réduit également le prix des API gérées de Cohere et augmente considérablement l’efficacité des déploiements de cloud privé de Cohere. En combinant une fenêtre de contexte plus longue avec une tarification moins chère, Command-R ouvre des cas d'utilisation de RAG où un contexte supplémentaire peut améliorer considérablement les performances.

Le prix spécifique est le suivant, où la version Command coûte 1 USD pour 1 million de jetons d'entrée et 1 million de jetons de sortie pour 2 USD ; la version Command-R coûte 0,5 USD pour 1 million de jetons d'entrée et 1 ; millions de jetons de sortie.

Bientôt, Cohere publiera également un court rapport technique pour montrer plus de détails sur le modèle.

Adresse du blog : https://txt.cohere.com/command-r/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment lier des données dans une liste déroulante

Comment lier des données dans une liste déroulante

Utilisation de la suppression de base de données

Utilisation de la suppression de base de données

Quelles sont les manières d'exécuter des scripts Shell ?

Quelles sont les manières d'exécuter des scripts Shell ?

base de données de connexion jndi

base de données de connexion jndi

Solution au problème selon lequel le logiciel de téléchargement Win10 ne peut pas être installé

Solution au problème selon lequel le logiciel de téléchargement Win10 ne peut pas être installé

Comment résoudre l'erreur de requête http 415

Comment résoudre l'erreur de requête http 415

Comment configurer la fonction antiblocage de WeChat

Comment configurer la fonction antiblocage de WeChat

commande de capture de paquets Linux

commande de capture de paquets Linux