Périphériques technologiques

Périphériques technologiques

IA

IA

Nouvelle œuvre de Yan Shuicheng/Cheng Mingming ! La formation DiT, le composant principal de Sora, est accélérée 10 fois et Masked Diffusion Transformer V2 est open source

Nouvelle œuvre de Yan Shuicheng/Cheng Mingming ! La formation DiT, le composant principal de Sora, est accélérée 10 fois et Masked Diffusion Transformer V2 est open source

Nouvelle œuvre de Yan Shuicheng/Cheng Mingming ! La formation DiT, le composant principal de Sora, est accélérée 10 fois et Masked Diffusion Transformer V2 est open source

En tant que l'une des technologies de base convaincantes de Sora, DiT utilise le transformateur de diffusion pour faire évoluer le modèle génératif à une plus grande échelle afin d'obtenir des effets de génération d'images exceptionnels.

Cependant, les modèles de plus grande taille font monter en flèche les coûts de formation.

L'équipe de recherche de Yan Shuicheng et Cheng Mingming du Sea AI Lab, de l'Université de Nankai et de l'Institut de recherche Kunlun Wanwei 2050 a proposé un nouveau modèle appelé Masked Diffusion Transformer lors de la conférence ICCV 2023. Ce modèle utilise la technologie de modélisation de masques pour accélérer la formation de Diffusion Transformer en apprenant les informations de représentation sémantique et réalise des effets SoTA dans le domaine de la génération d'images. Cette innovation apporte de nouvelles avancées dans le développement de modèles de génération d’images et offre aux chercheurs une méthode de formation plus efficace. En combinant expertise et technologie de différents domaines, l’équipe de recherche a proposé avec succès une solution qui augmente la vitesse de formation et améliore les résultats de génération. Leurs travaux ont apporté d'importantes idées innovantes au développement du domaine de l'intelligence artificielle et ont fourni une source d'inspiration utile pour la recherche et la pratique futures. , Masked Diffusion Transformer V2 a encore une fois actualisé SoTA, augmentant la vitesse d'entraînement de plus de 10 fois par rapport à DiT et atteignant le score FID de 1,58.

La dernière version du document et du code est open source.

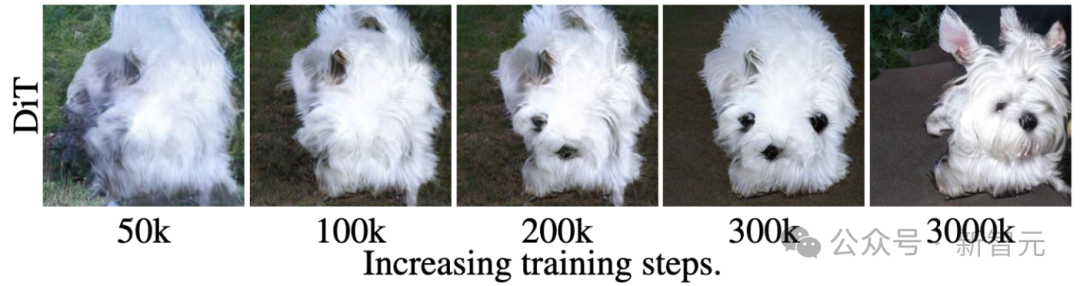

Par exemple, comme le montre l'image ci-dessus, DiT a appris à générer la texture des poils d'un chien à la 50ème étape d'entraînement, puis a appris à générer l'un des yeux du chien à la 200ème étape. marche d'entraînement et bouche, mais il manquait un autre œil.

Même au pas d'entraînement de 300k, la position relative des deux oreilles du chien générée par DiT n'est pas très précise.

Ce processus de formation et d'apprentissage révèle que le modèle de diffusion ne parvient pas à apprendre efficacement la relation sémantique entre les différentes parties de l'objet dans l'image, mais n'apprend que les informations sémantiques de chaque objet de manière indépendante.

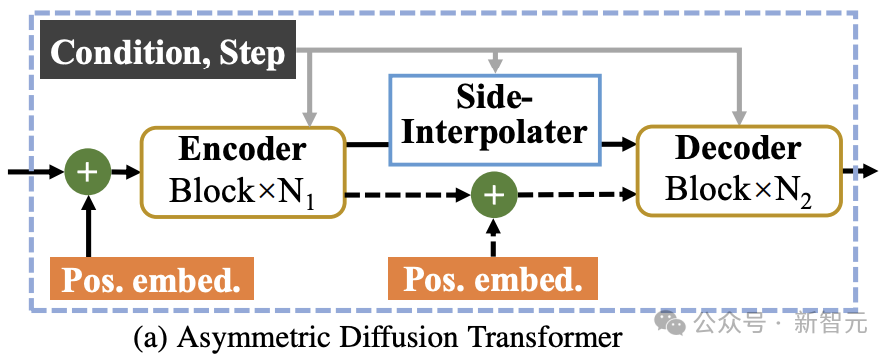

Comme le montre la figure ci-dessus, MDT introduit une stratégie d'apprentissage de la modélisation de masques tout en maintenant le processus de formation par diffusion. En masquant le jeton d'image bruyante, MDT utilise une architecture de transformateur de diffusion asymétrique (Asymétrique Diffusion Transformer) pour prédire le jeton d'image masqué à partir du jeton d'image bruyante qui n'a pas été masqué, réalisant ainsi simultanément les processus de modélisation de masque et de formation à la diffusion.

Pendant le processus d'inférence, MDT maintient toujours le processus de génération de diffusion standard. La conception de MDT permet à Diffusion Transformer de bénéficier à la fois de la capacité d'expression d'informations sémantiques apportée par l'apprentissage de la représentation par modélisation de masque et de la capacité du modèle de diffusion à générer des détails d'image.

Plus précisément, MDT mappe les images sur l'espace latent via l'encodeur VAE et les traite dans l'espace latent pour réduire les coûts de calcul.

Pendant le processus de formation, MDT masque d'abord une partie des jetons d'image après avoir ajouté du bruit, et envoie les jetons restants au transformateur de diffusion asymétrique pour prédire tous les jetons d'image après le débruitage.

Architecture du transformateur de diffusion asymétrique

Image

Image

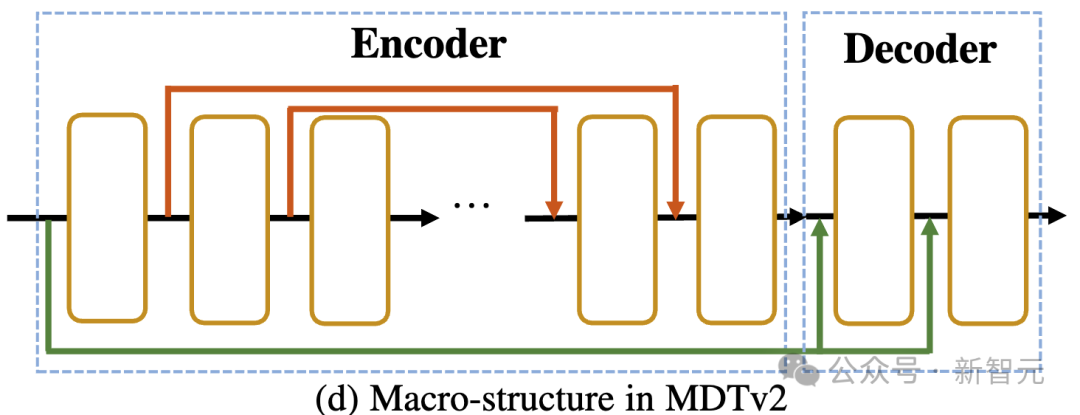

Comme le montre la figure ci-dessus, l'architecture du transformateur de diffusion asymétrique comprend un encodeur, un interpolateur latéral (interpolateur auxiliaire) et un décodeur.

Images

Images

Pendant le processus de formation, l'encodeur traite uniquement les jetons qui ne sont pas masqués pendant le processus d'inférence, puisqu'il n'y a pas d'étape de masque, il traite tous les jetons ;

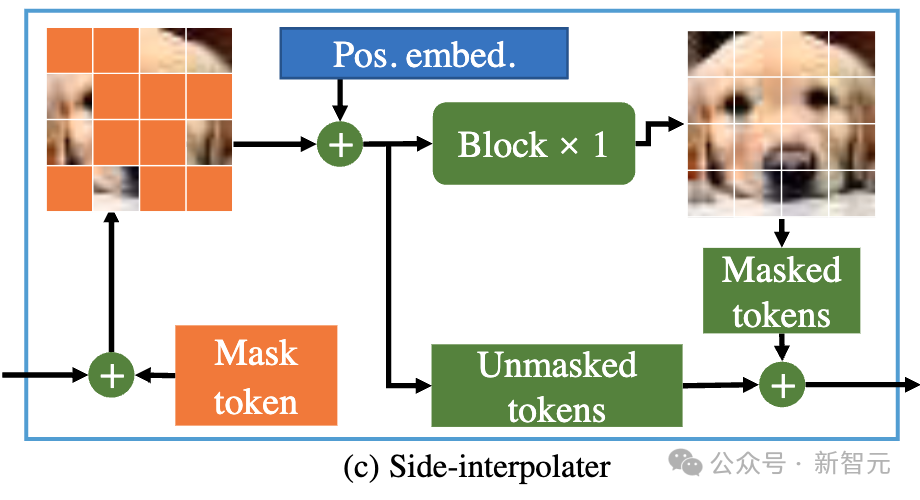

Par conséquent, afin de garantir que le décodeur puisse toujours traiter tous les jetons pendant la phase de formation ou d'inférence, les chercheurs ont proposé une solution : pendant le processus de formation, via un interpolateur auxiliaire composé de blocs DiT (comme le montre la figure ci-dessus), interpoler et prédire le jeton masqué à partir de la sortie de l'encodeur, et le supprimer pendant l'étape d'inférence sans ajouter de surcharge d'inférence.

L'encodeur et le décodeur de MDT insèrent des informations de codage de position globale et locale dans le bloc DiT standard pour aider à prédire le jeton dans la partie masque.

Transformateur de diffusion asymétrique V2

Photos

Photos

Comme le montre l'image ci-dessus, MDTv2 optimise davantage la diffusion et le masque en introduisant une structure de macro-réseau plus efficace conçue pour le processus de diffusion masquée. processus de modélisation.

Cela inclut l'intégration d'un raccourci long de style U-Net dans l'encodeur et d'un raccourci d'entrée dense dans le décodeur.

Parmi eux, un raccourci d'entrée dense envoie le jeton masqué après avoir ajouté du bruit au décodeur, conservant les informations de bruit correspondant au jeton masqué, facilitant ainsi l'apprentissage du processus de diffusion.

De plus, MDT a également introduit de meilleures stratégies d'entraînement, notamment l'utilisation d'un optimiseur Adan plus rapide, des poids de perte liés au pas de temps et des ratios de masques élargis pour accélérer davantage le processus d'entraînement du modèle de diffusion masquée.

Résultats expérimentaux

Comparaison de la qualité de la génération de référence ImageNet 256

images

images

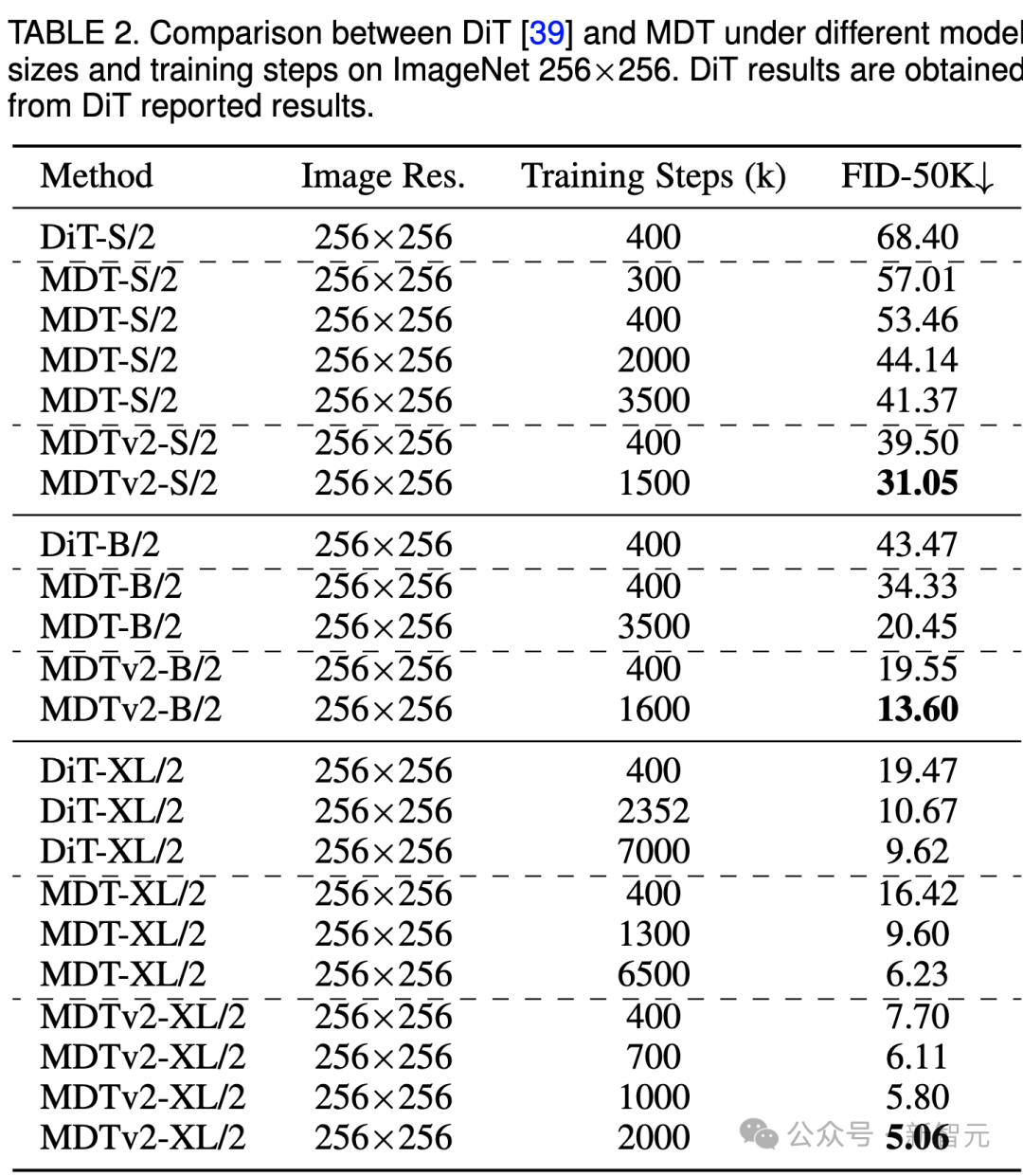

Le tableau ci-dessus compare les performances de MDT et DiT sous le benchmark ImageNet 256 sous différentes tailles de modèles.

Il est évident que MDT obtient des scores FID plus élevés avec moins de coûts de formation, quelle que soit la taille du modèle.

Les paramètres et les coûts d'inférence de MDT sont fondamentalement les mêmes que ceux de DiT, car comme mentionné ci-dessus, le processus de diffusion standard compatible avec DiT est toujours maintenu dans le processus d'inférence MDT.

Pour le plus grand modèle XL, MDTv2-XL/2, entraîné avec 400 000 pas, surpasse significativement DiT-XL/2, entraîné avec 7 000 000 pas, avec une amélioration du score FID de 1,92. Dans ce paramètre, les résultats montrent que MDT a un entraînement environ 18 fois plus rapide que DiT.

Pour les petits modèles, MDTv2-S/2 atteint toujours des performances nettement meilleures que DiT-S/2 avec beaucoup moins d'étapes de formation. Par exemple, avec la même formation de 400 000 étapes, MDTv2 a un indice FID de 39,50, ce qui est nettement supérieur à l'indice FID de DiT de 68,40.

Plus important encore, ce résultat dépasse également les performances du plus grand modèle DiT-B/2 à 400 000 pas d'entraînement (39,50 contre 43,47).

Comparaison de la qualité de génération CFG de référence ImageNet 256

images

images

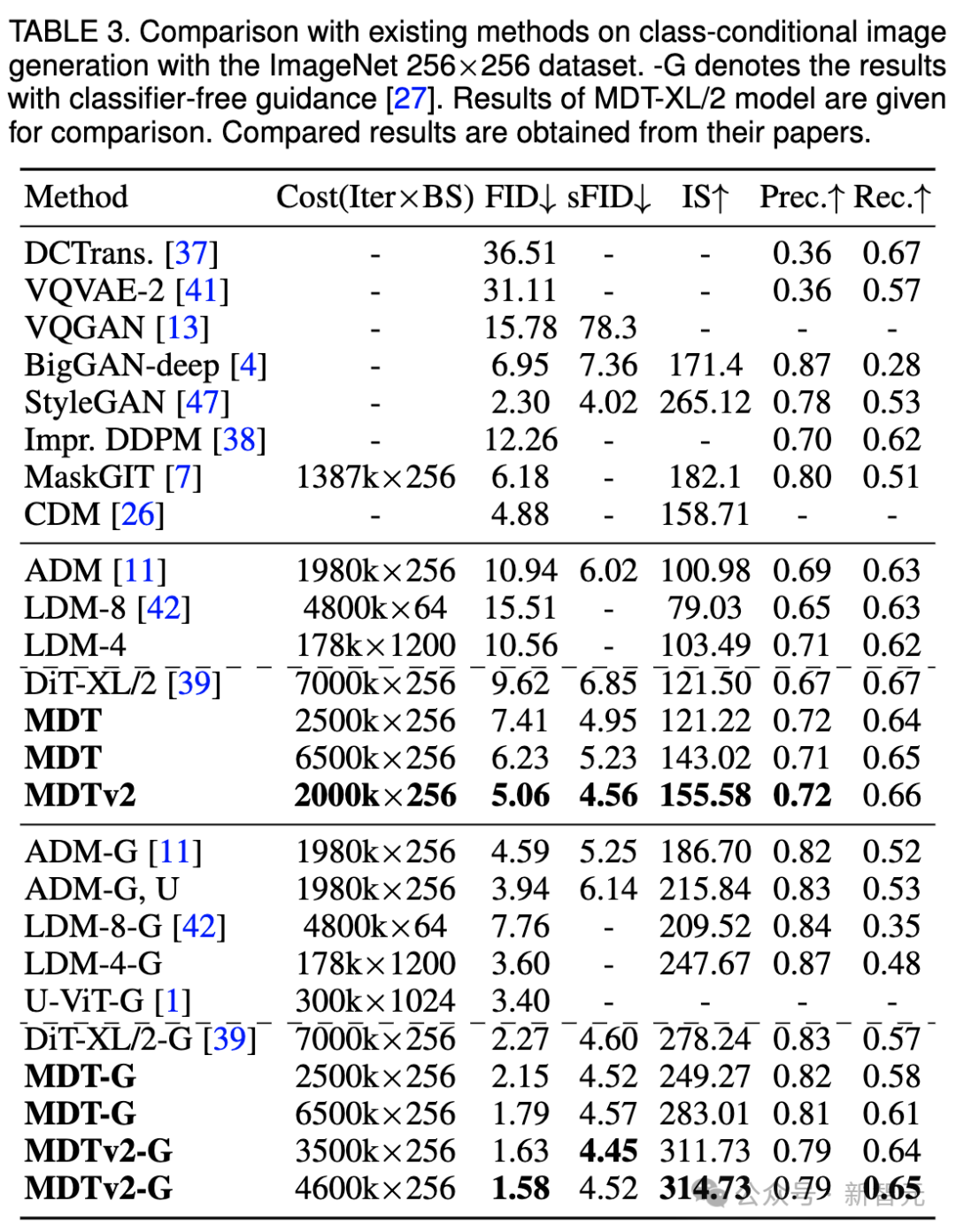

Nous avons également comparé les performances de génération d'images de MDT avec les méthodes existantes sous guidage sans classificateur dans le tableau ci-dessus.

MDT surpasse les précédentes méthodes SOTA DiT et autres avec un score FID de 1,79. MDTv2 améliore encore les performances, poussant le score SOTA FID pour la génération d'images à un nouveau plus bas de 1,58 avec moins d'étapes de formation.

Semblable à DiT, nous n'avons pas observé de saturation du score FID du modèle pendant l'entraînement alors que nous poursuivions l'entraînement.

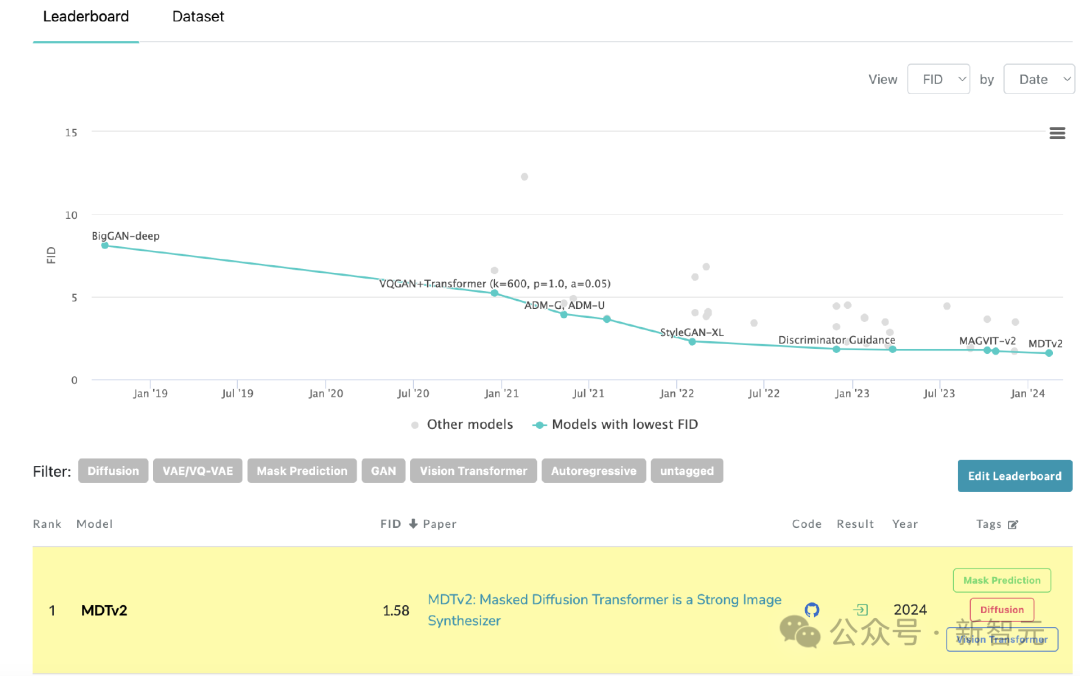

MDT actualise SoTA sur le classement de PaperWithCode

MDT actualise SoTA sur le classement de PaperWithCode

Comparaison de la vitesse de convergence

image

image

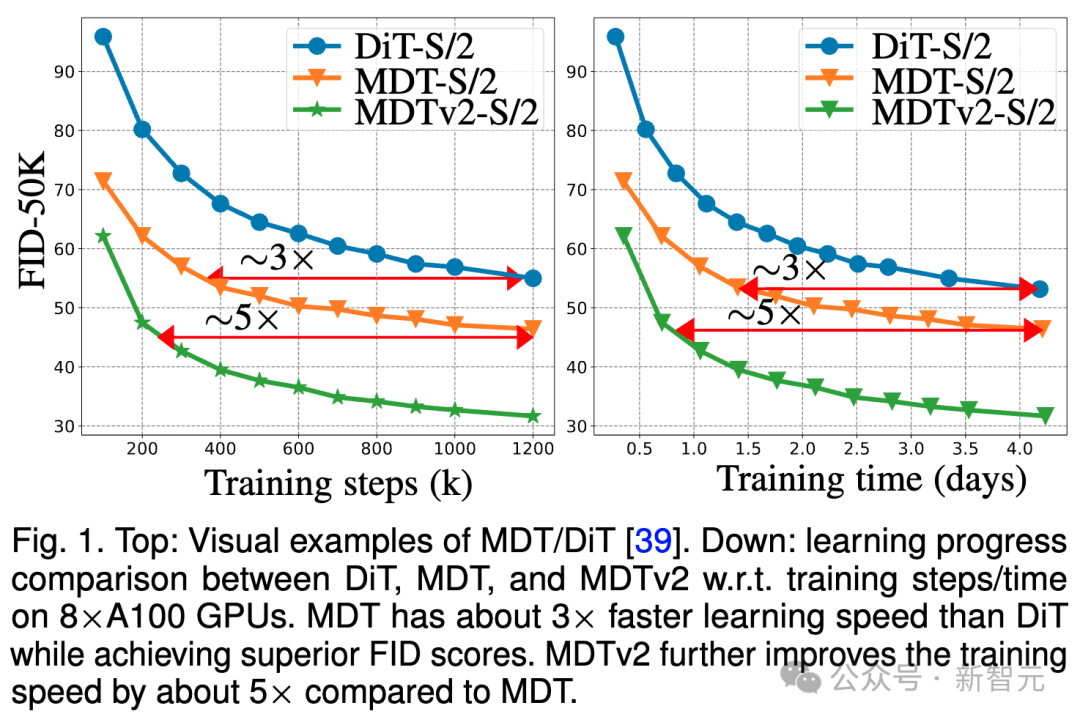

L'image ci-dessus compare 8 × A100 sous le benchmark ImageNet 256 DiT-S/ sur GPU 2 FID performances de la ligne de base, MDT-S/2 et MDTv2-S/2 sous différentes étapes/temps de formation.

Grâce à de meilleures capacités d'apprentissage contextuel, MDT surpasse DiT en termes de performances et de vitesse de génération. La vitesse de convergence de formation de MDTv2 est plus de 10 fois supérieure à celle de DiT.

MDT est environ 3 fois plus rapide que DiT en termes d'étapes et de temps d'entraînement. MDTv2 améliore encore la vitesse d'entraînement d'environ 5 fois par rapport à MDT.

Par exemple, MDTv2-S/2 affiche de meilleures performances en seulement 13 heures (15 000 pas) que DiT-S/2 qui prend environ 100 heures (1 500 000 pas) pour s'entraîner, ce qui révèle que l'apprentissage de la représentation contextuelle est important pour Un apprentissage génératif plus rapide des modèles de diffusion est crucial.

Résumé et discussion

MDT introduit un schéma d'apprentissage de représentation de modélisation de masque similaire au MAE dans le processus de formation par diffusion, qui peut utiliser les informations contextuelles des objets image pour reconstruire les informations complètes de l'image d'entrée incomplète, apprenant ainsi la sémantique dans l'image La corrélation entre les pièces, améliorant ainsi la qualité de la génération d'images et la vitesse d'apprentissage.

Les chercheurs pensent qu'améliorer la compréhension sémantique du monde physique grâce à l'apprentissage de la représentation visuelle peut améliorer l'effet de simulation du modèle génératif sur le monde physique. Cela coïncide avec la vision de Sora de construire un simulateur du monde physique grâce à des modèles génératifs. Espérons que ce travail inspirera davantage de travaux sur l’unification de l’apprentissage des représentations et de l’apprentissage génératif.

Référence :

https://arxiv.org/abs/2303.14389

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Introduction à l'utilisation du simulateur joiplay

May 04, 2024 pm 06:40 PM

Introduction à l'utilisation du simulateur joiplay

May 04, 2024 pm 06:40 PM

Le simulateur jojplay est un simulateur de téléphone mobile très facile à utiliser. Il prend en charge les jeux informatiques et peut être exécuté sur les téléphones mobiles, et la compatibilité est très bonne. Certains joueurs ne savent pas comment l'utiliser. comment l'utiliser. Comment utiliser le simulateur joiplay 1. Tout d'abord, vous devez télécharger le plug-in Joiplay body et RPGM. Il est préférable de les installer dans l'ordre body - plug-in. Le package apk peut être obtenu dans la barre Joiplay (. cliquez pour obtenir >>>). 2. Une fois Android terminé, vous pouvez ajouter des jeux dans le coin inférieur gauche. 3. Remplissez le nom avec désinvolture et appuyez sur CHOISIR sur le fichier exécutable pour sélectionner le fichier game.exe du jeu. 4. L'icône peut rester vide ou vous pouvez choisir votre image préférée.

Comment activer Vt sur la carte mère MSI

May 01, 2024 am 09:28 AM

Comment activer Vt sur la carte mère MSI

May 01, 2024 am 09:28 AM

Comment activer VT sur la carte mère MSI ? Quelles sont les méthodes ? Ce site a soigneusement compilé les méthodes d'activation VT de la carte mère MSI pour la majorité des utilisateurs. Bienvenue à lire et à partager ! La première étape consiste à redémarrer l'ordinateur et à accéder au BIOS. Que dois-je faire si la vitesse de démarrage est trop rapide et que je ne parviens pas à accéder au BIOS ? Une fois l'écran allumé, continuez d'appuyer sur "Suppr" pour accéder à la page du BIOS. La deuxième étape consiste à rechercher l'option VT dans le menu et à l'activer. Différents modèles d'ordinateurs ont des interfaces BIOS différentes et des noms différents pour VT. : 1. Entrez Après être entré dans la page du BIOS, recherchez l'option "OC (ou overclocking)" - "Fonctionnalités du processeur" - "SVMMode (ou Intel Virtualization Technology)" et modifiez le "Désactivé"

Comment activer vt sur la carte mère ASRock

May 01, 2024 am 08:49 AM

Comment activer vt sur la carte mère ASRock

May 01, 2024 am 08:49 AM

Comment activer VT sur la carte mère ASRock, quelles sont les méthodes et comment le faire fonctionner. Ce site Web a compilé la méthode d'activation du vt de la carte mère ASRock que les utilisateurs peuvent lire et partager ! La première étape consiste à redémarrer l'ordinateur. Une fois l'écran allumé, continuez d'appuyer sur la touche « F2 » pour accéder à la page du BIOS. Que dois-je faire si la vitesse de démarrage est trop rapide et que je ne parviens pas à accéder au BIOS ? La deuxième étape consiste à rechercher l'option VT dans le menu et à l'activer. Différents modèles de cartes mères ont des interfaces BIOS différentes et des noms différents pour VT. 1. Après avoir accédé à la page BIOS, recherchez « Avancé (Avancé) » - « Configuration du processeur ». (CPU) Configuration)" - Option "SVMMOD (Virtualization Technology)", remplacez "Disabled" par "Enabled".

Émulateur Android recommandé et plus fluide (choisissez l'émulateur Android que vous souhaitez utiliser)

Apr 21, 2024 pm 06:01 PM

Émulateur Android recommandé et plus fluide (choisissez l'émulateur Android que vous souhaitez utiliser)

Apr 21, 2024 pm 06:01 PM

Il peut offrir aux utilisateurs une meilleure expérience de jeu et d'utilisation. Un émulateur Android est un logiciel qui peut simuler le fonctionnement du système Android sur un ordinateur. Il existe de nombreux types d’émulateurs Android sur le marché, mais leur qualité varie. Pour aider les lecteurs à choisir l'émulateur qui leur convient le mieux, cet article se concentrera sur certains émulateurs Android fluides et faciles à utiliser. 1. BlueStacks : Vitesse d’exécution rapide Avec une excellente vitesse d’exécution et une expérience utilisateur fluide, BlueStacks est un émulateur Android populaire. Permettant aux utilisateurs de jouer à une variété de jeux et d'applications mobiles, il peut simuler des systèmes Android sur des ordinateurs dotés de performances extrêmement élevées. 2. NoxPlayer : prend en charge plusieurs ouvertures, ce qui rend les jeux plus agréables. Vous pouvez exécuter différents jeux dans plusieurs émulateurs en même temps.

Comment installer le système Windows sur une tablette

May 03, 2024 pm 01:04 PM

Comment installer le système Windows sur une tablette

May 03, 2024 pm 01:04 PM

Comment flasher le système Windows sur la tablette BBK ? La première façon est d'installer le système sur le disque dur. Tant que le système informatique ne tombe pas en panne, vous pouvez accéder au système et télécharger des éléments, vous pouvez utiliser le disque dur de l'ordinateur pour installer le système. La méthode est la suivante : Selon la configuration de votre ordinateur, vous pouvez installer le système d'exploitation WIN7. Nous choisissons de télécharger le système de réinstallation en un clic de Xiaobai dans vivopad pour l'installer. Tout d'abord, sélectionnez la version du système adaptée à votre ordinateur, puis cliquez sur « Installer ce système » pour passer à l'étape suivante. Nous attendons ensuite patiemment que les ressources d'installation soient téléchargées, puis attendons que l'environnement soit déployé et redémarré. Les étapes pour installer win11 sur vivopad sont les suivantes : utilisez d’abord le logiciel pour vérifier si win11 peut être installé. Après avoir réussi la détection du système, entrez les paramètres du système. Sélectionnez-y l’option Mise à jour et sécurité. Cliquez sur

Guide du simulateur de redémarrage de la vie

May 07, 2024 pm 05:28 PM

Guide du simulateur de redémarrage de la vie

May 07, 2024 pm 05:28 PM

Life Restart Simulator est un jeu de simulation très intéressant. Ce jeu est devenu très populaire récemment. Il existe de nombreuses façons de jouer au jeu. Ci-dessous, l'éditeur vous propose un guide complet de Life Restart Simulator. les stratégies existent-elles ? Guide du Life Restart Simulator Guide Caractéristiques du Life Restart Simulator Il s'agit d'un jeu très créatif dans lequel les joueurs peuvent jouer selon leurs propres idées. Il y a de nombreuses tâches à accomplir chaque jour et vous pouvez profiter d'une nouvelle vie dans ce monde virtuel. Il y a de nombreuses chansons dans le jeu et toutes sortes de vies différentes vous attendent. Contenu du jeu Life Restart Simulator Cartes de dessin de talents : Talent : Vous devez choisir la mystérieuse petite boîte pour devenir un immortel. Une variété de petites capsules sont disponibles pour éviter de mourir à mi-chemin. Cthulhu peut choisir

Introduction à la méthode de configuration des polices du simulateur Joiplay

May 09, 2024 am 08:31 AM

Introduction à la méthode de configuration des polices du simulateur Joiplay

May 09, 2024 am 08:31 AM

Le simulateur Jojplay peut réellement personnaliser les polices du jeu et résoudre le problème des caractères manquants et des caractères encadrés dans le texte. Je suppose que de nombreux joueurs ne savent toujours pas comment l'utiliser. L'éditeur suivant vous apportera la méthode de configuration. police du simulateur jojplay introduire. Comment définir la police du simulateur Joiplay 1. Ouvrez d'abord le simulateur Joiplay, cliquez sur les paramètres (trois points) dans le coin supérieur droit et recherchez-le. 2. Dans la colonne RPGMSettings, cliquez pour sélectionner la police personnalisée CustomFont dans la troisième ligne. 3. Sélectionnez le fichier de police et cliquez sur OK. Veillez à ne pas cliquer sur l'icône "Enregistrer" dans le coin inférieur droit, sinon les paramètres par défaut seront restaurés. 4. Recommander le chinois simplifié Founder et Quasi-Yuan (déjà dans les dossiers des jeux Fuxing et Rebirth). joi

Comment supprimer l'application simulateur de tonnerre et d'éclairs ? -Comment supprimer des applications dans Thunderbolt Simulator ?

May 08, 2024 pm 02:40 PM

Comment supprimer l'application simulateur de tonnerre et d'éclairs ? -Comment supprimer des applications dans Thunderbolt Simulator ?

May 08, 2024 pm 02:40 PM

La version officielle de Thunderbolt Simulator est un outil d'émulation Android très professionnel. Alors comment supprimer l’application simulateur de tonnerre et d’éclairs ? Comment supprimer des applications dans Thunderbolt Simulator ? Laissez l'éditeur vous donner la réponse ci-dessous ! Comment supprimer l'application de simulation de tonnerre et d'éclairs ? 1. Cliquez et maintenez l'icône de l'application que vous souhaitez supprimer. 2. Attendez un moment jusqu'à ce que l'option de désinstallation ou de suppression de l'application apparaisse. 3. Faites glisser l'application vers l'option de désinstallation. 4. Dans la fenêtre de confirmation qui apparaît, cliquez sur OK pour terminer la suppression de l'application.