Pièges et solutions du pool de threads Java

1. Fuite de fil

ThreadLeak signifie que le thread créé n'est pas détruit correctement, ce qui entraîne une fuite de mémoire. C'est l'un des pièges les plus courants dans les pools de threads.

Solution :

- Utilisez la méthode

ExecutorService接口的shutdown()和shutdownNow()pour fermer explicitement le pool de threads. - Utilisez l'instruction

try-with-resourcespour vous assurer que le pool de threads est automatiquement fermé en cas d'exception ou de sortie normale. - Définissez le nombre maximum de threads pour le pool de threads afin d'éviter la création de plusieurs threads.

2. Épuisement des ressources

Le nombre de threads disponibles dans le pool de threads est limité. S'il y a trop de tâches, cela peut entraîner un épuisement des ressources, ce qui peut entraîner de mauvaises performances, voire un crash de l'application.

Solution :

- Ajustez la taille du pool de threads pour équilibrer le débit des tâches et l'utilisation des ressources.

- Utilisez les files d'attente pour gérer les tâches et éviter que les tâches ne s'accumulent.

- Envisagez d'utiliser un pool de threads élastique, qui peut ajuster dynamiquement le nombre de threads selon vos besoins.

3. Impasse

Un lock mort se produit lorsque les threads s'attendent et sont incapables de continuer. Dans un pool de threads, si les tâches dépendent de ressources externes, le risque de blocage augmente.

Solution :

- Évitez les dépendances circulaires et utilisez des verrous ou d'autres mécanismes de synchronisation pour garantir un accès séquentiel aux ressources.

- Utilisez le mécanisme de délai d'attente pour forcer le fil à libérer le verrou dans un certain laps de temps.

- Envisagez d'utiliser un modèle d'E/S non bloquant pour réduire le risque de blocages.

4. File d'attente des tâches

Les pools de threads utilisent des files d'attente pour gérer les tâches. La taille de la file d'attente est limitée et s'il y a trop de tâches, celles-ci peuvent rester longtemps en file d'attente.

Solution :

- Ajustez la taille de la file d’attente pour équilibrer le débit et le temps de réponse.

- Envisagez d'utiliser une file d'attente prioritaire pour hiérarchiser les tâches importantes.

- Mettez en œuvre le partage des tâches et divisez les tâches volumineuses en tâches plus petites pour les terminer plus rapidement.

5. Utilisation de la mémoire

Chaque thread nécessite une certaine quantité de mémoire. Trop de threads dans le pool de threads peuvent entraîner une utilisation élevée de la mémoire.

Solution :

- Limitez la taille du pool de threads et créez uniquement le nombre de threads nécessaire.

- Utilisez une implémentation légère de pool de threads, telle que

ForkJoinPool. - Utilisez des variables locales dans les tâches au lieu de variables d'instance pour réduire l'utilisation de la mémoire.

6. Goulot d'étranglement des performances

Les pools de threads sont conçus pour améliorer les performances, mais s'ils sont mal configurés ou utilisés, ils peuvent devenir un goulot d'étranglement des performances.

Solution :

- Analysez soigneusement l'utilisation des threads de votre application et ajustez la taille du pool de threads si nécessaire.

- Évitez de créer trop de threads pour éviter d'augmenter le changement de contexte et la surcharge de planification.

- Utilisez les outils d'analyse des performances pour identifier et résoudre les goulots d'étranglement des performances.

7. Problèmes de concurrence

Bien que les pools de threads soient conçus pour gérer des tâches concurrentes, des problèmes de concurrence peuvent toujours survenir s'il existe une concurrence de données entre les tâches.

Solution :

- Utilisez des mécanismes de synchronisation tels que des verrous ou des opérations atomiques pour garantir la cohérence des données.

- Envisagez d'utiliser des objets immuables pour éviter les courses aux données.

- Utilisez le stockage local des threads dans les tâches pour isoler les données de chaque thread.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment affiner la profondeur localement

Feb 19, 2025 pm 05:21 PM

Comment affiner la profondeur localement

Feb 19, 2025 pm 05:21 PM

Le réglage fin local des modèles de classe Deepseek est confronté au défi des ressources informatiques insuffisantes et de l'expertise. Pour relever ces défis, les stratégies suivantes peuvent être adoptées: quantification du modèle: convertir les paramètres du modèle en entiers à faible précision, réduisant l'empreinte de la mémoire. Utilisez des modèles plus petits: sélectionnez un modèle pré-entraîné avec des paramètres plus petits pour un réglage fin local plus facile. Sélection des données et prétraitement: sélectionnez des données de haute qualité et effectuez un prétraitement approprié pour éviter une mauvaise qualité des données affectant l'efficacité du modèle. Formation par lots: pour les grands ensembles de données, chargez les données en lots de formation pour éviter le débordement de la mémoire. Accélération avec GPU: Utilisez des cartes graphiques indépendantes pour accélérer le processus de formation et raccourcir le temps de formation.

Que faire si le navigateur Edge prend trop de mémoire Que faire si le navigateur Edge prend trop de mémoire

May 09, 2024 am 11:10 AM

Que faire si le navigateur Edge prend trop de mémoire Que faire si le navigateur Edge prend trop de mémoire

May 09, 2024 am 11:10 AM

1. Tout d’abord, entrez dans le navigateur Edge et cliquez sur les trois points dans le coin supérieur droit. 2. Ensuite, sélectionnez [Extensions] dans la barre des tâches. 3. Ensuite, fermez ou désinstallez les plug-ins dont vous n'avez pas besoin.

Pour seulement 250$, le directeur technique de Hugging Face vous apprend étape par étape comment peaufiner Llama 3

May 06, 2024 pm 03:52 PM

Pour seulement 250$, le directeur technique de Hugging Face vous apprend étape par étape comment peaufiner Llama 3

May 06, 2024 pm 03:52 PM

Les grands modèles de langage open source familiers tels que Llama3 lancé par Meta, les modèles Mistral et Mixtral lancés par MistralAI et Jamba lancé par AI21 Lab sont devenus des concurrents d'OpenAI. Dans la plupart des cas, les utilisateurs doivent affiner ces modèles open source en fonction de leurs propres données pour libérer pleinement le potentiel du modèle. Il n'est pas difficile d'affiner un grand modèle de langage (comme Mistral) par rapport à un petit en utilisant Q-Learning sur un seul GPU, mais le réglage efficace d'un grand modèle comme Llama370b ou Mixtral est resté un défi jusqu'à présent. . C'est pourquoi Philipp Sch, directeur technique de HuggingFace

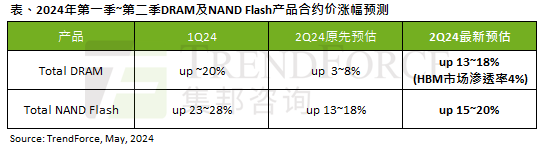

L'impact de la vague de l'IA est évident. TrendForce a révisé à la hausse ses prévisions d'augmentation des prix des contrats de mémoire DRAM et de mémoire flash NAND ce trimestre.

May 07, 2024 pm 09:58 PM

L'impact de la vague de l'IA est évident. TrendForce a révisé à la hausse ses prévisions d'augmentation des prix des contrats de mémoire DRAM et de mémoire flash NAND ce trimestre.

May 07, 2024 pm 09:58 PM

Selon un rapport d'enquête TrendForce, la vague de l'IA a un impact significatif sur les marchés de la mémoire DRAM et de la mémoire flash NAND. Dans l'actualité de ce site du 7 mai, TrendForce a déclaré aujourd'hui dans son dernier rapport de recherche que l'agence avait augmenté les augmentations de prix contractuels pour deux types de produits de stockage ce trimestre. Plus précisément, TrendForce avait initialement estimé que le prix du contrat de mémoire DRAM au deuxième trimestre 2024 augmenterait de 3 à 8 %, et l'estime désormais à 13 à 18 % en termes de mémoire flash NAND, l'estimation initiale augmentera de 13 à 8 % ; 18 %, et la nouvelle estimation est de 15 % ~ 20 %, seul eMMC/UFS a une augmentation inférieure de 10 %. ▲Source de l'image TrendForce TrendForce a déclaré que l'agence prévoyait initialement de continuer à

Programmation simultanée C++ : comment gérer la communication inter-thread ?

May 04, 2024 pm 12:45 PM

Programmation simultanée C++ : comment gérer la communication inter-thread ?

May 04, 2024 pm 12:45 PM

Les méthodes de communication inter-thread en C++ incluent : la mémoire partagée, les mécanismes de synchronisation (verrous mutex, variables de condition), les canaux et les files d'attente de messages. Par exemple, utilisez un verrou mutex pour protéger un compteur partagé : déclarez un verrou mutex (m) et une variable partagée (counter) ; chaque thread met à jour le compteur en verrouillant (lock_guard) ; pour éviter les conditions de course.

À quels pièges devons-nous prêter attention lors de la conception de systèmes distribués avec la technologie Golang ?

May 07, 2024 pm 12:39 PM

À quels pièges devons-nous prêter attention lors de la conception de systèmes distribués avec la technologie Golang ?

May 07, 2024 pm 12:39 PM

Pièges du langage Go lors de la conception de systèmes distribués Go est un langage populaire utilisé pour développer des systèmes distribués. Cependant, il existe certains pièges à prendre en compte lors de l'utilisation de Go qui peuvent nuire à la robustesse, aux performances et à l'exactitude de votre système. Cet article explorera quelques pièges courants et fournira des exemples pratiques sur la façon de les éviter. 1. Surutilisation de la concurrence Go est un langage de concurrence qui encourage les développeurs à utiliser des goroutines pour augmenter le parallélisme. Cependant, une utilisation excessive de la concurrence peut entraîner une instabilité du système, car trop de goroutines se disputent les ressources et entraînent une surcharge de changement de contexte. Cas pratique : une utilisation excessive de la concurrence entraîne des retards de réponse des services et une concurrence entre les ressources, qui se manifestent par une utilisation élevée du processeur et une surcharge importante de garbage collection.

Quels sont les frameworks et bibliothèques de programmation concurrente en C++ ? Quels sont leurs avantages et limites respectifs ?

May 07, 2024 pm 02:06 PM

Quels sont les frameworks et bibliothèques de programmation concurrente en C++ ? Quels sont leurs avantages et limites respectifs ?

May 07, 2024 pm 02:06 PM

Le cadre de programmation simultanée C++ propose les options suivantes : threads légers (std::thread) ; conteneurs et algorithmes de concurrence Boost sécurisés pour les threads ; OpenMP pour les multiprocesseurs à mémoire partagée ; bibliothèque d'opérations d'interaction simultanée C++ multiplateforme ; (cpp-Concur).

Quels avertissements ou mises en garde doivent être inclus dans la documentation des fonctions Golang ?

May 04, 2024 am 11:39 AM

Quels avertissements ou mises en garde doivent être inclus dans la documentation des fonctions Golang ?

May 04, 2024 am 11:39 AM

La documentation de la fonction Go contient des avertissements et des mises en garde essentiels pour comprendre les problèmes potentiels et éviter les erreurs. Ceux-ci incluent : Avertissement de validation des paramètres : vérifiez la validité des paramètres. Considérations sur la sécurité de la concurrence : indiquez la sécurité des threads d'une fonction. Considérations sur les performances : mettez en évidence le coût de calcul élevé ou l'empreinte mémoire d'une fonction. Annotation du type de retour : décrit le type d'erreur renvoyé par la fonction. Remarque sur les dépendances : répertorie les bibliothèques ou packages externes requis par la fonction. Avertissement de dépréciation : indique qu'une fonction est obsolète et suggère une alternative.