Périphériques technologiques

Périphériques technologiques

IA

IA

Avec seulement 200 millions de paramètres, les performances sans échantillon dépassent celles supervisées ! Google publie un modèle de base de prédiction de séries chronologiques TimesFM

Avec seulement 200 millions de paramètres, les performances sans échantillon dépassent celles supervisées ! Google publie un modèle de base de prédiction de séries chronologiques TimesFM

Avec seulement 200 millions de paramètres, les performances sans échantillon dépassent celles supervisées ! Google publie un modèle de base de prédiction de séries chronologiques TimesFM

La prévision des séries chronologiques joue un rôle important dans divers domaines, tels que la vente au détail, la finance, la fabrication, la santé et les sciences naturelles, etc. Dans le secteur de la vente au détail, les coûts de stocks peuvent être efficacement réduits et les revenus augmentés en améliorant la précision des prévisions de la demande. Cela signifie que les entreprises peuvent mieux répondre à la demande des clients, réduire les stocks excédentaires et les pertes, tout en augmentant leurs ventes et leurs bénéfices. Par conséquent, la prévision de séries chronologiques est d'une grande valeur dans le domaine de la vente au détail et peut apporter de la substance aux entreprises

Les modèles d'apprentissage en profondeur (DL) dominent la tâche de « prévision de séries chronologiques multivariables » et sont utilisés dans diverses compétitions et d'excellentes performances réelles dans applications.

Dans le même temps, des progrès significatifs ont été réalisés dans les modèles linguistiques de base à grande échelle dans les tâches de traitement du langage naturel (NLP), améliorant efficacement les performances de tâches telles que la traduction, la génération d'améliorations de récupération et la complétion de code.

La formation des modèles NLP repose sur des données textuelles massives, provenant de diverses sources, notamment des robots d'exploration, du code open source, etc. Le modèle formé peut reconnaître des modèles dans le langage et a la capacité d'apprendre à partir de zéro échantillon. : par exemple, les grands modèles sont utilisés dans des tâches de récupération où le modèle peut répondre à des questions sur les événements actuels et les résumer.

Bien que les prédicteurs basés sur le deep learning surpassent les méthodes traditionnelles à bien des égards, notamment en réduisant les coûts de formation et d'inférence, il reste encore certains défis à surmonter :

De nombreux modèles de deep learning subissent une longue formation et validation. Ce n'est qu'alors que cela pourra être testé sur une nouvelle série temporelle. En revanche, le modèle sous-jacent pour la prévision de séries chronologiques possède des capacités de « prévision prêtes à l'emploi » et peut être appliqué à des données de séries chronologiques inconnues sans formation supplémentaire. Cette fonctionnalité permet aux utilisateurs de se concentrer sur l'amélioration des prévisions pour des tâches pratiques en aval telles que la planification de la demande au détail.

Des chercheurs de Google Research ont récemment proposé un modèle de base pour la prévision de séries chronologiques appelé TimesFM, qui a été pré-entraîné sur 100 milliards de points temporels réels. Comparé aux grands modèles de langage (LLM) de pointe actuels, TimesFM est beaucoup plus petit, ne contenant que 200 millions de paramètres.

Lien papier : https://arxiv.org/pdf/2310.10688.pdf

Les résultats expérimentaux montrent que malgré sa petite échelle, TimesFM fonctionne différemment dans divers domaines et échelles de temps que sans formation. des « performances zéro tir » surprenantes, proches des performances de méthodes supervisées de pointe et explicitement entraînées sur ces ensembles de données.

Les chercheurs prévoient de mettre le modèle TimesFM à la disposition des clients externes dans Google Cloud Vertex AI plus tard cette année.

Modèle de base TimesFM

Les LLM sont généralement formés de manière uniquement par décodeur, en trois étapes :

1 Le texte est décomposé en sous-mots appelés jetons

2. Couche de transformateur causale empilée et génère une sortie correspondant à chaque jeton d'entrée. Il convient de noter que cette couche ne peut pas gérer les jetons sans entrée, c'est-à-dire les futurs jetons

3. informations des jetons précédents et prédit le (i+1)-ième jeton

Pendant l'inférence, LLM génère la sortie d'un jeton à la fois.

Par exemple, lors de la saisie de la question « Quelle est la capitale de la France ? » (Quelle est la capitale de la France ?), le modèle peut générer le jeton « Le », puis générer le jeton suivant « Capital » basé sur à cette invite. "(majuscule) et ainsi de suite jusqu'à ce que le modèle génère une réponse complète : "La capitale de la France est Paris" (La capitale de la France est Paris).

Le modèle sous-jacent pour la prévision des séries chronologiques doit s'adapter à des longueurs de contexte (ce que le modèle observe) et de plage (ce que le modèle de requête prédit) variables tout en étant suffisamment puissant pour coder tous les modèles à partir de grands ensembles de données pré-entraînés (modèles).

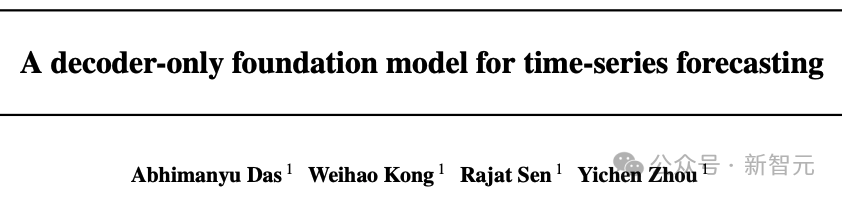

Semblable aux LLM, les chercheurs utilisent des couches Transformer empilées (couches d'auto-attention et de rétroaction) comme principaux éléments constitutifs du modèle TimesFM dans le contexte de la prévision de séries chronologiques, un patch (un ensemble de point temporel continu) à titre symbolique, l'idée vient de récents travaux de prévision à long horizon : la tâche spécifique est de prédire le (i+1)ème point temporel pour la i-ème sortie donnée à la fin du patch de couche Transformer empilé

Mais TimesFM présente plusieurs différences clés par rapport aux modèles de langage :

1 Le modèle nécessite un bloc perceptron multicouche avec des connexions résiduelles pour convertir les correctifs de séries temporelles en jetons, qui peuvent être comparés à la position Encoding (. PE) ainsi que l'entrée de la couche Transformer. Pour ce faire, nous utilisons des blocs résiduels similaires à nos travaux précédents en prédiction à long terme.

2. Le jeton de sortie du transformateur empilé peut être utilisé pour prédire la longueur des points temporels suivants qui est plus longue que la longueur du patch d'entrée, c'est-à-dire que la longueur du patch de sortie peut être supérieure à la longueur du patch d'entrée.

Supposons qu'une série temporelle d'une longueur de 512 points temporels soit utilisée pour entraîner un modèle TimesFM avec une « longueur de patch d'entrée 32 » et une « longueur de patch de sortie 128 » :

Pendant la formation, le modèle est formé à en même temps Pour prédire les 128 points temporels suivants en utilisant les 32 premiers points temporels, utilisez les 64 premiers points temporels pour prédire les points temporels 65 à 192, utilisez les 96 premiers points temporels pour prédire les points temporels 97 à 224, et ainsi de suite.

En supposant que les données d'entrée sont une série temporelle de longueur 256 et que sa tâche est de prédire les 256 prochains points temporels dans le futur, le modèle génère d'abord des prédictions futures pour les points temporels 257 à 384, puis prend le premier Entrée de longueur 256 plus La sortie générée est conditionnelle à la génération des points temporels 385 à 512.

En revanche, si dans le modèle, la longueur du patch de sortie est égale à la longueur du patch d'entrée 32, alors pour la même tâche, le modèle passe par huit étapes de génération au lieu de 2, augmentant le risque d'accumulation d'erreurs et donc dans les résultats expérimentaux, comme on peut le voir dans , une longueur de patch de sortie plus longue entraînera de meilleures performances de prédiction à long terme.

Données de pré-formation

Tout comme les LLM peuvent s'améliorer avec plus de jetons, TimesFM nécessite de grandes quantités de données de séries chronologiques légitimes pour apprendre et s'améliorer ; les chercheurs passent beaucoup de temps à créer et à évaluer des ensembles de données de formation et ont trouvé deux meilleures méthodes ; :

Les données synthétiques aident avec les bases

Vous pouvez utiliser des modèles statistiques ou des simulations physiques pour générer des données de séries chronologiques synthétiques significatives, essentiellement. Le modèle temporel peut guider le modèle pour apprendre la grammaire de la prédiction des séries chronologiques.

Les données du monde réel ajoutent une saveur du monde réel

Les chercheurs ont passé au peigne fin les ensembles de données de séries chronologiques publiques disponibles et ont combiné sélectivement 100 milliards Un vaste corpus de points temporels est constitué.

Dans l'ensemble de données, il y a des pages vues de Google Trends et Wikipedia, qui suivent ce qui intéresse les utilisateurs et reflètent bien les tendances et les modèles de nombreuses autres séries chronologiques du monde réel, aidant TimesFM à comprendre la situation dans son ensemble. peut améliorer les performances de généralisation pour les « contextes spécifiques à un domaine non vus pendant la formation ».

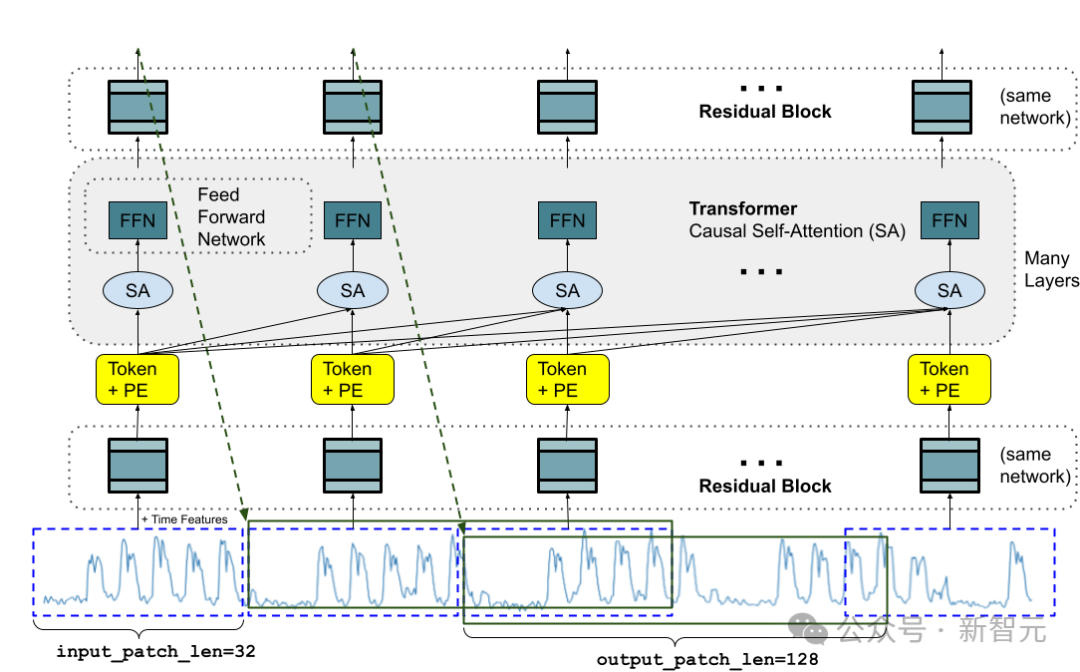

Résultats de l'évaluation sur échantillon zéro

Les chercheurs ont mené une évaluation sur échantillon zéro de TimesFM sur des données invisibles pendant la formation en utilisant une référence de série chronologique couramment utilisée, et il a été observé que TimesFM surpassait la plupart des méthodes statistiques telles que ARIMA, ETS, et peut égaler ou surpasser de puissants modèles DL tels que DeepAR, PatchTST, qui ont été explicitement formés sur des séries chronologiques cibles.

Les chercheurs ont utilisé Monash Forecasting Archive pour évaluer les performances prêtes à l'emploi de TimesFM, un ensemble de données contenant des dizaines de milliers de séries chronologiques provenant de divers domaines tels que les prévisions de trafic, de météo et de demande, couvrant des fréquences allant de quelques minutes. aux données annuelles.

Sur la base de la littérature existante, les chercheurs ont examiné l'erreur absolue moyenne (MAE) correctement mise à l'échelle pour obtenir la moyenne sur l'ensemble de données.

Comme on peut le constater, Zero-shot (ZS) TimesFM surpasse la plupart des méthodes supervisées, y compris les récents modèles d'apprentissage en profondeur. TimesFM et GPT-3.5 ont également été comparés pour la prédiction à l'aide de la technologie d'indication spécifique proposée par llmtime (ZS), et les résultats ont prouvé que TimesFM fonctionnait mieux que llmtime (ZS)

Sur l'ensemble de données Monash, TimesFM (ZS ) Rapport MAE par rapport à d'autres méthodes supervisées et sans tir (plus le niveau est faible, mieux c'est)

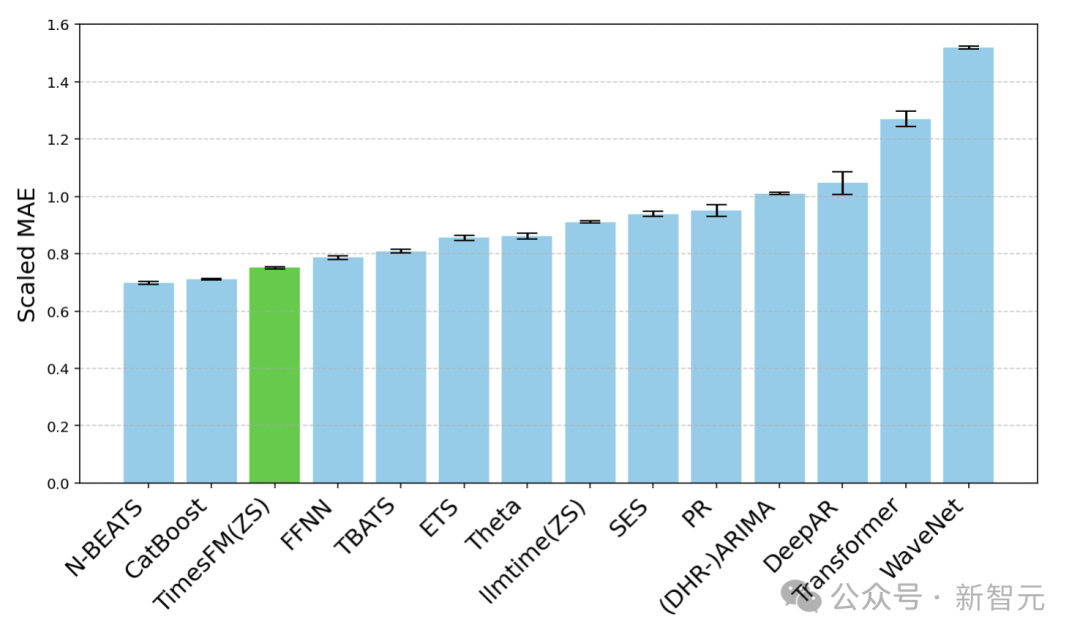

La plupart des ensembles de données Monash sont à court ou à moyen terme, ce qui signifie que la longueur de prédiction n'est pas trop longue. les prévisions à long terme sont le PatchTST de référence de pointe (et d’autres références de prévision à long terme).

Les chercheurs ont tracé le MAE sur l'ensemble de données ETT pour la tâche de prévoir 96 et 192 points temporels dans le futur, en calculant la métrique sur la dernière fenêtre de test de chaque ensemble de données.

Dernière fenêtre MAE (le plus bas est le meilleur) de TimesFM (ZS) par rapport à llmtime (ZS) et la référence de prévision à long terme sur l'ensemble de données ETT

Comme on peut le voir, TimesFM ne dépasse pas seulement llmtime ( ZS) et correspond à celui d'un modèle PatchTST supervisé explicitement formé sur l'ensemble de données correspondant.

Conclusion

Les chercheurs ont formé un modèle de base uniquement décodeur en utilisant un vaste corpus de pré-formation de 100 milliards de points temporels réels, dont la plupart étaient des données de séries chronologiques d'intérêt de recherche de Google Trends et des pages de Wikipedia Views.

Les résultats montrent que même un modèle pré-entraîné relativement petit de 200 M de paramètres, utilisant l'architecture TimesFM, présente d'assez bonnes performances zéro-shot dans divers benchmarks publics (différents domaines et granularités).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,