Périphériques technologiques

Périphériques technologiques

IA

IA

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

Il n'y a pas si longtemps, OpenAI Sora est rapidement devenu populaire grâce à ses incroyables effets de génération vidéo. Il s'est démarqué parmi la foule des modèles vidéo Wensheng et est devenu le centre de l'attention mondiale. Suite au lancement du processus de reproduction d'inférence de formation Sora avec une réduction des coûts de 46 % il y a 2 semaines, l'équipe Colossal-AI a entièrement open source le premier modèle de génération vidéo d'architecture de type Sora au monde "Open-Sora 1.0", couvrant l'ensemble du processus de formation. , y compris le traitement des données, tous les détails de formation et les poids des modèles, et joignez-vous à des passionnés mondiaux d'IA pour promouvoir une nouvelle ère de création vidéo.

Pour un aperçu, regardons d'abord une vidéo d'une ville animée générée par le modèle « Open-Sora 1.0 » publié par l'équipe Colossal-AI.

Un instantané de la ville animée généré par Open-Sora 1.0

Ce n'est que la pointe de l'iceberg de la technologie de reproduction de Sora concernant l'architecture du modèle de la vidéo Wensheng ci-dessus, les poids du modèle entraîné et. tous les détails de formation de la reproduction, L'équipe Colossal-AI a rendu le processus de prétraitement des données, l'affichage de la démonstration et les didacticiels de démarrage détaillés gratuits et open source sur GitHub. Dans le même temps, l'auteur a immédiatement contacté l'équipe et a appris qu'ils le feraient. continuez à mettre à jour les solutions liées à Open-Sora et les derniers développements, les amis intéressés peuvent continuer à prêter attention à la communauté open source d'Open-Sora .

Adresse open source Open-Sora : https://github.com/hpcaitech/Open-Sora

Interprétation complète de la solution de réplication Sora

Ensuite, nous approfondirons plusieurs aspects de Sora solution de réplication Les aspects clés incluent la conception de l'architecture du modèle, les méthodes de formation, le prétraitement des données, l'affichage des effets du modèle et les stratégies de formation d'optimisation.

Conception de l'architecture du modèle

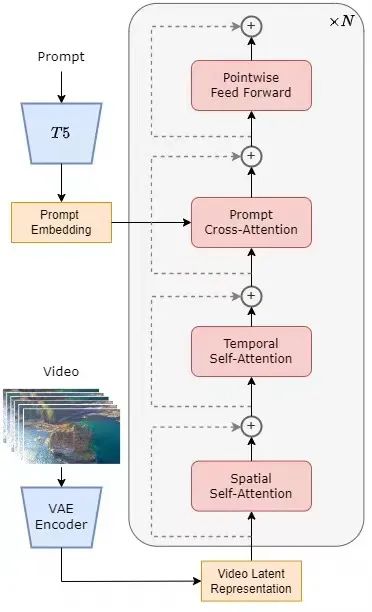

Le modèle adopte l'architecture actuellement populaire du transformateur de diffusion (DiT) [1]. L'équipe d'auteurs utilise le modèle graphique Vincent open source de haute qualité PixArt-α [2] qui utilise également l'architecture DiT comme base, introduit une couche d'attention temporelle sur cette base et l'étend aux données vidéo. Plus précisément, l'ensemble de l'architecture comprend un VAE pré-entraîné, un encodeur de texte et un modèle STDiT (Spatial Temporal Diffusion Transformer) qui utilise le mécanisme d'attention spatio-temporelle. Parmi eux, la structure de chaque couche de STDiT est présentée dans la figure ci-dessous. Il utilise une méthode sérielle pour superposer un module d'attention temporelle unidimensionnelle sur un module d'attention spatiale bidimensionnelle afin de modéliser les relations temporelles. Après le module d'attention temporelle, le module d'attention croisée permet d'aligner la sémantique du texte. Par rapport au mécanisme d’attention totale, une telle structure réduit considérablement les frais de formation et d’inférence. Par rapport au modèle Latte [3], qui utilise également un mécanisme d'attention spatio-temporel, STDiT peut mieux utiliser les poids des images DiT pré-entraînées pour continuer l'entraînement sur les données vidéo.

Schéma structurel STDiT

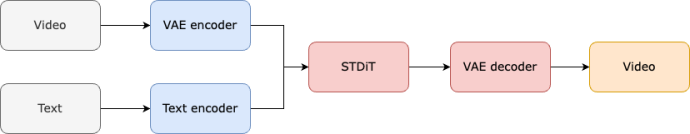

Le processus de formation et d'inférence de l'ensemble du modèle est le suivant. Il est entendu que dans la phase de formation, l'encodeur Variational Autoencoder (VAE) pré-entraîné est d'abord utilisé pour compresser les données vidéo, puis le modèle de diffusion STDiT est formé avec l'intégration de texte dans l'espace latent compressé. Lors de l'étape d'inférence, un bruit gaussien est échantillonné de manière aléatoire dans l'espace latent de VAE et entré dans STDiT avec une intégration rapide pour obtenir les caractéristiques débruitées. Enfin, il est entré dans le décodeur de VAE et décodé pour obtenir la vidéo.

Processus de formation du modèle

Plan de reproduction de la formation

Nous avons appris de l'équipe que le plan de reproduction d'Open-Sora fait référence au travail de diffusion vidéo stable (SVD)[3]. Il se compose de trois. étapes, à savoir :

- Pré-formation en image à grande échelle.

- Pré-formation vidéo à grande échelle.

- Réglage précis des données vidéo de haute qualité.

Chaque étape continuera l'entraînement en fonction des poids de l'étape précédente. Par rapport à la formation en une seule étape à partir de zéro, la formation en plusieurs étapes atteint plus efficacement l'objectif de génération vidéo de haute qualité en développant progressivement les données.

Trois étapes du plan d'entraînement

La première étape : pré-formation d'images à grande échelle

La première étape utilise une pré-formation d'images à grande échelle et utilise le modèle de graphique vincentien mature pour réduire efficacement le coût de la pré-formation vidéo.

L'équipe d'auteurs nous a révélé que grâce aux riches données d'images à grande échelle sur Internet et à la technologie avancée des graphiques Vincent, nous pouvons former un modèle de graphique Vincent de haute qualité, qui servira de poids d'initialisation pour la prochaine étape. de pré-formation vidéo. Dans le même temps, comme il n’existe actuellement pas de VAE spatio-temporelle de haute qualité, ils ont utilisé la VAE d’image pré-entraînée par le modèle Stable Diffusion [5]. Cette stratégie garantit non seulement les performances supérieures du modèle initial, mais réduit également considérablement le coût global de la pré-formation vidéo.

La deuxième étape : pré-entraînement vidéo à grande échelle

La deuxième étape effectue un pré-entraînement vidéo à grande échelle pour augmenter la capacité de généralisation du modèle et saisir efficacement la corrélation des séries chronologiques des vidéos.

Nous comprenons que cette étape nécessite une grande quantité de formation sur les données vidéo pour assurer la diversité des thèmes vidéo, augmentant ainsi la capacité de généralisation du modèle. Le modèle de deuxième étape ajoute un module d'attention temporelle au modèle graphique vincentien de première étape pour apprendre les relations temporelles dans les vidéos. Les modules restants restent cohérents avec la première étape et chargent les poids de la première étape comme initialisation, tout en initialisant la sortie du module d'attention temporelle à zéro pour obtenir une convergence plus efficace et plus rapide. L'équipe Colossal-AI a utilisé les poids open source de PixArt-alpha [2] comme initialisation pour le modèle STDiT de deuxième étape, et le modèle T5 [6] comme encodeur de texte. Dans le même temps, ils ont utilisé une petite résolution de 256 x 256 pour la pré-formation, ce qui a encore augmenté la vitesse de convergence et réduit les coûts de formation.

La troisième étape : affiner les données vidéo de haute qualité

La troisième étape affine les données vidéo de haute qualité pour améliorer considérablement la qualité de la génération vidéo.

L'équipe d'auteurs a mentionné que la taille des données vidéo utilisées dans la troisième étape est d'un ordre de grandeur inférieure à celle de la deuxième étape, mais que la longueur, la résolution et la qualité de la vidéo sont supérieures. En ajustant ainsi, ils ont obtenu une mise à l'échelle efficace de la génération vidéo de courte à longue, de basse à haute résolution et de basse à haute fidélité.

L'équipe d'auteurs a déclaré que dans le processus de reproduction Open-Sora, ils ont utilisé 64 blocs H800 pour l'entraînement. Le volume total de formation de la deuxième étape est de 2 808 heures GPU, soit environ 7 000 $, et le volume de formation de la troisième étape est de 1 920 heures GPU, soit environ 4 500 $. Après des estimations préliminaires, l'ensemble du programme de formation a réussi à contrôler le processus de reproduction d'Open-Sora à environ 10 000 $ US.

Prétraitement des données

Afin de réduire davantage le seuil et la complexité de la reproduction de Sora, l'équipe Colossal-AI fournit également un script de prétraitement des données vidéo pratique dans l'entrepôt de code, afin que tout le monde puisse facilement démarrer la reproduction de Sora. -la formation comprend le téléchargement d'ensembles de données vidéo publiques, la segmentation de longues vidéos en courts clips vidéo en fonction de la continuité des plans et l'utilisation du grand modèle de langage open source LLaVA [7] pour générer des mots d'invite précis. L'équipe d'auteurs a mentionné que le code de génération de titres vidéo par lots qu'ils ont fourni peut annoter une vidéo avec deux cartes et 3 secondes, et que la qualité est proche de GPT-4V. Les couples vidéo/texte résultants peuvent être utilisés directement pour la formation. Avec le code open source qu'ils fournissent sur GitHub, nous pouvons générer facilement et rapidement les paires vidéo/texte nécessaires à la formation sur notre propre ensemble de données, réduisant ainsi considérablement le seuil technique et la préparation préliminaire au démarrage d'un projet de réplication Sora.

Paire vidéo/texte générée automatiquement en fonction du script de prétraitement des données

Affichage de l'effet de génération de modèle

Jetons un coup d'œil à l'effet de génération vidéo réel d'Open-Sora. Par exemple, laissez Open-Sora générer une séquence aérienne d’eau de mer clapotant contre les rochers d’une falaise.

Laissez Open-Sora capturer la vue aérienne majestueuse des montagnes et des cascades jaillissant des falaises et se jetant finalement dans le lac.

En plus d'aller vers le ciel, vous pouvez également entrer dans la mer. Entrez simplement l'invite et laissez Open-Sora générer une photo du monde sous-marin. Dans la photo, une tortue de mer nage tranquillement parmi. les récifs coralliens.

Open-Sora peut également nous montrer la Voie lactée avec des étoiles scintillantes grâce à la photographie accélérée.

Si vous avez des idées plus intéressantes pour la génération de vidéos, vous pouvez visiter la communauté open source Open-Sora pour obtenir les poids des modèles pour une expérience gratuite. Lien : https://github.com/hpcaitech/Open-Sora

Il est à noter que l'équipe d'auteurs a mentionné sur Github que la version actuelle n'utilise que 400 000 données d'entraînement, la qualité de génération du modèle et la possibilité de suivre du texte. Tout doit être amélioré. Par exemple, dans la vidéo de tortue ci-dessus, la tortue résultante a une patte supplémentaire. Open-Sora 1.0 n'est pas non plus efficace pour générer des portraits et des images complexes. L'équipe d'auteurs a répertorié une série de plans à réaliser sur Github, visant à résoudre en permanence les défauts existants et à améliorer la qualité de la production.

Support de formation efficace

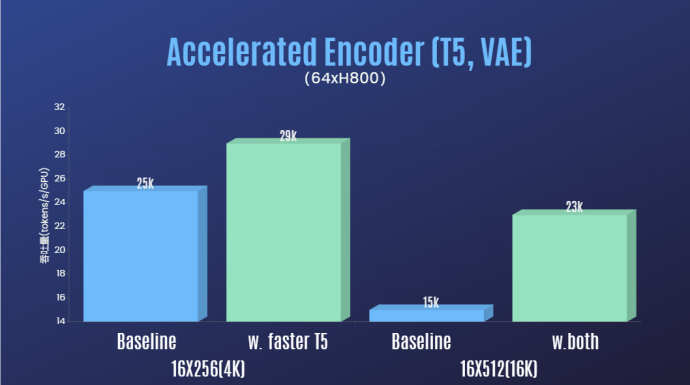

En plus de réduire considérablement le seuil technique de reproduction Sora et d'améliorer la qualité de la génération vidéo dans de multiples dimensions telles que la durée, la résolution et le contenu, l'équipe d'auteur fournit également l'accélération Colossal-AI système pour la reproduction de Sora. Support de formation efficace maintenant. Grâce à des stratégies de formation efficaces telles que l'optimisation des opérateurs et le parallélisme hybride, un effet d'accélération de 1,55 fois a été obtenu lors de la formation au traitement de vidéos de 64 images, d'une résolution de 512 x 512. Dans le même temps, grâce au système de gestion de mémoire hétérogène de Colossal-AI, une tâche de formation vidéo haute définition 1080p d'une minute peut être effectuée sans entrave sur un seul serveur (8*H800).

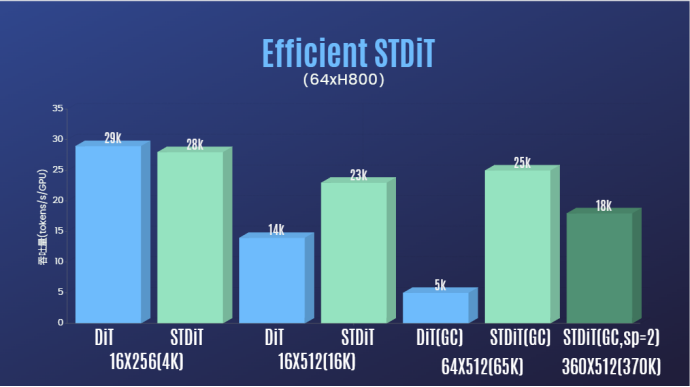

De plus, dans le rapport de l'équipe d'auteurs, nous avons également constaté que l'architecture du modèle STDiT a également montré une excellente efficacité lors de la formation. Comparé à DiT, qui utilise un mécanisme d'attention totale, STDiT atteint une accélération jusqu'à 5 fois supérieure à mesure que le nombre d'images augmente, ce qui est particulièrement critique dans les tâches du monde réel telles que le traitement de longues séquences vidéo.

Bienvenue pour continuer à prêter attention au projet open source Open-Sora : https://github.com/hpcaitech/Open-Sora

L'équipe d'auteur a déclaré qu'elle continuerait à maintenir et à optimiser le projet Open-Sora et devraient utiliser davantage de données de formation vidéo pour générer un contenu vidéo plus long et de meilleure qualité, et prendre en charge des fonctionnalités multi-résolution pour promouvoir efficacement la mise en œuvre de la technologie de l'IA dans les films, les jeux, la publicité et d'autres domaines.

Lien de référence :

[1] https://arxiv.org/abs/2212.09748 Modèles de diffusion évolutifs avec transformateurs.

[2] https://arxiv.org/abs/2310.00426 PixArt-α : Formation rapide du transformateur de diffusion pour la synthèse photoréaliste de texte en image.

[3] https://arxiv.org/abs/2311.15127 Diffusion vidéo stable : mise à l'échelle des modèles de diffusion vidéo latente vers de grands ensembles de données.

[4] https://arxiv.org/abs/2401.03048 Latte : Transformateur de diffusion latente pour la génération vidéo.

[5] https://huggingface.co/stabilityai/sd-vae-ft-mse-original.

[6] https://github.com/google-research/text-to-text-transfer-transformer.

[7] https://github.com/haotian-liu/LLaVA.

[8] https://hpc-ai.com/blog/open-sora-v1.0.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Si la réponse donnée par le modèle d’IA est incompréhensible du tout, oseriez-vous l’utiliser ? À mesure que les systèmes d’apprentissage automatique sont utilisés dans des domaines de plus en plus importants, il devient de plus en plus important de démontrer pourquoi nous pouvons faire confiance à leurs résultats, et quand ne pas leur faire confiance. Une façon possible de gagner confiance dans le résultat d'un système complexe est d'exiger que le système produise une interprétation de son résultat qui soit lisible par un humain ou un autre système de confiance, c'est-à-dire entièrement compréhensible au point que toute erreur possible puisse être trouvé. Par exemple, pour renforcer la confiance dans le système judiciaire, nous exigeons que les tribunaux fournissent des avis écrits clairs et lisibles qui expliquent et soutiennent leurs décisions. Pour les grands modèles de langage, nous pouvons également adopter une approche similaire. Cependant, lorsque vous adoptez cette approche, assurez-vous que le modèle de langage génère

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Selon les informations de ce site Web du 5 juillet, GlobalFoundries a publié un communiqué de presse le 1er juillet de cette année, annonçant l'acquisition de la technologie de nitrure de gallium (GaN) et du portefeuille de propriété intellectuelle de Tagore Technology, dans l'espoir d'élargir sa part de marché dans l'automobile et Internet. des objets et des domaines d'application des centres de données d'intelligence artificielle pour explorer une efficacité plus élevée et de meilleures performances. Alors que des technologies telles que l’intelligence artificielle générative (GenerativeAI) continuent de se développer dans le monde numérique, le nitrure de gallium (GaN) est devenu une solution clé pour une gestion durable et efficace de l’énergie, notamment dans les centres de données. Ce site Web citait l'annonce officielle selon laquelle, lors de cette acquisition, l'équipe d'ingénierie de Tagore Technology rejoindrait GF pour développer davantage la technologie du nitrure de gallium. g

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

Selon les informations de ce site le 1er août, SK Hynix a publié un article de blog aujourd'hui (1er août), annonçant sa participation au Global Semiconductor Memory Summit FMS2024 qui se tiendra à Santa Clara, Californie, États-Unis, du 6 au 8 août, présentant de nombreuses nouvelles technologies de produit. Introduction au Future Memory and Storage Summit (FutureMemoryandStorage), anciennement Flash Memory Summit (FlashMemorySummit) principalement destiné aux fournisseurs de NAND, dans le contexte de l'attention croissante portée à la technologie de l'intelligence artificielle, cette année a été rebaptisée Future Memory and Storage Summit (FutureMemoryandStorage) pour invitez les fournisseurs de DRAM et de stockage et bien d’autres joueurs. Nouveau produit SK hynix lancé l'année dernière