Périphériques technologiques

Périphériques technologiques

IA

IA

CVPR 2024 | Cadre d'estimation de pose d'objet 6D à échantillon zéro SAM-6D, un pas de plus vers l'intelligence incarnée

CVPR 2024 | Cadre d'estimation de pose d'objet 6D à échantillon zéro SAM-6D, un pas de plus vers l'intelligence incarnée

CVPR 2024 | Cadre d'estimation de pose d'objet 6D à échantillon zéro SAM-6D, un pas de plus vers l'intelligence incarnée

L'estimation de la pose d'un objet joue un rôle clé dans de nombreuses applications pratiques, notamment dans des domaines tels que l'intelligence incorporée, le fonctionnement des robots et la réalité augmentée.

Dans ce domaine, la première tâche à retenir est l'Estimation de pose 6D au niveau de l'instance, qui nécessite des données annotées sur l'objet cible pour la formation du modèle, rendant le modèle profond spécifique à l'objet et incapable d'être transféré à de nouveaux objets. supérieur. Plus tard, l'accent de la recherche s'est progressivement tourné vers l'estimation de pose 6D au niveau de la catégorie, qui est utilisée pour traiter des objets invisibles, mais nécessite que l'objet appartienne à une catégorie d'intérêt connue. Et

estimation de pose 6D zéro tirest un paramètre de tâche plus général, étant donné un modèle CAO de n'importe quel objet, visant à détecter l'objet cible dans la scène et à estimer sa pose 6D. Malgré son importance, ce paramètre de tâche sans tir est confronté à des défis importants en matière de détection d'objets et d'estimation de pose.

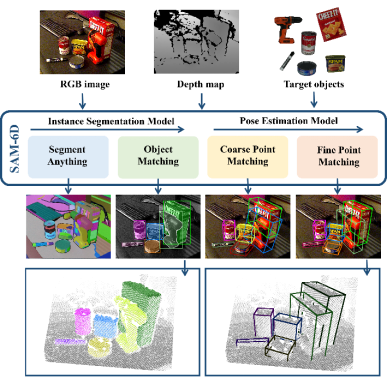

Figure 1. Tâche d'estimation de la pose d'un objet 6D à échantillon nul Récemment, la segmentation de tous les modèles SAM [1] a attiré beaucoup d'attention, et son excellente capacité de segmentation sans échantillon est accrocheuse. SAM réalise une segmentation de haute précision grâce à divers indices, tels que des pixels, des cadres de délimitation, du texte et des masques, etc., qui fournissent également un support fiable pour la tâche d'estimation de la pose d'objet 6D à échantillon nul, démontrant ainsi son potentiel prometteur.

Par conséquent, un nouveau cadre d'estimation de pose d'objet 6D à échantillon nul, SAM-6D, a été proposé par des chercheurs de Cross-Dimensional Intelligence, de l'Université chinoise de Hong Kong (Shenzhen) et de l'Université de technologie de Chine du Sud. Cette recherche a été reconnue par CVPR 2024.

- Lien papier : https://arxiv.org/pdf/2311.15707.pdf

- Lien code : https://github.com/JiehongLin/SAM-6D

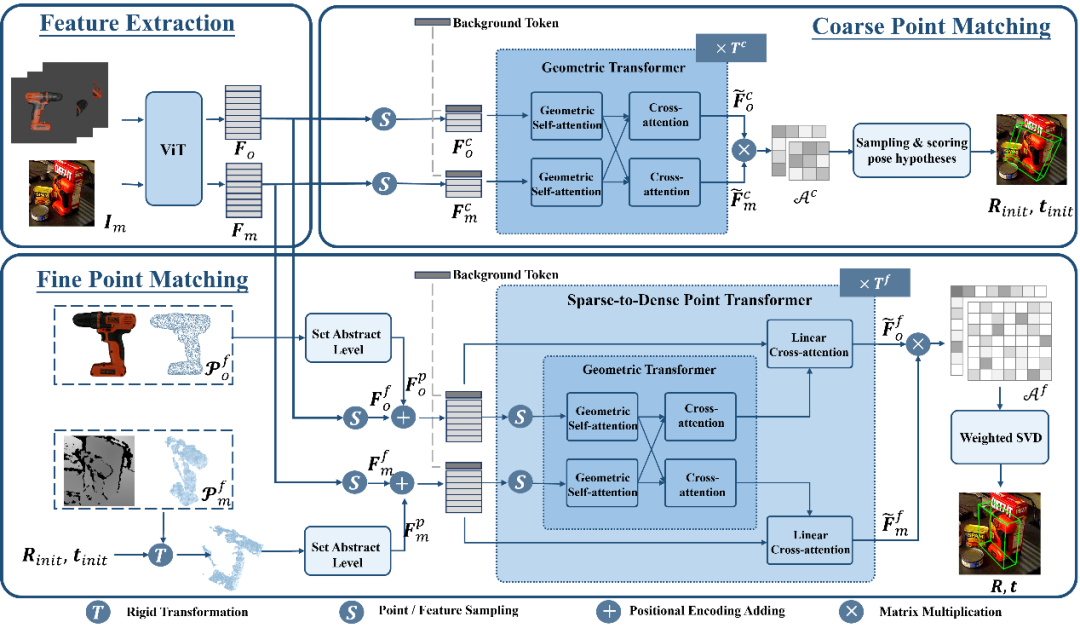

- SAM-6D L'estimation de la pose d'un objet 6D à échantillon nul est réalisée en deux étapes, notamment la segmentation des instances et l'estimation de la pose. De manière correspondante, pour tout objet cible, SAM-6D utilise deux sous-réseaux dédiés, à savoir le modèle de segmentation d'instance (ISM) et le modèle d'estimation de pose (PEM)

SAM-6D exploite la capacité de segmentation sans tir du modèle Segment Everything pour générer tous les candidats possibles et conçoit un nouveau score de correspondance d'objets pour identifier les candidats correspondant aux objets cibles.

SAM-6D traite l'estimation de pose comme un problème de correspondance d'ensembles de points local à local, adopte une conception de jeton d'arrière-plan simple mais efficace et propose d'abord un modèle de correspondance d'ensembles de points en deux étapes pour les objets arbitraires. une correspondance d'ensemble de points grossière pour obtenir la pose initiale de l'objet, et la deuxième étape utilise un nouveau transformateur d'ensemble de points clairsemé à dense pour effectuer une correspondance d'ensemble de points fine afin d'optimiser davantage la pose.- Modèle de segmentation d'instance (ISM)

- SAM-6D utilise le modèle de segmentation d'instance (ISM) pour détecter et segmenter des masques d'objets arbitraires.

- Étant donné une scène encombrée représentée par des images RVB, ISM exploite la capacité de transfert zéro-shot du Segmentation Everything Model (SAM) pour générer tous les candidats possibles. Pour chaque objet candidat, ISM calcule un score de correspondance d'objet pour estimer dans quelle mesure il correspond à l'objet cible en termes de sémantique, d'apparence et de géométrie. Enfin, en définissant simplement un seuil de correspondance, les instances correspondant à l'objet cible peuvent être identifiées. Le score de correspondance d'objet est calculé par la somme pondérée de trois termes de correspondance :

Terme de correspondance sémantique - Pour l'objet cible, ISM restitue les modèles d'objet sous plusieurs perspectives et utilise DINOv2 [3] pour la pré-formation. Le modèle ViT extrait les caractéristiques sémantiques des objets candidats et des modèles d'objets, et calcule les scores de corrélation entre eux. Le score de correspondance sémantique est obtenu en faisant la moyenne des K scores les plus élevés, et le modèle d'objet correspondant au score de corrélation le plus élevé est considéré comme le meilleur modèle de correspondance.

Correspondance d'apparence - Pour le meilleur modèle de correspondance, le modèle ViT est utilisé pour extraire les caractéristiques du bloc d'image et calculer la corrélation entre elles et les caractéristiques du bloc de l'objet candidat pour obtenir le score de correspondance d'apparence, qui est utilisé pour distinguer sémantiquement similaire mais des objets correspondant à l'apparence.

Correspondances géométriques - En tenant compte de facteurs tels que les différences de forme et de taille des différents objets, ISM a également conçu un score de correspondance géométrique. La moyenne de la rotation correspondant au modèle le mieux adapté et au nuage de points de l'objet candidat peut donner une pose d'objet approximative, et le cadre de délimitation peut être obtenu en transformant et en projetant de manière rigide le modèle CAO d'objet à l'aide de cette pose. Le calcul du rapport d'intersection sur union (IoU) entre le cadre englobant et le cadre englobant candidat peut obtenir le score de correspondance géométrique.

Modèle d'estimation de pose (PEM)

Pour chaque objet candidat qui correspond à un objet cible, SAM-6D utilise un modèle d'estimation de pose (PEM) pour prédire sa pose 6D par rapport au modèle CAO de l'objet.

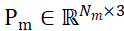

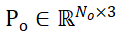

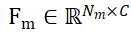

Désignons les ensembles de points d'échantillonnage des objets candidats segmentés et des modèles CAO d'objets respectivement par  et

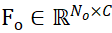

et  , où N_m et N_o représentent le nombre de leurs points en même temps, représentent les caractéristiques de ces deux ensembles de points par

, où N_m et N_o représentent le nombre de leurs points en même temps, représentent les caractéristiques de ces deux ensembles de points par  et

et  , C représente le nombre de canaux de la fonctionnalité. L'objectif de PEM est d'obtenir une matrice d'affectation qui représente la correspondance locale à locale de P_m à P_o ; en raison de l'occlusion, P_o ne correspond que partiellement à P_m, et en raison de l'imprécision de la segmentation et du bruit du capteur, P_m ne correspond que partiellement aux correspondances ET partielles. P_o.

, C représente le nombre de canaux de la fonctionnalité. L'objectif de PEM est d'obtenir une matrice d'affectation qui représente la correspondance locale à locale de P_m à P_o ; en raison de l'occlusion, P_o ne correspond que partiellement à P_m, et en raison de l'imprécision de la segmentation et du bruit du capteur, P_m ne correspond que partiellement aux correspondances ET partielles. P_o.

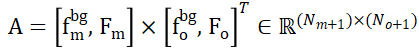

Afin de résoudre le problème de l'attribution de points qui ne se chevauchent pas dans deux ensembles de points, ISM les équipe de jetons d'arrière-plan, notés  et

et  , qui peuvent établir efficacement une correspondance locale à locale basée sur la similarité des caractéristiques. Plus précisément, la matrice d'attention peut d'abord être calculée comme suit :

, qui peuvent établir efficacement une correspondance locale à locale basée sur la similarité des caractéristiques. Plus précisément, la matrice d'attention peut d'abord être calculée comme suit :

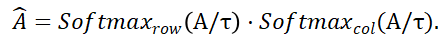

Ensuite, la matrice de distribution

et

et  représentent l'opération softmax le long des lignes et des colonnes respectivement, et

représentent l'opération softmax le long des lignes et des colonnes respectivement, et  représente une constante. La valeur de chaque ligne de

représente une constante. La valeur de chaque ligne de  (sauf la première ligne) représente la probabilité de correspondance de chaque point P_m dans l'ensemble de points P_m avec l'arrière-plan et le point médian de P_o. En localisant l'indice du score maximum, le point correspondant à P_m (y compris. l'arrière-plan) peut être trouvé ).

(sauf la première ligne) représente la probabilité de correspondance de chaque point P_m dans l'ensemble de points P_m avec l'arrière-plan et le point médian de P_o. En localisant l'indice du score maximum, le point correspondant à P_m (y compris. l'arrière-plan) peut être trouvé ).

Une fois  calculé, toutes les paires de points correspondantes {(P_m,P_o)} et leurs scores correspondants peuvent être rassemblés, et enfin le SVD pondéré est utilisé pour calculer la pose de l'objet.

calculé, toutes les paires de points correspondantes {(P_m,P_o)} et leurs scores correspondants peuvent être rassemblés, et enfin le SVD pondéré est utilisé pour calculer la pose de l'objet.

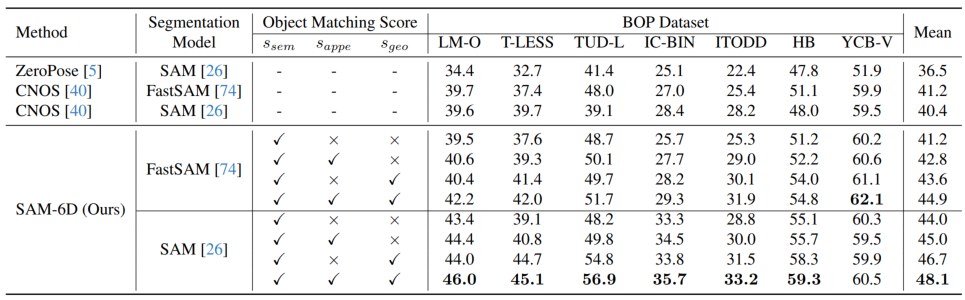

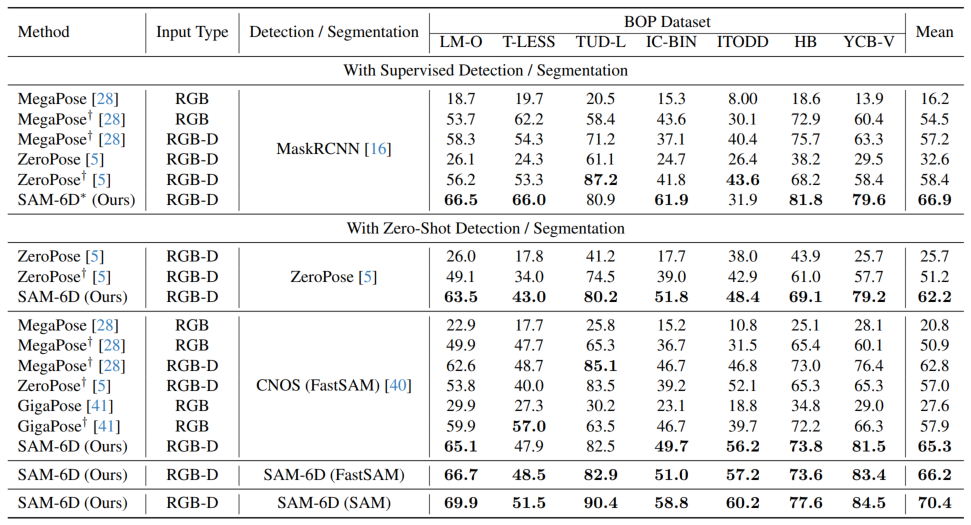

En utilisant la stratégie ci-dessus basée sur le jeton d'arrière-plan, deux étapes de correspondance d'ensembles de points sont conçues dans PEM. La structure du modèle est illustrée dans la figure 3, qui comprend l'extraction de caractéristiques, la correspondance d'ensembles de points grossiers et la correspondance d'ensembles de points finstrois modules. Le module de correspondance d'ensemble de points approximatifs implémente une correspondance clairsemée pour calculer la pose initiale de l'objet, puis utilise cette pose pour transformer l'ensemble de points de l'objet candidat afin d'obtenir un apprentissage du codage de position. Le module de correspondance d'ensembles de points fins combine le codage de position des ensembles de points d'échantillonnage de l'objet candidat et de l'objet cible, injectant ainsi la correspondance approximative dans la première étape et établissant davantage une correspondance dense pour obtenir une pose d'objet plus précise. Afin d'apprendre efficacement les interactions denses à ce stade, PEM introduit un nouveau transformateur d'ensemble de points clairsemé à dense, qui implémente des interactions sur des versions clairsemées de caractéristiques denses, et utilise le transformateur linéaire [5] pour transformer les caractéristiques clairsemées améliorées en diffusion en dense. caractéristiques. Résultats expérimentaux Pour les deux sous-modèles de SAM-6D, le modèle de segmentation d'instance (ISM) est construit sur la base de SAM sans nécessiter de recyclage et de réglage du réseau, tandis que le modèle d'estimation de pose (PEM) utilise MegaPose. [4] fournit des ensembles de données synthétiques ShapeNet-Objects et Google-Scanned-Objects à grande échelle pour la formation. Pour vérifier sa capacité à échantillon zéro, SAM-6D a été testé sur sept ensembles de données de base de BOP [2], notamment LM-O, T-LESS, TUD-L, IC-BIN, ITODD, HB et YCB-V. . Les tableaux 1 et 2 montrent respectivement la comparaison de la segmentation des instances et les résultats de l'estimation de pose de différentes méthodes sur ces sept ensembles de données. Comparé à d’autres méthodes, SAM-6D fonctionne très bien sur les deux méthodes, démontrant pleinement sa forte capacité de généralisation. B Tableau 1. Le résultat de stérilisation de différentes méthodes sur les sept ensembles de données de base sur BOP Tableaux 2. Différentes méthodes sur l'attitude des différentes méthodes sur les sept ensembles de données de base de BOP Comparaison des résultats Pour plus de détails sur la mise en œuvre de SAM-6D, n'hésitez pas à lire l'article original. [1] Alexander Kirillov et al., "Segment any." [2] Martin Sundermeyer et. al., "Bop challenge 2022 sur la détection, la segmentation et l'estimation de pose d'objets rigides spécifiques." [3] Maxime Oquab et al., "Dinov2 : Learning Fonctionnalités visuelles robustes sans supervision. . . al., "Les transformateurs sont des RNN : des transformateurs autorégressifs rapides avec une attention linéaire."

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Du RLHF au DPO en passant par TDPO, les algorithmes d'alignement des grands modèles sont déjà « au niveau des jetons »

Jun 24, 2024 pm 03:04 PM

Du RLHF au DPO en passant par TDPO, les algorithmes d'alignement des grands modèles sont déjà « au niveau des jetons »

Jun 24, 2024 pm 03:04 PM

La colonne AIxiv est une colonne où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com Dans le processus de développement de l'intelligence artificielle, le contrôle et le guidage des grands modèles de langage (LLM) ont toujours été l'un des principaux défis, visant à garantir que ces modèles sont à la fois puissant et sûr au service de la société humaine. Les premiers efforts se sont concentrés sur les méthodes d’apprentissage par renforcement par feedback humain (RL

L'auteur de ControlNet a encore un succès ! L'ensemble du processus de génération d'une peinture à partir d'une image, gagnant 1,4k étoiles en deux jours

Jul 17, 2024 am 01:56 AM

L'auteur de ControlNet a encore un succès ! L'ensemble du processus de génération d'une peinture à partir d'une image, gagnant 1,4k étoiles en deux jours

Jul 17, 2024 am 01:56 AM

Il s'agit également d'une vidéo Tusheng, mais PaintsUndo a emprunté une voie différente. L'auteur de ControlNet, LvminZhang, a recommencé à vivre ! Cette fois, je vise le domaine de la peinture. Le nouveau projet PaintsUndo a reçu 1,4kstar (toujours en hausse folle) peu de temps après son lancement. Adresse du projet : https://github.com/lllyasviel/Paints-UNDO Grâce à ce projet, l'utilisateur saisit une image statique et PaintsUndo peut automatiquement vous aider à générer une vidéo de l'ensemble du processus de peinture, du brouillon de ligne au suivi du produit fini. . Pendant le processus de dessin, les changements de lignes sont étonnants. Le résultat vidéo final est très similaire à l’image originale : jetons un coup d’œil à un dessin complet.

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Si la réponse donnée par le modèle d’IA est incompréhensible du tout, oseriez-vous l’utiliser ? À mesure que les systèmes d’apprentissage automatique sont utilisés dans des domaines de plus en plus importants, il devient de plus en plus important de démontrer pourquoi nous pouvons faire confiance à leurs résultats, et quand ne pas leur faire confiance. Une façon possible de gagner confiance dans le résultat d'un système complexe est d'exiger que le système produise une interprétation de son résultat qui soit lisible par un humain ou un autre système de confiance, c'est-à-dire entièrement compréhensible au point que toute erreur possible puisse être trouvé. Par exemple, pour renforcer la confiance dans le système judiciaire, nous exigeons que les tribunaux fournissent des avis écrits clairs et lisibles qui expliquent et soutiennent leurs décisions. Pour les grands modèles de langage, nous pouvons également adopter une approche similaire. Cependant, lorsque vous adoptez cette approche, assurez-vous que le modèle de langage génère

En tête de liste des ingénieurs logiciels d'IA open source, la solution sans agent de l'UIUC résout facilement les problèmes de programmation réels du banc SWE.

Jul 17, 2024 pm 10:02 PM

En tête de liste des ingénieurs logiciels d'IA open source, la solution sans agent de l'UIUC résout facilement les problèmes de programmation réels du banc SWE.

Jul 17, 2024 pm 10:02 PM

La colonne AIxiv est une colonne où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com Les auteurs de cet article font tous partie de l'équipe de l'enseignant Zhang Lingming de l'Université de l'Illinois à Urbana-Champaign (UIUC), notamment : Steven Code repair ; doctorant en quatrième année, chercheur

Une avancée significative dans l'hypothèse de Riemann ! Tao Zhexuan recommande fortement les nouveaux articles du MIT et d'Oxford, et le lauréat de la médaille Fields, âgé de 37 ans, a participé

Aug 05, 2024 pm 03:32 PM

Une avancée significative dans l'hypothèse de Riemann ! Tao Zhexuan recommande fortement les nouveaux articles du MIT et d'Oxford, et le lauréat de la médaille Fields, âgé de 37 ans, a participé

Aug 05, 2024 pm 03:32 PM

Récemment, l’hypothèse de Riemann, connue comme l’un des sept problèmes majeurs du millénaire, a réalisé une nouvelle avancée. L'hypothèse de Riemann est un problème mathématique non résolu très important, lié aux propriétés précises de la distribution des nombres premiers (les nombres premiers sont les nombres qui ne sont divisibles que par 1 et par eux-mêmes, et jouent un rôle fondamental dans la théorie des nombres). Dans la littérature mathématique actuelle, il existe plus d'un millier de propositions mathématiques basées sur l'établissement de l'hypothèse de Riemann (ou sa forme généralisée). En d’autres termes, une fois que l’hypothèse de Riemann et sa forme généralisée seront prouvées, ces plus d’un millier de propositions seront établies sous forme de théorèmes, qui auront un impact profond sur le domaine des mathématiques et si l’hypothèse de Riemann s’avère fausse, alors parmi eux ; ces propositions qui en font partie perdront également de leur efficacité. Une nouvelle percée vient du professeur de mathématiques du MIT, Larry Guth, et de l'Université d'Oxford

Génération vidéo illimitée, planification et prise de décision, diffusion, intégration forcée de la prédiction du prochain jeton et diffusion de la séquence complète

Jul 23, 2024 pm 02:05 PM

Génération vidéo illimitée, planification et prise de décision, diffusion, intégration forcée de la prédiction du prochain jeton et diffusion de la séquence complète

Jul 23, 2024 pm 02:05 PM

Actuellement, les modèles linguistiques autorégressifs à grande échelle utilisant le prochain paradigme de prédiction de jetons sont devenus populaires partout dans le monde. Dans le même temps, un grand nombre d'images et de vidéos synthétiques sur Internet nous ont déjà montré la puissance des modèles de diffusion. Récemment, une équipe de recherche de MITCSAIL (dont Chen Boyuan, doctorant au MIT) a intégré avec succès les puissantes capacités du modèle de diffusion en séquence complète et du prochain modèle de jeton, et a proposé un paradigme de formation et d'échantillonnage : le forçage de diffusion (DF ). Titre de l'article : DiffusionForcing:Next-tokenPredictionMeetsFull-SequenceDiffusion Adresse de l'article : https://

Les articles arXiv peuvent être publiés sous forme de 'barrage', la plateforme de discussion alphaXiv de Stanford est en ligne, LeCun l'aime

Aug 01, 2024 pm 05:18 PM

Les articles arXiv peuvent être publiés sous forme de 'barrage', la plateforme de discussion alphaXiv de Stanford est en ligne, LeCun l'aime

Aug 01, 2024 pm 05:18 PM

acclamations! Qu’est-ce que ça fait lorsqu’une discussion sur papier se résume à des mots ? Récemment, des étudiants de l'Université de Stanford ont créé alphaXiv, un forum de discussion ouvert pour les articles arXiv qui permet de publier des questions et des commentaires directement sur n'importe quel article arXiv. Lien du site Web : https://alphaxiv.org/ En fait, il n'est pas nécessaire de visiter spécifiquement ce site Web. Il suffit de remplacer arXiv dans n'importe quelle URL par alphaXiv pour ouvrir directement l'article correspondant sur le forum alphaXiv : vous pouvez localiser avec précision les paragraphes dans. l'article, Phrase : dans la zone de discussion sur la droite, les utilisateurs peuvent poser des questions à l'auteur sur les idées et les détails de l'article. Par exemple, ils peuvent également commenter le contenu de l'article, tels que : "Donné à".

La formation Axiom permet au LLM d'apprendre le raisonnement causal : le modèle à 67 millions de paramètres est comparable au niveau de mille milliards de paramètres GPT-4.

Jul 17, 2024 am 10:14 AM

La formation Axiom permet au LLM d'apprendre le raisonnement causal : le modèle à 67 millions de paramètres est comparable au niveau de mille milliards de paramètres GPT-4.

Jul 17, 2024 am 10:14 AM

Montrez la chaîne causale à LLM et il pourra apprendre les axiomes. L'IA aide déjà les mathématiciens et les scientifiques à mener des recherches. Par exemple, le célèbre mathématicien Terence Tao a partagé à plusieurs reprises son expérience de recherche et d'exploration à l'aide d'outils d'IA tels que GPT. Pour que l’IA soit compétitive dans ces domaines, des capacités de raisonnement causal solides et fiables sont essentielles. La recherche présentée dans cet article a révélé qu'un modèle Transformer formé sur la démonstration de l'axiome de transitivité causale sur de petits graphes peut se généraliser à l'axiome de transitivité sur de grands graphes. En d’autres termes, si le Transformateur apprend à effectuer un raisonnement causal simple, il peut être utilisé pour un raisonnement causal plus complexe. Le cadre de formation axiomatique proposé par l'équipe est un nouveau paradigme pour l'apprentissage du raisonnement causal basé sur des données passives, avec uniquement des démonstrations.