Périphériques technologiques

Périphériques technologiques

IA

IA

DifFlow3D : Nouveau SOTA pour l'estimation du flux de scène, le modèle de diffusion connaît un autre succès !

DifFlow3D : Nouveau SOTA pour l'estimation du flux de scène, le modèle de diffusion connaît un autre succès !

DifFlow3D : Nouveau SOTA pour l'estimation du flux de scène, le modèle de diffusion connaît un autre succès !

Titre original : DifFlow3D : Toward Robust Uncertainty-Aware Scene Flow Estimation with Iterative Diffusion-Based Refinement

Lien papier : https://arxiv.org/pdf/2311.17456.pdf

Lien code : https://github. com/IRMVLab/DifFlow3D

Affiliation de l'auteur : Shanghai Jiao Tong University Cambridge University Zhejiang University Intelligent Robot

Idée de thèse :

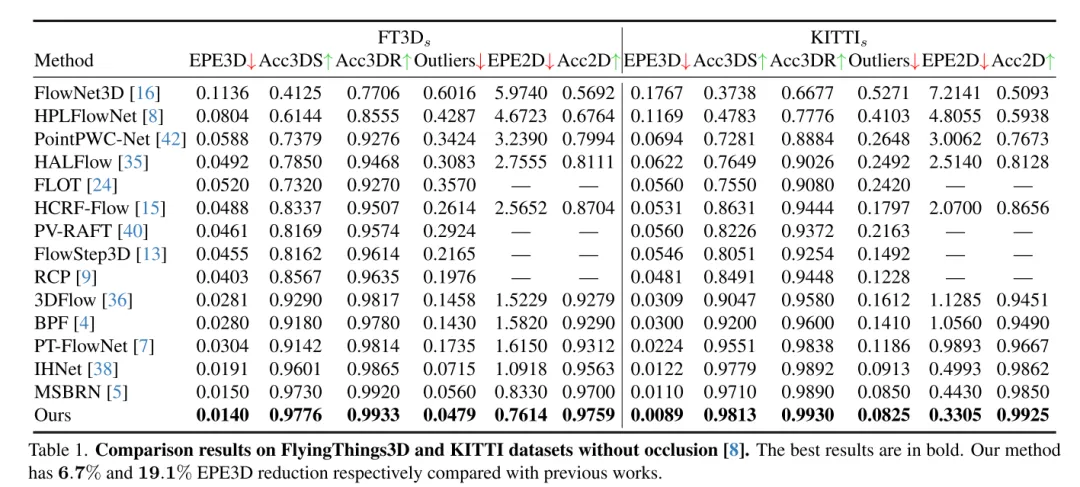

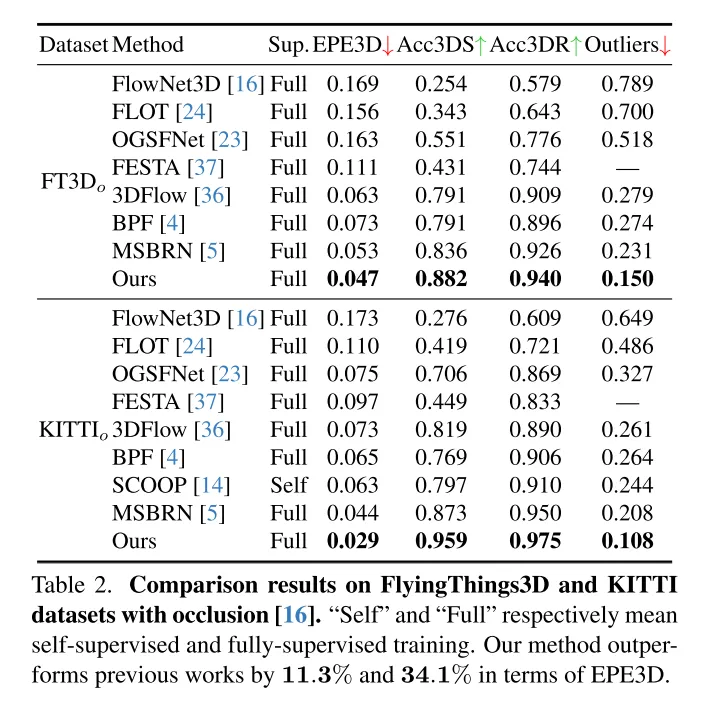

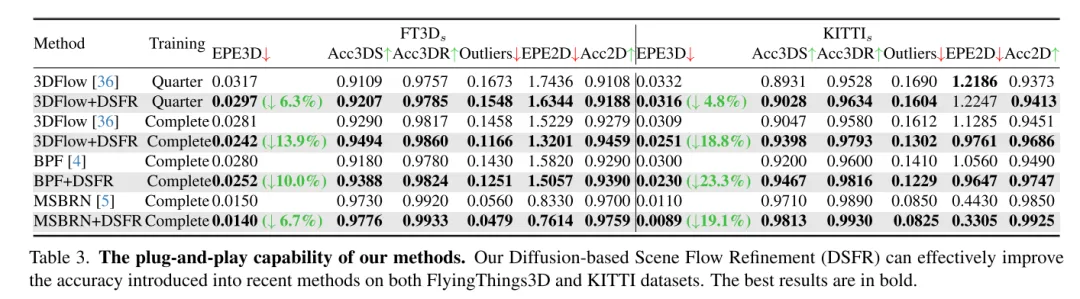

L'estimation du flux de scène vise à prédire le changement de déplacement 3D de chaque point dans une scène dynamique, c'est une tâche fondamentale dans le domaine de la vision par ordinateur. Cependant, les travaux antérieurs souffrent souvent de corrélations peu fiables causées par des plages de recherche localement contraintes et accumulent des inexactitudes dans les structures grossières à fines. Pour atténuer ces problèmes, cet article propose un nouveau réseau d'estimation de flux de scène tenant compte de l'incertitude (DifFlow3D), qui adopte un modèle probabiliste de diffusion. Le raffinement itératif basé sur la diffusion est conçu pour améliorer la robustesse de la corrélation et avoir une forte adaptabilité aux situations difficiles (telles que la dynamique, les entrées bruyantes, les modèles répétés, etc.). Pour limiter la diversité des générations, trois caractéristiques clés liées au flux sont exploitées comme conditions dans notre modèle de diffusion. De plus, cet article développe un module d'estimation de l'incertitude en diffusion pour évaluer la fiabilité du flux de scène estimé. Le DifFlow3D de cet article atteint respectivement une réduction de 6,7 % et 19,1 % des erreurs de point final tridimensionnel (EPE3D) sur les ensembles de données FlyingThings3D et KITTI 2015, et atteint une précision millimétrique sans précédent sur l'ensemble de données KITTI (0,0089 mètres pour EPE3D). De plus, notre paradigme de raffinement basé sur la diffusion peut être facilement intégré aux réseaux de flux de scènes existants en tant que module plug-and-play, améliorant considérablement la précision de leur estimation.

Principales contributions :

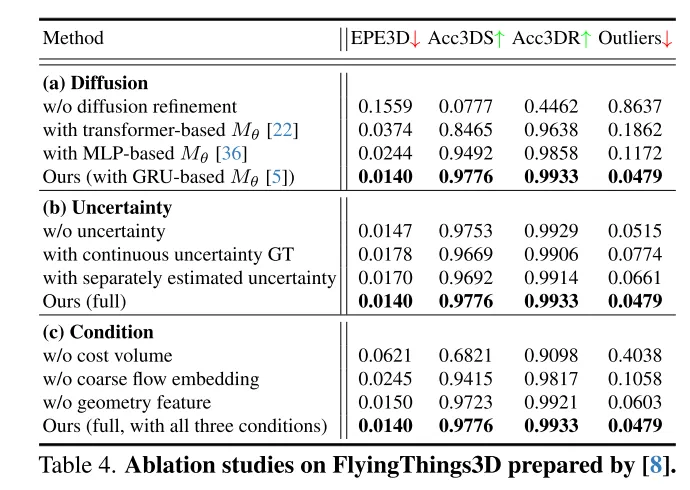

Pour obtenir une estimation robuste du flux de scène, cette étude propose un nouveau processus de raffinement plug-and-play basé sur la diffusion. À notre connaissance, c'est la première fois qu'un modèle probabiliste de diffusion est utilisé dans une tâche de flux de scène.

L'auteur combine des techniques telles que l'intégration de flux grossiers, l'encodage géométrique et les volumes de coûts inter-images pour concevoir une méthode de guidage conditionnel efficace pour contrôler la diversité des résultats générés.

Pour évaluer la fiabilité des flux dans cet article et identifier les correspondances de points inexactes, les auteurs introduisent également des estimations d'incertitude pour chaque point du modèle de diffusion.

Les résultats de la recherche montrent que la méthode proposée dans cet article fonctionne bien sur les ensembles de données FlyingThings3D et KITTI, surpassant les autres méthodes existantes. En particulier, DifFlow3D atteint pour la première fois une erreur de point final au niveau millimétrique (EPE3D) sur l’ensemble de données KITTI. Par rapport aux recherches précédentes, notre méthode est plus robuste dans la gestion de situations difficiles, telles que des entrées bruyantes et des changements dynamiques.

Conception de réseau :

En tant que tâche de base en vision par ordinateur, le flux de scène fait référence à l'estimation d'un champ de mouvement tridimensionnel à partir d'images continues ou de nuages de points. Il fournit des informations pour la perception de bas niveau de scènes dynamiques et a diverses applications en aval, telles que la conduite autonome [21], l'estimation de pose [9] et la segmentation de mouvement [1]. Les premiers travaux se sont concentrés sur l'utilisation d'images stéréo [12] ou RVB-D [10] comme entrée. Avec la popularité croissante des capteurs 3D, tels que le lidar, les travaux récents prennent souvent les nuages de points directement en entrée.

En tant que travail pionnier, FlowNet3D[16] utilise PointNet++[25] pour extraire des caractéristiques hiérarchiques, puis régresse de manière itérative le flux de la scène. PointPWC [42] l’améliore encore grâce à des structures pyramidales, de déformation et de volume de coûts [31]. HALFlow [35] les suit et introduit un mécanisme d'attention pour une meilleure intégration des flux. Cependant, ces travaux basés sur la régression souffrent souvent d'une corrélation peu fiable et de problèmes d'optima locaux [17]. Il y a deux raisons principales : (1) Dans leur réseau, K voisins les plus proches (KNN) sont utilisés pour rechercher des correspondances de points, ce qui ne prend pas en compte les paires de points correctes mais distantes, et il existe également un bruit de correspondance [7] . (2) Un autre problème potentiel vient de la structure grossière à fine largement utilisée dans les travaux antérieurs [16, 35, 36, 42]. Fondamentalement, le flux initial est estimé au niveau de la couche la plus grossière, puis affiné de manière itérative dans des résolutions plus élevées. Cependant, les performances du raffinement du flux dépendent fortement de la fiabilité du flux grossier initial, puisque les raffinements ultérieurs sont généralement limités à une petite étendue spatiale autour de l'initialisation.

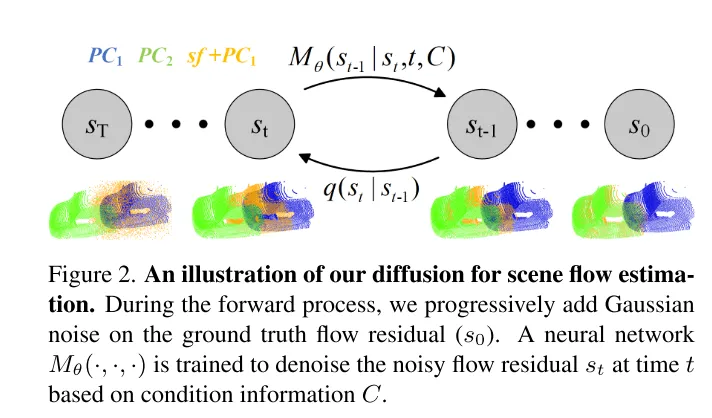

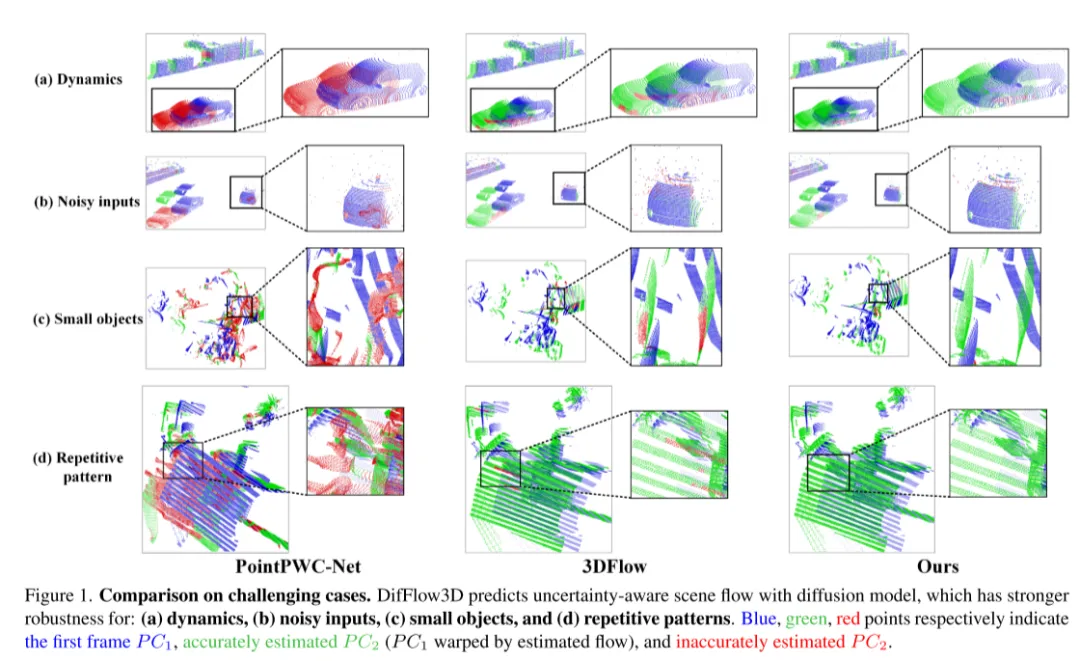

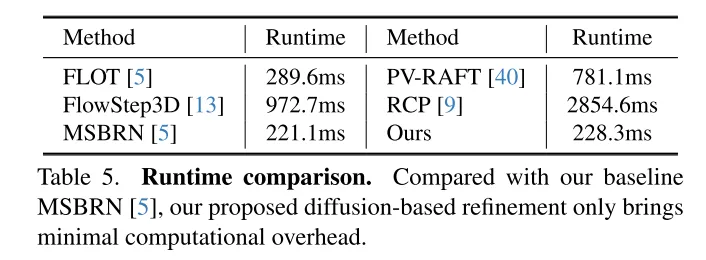

Afin de résoudre le problème du manque de fiabilité, 3DFlow[36] a conçu un module de collecte de points tout-à-tout et ajouté une vérification inverse. De même, Bi-PointFlowNet [4] et son extension MSBRN [5] proposent un réseau bidirectionnel avec corrélation avant-arrière. IHNet [38] utilise un réseau récurrent avec un schéma d'amorçage et de rééchantillonnage haute résolution. Cependant, la plupart de ces réseaux souffrent d’un coût de calcul dû à leurs corrélations bidirectionnelles ou à leurs itérations de boucles. Cet article révèle que les modèles de diffusion peuvent également améliorer la fiabilité des corrélations et la résilience au bruit d'adaptation, grâce à leur nature débruitante (illustré sur la figure 1). Inspiré par la découverte de [30] selon laquelle l'injection de bruit aléatoire permet de sortir de l'optimum local, cet article reconstruit la tâche de régression de flux déterministe en utilisant un modèle de diffusion probabiliste, comme le montre la figure 2. De plus, notre méthode peut être utilisée comme module plug-and-play pour servir le réseau de flux de scène précédent, qui est plus général et n’ajoute presque aucun coût de calcul (Section 4.5).

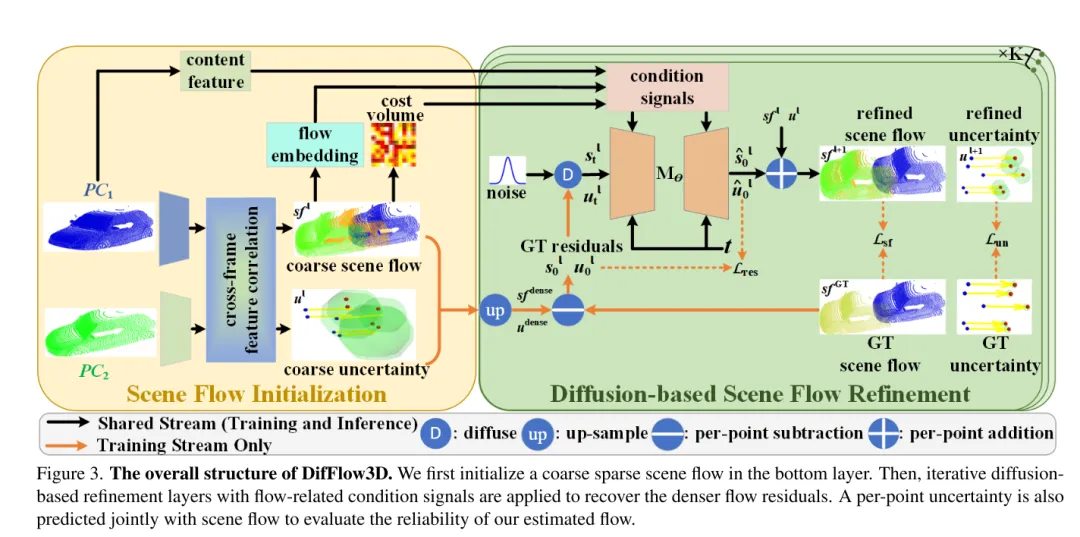

Cependant, exploiter les modèles génératifs dans le cadre de cet article est assez difficile en raison de la diversité générative inhérente aux modèles de diffusion. Contrairement à la tâche de génération de nuages de points qui nécessite divers échantillons de sortie, la prédiction du flux de scène est une tâche déterministe qui calcule des vecteurs de mouvement précis par point. Pour résoudre ce problème, cet article utilise des informations conditionnelles fortes pour limiter la diversité et contrôler efficacement le flux généré. Plus précisément, un flux de scène clairsemé est d'abord initialisé, puis les résidus de flux sont générés de manière itérative par diffusion. Dans chaque couche de raffinement basée sur la diffusion, nous utilisons comme conditions l'intégration du flux grossier, le volume des coûts et le codage géométrique. Dans ce cas, la diffusion est appliquée pour réellement apprendre une cartographie probabiliste à partir des entrées conditionnelles vers les résidus de flux.

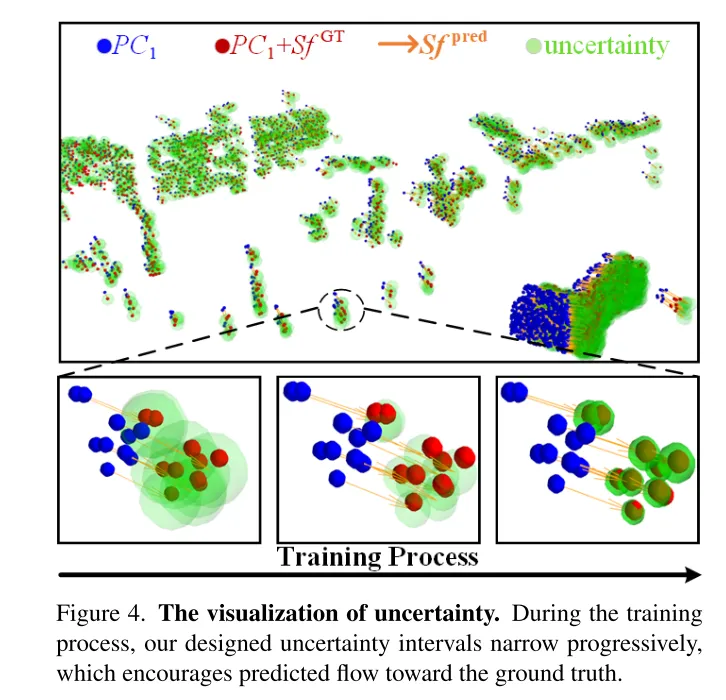

De plus, peu de travaux antérieurs ont exploré la confiance et la fiabilité de l'estimation du flux de scène. Cependant, comme le montre la figure 1, la correspondance de flux dense est sujette à des erreurs en présence de bruit, de changements dynamiques, de petits objets et de motifs répétés. Il est donc très important de savoir si chaque correspondance ponctuelle estimée est fiable. Inspirés par le récent succès de l'estimation de l'incertitude dans les tâches de flux optique [33], nous proposons une incertitude ponctuelle dans le modèle de diffusion pour évaluer la fiabilité de notre estimation du flux de scène.

Photo 3. La structure globale de DifFlow3D. Cet article initialise d’abord un flux de scène clairsemé dans la couche inférieure. Des couches de raffinement de diffusion itératives sont ensuite utilisées en conjonction avec des signaux conditionnels liés au flux pour récupérer des résidus de flux plus denses. Pour évaluer la fiabilité des flux estimés dans cet article, l'incertitude en chaque point sera également prédite conjointement avec le flux de scène.

Photo 2. Diagramme schématique du processus de diffusion utilisé dans cet article pour l'estimation du flux de scène.

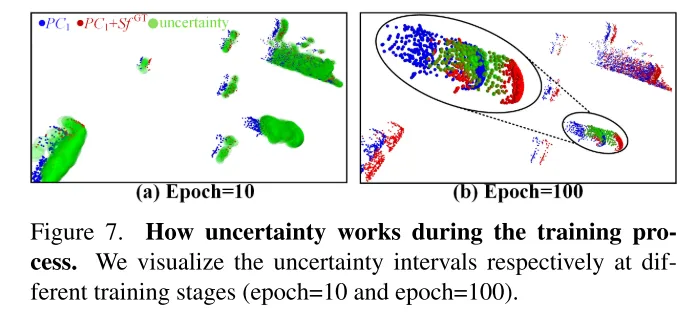

Photo 4. Visualiser l’incertitude. Au cours du processus de formation, l'intervalle d'incertitude conçu dans cet article diminue progressivement, ce qui permet au flux prédit de se rapprocher de la valeur réelle.

Résultats expérimentaux :

Figure 1. Comparaison dans des situations difficiles. DifFlow3D prédit le flux de scène tenant compte de l'incertitude à l'aide d'un modèle de diffusion plus robuste face : (a) aux changements dynamiques, (b) aux entrées bruyantes, (c) aux petits objets et (d)) aux motifs répétitifs.

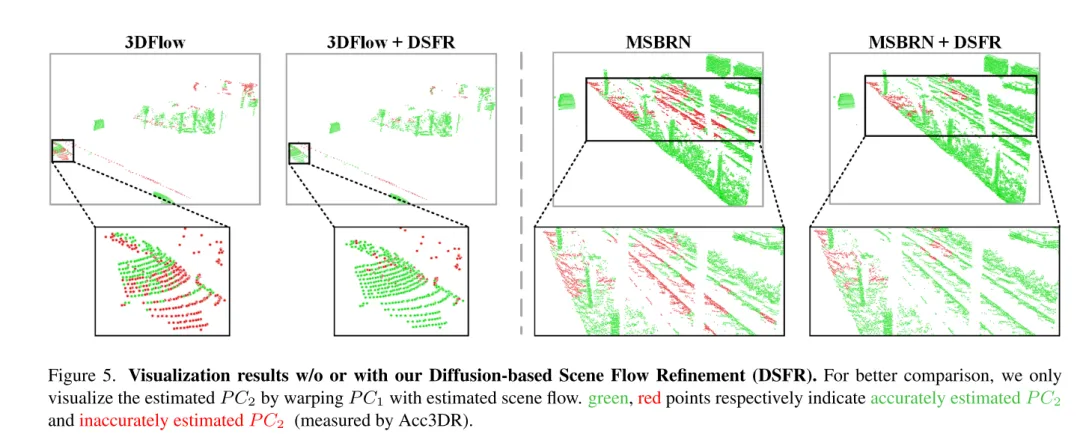

Figure 5. Résultats de visualisation sans ou avec raffinement du flux de scène basé sur la diffusion (DSFR).

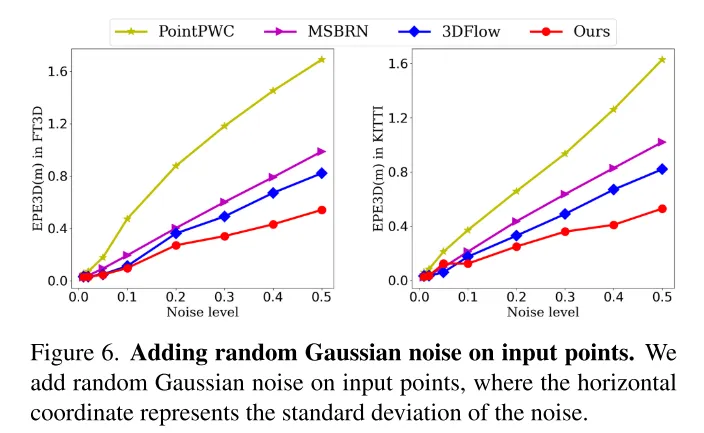

Photo 6. Ajoutez un bruit gaussien aléatoire aux points d’entrée.

Photo 7. Le rôle de l'incertitude dans le processus de formation. Cet article visualise les intervalles d'incertitude à différentes étapes de formation (10e tour et 100e tour).

Résumé :

Cet article propose de manière innovante un réseau de raffinement de flux de scène basé sur la diffusion et conscient de l'incertitude d'estimation. Cet article adopte un raffinement de diffusion multi-échelle pour générer des résidus d’écoulement dense à grain fin. Pour améliorer la robustesse de l'estimation, cet article introduit également une incertitude ponctuelle générée conjointement avec le flux de scène. Des expériences approfondies démontrent la supériorité et les capacités de généralisation de notre DifFlow3D. Il convient de noter que le raffinement de cet article basé sur la diffusion peut être appliqué à des travaux antérieurs en tant que module plug-and-play et fournir de nouvelles implications pour les recherches futures.

Citation :

Liu J, Wang G, Ye W et al. DifFlow3D : Vers une estimation robuste du flux de scène tenant compte de l'incertitude avec le modèle de diffusion[J].

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.