Périphériques technologiques

Périphériques technologiques

IA

IA

Tueur de production de masse ! P-Mapnet : En utilisant la carte de basse précision SDMap précédente, les performances de cartographie sont violemment améliorées de près de 20 points !

Tueur de production de masse ! P-Mapnet : En utilisant la carte de basse précision SDMap précédente, les performances de cartographie sont violemment améliorées de près de 20 points !

Tueur de production de masse ! P-Mapnet : En utilisant la carte de basse précision SDMap précédente, les performances de cartographie sont violemment améliorées de près de 20 points !

Écrit avant

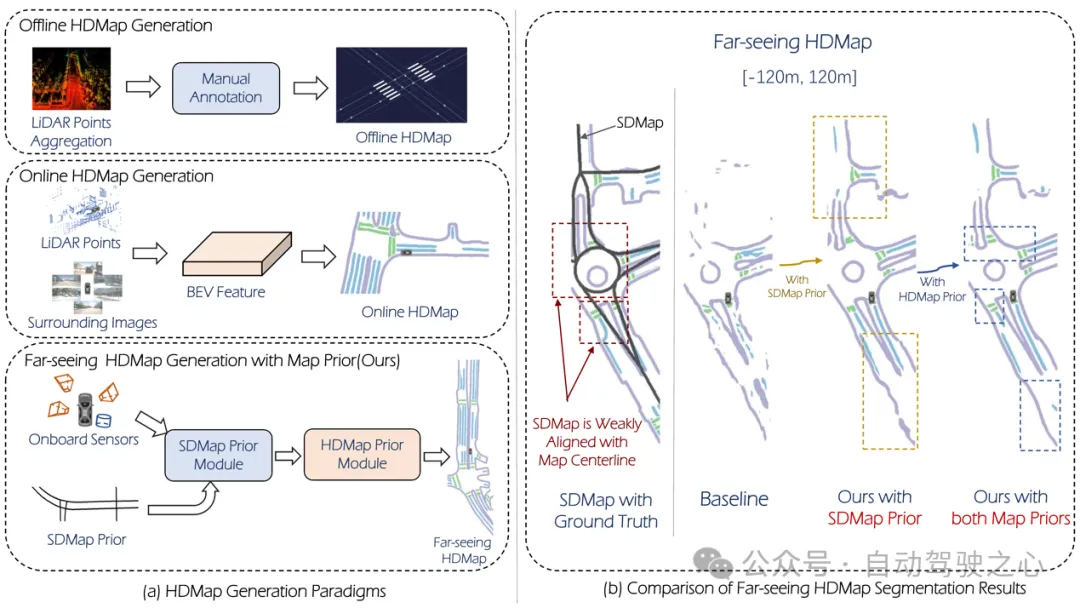

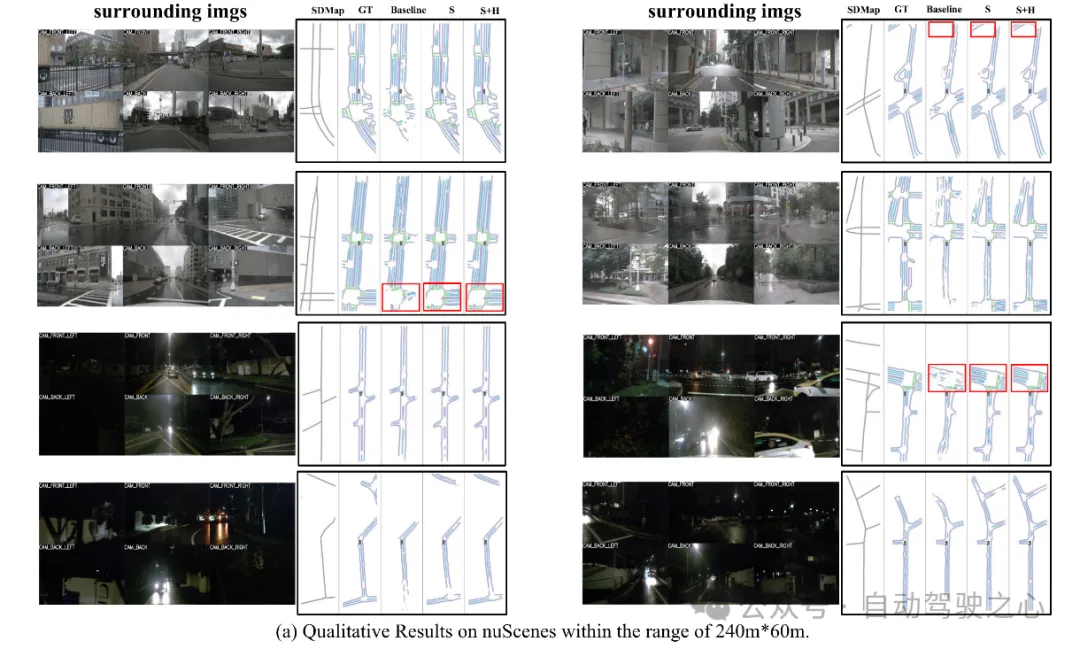

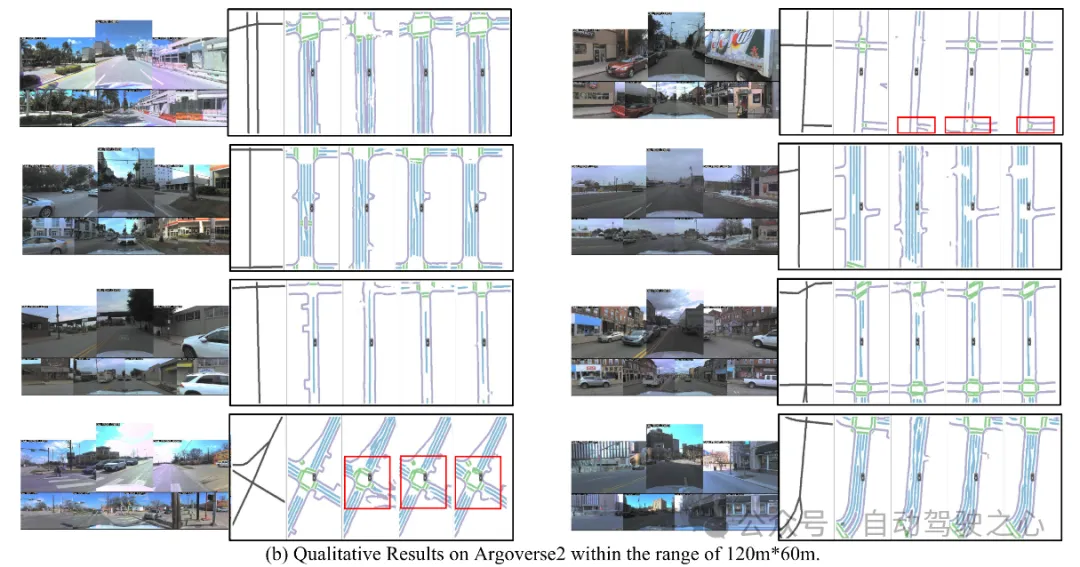

L'un des algorithmes utilisés par le système de conduite autonome actuel pour se débarrasser de sa dépendance aux cartes de haute précision est de profiter du fait que les performances de perception sur de longues distances sont encore médiocres. À cette fin, nous proposons P-MapNet, où le « P » se concentre sur la fusion des cartes a priori pour améliorer les performances du modèle. Plus précisément, nous exploitons les informations préalables dans SDMap et HDMap : d'une part, nous extrayons les données SDMap faiblement alignées d'OpenStreetMap et les encodons en termes indépendants pour prendre en charge l'entrée. Il existe un problème de faible alignement entre l'entrée strictement modifiée et la HD+Map réelle. Notre structure basée sur le mécanisme Cross-attention peut se concentrer de manière adaptative sur le squelette SDMap et apporter des améliorations significatives des performances. Par contre, nous proposons une méthode utilisant ; MAE Pour capturer le module d'affinement de la distribution précédente de HDMap, ce module permet de générer une distribution plus cohérente avec la carte réelle et permet de réduire les effets d'occlusion, d'artefacts, etc. Nous effectuons une validation expérimentale approfondie sur les ensembles de données nuScenes et Argoverse2.

Figure 1

Figure 1

En résumé, nos contributions sont les suivantes :

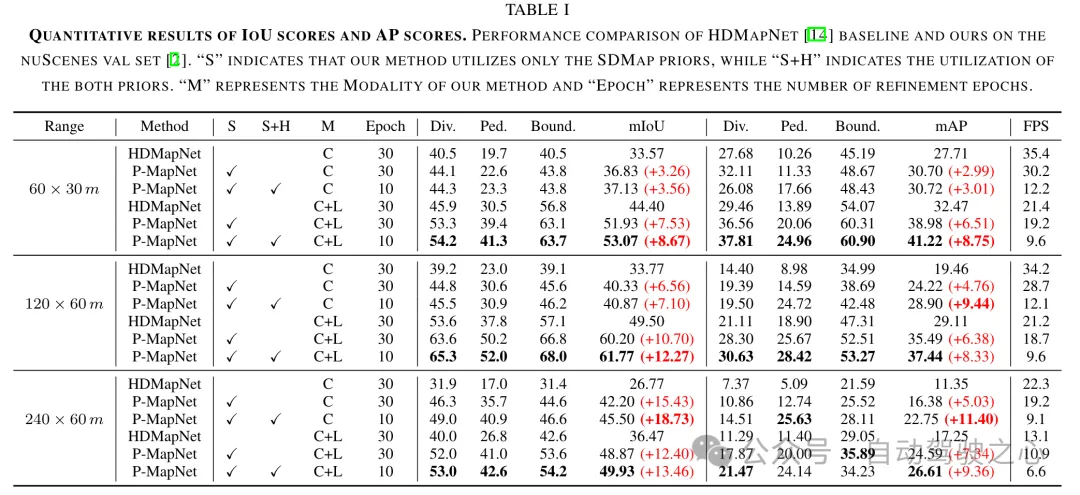

Notre SDMap avancé peut améliorer les performances de génération de cartes en ligne, y compris la rastérisation (jusqu'à 18,73 mIoU) et la quantification (jusqu'à 8,50 mAP). Deux représentations cartographiques.

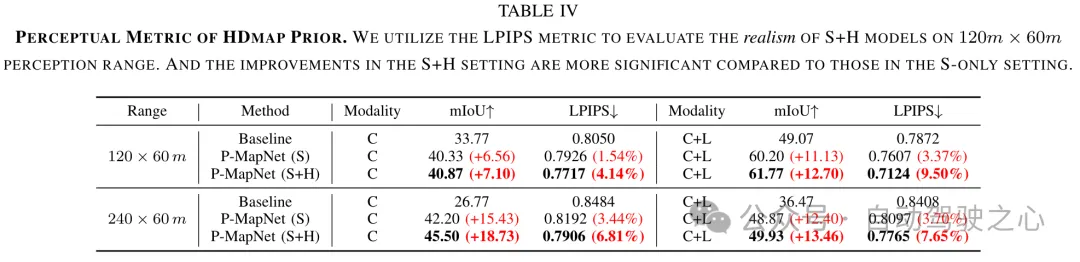

(2) Notre HDMap prior peut améliorer l'indice de connaissance de la carte jusqu'à 6,34 %.

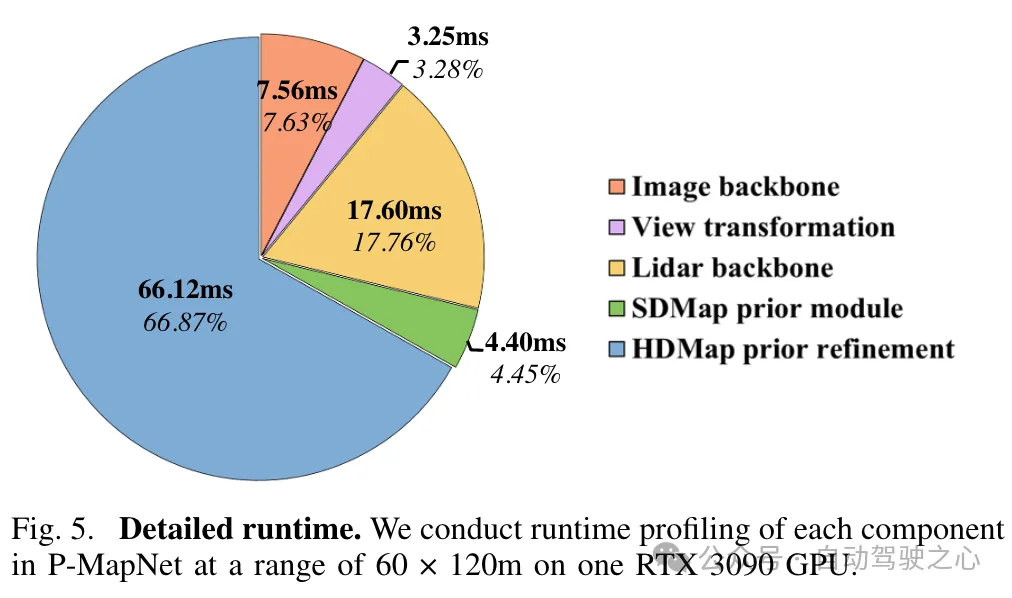

(3) P-MapNet peut passer à différents modes d'inférence pour trouver un compromis entre précision et efficacité.

P-MapNet est une solution de génération de cartes HD+ longue distance, qui peut apporter une plus grande amélioration à la plage de détection la plus éloignée. Notre code et notre modèle ont été rendus publics sur https://jike5.github.io/P-MapNet/.

Examen des travaux connexes

(1)Génération de cartes en ligne

La production de cartes HD+ comprend principalement la cartographie SLAM, l'étiquetage automatique, l'étiquetage manuel et d'autres étapes. Cela se traduit par le coût élevé et la fraîcheur limitée de HD+Map. La génération de cartes en ligne est donc cruciale pour les systèmes de conduite autonome. HDMapNet exprime les éléments cartographiques via un maillage et utilise des méthodes de prédiction et de post-traitement par pixel pour obtenir des résultats de prédiction vectorisés. Certaines méthodes récentes, telles que MapTR, PivotNet, Streammapnet, etc., implémentent une prédiction vectorisée de bout en bout basée sur l'architecture Transformer. Cependant, ces méthodes n'utilisent que les entrées de capteurs et leurs performances sont encore limitées dans des environnements complexes tels que l'occlusion. et des conditions météorologiques extrêmes.

(2)Perception cartographique longue distance

Afin de mieux utiliser les résultats générés par les cartes en ligne par les modules en aval, certaines recherches tentent d'élargir davantage la portée de la perception cartographique. SuperFusion[7] permet une prévision longue distance de 90 m en fusionnant le lidar et les caméras et en utilisant la transformation BEV sensible à la profondeur. NeuralMapPrior[8] améliore la qualité des observations en ligne actuelles et élargit la portée de la perception en maintenant et en mettant à jour les priorités de la carte neuronale globale. [6] obtient les caractéristiques du BEV en agrégeant des images satellite et des données de capteurs de véhicules, et les prédit davantage. MV-Map se concentre sur la génération de cartes longue distance hors ligne. Cette méthode optimise les fonctionnalités BEV en agrégeant toutes les fonctionnalités de trame associées et en utilisant des champs de rayonnement neuronal.

Aperçu de P-MapNet

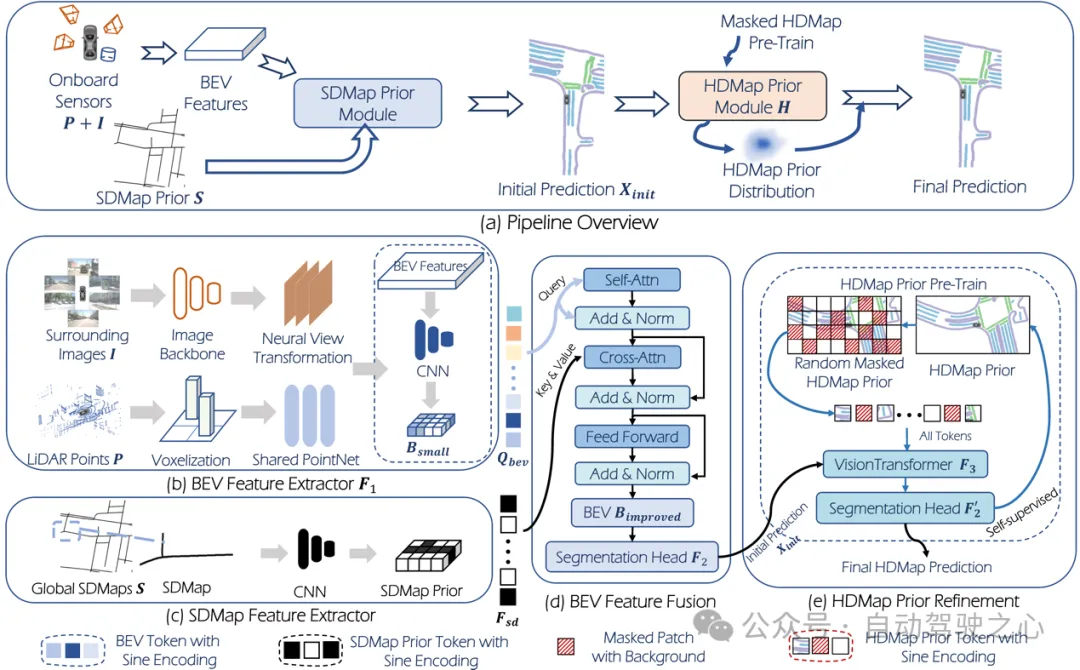

Le cadre global est présenté dans la figure 2.

Figure 2

Figure 2

Entrée : L'entrée du système est un nuage de points : , caméra surround :, où est le nombre de caméras surround. Une tâche de génération HDMap courante (telle que HDMapNet) peut être définie comme :

où représente l'extraction de fonctionnalités, représente la tête de segmentation et est le résultat de la prédiction de HDMap.

Le P-MapNet que nous avons proposé combine les a priori SD Map et HD Map. Cette nouvelle tâche ( setting) peut être exprimée comme suit :

où, représente l'a priori SDMap, représente celui proposé dans le raffinement de cet article. module. Le module apprend la distribution de cartes HD au préalable grâce à une pré-formation. De même, en utilisant uniquement SDMap auparavant, nous obtenons paramètre uniquement :

Sortie : Pour les tâches de génération de carte, il existe généralement deux représentations cartographiques : la rastérisation et la vectorisation. Dans la recherche de cet article, étant donné que les deux modules a priori conçus dans cet article sont plus adaptés à une sortie rastérisée, nous nous concentrons principalement sur la représentation rastérisée.

3.1 Module SDMap Prior

Génération de données SDMap

Cet article effectue des recherches basées sur les ensembles de données nuScenes et Argoverse2, utilise les données OpenStreetMap pour générer des données SD Map pour les zones correspondantes des ensembles de données ci-dessus et effectue des coordonnées Transformation du système via le GPS du véhicule. Pour obtenir la carte SD de la zone correspondante.

Requête BEV

Comme le montre la figure 2, nous effectuons d'abord l'extraction de caractéristiques et la conversion de perspective sur les données d'image et l'extraction de caractéristiques sur le nuage de points pour obtenir les caractéristiques BEV. Ensuite, les fonctionnalités BEV sont sous-échantillonnées via le réseau convolutif pour obtenir les nouvelles fonctionnalités BEV :, et la carte des fonctionnalités est aplatie pour obtenir la requête BEV.

Fusion préalable de la carte SD

Pour les données SD Map, après extraction des caractéristiques via le réseau convolutif, les caractéristiques obtenues Mécanisme d'attention croisée avec requête BEV :

BEV obtenu après le mécanisme d'attention croisée Les caractéristiques sont transmises la tête de segmentation pour obtenir des prédictions initiales des éléments de la carte.

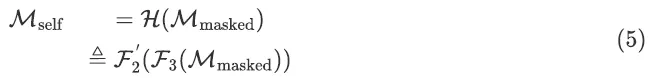

3.2. Le module HDMap Prior

utilise directement la carte HD rastérisée comme entrée du MAE d'origine. Le MAE sera entraîné via MSE Loss, ce qui le rend incapable d'être utilisé comme module de raffinement. Ainsi, dans cet article, nous remplaçons la sortie de MAE par notre tête de segmentation. Afin de garantir la continuité et l'authenticité des éléments cartographiques prédits (plus proches de la distribution de la carte HD réelle), nous utilisons un module MAE pré-entraîné pour le raffinement. La formation de ce module se compose de deux étapes : la première étape consiste à utiliser l'apprentissage auto-supervisé pour entraîner le module MAE à apprendre la distribution de HD Map, et la deuxième étape consiste à affiner tous les modules du réseau en utilisant les poids obtenus. dans la première étape comme poids initiaux.

Dans la première étape de la pré-formation, la véritable carte HD obtenue à partir de l'ensemble de données est masquée de manière aléatoire et utilisée comme entrée réseau , et l'objectif de la formation est de compléter la carte HD :

Dans la seconde étape de réglage fin, Les poids pré-entraînés dans la première étape sont utilisés comme poids initiaux. Le réseau complet est :

Expérience

4.1 Ensembles de données et indicateurs

. Nous l'effectuons sur deux ensembles de données grand public examinés : nuScenes et Argoverse2. Afin de prouver l'efficacité de notre méthode proposée à longue distance, nous l'avons fixée à trois distances de détection différentes :, . Parmi eux, la résolution de BEV Grid dans la plage est de 0,15 m et la résolution dans les deux autres plages est de 0,3 m. Nous utilisons la métrique mIOU pour évaluer les résultats de prédiction rastérisés et mAP pour évaluer les résultats de prédiction vectorisés. Pour évaluer l'authenticité de la carte, nous utilisons également la métrique LPIPS comme métrique de connaissance de la carte.

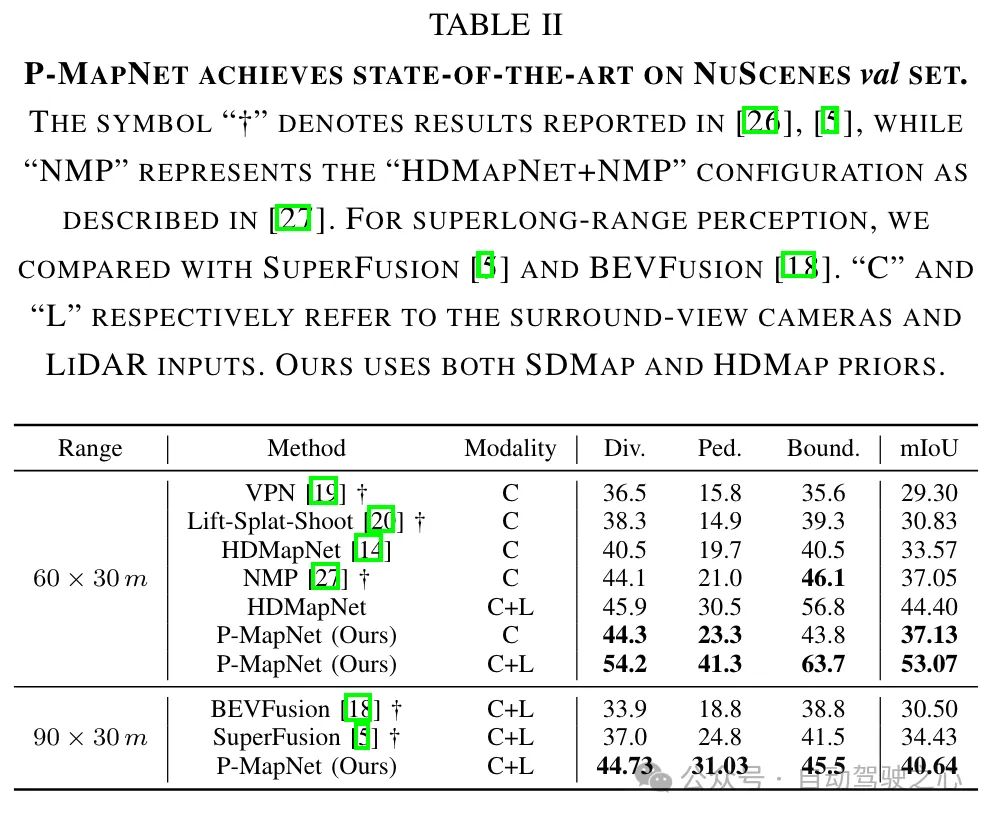

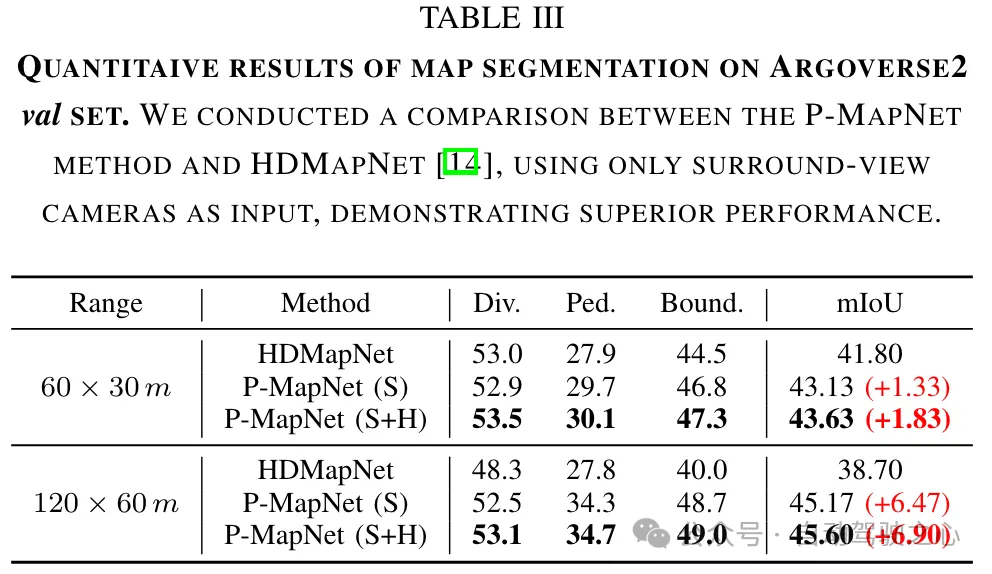

4.2 Résultats

Comparaison avec les résultats SOTA : Nous comparons les résultats de génération de cartes de la méthode proposée et de la méthode SOTA actuelle à courte distance (60m × 30m) et longue distance (90m × 30m). Comme le montre le tableau II, notre méthode présente des performances supérieures par rapport aux méthodes existantes de vision uniquement et multimodales (RVB + LiDAR).

présente une plus grande amélioration que celui dans le paramètre uniquement.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Le premier article pilote et clé présente principalement plusieurs systèmes de coordonnées couramment utilisés dans la technologie de conduite autonome, et comment compléter la corrélation et la conversion entre eux, et enfin construire un modèle d'environnement unifié. L'objectif ici est de comprendre la conversion du véhicule en corps rigide de caméra (paramètres externes), la conversion de caméra en image (paramètres internes) et la conversion d'image en unité de pixel. La conversion de 3D en 2D aura une distorsion, une traduction, etc. Points clés : Le système de coordonnées du véhicule et le système de coordonnées du corps de la caméra doivent être réécrits : le système de coordonnées planes et le système de coordonnées des pixels Difficulté : la distorsion de l'image doit être prise en compte. La dé-distorsion et l'ajout de distorsion sont compensés sur le plan de l'image. 2. Introduction Il existe quatre systèmes de vision au total : système de coordonnées du plan de pixels (u, v), système de coordonnées d'image (x, y), système de coordonnées de caméra () et système de coordonnées mondiales (). Il existe une relation entre chaque système de coordonnées,

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Au cours du mois dernier, pour des raisons bien connues, j'ai eu des échanges très intensifs avec divers professeurs et camarades de classe du secteur. Un sujet inévitable dans l'échange est naturellement le populaire Tesla FSDV12 de bout en bout. Je voudrais profiter de cette occasion pour trier certaines de mes pensées et opinions en ce moment pour votre référence et votre discussion. Comment définir un système de conduite autonome de bout en bout et quels problèmes devraient être résolus de bout en bout ? Selon la définition la plus traditionnelle, un système de bout en bout fait référence à un système qui saisit les informations brutes des capteurs et génère directement les variables pertinentes pour la tâche. Par exemple, en reconnaissance d'images, CNN peut être appelé de bout en bout par rapport à la méthode traditionnelle d'extraction de caractéristiques + classificateur. Dans les tâches de conduite autonome, saisir les données de divers capteurs (caméra/LiDAR

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

Écrit à l'avant et point de départ Le paradigme de bout en bout utilise un cadre unifié pour réaliser plusieurs tâches dans les systèmes de conduite autonome. Malgré la simplicité et la clarté de ce paradigme, les performances des méthodes de conduite autonome de bout en bout sur les sous-tâches sont encore loin derrière les méthodes à tâche unique. Dans le même temps, les fonctionnalités de vue à vol d'oiseau (BEV) denses, largement utilisées dans les méthodes de bout en bout précédentes, rendent difficile l'adaptation à davantage de modalités ou de tâches. Un paradigme de conduite autonome de bout en bout (SparseAD) centré sur la recherche clairsemée est proposé ici, dans lequel la recherche clairsemée représente entièrement l'ensemble du scénario de conduite, y compris l'espace, le temps et les tâches, sans aucune représentation BEV dense. Plus précisément, une architecture clairsemée unifiée est conçue pour la connaissance des tâches, notamment la détection, le suivi et la cartographie en ligne. De plus, lourd