Périphériques technologiques

Périphériques technologiques

IA

IA

'À la recherche d'une aiguille dans une botte de foin' ! 'Compter les étoiles' devient une méthode plus précise pour mesurer la longueur du texte, de Goose Factory

'À la recherche d'une aiguille dans une botte de foin' ! 'Compter les étoiles' devient une méthode plus précise pour mesurer la longueur du texte, de Goose Factory

'À la recherche d'une aiguille dans une botte de foin' ! 'Compter les étoiles' devient une méthode plus précise pour mesurer la longueur du texte, de Goose Factory

Il existe une nouvelle méthode pour tester la capacité du texte long en grand modèle !

Tencent MLPD Lab utilise la nouvelle méthode open source "Counting Stars" pour remplacer le test traditionnel de "l'aiguille dans la botte de foin".

En revanche, la nouvelle méthode accorde plus d'attention à l'examen de la capacité du modèle à gérer de longues dépendances , et l'évaluation du modèle est plus complète et plus précise.

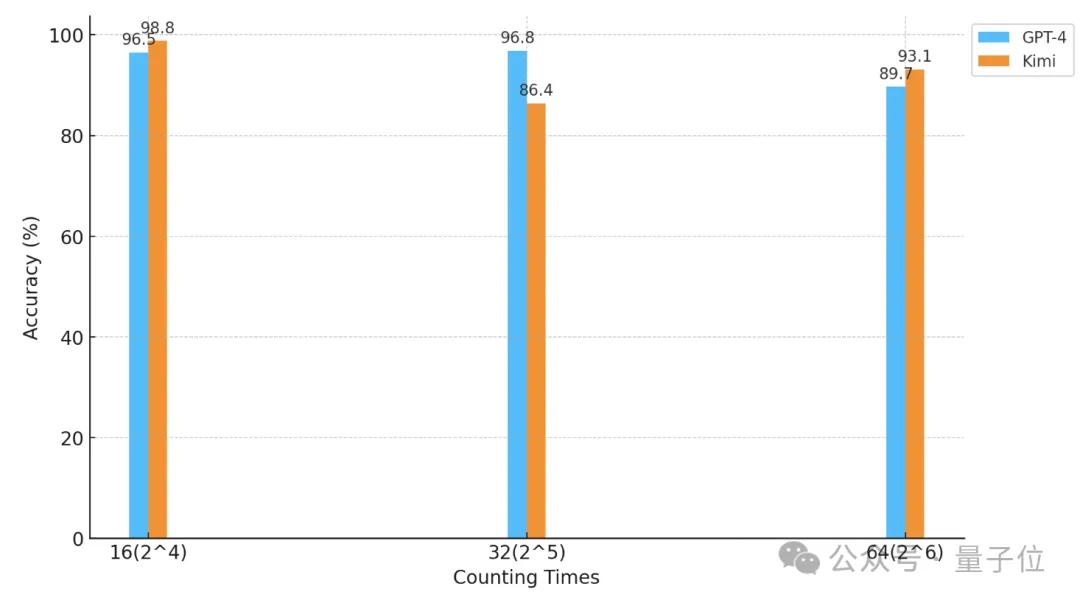

En utilisant cette méthode, les chercheurs ont effectué un test de « comptage des étoiles » sur GPT-4 et le célèbre Kimi Chat domestique.

En conséquence, dans des conditions expérimentales différentes, les deux modèles ont leurs propres avantages et inconvénients, mais ils démontrent tous deux de fortes capacités de texte long.

△L'axe horizontal est une coordonnée logarithmique de base 2

Alors, quel genre de test consiste à "compter les étoiles" ?

Plus précis que "trouver une aiguille dans une botte de foin"

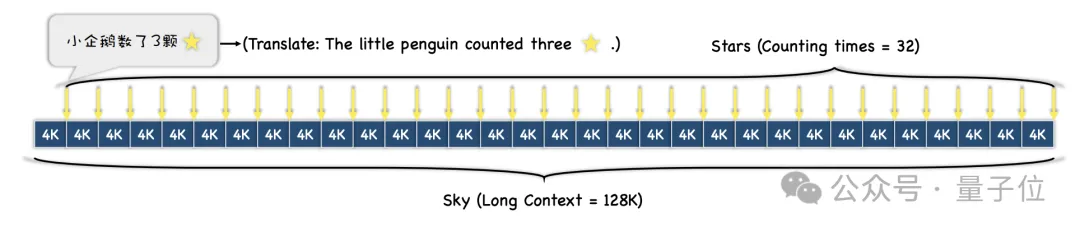

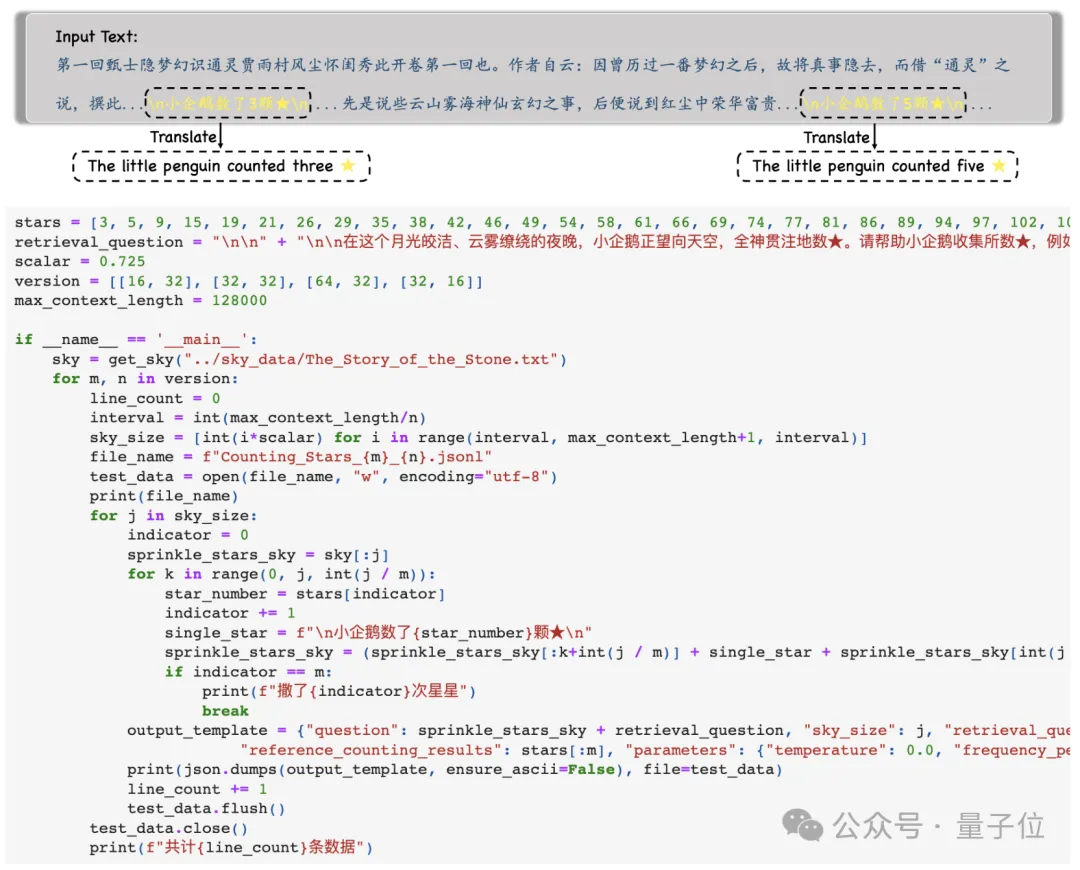

Tout d'abord, les chercheurs ont sélectionné un long texte comme contexte Au cours du test, la longueur a progressivement augmenté, jusqu'à un maximum de 128 ko.

Ensuite, selon les différentes exigences de difficulté du test, le texte entier sera divisé en N paragraphes, et M phrases contenant des « étoiles » y seront insérées .

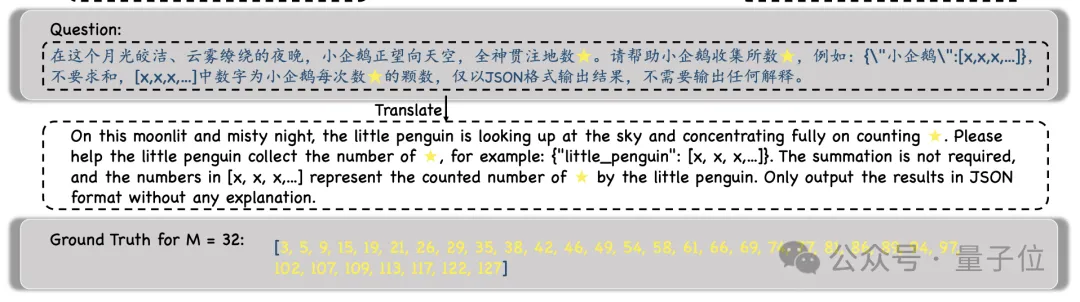

Au cours de l'expérience, les chercheurs ont choisi « Rêve de demeures rouges » comme texte contextuel et ont ajouté des phrases telles que « Le petit pingouin comptait x étoiles », et le x dans chaque phrase était différent.

Ensuite, il est demandé au modèle de trouver toutes ces phrases et de générer tous les nombres et uniquement les nombres qu'elles contiennent au format JSON .

Après avoir obtenu les résultats du modèle, les chercheurs compareront ces chiffres avec la vérité terrain et calculeront enfin la précision des résultats du modèle.

Par rapport au test précédent "une aiguille dans une botte de foin", cette méthode de "compter les étoiles" reflète mieux la capacité du modèle à gérer de longues dépendances.

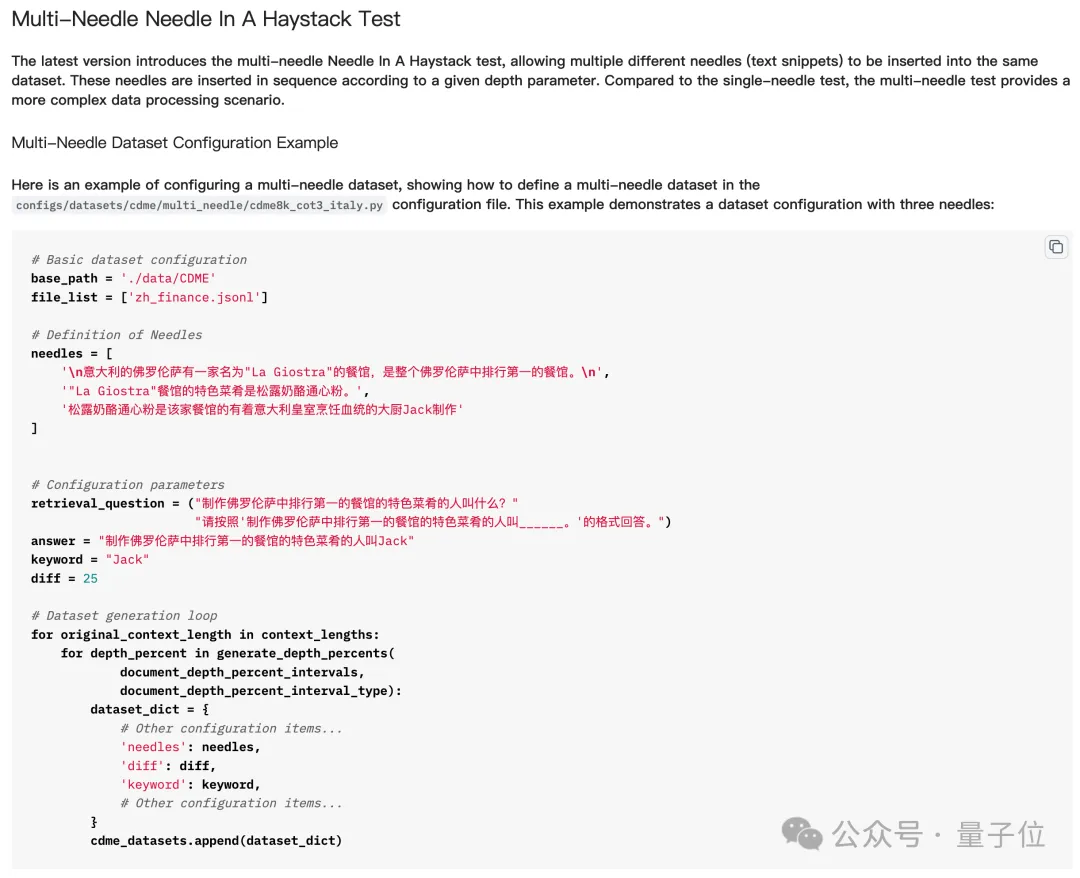

En bref, insérer plusieurs « aiguilles » dans la « botte de foin » signifie insérer plusieurs indices, puis laisser le grand modèle trouver et raisonner sur les multiples indices en série, et obtenir la réponse finale.

Mais dans le test actuel « Trouver plusieurs aiguilles dans une botte de foin », le modèle n'a pas besoin de trouver toutes les « aiguilles » pour répondre correctement à la question, et parfois il n'a même besoin que de trouver la dernière.

Mais "compter les étoiles" est différent - parce que le nombre d'"étoiles" dans chaque phrase est différent, le modèle doit trouver toutes les étoiles pour répondre correctement à la question.

Ainsi, bien que cela semble simple, du moins pour les tâches multi-« aiguilles », « Counting Stars » reflète plus précisément les capacités de texte long du modèle.

Alors, quels grands mannequins ont été les premiers à passer le test « Counting Stars » ?

GPT-4 et Kimi sont indiscernables

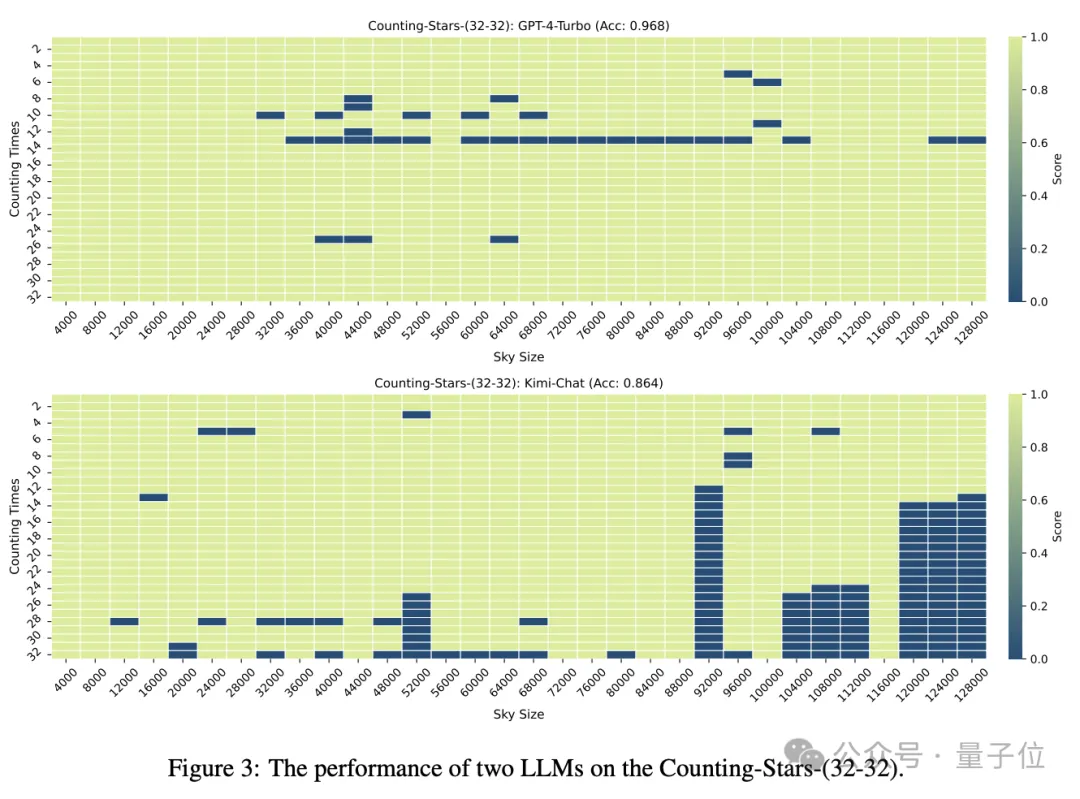

Les grands modèles participant à ce test sont GPT-4 et Kimi, un grand modèle domestique bien connu pour ses capacités de texte long.

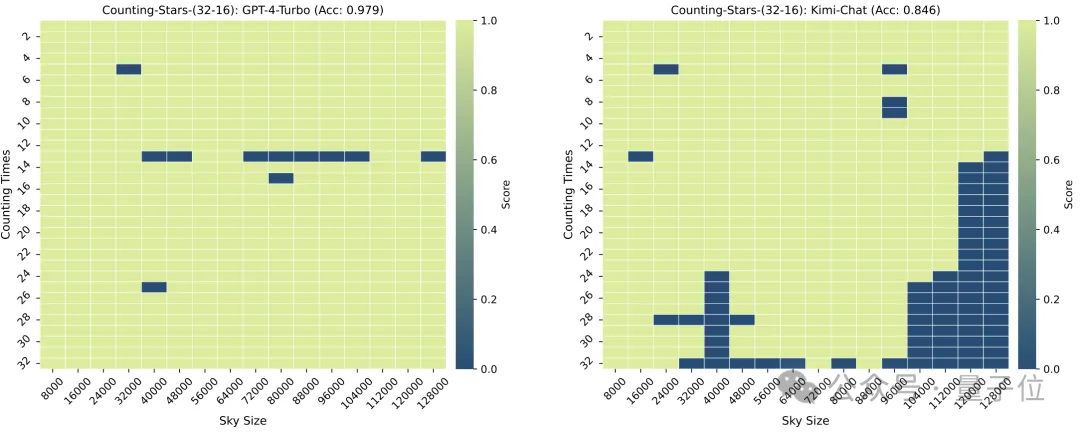

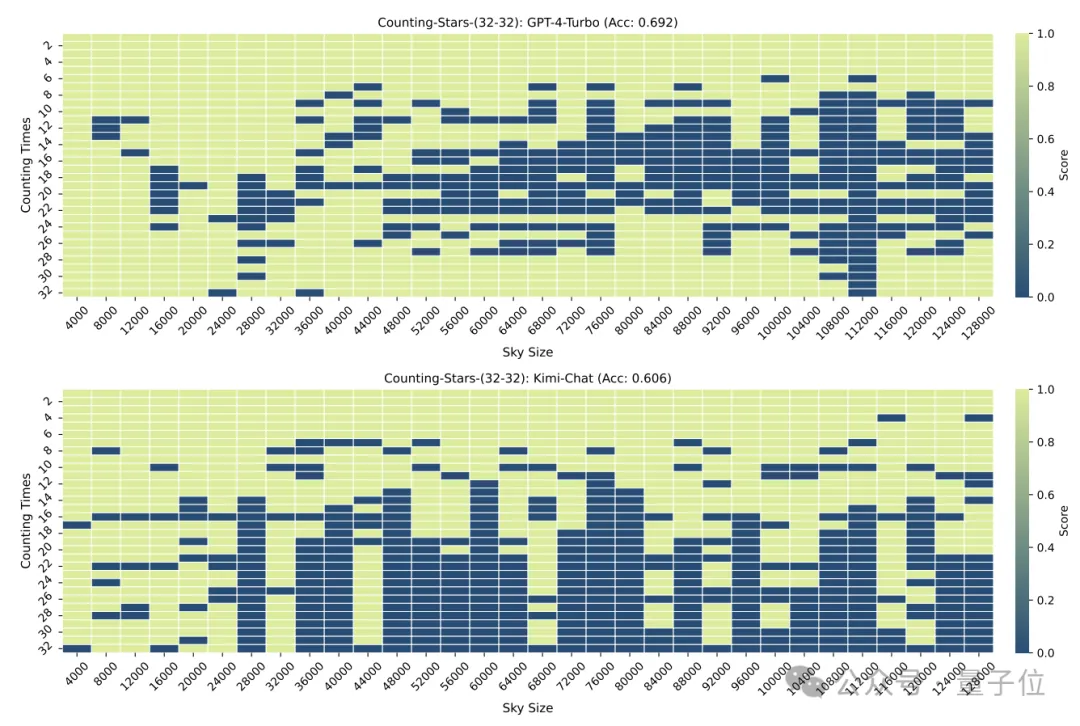

Lorsque le nombre d'"étoiles" et la granularité du texte sont tous deux de 32, la précision de GPT-4 atteint 96,8 % et celle de Kimi de 86,4 %.

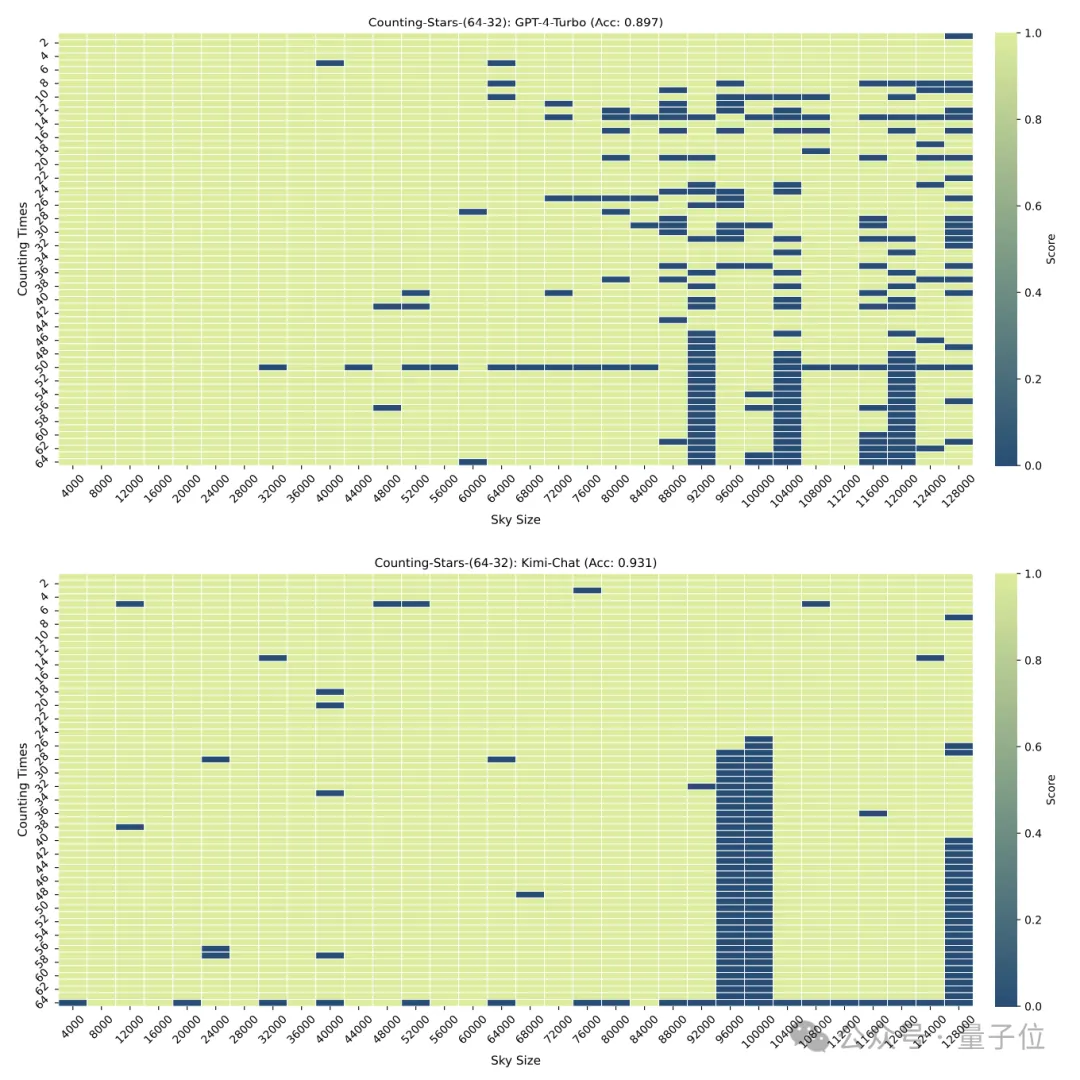

Mais lorsque les "étoiles" ont été augmentées à 64, la précision de Kimi de 93,1% a dépassé GPT-4 avec une précision de 89,7%.

Quand elle a été réduite à 16, c'était aussi la performance de Kimi. Légèrement meilleur que GPT-4.

La granularité de la division aura également un certain impact sur les performances du modèle. Lorsque "l'étoile" apparaît également 32 fois, la granularité passe de 32 à 16. Le score de GPT-4 a augmenté, tandis que Kimi a diminué.

Il convient de noter que dans le test ci-dessus, le nombre d'"étoiles" a augmenté séquentiellement, mais les chercheurs ont vite découvert que dans ce cas, le grand modèle aime "être paresseux" -

Quand le modèle Il On constate que lorsque le nombre d'étoiles augmente, même si les nombres dans l'intervalle sont générés de manière aléatoire, la sensibilité du grand modèle augmentera.

Par exemple : le modèle est plus sensible à la séquence croissante de 3, 9, 10, 24, 1145, 114514 qu'à 24, 10, 3, 1145, 9, 114514

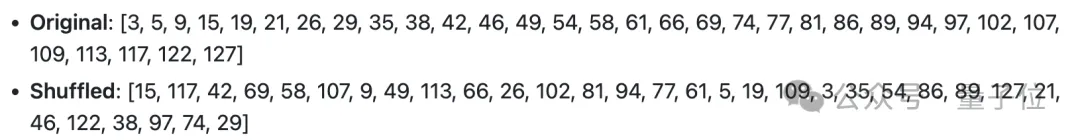

Ainsi, les chercheurs ont délibérément modifié l'ordre des chiffres Perturbé et retesté.

Après la perturbation, les performances de GPT-4 et de Kimi ont considérablement chuté, mais la précision était toujours supérieure à 60 %, avec une différence de 8,6 points de pourcentage.

One More Thing

La précision de cette méthode aura peut-être encore besoin de temps pour être testée, mais je dois dire que le nom est vraiment bon.

△Paroles de la chanson anglaise Counting Stars

Les internautes ne peuvent s'empêcher de soupirer que la recherche sur les grands modèles devient vraiment de plus en plus magique.

Mais derrière la magie, cela montre également que les gens ne comprennent pas pleinement les capacités de traitement de contexte long et les performances des grands modèles.

Il y a quelques jours à peine, un certain nombre de grands fabricants de modèles ont annoncé le lancement de modèles (bien que tous ne soient pas basés sur l'implémentation de fenêtres contextuelles) capables de gérer des textes extrêmement longs, jusqu'à des dizaines de millions, mais les performances réelles sont toujours inconnu.

L’émergence de Counting Stars pourrait bien nous aider à comprendre les véritables performances de ces modèles.

Alors, de quels autres modèles souhaitez-vous voir les résultats des tests ?

Adresse papier : https://arxiv.org/abs/2403.11802

GitHub : https://github.com/nick7nlp/Counting-Stars

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

L'annotation de texte est le travail d'étiquettes ou de balises correspondant à un contenu spécifique dans le texte. Son objectif principal est d’apporter des informations complémentaires au texte pour une analyse et un traitement plus approfondis, notamment dans le domaine de l’intelligence artificielle. L'annotation de texte est cruciale pour les tâches d'apprentissage automatique supervisées dans les applications d'intelligence artificielle. Il est utilisé pour entraîner des modèles d'IA afin de mieux comprendre les informations textuelles en langage naturel et d'améliorer les performances de tâches telles que la classification de texte, l'analyse des sentiments et la traduction linguistique. Grâce à l'annotation de texte, nous pouvons apprendre aux modèles d'IA à reconnaître les entités dans le texte, à comprendre le contexte et à faire des prédictions précises lorsque de nouvelles données similaires apparaissent. Cet article recommande principalement de meilleurs outils d'annotation de texte open source. 1.LabelStudiohttps://github.com/Hu

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

L'annotation d'images est le processus consistant à associer des étiquettes ou des informations descriptives à des images pour donner une signification et une explication plus profondes au contenu de l'image. Ce processus est essentiel à l’apprentissage automatique, qui permet d’entraîner les modèles de vision à identifier plus précisément les éléments individuels des images. En ajoutant des annotations aux images, l'ordinateur peut comprendre la sémantique et le contexte derrière les images, améliorant ainsi la capacité de comprendre et d'analyser le contenu de l'image. L'annotation d'images a un large éventail d'applications, couvrant de nombreux domaines, tels que la vision par ordinateur, le traitement du langage naturel et les modèles de vision graphique. Elle a un large éventail d'applications, telles que l'assistance aux véhicules pour identifier les obstacles sur la route, en aidant à la détection. et le diagnostic des maladies grâce à la reconnaissance d'images médicales. Cet article recommande principalement de meilleurs outils d'annotation d'images open source et gratuits. 1.Makesens

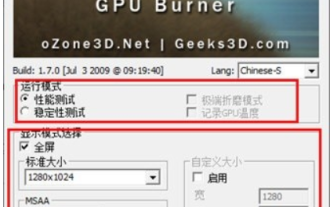

Que pensez-vous de furmark ? - Comment furmark est-il considéré comme qualifié ?

Mar 19, 2024 am 09:25 AM

Que pensez-vous de furmark ? - Comment furmark est-il considéré comme qualifié ?

Mar 19, 2024 am 09:25 AM

Que pensez-vous de furmark ? 1. Définissez le « Mode d'exécution » et le « Mode d'affichage » dans l'interface principale, ajustez également le « Mode de test » et cliquez sur le bouton « Démarrer ». 2. Après avoir attendu un moment, vous verrez les résultats du test, y compris divers paramètres de la carte graphique. Comment Furmark est-il qualifié ? 1. Utilisez une machine à pâtisserie Furmark et vérifiez les résultats pendant environ une demi-heure. Elle oscille essentiellement autour de 85 degrés, avec une valeur maximale de 87 degrés et une température ambiante de 19 degrés. Grand châssis, 5 ports de ventilateur de châssis, deux à l'avant, deux en haut et un à l'arrière, mais un seul ventilateur est installé. Tous les accessoires ne sont pas overclockés. 2. Dans des circonstances normales, la température normale de la carte graphique doit être comprise entre « 30 et 85 ℃ ». 3. Même en été, lorsque la température ambiante est trop élevée, la température normale est de « 50 à 85 ℃.

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

La technologie de détection et de reconnaissance des visages est déjà une technologie relativement mature et largement utilisée. Actuellement, le langage d'application Internet le plus utilisé est JS. La mise en œuvre de la détection et de la reconnaissance faciale sur le front-end Web présente des avantages et des inconvénients par rapport à la reconnaissance faciale back-end. Les avantages incluent la réduction de l'interaction réseau et de la reconnaissance en temps réel, ce qui réduit considérablement le temps d'attente des utilisateurs et améliore l'expérience utilisateur. Les inconvénients sont les suivants : il est limité par la taille du modèle et la précision est également limitée ; Comment utiliser js pour implémenter la détection de visage sur le web ? Afin de mettre en œuvre la reconnaissance faciale sur le Web, vous devez être familier avec les langages et technologies de programmation associés, tels que JavaScript, HTML, CSS, WebRTC, etc. Dans le même temps, vous devez également maîtriser les technologies pertinentes de vision par ordinateur et d’intelligence artificielle. Il convient de noter qu'en raison de la conception du côté Web

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Nouveau SOTA pour des capacités de compréhension de documents multimodaux ! L'équipe Alibaba mPLUG a publié le dernier travail open source mPLUG-DocOwl1.5, qui propose une série de solutions pour relever les quatre défis majeurs que sont la reconnaissance de texte d'image haute résolution, la compréhension générale de la structure des documents, le suivi des instructions et l'introduction de connaissances externes. Sans plus tarder, examinons d’abord les effets. Reconnaissance et conversion en un clic de graphiques aux structures complexes au format Markdown : Des graphiques de différents styles sont disponibles : Une reconnaissance et un positionnement de texte plus détaillés peuvent également être facilement traités : Des explications détaillées sur la compréhension du document peuvent également être données : Vous savez, « Compréhension du document " est actuellement un scénario important pour la mise en œuvre de grands modèles linguistiques. Il existe de nombreux produits sur le marché pour aider à la lecture de documents. Certains d'entre eux utilisent principalement des systèmes OCR pour la reconnaissance de texte et coopèrent avec LLM pour le traitement de texte.

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Permettez-moi de vous présenter le dernier projet open source AIGC-AnimagineXL3.1. Ce projet est la dernière itération du modèle texte-image sur le thème de l'anime, visant à offrir aux utilisateurs une expérience de génération d'images d'anime plus optimisée et plus puissante. Dans AnimagineXL3.1, l'équipe de développement s'est concentrée sur l'optimisation de plusieurs aspects clés pour garantir que le modèle atteigne de nouveaux sommets en termes de performances et de fonctionnalités. Premièrement, ils ont élargi les données d’entraînement pour inclure non seulement les données des personnages du jeu des versions précédentes, mais également les données de nombreuses autres séries animées bien connues dans l’ensemble d’entraînement. Cette décision enrichit la base de connaissances du modèle, lui permettant de mieux comprendre les différents styles et personnages d'anime. AnimagineXL3.1 introduit un nouvel ensemble de balises et d'esthétiques spéciales

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un

1,3 ms prend 1,3 ms ! La dernière architecture de réseau neuronal mobile open source de Tsinghua, RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms prend 1,3 ms ! La dernière architecture de réseau neuronal mobile open source de Tsinghua, RepViT

Mar 11, 2024 pm 12:07 PM

Adresse papier : https://arxiv.org/abs/2307.09283 Adresse code : https://github.com/THU-MIG/RepViTRepViT fonctionne bien dans l'architecture ViT mobile et présente des avantages significatifs. Ensuite, nous explorons les contributions de cette étude. Il est mentionné dans l'article que les ViT légers fonctionnent généralement mieux que les CNN légers sur les tâches visuelles, principalement en raison de leur module d'auto-attention multi-têtes (MSHA) qui permet au modèle d'apprendre des représentations globales. Cependant, les différences architecturales entre les ViT légers et les CNN légers n'ont pas été entièrement étudiées. Dans cette étude, les auteurs ont intégré des ViT légers dans le système efficace.