Il y a vraiment une tendance à encercler et à supprimer Google !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Tutoriel sur la fabrication de pièces inscrites

Tutoriel sur la fabrication de pièces inscrites

Le téléphone ne parvient pas à se connecter au casque Bluetooth

Le téléphone ne parvient pas à se connecter au casque Bluetooth

Utilisation composée

Utilisation composée

vue instructions communes

vue instructions communes

Que dois-je faire si msconfig ne peut pas être ouvert ?

Que dois-je faire si msconfig ne peut pas être ouvert ?

Quelle est la différence entre Douyin et Douyin Express Edition ?

Quelle est la différence entre Douyin et Douyin Express Edition ?

Logiciel de système de gestion immobilière

Logiciel de système de gestion immobilière

Pourquoi swoole peut-il résider en mémoire ?

Pourquoi swoole peut-il résider en mémoire ?

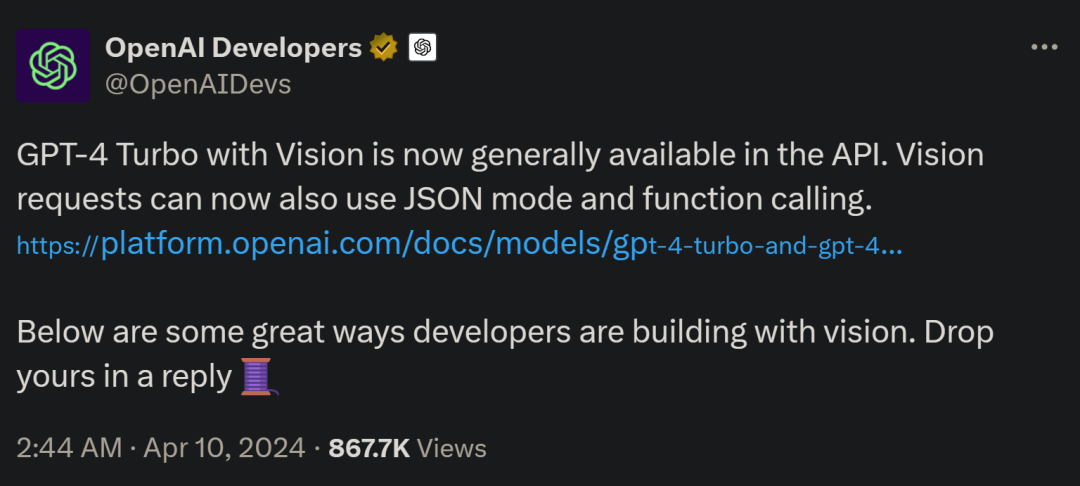

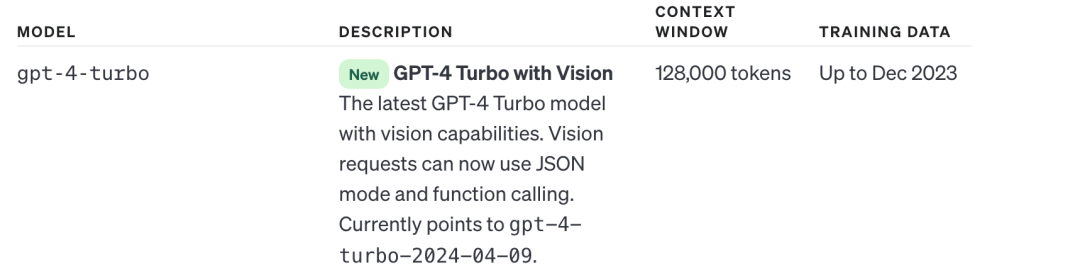

Encyclopédie ChatGPT nationale gratuite

Encyclopédie ChatGPT nationale gratuite