Comprenez la tokenisation en un seul article !

Les modèles linguistiques raisonnent sur le texte, qui se présente généralement sous la forme de chaînes, mais l'entrée du modèle ne peut être que des nombres, le texte doit donc être converti sous forme numérique.

La tokenisation est une tâche de base du traitement du langage naturel. Elle peut diviser une séquence de texte continue (telle que des phrases, des paragraphes, etc.) en une séquence de caractères (telle que des mots, des phrases, des caractères, des signes de ponctuation, etc.) selon des critères spécifiques. besoins. Parmi eux L'unité est appelée un jeton ou un mot.

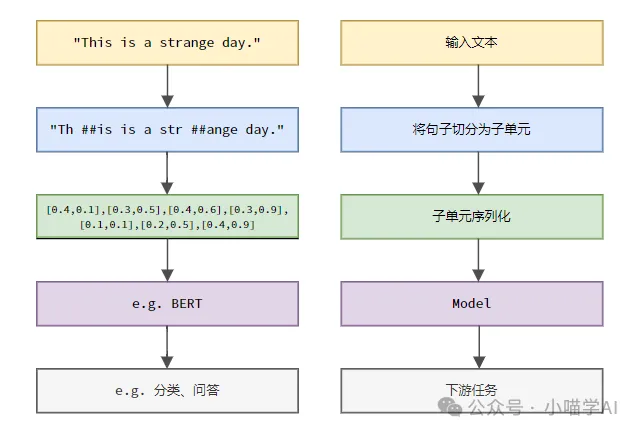

Selon le processus spécifique illustré dans la figure ci-dessous, divisez d'abord les phrases de texte en unités, puis numérisez les éléments individuels (mappez-les en vecteurs), puis entrez ces vecteurs dans le modèle pour l'encodage, et enfin envoyez-les vers des tâches en aval. pour obtenir davantage le résultat final.

Segmentation de texte

Selon la granularité de la segmentation du texte, la tokenisation peut être divisée en trois catégories : la tokenisation granulaire des mots, la tokenisation granulaire des caractères et la tokenisation granulaire des sous-mots.

1. Tokenisation de la granularité des mots

Granularité des mots La tokenisation est la méthode de segmentation de mots la plus intuitive, ce qui signifie segmenter le texte en fonction des mots du vocabulaire. Par exemple :

The quick brown fox jumps over the lazy dog.词粒度Tokenized结果:['The', 'quick', 'brown', 'fox', 'jumps', 'over', 'the', 'lazy', 'dog', '.']

Dans cet exemple, le texte est divisé en mots indépendants, chaque mot est utilisé comme un jeton et le signe de ponctuation '.' est également considéré comme un jeton indépendant.

Les textes chinois sont généralement segmentés sur la base de collections de vocabulaire standard collectées dans des dictionnaires ou des expressions, des expressions idiomatiques, des noms propres, etc. identifiées grâce à des algorithmes de segmentation de mots.

我喜欢吃苹果。词粒度Tokenized结果:['我', '喜欢', '吃', '苹果', '。']

Ce texte chinois est divisé en cinq mots : "Je", "j'aime", "manger", "pomme" et point ".", chaque mot sert de jeton.

2. Tokenisation granulaire des caractères

La tokenisation granulaire des caractères divise le texte en unités de caractères les plus petites, c'est-à-dire que chaque caractère est traité comme un jeton distinct. Par exemple :

Hello, world!字符粒度Tokenized结果:['H', 'e', 'l', 'l', 'o', ',', ' ', 'w', 'o', 'r', 'l', 'd', '!']

Granularité des caractères La tokenisation en chinois consiste à segmenter le texte en fonction de chaque caractère chinois indépendant.

我喜欢吃苹果。字符粒度Tokenized结果:['我', '喜', '欢', '吃', '苹', '果', '。']

3.subword granular Tokenization

subword granular Tokenization se situe entre la granularité des mots et la granularité des caractères. Elle divise le texte en sous-mots (sous-mots) entre les mots et les caractères en tant que jetons. Les méthodes courantes de tokenisation de sous-mots incluent le codage par paire d'octets (BPE), WordPièce, etc. Ces méthodes génèrent automatiquement un dictionnaire de segmentation de mots en comptant les fréquences de sous-chaînes dans les données texte, ce qui permet de résoudre efficacement le problème des mots hors service (OOV) tout en conservant une certaine intégrité sémantique.

helloworld

Supposons qu'après un entraînement avec l'algorithme BPE, le dictionnaire de sous-mots généré contienne les entrées suivantes :

h, e, l, o, w, r, d, hel, low, wor, orld

Granularité des sous-mots Résultats tokenisés :

['hel', 'low', 'orld']

Ici, "helloworld" est divisé en trois sous-mots" " hel", "low", "orld", ce sont toutes des combinaisons de sous-chaînes à haute fréquence qui apparaissent dans les dictionnaires. Cette méthode de segmentation peut non seulement gérer des mots inconnus (par exemple, « helloworld » n'est pas un mot anglais standard), mais également conserver certaines informations sémantiques (la combinaison de sous-mots peut restaurer le mot original).

En chinois, la tokenisation granulaire des sous-mots divise également le texte en sous-mots entre les caractères chinois et les mots en tant que jetons. Par exemple :

我喜欢吃苹果

Supposons qu'après un entraînement avec l'algorithme BPE, le dictionnaire de sous-mots généré contienne les entrées suivantes :

我, 喜, 欢, 吃, 苹, 果, 我喜欢, 吃苹果

Granularité des sous-mots Résultats tokenisés :

['我', '喜欢', '吃', '苹果']

Dans cet exemple, "J'aime manger pommes" Il est divisé en quatre sous-mots "Je", "aimer", "manger" et "pomme", et ces sous-mots apparaissent tous dans le dictionnaire. Bien que les caractères chinois ne soient pas combinés comme les sous-mots anglais, la méthode de tokenisation des sous-mots a pris en compte des combinaisons de mots à haute fréquence, telles que « J'aime » et « manger des pommes » lors de la génération du dictionnaire. Cette méthode de segmentation conserve les informations sémantiques au niveau des mots tout en traitant les mots inconnus.

Indexation

Supposons qu'un corpus ou un vocabulaire ait été créé comme suit.

vocabulary = {'我': 0,'喜欢': 1,'吃': 2,'苹果': 3,'。': 4}peut retrouver l'index de chaque jeton dans la séquence dans le vocabulaire.

indexed_tokens = [vocabulary[token] for token in token_sequence]print(indexed_tokens)

Sortie : [0, 1, 2, 3, 4].

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:36 PM

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:36 PM

Pour créer une base de données Oracle, la méthode commune consiste à utiliser l'outil graphique DBCA. Les étapes sont les suivantes: 1. Utilisez l'outil DBCA pour définir le nom DBN pour spécifier le nom de la base de données; 2. Définissez Syspassword et SystemPassword sur des mots de passe forts; 3. Définir les caractères et NationalCharacterset à Al32Utf8; 4. Définissez la taille de mémoire et les espaces de table pour s'ajuster en fonction des besoins réels; 5. Spécifiez le chemin du fichier log. Les méthodes avancées sont créées manuellement à l'aide de commandes SQL, mais sont plus complexes et sujets aux erreurs. Faites attention à la force du mot de passe, à la sélection du jeu de caractères, à la taille et à la mémoire de l'espace de table

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:33 PM

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:33 PM

La création d'une base de données Oracle n'est pas facile, vous devez comprendre le mécanisme sous-jacent. 1. Vous devez comprendre les concepts de la base de données et des SGBD Oracle; 2. Master les concepts de base tels que SID, CDB (base de données de conteneurs), PDB (base de données enfichable); 3. Utilisez SQL * Plus pour créer CDB, puis créer PDB, vous devez spécifier des paramètres tels que la taille, le nombre de fichiers de données et les chemins; 4. Les applications avancées doivent ajuster le jeu de caractères, la mémoire et d'autres paramètres et effectuer un réglage des performances; 5. Faites attention à l'espace disque, aux autorisations et aux paramètres des paramètres, et surveillez et optimisez en continu les performances de la base de données. Ce n'est qu'en le maîtrisant habilement une pratique continue que vous pouvez vraiment comprendre la création et la gestion des bases de données Oracle.

Comment rédiger des instructions de base de données Oracle

Apr 11, 2025 pm 02:42 PM

Comment rédiger des instructions de base de données Oracle

Apr 11, 2025 pm 02:42 PM

Le cœur des instructions Oracle SQL est sélectionné, insérer, mettre à jour et supprimer, ainsi que l'application flexible de diverses clauses. Il est crucial de comprendre le mécanisme d'exécution derrière l'instruction, tel que l'optimisation de l'indice. Les usages avancés comprennent des sous-requêtes, des requêtes de connexion, des fonctions d'analyse et PL / SQL. Les erreurs courantes incluent les erreurs de syntaxe, les problèmes de performances et les problèmes de cohérence des données. Les meilleures pratiques d'optimisation des performances impliquent d'utiliser des index appropriés, d'éviter la sélection *, d'optimiser les clauses et d'utiliser des variables liées. La maîtrise d'Oracle SQL nécessite de la pratique, y compris l'écriture de code, le débogage, la réflexion et la compréhension des mécanismes sous-jacents.

Comment ajouter, modifier et supprimer le guide de fonctionnement du champ de table de données MySQL

Apr 11, 2025 pm 05:42 PM

Comment ajouter, modifier et supprimer le guide de fonctionnement du champ de table de données MySQL

Apr 11, 2025 pm 05:42 PM

Guide de fonctionnement du champ dans MySQL: Ajouter, modifier et supprimer les champs. Ajouter un champ: alter table table_name Ajouter Column_name data_type [pas null] [Default default_value] [Clé primaire] [Auto_increment] Modifier le champ: alter table table_name modifie Column_name data_type [pas null] [default default_value] [clé primaire]

Quelles sont les contraintes d'intégrité des tables de base de données Oracle?

Apr 11, 2025 pm 03:42 PM

Quelles sont les contraintes d'intégrité des tables de base de données Oracle?

Apr 11, 2025 pm 03:42 PM

Les contraintes d'intégrité des bases de données Oracle peuvent garantir la précision des données, notamment: Not Null: les valeurs nulles sont interdites; Unique: garantie l'unicité, permettant une seule valeur nulle; Clé primaire: contrainte de clé primaire, renforcer unique et interdire les valeurs nulles; Clé étrangère: maintenir les relations entre les tableaux, les clés étrangères se réfèrent aux clés primaires primaires; Vérifiez: limitez les valeurs de colonne en fonction des conditions.

Explication détaillée des instances de requête imbriquées dans la base de données MySQL

Apr 11, 2025 pm 05:48 PM

Explication détaillée des instances de requête imbriquées dans la base de données MySQL

Apr 11, 2025 pm 05:48 PM

Les requêtes imbriquées sont un moyen d'inclure une autre requête dans une requête. Ils sont principalement utilisés pour récupérer des données qui remplissent des conditions complexes, associer plusieurs tables et calculer des valeurs de résumé ou des informations statistiques. Les exemples incluent la recherche de salaires supérieurs aux employés, la recherche de commandes pour une catégorie spécifique et le calcul du volume des commandes totales pour chaque produit. Lorsque vous écrivez des requêtes imbriquées, vous devez suivre: écrire des sous-requêtes, écrire leurs résultats sur les requêtes extérieures (référencées avec des alias ou en tant que clauses) et optimiser les performances de la requête (en utilisant des index).

Que fait Oracle

Apr 11, 2025 pm 06:06 PM

Que fait Oracle

Apr 11, 2025 pm 06:06 PM

Oracle est la plus grande société de logiciels de gestion de base de données au monde (SGBD). Ses principaux produits incluent les fonctions suivantes: Outils de développement du système de gestion de la base de données relationnels (Oracle Database) (Oracle Apex, Oracle Visual Builder) Middleware (Oracle Weblogic Server, Oracle Soa Suite) Cloud Service (Oracle Cloud Infrastructure) Analyse et Oracle Blockchain Pla Intelligence (Oracle Analytic

Comment configurer le format de journal debian Apache

Apr 12, 2025 pm 11:30 PM

Comment configurer le format de journal debian Apache

Apr 12, 2025 pm 11:30 PM

Cet article décrit comment personnaliser le format de journal d'Apache sur les systèmes Debian. Les étapes suivantes vous guideront à travers le processus de configuration: Étape 1: Accédez au fichier de configuration Apache Le fichier de configuration apache principal du système Debian est généralement situé dans /etc/apache2/apache2.conf ou /etc/apache2/httpd.conf. Ouvrez le fichier de configuration avec les autorisations racinaires à l'aide de la commande suivante: sudonano / etc / apache2 / apache2.conf ou sudonano / etc / apache2 / httpd.conf Étape 2: définir les formats de journal personnalisés à trouver ou