Périphériques technologiques

Périphériques technologiques

IA

IA

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Soudain ! OpenAI a licencié des gens, la raison : une fuite d'informations suspectée.

L'un d'entre eux est Léopold Aschenbrenner, un allié du scientifique en chef disparu Ilya et un membre principal de l'équipe Superalignment.

L'autre personne n'est pas simple non plus. Il s'agit de Pavel Izmailov, chercheur dans l'équipe d'inférence du LLM, qui a également travaillé dans l'équipe de super alignement.

On ne sait actuellement pas quelles informations ces deux personnes ont divulguées.

Après la révélation de la nouvelle, de nombreux internautes se sont dits "assez choqués" :

J'ai vu le message d'Aschenbrenner il n'y a pas longtemps et j'ai senti qu'il était en pleine ascension dans sa carrière. Je ne m'attendais pas à un tel changement.

Photos

Photos

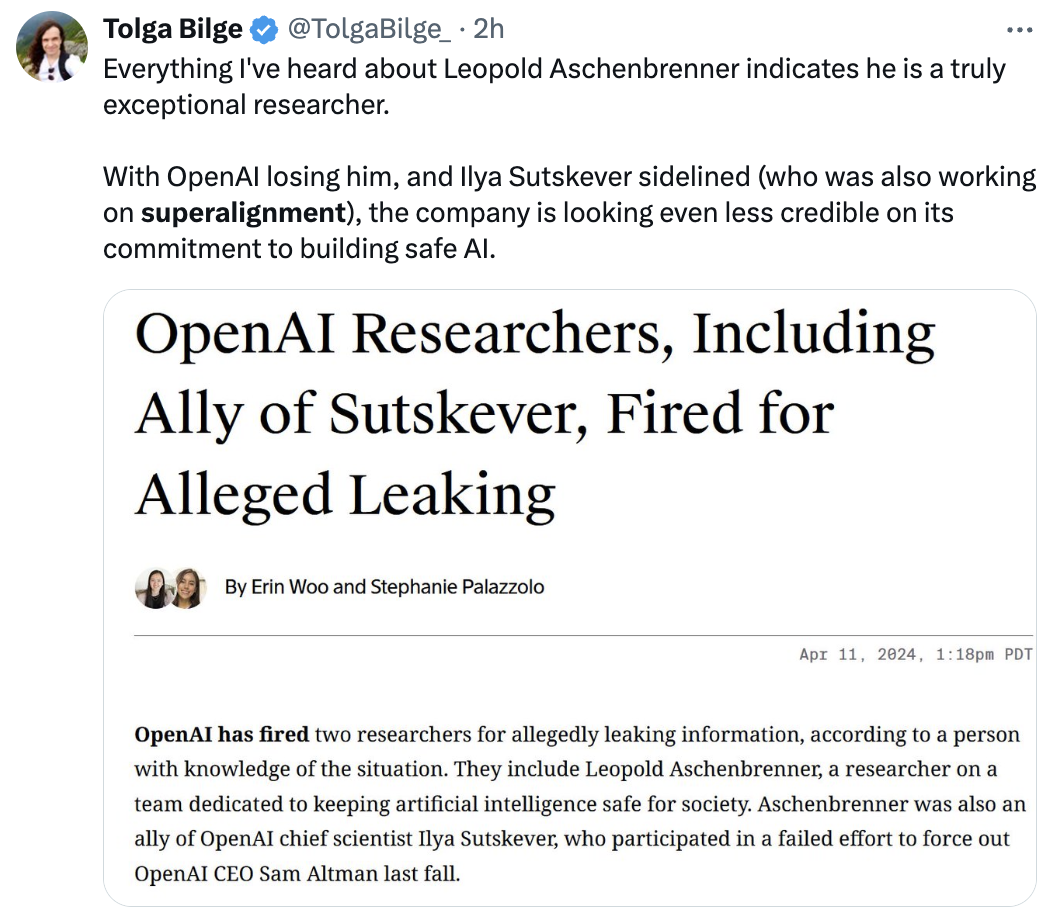

Certains internautes pensent :

OpenAI a perdu Aschenbrenner, Ilya Sutskever a également été marginalisé, et l'engagement de l'entreprise à construire une IA sûre semble encore plus indigne de confiance.

Pictures

Pictures

Le flux de talents d'OpenAI et le braconnage mutuel avec Google Meta ne sont plus surprenants, mais il s'agit du premier transfert de personnel sous forme d'expulsions depuis la rébellion du conseil d'administration en novembre de l'année dernière.

Tous deux étaient autrefois des subordonnés d'Ilya

Il est entendu que Leopold Aschenbrenner a rejoint OpenAI il y a un an. Il avait auparavant travaillé au Future Fund. En remontant plus loin, il est diplômé de l'Université de Columbia à l'âge de 19 ans et a également mené des recherches sur la croissance économique à l'Université d'Oxford.

Pavel Izmailov est également membre de l'équipe CILVR à l'Université de New York. Il a révélé qu'il rejoindrait NYU Tandon CSE et Courant CS à l'automne 2025 en tant que professeur adjoint.

Actuellement, leurs deux pages d'accueil X notent leur relation avec OpenAI.

Pictures

Pictures

Pictures

Pictures

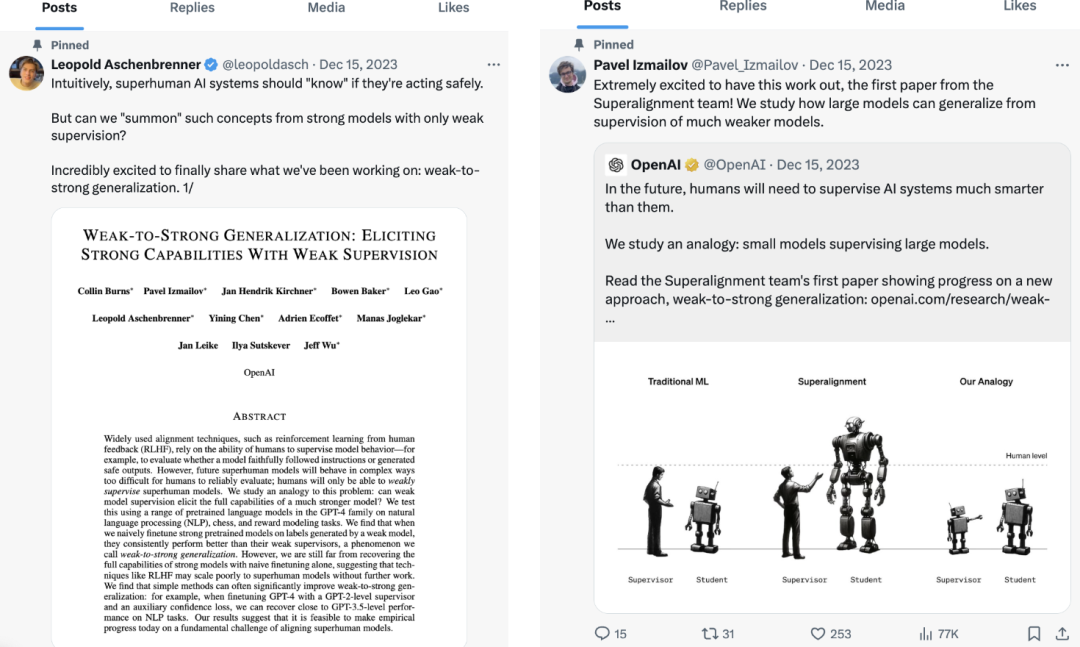

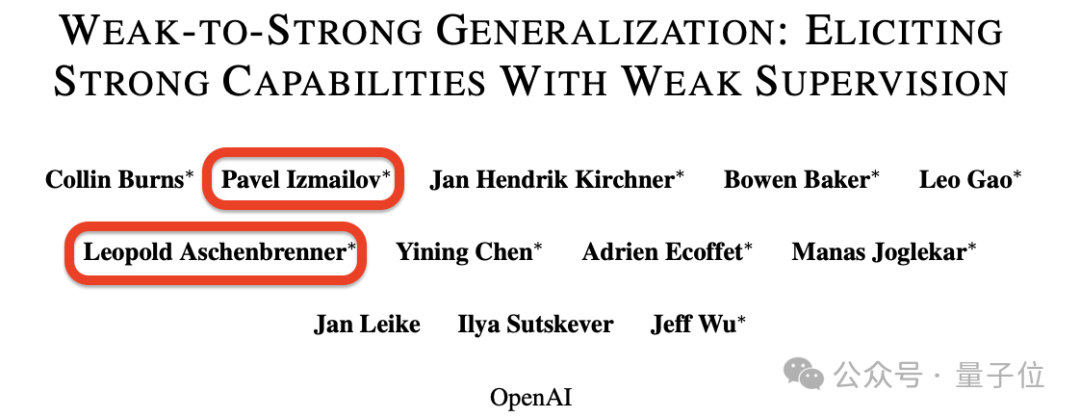

Tous deux n'ont pas publié de nouveaux tweets au cours du mois dernier, mais les messages épinglés sont très accrocheurs.

Oui, tous deux sont les premiers articles de l'équipe Super Alignment, et tous deux sont les auteurs de cet article.

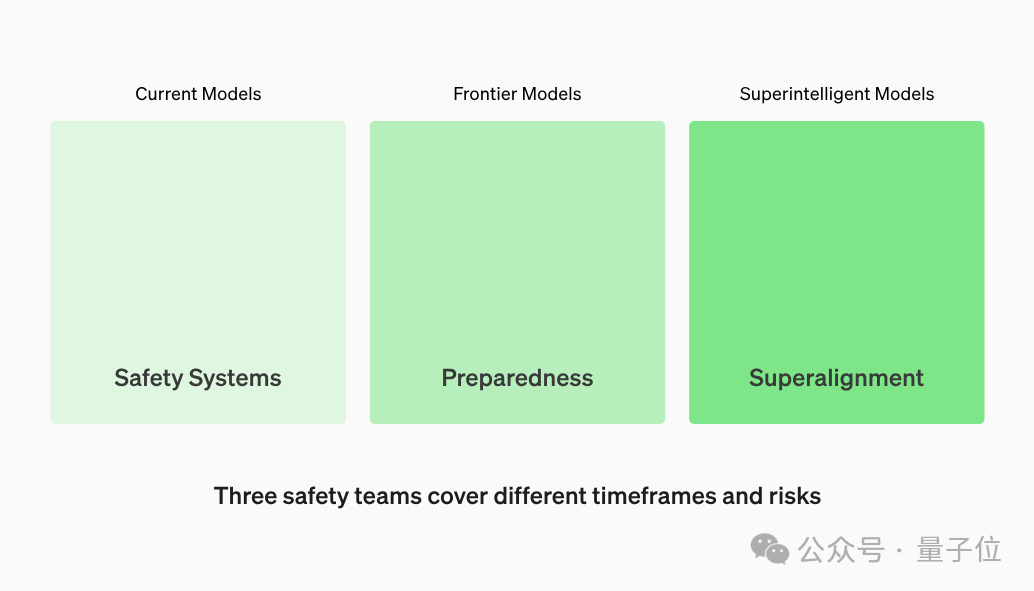

Il faut dire cela à propos de cette équipe, qui a été créée en juillet de l'année dernière. C'est l'une des trois principales équipes de sécurité établies par OpenAI pour traiter les problèmes de sécurité pouvant survenir à partir de grands modèles à différentes échelles de temps.

Photos

Photos

La Super Alignment Team est chargée de jeter les bases de la sécurité du super-renseignement dans un avenir lointain, dirigée par Ilya Sutskever et Jan Leike.

Bien qu'OpenAI semble prendre la sécurité au sérieux, ce n'est un secret pour personne qu'il existe de grandes différences en son sein concernant le développement sûr de l'IA.

Ce désaccord est même considéré comme la principale raison des conflits internes au conseil d'administration d'OpenAI en novembre de l'année dernière :

Photos

Photos

On dit en ligne qu'Ilya Sutskever est devenu le leader du "coup d'État" parce qu'il a vu quelque chose qui l'a mis mal à l'aise.

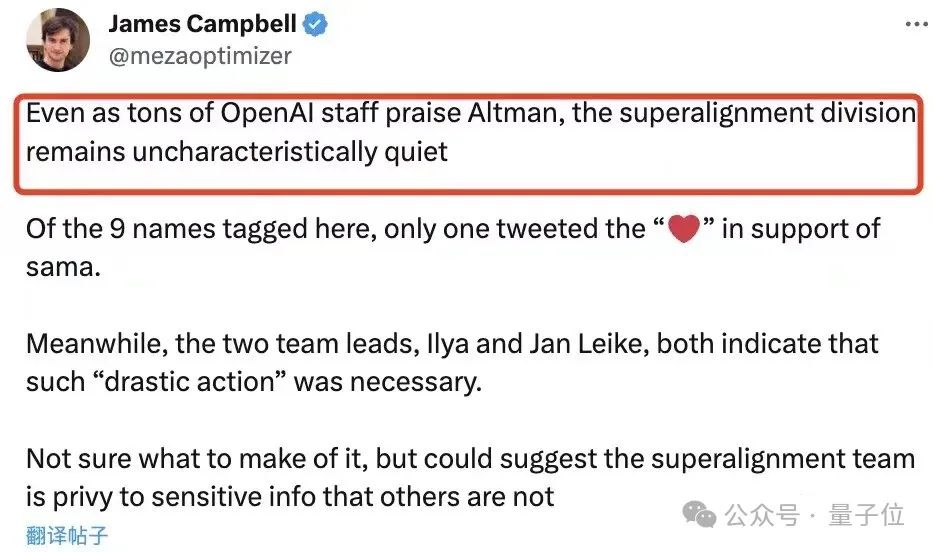

Quant à l'équipe super-alignée dirigée par Ilya, de nombreux membres ont également soutenu Ilya. Lors de l'événement Solitaire qui a suivi en soutien à Ultraman, les membres de cette équipe super-alignée sont restés pratiquement silencieux.

Photos

Photos

Alors que les conflits internes à OpenAI s'apaisaient, Ultraman est devenu le vainqueur, Ilya Sutskever a quitté le conseil d'administration et n'est presque plus jamais apparu en public. Nous ne savons pas quelle est la situation de l'équipe Super Alignment maintenant. .

À cette époque, deux chercheurs ont été licenciés.

Tous deux étaient autrefois des subordonnés d'Ilya. L'information indiquait également qu'Aschenbrenner est un allié d'Ilya et est lié au mouvement qui donne la priorité à la résolution des dangers de l'IA.

Par conséquent, certains internautes ont émis l’hypothèse que ce licenciement était le « règlement de comptes » d’Ultraman.

Est-ce lié aux fuites Q* ?

De plus, les internautes sont plus préoccupés par le contenu divulgué.

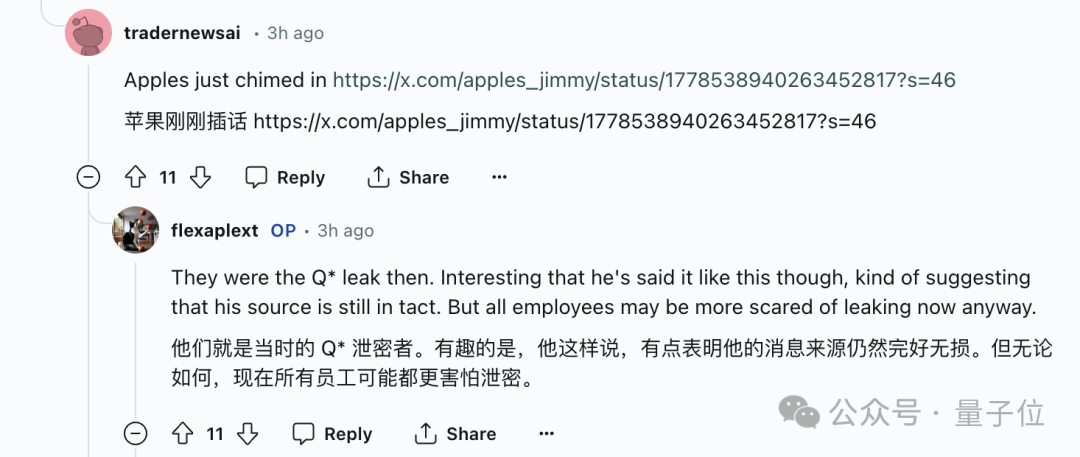

La spéculation actuelle se concentre toujours sur Q*, qui est l'un des déclencheurs de la rébellion des conseils d'administration.

Selon les commentaires des internautes, Jimmy Apples semblait avoir publié des tweets liés, mais peu de temps après, nous avons vu que le tweet avait été supprimé lorsque le lien a été ouvert...

Photos

Photos

À en juger par les indices laissés derrière , il semble que cela puisse encore être lié à Q*.

Photos

Photos

Actuellement, Q* est passé de rumeurs à une existence officiellement confirmée, mais Ultraman lui-même est actuellement discret sur tout ce qui s'y rapporte.

Photos

Photos

En bref, depuis Q*, il y a eu des divergences idéologiques au sein d'OpenAI.

Après une série de troubles, 93 % des employés ont signé une lettre commune pour vivre et mourir avec Ultraman. Après l'annonce des résultats de l'enquête, Ultraman est revenu au conseil d'administration sans inculpation.

Tout semble calme, mais dans les coulisses, tout le monde s'engage à réaliser l'AGI, mais des fissures existent encore.

Lien de référence :

[1]https://www.theinformation.com/articles/openai-researchers-inclure-ally-of-sutskever-fired-for-alleged-leaking

[2]https://x. com/BenjaminDEKR/status/1778536771837694353

[3]https://twitter.com/leopoldasch

[4]https://twitter.com/Pavel_Izmailov

[5]https://www.reddit.com/r/singularity /comments/1c1qo04/openai_superalignment_researcher_fired_for/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Un nouveau paradigme de programmation, quand Spring Boot rencontre OpenAI

Feb 01, 2024 pm 09:18 PM

Un nouveau paradigme de programmation, quand Spring Boot rencontre OpenAI

Feb 01, 2024 pm 09:18 PM

En 2023, la technologie de l’IA est devenue un sujet brûlant et a un impact énorme sur diverses industries, notamment dans le domaine de la programmation. Les gens sont de plus en plus conscients de l’importance de la technologie de l’IA, et la communauté Spring ne fait pas exception. Avec l’évolution continue de la technologie GenAI (Intelligence Artificielle Générale), il est devenu crucial et urgent de simplifier la création d’applications dotées de fonctions d’IA. Dans ce contexte, « SpringAI » a émergé, visant à simplifier le processus de développement d'applications fonctionnelles d'IA, en le rendant simple et intuitif et en évitant une complexité inutile. Grâce à « SpringAI », les développeurs peuvent plus facilement créer des applications dotées de fonctions d'IA, ce qui les rend plus faciles à utiliser et à exploiter.

Choisir le modèle d'intégration qui correspond le mieux à vos données : un test comparatif des intégrations multilingues OpenAI et open source

Feb 26, 2024 pm 06:10 PM

Choisir le modèle d'intégration qui correspond le mieux à vos données : un test comparatif des intégrations multilingues OpenAI et open source

Feb 26, 2024 pm 06:10 PM

OpenAI a récemment annoncé le lancement de son modèle d'intégration de dernière génération, embeddingv3, qui, selon eux, est le modèle d'intégration le plus performant avec des performances multilingues plus élevées. Ce lot de modèles est divisé en deux types : les plus petits text-embeddings-3-small et les plus puissants et plus grands text-embeddings-3-large. Peu d'informations sont divulguées sur la façon dont ces modèles sont conçus et formés, et les modèles ne sont accessibles que via des API payantes. Il existe donc de nombreux modèles d'intégration open source. Mais comment ces modèles open source se comparent-ils au modèle open source open source ? Cet article comparera empiriquement les performances de ces nouveaux modèles avec des modèles open source. Nous prévoyons de créer une donnée

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Si la réponse donnée par le modèle d’IA est incompréhensible du tout, oseriez-vous l’utiliser ? À mesure que les systèmes d’apprentissage automatique sont utilisés dans des domaines de plus en plus importants, il devient de plus en plus important de démontrer pourquoi nous pouvons faire confiance à leurs résultats, et quand ne pas leur faire confiance. Une façon possible de gagner confiance dans le résultat d'un système complexe est d'exiger que le système produise une interprétation de son résultat qui soit lisible par un humain ou un autre système de confiance, c'est-à-dire entièrement compréhensible au point que toute erreur possible puisse être trouvé. Par exemple, pour renforcer la confiance dans le système judiciaire, nous exigeons que les tribunaux fournissent des avis écrits clairs et lisibles qui expliquent et soutiennent leurs décisions. Pour les grands modèles de langage, nous pouvons également adopter une approche similaire. Cependant, lorsque vous adoptez cette approche, assurez-vous que le modèle de langage génère

L'éditeur Zed basé sur Rust est open source, avec prise en charge intégrée d'OpenAI et GitHub Copilot

Feb 01, 2024 pm 02:51 PM

L'éditeur Zed basé sur Rust est open source, avec prise en charge intégrée d'OpenAI et GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Auteur丨Compilé par TimAnderson丨Produit par Noah|51CTO Technology Stack (WeChat ID : blog51cto) Le projet d'éditeur Zed est encore en phase de pré-version et a été open source sous licences AGPL, GPL et Apache. L'éditeur offre des performances élevées et plusieurs options assistées par l'IA, mais n'est actuellement disponible que sur la plate-forme Mac. Nathan Sobo a expliqué dans un article que dans la base de code du projet Zed sur GitHub, la partie éditeur est sous licence GPL, les composants côté serveur sont sous licence AGPL et la partie GPUI (GPU Accelerated User) l'interface) adopte la Licence Apache2.0. GPUI est un produit développé par l'équipe Zed

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

Mar 18, 2024 pm 08:40 PM

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

Mar 18, 2024 pm 08:40 PM

Il n'y a pas si longtemps, OpenAISora est rapidement devenu populaire grâce à ses étonnants effets de génération vidéo. Il s'est démarqué parmi la foule de modèles vidéo littéraires et est devenu le centre d'attention mondiale. Suite au lancement du processus de reproduction d'inférence de formation Sora avec une réduction des coûts de 46 % il y a 2 semaines, l'équipe Colossal-AI a entièrement open source le premier modèle de génération vidéo d'architecture de type Sora au monde "Open-Sora1.0", couvrant l'ensemble processus de formation, y compris le traitement des données, tous les détails de la formation et les poids des modèles, et joignez-vous aux passionnés mondiaux de l'IA pour promouvoir une nouvelle ère de création vidéo. Pour un aperçu, jetons un œil à une vidéo d'une ville animée générée par le modèle « Open-Sora1.0 » publié par l'équipe Colossal-AI. Ouvrir-Sora1.0

Microsoft et OpenAI prévoient d'investir 100 millions de dollars dans des robots humanoïdes ! Les internautes appellent Musk

Feb 01, 2024 am 11:18 AM

Microsoft et OpenAI prévoient d'investir 100 millions de dollars dans des robots humanoïdes ! Les internautes appellent Musk

Feb 01, 2024 am 11:18 AM

Il a été révélé que Microsoft et OpenAI investissaient de grosses sommes d’argent dans une start-up de robots humanoïdes au début de l’année. Parmi eux, Microsoft prévoit d'investir 95 millions de dollars et OpenAI investira 5 millions de dollars. Selon Bloomberg, la société devrait lever un total de 500 millions de dollars au cours de ce cycle, et sa valorisation pré-monétaire pourrait atteindre 1,9 milliard de dollars. Qu'est-ce qui les attire ? Jetons d’abord un coup d’œil aux réalisations de cette entreprise en matière de robotique. Ce robot est tout argenté et noir, et son apparence ressemble à l'image d'un robot dans un blockbuster de science-fiction hollywoodien : maintenant, il met une capsule de café dans la machine à café : si elle n'est pas placée correctement, elle s'ajustera sans aucun problème. télécommande humaine : Cependant, après un certain temps, une tasse de café peut être emportée et dégustée : Avez-vous des membres de votre famille qui l'ont reconnu ? Oui, ce robot a été créé il y a quelque temps.

Les performances d'exécution locale du service Embedding dépassent celles d'OpenAI Text-Embedding-Ada-002, ce qui est très pratique !

Apr 15, 2024 am 09:01 AM

Les performances d'exécution locale du service Embedding dépassent celles d'OpenAI Text-Embedding-Ada-002, ce qui est très pratique !

Apr 15, 2024 am 09:01 AM

Ollama est un outil super pratique qui vous permet d'exécuter facilement des modèles open source tels que Llama2, Mistral et Gemma localement. Dans cet article, je vais vous présenter comment utiliser Ollama pour vectoriser du texte. Si vous n'avez pas installé Ollama localement, vous pouvez lire cet article. Dans cet article, nous utiliserons le modèle nomic-embed-text[2]. Il s'agit d'un encodeur de texte qui surpasse OpenAI text-embedding-ada-002 et text-embedding-3-small sur les tâches à contexte court et à contexte long. Démarrez le service nomic-embed-text lorsque vous avez installé avec succès o

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Apr 15, 2024 am 09:01 AM

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Apr 15, 2024 am 09:01 AM

Soudain! OpenAI a licencié des gens, la raison : une fuite d'informations suspectée. L’un d’eux est Léopold Aschenbrenner, un allié du scientifique en chef disparu Ilya et un membre principal de l’équipe Superalignment. L'autre personne n'est pas simple non plus : il s'agit de Pavel Izmailov, chercheur au sein de l'équipe d'inférence du LLM, qui a également travaillé dans l'équipe de super alignement. On ne sait pas exactement quelles informations les deux hommes ont divulguées. Après que la nouvelle ait été révélée, de nombreux internautes se sont dits « assez choqués » : j'ai vu le message d'Aschenbrenner il n'y a pas longtemps et j'ai senti qu'il était en pleine ascension dans sa carrière. Certains internautes sur la photo pensent : OpenAI a perdu Aschenbrenner, je