Au lieu de suivre le chemin habituel de Transformer, nous avons modifié la nouvelle architecture domestique de RNN RWKV et réalisé de nouveaux progrès :

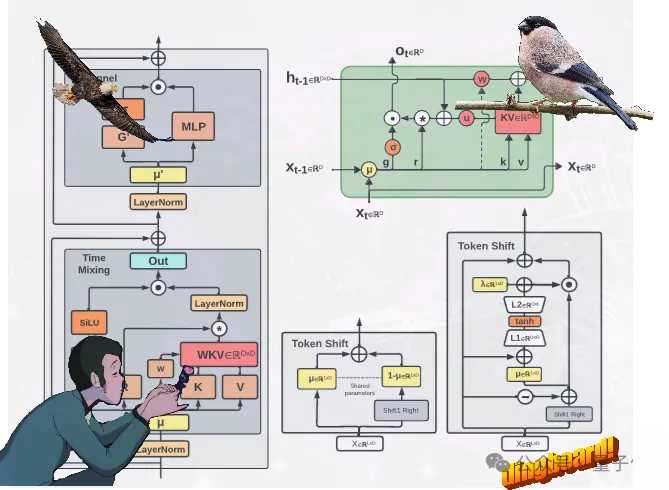

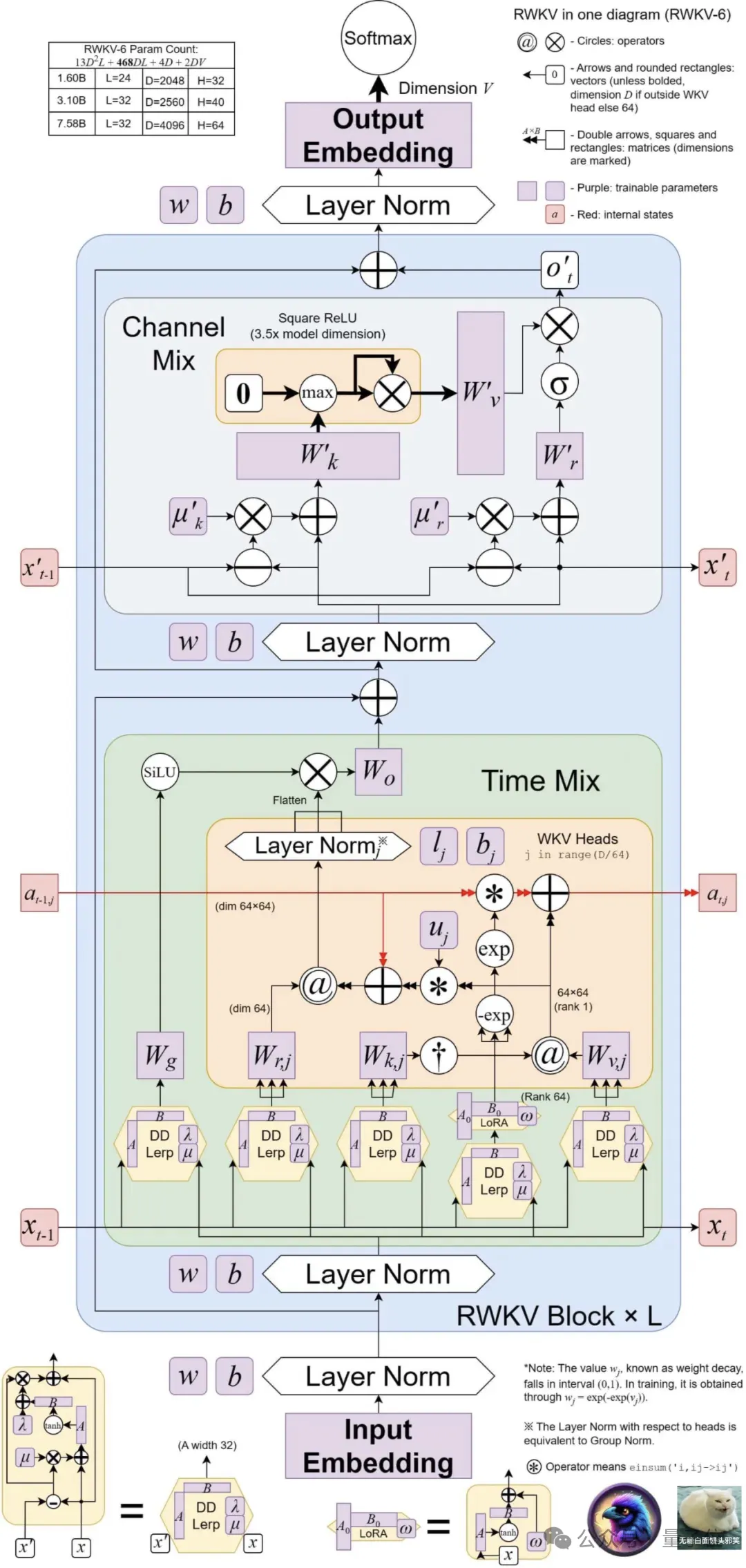

proposé deux nouvelles architectures RWKV, à savoir Eagle (RWKV-5) et Finch ( RWKV-6).

Ces deux modèles de séquence sont basés sur l'architecture RWKV-4 puis améliorés.

Les progrès de conception dans la nouvelle architecture incluent états à valeurs matricielles à plusieurs têtes(états à valeurs matricielles à plusieurs têtes) et mécanisme de récurrence dynamique(mécanisme de récurrence dynamique) Ces améliorations améliorent la capacité d'expression de. le modèle RWKV, tout en conservant les caractéristiques d'efficacité d'inférence de RNN.

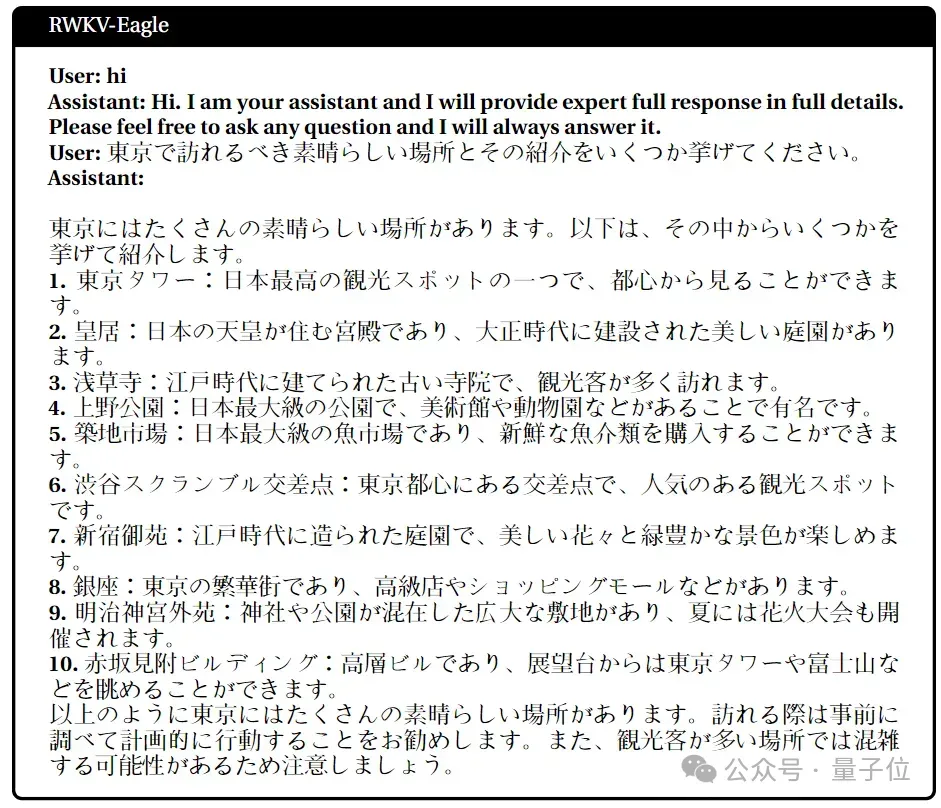

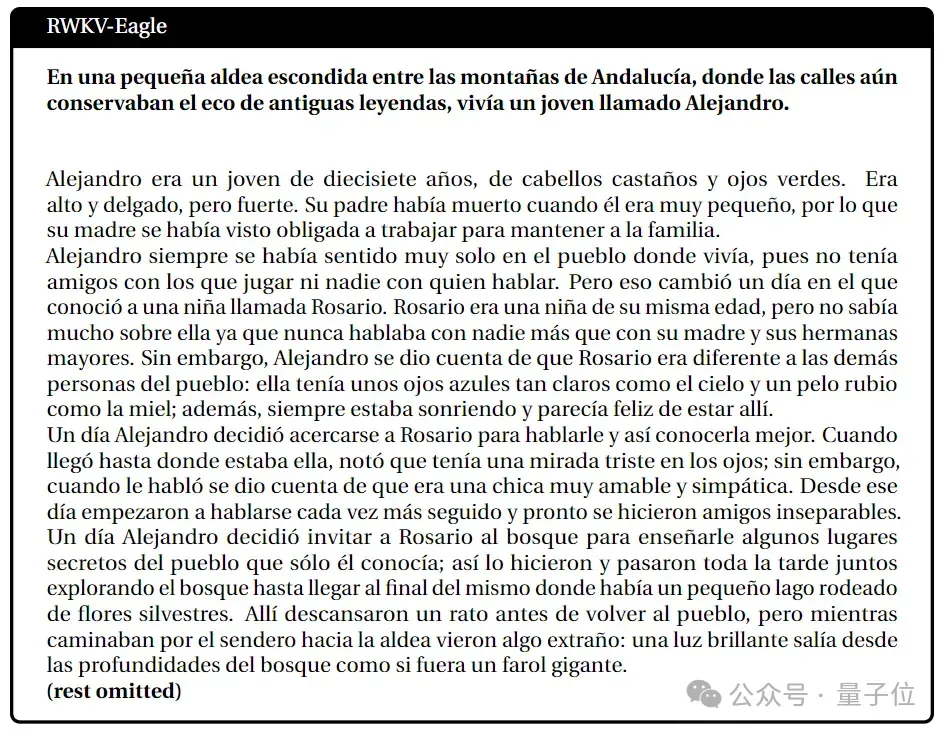

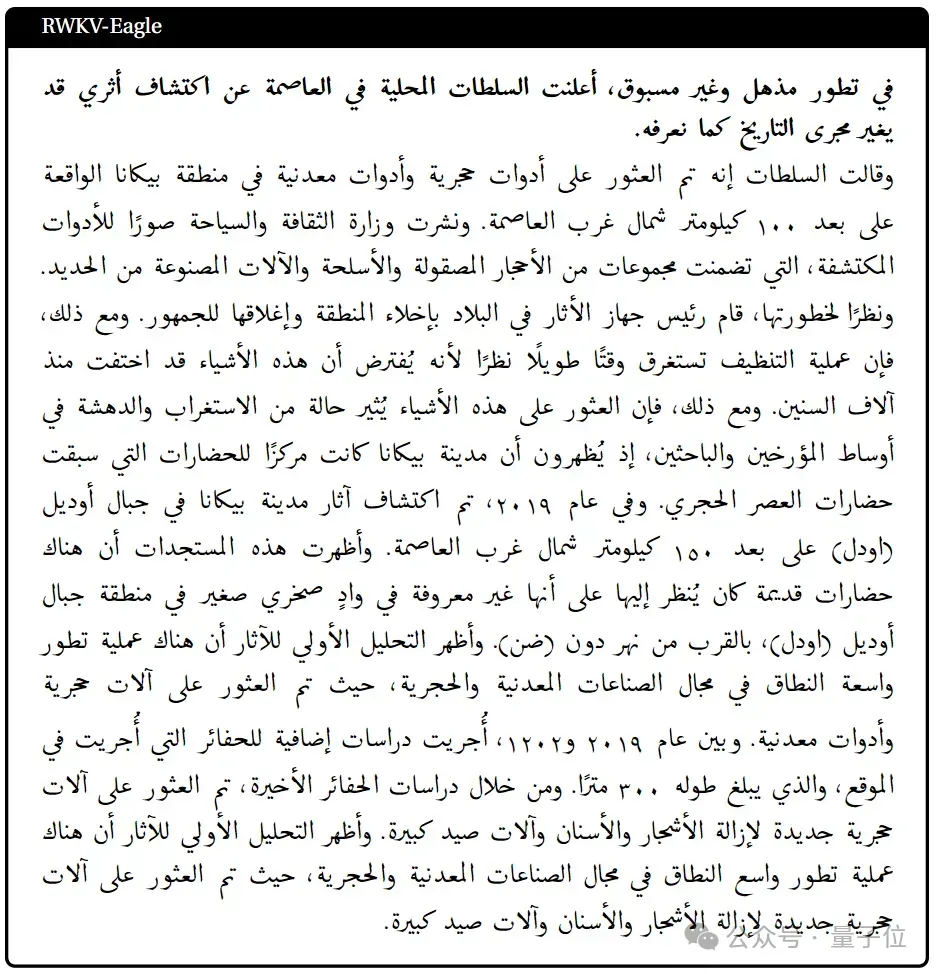

Dans le même temps, la nouvelle architecture introduit un nouveau corpus multilingue contenant 1,12 billion de jetons.

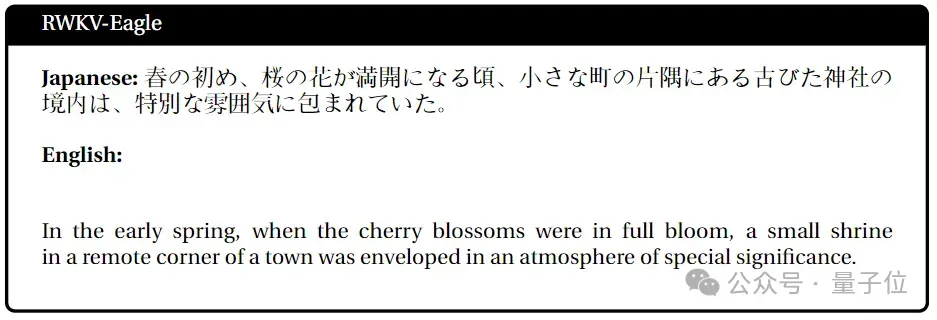

L'équipe a également développé un tokenizer rapide basé sur la correspondance gourmande pour améliorer le multilinguisme de RWKV.

Actuellement, 4 modèles Eagle et 2 modèles Finch ont été publiés sur Huo Hua Face~

4 Eagle (RWKV-5)Modèle : tailles de paramètres 0,4B, 1,5B, 3B, 7B respectivement ;

Eagle améliore l'architecture et la dégradation de l'apprentissage apprises du RWKV-4 en utilisant des états à valeurs matricielles multi-têtes (plutôt que des états à valeurs vectorielles)

Finch améliore encore les capacités de performances et la flexibilité de l'architecture en introduisant de

Finch améliore encore les capacités de performances et la flexibilité de l'architecture en introduisant de

nouvelles fonctions liées aux données pour les modules de mélange temporel et de décalage de jetons, y compris l'interpolation linéaire paramétrée. De plus, Finch propose une nouvelle utilisation de fonctions adaptatives de bas rang pour permettre aux matrices de poids entraînables d'augmenter efficacement les vecteurs de désintégration des données apprises de manière contextuelle.

Enfin, la nouvelle architecture RWKV introduit un nouveau tokenizer RWKV World Tokenizer et

un nouvel ensemble de données

RWKV World v2, tous deux utilisés pour améliorer le modèle RWKV sur les performances des données multi-langues et de code. . Le nouveau tokenizer RWKV World Tokenizer contient des mots de langues rares et effectue une tokenisation rapide grâce à une correspondance gourmande basée sur Trie (correspondance gourmande). Le nouvel ensemble de données RWKV World v2 est un nouvel ensemble de données de jetons multilingues 1,12T, extrait de diverses sources de données sélectionnées à la main et accessibles au public. Dans sa composition de données, environ 70 % sont des données en anglais, 15 % sont des données multilingues et 15 % sont des données codées.

Quels ont été les résultats du benchmark ? L'innovation architecturale à elle seule ne suffit pas, la clé réside dans la performance réelle du modèle.

Jetons un coup d'œil aux résultats du nouveau modèle sur les principales listes d'évaluation faisant autorité -

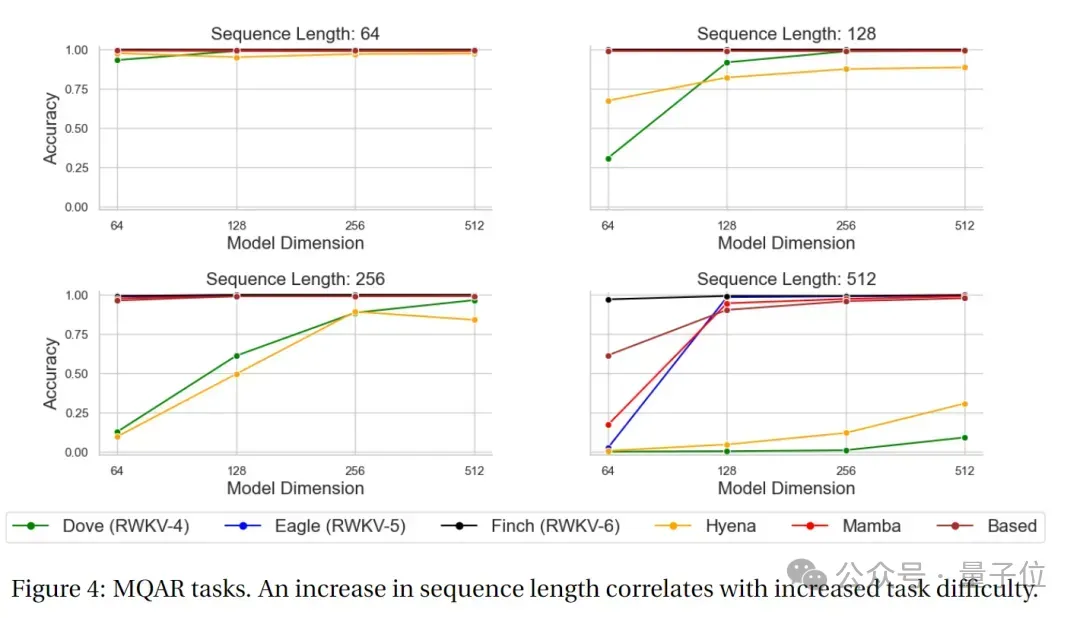

Résultats du test MQAR

MQAR

(Rappel associatif de requêtes multiples)Dans ce type de tâche, le modèle doit récupérer des informations pertinentes à partir de plusieurs requêtes. L'objectif de la tâche MQAR est de mesurer la capacité du modèle à récupérer des informations sous plusieurs requêtes, ainsi que son adaptabilité et sa précision à différentes requêtes. L'image ci-dessous montre les résultats des tests de tâches MQAR de RWKV-4, Eagle, Finch et d'autres architectures non Transformer.

On peut voir que dans le test de précision de la tâche MQAR, les performances de précision de Finch dans divers tests de longueur de séquence sont très stables par rapport au RWKV-4, au RWKV-5 et à d'autres modèles d'architecture non-Transformer, des performances significatives. avantages. Expérience en contexte longLa perte et la position de séquence de RWKV-4, Eagle et Finch à partir de 2048 jetons ont été testées sur l'ensemble de test PG19.

.

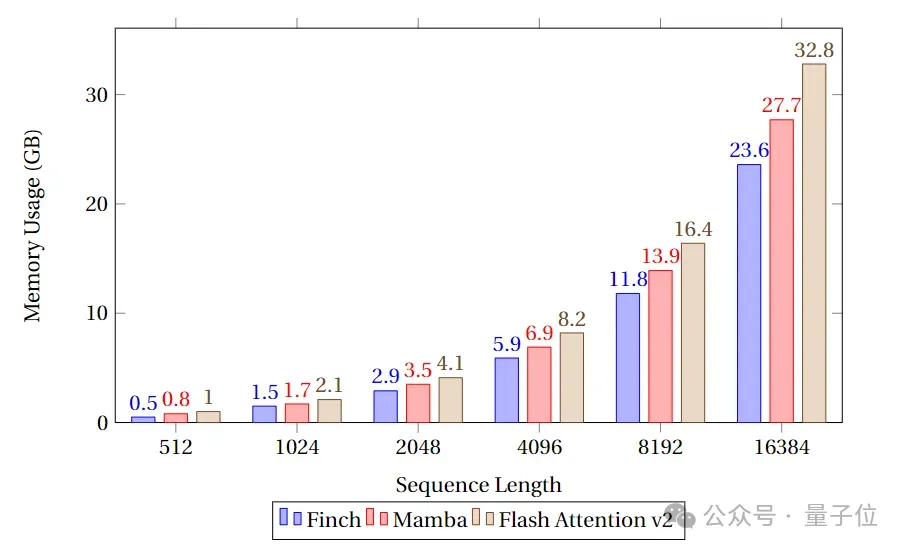

Les résultats des tests montrent qu'Eagle s'est considérablement amélioré par rapport au RWKV-4 sur les tâches à séquence longue, tandis que Finch, entraîné avec une longueur de contexte de 4096, est plus performant qu'Eagle et peut automatiquement bien s'adapter à plus de 20 000 longueurs de contexte. .Benchmarks de vitesse et de mémoire

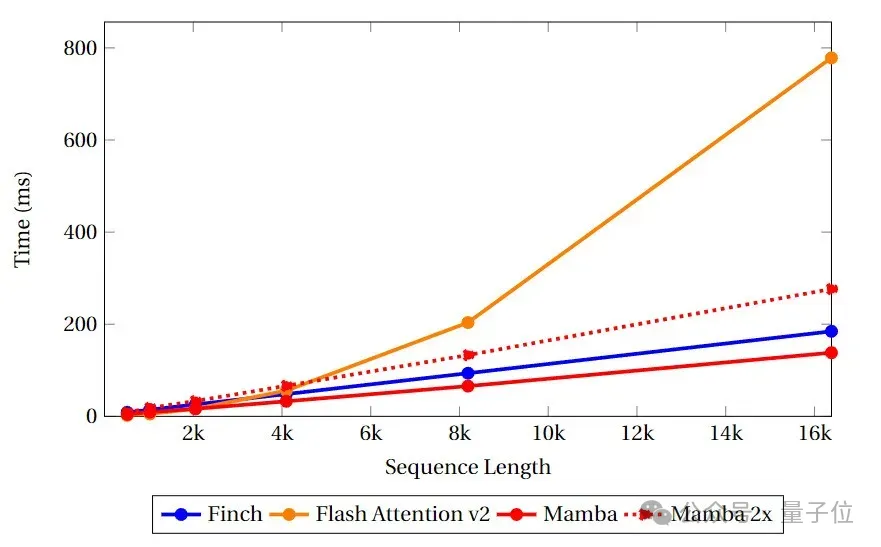

Dans les benchmarks de vitesse et de mémoire, l'équipe a comparé la vitesse et l'utilisation de la mémoire des noyaux de type Attention de Finch, Mamba et Flash Attention.

On peut voir que Finch est toujours meilleur que Mamba et Flash Attention en termes d'utilisation de la mémoire, et l'utilisation de la mémoire est respectivement 40 % et 17 % inférieure à Flash Attention et Mamba.

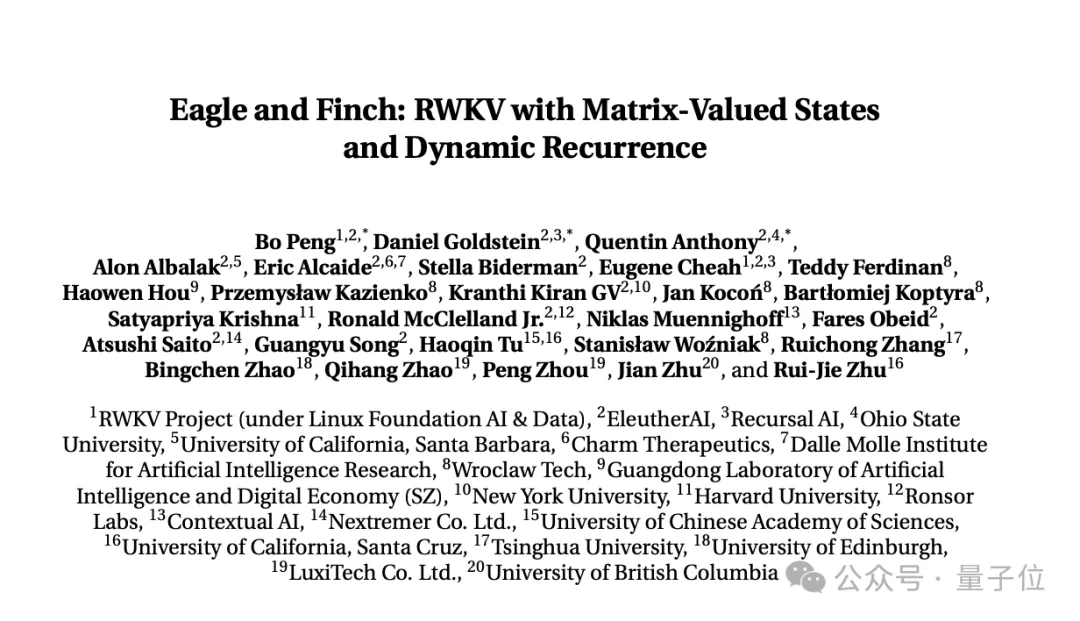

Contenu de la recherche ci-dessus, publié par la Fondation RWKV Le dernier article "Aigle et Finch : RWKV avec états à valeur matricielle et récurrence dynamique".

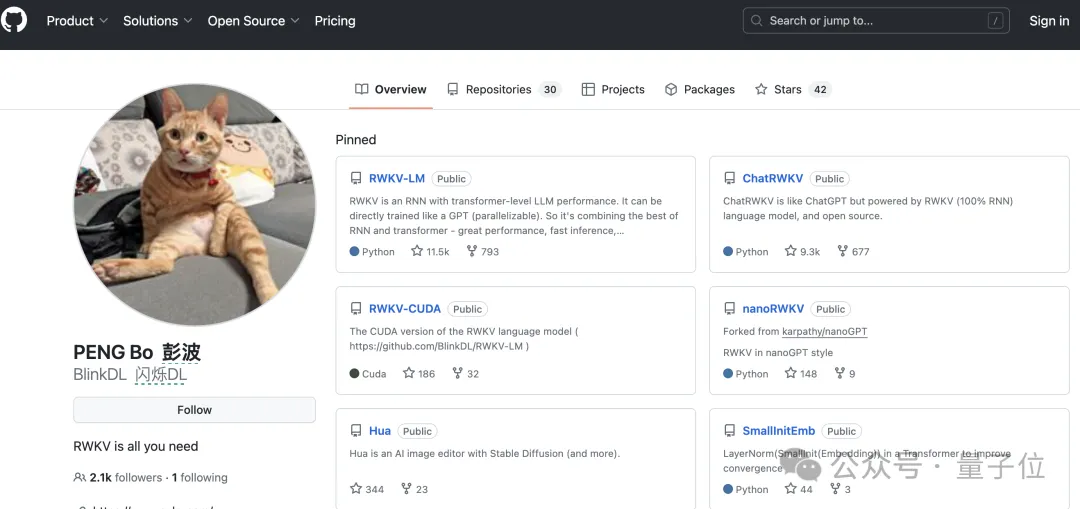

Le document a été rédigé conjointement par le fondateur de RWKV, Bo PENG (Bloomberg) et des membres de la communauté open source de RWKV.

Co-auteur de Bloomberg, diplômé du Université de Hong KongDépartement de physique, avec plus de 20 ans d'expérience en programmation. Il a déjà travaillé chez Ortus Capital, l'un des plus grands fonds spéculatifs de change au monde, et en était responsable. pour le trading quantitatif à haute fréquence.

A également publié un livre sur les réseaux convolutionnels profonds "Deep Convolutional Networks·Principes and Practice".

Son principal objectif et intérêt réside dans le développement de logiciels et de matériel informatique. Lors d'entretiens publics précédents, il a clairement indiqué que l'AIGC était son intérêt, en particulier la nouvelle génération.

Actuellement, Bloomberg compte 2,1k abonnés sur Github.

Mais son identité publique la plus importante est le co-fondateur d'une entreprise d'éclairage, Xinlin Technology, qui fabrique principalement des lampes solaires, des plafonniers, des lampes de bureau portables, etc.

Et il devrait être un amoureux des chats senior. Il y a un chat orange sur les avatars Github, Zhihu et WeChat, ainsi que sur la page d'accueil du site officiel de la société d'éclairage et sur Weibo.

Qubit a appris que le travail multimodal actuel de RWKV comprend RWKV Music (direction musicale) et VisualRWKV (direction de l'image) .

Ensuite, RWKV se concentrera sur les orientations suivantes :

https://arxiv.org/pdf/2404.05892.pdf

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Construisez votre propre serveur git

Construisez votre propre serveur git

La différence entre git et svn

La différence entre git et svn

git annuler le commit soumis

git annuler le commit soumis

Comment annuler l'erreur de commit git

Comment annuler l'erreur de commit git

Comment comparer le contenu des fichiers de deux versions dans git

Comment comparer le contenu des fichiers de deux versions dans git

Comment ouvrir le fichier HTML WeChat

Comment ouvrir le fichier HTML WeChat

À quel point Snapdragon 8gen2 est-il équivalent à Apple ?

À quel point Snapdragon 8gen2 est-il équivalent à Apple ?

et catalyseur

et catalyseur

Trois formes d'instructions conditionnelles

Trois formes d'instructions conditionnelles