Périphériques technologiques

Périphériques technologiques

IA

IA

L'OWASP publie une liste de contrôle de sécurité et de gouvernance du réseau avec un grand modèle de langage

L'OWASP publie une liste de contrôle de sécurité et de gouvernance du réseau avec un grand modèle de langage

L'OWASP publie une liste de contrôle de sécurité et de gouvernance du réseau avec un grand modèle de langage

Le plus grand risque auquel est actuellement confrontée la technologie de l'intelligence artificielle est que la vitesse de développement et d'application des grands modèles de langage (LLM) et de la technologie d'intelligence artificielle générative a largement dépassé la vitesse de la sécurité et de la gouvernance.

L'utilisation de produits d'IA générative et de grands modèles de langage d'entreprises comme OpenAI, Anthropic, Google et Microsoft connaît une croissance exponentielle. Dans le même temps, les solutions open source de grands modèles de langage connaissent également une croissance rapide. Les communautés d'intelligence artificielle open source telles que HuggingFace fournissent un grand nombre de modèles open source, d'ensembles de données et d'applications d'IA.

Afin de promouvoir le développement de l'intelligence artificielle, des organisations industrielles telles que l'OWASP, OpenSSF et CISA développent et fournissent activement des actifs clés pour la sécurité et la gouvernance de l'intelligence artificielle, tels que OWASP AI Exchange, AI Security and Privacy Guide et le Liste des dix principaux risques des grands modèles de langage ( LLMTop10).

Récemment, l'OWASP a publié une vaste liste de contrôle de modèle de langage pour la cybersécurité et la gouvernance, comblant les lacunes dans la gouvernance de la sécurité de l'intelligence artificielle générative. Le contenu spécifique est le suivant :

La définition de l'OWASP des types et des menaces d'IA

Le modèle de langage de l'OWASP pour la cybersécurité et la gouvernance. La liste de contrôle définit les différences entre l'intelligence artificielle, l'apprentissage automatique, l'IA générative et les grands modèles de langage.

Par exemple, la définition de l'IA générative de l'OWASP est la suivante : un type d'apprentissage automatique axé sur la création de nouvelles données, tandis que les grands modèles de langage sont un modèle d'IA utilisé pour traiter et générer du « contenu naturel » de type humain. - Ils font des prédictions basées sur l’entrée qui leur est fournie, et la sortie est un « contenu naturel » semblable à celui d’un être humain.

Concernant la « Liste des dix principales menaces du Big Language Model », l'OWASP estime qu'elle peut aider les praticiens de la cybersécurité à suivre le développement rapide de la technologie de l'IA, à identifier les menaces clés et à garantir que les entreprises disposent de contrôles de sécurité de base pour protéger et prendre en charge l'utilisation. métier de l’intelligence artificielle générative et des grands modèles de langage. L’OWASP estime cependant que cette liste n’est pas exhaustive et doit être continuellement améliorée en fonction du développement de l’intelligence artificielle générative.

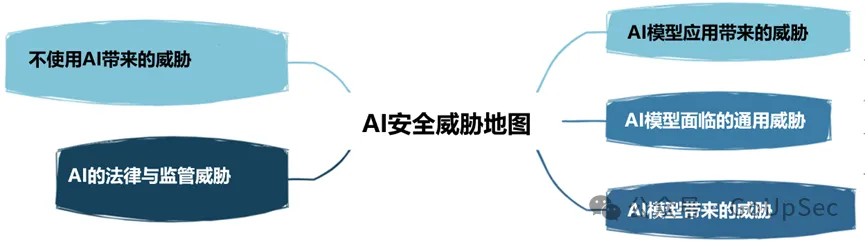

OWASP divise les menaces de sécurité de l'IA en cinq types suivants :

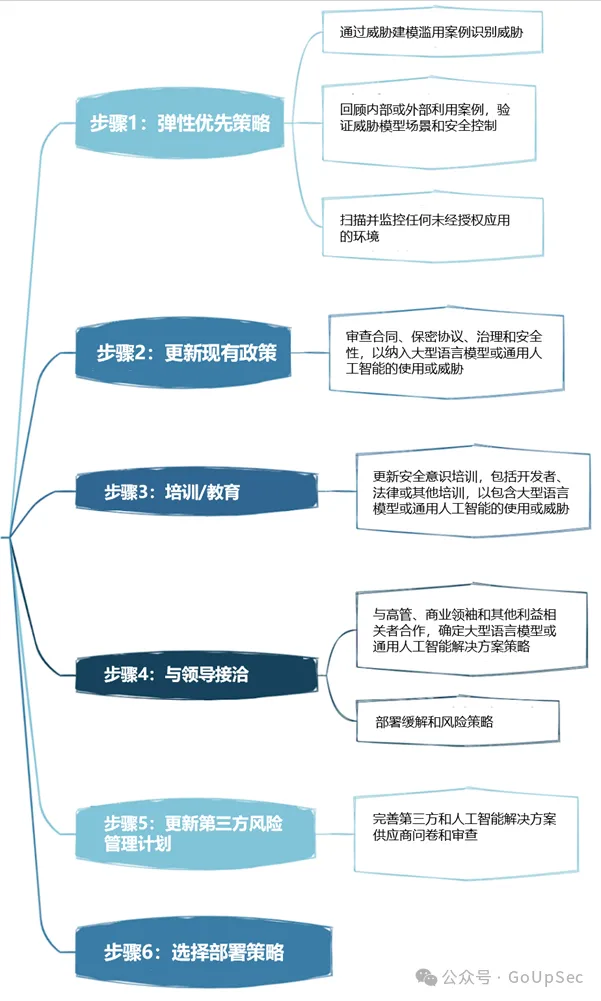

Le déploiement de la stratégie de gouvernance de la sécurité du grand modèle de langage de l'OWASP est divisé en six étapes :

Voici la liste de sécurité et de gouvernance du réseau du grand modèle de langage de l'OWASP. :

1. Risque d'adversaire

Le risque d'adversaire des grands modèles de langage implique non seulement les concurrents, mais également les attaquants. Il se concentre non seulement sur la posture d'attaque, mais aussi sur la posture de l'entreprise. Cela implique de comprendre comment les concurrents utilisent l'IA pour générer des résultats commerciaux, ainsi que de mettre à jour les processus et politiques internes, tels que les plans de réponse aux incidents (IRP), pour répondre aux attaques et incidents génératifs d'IA.

2. Modélisation des menaces

La modélisation des menaces est une technologie de sécurité de plus en plus populaire, qui attire de plus en plus d'attention avec la promotion du concept de systèmes de conception sécurisés, et a été approuvée par la Cybersecurity and Infrastructure Security Agency (CISA) des États-Unis et d'autres organisations faisant autorité. La modélisation des menaces nécessite de réfléchir à la manière dont les attaquants exploitent les grands modèles de langage et l'IA générative pour accélérer l'exploitation des vulnérabilités, à la capacité de l'entreprise à détecter les grands modèles de langage malveillants et à la question de savoir si les organisations peuvent protéger les grands modèles de langage et les plates-formes d'IA générative des systèmes et environnements internes.

3. Liste de contrôle des actifs d'intelligence artificielle

L'adage « Vous ne pouvez pas protéger un actif inconnu » s'applique également aux domaines de l'IA générative et des grands modèles de langage. Cette partie de l'inventaire OWASP implique l'inventaire des actifs d'IA pour les solutions d'IA développées en interne ainsi que pour les outils et plateformes externes.

OWASP souligne que les entreprises doivent non seulement comprendre quels outils et services sont utilisés en interne, mais également comprendre qui en est la propriété, c'est-à-dire qui est responsable de l'utilisation de ces outils et services. La liste de contrôle recommande également d'inclure les composants d'IA dans une nomenclature logicielle (SBOM) et de documenter les sources de données d'IA et leurs sensibilités respectives.

En plus d'inventorier les outils et services d'IA existants, les entreprises doivent également établir un processus sécurisé pour ajouter les futurs outils et services d'IA à l'inventaire.

4. Formation de sensibilisation à la sécurité et à la confidentialité de l'intelligence artificielle

On dit souvent que « les personnes constituent la plus grande vulnérabilité en matière de sécurité ». Les entreprises ne peuvent que raisonnablement intégrer la formation sur la sécurité et la confidentialité de l'intelligence artificielle dans le processus d'application de leur intelligence artificielle générative et de leur grand langage. modèles, peuvent considérablement atténuer les risques humains.

Cela implique d'aider les employés à comprendre les initiatives existantes en matière d'IA générative/de grands modèles de langage, les technologies et leurs capacités, ainsi que les principales considérations de sécurité telles que les violations de données. De plus, il est essentiel de bâtir une culture de sécurité fondée sur la confiance et la transparence.

Une culture de confiance et de transparence au sein de l'entreprise peut également aider à éviter les menaces de l'IA fantôme, sinon les employés utiliseront « secrètement » l'IA fantôme sans en informer les équipes informatiques et de sécurité.

5. Analyse de rentabilisation pour les projets d'intelligence artificielle

Tout comme le cloud computing, la plupart des entreprises n'ont pas réellement développé d'analyse de rentabilisation stratégique cohérente pour les nouvelles applications technologiques telles que l'intelligence artificielle générative et les grands modèles de langage, et il est facile de suivre aveuglément la tendance. . Laissez-vous emporter par le battage médiatique. Sans une analyse de rentabilisation solide, les applications d’IA d’entreprise sont susceptibles de produire de mauvais résultats et d’augmenter les risques.

6. Gouvernance

Sans gouvernance, les entreprises ne peuvent pas établir de mécanismes de responsabilisation et d'objectifs clairs pour l'intelligence artificielle. La liste de contrôle de l'OWASP recommande aux entreprises d'élaborer un tableau RACI (matrice d'attribution des responsabilités) pour les applications d'intelligence artificielle, d'enregistrer et d'attribuer les responsabilités en matière de risques et les tâches de gouvernance, et d'établir des politiques et procédures d'intelligence artificielle à l'échelle de l'entreprise.

7. Juridique

Avec le développement rapide de la technologie de l'intelligence artificielle, son impact juridique ne peut être sous-estimé et peut entraîner des risques financiers et de réputation importants pour les entreprises.

Les affaires juridiques de l'intelligence artificielle impliquent une série d'activités, telles que la garantie des produits d'intelligence artificielle, le contrat de licence d'utilisateur final (CLUF) d'intelligence artificielle, la propriété du code développé à l'aide d'outils d'intelligence artificielle, les risques de propriété intellectuelle et les clauses de compensation contractuelle, etc. En bref, assurez-vous que votre équipe juridique ou vos experts comprennent les différentes activités juridiques de soutien que votre entreprise doit entreprendre lorsqu'elle utilise l'IA générative et les grands modèles linguistiques.

8. Réglementation

Les réglementations réglementaires sur l'intelligence artificielle se développent également rapidement, comme la loi européenne sur l'intelligence artificielle, et des réglementations dans d'autres pays et régions seront bientôt introduites. Les entreprises doivent comprendre les exigences de conformité de leur pays en matière d’IA, telles que la surveillance des employés, et comprendre clairement comment leurs fournisseurs d’IA stockent et suppriment les données et réglementent leur utilisation.

9. Utiliser ou mettre en œuvre des solutions de modèles de langage à grande échelle

L'utilisation de solutions de modèles de langage à grande échelle nécessite la prise en compte de risques et de contrôles spécifiques. La liste de contrôle OWASP répertorie des éléments tels que le contrôle d'accès, la sécurité du pipeline de formation, la cartographie des flux de travail de données et la compréhension des vulnérabilités existantes ou potentielles dans les grands modèles de modèles de langage et les chaînes d'approvisionnement. De plus, des audits tiers, des tests d'intrusion et même des révisions de code des fournisseurs sont requis, tant au départ que de manière continue.

10. Test, évaluation, vérification et validation (TEVV)

Le processus TEVV est un processus spécifiquement recommandé par le NIST dans son cadre d'intelligence artificielle. Cela implique d'établir des tests, des évaluations, des validations et des validations continues tout au long du cycle de vie du modèle d'IA, ainsi que de fournir des mesures d'exécution sur la fonctionnalité, la sécurité et la fiabilité du modèle d'IA.

11. Cartes modèles et cartes de risque

Pour déployer de grands modèles de langage de manière éthique, la liste de contrôle de l'OWASP exige que les entreprises utilisent des cartes de modèles et de risques qui peuvent être utilisées pour permettre aux utilisateurs de comprendre et de faire confiance aux systèmes d'IA, et de lutter ouvertement contre les préjugés et la confidentialité. etc. conséquences négatives potentielles.

Ces cartes peuvent contenir des éléments tels que des détails sur le modèle, l'architecture, les méthodes de données d'entraînement et les mesures de performances. Les considérations en faveur d’une IA responsable et les préoccupations concernant l’équité et la transparence sont également mises en avant.

12RAG : Optimisation de grands modèles de langage

Retrieval Augmented Generation (RAG) est une méthode d'optimisation de la capacité des grands modèles de langage à récupérer des données pertinentes à partir de sources spécifiques. C'est l'un des moyens d'optimiser les modèles pré-entraînés ou de recycler les modèles existants en fonction de nouvelles données pour améliorer les performances. L'OWASP recommande aux entreprises de mettre en œuvre RAG pour maximiser la valeur et l'efficacité des grands modèles de langage.

13. AI Red Team

Enfin, la liste de contrôle OWASP souligne l'importance de l'AI Red Teaming, qui simule des attaques contradictoires sur les systèmes d'IA pour identifier les vulnérabilités et valider les contrôles et les défenses existants. L'OWASP souligne que les équipes rouges devraient faire partie intégrante d'une solution de sécurité complète dotée d'une IA générative et de grands modèles de langage.

Il convient de noter que les entreprises doivent également avoir une compréhension claire des services de l'équipe rouge, ainsi que des exigences et des capacités du système de l'IA générative externe et des grands fournisseurs de modèles de langage pour éviter de violer les politiques ou même d'avoir des problèmes juridiques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Guide étape par étape pour utiliser Groq Llama 3 70B localement

Jun 10, 2024 am 09:16 AM

Guide étape par étape pour utiliser Groq Llama 3 70B localement

Jun 10, 2024 am 09:16 AM

Traducteur | Bugatti Review | Chonglou Cet article décrit comment utiliser le moteur d'inférence GroqLPU pour générer des réponses ultra-rapides dans JanAI et VSCode. Tout le monde travaille à la création de meilleurs grands modèles de langage (LLM), tels que Groq, qui se concentre sur le côté infrastructure de l'IA. Une réponse rapide de ces grands modèles est essentielle pour garantir que ces grands modèles réagissent plus rapidement. Ce didacticiel présentera le moteur d'analyse GroqLPU et comment y accéder localement sur votre ordinateur portable à l'aide de l'API et de JanAI. Cet article l'intégrera également dans VSCode pour nous aider à générer du code, à refactoriser le code, à saisir la documentation et à générer des unités de test. Cet article créera gratuitement notre propre assistant de programmation d’intelligence artificielle. Introduction au moteur d'inférence GroqLPU Groq

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Pour en savoir plus sur l'AIGC, veuillez visiter : 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou est différent de la banque de questions traditionnelle que l'on peut voir partout sur Internet. nécessite de sortir des sentiers battus. Les grands modèles linguistiques (LLM) sont de plus en plus importants dans les domaines de la science des données, de l'intelligence artificielle générative (GenAI) et de l'intelligence artificielle. Ces algorithmes complexes améliorent les compétences humaines et stimulent l’efficacité et l’innovation dans de nombreux secteurs, devenant ainsi la clé permettant aux entreprises de rester compétitives. LLM a un large éventail d'applications. Il peut être utilisé dans des domaines tels que le traitement du langage naturel, la génération de texte, la reconnaissance vocale et les systèmes de recommandation. En apprenant de grandes quantités de données, LLM est capable de générer du texte

Déployer de grands modèles de langage localement dans OpenHarmony

Jun 07, 2024 am 10:02 AM

Déployer de grands modèles de langage localement dans OpenHarmony

Jun 07, 2024 am 10:02 AM

Cet article ouvrira en source les résultats du « Déploiement local de grands modèles de langage dans OpenHarmony » démontrés lors de la 2e conférence technologique OpenHarmony. Adresse : https://gitee.com/openharmony-sig/tpc_c_cplusplus/blob/master/thirdparty/. InferLLM/docs/hap_integrate.md. Les idées et les étapes de mise en œuvre consistent à transplanter le cadre d'inférence de modèle LLM léger InferLLM vers le système standard OpenHarmony et à compiler un produit binaire pouvant s'exécuter sur OpenHarmony. InferLLM est un L simple et efficace

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.