Périphériques technologiques

Périphériques technologiques

IA

IA

Le grand modèle de texte long méta illimité est ici : seulement 7B de paramètres, open source

Le grand modèle de texte long méta illimité est ici : seulement 7B de paramètres, open source

Le grand modèle de texte long méta illimité est ici : seulement 7B de paramètres, open source

Après Google, Meta vient aussi rouler des contextes infiniment longs.

La complexité quadratique et la faible extrapolation de longueur des Transformers limitent leur capacité à s'adapter à de longues séquences. Bien que des solutions quadratiques telles que les modèles d'attention linéaire et d'espace d'état existent, d'après l'expérience passée, elles fonctionnent mal en termes d'efficacité de pré-entraînement. et la précision des tâches en aval.

Récemment, Infini-Transformer proposé par Google a attiré l'attention des gens en introduisant une méthode efficace qui peut étendre les grands modèles de langage (LLM) basés sur Transformer à des entrées infiniment longues sans augmenter les besoins de stockage et de calcul.

Presque au même moment, Meta proposait également une technologie de texte infiniment long.

Adresse de l'article : https://arxiv.org/pdf/2404.08801.pdf

Titre de l'article : MEGALODON : Pré-entraînement et inférence LLM efficaces avec une longueur de contexte illimitée

Code : https:/ /github.com/XuezheMax/megalodon

Dans un article soumis le 12 avril, des institutions de Meta, de l'Université de Californie du Sud, de la CMU, de l'UCSD et d'autres institutions ont présenté MEGALODON, un réseau neuronal pour une modélisation efficace des séquences et de la longueur du contexte. n'est pas limité.

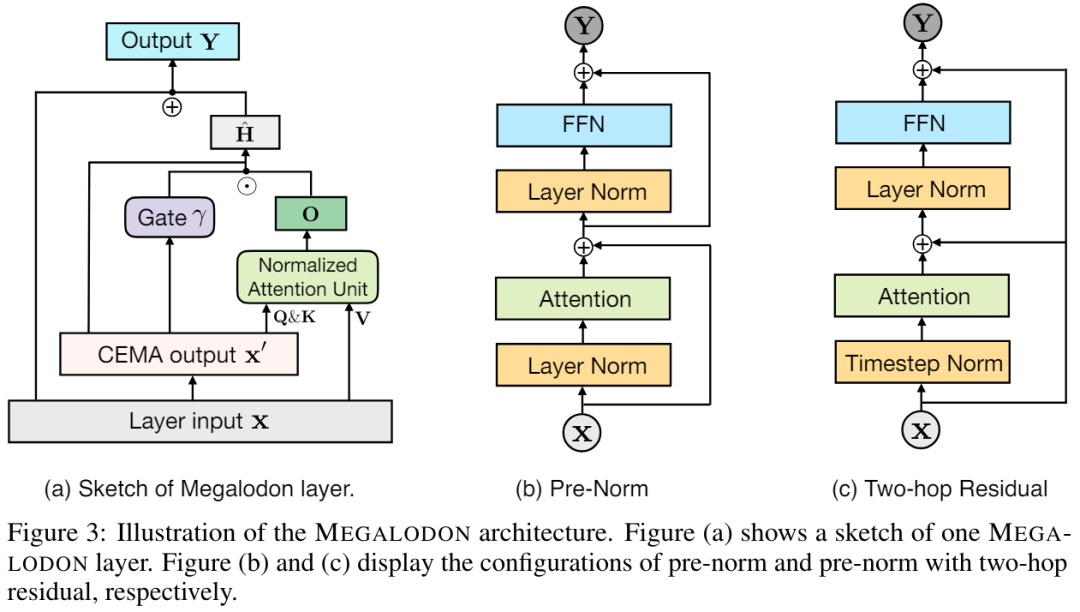

MEGALODON développe davantage la structure de MEGA (Exponential Moving Average with Gated Attention) et introduit une variété de composants techniques pour améliorer ses capacités et sa stabilité, notamment la moyenne mobile exponentielle complexe (CEMA), la couche de normalisation du pas de temps, le mécanisme d'attention normalisé et le pré -connexion résiduelle normalisée avec deux fonctionnalités.

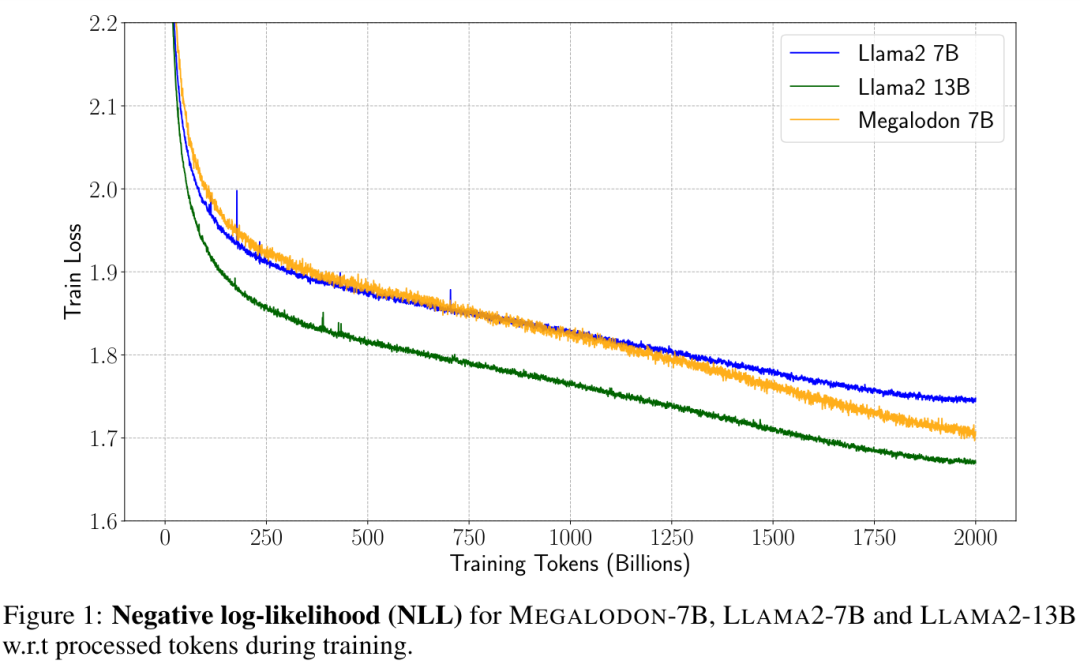

En comparaison directe avec LAMA2, MEGALODON atteint une meilleure efficacité que Transformer à une échelle de 7 milliards de paramètres et 2 000 milliards de jetons d'entraînement. La perte d'entraînement de MEGALODON atteint 1,70, soit entre LAMA2-7B (1,75) et 13B (1,67). Les améliorations de MEGALODON par rapport à Transformers montrent de solides performances sur une gamme de tests de performances et sur différentes tâches et modalités.

MEGALODON est essentiellement une architecture MEGA améliorée (Ma et al., 2023), qui utilise le mécanisme d'attention fermée et la méthode classique de moyenne mobile exponentielle (EMA). Afin d'améliorer encore les capacités et l'efficacité de MEGALODON dans le cadre d'une pré-formation à grande échelle en contexte long, les auteurs ont proposé une variété de composants techniques. Premièrement, MEGALODON introduit un composant de moyenne mobile exponentielle complexe (CEMA) qui étend l'EMA amortie multidimensionnelle dans MEGA au domaine complexe. Deuxièmement, MEGALODON propose une couche de normalisation par pas de temps, qui généralise les couches de normalisation de groupe aux tâches de modélisation de séquence autorégressive pour permettre la normalisation le long de la dimension séquentielle.

Afin d'améliorer la stabilité du pré-entraînement à grande échelle, MEGALODON propose en outre une attention normalisée, ainsi qu'une pré-normalisation avec une configuration résiduelle à deux sauts en modifiant les méthodes de pré-normalisation et de post-normalisation largement adoptées. En découpant simplement la séquence d'entrée en morceaux fixes, comme cela est fait dans MEGA-chunk, MEGALODON atteint une complexité de calcul et de mémoire linéaire dans la formation et l'inférence de modèles.

Dans une comparaison directe avec LAMA2, tout en contrôlant les données et les calculs, MEGALODON-7B surpasse considérablement la variante de pointe du Transformer utilisée pour entraîner LLAMA2-7B en termes de perplexité d'entraînement. Les évaluations sur la modélisation de contextes longs, y compris la perplexité dans diverses longueurs de contexte allant jusqu'à 2 M et les tâches d'assurance qualité à contexte long dans Scrolls, démontrent la capacité de MEGALODON à modéliser des séquences de longueur infinie. Des résultats expérimentaux supplémentaires sur des benchmarks de petite et moyenne taille, notamment LRA, ImageNet, Speech Commands, WikiText-103 et PG19, démontrent les capacités de MEGALODON en termes de volume et de multimodalité.

Introduction à la méthode

Tout d'abord, l'article passe brièvement en revue les composants clés de l'architecture MEGA (Moving Average Equipé Gated Attention) et aborde les problèmes existant dans MEGA.

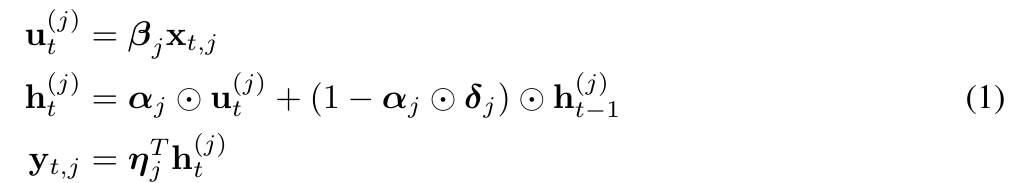

MEGA intègre un composant EMA (moyenne mobile exponentielle) dans le calcul de la matrice d'attention pour intégrer un biais inductif sur toutes les dimensions du pas de temps. Plus précisément, l'EMA amorti multidimensionnel élargit d'abord chaque dimension de la séquence d'entrée. La forme est la suivante :

Techniquement parlant, la sous-couche EMA de MEGA permet de capturer des informations contextuelles locales à proximité de chaque jeton, atténuant ainsi le problème de perte d'informations dans le contexte au-delà des limites des blocs. Bien que MEGA obtienne des résultats impressionnants, il est confronté aux problèmes suivants :

i) En raison de la puissance d'expression limitée de la sous-couche EMA dans MEGA, les performances de MEGA avec une attention au niveau du bloc sont toujours en retard par rapport à celles de MEGA à pleine attention.

ii) Pour différentes tâches et types de données, il peut y avoir des différences architecturales dans l'architecture MEGA finale, telles que différentes couches de normalisation, modes de normalisation et fonctions d'attention f (・).

iii) Il n'existe aucune preuve empirique que MEGA s'adapte à la pré-formation à grande échelle.

CEMA : Extension de l'amortissement multidimensionnel EMA au domaine complexe

Pour résoudre les problèmes rencontrés par MEGA, cette recherche propose MEGALODON.

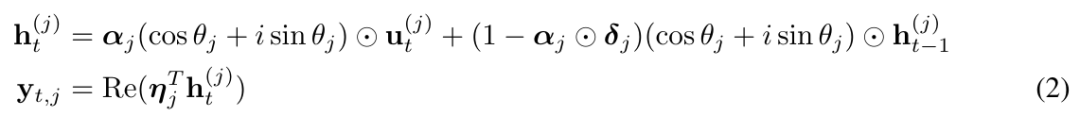

Plus précisément, ils ont proposé de manière créative la moyenne mobile exponentielle complexe CEMA (moyenne mobile exponentielle complexe), en réécrivant l'équation ci-dessus (1) sous la forme suivante :

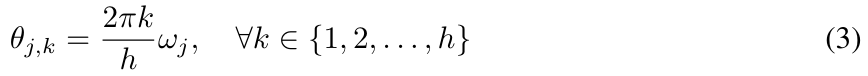

et en paramétrant θ_j dans (2) comme :

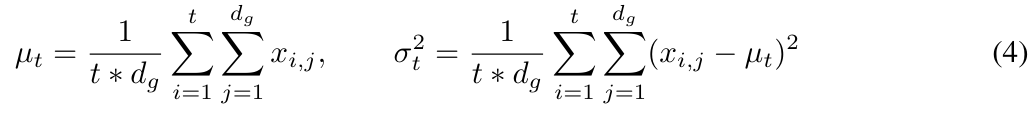

Normalisation du pas de temps

Bien que les performances de la normalisation des couches combinées avec Transformer soient impressionnantes, il est évident que la normalisation des couches ne peut pas réduire directement le long de la dimension spatiale (le décalage de covariable interne est également appelé pas de temps ou dimension de séquence).

Dans MEGALODON, cette étude étend la normalisation de groupe au cas autorégressif en calculant la moyenne et la variance cumulées.

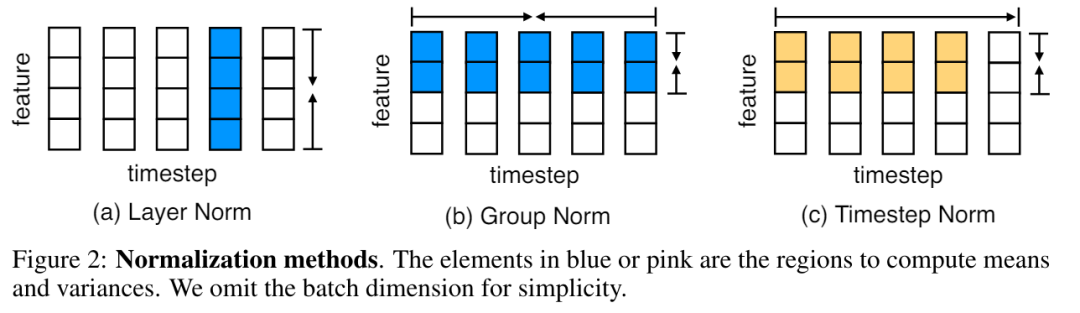

La figure 2 illustre la normalisation des couches et la normalisation des pas de temps.

Attention normalisée chez MEGALODON

De plus, la recherche propose également un mécanisme d'attention normalisé spécifiquement personnalisé pour MEGA afin d'améliorer sa stabilité. La forme est la suivante :

Ensuite, l'opération d'attention dans l'équation (17) ci-dessus est modifiée en :

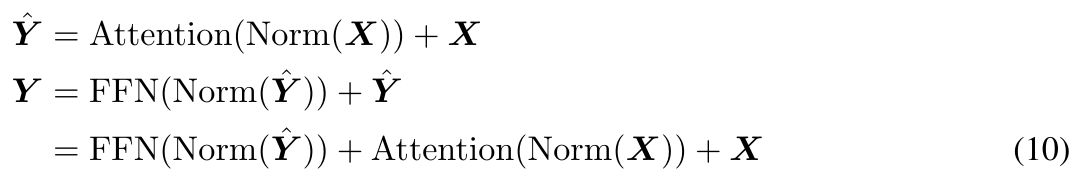

Pré-norme avec résidu à deux sauts

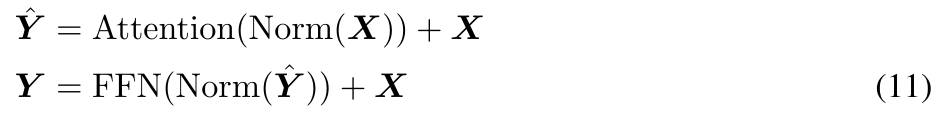

L'enquête révèle que, L'augmentation de la taille du modèle peut entraîner une instabilité de prénormalisation. La pré-normalisation basée sur le bloc Transformer peut être exprimée comme suit (illustré sur la figure 3 (b)) :

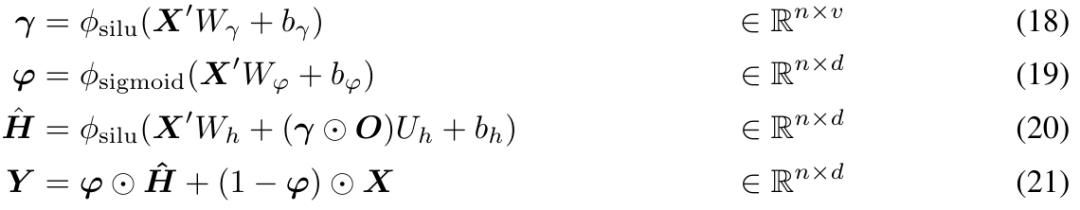

Dans l'architecture MEGA originale, φ (19) est utilisé pour la connexion résiduelle fermée (21 ) pour atténuer ce problème. Cependant, la porte de mise à jour φ introduit davantage de paramètres de modèle et le problème d'instabilité persiste lorsque la taille du modèle est étendue à 7 milliards. MEGALODON introduit une nouvelle configuration appelée pré-norme avec des résidus à deux sauts, qui réorganise simplement les connexions résiduelles dans chaque bloc, comme le montre la figure 3(c) :

Expériences

Afin de Évaluant l'évolutivité et l'efficacité de MEGALODON dans la modélisation de séquences à contexte long, cet article étend MEGALODON à une échelle de 7 milliards.

Pré-formation LLM

Afin d'améliorer l'efficacité des données, les chercheurs ont montré la vraisemblance log négative (NLL) de MEGALODON-7B, LAMA2-7B et LAMA2-13B pendant le processus de formation, comme le montre la figure 1.

Avec le même nombre de jetons d'entraînement, MEGALODON-7B a obtenu un NLL nettement meilleur (inférieur) que LLAMA2-7B, montrant une meilleure efficacité des données.

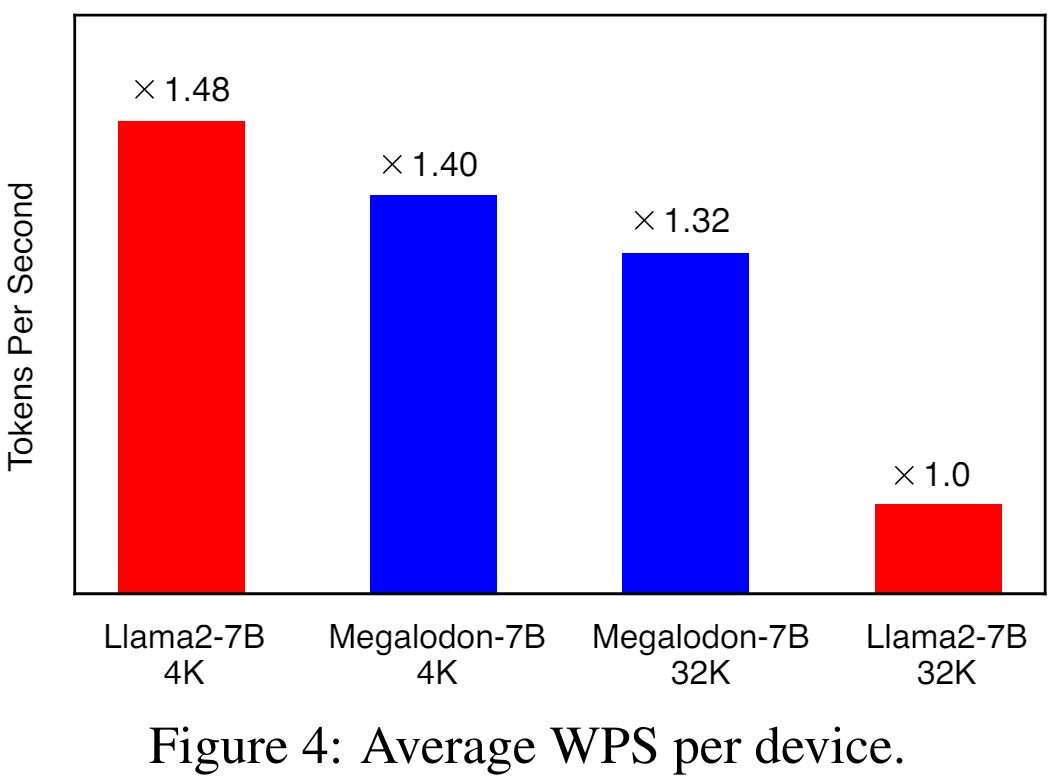

La figure 4 illustre le WPS moyen (mot/jeton par seconde) par appareil pour LAMA2-7B et MEGALODON-7B en utilisant respectivement des longueurs de contexte de 4K et 32K. Pour le modèle LLAMA2, l'étude utilise Flash-Attention V2 pour accélérer le calcul de la pleine attention. Avec une longueur de contexte 4K, MEGALODON-7B est légèrement plus lent (~ 6 %) que LLAMA2-7B en raison de l'introduction du CEMA et de la normalisation du pas de temps. En étendant la longueur du contexte à 32 Ko, MEGALODON-7B est nettement plus rapide que LAMA2-7B (environ 32 %), ce qui démontre l'efficacité informatique de MEGALODON pour le pré-entraînement à long contexte.

Évaluation contextuelle courte

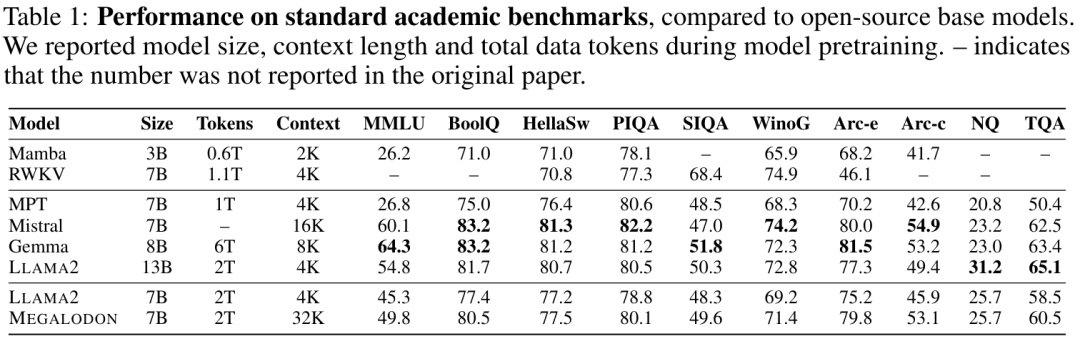

Le tableau 1 résume les résultats de MEGALODON et LLAMA2 sur des critères académiques, ainsi que les résultats de comparaison d'autres modèles de base open source, notamment MPT, RWKV, Mamba, Mistral et Gemma. Après un pré-entraînement sur les mêmes jetons 2T, MEGALODON-7B surpasse LLAMA2-7B sur tous les benchmarks. Sur certaines tâches, les performances de MEGALODON-7B sont comparables, voire meilleures, à celles de LAMA2-13B.

Évaluation du contexte long

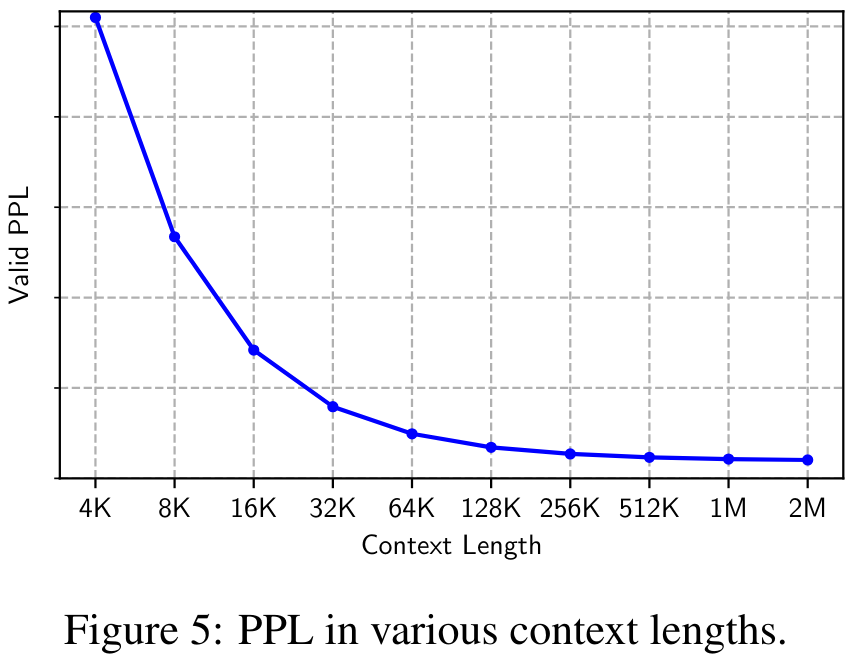

La figure 5 montre la perplexité (PPL) de l'ensemble de données de validation sous différentes longueurs de contexte allant de 4K à 2M. On peut observer que le PPL diminue de façon monotone avec la longueur du contexte, validant l'efficacité et la robustesse de MEGALODON dans la modélisation de séquences extrêmement longues.

Réglage fin des instructions

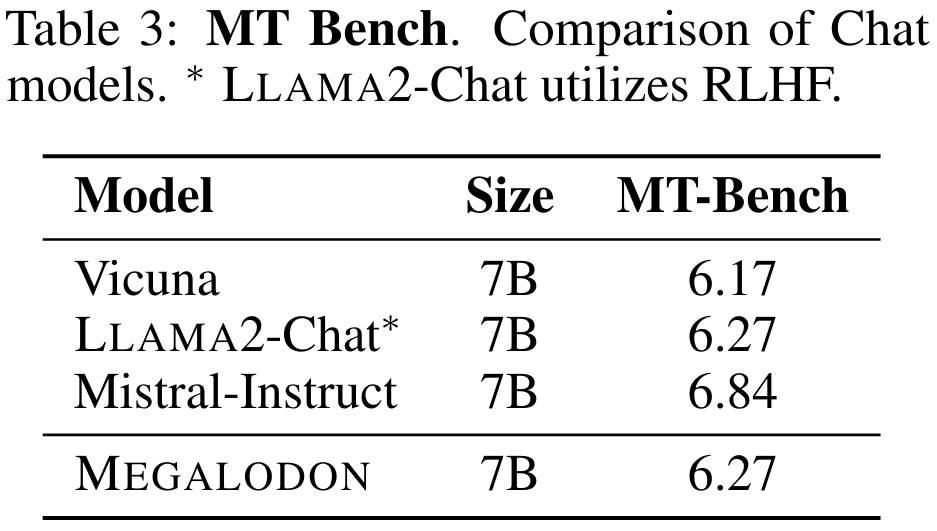

Le tableau 3 résume les performances du modèle 7B sur MT-Bench. MEGALODON présente des performances supérieures sur MT-Bench par rapport à Vicuna et est comparable à LLAMA2-Chat, qui utilise RLHF pour un réglage plus précis de l'alignement.

Évaluation de référence à moyenne échelle

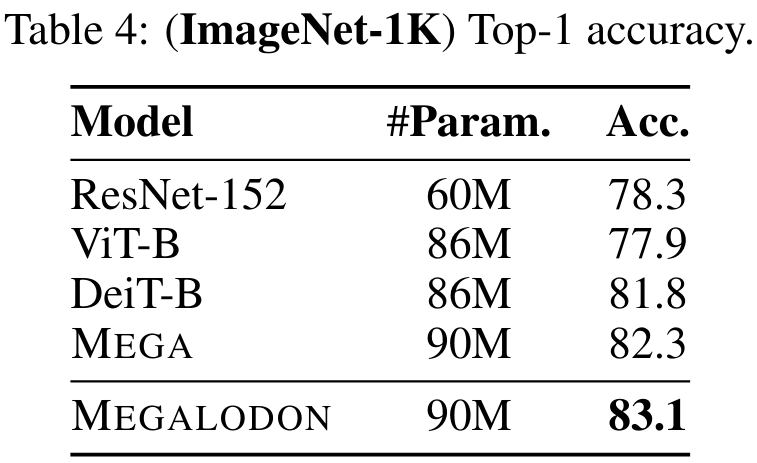

Pour évaluer les performances de MEGALODON sur les tâches de classification d'images, l'étude a mené des expériences sur l'ensemble de données Imagenet-1K. Le tableau 4 indique la précision Top-1 sur l'ensemble de validation. La précision de MEGALODON est 1,3 % supérieure à celle de DeiT-B et 0,8 % supérieure à celle de MEGA.

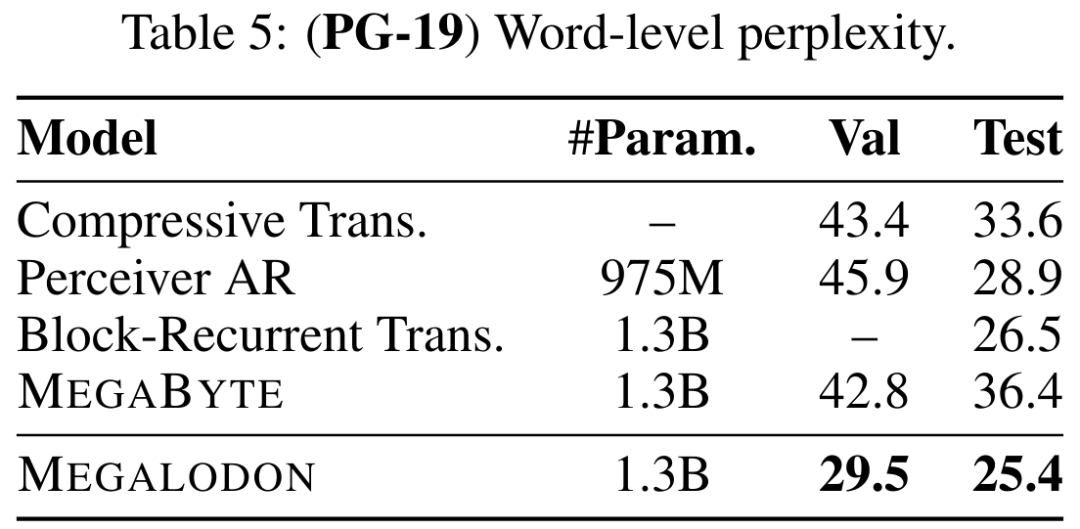

Le Tableau 5 illustre la perplexité au niveau des mots (PPL) de MEGALODON sur PG-19 et la comparaison avec les modèles de pointe précédents, notamment Compressive Transformer, Perceiver AR, Perceiver AR, Block Loop Transformer. et MÉGABYTE, etc. Les performances de MEGALODON sont clairement en avance.

Veuillez vous référer au document original pour plus de détails.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1359

1359

52

52

Quelles bibliothèques de GO sont développées par de grandes entreprises ou fournies par des projets open source bien connus?

Apr 02, 2025 pm 04:12 PM

Quelles bibliothèques de GO sont développées par de grandes entreprises ou fournies par des projets open source bien connus?

Apr 02, 2025 pm 04:12 PM

Quelles bibliothèques de GO sont développées par de grandes entreprises ou des projets open source bien connus? Lors de la programmation en Go, les développeurs rencontrent souvent des besoins communs, ...

Gitee Pages STATIQUE Le déploiement du site Web a échoué: comment dépanner et résoudre les erreurs de fichier unique 404?

Apr 04, 2025 pm 11:54 PM

Gitee Pages STATIQUE Le déploiement du site Web a échoué: comment dépanner et résoudre les erreurs de fichier unique 404?

Apr 04, 2025 pm 11:54 PM

GiteEpages STATIQUE Le déploiement du site Web a échoué: 404 Dépannage des erreurs et résolution lors de l'utilisation de Gitee ...

Comment calculer C-SUBScript 3 Indice 5 C-SUBScript 3 Indice Indice 5 Tutoriel d'algorithme

Apr 03, 2025 pm 10:33 PM

Comment calculer C-SUBScript 3 Indice 5 C-SUBScript 3 Indice Indice 5 Tutoriel d'algorithme

Apr 03, 2025 pm 10:33 PM

Le calcul de C35 est essentiellement des mathématiques combinatoires, représentant le nombre de combinaisons sélectionnées parmi 3 des 5 éléments. La formule de calcul est C53 = 5! / (3! * 2!), Qui peut être directement calculé par des boucles pour améliorer l'efficacité et éviter le débordement. De plus, la compréhension de la nature des combinaisons et la maîtrise des méthodes de calcul efficaces est cruciale pour résoudre de nombreux problèmes dans les domaines des statistiques de probabilité, de la cryptographie, de la conception d'algorithmes, etc.

Comment résoudre le problème de conversion de type user_id lors de l'utilisation du flux redis pour implémenter les files d'attente de messages dans le langage Go?

Apr 02, 2025 pm 04:54 PM

Comment résoudre le problème de conversion de type user_id lors de l'utilisation du flux redis pour implémenter les files d'attente de messages dans le langage Go?

Apr 02, 2025 pm 04:54 PM

Le problème de l'utilisation de Redessstream pour implémenter les files d'attente de messages dans le langage GO consiste à utiliser le langage GO et redis ...

Comment implémenter la disposition adaptative de la position de l'axe y dans l'annotation Web?

Apr 04, 2025 pm 11:30 PM

Comment implémenter la disposition adaptative de la position de l'axe y dans l'annotation Web?

Apr 04, 2025 pm 11:30 PM

L'algorithme adaptatif de la position de l'axe y pour la fonction d'annotation Web Cet article explorera comment implémenter des fonctions d'annotation similaires aux documents de mots, en particulier comment gérer l'intervalle entre les annotations ...

Comment convertir XML en Excel

Apr 03, 2025 am 08:54 AM

Comment convertir XML en Excel

Apr 03, 2025 am 08:54 AM

Il existe deux façons de convertir XML en Excel: utilisez des fonctionnalités Excel intégrées ou des outils tiers. Les outils tiers incluent XML pour Excel Converter, XML2Excel et XML Candy.

Fonction de fonction distincte Distance de distance C Tutoriel d'utilisation

Apr 03, 2025 pm 10:27 PM

Fonction de fonction distincte Distance de distance C Tutoriel d'utilisation

Apr 03, 2025 pm 10:27 PM

STD :: Unique supprime les éléments en double adjacents dans le conteneur et les déplace jusqu'à la fin, renvoyant un itérateur pointant vers le premier élément en double. STD :: Distance calcule la distance entre deux itérateurs, c'est-à-dire le nombre d'éléments auxquels ils pointent. Ces deux fonctions sont utiles pour optimiser le code et améliorer l'efficacité, mais il y a aussi quelques pièges à prêter attention, tels que: std :: unique traite uniquement des éléments en double adjacents. STD :: La distance est moins efficace lorsqu'il s'agit de transacteurs d'accès non aléatoires. En maîtrisant ces fonctionnalités et les meilleures pratiques, vous pouvez utiliser pleinement la puissance de ces deux fonctions.

Comment faire en sorte que la hauteur des colonnes adjacentes dans l'interface utilisateur de l'élément s'adapte automatiquement au contenu?

Apr 05, 2025 am 06:12 AM

Comment faire en sorte que la hauteur des colonnes adjacentes dans l'interface utilisateur de l'élément s'adapte automatiquement au contenu?

Apr 05, 2025 am 06:12 AM

Comment faire en sorte que la hauteur des colonnes adjacentes de la même ligne s'adapte automatiquement au contenu? Dans la conception Web, nous rencontrons souvent ce problème: quand il y en a beaucoup dans une table ou une ligne ...