Périphériques technologiques

Périphériques technologiques

IA

IA

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Lama 3 est là !

Tout à l'heure, le site officiel de Meta a été mis à jour et a officiellement annoncé les versions de Llama 3 à 8 milliards et 70 milliards de paramètres.

Et le lancement est open source SOTA :

Les données officielles de Meta montrent que les versions Llama 3 8B et 70B surpassent tous les adversaires dans leurs échelles de paramètres respectives. Le modèle

8B surpasse Gemma 7B et Mistral 7B Instruct sur de nombreux benchmarks tels que MMLU, GPQA, HumanEval, etc.

Le modèle 70B a surpassé le populaire Claude 3 Sonnet à source fermée et a fait des allers-retours avec le Gemini Pro 1.5 de Google.

Dès que le lien Huggingface est sorti, la communauté open source est redevenue enthousiasmée.

Les étudiants aveugles aux yeux perçants ont également découvert immédiatement le point beauté :

Meta a même caché une version de Llama 3 avec 400 milliards de paramètres +, ce qui n'est pas pire que le super grand Opus Claude 3 !

Le PDG d'HyperWriteAI, une startup d'assistant d'écriture d'IA, n'a pas pu s'empêcher de soupirer en voyant ceci :

Nous entrons dans un nouveau monde, un monde où les modèles de niveau GPT-4 sont open source et librement accessible.

Jim Fan, scientifique chez NVIDIA, estime que Llama 3 400B, qui est encore en formation, deviendra un tournant pour les grands modèles open source et changera la façon dont de nombreuses recherches universitaires et start-ups se développent.

SOTA complet, mais fenêtre 8k

Plus de détails techniques, donne Meta dans le billet de blog.

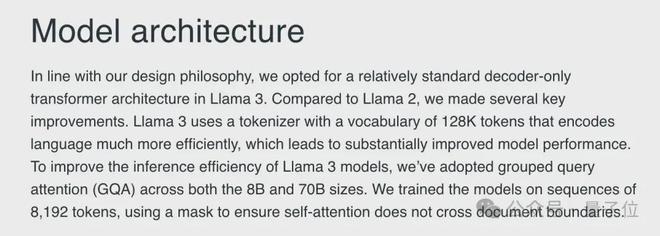

Au niveau architectural, Llama 3 a choisi l'architecture classique Transformer uniquement avec décodeur, en utilisant un segmenteur de mots contenant un vocabulaire de 128 Ko de jetons.

En regardant les données de formation, l'échelle des données de formation de Llama 3 a atteint 15T de jetons, qui proviennent tous d'informations publiques, dont 5 % sont des données non anglaises, couvrant plus de 30 langues.

Llama 3 contient 7 fois plus de données d'entraînement que Llama 2 et contient 4 fois plus de code que Llama 2.

De plus, afin d'améliorer l'efficacité du raisonnement du modèle Llama 3, Meta AI adopte également le mécanisme Group Query Attention (GQA) pour entraîner le modèle sur une séquence de 8192 jetons, et utilise un masque pour garantir que l’attention ne dépasse pas les limites du document.

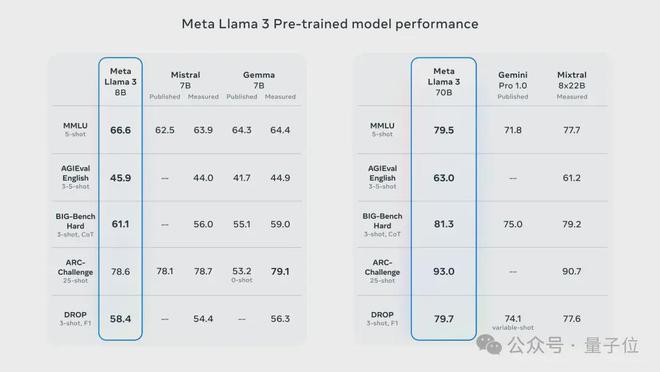

De ce fait, qu'il s'agisse de la version 8B ou 70B, Llama 3 a fait un grand pas en avant par rapport à la génération précédente Llama 2 de taille similaire.

Parmi les modèles réduits de paramètres 8B et 70B jusqu'à présent, Llama 3 est devenu le nouveau modèle SOTA.

En termes de langage (MMLU), de connaissances (GPQA), de programmation (HumanEval), de mathématiques (GSM-8K, MATH) et d'autres capacités, Llama 3 est presque complètement en avance sur les autres modèles de même échelle.

En plus de ces ensembles de données réguliers, Meta AI a également évalué les performances de Llama 3 dans des scénarios réels et a développé un ensemble d'ensembles de données de test de haute qualité à cet effet.

Cet ensemble de tests contient 1 800 éléments de données, couvrant 12 cas d'utilisation clés tels que le codage, le raisonnement, l'écriture et le résumé, et est confidentiel pour l'équipe de développement.

En conséquence, Llama 3 a non seulement dépassé de manière significative Llama 2, mais a également vaincu des modèles bien connus tels que Claude 3 Sonnet, Mistral Medium et GPT-3.5.

Sur des ensembles de données d'ordre supérieur et plus difficiles tels que AGIEval, BIG-Bench et ARC-Challenge, les performances de Llama 3 sont également remarquables.

La version 8B a surpassé Mistral et Gemma dans ces tâches, tandis que la version 70B a battu Gemini Pro et Mixtral avec l'architecture MoE, remportant respectivement des SOTA de tailles correspondantes.

Cependant, le seul inconvénient est que la fenêtre contextuelle de Llama 3 n'est que de 8k Par rapport aux grands modèles actuels avec des dizaines ou des millions de fenêtres, elle semble toujours bloquée dans la génération précédente (tête de chien manuelle). .

Mais ne vous inquiétez pas trop. Matt Shumer est optimiste à ce sujet. Il a exprimé sa conviction qu'avec les efforts de la communauté open source, la longueur de la fenêtre sera bientôt étendue.

Llama accueille la version Web officielle

Actuellement, les versions de base et Instruct des deux paramètres de Llama 3 sont disponibles en téléchargement sur Hugging Face.

De plus, les plateformes de services cloud telles que Microsoft Azure, Google Cloud, Amazon AWS et NVIDIA NIM lanceront également Llama 3 l'une après l'autre.

Dans le même temps, Meta a également déclaré que Llama 3 sera pris en charge par les plates-formes matérielles fournies par Intel, NVIDIA, AMD, Qualcomm et d'autres fabricants.

Il convient de mentionner que, publiée cette fois avec le modèle de base, il existe également une version Web officielle basée sur Llama 3, appelée Meta AI.

Actuellement, la plateforme a deux fonctions principales : le dialogue et la peinture. Si vous utilisez uniquement le dialogue, vous n'avez pas besoin de vous inscrire et de vous connecter, et elle peut être utilisée immédiatement. vous devez d'abord vous connecter à votre compte.

Cependant, la plateforme ne prend actuellement pas en charge le chinois et des fonctions telles que le téléchargement de texte n'ont pas encore été lancées.

En termes de code, la plateforme peut également exécuter des programmes Python simples, mais il semble qu'elle ne puisse produire que du texte et les tâches impliquant le dessin ne peuvent pas être exécutées.

De manière générale, cette version web est encore relativement rudimentaire, mais autant s'attendre à une vague de mises à jour ultérieures.

One More Thing

Un petit incident est qu'en effet, quelques heures avant l'annonce officielle de Meta, le marché Azure de Microsoft avait déjà volé l'actualité de la version Llama 3 8B Instruct.

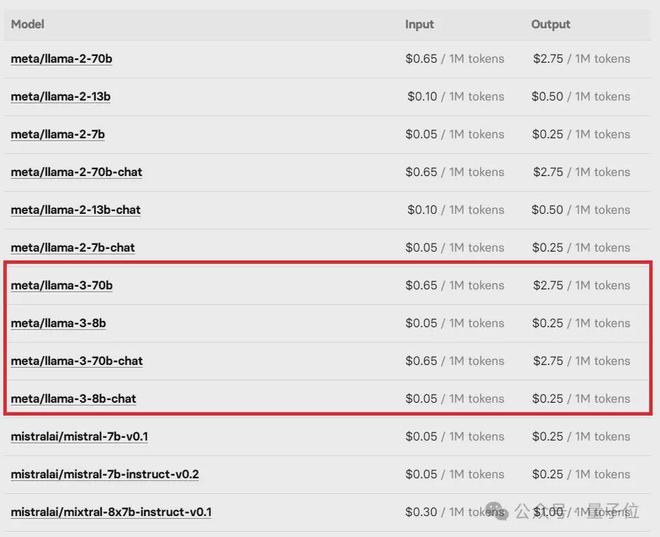

La liste de prix Llama 3 sur la plateforme en ligne d'apprentissage automatique de modèles open source Replicate a également été immédiatement retirée par les internautes.

Mais bientôt, ces « bavardages » furent tous 404.

Heureusement, l'erreur est terminée et le responsable ne la retarde pas. Les amis qui se soucient des grands modèles open source peuvent commencer à se tromper.

参考链接:

[1]https://ai.meta.com/blog/meta-llama-3/。

[2]https://about.fb.com/news/2024 /04/meta-ai-assistant-built-with-llama-3/。

[3]https://huggingface.co/meta-llama/Meta-Llama-3-70B。

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

PHP et Python: comparaison de deux langages de programmation populaires

Apr 14, 2025 am 12:13 AM

PHP et Python: comparaison de deux langages de programmation populaires

Apr 14, 2025 am 12:13 AM

PHP et Python ont chacun leurs propres avantages et choisissent en fonction des exigences du projet. 1.Php convient au développement Web, en particulier pour le développement rapide et la maintenance des sites Web. 2. Python convient à la science des données, à l'apprentissage automatique et à l'intelligence artificielle, avec syntaxe concise et adaptée aux débutants.

Python: jeux, GUIS, et plus

Apr 13, 2025 am 12:14 AM

Python: jeux, GUIS, et plus

Apr 13, 2025 am 12:14 AM

Python excelle dans les jeux et le développement de l'interface graphique. 1) Le développement de jeux utilise Pygame, fournissant des fonctions de dessin, audio et d'autres fonctions, qui conviennent à la création de jeux 2D. 2) Le développement de l'interface graphique peut choisir Tkinter ou Pyqt. Tkinter est simple et facile à utiliser, PYQT a des fonctions riches et convient au développement professionnel.

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

La fonction ReadDir dans le système Debian est un appel système utilisé pour lire le contenu des répertoires et est souvent utilisé dans la programmation C. Cet article expliquera comment intégrer ReadDir avec d'autres outils pour améliorer sa fonctionnalité. Méthode 1: combinant d'abord le programme de langue C et le pipeline, écrivez un programme C pour appeler la fonction readdir et sortir le résultat: # include # include # include # includeIntmain (intargc, char * argv []) {dir * dir; structDirent * entrée; if (argc! = 2) {

Python et temps: tirer le meilleur parti de votre temps d'étude

Apr 14, 2025 am 12:02 AM

Python et temps: tirer le meilleur parti de votre temps d'étude

Apr 14, 2025 am 12:02 AM

Pour maximiser l'efficacité de l'apprentissage de Python dans un temps limité, vous pouvez utiliser les modules DateTime, Time et Schedule de Python. 1. Le module DateTime est utilisé pour enregistrer et planifier le temps d'apprentissage. 2. Le module de temps aide à définir l'étude et le temps de repos. 3. Le module de planification organise automatiquement des tâches d'apprentissage hebdomadaires.

Certificat NGINX SSL Mise à jour du tutoriel Debian

Apr 13, 2025 am 07:21 AM

Certificat NGINX SSL Mise à jour du tutoriel Debian

Apr 13, 2025 am 07:21 AM

Cet article vous guidera sur la façon de mettre à jour votre certificat NGINXSSL sur votre système Debian. Étape 1: Installez d'abord CERTBOT, assurez-vous que votre système a des packages CERTBOT et Python3-CERTBOT-NGINX installés. Si ce n'est pas installé, veuillez exécuter la commande suivante: Sudoapt-getUpDaSuDoapt-GetInstallCertBotpyThon3-Certerbot-Nginx Étape 2: Obtenez et configurez le certificat Utilisez la commande Certbot pour obtenir le certificat LETSCRYPT et configure

Comment configurer le serveur HTTPS dans Debian OpenSSL

Apr 13, 2025 am 11:03 AM

Comment configurer le serveur HTTPS dans Debian OpenSSL

Apr 13, 2025 am 11:03 AM

La configuration d'un serveur HTTPS sur un système Debian implique plusieurs étapes, notamment l'installation du logiciel nécessaire, la génération d'un certificat SSL et la configuration d'un serveur Web (tel qu'Apache ou Nginx) pour utiliser un certificat SSL. Voici un guide de base, en supposant que vous utilisez un serveur Apacheweb. 1. Installez d'abord le logiciel nécessaire, assurez-vous que votre système est à jour et installez Apache et OpenSSL: SudoaptupDaSuDoaptupgradeSudoaptinsta

Guide de développement du plug-in de Gitlab sur Debian

Apr 13, 2025 am 08:24 AM

Guide de développement du plug-in de Gitlab sur Debian

Apr 13, 2025 am 08:24 AM

Développer un plugin Gitlab sur Debian nécessite des étapes et des connaissances spécifiques. Voici un guide de base pour vous aider à démarrer avec ce processus. Installation de GitLab Tout d'abord, vous devez installer GitLab sur votre système Debian. Vous pouvez vous référer au manuel d'installation officiel de Gitlab. Obtenez un jeton d'accès API avant d'effectuer l'intégration de l'API, vous devez d'abord obtenir le jeton d'accès API de GitLab. Ouvrez le tableau de bord GitLab, recherchez l'option "AccessTokens" dans les paramètres utilisateur et générez un nouveau jeton d'accès. Sera généré

Quel service est Apache

Apr 13, 2025 pm 12:06 PM

Quel service est Apache

Apr 13, 2025 pm 12:06 PM

Apache est le héros derrière Internet. Ce n'est pas seulement un serveur Web, mais aussi une plate-forme puissante qui prend en charge un trafic énorme et fournit un contenu dynamique. Il offre une flexibilité extrêmement élevée grâce à une conception modulaire, permettant l'expansion de diverses fonctions au besoin. Cependant, la modularité présente également des défis de configuration et de performance qui nécessitent une gestion minutieuse. Apache convient aux scénarios de serveur qui nécessitent des besoins complexes hautement personnalisables.