Périphériques technologiques

Périphériques technologiques

IA

IA

CVPR 2024 | L'IA peut également restaurer fortement la jupe volante lors de la danse. Nanyang Polytechnic propose un nouveau paradigme pour le rendu dynamique du corps humain.

CVPR 2024 | L'IA peut également restaurer fortement la jupe volante lors de la danse. Nanyang Polytechnic propose un nouveau paradigme pour le rendu dynamique du corps humain.

CVPR 2024 | L'IA peut également restaurer fortement la jupe volante lors de la danse. Nanyang Polytechnic propose un nouveau paradigme pour le rendu dynamique du corps humain.

La rubrique AIxiv est une rubrique où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com.

Titre de l'article : SurMo : Modélisation de mouvements 4D basée sur une surface pour le rendu humain dynamique Adresse de l'article : https://arxiv.org/pdf/2404.01225.pdf Page d'accueil du projet : https ://taohuumd.github.io/projects/SurMo Lien Github : https://github.com/TaoHuUMD/SurMo

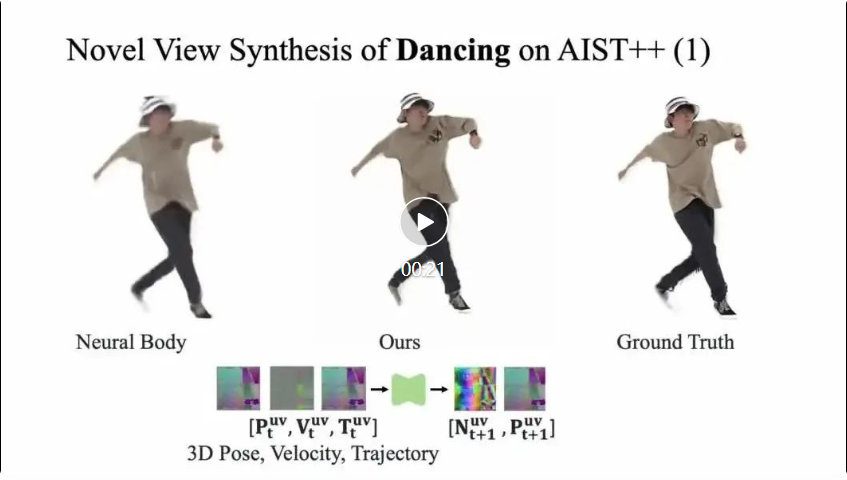

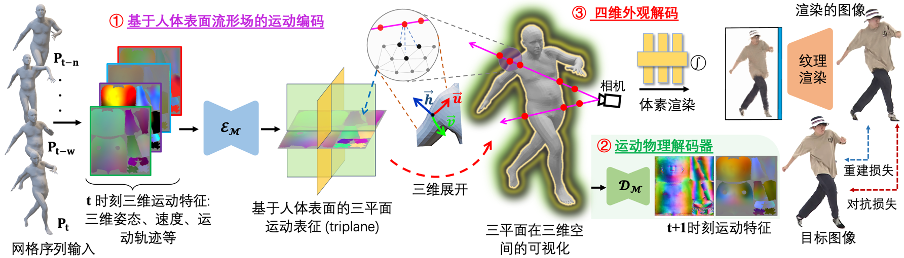

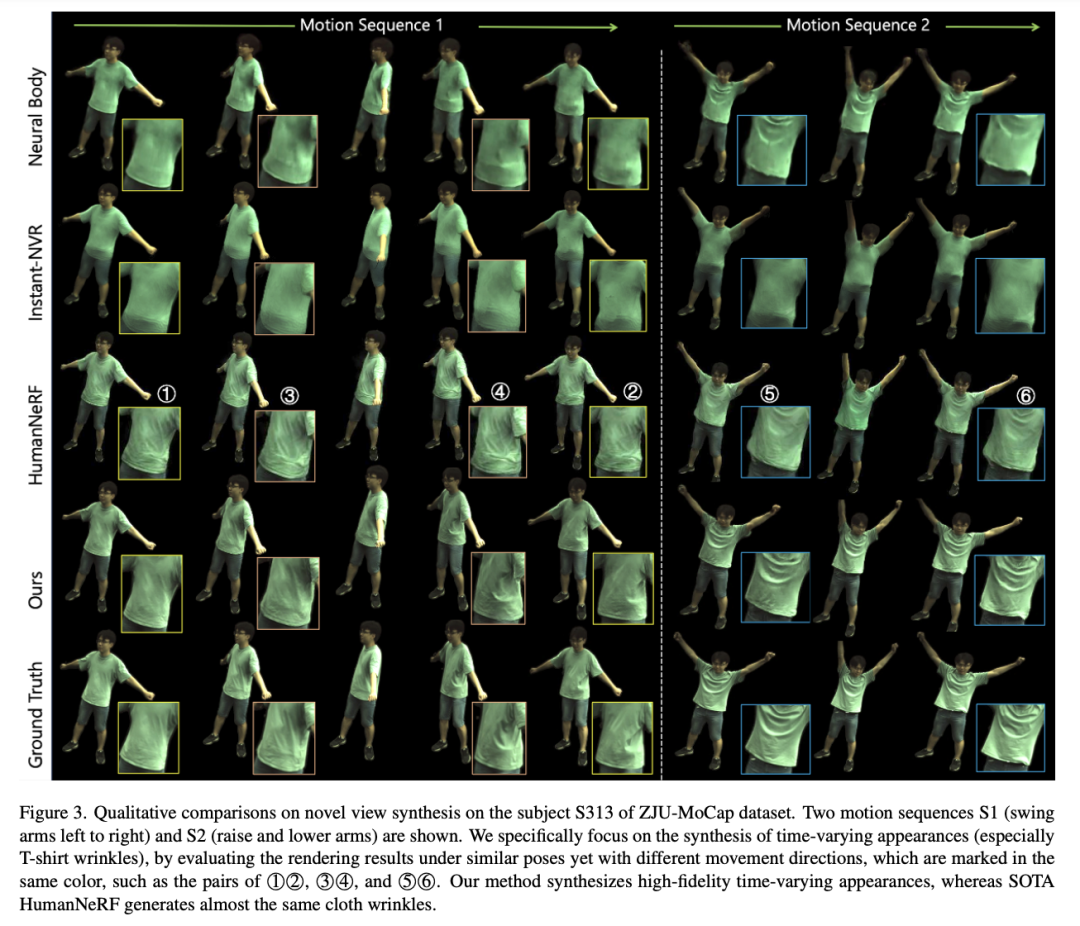

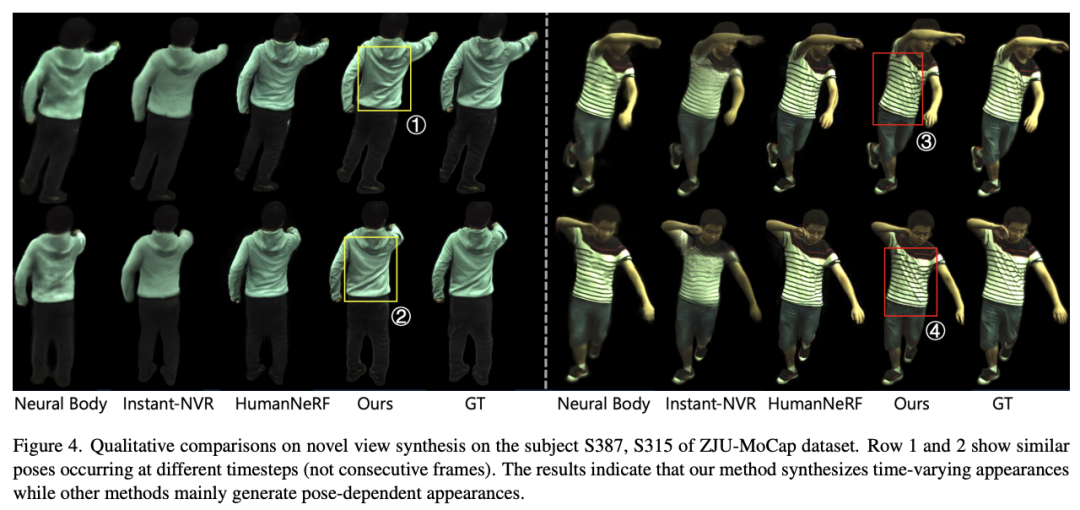

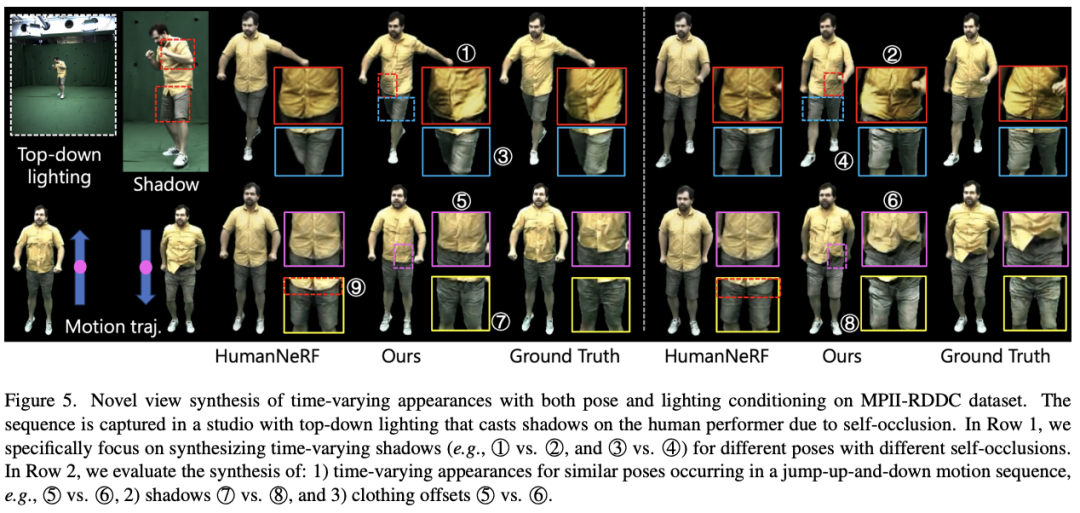

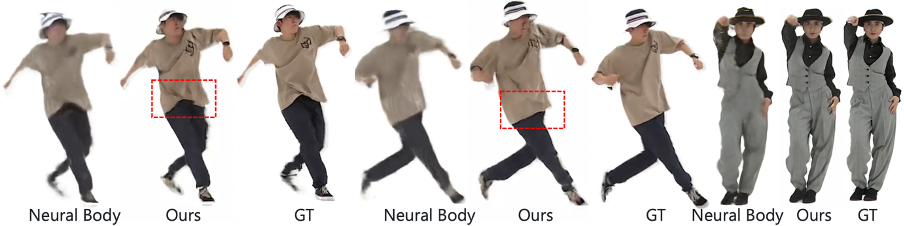

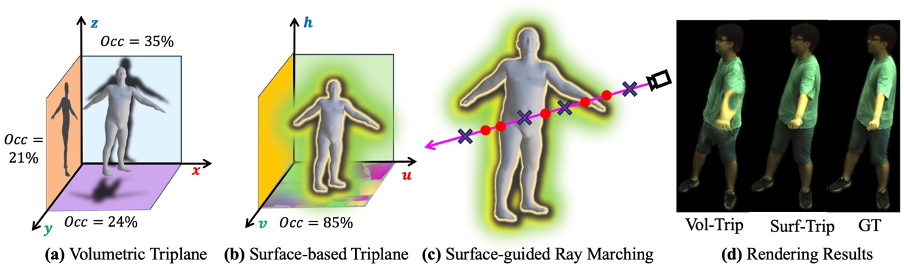

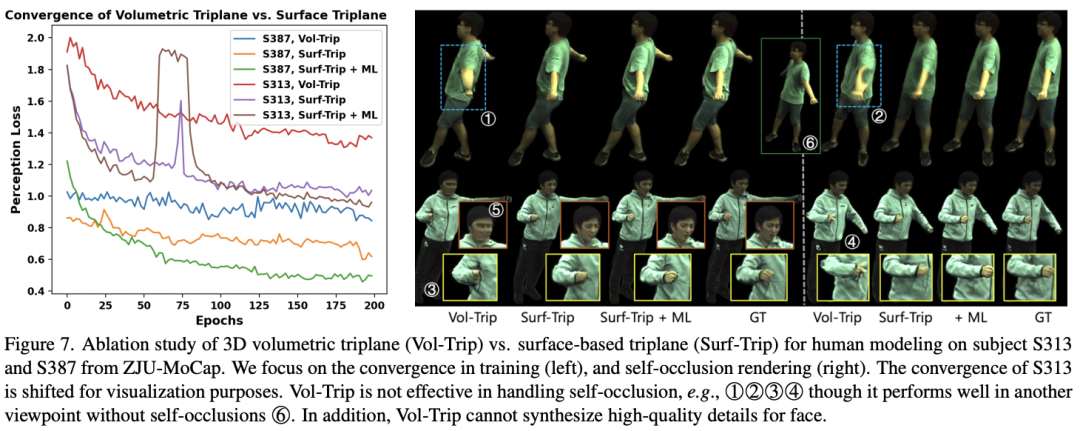

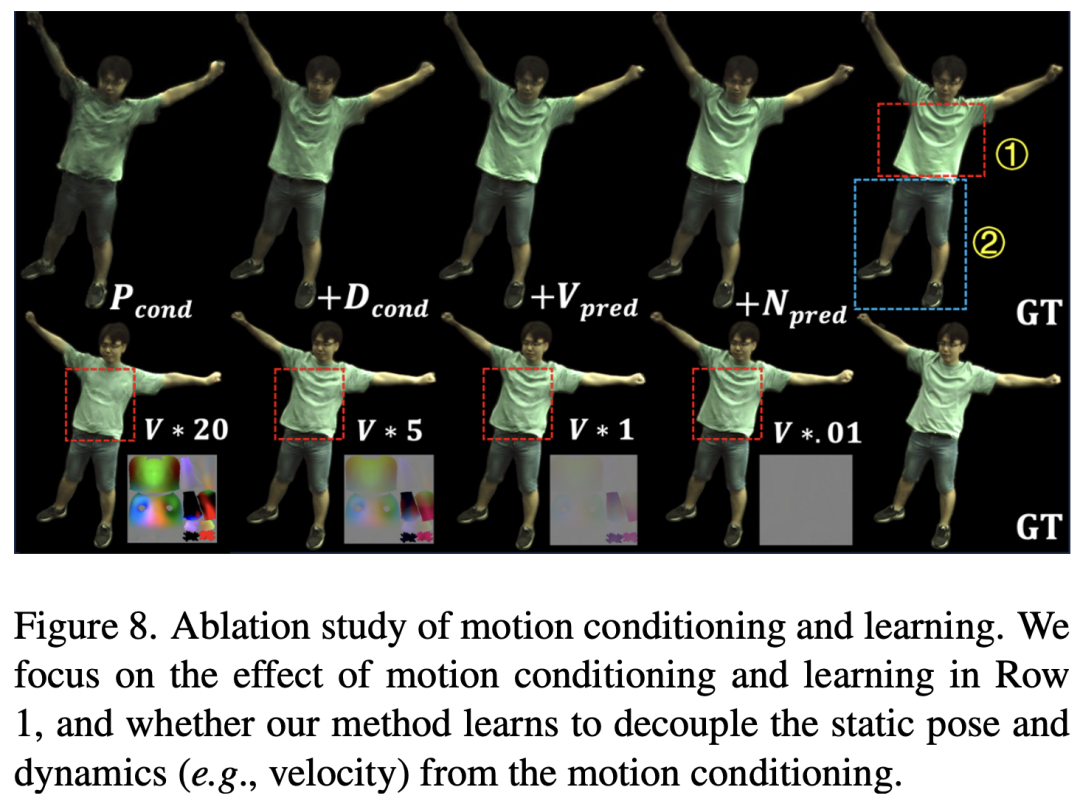

Différent des méthodes existantes qui modélisent le mouvement dans un espace tridimensionnel clairsemé, SurMo propose basé sur le champ multiple de la surface humaine (ou compact espace UV texturé bidimensionnel) modélisation du mouvement en quatre dimensions (XYZ-T), et représente le mouvement à travers un à trois plans (triplan basé sur la surface) défini sur la surface du corps humain. Proposer un décodeur physique du mouvement pour prédire l'état de mouvement de l'image suivante en fonction des caractéristiques du mouvement actuel (telles que la posture tridimensionnelle, la vitesse, la trajectoire du mouvement, etc.), telles que la déviation spatiale du mouvement – surface vecteur normal et déviation temporelle - vitesse, pour modéliser la continuité des caractéristiques de mouvement. Décodage d'apparence en quatre dimensions, décodage temporel des caractéristiques de mouvement pour restituer une vidéo tridimensionnelle à point de vue libre, principalement mis en œuvre via un rendu neuronal hybride à texture de voxel (Hybrid Volumetric-Textural Rendering, HVTR [Hu et al. 2022]) .

Rendu des ombres liées au mouvement et des mouvements affiliés aux vêtements

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelles bibliothèques sont utilisées pour les opérations du numéro de point flottantes en Go?

Apr 02, 2025 pm 02:06 PM

Quelles bibliothèques sont utilisées pour les opérations du numéro de point flottantes en Go?

Apr 02, 2025 pm 02:06 PM

La bibliothèque utilisée pour le fonctionnement du numéro de point flottante dans le langage go présente comment s'assurer que la précision est ...

Gitee Pages STATIQUE Le déploiement du site Web a échoué: comment dépanner et résoudre les erreurs de fichier unique 404?

Apr 04, 2025 pm 11:54 PM

Gitee Pages STATIQUE Le déploiement du site Web a échoué: comment dépanner et résoudre les erreurs de fichier unique 404?

Apr 04, 2025 pm 11:54 PM

GiteEpages STATIQUE Le déploiement du site Web a échoué: 404 Dépannage des erreurs et résolution lors de l'utilisation de Gitee ...

Comment exécuter le projet H5

Apr 06, 2025 pm 12:21 PM

Comment exécuter le projet H5

Apr 06, 2025 pm 12:21 PM

L'exécution du projet H5 nécessite les étapes suivantes: Installation des outils nécessaires tels que le serveur Web, Node.js, les outils de développement, etc. Créez un environnement de développement, créez des dossiers de projet, initialisez les projets et écrivez du code. Démarrez le serveur de développement et exécutez la commande à l'aide de la ligne de commande. Aperçu du projet dans votre navigateur et entrez l'URL du serveur de développement. Publier des projets, optimiser le code, déployer des projets et configurer la configuration du serveur Web.

Quelles bibliothèques de GO sont développées par de grandes entreprises ou fournies par des projets open source bien connus?

Apr 02, 2025 pm 04:12 PM

Quelles bibliothèques de GO sont développées par de grandes entreprises ou fournies par des projets open source bien connus?

Apr 02, 2025 pm 04:12 PM

Quelles bibliothèques de GO sont développées par de grandes entreprises ou des projets open source bien connus? Lors de la programmation en Go, les développeurs rencontrent souvent des besoins communs, ...

Comment spécifier la base de données associée au modèle de Beego ORM?

Apr 02, 2025 pm 03:54 PM

Comment spécifier la base de données associée au modèle de Beego ORM?

Apr 02, 2025 pm 03:54 PM

Dans le cadre du cadre de beegoorm, comment spécifier la base de données associée au modèle? De nombreux projets Beego nécessitent que plusieurs bases de données soient opérées simultanément. Lorsque vous utilisez Beego ...

Comment résoudre le problème de conversion de type user_id lors de l'utilisation du flux redis pour implémenter les files d'attente de messages dans le langage Go?

Apr 02, 2025 pm 04:54 PM

Comment résoudre le problème de conversion de type user_id lors de l'utilisation du flux redis pour implémenter les files d'attente de messages dans le langage Go?

Apr 02, 2025 pm 04:54 PM

Le problème de l'utilisation de Redessstream pour implémenter les files d'attente de messages dans le langage GO consiste à utiliser le langage GO et redis ...

La production de pages H5 nécessite-t-elle une maintenance continue?

Apr 05, 2025 pm 11:27 PM

La production de pages H5 nécessite-t-elle une maintenance continue?

Apr 05, 2025 pm 11:27 PM

La page H5 doit être maintenue en continu, en raison de facteurs tels que les vulnérabilités du code, la compatibilité des navigateurs, l'optimisation des performances, les mises à jour de sécurité et les améliorations de l'expérience utilisateur. Des méthodes de maintenance efficaces comprennent l'établissement d'un système de test complet, à l'aide d'outils de contrôle de version, de surveiller régulièrement les performances de la page, de collecter les commentaires des utilisateurs et de formuler des plans de maintenance.

Comment obtenir les données de la région d'expédition de la version à l'étranger? Quelles sont les ressources prêtes à l'emploi disponibles?

Apr 01, 2025 am 08:15 AM

Comment obtenir les données de la région d'expédition de la version à l'étranger? Quelles sont les ressources prêtes à l'emploi disponibles?

Apr 01, 2025 am 08:15 AM

Description de la question: Comment obtenir les données de la région d'expédition de la version à l'étranger? Y a-t-il des ressources prêtes à l'emploi disponibles? Soyez précis dans le commerce électronique transfrontalier ou les entreprises mondialisées ...