Périphériques technologiques

Périphériques technologiques

IA

IA

Quelques heures après sa sortie, Microsoft a supprimé un grand modèle open source comparable à GPT-4 en quelques secondes ! J'ai oublié de faire un test anti-poison

Quelques heures après sa sortie, Microsoft a supprimé un grand modèle open source comparable à GPT-4 en quelques secondes ! J'ai oublié de faire un test anti-poison

Quelques heures après sa sortie, Microsoft a supprimé un grand modèle open source comparable à GPT-4 en quelques secondes ! J'ai oublié de faire un test anti-poison

La semaine dernière, Microsoft a diffusé un modèle open source appelé WizardLM-2 qui peut être appelé niveau GPT-4.

De façon inattendue, il a été supprimé immédiatement quelques heures après sa publication.

Certains internautes ont soudainement découvert que les poids des modèles et les messages d'annonce de WizardLM avaient tous été supprimés et ne figuraient plus dans la collection Microsoft. Hormis la mention du site, aucune preuve n'a pu être trouvée pour prouver ce projet officiel de Microsoft.

La page d'accueil du projet GitHub est devenue 404.

Adresse du projet : https://wizardlm.github.io/

Y compris le poids du modèle sur HF, tout a disparu...

L'ensemble du réseau Le visage est plein de confusion, pourquoi WizardLM est-il parti ?

Mais Microsoft a fait cela parce que l'équipe a oublié de "tester" le modèle.

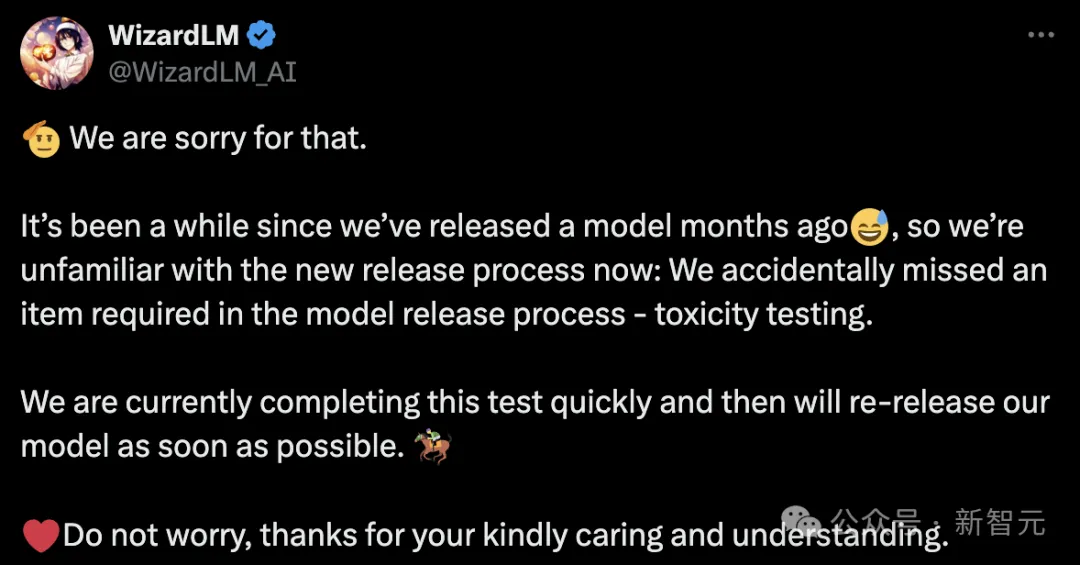

Plus tard, l'équipe Microsoft s'est présentée pour s'excuser et expliquer que cela faisait un moment que WizardLM n'était pas sorti il y a quelques mois, nous n'étions donc pas familiers avec le nouveau processus de publication.

Nous avons accidentellement manqué l'une des choses requises dans le processus de publication du modèle : le test d'empoisonnement

Microsoft WizardLM mis à niveau vers la deuxième génération

En juin de l'année dernière, il a été affiné basé sur LlaMA Une fois la première génération de WizardLM sortie, elle a attiré beaucoup d'attention de la part de la communauté open source.

Adresse papier : https://arxiv.org/pdf/2304.12244.pdf

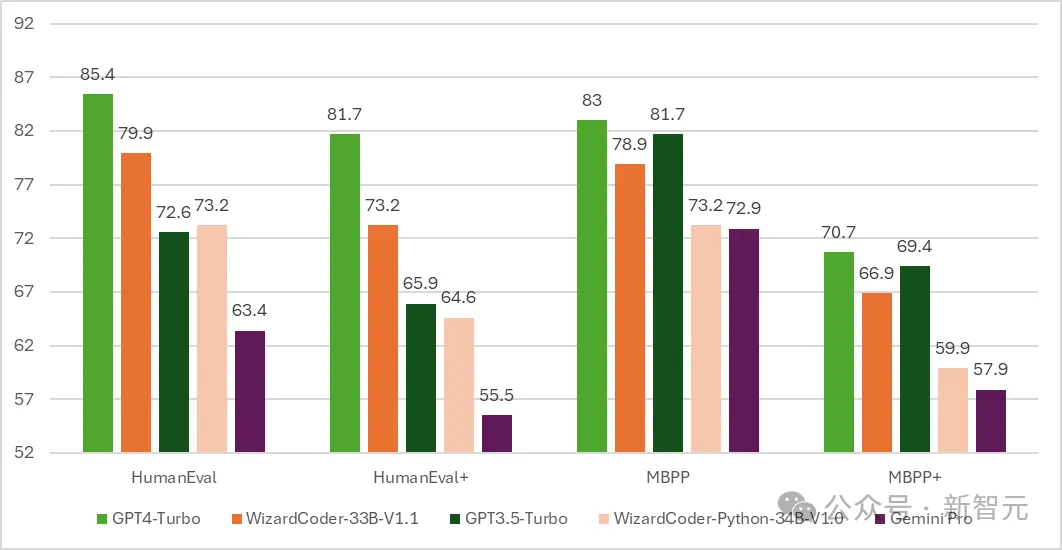

Par la suite, la version code de WizardCoder est née - un modèle basé sur Code Llama et affiné à l'aide d'Evol- Instruire.

Les résultats des tests montrent que le pass@1 de WizardCoder sur HumanEval a atteint un étonnant 73,2 %, dépassant le GPT-4 d'origine.

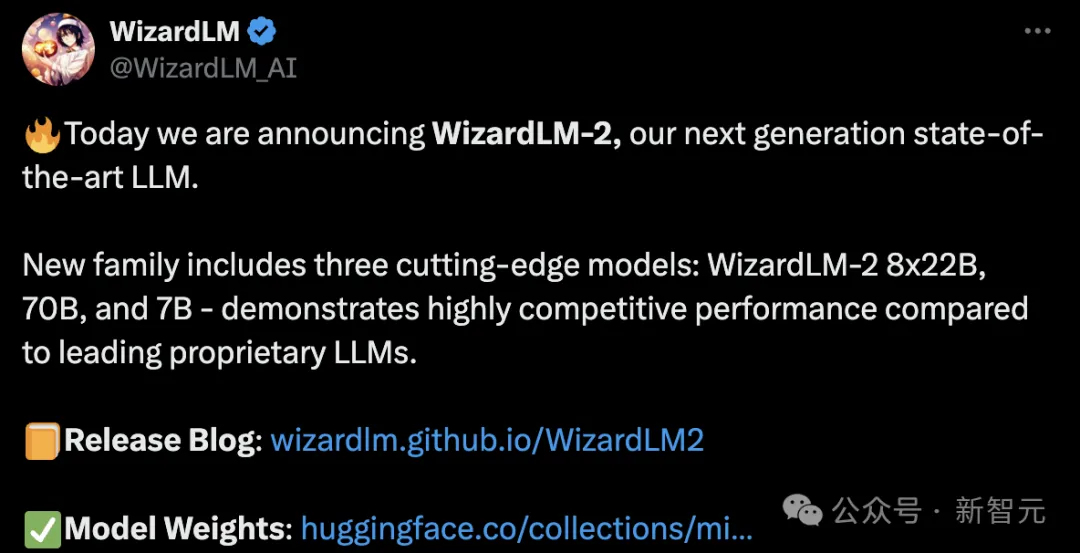

Alors que le temps avance jusqu'au 15 avril, les développeurs Microsoft ont officiellement annoncé une nouvelle génération de WizardLM, cette fois affiné à partir de Mixtral 8x22B.

Il contient trois versions de paramètres, à savoir 8x22B, 70B et 7B.

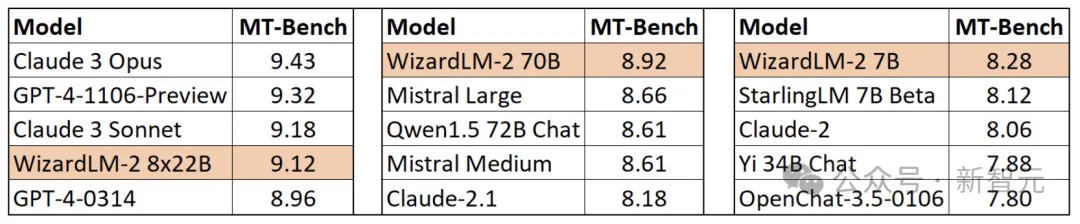

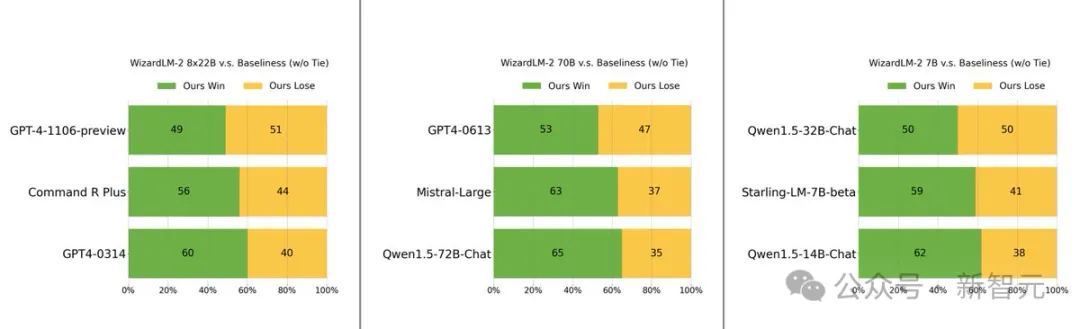

Le plus intéressant à mentionner est que lors du test de référence MT-Bench, le nouveau modèle a obtenu un avantage de premier plan.

Plus précisément, les performances de la version avec le plus grand paramètre du modèle WizardLM 8x22B sont presque proches de GPT-4 et Claude 3.

Sur la même échelle de paramètres, la version 70B se classe première.

La version 7B est la plus rapide et peut même atteindre des performances comparables au modèle leader avec une échelle de paramètres 10 fois plus grande.

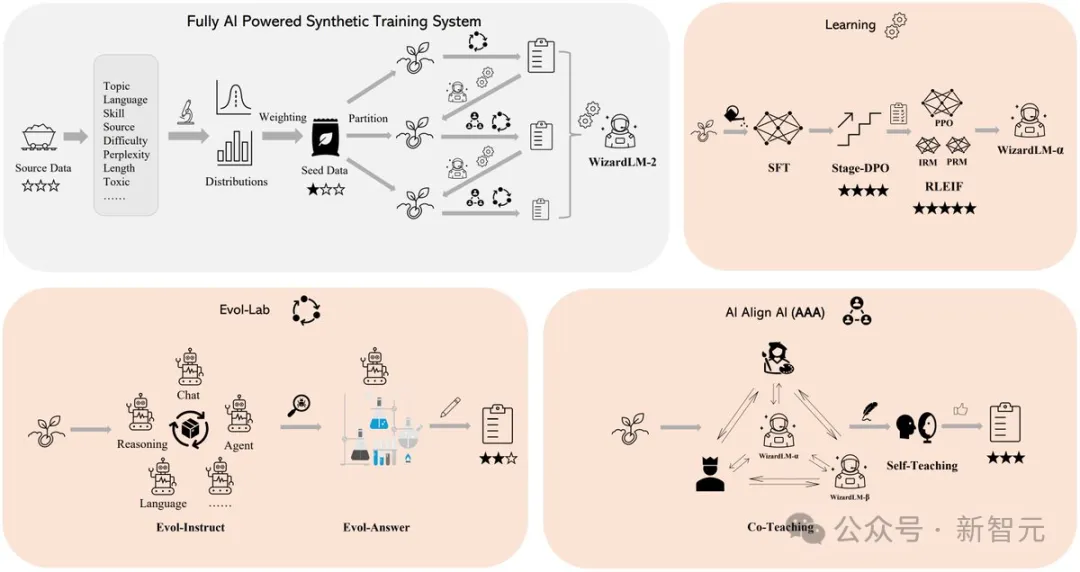

Le secret des performances exceptionnelles de WizardLM 2 réside dans la méthodologie de formation révolutionnaire Evol-Instruct développée par Microsoft.

Evol-Instruct exploite de grands modèles de langage pour réécrire de manière itérative l'ensemble d'instructions initial en variantes de plus en plus complexes. Ces données d'instructions évoluées sont ensuite utilisées pour affiner le modèle de base, améliorant ainsi considérablement sa capacité à gérer des tâches complexes.

L'autre est le cadre d'apprentissage par renforcement RLEIF, qui a également joué un rôle important dans le processus de développement de WizardLM 2.

Dans la formation WizardLM 2, la méthode AI Align AI (AAA) est également adoptée, qui permet à plusieurs grands modèles de premier plan de se guider et de s'améliorer mutuellement.

Le cadre AAA se compose de deux volets principaux, à savoir le « co-enseignement » et l'« auto-apprentissage ».

Co-enseignant cette étape, WizardLM et une variété de modèles avancés open source et propriétaires sous licence mènent des discussions de simulation, des jugements de qualité, des suggestions d'amélioration et comblent les lacunes en matière de compétences.

En communiquant entre eux et en fournissant des commentaires, les modèles peuvent apprendre de leurs pairs et améliorer leurs capacités.

Pour l'auto-apprentissage, WizardLM peut générer de nouvelles données d'entraînement évolutives pour l'apprentissage supervisé et des données de préférence pour l'apprentissage par renforcement grâce à l'auto-apprentissage actif.

Ce mécanisme d'auto-apprentissage permet au modèle d'améliorer continuellement les performances en apprenant de ses propres données générées et des informations de retour d'information.

De plus, le modèle WizardLM 2 a été entraîné à l'aide des données synthétiques générées.

De l'avis des chercheurs, les données d'entraînement pour les grands modèles sont de plus en plus épuisées, et on pense que les données soigneusement créées par l'IA et les modèles progressivement supervisés par l'IA seront le seul moyen d'accéder à une intelligence artificielle plus puissante.

Ils ont donc créé un système de formation synthétique entièrement piloté par l'IA pour améliorer WizardLM-2.

Les internautes rapides ont déjà téléchargé les poids

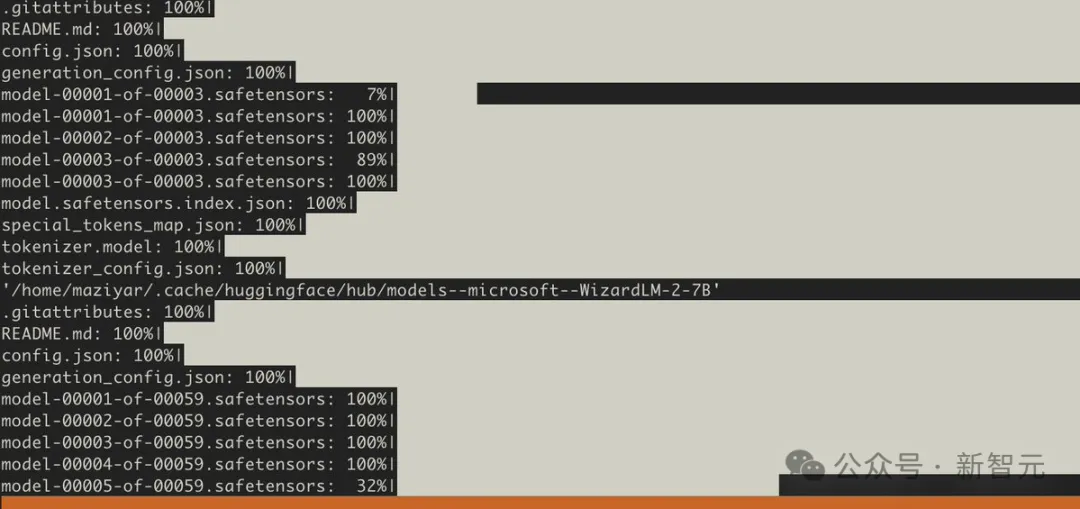

Cependant, avant la suppression de la base de données, de nombreuses personnes avaient déjà téléchargé les poids des modèles.

Avant la suppression du modèle, plusieurs utilisateurs l'ont également testé sur des benchmarks supplémentaires.

Heureusement, les internautes qui l'ont testé ont été impressionnés par le modèle 7B et ont déclaré que ce serait leur premier choix pour effectuer des tâches d'assistant local.

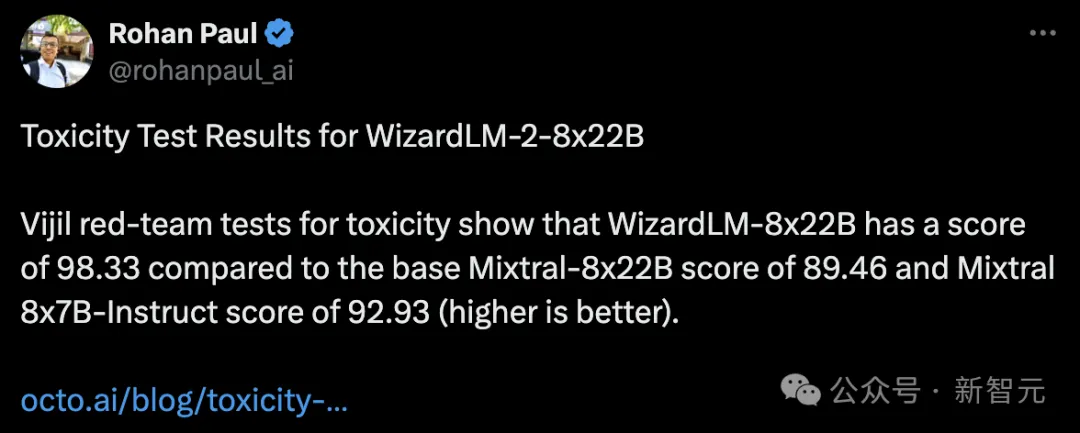

Quelqu'un a également fait un test anti-poison et a découvert que le WizardLM-8x22B avait un score de 98,33, tandis que le Mixtral-8x22B de base avait un score de 89,46 et le Mixtral 8x7B-Indict un score de 92,93.

Plus le score est élevé, mieux c'est, ce qui signifie que WizardLM-8x22B est toujours très fort.

S'il n'y a pas de test d'empoisonnement, il est absolument impossible d'envoyer le modèle.

Tout le monde sait que les grands mannequins sont sujets aux hallucinations.

Si WizardLM 2 génère du contenu « toxique, biaisé et incorrect » dans les réponses, il ne sera pas convivial pour les grands modèles.

En particulier, ces erreurs ont attiré l'attention de l'ensemble du réseau, et susciteront également des critiques de la part de Microsoft lui-même, et pourraient même faire l'objet d'une enquête de la part des autorités.

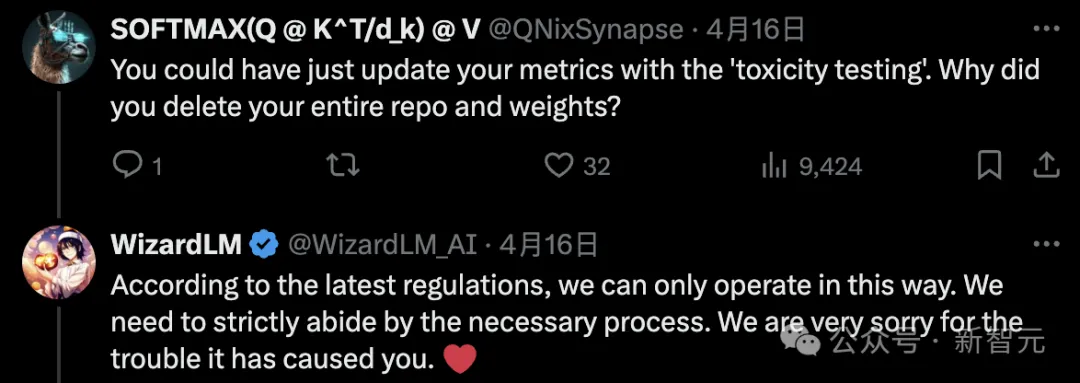

Certains internautes étaient confus et ont déclaré qu'il était possible de mettre à jour les indicateurs grâce à un "test d'empoisonnement". Pourquoi supprimer l'intégralité du référentiel et son poids ?

L'auteur de Microsoft a déclaré que selon le dernier règlement interne, cela ne peut être fait.

Certaines personnes ont également dit que nous voulions des modèles sans « lobotomie ».

Cependant, les développeurs doivent encore attendre patiemment, et l'équipe Microsoft promet qu'elle se remettra en ligne une fois le test terminé.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelles bibliothèques sont utilisées pour les opérations du numéro de point flottantes en Go?

Apr 02, 2025 pm 02:06 PM

Quelles bibliothèques sont utilisées pour les opérations du numéro de point flottantes en Go?

Apr 02, 2025 pm 02:06 PM

La bibliothèque utilisée pour le fonctionnement du numéro de point flottante dans le langage go présente comment s'assurer que la précision est ...

Comment exécuter le projet H5

Apr 06, 2025 pm 12:21 PM

Comment exécuter le projet H5

Apr 06, 2025 pm 12:21 PM

L'exécution du projet H5 nécessite les étapes suivantes: Installation des outils nécessaires tels que le serveur Web, Node.js, les outils de développement, etc. Créez un environnement de développement, créez des dossiers de projet, initialisez les projets et écrivez du code. Démarrez le serveur de développement et exécutez la commande à l'aide de la ligne de commande. Aperçu du projet dans votre navigateur et entrez l'URL du serveur de développement. Publier des projets, optimiser le code, déployer des projets et configurer la configuration du serveur Web.

Gitee Pages STATIQUE Le déploiement du site Web a échoué: comment dépanner et résoudre les erreurs de fichier unique 404?

Apr 04, 2025 pm 11:54 PM

Gitee Pages STATIQUE Le déploiement du site Web a échoué: comment dépanner et résoudre les erreurs de fichier unique 404?

Apr 04, 2025 pm 11:54 PM

GiteEpages STATIQUE Le déploiement du site Web a échoué: 404 Dépannage des erreurs et résolution lors de l'utilisation de Gitee ...

Comment spécifier la base de données associée au modèle de Beego ORM?

Apr 02, 2025 pm 03:54 PM

Comment spécifier la base de données associée au modèle de Beego ORM?

Apr 02, 2025 pm 03:54 PM

Dans le cadre du cadre de beegoorm, comment spécifier la base de données associée au modèle? De nombreux projets Beego nécessitent que plusieurs bases de données soient opérées simultanément. Lorsque vous utilisez Beego ...

Quelles bibliothèques de GO sont développées par de grandes entreprises ou fournies par des projets open source bien connus?

Apr 02, 2025 pm 04:12 PM

Quelles bibliothèques de GO sont développées par de grandes entreprises ou fournies par des projets open source bien connus?

Apr 02, 2025 pm 04:12 PM

Quelles bibliothèques de GO sont développées par de grandes entreprises ou des projets open source bien connus? Lors de la programmation en Go, les développeurs rencontrent souvent des besoins communs, ...

Comment résoudre le problème de conversion de type user_id lors de l'utilisation du flux redis pour implémenter les files d'attente de messages dans le langage Go?

Apr 02, 2025 pm 04:54 PM

Comment résoudre le problème de conversion de type user_id lors de l'utilisation du flux redis pour implémenter les files d'attente de messages dans le langage Go?

Apr 02, 2025 pm 04:54 PM

Le problème de l'utilisation de Redessstream pour implémenter les files d'attente de messages dans le langage GO consiste à utiliser le langage GO et redis ...

La production de pages H5 nécessite-t-elle une maintenance continue?

Apr 05, 2025 pm 11:27 PM

La production de pages H5 nécessite-t-elle une maintenance continue?

Apr 05, 2025 pm 11:27 PM

La page H5 doit être maintenue en continu, en raison de facteurs tels que les vulnérabilités du code, la compatibilité des navigateurs, l'optimisation des performances, les mises à jour de sécurité et les améliorations de l'expérience utilisateur. Des méthodes de maintenance efficaces comprennent l'établissement d'un système de test complet, à l'aide d'outils de contrôle de version, de surveiller régulièrement les performances de la page, de collecter les commentaires des utilisateurs et de formuler des plans de maintenance.

Lorsque vous utilisez SQL.Open, pourquoi ne signale pas une erreur lorsque DSN passe vide?

Apr 02, 2025 pm 12:54 PM

Lorsque vous utilisez SQL.Open, pourquoi ne signale pas une erreur lorsque DSN passe vide?

Apr 02, 2025 pm 12:54 PM

Lorsque vous utilisez SQL.Open, pourquoi le DSN ne signale-t-il pas une erreur? En langue go, sql.open ...