Périphériques technologiques

Périphériques technologiques

IA

IA

Quantification, taille, distillation, que disent exactement ces argots des grands modèles ?

Quantification, taille, distillation, que disent exactement ces argots des grands modèles ?

Quantification, taille, distillation, que disent exactement ces argots des grands modèles ?

Quantification, élagage, distillation, si vous faites souvent attention aux grands modèles de langage, vous verrez certainement ces mots rien qu'en regardant ces mots, il nous est difficile de comprendre ce qu'ils font, mais ces mots sont particulièrement importants. pour le développement de grands modèles de langage à ce stade. Cet article vous aidera à les connaître et à comprendre leurs principes.

Compression de modèle

La quantification, l'élagage et la distillation sont en fait des technologies générales de compression de modèles de réseaux neuronaux, non exclusives aux grands modèles de langage.

L'importance de la compression du modèle

Après la compression, le fichier modèle deviendra plus petit, l'espace disque utilisé deviendra également plus petit, l'espace cache utilisé lors du chargement en mémoire ou affiché deviendra également plus petit, et le le fonctionnement du modèle deviendra également plus petit. Il pourrait également y avoir des améliorations de vitesse.

Grâce à la compression, l'utilisation du modèle consommera moins de ressources informatiques, ce qui peut considérablement élargir les scénarios d'application du modèle, en particulier dans les endroits où la taille du modèle et l'efficacité informatique sont plus préoccupantes, comme les téléphones mobiles, les appareils embarqués, etc.

Qu'est-ce qui est compressé ?

Ce qui est compressé, ce sont les paramètres du modèle. Quels sont les paramètres du modèle ?

Vous avez peut-être entendu dire que l'apprentissage automatique actuel utilise des modèles de réseau neuronal. Le modèle de réseau neuronal simule le réseau neuronal du cerveau humain.

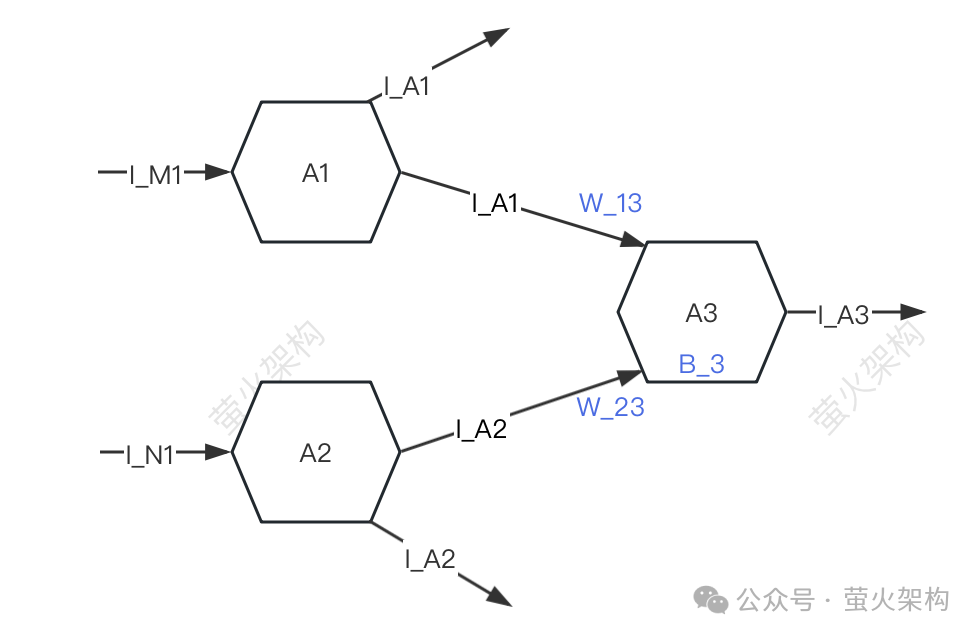

Ici, j'ai dessiné un schéma simple, vous pouvez y jeter un oeil.

Photos

Photos

Par souci de simplicité, seuls trois neurones sont décrits : A1, A2, A3. Chaque neurone reçoit des signaux d'autres neurones et transmet des signaux à d'autres neurones.

A3 recevra les signaux I_A1 et I_A2 de A1 et A2, mais la force des signaux reçus par A3 de A1 et A2 est différente (cette force est appelée « poids ») Supposons que les forces ici sont W_13 et. W_23 respectivement, A3 traitera les données du signal reçu.

- Effectuez d'abord une sommation pondérée des signaux, c'est-à-dire I_A1*W_13+I_A2*W_23,

- Puis ajoutez le propre paramètre B_3 de A3 (appelé "bias"),

- Enfin, ces données est converti sous une forme spécifique et le signal converti est envoyé au neurone suivant.

Dans le processus de traitement de ces données de signal, les poids (W_13, W_23) et les décalages (B_3) utilisés sont les paramètres du modèle. Bien sûr, le modèle a d'autres paramètres, mais les poids et les décalages le sont généralement. tous La majeure partie des paramètres, s'ils sont divisés selon le principe 80/20, doivent être supérieurs à 80 %.

Lors de l'utilisation d'un grand modèle de langage pour générer du texte, ces paramètres sont déjà pré-entraînés et nous ne pouvons pas les modifier. C'est comme les coefficients des polynômes en mathématiques. Nous ne pouvons transmettre que le xyz inconnu et obtenir un résultat de sortie. .

La compression du modèle consiste à compresser ces paramètres du modèle. Les principales considérations sont les poids et les biais. Les méthodes spécifiques utilisées sont la quantification, l'élagage et la distillation, qui font l'objet de cet article.

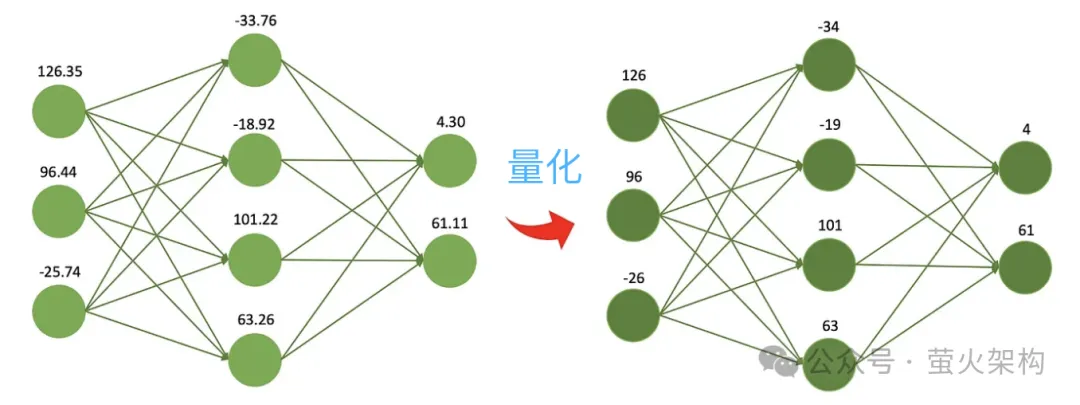

Quantisation

La quantification consiste à réduire la précision numérique des paramètres du modèle. Par exemple, les poids initialement formés sont des nombres à virgule flottante de 32 bits, mais en utilisation réelle, il s'avère qu'il n'y a presque aucune perte si. exprimé en 16 bits, mais la taille du fichier modèle est réduite de moitié, l'utilisation de la mémoire vidéo est réduite de moitié et les besoins en bande passante de communication entre le processeur et la mémoire sont également réduits, ce qui signifie des coûts inférieurs et des avantages plus élevés.

C’est comme suivre une recette, il faut déterminer le poids de chaque ingrédient. Vous pouvez utiliser une balance électronique très précise, précise à 0,01 gramme près, ce qui est génial car vous pouvez connaître très précisément le poids de chaque ingrédient. Cependant, si vous préparez simplement un repas à partager et n'avez pas réellement besoin d'une telle précision, vous pouvez utiliser une balance simple et bon marché avec une balance minimale de 1 gramme, ce qui n'est pas aussi précis mais est suffisant pour préparer un délicieux repas. dîner.

Images

Images

Un autre avantage de la quantification est qu'elle calcule plus rapidement. Les processeurs modernes contiennent généralement de nombreuses unités de calcul vectoriel de faible précision. Le modèle peut exploiter pleinement ces fonctionnalités matérielles pour effectuer davantage d'opérations parallèles. Dans le même temps, les opérations de faible précision sont généralement plus rapides que les opérations de haute précision. la consommation d'une seule multiplication et addition est plus courte. Ces avantages permettent également au modèle de fonctionner sur des machines de configuration inférieure, telles que des ordinateurs de bureau ou personnels ordinaires, des téléphones mobiles et d'autres terminaux mobiles sans GPU hautes performances.

Suite à cette idée, les gens continuent de compresser les modèles 8 bits, 4 bits et 2 bits, qui sont plus petits et utilisent moins de ressources informatiques. Cependant, à mesure que l'exactitude des poids diminue, les valeurs des différents poids deviendront plus proches, voire égales, ce qui réduira l'exactitude et la précision de la sortie du modèle, et les performances du modèle diminueront à des degrés divers.

La technologie de quantification a de nombreuses stratégies et détails techniques différents, tels que la quantification dynamique, la quantification statique, la quantification symétrique, la quantification asymétrique, etc. Pour les grands modèles de langage, des stratégies de quantification statique sont généralement utilisées une fois la formation du modèle terminée. Les paramètres sont quantifiés une seule fois et les calculs quantitatifs ne sont plus nécessaires lors de l'exécution du modèle, ce qui facilite sa distribution et son déploiement.

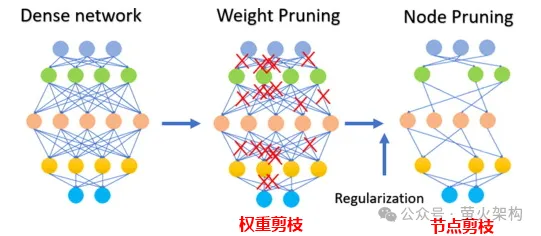

Pruning

L'élagage consiste à supprimer les poids sans importance ou rarement utilisés dans le modèle. Les valeurs de ces poids sont généralement proches de 0. Pour certains modèles, l'élagage peut produire un taux de compression plus élevé, rendant le modèle plus compact et efficace. Ceci est particulièrement utile pour déployer des modèles sur des appareils aux ressources limitées ou lorsque la mémoire et le stockage sont limités.

L'élagage améliore également l'interprétabilité du modèle. En supprimant les composants inutiles, l’élagage rend la structure sous-jacente du modèle plus transparente et plus facile à analyser. Ceci est important pour comprendre le processus décisionnel de modèles complexes tels que les réseaux de neurones.

La taille implique non seulement la taille des paramètres de poids, mais également la taille de certains nœuds neuronaux, comme le montre la figure suivante :

Photo

Photo

A noter que la taille ne convient pas à tous les modèles, pour certains clairsemés. (la plupart des paramètres sont 0 ou proches de 0), l'élagage peut n'avoir aucun effet ; pour certains petits modèles avec relativement peu de paramètres, l'élagage peut également entraîner une baisse significative des performances du modèle ; pour certaines tâches ou applications de haute précision ; Il ne convient pas pour élaguer le modèle, comme le diagnostic médical, qui est une question de vie ou de mort.

Lors de l'application réelle de la technologie d'élagage, il est généralement nécessaire de prendre en compte de manière globale l'amélioration de la vitesse d'exécution du modèle et l'impact négatif de l'élagage sur les performances du modèle, et d'adopter certaines stratégies, telles que la notation de chaque paramètre du modèle, c'est-à-dire évaluer les paramètres. Dans quelle mesure cela contribue-t-il aux performances du modèle. Ceux qui ont des scores élevés sont des paramètres importants qui ne doivent pas être tronqués ; ceux qui ont des scores faibles sont des paramètres qui ne sont peut-être pas si importants et peuvent être pris en compte pour un seuil. Ce score peut être calculé par diverses méthodes, telles que l'examen de la taille du paramètre (la valeur absolue la plus élevée est généralement plus importante), ou déterminé par des méthodes d'analyse statistique plus complexes.

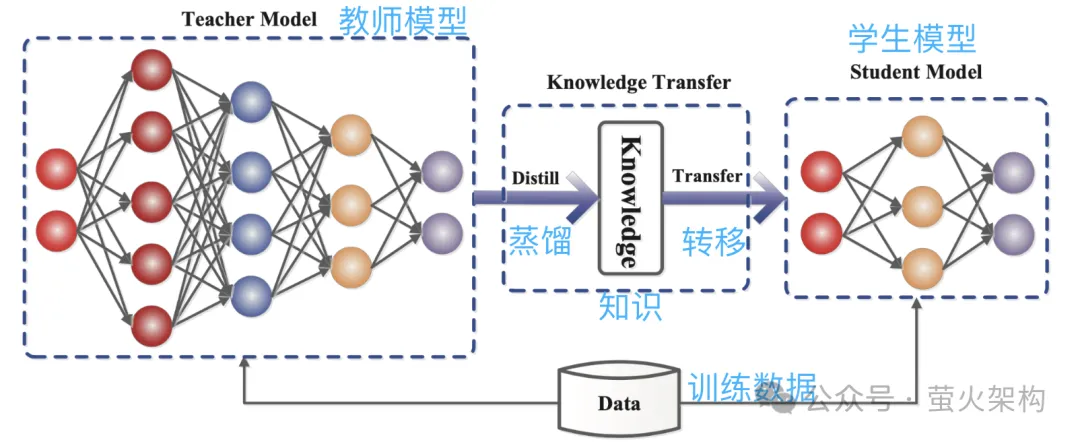

Distillation

La distillation consiste à copier directement la distribution de probabilité apprise par le grand modèle dans un petit modèle. Le modèle copié est appelé modèle d'enseignant, qui est généralement un excellent modèle avec un grand nombre de paramètres et de fortes performances. Le nouveau modèle est appelé modèle d'étudiant, qui est généralement un petit modèle avec relativement peu de paramètres.

Pendant la distillation, le modèle de l'enseignant générera des distributions de probabilité de plusieurs sorties possibles en fonction de l'entrée, puis le modèle de l'élève apprendra la distribution de probabilité de cette entrée et de cette sortie. Après une formation approfondie, le modèle étudiant peut imiter le comportement du modèle enseignant ou acquérir les connaissances du modèle enseignant.

Par exemple, dans une tâche de classification d'images, étant donné une image, le modèle de l'enseignant peut générer une distribution de probabilité similaire à la suivante :

- Chat : 0,7

- Chien : 0,4

- Voiture : 0.1

Ensuite, soumettez cette image et les informations de distribution de probabilité de sortie au modèle d'élève pour l'apprentissage par imitation.

Photos

Photos

Parce que la distillation compresse les connaissances du modèle d'enseignant dans un modèle d'étudiant plus petit et plus simple, le nouveau modèle peut perdre certaines informations. De plus, le modèle d'étudiant peut trop s'appuyer sur le modèle d'enseignant, ce qui entraîne une faible capacité de généralisation.

Afin d'améliorer l'effet d'apprentissage du modèle étudiant, nous pouvons adopter certaines méthodes et stratégies.

Présentation du paramètre de température : Supposons qu'il y ait un enseignant qui enseigne très vite et que la densité de l'information soit très élevée, cela peut être un peu difficile à suivre pour les élèves. À ce moment-là, si l’enseignant ralentit et simplifie l’information, celle-ci sera plus facile à comprendre pour les élèves. Dans la distillation du modèle, le paramètre de température joue un rôle similaire à « l'ajustement de la vitesse de cours » pour aider le modèle étudiant (petit modèle) à mieux comprendre et acquérir les connaissances du modèle enseignant (grand modèle). D'un point de vue professionnel, il s'agit de donner à la sortie du modèle une distribution de probabilité plus fluide, ce qui permettra au modèle étudiant de capturer et d'apprendre plus facilement les détails de sortie du modèle enseignant.

Ajustez la structure du modèle d'enseignant et du modèle d'étudiant : Il peut être difficile pour un étudiant d'apprendre quelque chose d'un expert, car l'écart de connaissances entre eux est trop grand et l'apprentissage direct peut ne pas comprendre. ajoutez un enseignant au milieu, qui peut à la fois comprendre les mots des experts et les traduire dans un langage que les élèves peuvent comprendre. L'enseignant ajouté au milieu peut être des couches intermédiaires ou des réseaux de neurones auxiliaires, ou l'enseignant peut apporter quelques ajustements au modèle d'élève afin qu'il puisse mieux correspondre à la sortie du modèle d'enseignant.

Nous avons présenté trois technologies principales de compression de modèles ci-dessus. En fait, il y a encore beaucoup de détails ici, mais c'est presque suffisant pour comprendre les principes. Il existe également d'autres technologies de compression de modèles, telles que la décomposition de bas rang. et partage de paramètres, connexion clairsemée, etc. Les étudiants intéressés peuvent consulter davantage de contenu connexe.

De plus, une fois le modèle compressé, ses performances peuvent diminuer considérablement. À ce stade, nous pouvons affiner le modèle, en particulier pour les tâches qui nécessitent une grande précision du modèle, telles que le diagnostic médical, le risque financier. contrôle et conduite automatique, etc., le réglage fin peut restaurer les performances du modèle dans une certaine mesure et stabiliser son exactitude et sa précision dans certains aspects.

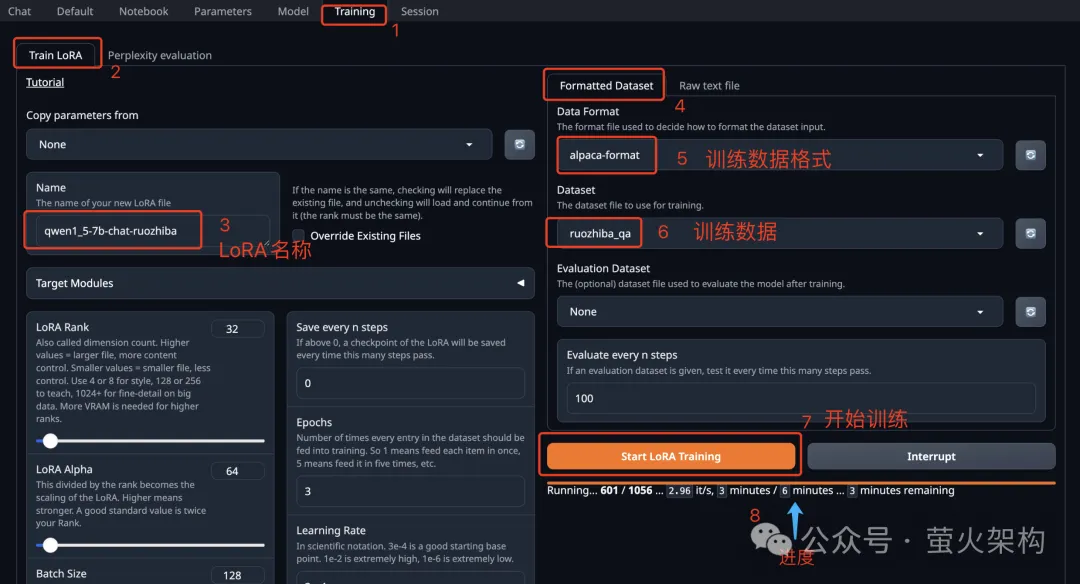

En parlant de réglage fin du modèle, j'ai récemment partagé une image de Text Generation WebUI sur AutoDL Text Generation WebUI est un programme Web écrit à l'aide de Gradio, qui peut facilement effectuer l'inférence et le réglage fin de grands modèles de langage, et prend en charge. une variété de types de grands modèles de langage, notamment Transformers, llama.cpp (GGUF), GPTQ, AWQ, EXL2 et d'autres modèles dans divers formats. Dans la dernière image, j'ai intégré le grand modèle Llama3 récemment open source par Meta. . Étudiants intéressés Vous pouvez l'essayer, voir comment l'utiliser : Apprenez à peaufiner un grand modèle de langage en dix minutes

Photos

Photos

Article de référence :

https:/ /www.php.cn/link/d7852cd2408d9d3205dc75b59 a6ce22e

https://www.php.cn/link/f204aab71691a8e18c3f6f00872db63b

https://www.php.cn/link/b31f0c758bb498b5d56b5fea80 f313a7

https://www.php .cn/link/129ccfc1c1a82b0b23d4473a72373a0a

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment conserver la qualité d'image originale de Meitu Xiu Xiu

Apr 09, 2024 am 08:34 AM

Comment conserver la qualité d'image originale de Meitu Xiu Xiu

Apr 09, 2024 am 08:34 AM

De nombreux amis utilisent le logiciel Meituan Xiuxiu pour P-picture, mais comment conserver la qualité originale de l'image lors de son enregistrement après P-picture ? Le mode opératoire vous est présenté ci-dessous. Les amis intéressés peuvent y jeter un œil avec moi. Après avoir ouvert l'application Meitu Xiu Xiu sur votre téléphone mobile, cliquez sur « Moi » dans le coin inférieur droit de la page pour entrer, puis cliquez sur l'icône hexagonale dans le coin supérieur droit de la page Ma pour l'ouvrir. 2. Après avoir accédé à la page des paramètres, recherchez « Général » et cliquez sur cet élément pour entrer. 3. Ensuite, il y a « Qualité de l'image » sur la page générale. Cliquez sur la flèche derrière pour entrer les paramètres. 4. Enfin, après être entré dans l'interface de réglage de la qualité de l'image, vous verrez une ligne horizontale en bas. Cliquez sur le curseur circulaire sur la ligne horizontale et faites-le glisser vers la droite jusqu'à 100. Lorsque vous enregistrez l'image après l'édition, elle sera la qualité de l'image originale.

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

cURL vs wget : lequel vous convient le mieux ?

May 07, 2024 am 09:04 AM

cURL vs wget : lequel vous convient le mieux ?

May 07, 2024 am 09:04 AM

Lorsque vous souhaitez télécharger des fichiers directement via la ligne de commande Linux, deux outils vous viennent immédiatement à l'esprit : wget et cURL. Ils ont bon nombre des mêmes caractéristiques et peuvent facilement accomplir certaines des mêmes tâches. Bien qu’ils aient certaines caractéristiques similaires, ils ne sont pas exactement les mêmes. Ces deux programmes sont adaptés à des situations différentes et possèdent leurs propres caractéristiques dans des situations spécifiques. cURL vs wget : similarités wget et cURL peuvent télécharger du contenu. C’est ainsi qu’ils sont conçus à la base. Ils peuvent à la fois envoyer des demandes sur Internet et renvoyer les éléments demandés. Il peut s'agir d'un fichier, d'une image ou de quelque chose d'autre comme le code HTML brut du site Web. Les deux programmes peuvent effectuer des requêtes HTTPPOST. Cela signifie qu'ils peuvent tous envoyer

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.