Périphériques technologiques

Périphériques technologiques

IA

IA

Parlons de la collision entre l'apprentissage automatique et la gestion des ressources humaines ?

Parlons de la collision entre l'apprentissage automatique et la gestion des ressources humaines ?

Parlons de la collision entre l'apprentissage automatique et la gestion des ressources humaines ?

Préface

Ces dernières années, de nombreuses avancées majeures ont été réalisées dans le domaine de l'apprentissage automatique, et les produits de services de gestion des ressources humaines pilotés par la technologie de l'intelligence artificielle disposent également d'un marché énorme et dynamique. De plus en plus d'entreprises et d'agences gouvernementales réfléchissent progressivement à appliquer la technologie d'apprentissage automatique à la gestion des ressources humaines, à prendre des décisions efficaces via les réseaux de neurones et à prédire avec précision les résultats de la gestion des ressources humaines.

Cet article présente quatre aspects de l'application de l'apprentissage automatique à la recherche sur la gestion des ressources humaines, notamment les difficultés techniques, l'introduction aux systèmes de prise de décision en matière de gestion des ressources humaines, les méthodes de conception de systèmes et la sécurité des systèmes. recherche connexe.

Difficultés techniques

En 2019, les PDG de 20 grandes entreprises aux États-Unis ont organisé des séminaires pertinents. Les résultats ont montré que l'application de la technologie d'apprentissage automatique est confrontée à des défis uniques dans le domaine de la gestion des ressources humaines. Le développement de systèmes décisionnels utiles en matière de GRH présente non seulement des défis techniques, mais également des obstacles à la gestion de la complexité inhérente aux résultats de la GRH, ainsi que des données difficiles à traiter, des contraintes éthiques et juridiques et des préoccupations concernant les employés concernés ou d'autres parties prenantes. processus que certains estiment controversé. Les décisions de gestion des ressources humaines doivent éviter les procédures de sélection susceptibles de faire l’objet de contestations judiciaires ou considérées comme controversées par les employés ou d’autres parties prenantes.

Le résumé présente les aspects suivants :

- Comment établir et superviser une série de projets de recherche et développement pour explorer l'application de l'apprentissage automatique dans la gestion des ressources humaines ;

- Comment développer efficacement des systèmes d'aide à la décision basés sur la PNL ; Comment tester les systèmes d'aide à la décision pour confirmer qu'ils peuvent être utilisés en toute sécurité dans la prise de décision ;

- Comment réussir à convertir les systèmes en utilisations acceptables une fois qu'ils ont été développés et testés.

- Le système doit-il automatiser la prise de décision, fournir une contribution aux décideurs humains, ou autrement interagir avec le processus de prise de décision ?

- De quelles informations les décideurs humains ont-ils besoin et dans quelle mesure les systèmes d'apprentissage automatique candidats sont-ils efficaces pour fournir ces informations ?

- Compte tenu du niveau de fonctionnalité actuellement disponible dans les différents systèmes candidats, quels sont les risques des différents types d'aide à la décision ?

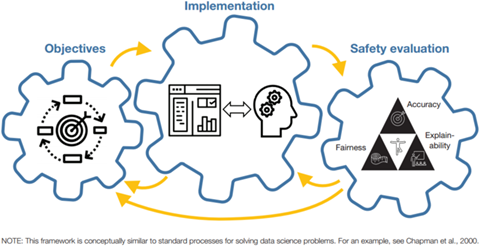

Figure Cadre du système d'apprentissage automatique

Figure Cadre du système d'apprentissage automatique

Photo

Photo

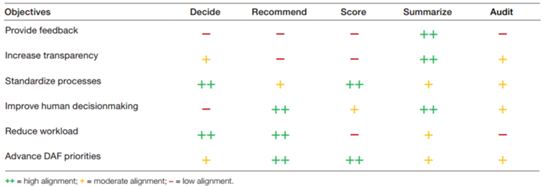

Les systèmes d'apprentissage automatique qui résument automatiquement les enregistrements narratifs peuvent servir de modèle d'aide à la décision. La plupart des dossiers RH d'une personne sont divisés en deux types de texte libre et d'attributs de personne. Texte de forme libre tel que des listes de tâches, des descriptions de responsabilités et des résumés des principales réalisations. Les attributs du personnel sont des données pré-quantifiées, interprétables et utiles à la gestion, telles que les années d'expérience, l'ordre de mérite ou les résultats des tests de promotion. Bien que ce dernier type d’informations soit plus facile à traiter et à utiliser dans des modèles ou des visualisations, le premier type d’informations est également nécessaire pour prendre des décisions pleinement éclairées en matière de gestion des ressources humaines.

Les décisions de traitement de gestion nécessitent un examen réfléchi des dossiers et un processus d'examen manuel ou de notation par un personnel expérimenté. Parmi les différentes implémentations de conception considérées pour prendre en charge la révision manuelle, le « résumé » est la plus polyvalente. Il s’agit de la seule conception qui soit modérément ou hautement cohérente avec tous les objectifs de gestion des ressources humaines. Les résumés automatisés sont utiles pour fournir des commentaires, accroître la transparence et améliorer la précision de la prise de décision humaine, et ils sont au moins quelque peu utiles pour standardiser et réduire la charge de travail manuelle. Dans le même temps, la mise en œuvre sommaire maintient un degré élevé de contrôle manuel sur le processus de prise de décision, de sorte qu'elle est plus susceptible que d'autres conceptions de répondre aux normes de sécurité. En effet, le résumé met en évidence les éléments du texte que le système juge importants et constitue donc une explication des décisions du système. Par conséquent, les résumés peuvent constituer une aide utile pour aider les gestionnaires à comprendre les résultats du modèle dans d’autres implémentations de conception.

Sécurité du système

Les décisions en matière de gestion des ressources humaines sont une force vitale qui affecte l'avenir de l'entreprise. Par conséquent, le principe « ne pas nuire » doit être adopté lors de changements importants dans le processus décisionnel. À mesure que les investissements dans l’apprentissage automatique augmentent, une multitude de documents de recherche et de politiques visent à fournir des orientations normatives pour une utilisation responsable et éthique de l’apprentissage automatique (et de l’intelligence artificielle en général).

Par exemple, les règles et cadres existants visant à protéger la vie privée des membres continueront de s'appliquer à tout projet de développement. Lors du développement et du déploiement, trois principes sont particulièrement pertinents pour tester les systèmes, qui nécessitent que les systèmes d'apprentissage automatique soient précis, équitables et interprétables :

La précision signifie qu'un système d'apprentissage automatique ou le modèle qu'il contient prédit correctement l'intérêt avec une forte probabilité de résultat de.

L'équité signifie que le système d'apprentissage automatique traite les sous-groupes de manière égale.

L'explicabilité signifie que les humains peuvent comprendre les facteurs et les relations qui conduisent aux résultats d'un système d'apprentissage automatique.

Ces normes de sécurité entrent parfois en conflit les unes avec les autres. Pour accroître l'équité, les concepteurs peuvent imposer des limitations au système qui réduisent sa précision ou son interprétabilité. Pour accroître l'interprétabilité, les concepteurs de systèmes peuvent utiliser des méthodes de modélisation plus interprétables (mais moins flexibles), ce qui peut avoir un impact sur la précision et l'équité. Les tests doivent inclure un équilibre entre l'exactitude, l'équité et l'interprétabilité pour arriver à une conception qui répond aux objectifs de gestion des ressources humaines ainsi qu'aux contraintes juridiques et éthiques.

Concernant l'équité, il est important de noter qu'il n'existe pas de définition unique de l'équité, et qu'il est souvent impossible de satisfaire des types d'équité compétitifs. Par conséquent, les agences doivent choisir une définition pour procéder aux tests. Une distinction est faite ici entre l'équité procédurale, qui garantit qu'un processus ou un algorithme de gestion des ressources humaines traite les membres de différents sous-groupes de manière égale, et l'équité des résultats, qui vérifie si le résultat d'un modèle ou d'un processus est biaisé.

Enfin, l’explicabilité est essentielle pour atteindre les objectifs de GRH, car les gens peuvent ignorer ou abuser du système s’ils ne comprennent pas comment il contribue à une meilleure prise de décision. De plus, la définition de l’explicabilité est indissociable du public cible, car différents types d’utilisateurs nécessitent différents niveaux d’explication. Les concepteurs peuvent envisager d'utiliser des modèles intrinsèquement interprétables pour augmenter l'interprétabilité, et ils peuvent également effectuer des tests humains dans la boucle pour évaluer dans quelle mesure les gens comprennent les fonctionnalités du système.

Petit résumé

Cet article présente principalement brièvement la recherche sur l'apprentissage automatique dans le domaine de la gestion des ressources humaines sous quatre aspects : les difficultés techniques, l'introduction aux systèmes décisionnels en matière de gestion des ressources humaines, les méthodes de conception de systèmes et la sécurité des systèmes. Nous espérons qu'il pourra être utile aux lecteurs qui souhaitent avoir une compréhension préliminaire de cette recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

En termes simples, un modèle d’apprentissage automatique est une fonction mathématique qui mappe les données d’entrée à une sortie prédite. Plus précisément, un modèle d'apprentissage automatique est une fonction mathématique qui ajuste les paramètres du modèle en apprenant à partir des données d'entraînement afin de minimiser l'erreur entre la sortie prédite et la véritable étiquette. Il existe de nombreux modèles dans l'apprentissage automatique, tels que les modèles de régression logistique, les modèles d'arbre de décision, les modèles de machines à vecteurs de support, etc. Chaque modèle a ses types de données et ses types de problèmes applicables. Dans le même temps, il existe de nombreux points communs entre les différents modèles, ou il existe une voie cachée pour l’évolution du modèle. En prenant comme exemple le perceptron connexionniste, en augmentant le nombre de couches cachées du perceptron, nous pouvons le transformer en un réseau neuronal profond. Si une fonction noyau est ajoutée au perceptron, elle peut être convertie en SVM. celui-ci

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Cet article présentera comment identifier efficacement le surajustement et le sous-apprentissage dans les modèles d'apprentissage automatique grâce à des courbes d'apprentissage. Sous-ajustement et surajustement 1. Surajustement Si un modèle est surentraîné sur les données de sorte qu'il en tire du bruit, alors on dit que le modèle est en surajustement. Un modèle surajusté apprend chaque exemple si parfaitement qu'il classera mal un exemple inédit/inédit. Pour un modèle surajusté, nous obtiendrons un score d'ensemble d'entraînement parfait/presque parfait et un score d'ensemble/test de validation épouvantable. Légèrement modifié : "Cause du surajustement : utilisez un modèle complexe pour résoudre un problème simple et extraire le bruit des données. Parce qu'un petit ensemble de données en tant qu'ensemble d'entraînement peut ne pas représenter la représentation correcte de toutes les données."

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

Dans les années 1950, l’intelligence artificielle (IA) est née. C’est à ce moment-là que les chercheurs ont découvert que les machines pouvaient effectuer des tâches similaires à celles des humains, comme penser. Plus tard, dans les années 1960, le Département américain de la Défense a financé l’intelligence artificielle et créé des laboratoires pour poursuivre son développement. Les chercheurs trouvent des applications à l’intelligence artificielle dans de nombreux domaines, comme l’exploration spatiale et la survie dans des environnements extrêmes. L'exploration spatiale est l'étude de l'univers, qui couvre l'ensemble de l'univers au-delà de la terre. L’espace est classé comme environnement extrême car ses conditions sont différentes de celles de la Terre. Pour survivre dans l’espace, de nombreux facteurs doivent être pris en compte et des précautions doivent être prises. Les scientifiques et les chercheurs pensent qu'explorer l'espace et comprendre l'état actuel de tout peut aider à comprendre le fonctionnement de l'univers et à se préparer à d'éventuelles crises environnementales.

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

MetaFAIR s'est associé à Harvard pour fournir un nouveau cadre de recherche permettant d'optimiser le biais de données généré lors de l'apprentissage automatique à grande échelle. On sait que la formation de grands modèles de langage prend souvent des mois et utilise des centaines, voire des milliers de GPU. En prenant comme exemple le modèle LLaMA270B, sa formation nécessite un total de 1 720 320 heures GPU. La formation de grands modèles présente des défis systémiques uniques en raison de l’ampleur et de la complexité de ces charges de travail. Récemment, de nombreuses institutions ont signalé une instabilité dans le processus de formation lors de la formation des modèles d'IA générative SOTA. Elles apparaissent généralement sous la forme de pics de pertes. Par exemple, le modèle PaLM de Google a connu jusqu'à 20 pics de pertes au cours du processus de formation. Le biais numérique est à l'origine de cette imprécision de la formation,

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.