Périphériques technologiques

Périphériques technologiques

IA

IA

Les performances des petits modèles sont saturées et les performances sont médiocres. La cause première est Softmax ?

Les performances des petits modèles sont saturées et les performances sont médiocres. La cause première est Softmax ?

Les performances des petits modèles sont saturées et les performances sont médiocres. La cause première est Softmax ?

L'émergence de petits modèles de langage vise à compenser les inconvénients d'une formation coûteuse et de l'inférence de grands modèles de langage, mais elle a aussi le fait que ses performances diminuent après l'entraînement jusqu'à un certain stade (phénomène de saturation), donc la raison car ce phénomène est quoi ? Peut-il être surmonté et exploité pour améliorer les performances des petits modèles de langage ?

Les derniers progrès dans le domaine de la modélisation du langage résident dans le pré-entraînement de réseaux de neurones hautement paramétrés sur des corpus de textes Web à très grande échelle. En pratique, l’utilisation d’un tel modèle pour la formation et l’inférence peut s’avérer coûteuse, ce qui incite à utiliser des modèles alternatifs plus petits. Cependant, il a été observé que les modèles plus petits peuvent souffrir d'une saturation et d'un phénomène caractérisé par une diminution des capacités et un plateau à un stade avancé de la formation.

Un article récent a révélé que ce phénomène de somme de saturation peut s'expliquer par un décalage entre la dimensionnalité latente des modèles plus petits et le rang élevé de la distribution de probabilité du contexte cible. Cette inadéquation affecte les performances des têtes de prédiction linéaire utilisées dans ces modèles en exploitant les performances des modèles appelés goulots d'étranglement softmax.

Lien papier : https://arxiv.org/pdf/2404.07647.pdf

Cet article mesure l'impact du goulot d'étranglement softmax dans différents contextes et constate que les modèles basés sur moins de 1000 dimensions cachées ont tendance à être pré Les représentations latentes dégénérées formées sont adoptées à un stade ultérieur, ce qui entraîne une réduction des performances d'évaluation.

Introduction

Le problème de dégradation de la représentation est un phénomène courant qui affecte divers modes tels que les méthodes d'apprentissage auto-supervisées de données textuelles. Les observations de représentations intermédiaires de modèles de langage révèlent leur variabilité à faible angle (ou anisotropie) ou des dimensions inhabituelles qui surviennent au cours de l'entraînement. Cependant, ces observations sont majoritairement réalisées sur des modèles à relativement petite échelle et aux dimensions comparables aux modèles familiaux tels que le BERT ou le GPT-2.

Ces modèles consistent généralement en un réseau neuronal f_θ qui accepte une séquence de jetons :

et génère une représentation de contexte relativement basse dimensionnelle dans R^d, où d est la dimension cachée du modèle. Ils s’appuient ensuite sur une tête de modélisation du langage qui produit le logarithme des probabilités des jetons de contexte. Un choix courant pour une tête de modélisation de langage est une couche linéaire avec des paramètres W ∈ R^(V×d), où V est le nombre de jetons possibles. Ainsi, la distribution de probabilité résultante pour le prochain jeton est  où σ est la fonction softmax.

où σ est la fonction softmax.

Dans le domaine de la modélisation du langage, la tendance actuelle est d'étendre la méthode de pré-entraînement génératif introduite par GPT-2, ce qui signifie entraîner des modèles neuronaux composés de milliards de paramètres sur un énorme corpus de texte Web. Cependant, la formation et l'application de ces modèles hautement paramétrés soulèvent des problèmes liés à l'énergie et au matériel, ce qui nécessite de trouver des moyens d'atteindre des niveaux de performances similaires avec des modèles plus petits.

Cependant, l'évaluation de la suite de modèles Pythia montre que l'entraînement de petits modèles sur de très grands corpus peut conduire à une saturation, se manifestant par une dégradation des performances tard dans la pré-entraînement. Cet article explore ce phénomène de saturation à travers le prisme de la dégradation de la représentation et constate qu'il existe une forte corrélation entre les deux phénomènes, tout en démontrant en outre que la dégradation de la représentation se produit dans les têtes de modélisation linguistique des petits modèles et a été démontrée à la fois théoriquement et empiriquement ci-dessus. comment les en-têtes de modélisation de langage linéaire peuvent devenir un goulot d'étranglement en termes de performances pour les architectures basées sur de petites dimensions cachées.

Phénomène de saturation du modèle linguistique

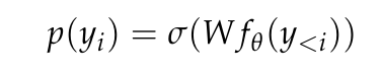

Cet article vérifie d'abord que la saturation des performances des points de contrôle Pythia peut effectivement être observée et quantifiée, car ce sont les seuls points de contrôle intermédiaires publiés pour une gamme de tailles de modèles. Cet article mesure l'entropie croisée des points de contrôle Pythia sur 50 000 jetons échantillonnés aléatoirement à partir de leur ensemble de données de pré-entraînement (c'est-à-dire The Pile).

On voit clairement sur la figure 1a que même le modèle à 410 millions de paramètres rencontre une saturation, se manifestant par une augmentation de la perte dans le domaine au stade de la formation avancée.

Dans la figure 1b, cet article ajuste les points de données du modèle à partir de 410 millions de paramètres selon la méthode de Hoffmann et al (2022), et optimise uniquement les constantes liées au modèle (A et α). , Tout en réutilisant toutes les autres valeurs (B = 410,7, β = 0,28, E = 1,69). Nous passons ici en revue la relation entre le nombre de paramètres N et le nombre de jetons T donnée par Hoffmann et al (2022) :

Cet article a révélé que les paramètres optimaux sont A = 119,09 et α = 0,246. Les auteurs montrent des courbes ajustées du nombre de jetons correspondant aux points de contrôle optimaux et finaux. On peut observer que la performance du point de contrôle final est en moyenne inférieure d’environ 8 % à la valeur extrapolée. Le point de contrôle de minimisation des pertes (optimal) devrait être inférieur à celui de la méthode d'extrapolation en raison d'un refroidissement incomplet du taux d'apprentissage, mais ses performances ne sont qu'environ 4 % inférieures à celles de la méthode d'extrapolation.

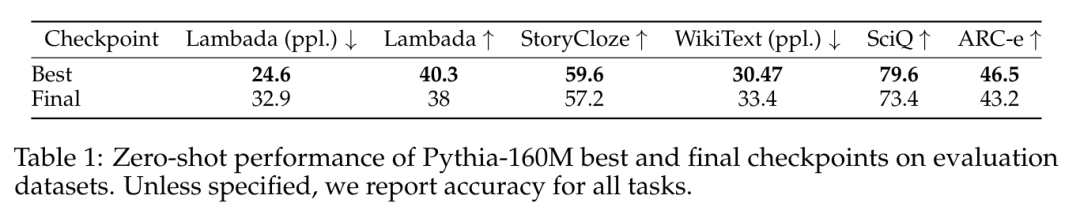

Un phénomène similaire de saturation des performances a également été observé dans l'ensemble de données utilisé pour l'évaluation de l'outil d'évaluation du modèle de langage (LM Evaluation Harness), comme le montre le tableau 1.

La saturation des performances est la saturation du rang

Anisotropie d'échelle

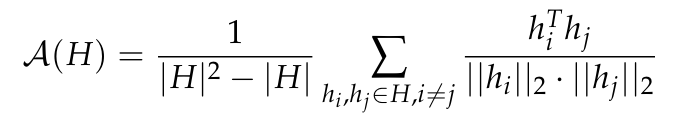

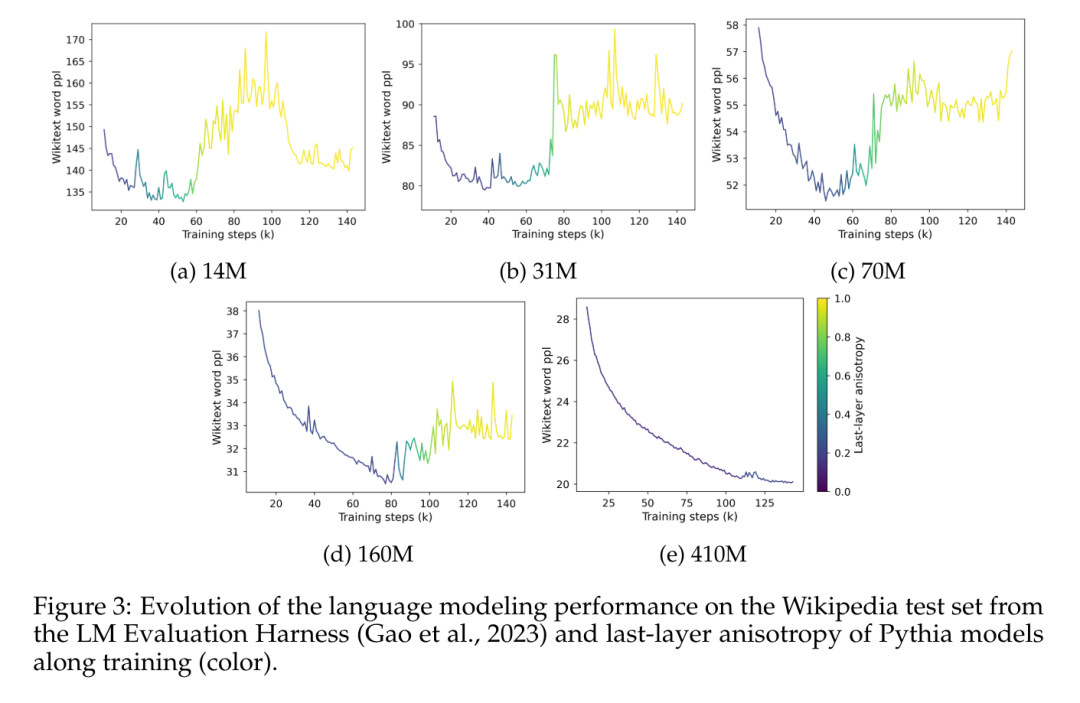

L'anisotropie est une forme courante de dégradation de la représentation observée dans divers petits modèles de langage. Elle comprend une réduction de la variabilité angulaire de la distribution de la représentation dans un domaine spécifique. couche. Des recherches antérieures (Ethayarajh, 2019 ; Godey et al., 2024) ont noté que presque toutes les couches de petits modèles de langage déformés sont anisotropes. Une manière courante de mesurer l'anisotropie dans un ensemble de représentations vectorielles H est la similarité cosinus moyenne :

Cependant, il n'est pas clair si l'anisotropie affecte les modèles avec plus d'un milliard de paramètres. Pour résoudre ce problème, cet article calcule la similarité cosinusoïdale moyenne entre les couches pour une série de représentations intermédiaires modèles, à savoir GPT-2, OPT, Pythia et Gemma ; Cet article utilise un sous-échantillon de The Pile car il est supposé que le domaine de cet ensemble de données inclut ou correspond au domaine des ensembles de données pré-entraînés utilisés dans ces suites.

Dans la figure 2, on peut observer que la plupart des couches de la plupart des modèles Transformer sont dans une certaine mesure anisotropes, quelle que soit leur échelle. Cependant, il semble y avoir une dichotomie dans la dernière couche, où le modèle est soit presque isotrope, soit fortement anisotrope. Cet article note que cette dichotomie est cohérente avec l'un des phénomènes de saturation de la suite Pythia, où seuls les modèles comportant 160 millions de paramètres ou moins sont affectés par l'anisotropie de la dernière couche.

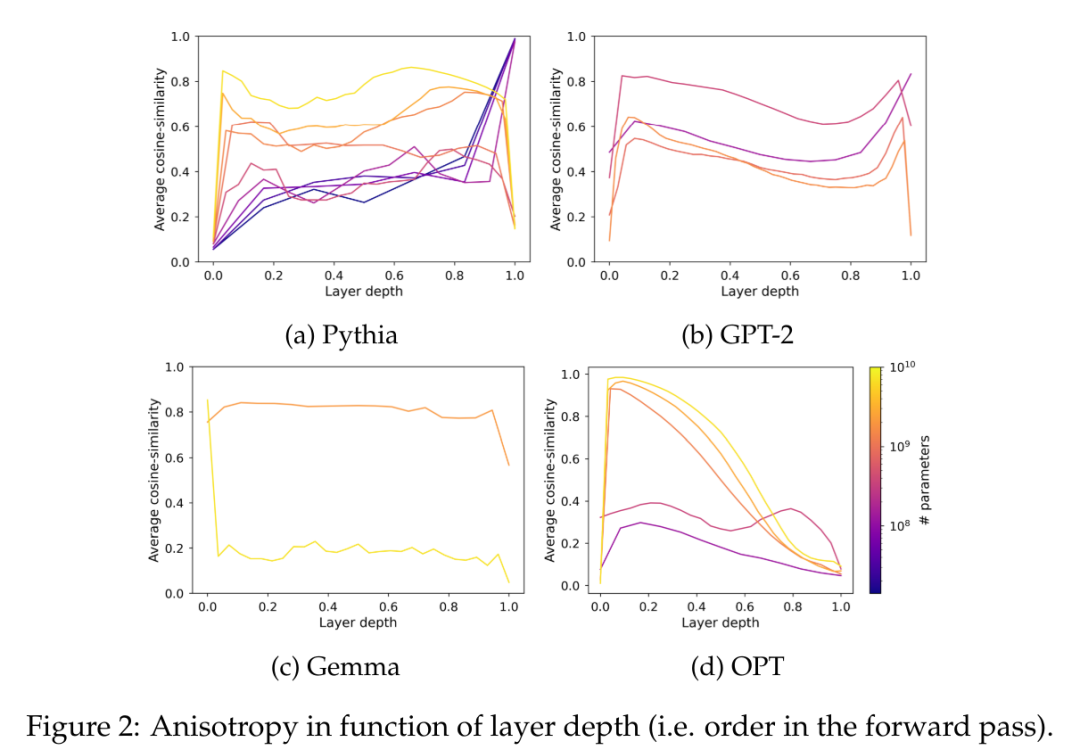

Cet article étudie la dynamique d'entraînement de l'anisotropie dans la suite Pythia et la compare au phénomène de saturation de la figure 3.

La figure 3 démontre clairement la corrélation claire entre l'émergence de la saturation des performances et l'émergence de l'anisotropie dans la représentation de la dernière couche du modèle. Il montre également une augmentation soudaine de l’anisotropie près du point de saturation pendant l’entraînement. Ce que l’on observe ici, c’est qu’au sein d’un corpus spécifique dans un domaine, le modèle perd rapidement ses performances en cas de saturation et ne semble jamais se remettre complètement de cette explosion.

Saturation des valeurs singulières

La similarité moyenne du cosinus est une mesure précieuse de l'uniformité de la distribution, mais l'inclusion d'autres mesures peut aider à mieux capturer la complexité de certaines variétés. De plus, il se concentre uniquement sur les intégrations de sortie du modèle de langage et non sur leurs poids. Cette section étend l'analyse de cet article en étudiant la distribution de valeurs singulières des têtes de modélisation du langage pour relier les observations empiriques aux conclusions théoriques de cet article.

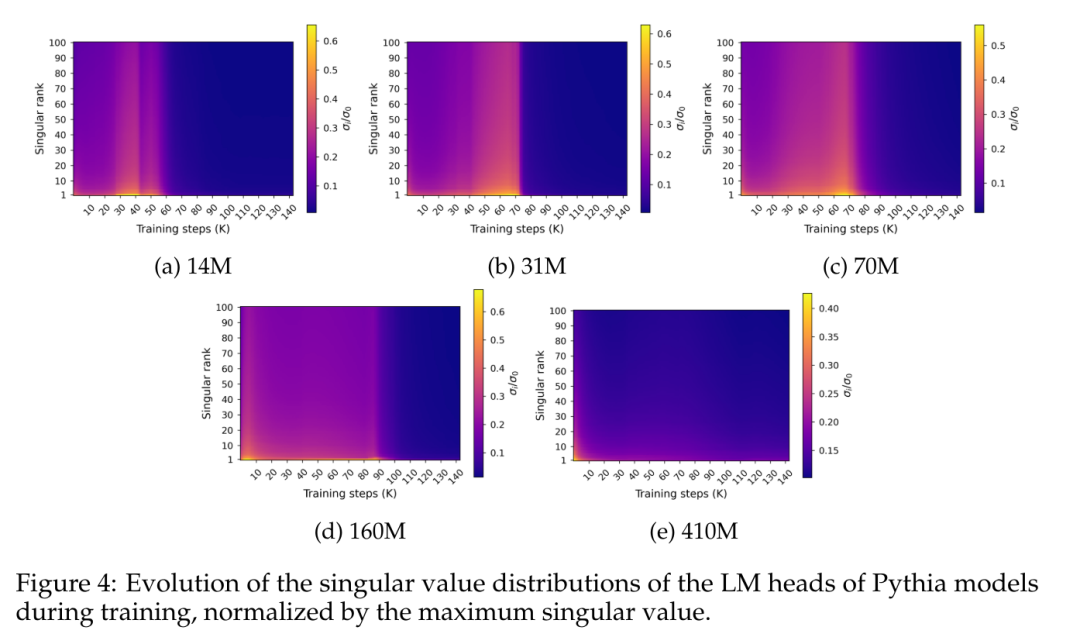

La figure 4 montre la distribution des valeurs singulières le long du poids W de la couche de prédiction finale pendant l'entraînement :

La figure 4 révèle un modèle spécifique de saturation spectrale qui se produit approximativement simultanément avec la saturation des performances. La figure montre que la distribution des valeurs singulières s'aplatit progressivement au cours du processus de formation, atteignant presque l'uniformité, puis évolue soudainement vers une distribution en pointes avec la plus grande valeur singulière relativement élevée par rapport aux autres distributions.

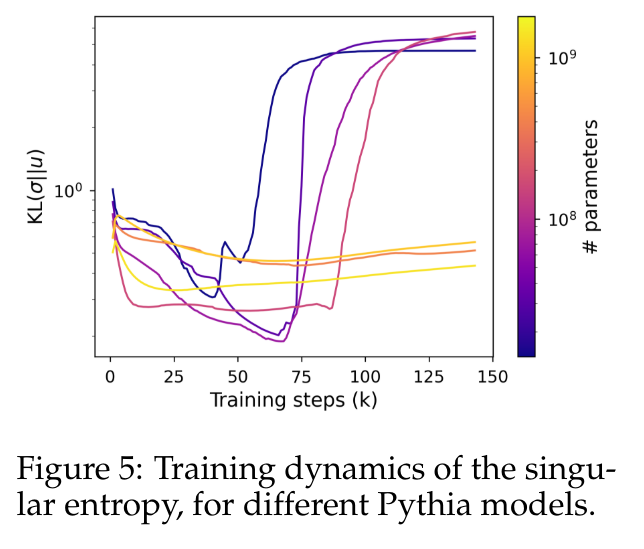

Pour quantifier ce comportement avec plus de précision, cet article utilise la métrique d'entropie singulière, calculée comme la divergence de Kullback-Leibler entre la distribution normalisée des valeurs singulières et la distribution uniforme.

La figure 5 montre comment la distribution singulière évolue différemment pour un modèle utilisant moins de 410 millions de paramètres par rapport à un modèle utilisant des paramètres plus grands. Les têtes de petits modèles voient leurs distributions de valeurs singulières devenir progressivement plus uniformes, jusqu'à ce qu'elles se dégradent soudainement, ce qui est là encore en corrélation avec une dégradation des performances du modèle de langage. La distribution des valeurs singulières des modèles plus grands a tendance à être plus stable et ne présente pas de modèle monotone évident tout au long de la formation.

Gout d'étranglement de Softmax et dimension du langage

Dimension intrinsèque du langage naturel

Intuitivement parlant, le phénomène de saturation de la distribution de valeurs singulières observé ci-dessus ne s'applique qu'aux modèles plus petits, ce qui pose problème pour la tête LM. Les dimensions impliqués dans l’optimisation ont été interrogés. Cette section propose de mesurer empiriquement la valeur critique du rang d'un responsable LM et d'estimer les dimensions de la distribution de probabilité contextuelle à laquelle devrait correspondre la sortie de ce responsable.

Pour mesurer empiriquement l'impact du classement linéaire des chefs, cet article propose de former un chef restreint au rang sur des représentations contextuelles pré-entraînées dérivées de modèles de langage hautement paramétrés. Pour contrôler le rang maximum r, considérons une tête de la forme W = AB ∈ R^(V×d), où les coefficients de A ∈ R^(V×r) et B ∈ R^(r×d) partent de N(0 ,1) extrait (d est la dimension cachée du modèle). Le rang de cette matrice W est balayé sur une plage de valeurs contrainte par le paramètre r ∈ [1, d].

En gelant le modèle linguistique et en formant le responsable restreint au rang sur environ 150 millions de jetons tout en ajustant le taux d'apprentissage en fonction du nombre de paramètres pouvant être entraînés.

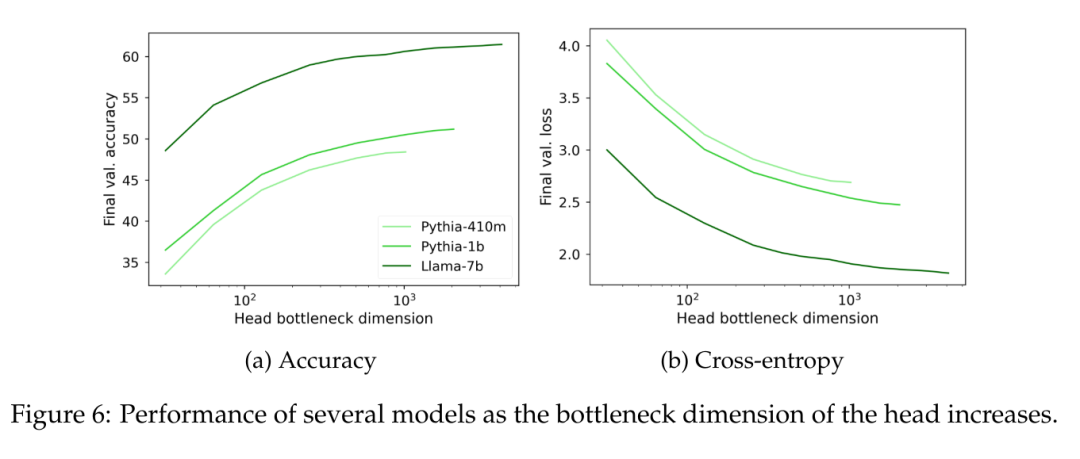

On peut observer sur la figure 6 que quelle que soit la taille du modèle, lorsque le rang de la tête de modélisation du langage W tombe en dessous de 1000, la perplexité commence à diminuer de manière significative. Cela implique que pour les modèles avec des dimensions cachées plus grandes, la tête ne constitue pas un goulot d'étranglement majeur en termes de performances, mais pour les modèles avec des dimensions cachées plus petites, elle peut nuire aux performances indépendamment de la qualité de la représentation de sortie.

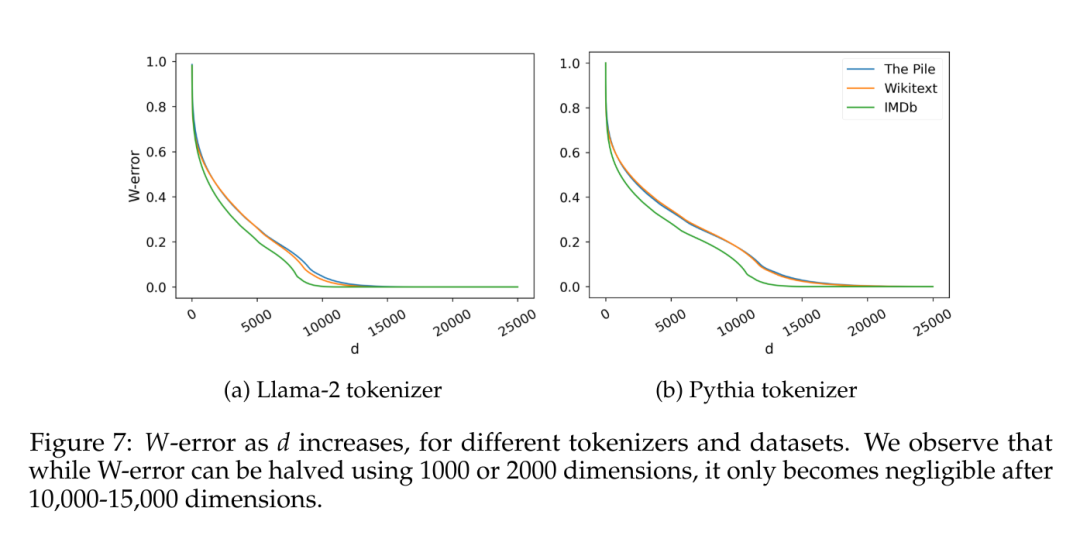

Un autre facteur intéressant est la dimensionnalité inhérente aux données estimées elles-mêmes. Afin d'éviter d'éventuels effets liés à un biais inductif spécifique, cet article a formé un modèle de langage naïf de 5 grammes sur plusieurs ensembles de données avec une couverture différente (IMDb, Wikitext et The Pile), en utilisant deux tailles de vocabulaire différentes Tokenizer (30 000 jetons pour. Llama-2, 50 000 jetons pour la Pythie). Étant donné C observé 5 grammes, cet article considère la matrice W ∈ R^(C×V), où chaque ligne est la distribution de probabilité de jetons possibles étant donné 4 jetons, et calcule leurs distributions de valeurs singulières, comme Terashima (2003).

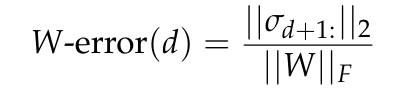

La figure 7 rapporte l'erreur W, l'erreur d'approximation minimale pour une matrice W de rang d prédite par le théorème d'Eckart-Young-Mirsky (voir Lemme 5.2) et normalisée à la norme de Frobenius de W.

Goulot d'étranglement théorique

Dans le même temps, le rang estimé de W ne peut être ignoré par rapport à l'ordre de grandeur conventionnel des dimensions cachées. Ici, nous analyserons le lien entre les dimensions et les performances d'une tête de modélisation de langage linéaire idéale d'un point de vue théorique.

Cette section vise à identifier un lien formel entre les dimensions inhérentes aux distributions de contexte et les goulots d'étranglement des performances qui peuvent être attribués à la dimensionnalité inférieure des représentations de sortie du modèle de langage. À cette fin, une tête de modélisation de langage optimisée sur une représentation de contexte idéal est conçue, et la relation entre ses propriétés spectrales et l'écart de performance qui apparaît lors de la formation d'une tête de rang inférieur sur la même représentation est explorée.

Pour plus de détails sur la recherche, veuillez consulter l’article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

L'auteur de ControlNet a encore un succès ! L'ensemble du processus de génération d'une peinture à partir d'une image, gagnant 1,4k étoiles en deux jours

Jul 17, 2024 am 01:56 AM

L'auteur de ControlNet a encore un succès ! L'ensemble du processus de génération d'une peinture à partir d'une image, gagnant 1,4k étoiles en deux jours

Jul 17, 2024 am 01:56 AM

Il s'agit également d'une vidéo Tusheng, mais PaintsUndo a emprunté une voie différente. L'auteur de ControlNet, LvminZhang, a recommencé à vivre ! Cette fois, je vise le domaine de la peinture. Le nouveau projet PaintsUndo a reçu 1,4kstar (toujours en hausse folle) peu de temps après son lancement. Adresse du projet : https://github.com/lllyasviel/Paints-UNDO Grâce à ce projet, l'utilisateur saisit une image statique et PaintsUndo peut automatiquement vous aider à générer une vidéo de l'ensemble du processus de peinture, du brouillon de ligne au suivi du produit fini. . Pendant le processus de dessin, les changements de lignes sont étonnants. Le résultat vidéo final est très similaire à l’image originale : jetons un coup d’œil à un dessin complet.

Du RLHF au DPO en passant par TDPO, les algorithmes d'alignement des grands modèles sont déjà « au niveau des jetons »

Jun 24, 2024 pm 03:04 PM

Du RLHF au DPO en passant par TDPO, les algorithmes d'alignement des grands modèles sont déjà « au niveau des jetons »

Jun 24, 2024 pm 03:04 PM

La colonne AIxiv est une colonne où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com Dans le processus de développement de l'intelligence artificielle, le contrôle et le guidage des grands modèles de langage (LLM) ont toujours été l'un des principaux défis, visant à garantir que ces modèles sont à la fois puissant et sûr au service de la société humaine. Les premiers efforts se sont concentrés sur les méthodes d’apprentissage par renforcement par feedback humain (RL

En tête de liste des ingénieurs logiciels d'IA open source, la solution sans agent de l'UIUC résout facilement les problèmes de programmation réels du banc SWE.

Jul 17, 2024 pm 10:02 PM

En tête de liste des ingénieurs logiciels d'IA open source, la solution sans agent de l'UIUC résout facilement les problèmes de programmation réels du banc SWE.

Jul 17, 2024 pm 10:02 PM

La colonne AIxiv est une colonne où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com Les auteurs de cet article font tous partie de l'équipe de l'enseignant Zhang Lingming de l'Université de l'Illinois à Urbana-Champaign (UIUC), notamment : Steven Code repair ; doctorant en quatrième année, chercheur

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Si la réponse donnée par le modèle d’IA est incompréhensible du tout, oseriez-vous l’utiliser ? À mesure que les systèmes d’apprentissage automatique sont utilisés dans des domaines de plus en plus importants, il devient de plus en plus important de démontrer pourquoi nous pouvons faire confiance à leurs résultats, et quand ne pas leur faire confiance. Une façon possible de gagner confiance dans le résultat d'un système complexe est d'exiger que le système produise une interprétation de son résultat qui soit lisible par un humain ou un autre système de confiance, c'est-à-dire entièrement compréhensible au point que toute erreur possible puisse être trouvé. Par exemple, pour renforcer la confiance dans le système judiciaire, nous exigeons que les tribunaux fournissent des avis écrits clairs et lisibles qui expliquent et soutiennent leurs décisions. Pour les grands modèles de langage, nous pouvons également adopter une approche similaire. Cependant, lorsque vous adoptez cette approche, assurez-vous que le modèle de langage génère

La formation Axiom permet au LLM d'apprendre le raisonnement causal : le modèle à 67 millions de paramètres est comparable au niveau de mille milliards de paramètres GPT-4.

Jul 17, 2024 am 10:14 AM

La formation Axiom permet au LLM d'apprendre le raisonnement causal : le modèle à 67 millions de paramètres est comparable au niveau de mille milliards de paramètres GPT-4.

Jul 17, 2024 am 10:14 AM

Montrez la chaîne causale à LLM et il pourra apprendre les axiomes. L'IA aide déjà les mathématiciens et les scientifiques à mener des recherches. Par exemple, le célèbre mathématicien Terence Tao a partagé à plusieurs reprises son expérience de recherche et d'exploration à l'aide d'outils d'IA tels que GPT. Pour que l’IA soit compétitive dans ces domaines, des capacités de raisonnement causal solides et fiables sont essentielles. La recherche présentée dans cet article a révélé qu'un modèle Transformer formé sur la démonstration de l'axiome de transitivité causale sur de petits graphes peut se généraliser à l'axiome de transitivité sur de grands graphes. En d’autres termes, si le Transformateur apprend à effectuer un raisonnement causal simple, il peut être utilisé pour un raisonnement causal plus complexe. Le cadre de formation axiomatique proposé par l'équipe est un nouveau paradigme pour l'apprentissage du raisonnement causal basé sur des données passives, avec uniquement des démonstrations.

Les articles arXiv peuvent être publiés sous forme de 'barrage', la plateforme de discussion alphaXiv de Stanford est en ligne, LeCun l'aime

Aug 01, 2024 pm 05:18 PM

Les articles arXiv peuvent être publiés sous forme de 'barrage', la plateforme de discussion alphaXiv de Stanford est en ligne, LeCun l'aime

Aug 01, 2024 pm 05:18 PM

acclamations! Qu’est-ce que ça fait lorsqu’une discussion sur papier se résume à des mots ? Récemment, des étudiants de l'Université de Stanford ont créé alphaXiv, un forum de discussion ouvert pour les articles arXiv qui permet de publier des questions et des commentaires directement sur n'importe quel article arXiv. Lien du site Web : https://alphaxiv.org/ En fait, il n'est pas nécessaire de visiter spécifiquement ce site Web. Il suffit de remplacer arXiv dans n'importe quelle URL par alphaXiv pour ouvrir directement l'article correspondant sur le forum alphaXiv : vous pouvez localiser avec précision les paragraphes dans. l'article, Phrase : dans la zone de discussion sur la droite, les utilisateurs peuvent poser des questions à l'auteur sur les idées et les détails de l'article. Par exemple, ils peuvent également commenter le contenu de l'article, tels que : "Donné à".

Une avancée significative dans l'hypothèse de Riemann ! Tao Zhexuan recommande fortement les nouveaux articles du MIT et d'Oxford, et le lauréat de la médaille Fields, âgé de 37 ans, a participé

Aug 05, 2024 pm 03:32 PM

Une avancée significative dans l'hypothèse de Riemann ! Tao Zhexuan recommande fortement les nouveaux articles du MIT et d'Oxford, et le lauréat de la médaille Fields, âgé de 37 ans, a participé

Aug 05, 2024 pm 03:32 PM

Récemment, l’hypothèse de Riemann, connue comme l’un des sept problèmes majeurs du millénaire, a réalisé une nouvelle avancée. L'hypothèse de Riemann est un problème mathématique non résolu très important, lié aux propriétés précises de la distribution des nombres premiers (les nombres premiers sont les nombres qui ne sont divisibles que par 1 et par eux-mêmes, et jouent un rôle fondamental dans la théorie des nombres). Dans la littérature mathématique actuelle, il existe plus d'un millier de propositions mathématiques basées sur l'établissement de l'hypothèse de Riemann (ou sa forme généralisée). En d’autres termes, une fois que l’hypothèse de Riemann et sa forme généralisée seront prouvées, ces plus d’un millier de propositions seront établies sous forme de théorèmes, qui auront un impact profond sur le domaine des mathématiques et si l’hypothèse de Riemann s’avère fausse, alors parmi eux ; ces propositions qui en font partie perdront également de leur efficacité. Une nouvelle percée vient du professeur de mathématiques du MIT, Larry Guth, et de l'Université d'Oxford

Génération vidéo illimitée, planification et prise de décision, diffusion, intégration forcée de la prédiction du prochain jeton et diffusion de la séquence complète

Jul 23, 2024 pm 02:05 PM

Génération vidéo illimitée, planification et prise de décision, diffusion, intégration forcée de la prédiction du prochain jeton et diffusion de la séquence complète

Jul 23, 2024 pm 02:05 PM

Actuellement, les modèles linguistiques autorégressifs à grande échelle utilisant le prochain paradigme de prédiction de jetons sont devenus populaires partout dans le monde. Dans le même temps, un grand nombre d'images et de vidéos synthétiques sur Internet nous ont déjà montré la puissance des modèles de diffusion. Récemment, une équipe de recherche de MITCSAIL (dont Chen Boyuan, doctorant au MIT) a intégré avec succès les puissantes capacités du modèle de diffusion en séquence complète et du prochain modèle de jeton, et a proposé un paradigme de formation et d'échantillonnage : le forçage de diffusion (DF ). Titre de l'article : DiffusionForcing:Next-tokenPredictionMeetsFull-SequenceDiffusion Adresse de l'article : https://