Sans OpenAI, Microsoft pourrait aussi devenir le leader de l'IA !

Médias étrangers L'information a annoncé que Microsoft développait en interne son premier modèle à grande échelle avec 500 milliards de paramètres, MAl-1.

C'est le moment pour Nadella de diriger l'équipe pour faire ses preuves.

Après avoir investi plus de 10 milliards de dollars américains dans OpenAI, Microsoft a obtenu le droit d'utiliser le modèle avancé GPT-3.5/GPT-4, mais après tout, ce n'est pas une solution à long terme.

Même des rumeurs circulaient selon lesquelles Microsoft aurait été réduit à un département informatique d'OpenAI.

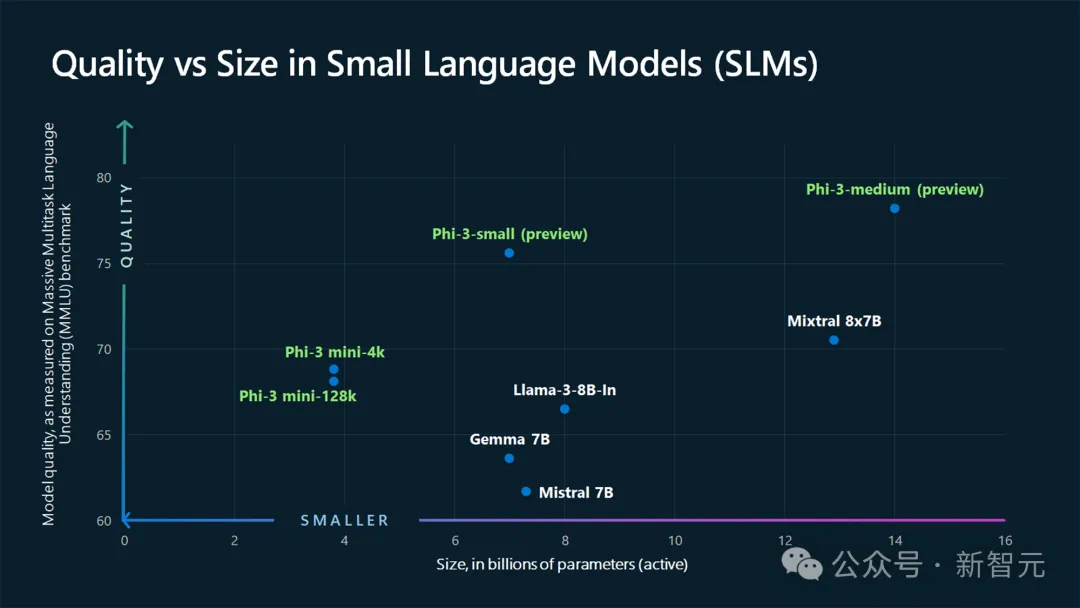

Au cours de la dernière année, comme chacun le sait, les recherches de Microsoft sur LLM se sont principalement concentrées sur la mise à jour de phi à petite échelle, comme l'open source de Phi-3.

Quant à la spécialisation dans les grands modèles, à l'exception de la série Turing, Microsoft n'a dévoilé aucune nouveauté interne.

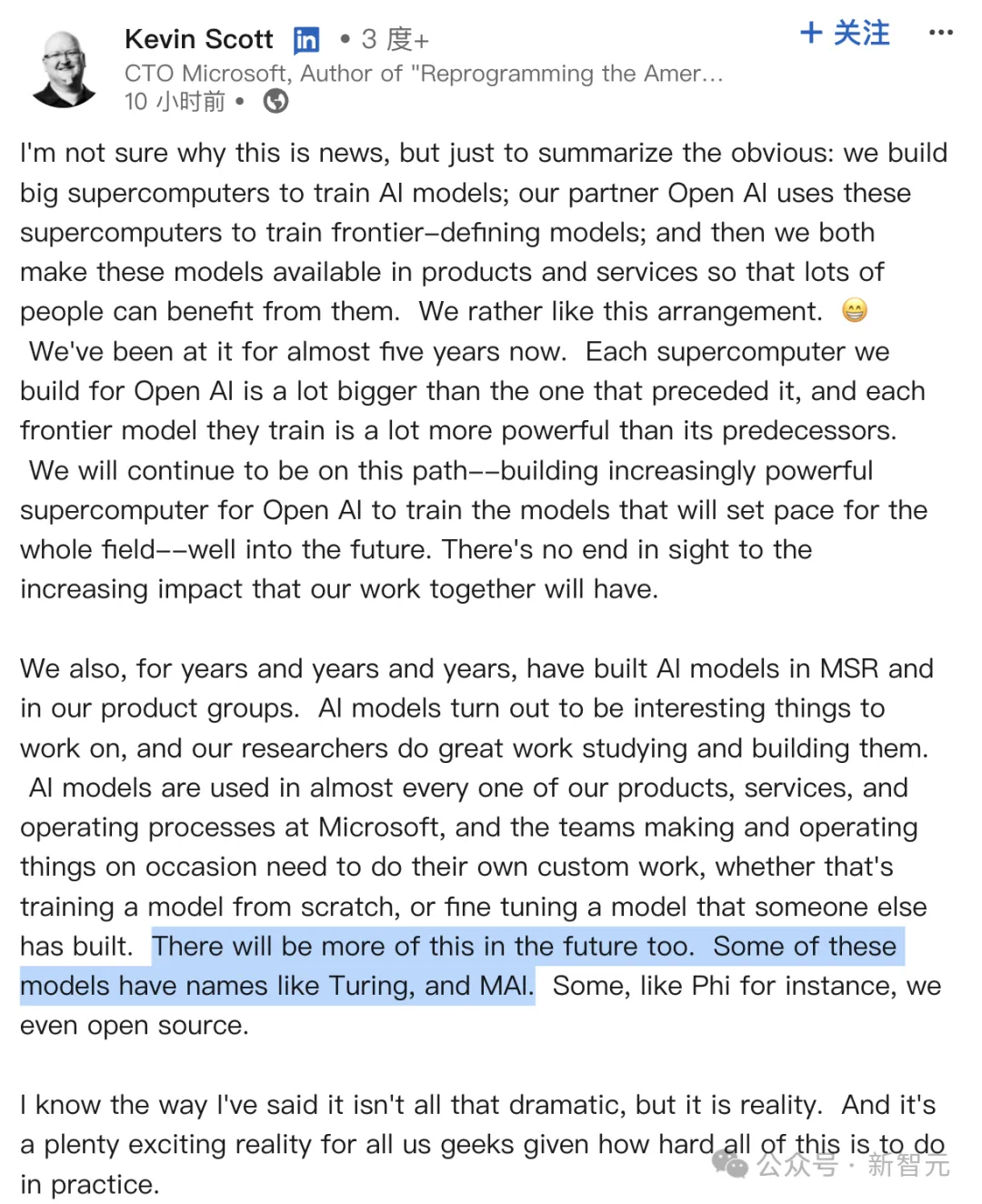

Aujourd'hui encore, Kevin Scott, directeur de la technologie de Microsoft, a confirmé que le grand modèle MAI est effectivement en cours de développement.

De toute évidence, le plan secret de Microsoft pour préparer de grands modèles est de développer un nouveau LLM capable de rivaliser avec les meilleurs modèles d'OpenAI, de Google et d'Anthropic.

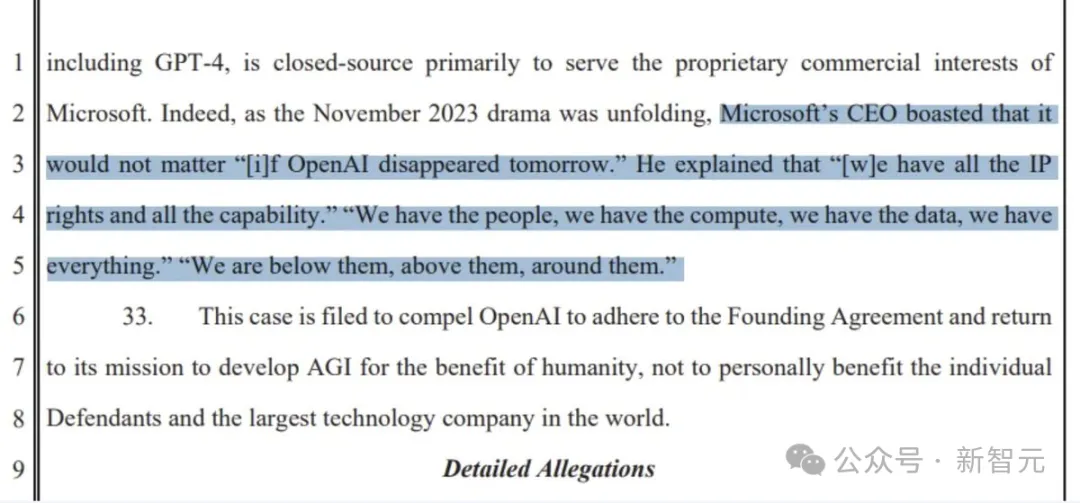

Après tout, Nadella a dit un jour : "Peu importe si OpenAI disparaît demain."

"Nous avons des talents, de la puissance de calcul et des données. Nous ne manquons de rien. Nous sommes en dessous d'eux, au-dessus d'eux et autour d'eux."

Il semble que la confiance de Microsoft soit elle-même.

Selon certaines informations, le grand modèle MAI-1 est supervisé par Mustafa Suleyman, l'ancien patron de Google DeepMind.

Il convient de mentionner qu'avant de rejoindre Microsoft, Suleyman était le fondateur et PDG de la start-up d'IA Inflection AI.

a été fondée en 2022. En un an, il a dirigé l'équipe pour lancer le grand modèle Inflection (actuellement mis à jour vers la version 2.5) et l'assistant IA à haut EQ Pi avec plus d'un million d'utilisateurs quotidiens.

Cependant, faute de trouver le bon modèle économique, Suleyman, un autre Lianchuang et la plupart des employés ont rejoint Microsoft en mars.

En d'autres termes, Suleyman et l'équipe sont responsables de ce nouveau projet MAI-1, et y apporteront plus d'expérience dans les grands modèles de pointe.

Je dois quand même mentionner que le modèle MAI-1 est auto-développé par Microsoft et n'est pas hérité du modèle Inflection.

Selon deux employés de Microsoft, "MAI-1 est différent du modèle précédemment publié par Inflection." Cependant, ses données et techniques de formation peuvent être utilisées dans le processus de formation.

Avec 500 milliards de paramètres, l'échelle des paramètres de MAI-1 dépassera de loin n'importe quel modèle open source à petite échelle formé par Microsoft dans le passé.

Cela signifie également que cela nécessitera plus de puissance de calcul et de données, et que le coût de la formation est également élevé.

Pour entraîner ce nouveau modèle, Microsoft a réservé un grand nombre de serveurs équipés de GPU NVIDIA et a compilé des données d'entraînement pour optimiser le modèle.

Y compris le texte généré à partir de GPT-4, ainsi que divers ensembles de données provenant de sources externes (données publiques Internet).

En comparaison, GPT-4 a été exposé à 1,8 billion de paramètres, et des sociétés d'IA telles que Meta et Mistral ont publié des modèles open source plus petits avec 70 milliards de paramètres.

Bien sûr, Microsoft adopte une stratégie à plusieurs volets, c'est-à-dire que les grands et petits modèles sont développés ensemble.

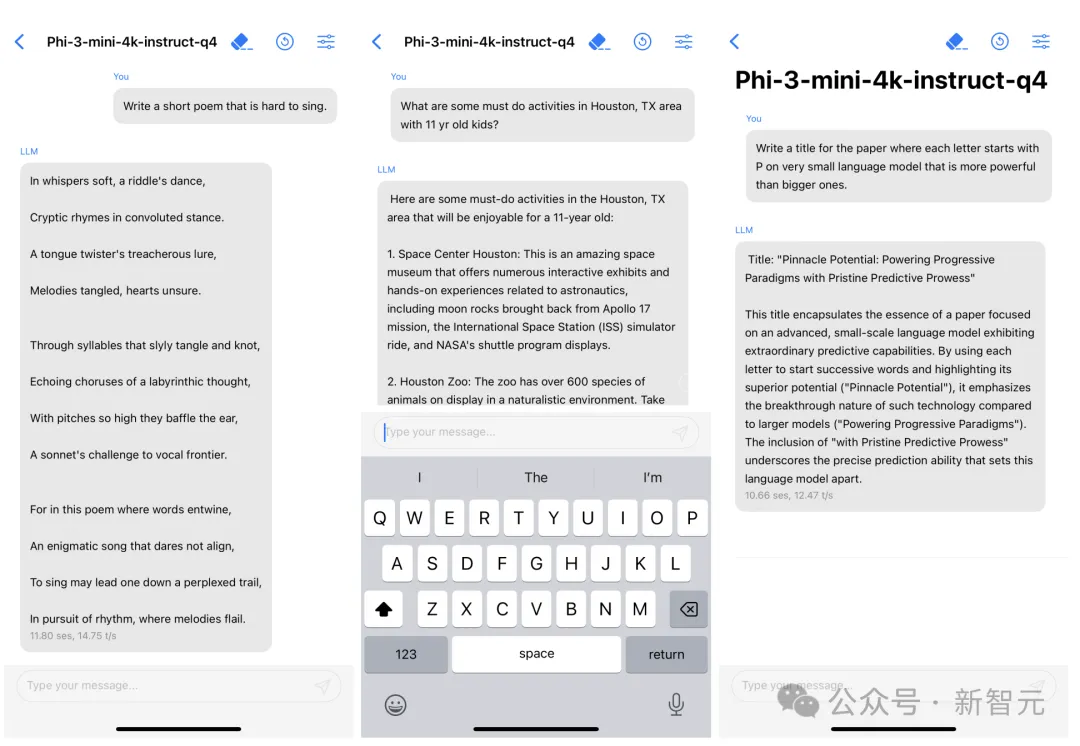

Parmi eux, le plus classique est le Phi-3 - un petit modèle qui peut être inséré dans un téléphone portable, et sa taille minimale de 3,8 Go écrase le GPT-3,5 en performances.

Phi-3 mini n'occupe qu'environ 1,8 Go de mémoire lorsqu'il est quantifié à 4 bits et peut générer 12 jetons par seconde avec l'iPhone14.

Après que les internautes aient soulevé la question "Ne serait-il pas préférable de former l'IA à moindre coût ?", Kevin Scott a répondu :

Ce n'est pas une relation soit l'un soit l'autre. Dans de nombreuses applications d’IA, nous utilisons une combinaison de grands modèles de pointe et de modèles plus petits et plus ciblés. Nous avons effectué beaucoup de travail pour nous assurer que SLM fonctionne correctement à la fois sur les appareils et dans le cloud. Nous avons accumulé beaucoup d'expérience dans la formation SLM, et nous avons même mis en open source une partie de ce travail pour que d'autres puissent l'étudier et l'utiliser. Je pense que cette combinaison de grands et de petits se poursuivra dans un avenir prévisible.

Cela montre que Microsoft doit non seulement développer un SLM à faible coût pouvant être intégré dans des applications et fonctionner sur des appareils mobiles, mais également développer des modèles d'IA plus grands et plus avancés.

Actuellement, Microsoft se qualifie de « société copilote ». Le chatbot Copilot, alimenté par l'IA, peut effectuer des tâches telles que la rédaction d'e-mails et la synthèse rapide de documents.

Et dans le futur, où sont les prochaines opportunités ?

En prenant en compte à la fois les grands et les petits modèles, cela montre que Microsoft, plein d'énergie innovante, est plus disposé à explorer de nouvelles voies en matière d'IA.

Là encore, MAI-1 auto-développé ne signifie pas que Microsoft abandonnera OpenAI.

Le directeur de la technologie, Kevin Scott, a d'abord affirmé la solide « amitié » entre Microsoft et OpenAI depuis cinq ans dans son message de ce matin.

Nous construisons des supercalculateurs à grande échelle pour notre partenaire OpenAI afin de former des modèles d'IA de pointe. Ensuite, les deux sociétés appliqueront ce modèle à leurs propres produits et services pour faire bénéficier davantage de personnes.

De plus, chaque nouvelle génération de supercalculateur sera plus puissante que la génération précédente, donc chaque modèle de pointe formé par OpenAI sera plus avancé que le précédent.

Nous continuerons sur cette voie - en construisant continuellement des supercalculateurs plus puissants afin qu'OpenAI puisse former des modèles qui dirigent l'ensemble du secteur. Notre collaboration aura un impact toujours croissant.

Il y a quelque temps, des médias étrangers ont révélé que Microsoft et OpenAI avaient uni leurs forces pour construire le supercalculateur d'IA "Stargate" et dépenseraient jusqu'à 115 milliards de dollars américains.

On dit que le calcul intensif sera lancé dès 2028 et encore étendu avant 2030.

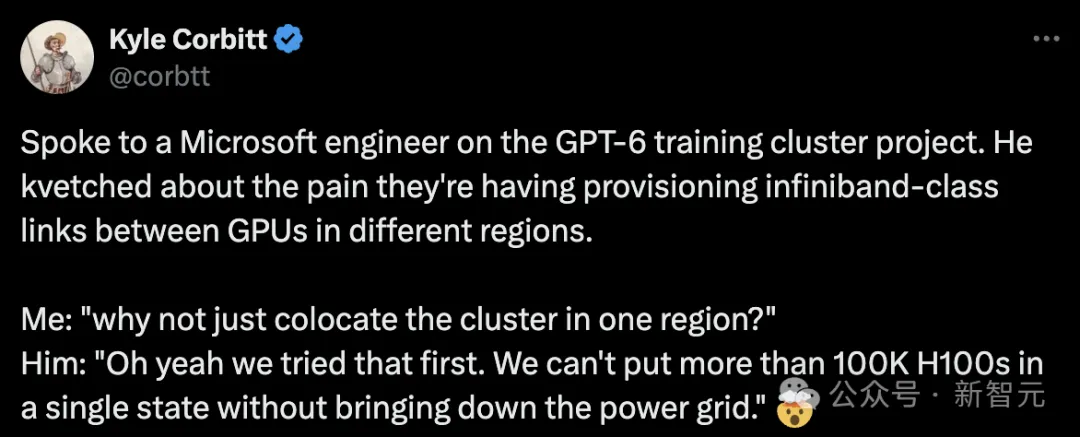

Y compris précédemment, les ingénieurs de Microsoft ont annoncé à l'entrepreneur Kyle Corbitt que Microsoft construisait intensivement 100 000 H100 pour OpenAI afin de former GPT-6.

Divers signes indiquent que la coopération entre Microsoft et OpenAI ne fera que se renforcer.

En outre, Scott a également déclaré : "En plus de la coopération avec OpenAI, Microsoft laisse MSR et diverses équipes de produits développer des modèles d'IA depuis de nombreuses années."

Les modèles d’IA ont pénétré presque tous les produits, services et opérations de Microsoft. Les équipes doivent également parfois effectuer un travail de personnalisation, qu'il s'agisse de former un modèle à partir de zéro ou d'affiner un modèle existant.

Il y aura d'autres situations similaires à l'avenir.

Certains de ces modèles s'appellent Turing, MAI, etc., et certains s'appellent Phi, et nous les avons rendus open source.

Bien que mon expression ne soit peut-être pas si dramatique, c'est la réalité. Pour nous, les geeks, c’est une réalité très excitante étant donné la complexité de la pratique.

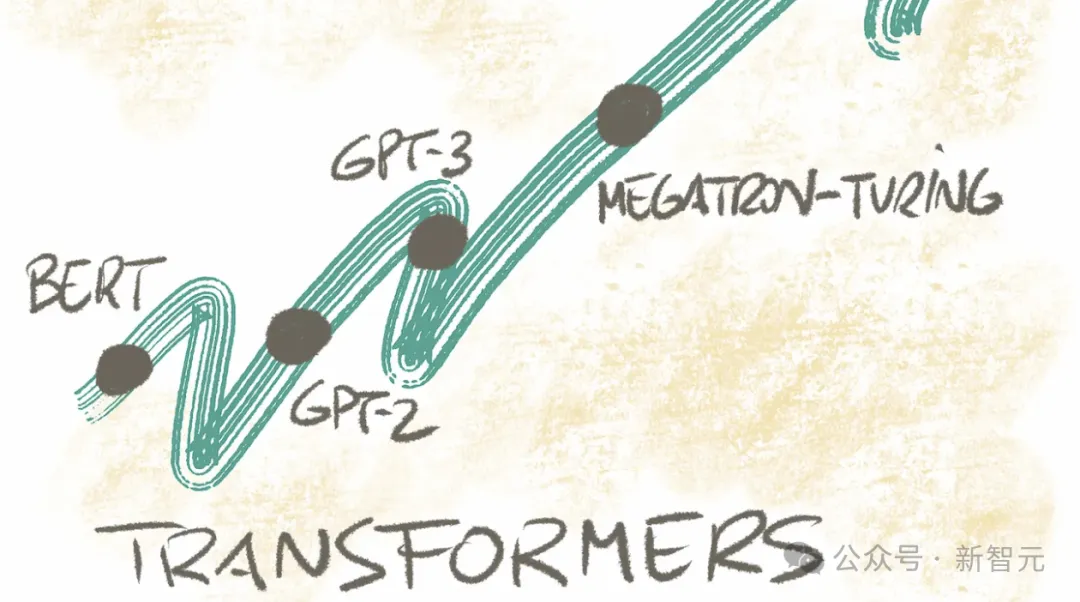

En plus des modèles des séries MAI et Phi, le nom de code "Turing" est un plan lancé en interne par Microsoft en 2017, visant à créer un grand modèle et à l'appliquer à tous gammes de produits au milieu.

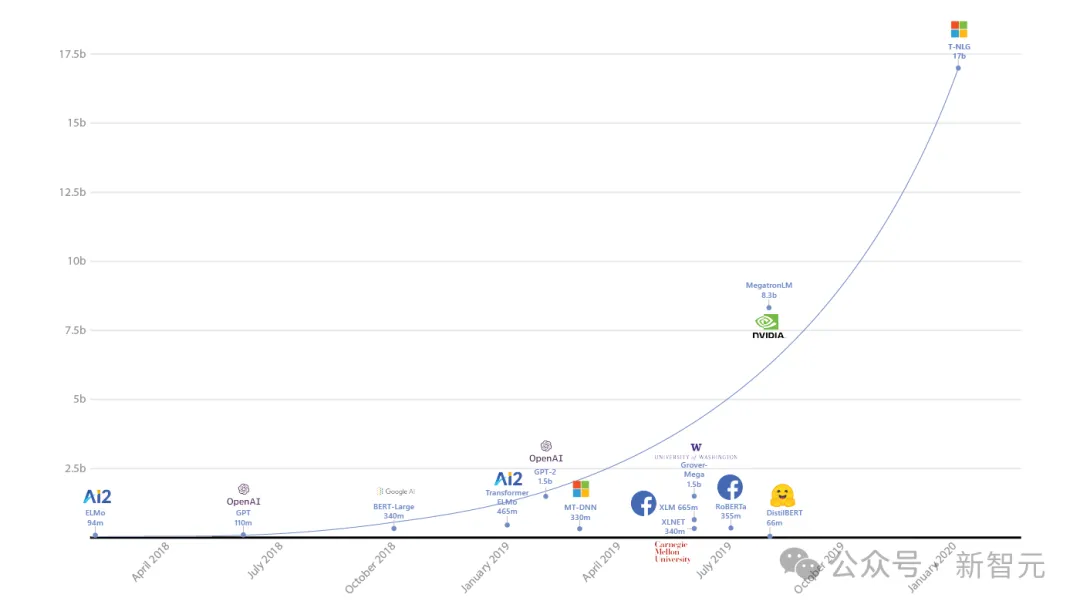

Après 3 ans de recherche et développement, ils ont publié le modèle T-NLG à 17 milliards de paramètres pour la première fois en 2020, établissant un record pour le LLM à la plus grande échelle de paramètres de l'histoire à cette époque.

En 2021, Microsoft s'est associé à NVIDIA pour lancer le Megatron-Turing (MT-NLP) à 530 milliards de paramètres, qui a démontré une précision « inégalée » dans un large éventail de tâches en langage naturel.

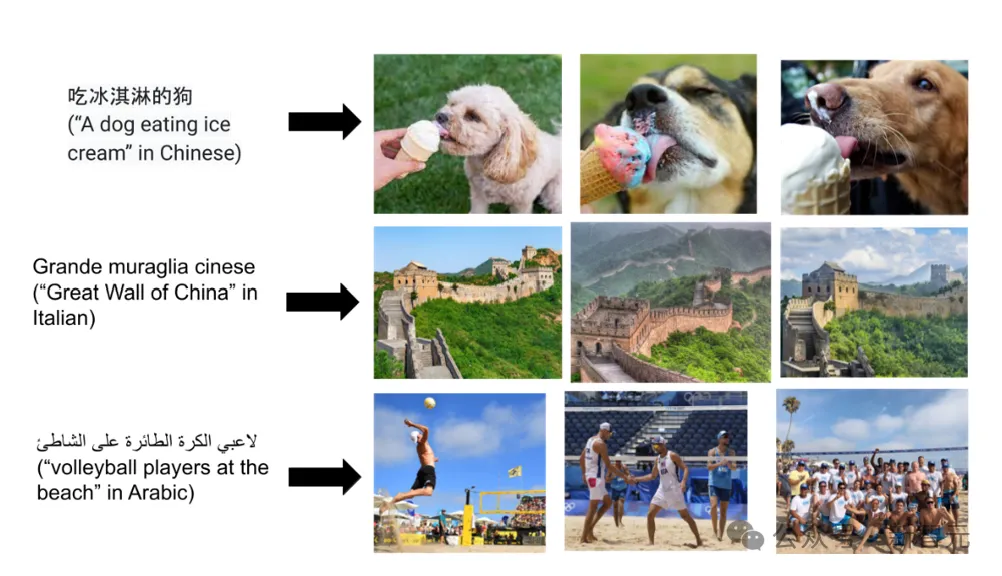

La même année, le modèle de langage visuel Turing Bletchley a été publié pour la première fois.

En août de l'année dernière, ce modèle multimodal a été itéré jusqu'à la version V3 et a été intégré à des produits associés tels que Bing pour offrir une meilleure expérience de recherche d'images.

De plus, Microsoft a également publié le « Modèle universel de représentation du langage Turing » en 2021 et 2022 - versions T-ULRv5 et T-ULRv6.

Actuellement, le modèle "Turing" a été utilisé dans SmartFind dans Word and Question Matching sur Xbox.

Il existe également le modèle de super-résolution d'image Turing Image Super-Resolution (T-ISR) développé par l'équipe, qui a été appliqué dans Bing Maps et peut améliorer la qualité des images aériennes pour les utilisateurs du monde entier.

Actuellement, l'application spécifique du nouveau modèle MAI-1 n'a pas encore été déterminée et dépendra de ses performances.

À propos, plus d'informations sur MAI-1 pourraient être présentées pour la première fois lors de la conférence des développeurs Microsoft Build du 21 au 23 mai.

La prochaine étape consiste à attendre la sortie de MAI-1.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment lier des données dans une liste déroulante

Comment lier des données dans une liste déroulante

Comment désactiver l'invite de mise à niveau Win10

Comment désactiver l'invite de mise à niveau Win10

Quelle plateforme est Fengxiangjia ?

Quelle plateforme est Fengxiangjia ?

Pourquoi l'activation de Win10 échoue-t-elle ?

Pourquoi l'activation de Win10 échoue-t-elle ?

À quel point Snapdragon 8gen2 est-il équivalent à Apple ?

À quel point Snapdragon 8gen2 est-il équivalent à Apple ?

Quel logiciel est Penguin ?

Quel logiciel est Penguin ?

Introduction à la relation entre php et front-end

Introduction à la relation entre php et front-end

Comment configurer au mieux la mémoire virtuelle

Comment configurer au mieux la mémoire virtuelle

Impossible de localiser le point d'entrée du programme dans la bibliothèque de liens dynamiques

Impossible de localiser le point d'entrée du programme dans la bibliothèque de liens dynamiques