Périphériques technologiques

Périphériques technologiques

IA

IA

Les indicateurs du MoE open source national explosent : capacités de niveau GPT-4, le prix de l'API n'est que de 1 %

Les indicateurs du MoE open source national explosent : capacités de niveau GPT-4, le prix de l'API n'est que de 1 %

Les indicateurs du MoE open source national explosent : capacités de niveau GPT-4, le prix de l'API n'est que de 1 %

Le dernier grand modèle MoE open source national est devenu populaire juste après ses débuts.

Les performances de DeepSeek-V2 atteignent le niveau GPT-4, mais il est open source, gratuit pour un usage commercial, et le prix de l'API ne représente qu'un pour cent de GPT-4-Turbo.

Donc, dès sa sortie, cela a immédiatement déclenché de nombreuses discussions.

Photos

Photos

À en juger par les indicateurs de performance publiés, les capacités chinoises complètes de DeepSeek V2 dépassent celles de nombreux modèles open source. Dans le même temps, les modèles fermés tels que GPT-4 Turbo et Wenkuai 4.0 sont également parmi les premiers. échelon.

La maîtrise complète de l'anglais se situe également dans le même premier échelon que LLaMA3-70B et dépasse Mixtral 8x22B, qui est également un MoE.

Il montre également de bonnes performances en connaissances, mathématiques, raisonnement, programmation, etc. Et prend en charge le contexte 128K.

Images

Images

Ces fonctionnalités peuvent être directement utilisées gratuitement par les utilisateurs ordinaires. La bêta fermée est maintenant ouverte, vous pouvez en faire l'expérience immédiatement après votre inscription.

Pictures

Pictures

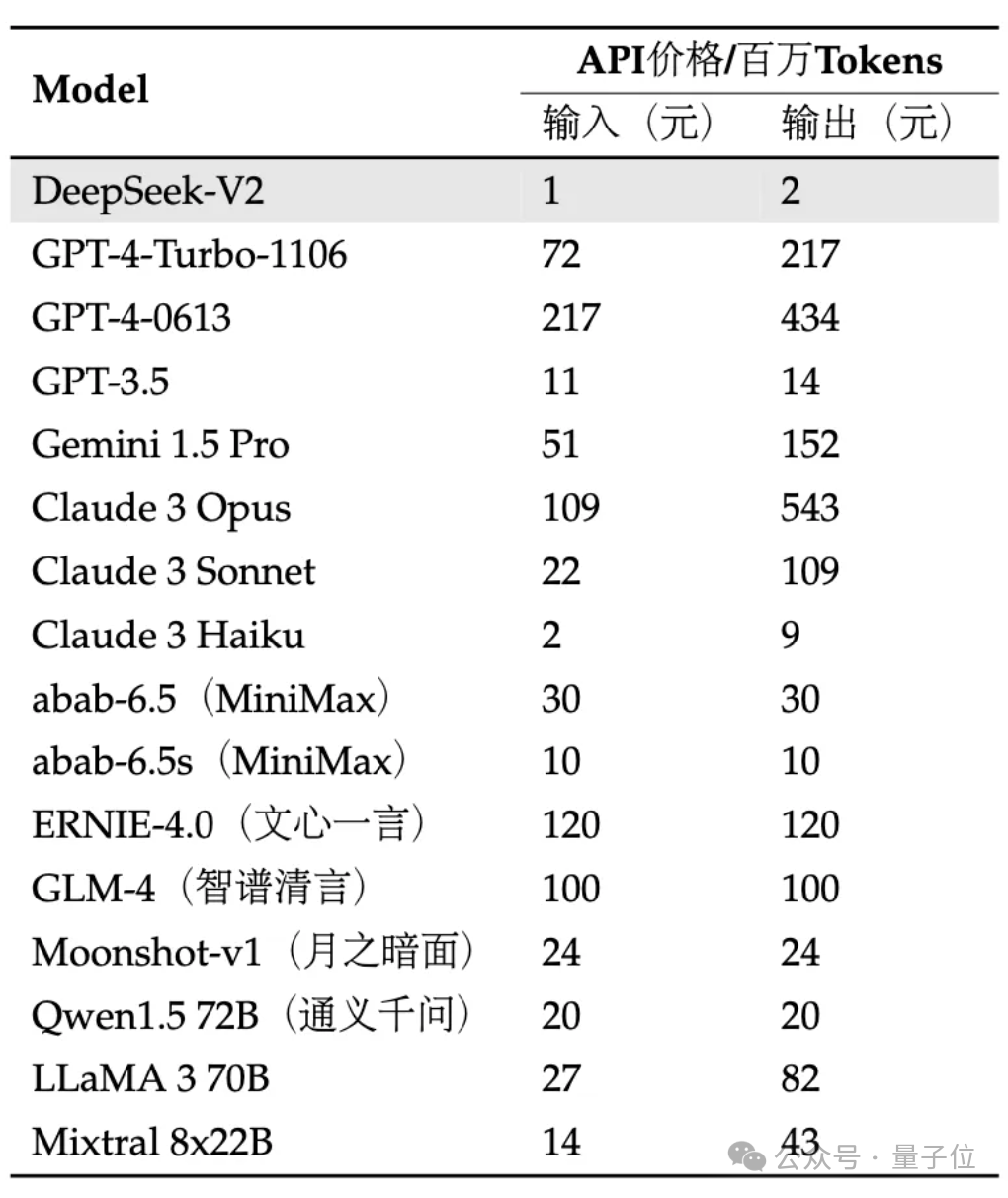

L'API est encore plus chère : l'entrée est de 1 yuan et la sortie est de 2 yuans par million de jetons (contexte 32K). Le prix ne représente que près d’un pour cent de celui du GPT-4-Turbo.

Dans le même temps, l'architecture du modèle est également innovée, en utilisant des structures MLA (Multi-head Latent Attention) et Sparse auto-développées, ce qui peut réduire considérablement la quantité de calcul du modèle et de mémoire d'inférence.

Les internautes ont déploré : DeepSeek apporte toujours des surprises aux gens !

Photos

Photos

Nous avons été les premiers à ressentir les effets spécifiques !

Testez-le en pratique

Actuellement, la version bêta interne V2 peut expérimenter l'assistant universel de dialogue et de code.

Images

Images

Vous pouvez tester la logique, les connaissances, la génération, les mathématiques et d'autres capacités des grands modèles dans des conversations générales.

Par exemple, vous pouvez lui demander d'imiter le style de "La Légende de Zhen Huan" pour rédiger un texte de plantation de rouge à lèvres.

Images

Images

peuvent également expliquer de manière populaire ce qu'est l'intrication quantique.

Images

Images

En termes de mathématiques, il peut répondre à des questions de calcul avancées, telles que :

Utilisez le calcul pour prouver la représentation en série infinie de la base e du logarithme naturel.

Images

Images

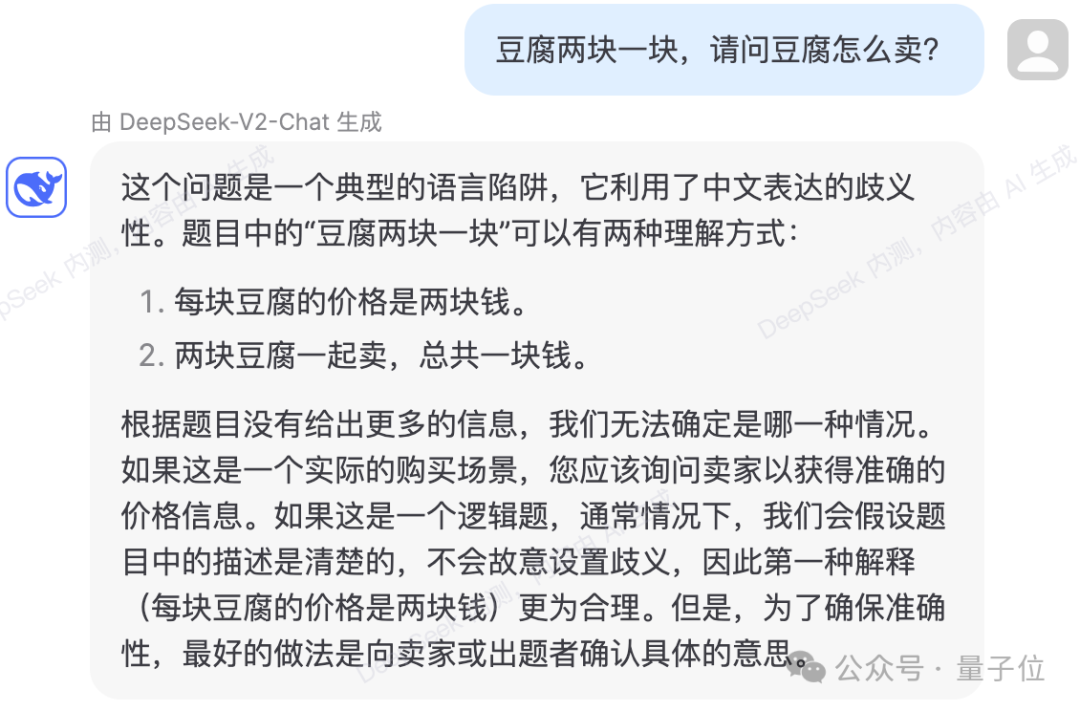

peuvent également éviter certains pièges logiques du langage.

Photos

Photos

Le test montre que le contenu des connaissances de DeepSeek-V2 a été mis à jour jusqu'en 2023.

Photos

Photos

En termes de code, la page de test interne montre que DeepSeek-Coder-33B est utilisé pour répondre aux questions.

En générant des codes plus simples, il n'y a eu aucune erreur dans plusieurs tests réels.

Pictures

Pictures

peut également expliquer et analyser le code donné.

Photos

Photos

Photos

Photos

Cependant, il existe également des cas de mauvaises réponses dans le test.

Dans la question logique suivante, pendant le processus de calcul, DeepSeek-V2 a calculé par erreur le temps nécessaire pour qu'une bougie soit allumée par les deux extrémités en même temps et s'éteigne comme étant un quart du temps nécessaire pour qu'elle brûle. d'une extrémité. Quelles améliorations apportent

pictures

pictures

?

Selon l'introduction officielle, DeepSeek-V2 a un paramètre total de 236B et une activation de 21B, ce qui atteint à peu près la capacité du modèle de 70B ~ 110B Dense.

Photos

Photos

Par rapport au précédent DeepSeek 67B, il offre des performances plus élevées et des coûts de formation inférieurs. Il peut économiser 42,5 % des coûts de formation, réduire le cache KV de 93,3 % et augmenter le débit maximum à 5,76 fois.

Officiellement déclaré, cela signifie que la mémoire vidéo (KV Cache) consommée par DeepSeek-V2 ne représente que 1/5~1/100 du modèle Dense du même niveau, et le coût par jeton est considérablement réduit.

De nombreuses optimisations de communication ont été réalisées spécifiquement pour les spécifications H800. Il est actuellement déployé sur une machine H800 à 8 cartes. Le débit d'entrée dépasse 100 000 jetons par seconde et la sortie dépasse 50 000 jetons par seconde.

Pictures

Pictures

Sur certains Benchmarks de base, les performances du modèle de base DeepSeek-V2 sont les suivantes :

Pictures

Pictures

DeepSeek-V2 adopte une architecture innovante.

Proposition d'architecture MLA (Multi-head Latent Attention) pour réduire considérablement la quantité de mémoire de calcul et d'inférence.

En parallèle, nous avons développé nous-mêmes la structure Sparse pour réduire encore davantage le montant du calcul.

Photos

Photos

Certaines personnes ont déclaré que ces mises à niveau pourraient être très utiles pour l'informatique à grande échelle dans les centres de données.

Photos

Photos

Et en termes de prix API, DeepSeek-V2 est presque inférieur à tous les modèles stars du marché.

Photos

Photos

L'équipe a déclaré que le modèle et le papier DeepSeek-V2 seront également entièrement open source. Les poids des modèles et les rapports techniques sont fournis.

Connectez-vous dès maintenant à la plateforme ouverte de l'API DeepSeek et inscrivez-vous pour recevoir 10 millions de jetons d'entrée/5 millions de sortie en cadeau. L’essai normal est entièrement gratuit.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

L'annotation de texte est le travail d'étiquettes ou de balises correspondant à un contenu spécifique dans le texte. Son objectif principal est d’apporter des informations complémentaires au texte pour une analyse et un traitement plus approfondis, notamment dans le domaine de l’intelligence artificielle. L'annotation de texte est cruciale pour les tâches d'apprentissage automatique supervisées dans les applications d'intelligence artificielle. Il est utilisé pour entraîner des modèles d'IA afin de mieux comprendre les informations textuelles en langage naturel et d'améliorer les performances de tâches telles que la classification de texte, l'analyse des sentiments et la traduction linguistique. Grâce à l'annotation de texte, nous pouvons apprendre aux modèles d'IA à reconnaître les entités dans le texte, à comprendre le contexte et à faire des prédictions précises lorsque de nouvelles données similaires apparaissent. Cet article recommande principalement de meilleurs outils d'annotation de texte open source. 1.LabelStudiohttps://github.com/Hu

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

L'annotation d'images est le processus consistant à associer des étiquettes ou des informations descriptives à des images pour donner une signification et une explication plus profondes au contenu de l'image. Ce processus est essentiel à l’apprentissage automatique, qui permet d’entraîner les modèles de vision à identifier plus précisément les éléments individuels des images. En ajoutant des annotations aux images, l'ordinateur peut comprendre la sémantique et le contexte derrière les images, améliorant ainsi la capacité de comprendre et d'analyser le contenu de l'image. L'annotation d'images a un large éventail d'applications, couvrant de nombreux domaines, tels que la vision par ordinateur, le traitement du langage naturel et les modèles de vision graphique. Elle a un large éventail d'applications, telles que l'assistance aux véhicules pour identifier les obstacles sur la route, en aidant à la détection. et le diagnostic des maladies grâce à la reconnaissance d'images médicales. Cet article recommande principalement de meilleurs outils d'annotation d'images open source et gratuits. 1.Makesens

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

Le code source de 25 agents IA est désormais public, inspiré de « Virtual Town » et de « Westworld » de Stanford

Aug 11, 2023 pm 06:49 PM

Le code source de 25 agents IA est désormais public, inspiré de « Virtual Town » et de « Westworld » de Stanford

Aug 11, 2023 pm 06:49 PM

Le public familier avec "Westworld" sait que ce spectacle se déroule dans un immense parc à thème pour adultes de haute technologie dans le monde futur. Les robots ont des capacités comportementales similaires à celles des humains, et peuvent se souvenir de ce qu'ils voient et entendent et répéter le scénario principal. Chaque jour, ces robots seront réinitialisés et ramenés à leur état initial. Après la publication de l'article de Stanford « Generative Agents : Interactive Simulacra of Human Behaviour », ce scénario ne se limite plus aux films et aux séries télévisées. L'IA a réussi à le reproduire. scène dans la « ville virtuelle » de Smallville 》Aperçu de l'adresse du papier cartographique : https://arxiv.org/pdf/2304.03442v1.pdf

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

La technologie de détection et de reconnaissance des visages est déjà une technologie relativement mature et largement utilisée. Actuellement, le langage d'application Internet le plus utilisé est JS. La mise en œuvre de la détection et de la reconnaissance faciale sur le front-end Web présente des avantages et des inconvénients par rapport à la reconnaissance faciale back-end. Les avantages incluent la réduction de l'interaction réseau et de la reconnaissance en temps réel, ce qui réduit considérablement le temps d'attente des utilisateurs et améliore l'expérience utilisateur. Les inconvénients sont les suivants : il est limité par la taille du modèle et la précision est également limitée ; Comment utiliser js pour implémenter la détection de visage sur le web ? Afin de mettre en œuvre la reconnaissance faciale sur le Web, vous devez être familier avec les langages et technologies de programmation associés, tels que JavaScript, HTML, CSS, WebRTC, etc. Dans le même temps, vous devez également maîtriser les technologies pertinentes de vision par ordinateur et d’intelligence artificielle. Il convient de noter qu'en raison de la conception du côté Web

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Nouveau SOTA pour des capacités de compréhension de documents multimodaux ! L'équipe Alibaba mPLUG a publié le dernier travail open source mPLUG-DocOwl1.5, qui propose une série de solutions pour relever les quatre défis majeurs que sont la reconnaissance de texte d'image haute résolution, la compréhension générale de la structure des documents, le suivi des instructions et l'introduction de connaissances externes. Sans plus tarder, examinons d’abord les effets. Reconnaissance et conversion en un clic de graphiques aux structures complexes au format Markdown : Des graphiques de différents styles sont disponibles : Une reconnaissance et un positionnement de texte plus détaillés peuvent également être facilement traités : Des explications détaillées sur la compréhension du document peuvent également être données : Vous savez, « Compréhension du document " est actuellement un scénario important pour la mise en œuvre de grands modèles linguistiques. Il existe de nombreux produits sur le marché pour aider à la lecture de documents. Certains d'entre eux utilisent principalement des systèmes OCR pour la reconnaissance de texte et coopèrent avec LLM pour le traitement de texte.

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Permettez-moi de vous présenter le dernier projet open source AIGC-AnimagineXL3.1. Ce projet est la dernière itération du modèle texte-image sur le thème de l'anime, visant à offrir aux utilisateurs une expérience de génération d'images d'anime plus optimisée et plus puissante. Dans AnimagineXL3.1, l'équipe de développement s'est concentrée sur l'optimisation de plusieurs aspects clés pour garantir que le modèle atteigne de nouveaux sommets en termes de performances et de fonctionnalités. Premièrement, ils ont élargi les données d’entraînement pour inclure non seulement les données des personnages du jeu des versions précédentes, mais également les données de nombreuses autres séries animées bien connues dans l’ensemble d’entraînement. Cette décision enrichit la base de connaissances du modèle, lui permettant de mieux comprendre les différents styles et personnages d'anime. AnimagineXL3.1 introduit un nouvel ensemble de balises et d'esthétiques spéciales

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un