Périphériques technologiques

Périphériques technologiques

IA

IA

7 262 articles ont été soumis, l'ICLR 2024 est devenu un succès et deux articles nationaux ont été nominés pour les articles exceptionnels.

7 262 articles ont été soumis, l'ICLR 2024 est devenu un succès et deux articles nationaux ont été nominés pour les articles exceptionnels.

7 262 articles ont été soumis, l'ICLR 2024 est devenu un succès et deux articles nationaux ont été nominés pour les articles exceptionnels.

Au total, 5 prix d'articles exceptionnels et 11 mentions honorables ont été sélectionnés cette année.

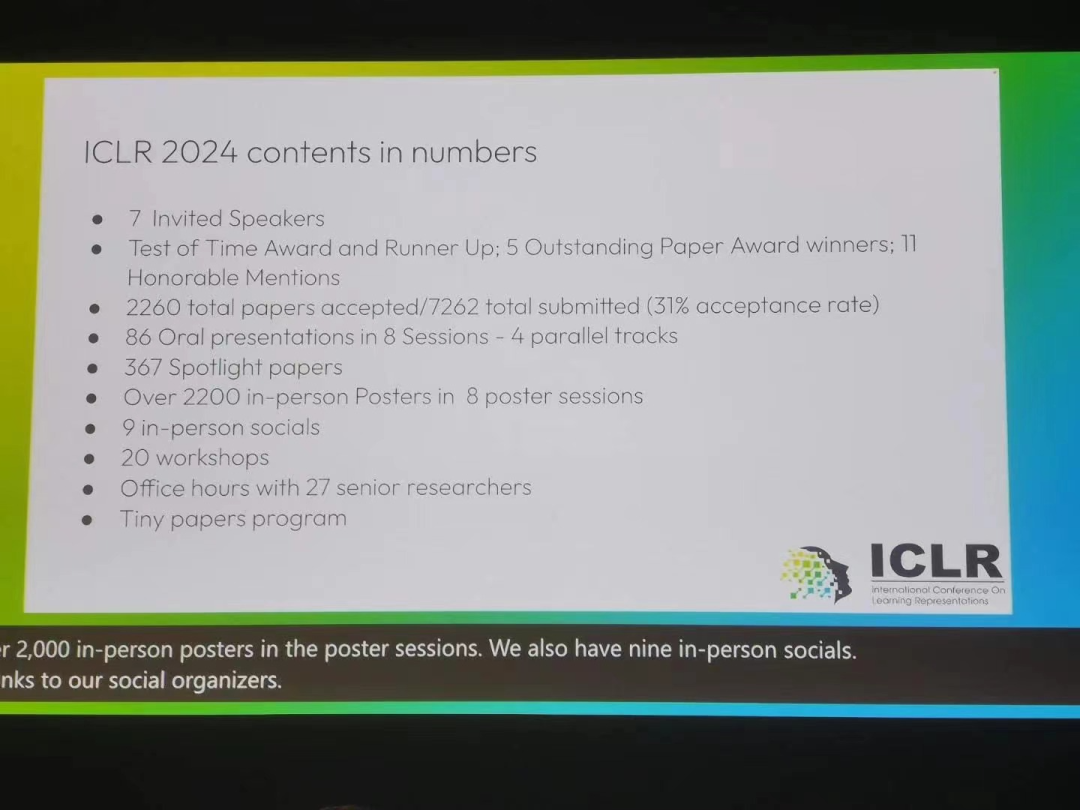

ICLR signifie International Conference on Learning Representations. Cette année, c'est la 12ème conférence, qui se tient à Vienne, en Autriche, du 7 au 11 mai.

Dans la communauté de l'apprentissage automatique, l'ICLR est une conférence académique de premier plan relativement « jeune ». Elle est organisée par les géants de l'apprentissage profond et lauréats du prix Turing, Yoshua Bengio et Yann LeCun. Elle vient de tenir sa première session en 2013. Cependant, l’ICLR a rapidement acquis une large reconnaissance auprès des chercheurs universitaires et est considérée comme la principale conférence universitaire sur l’apprentissage profond.

Cette conférence a reçu un total de 7 262 articles soumis et a accepté 2 260 articles. Le taux d'acceptation global était d'environ 31 %, le même que l'année dernière (31,8 %). De plus, la proportion d'articles Spotlights est de 5 % et la proportion d'articles oraux est de 1,2 %.

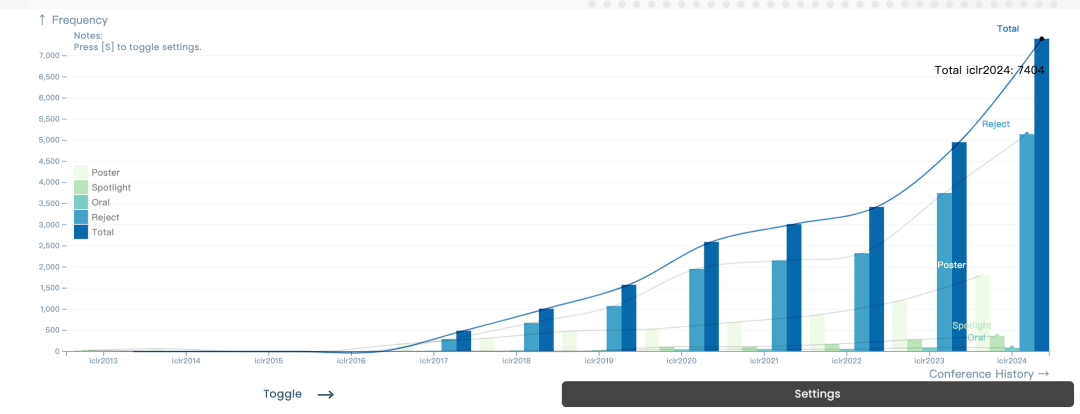

Par rapport aux années précédentes, qu'il s'agisse du nombre de participants ou du nombre de soumissions d'articles, on peut dire que la popularité de l'ICLR a considérablement augmenté. R Pour les données de thèse précédentes de l'ICLR

5 Outstanding Paper Awards

Lauréats d'Outstanding Paper

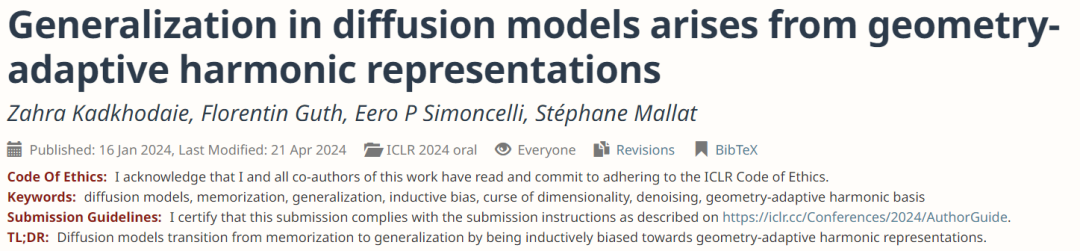

Article : La généralisation dans les modèles de diffusion découle de représentations harmoniques adaptatives à la géométrie

Adresse de l'article : https://openreview.net / pdf?id=ANvmVS2Yr0

- Auteur : Zahra Kadkhodaie, Florentin Guth, Eero P. Simoncelli, Stéphane Mallat

- Cet article généralise le modèle de diffusion d'images et Important analyse approfondie de la mémoire. Les auteurs étudient empiriquement le moment où un modèle de génération d'images passe de l'entrée mémoire au mode de généralisation et le relient à l'idée d'analyse harmonique via une représentation harmonique géométriquement adaptative, expliquant davantage ce phénomène du point de vue du biais d'induction architecturale. Cet article couvre un élément clé manquant dans notre compréhension des modèles génératifs de vision et a de grandes implications pour les recherches futures.

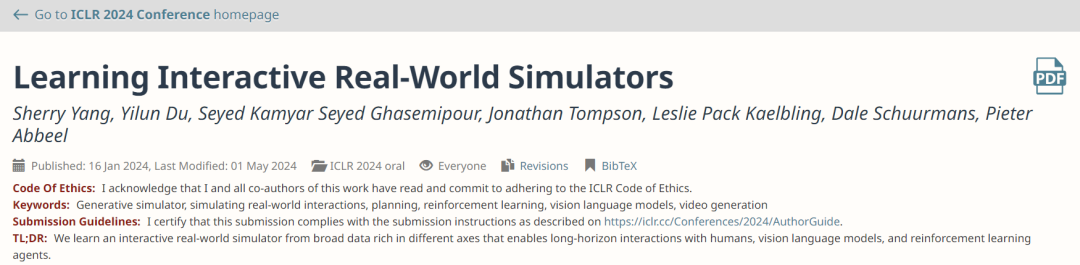

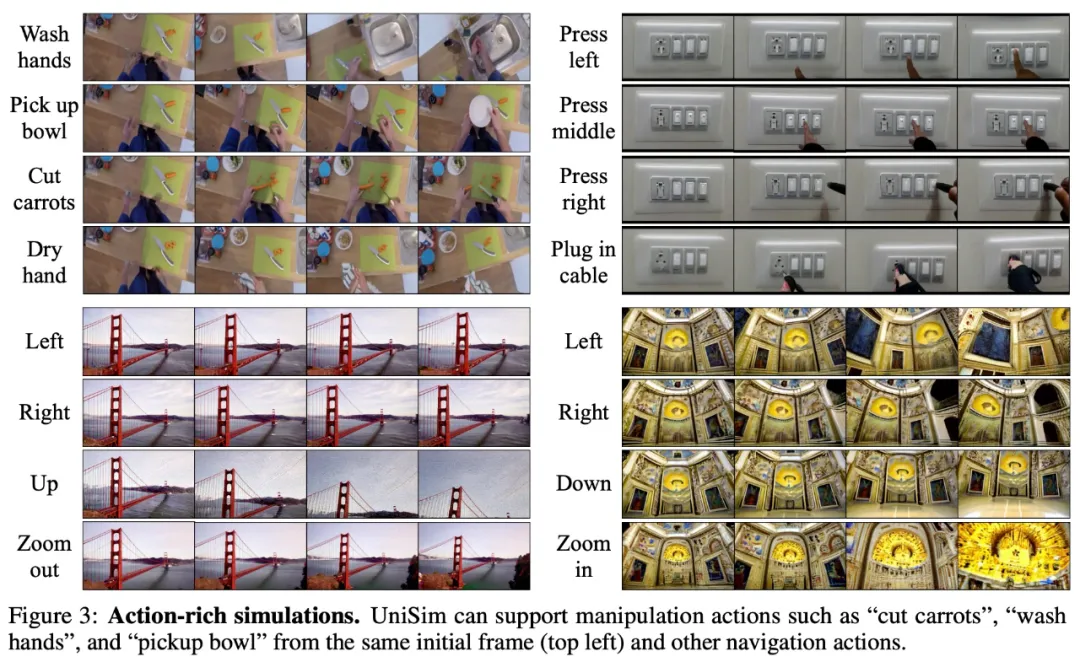

Article : Apprendre des simulateurs interactifs du monde réel

Adresse de l'article : https://openreview.net/forum?id=sFyTZEqmUY

- Auteurs : Sherry Yang, Yilun Du, Kamyar Ghasemipour, Jonathan Tompson, Leslie Kaelbling, Dale Schuurmans, Pieter Abbeel

- L'agrégation de données provenant de plusieurs sources pour former un modèle de base pour les robots est un travail à long terme but. Étant donné que différents robots ont des interfaces sensorimotrices différentes, cela pose des défis importants pour la formation sur des ensembles de données à grande échelle.

-

UniSim

, est une étape importante dans cette direction et une prouesse d'ingénierie, en tirant parti d'une interface unifiée basée sur des descriptions textuelles de la perception visuelle et du contrôle pour agréger les données et en tirant parti des dernières avancées en matière de vision et de langage développées pour former des simulateurs de robots. .

Comme le montre la figure 3 ci-dessous, UniSim peut simuler une série d'actions riches, telles que se laver les mains, prendre des bols, couper des carottes et se sécher les mains dans une scène de cuisine ; La figure 3 montre deux scènes de navigation. # La scène de navigation en bas à droite de la figure 3

Thèse : Ne jamais s'entraîner à partir de zéro : une comparaison équitable des modèles à séquence longue nécessite une approche basée sur les données avant Jonathan Berant, Ankit Cet article explore les capacités des modèles d'espace d'état et des architectures de transformateur récemment proposés pour modéliser les dépendances de séquence à long terme.

Étonnamment, les auteurs ont découvert que la formation d'un modèle de transformateur à partir de zéro entraîne une sous-estimation de ses performances, et que des améliorations significatives des performances peuvent être obtenues grâce à un pré-entraînement et à des réglages précis. Le document excelle dans l’accent mis sur la simplicité et les informations systématiques.

Article : Protein Discovery with Discrete Walk-Jump Sampling

Adresse de l'article : https://openreview.net/forum?id=zMPHKOmQNb

- Auteurs : Nathan C. Frey, Dan Berenberg, Karina Zadorozhny, Joseph Kleinhenz, Julien Lafrance-Vanasse, Isidro Hotzel, Yan Wu, Stephen Ra, Richard Bonneau, Kyunghyun Cho, Andreas Loukas, Vladimir Gligorijevic, Saeed Saremi

- Cet article aborde le problème de la conception d’anticorps basée sur la séquence, une application importante et opportune des modèles de génération de séquences protéiques.

- À cette fin, l'auteur présente une nouvelle méthode de modélisation innovante et efficace spécifiquement ciblée sur le problème du traitement des données de séquences protéiques discrètes. En plus de valider la méthode in silico, les auteurs ont réalisé de nombreuses expériences en laboratoire humide pour mesurer les affinités de liaison des anticorps in vitro, démontrant ainsi l'efficacité de leur méthode générée. Article : Vision Transformers Need Registers

Adresse de l'article : https://openreview.net/forum?id=2dnO3LLiJ1

- Auteur : Othée Darce t. Maxime Oquab, Julien Mairal, Piotr Bojanowski

- Cet article identifie les artefacts dans la carte caractéristique d'un réseau de transformateurs de vision, qui sont caractérisés par des jetons de haute norme dans des régions d'arrière-plan à faible information.

- Les auteurs proposent des hypothèses clés sur la manière dont ce phénomène se produit et proposent une solution simple mais élégante utilisant des jetons de registre supplémentaires pour traiter ces traces, améliorant ainsi les performances du modèle sur diverses tâches. Les enseignements tirés de ces travaux pourraient également avoir un impact sur d’autres domaines d’application. Cet article est parfaitement rédigé et fournit un bon exemple de conduite de recherche : "Identifier le problème, comprendre pourquoi il se produit, puis proposer une solution."

11 mentions honorables

En plus de 5 articles exceptionnels Articles, L'ICLR 2024 a également sélectionné 11 mentions honorables.Article : Amortizing intractable inference in large Language Models

- Institution : Université de Montréal, Université d'Oxford

- Auteur : Edward J Hu, Moksh Jain, Eric Elmoznino, Younesse Kaddar, Guillaume Lajoie, Yoshua Bengio , Nikolay Malkin

- Adresse de l'article : https://openreview.net/forum?id=Ouj6p4ca60

- Cet article propose une alternative au décodage autorégressif dans les grands modèles de langage du point de vue de l'inférence bayésienne. ce qui pourrait inspirer des recherches de suivi.

Institution : DeepMind

Auteur : Ian Gimp, Luke Marris, Georgios Piliouras

Adresse de l'article : https://open review .net/forum?id=cc8h3I3V4E

-

Il s'agit d'un article très clair qui contribue de manière significative à résoudre le problème important du développement de solveurs Nash efficaces et évolutifs.

Article : Au-delà de Weisfeiler-Lehman : Un cadre quantitatif pour l'expressivité du GNN

Institution : Université de Pékin, Institut de recherche sur l'intelligence artificielle Zhiyuan de Pékin

Auteur : Zhang Bohang Gai Jingchu Du Yiheng Ye Qiwei Hedi Wang Liwei

Adresse papier : https://openreview.net/forum?id=HSKaGOi7Ar

La capacité d'expression du GNN est un sujet important, et les solutions actuelles ont encore de grandes limites. L'auteur propose une nouvelle théorie de l'expressivité basée sur le comptage homomorphe.

Article : Flow Matching on General Geometries

Institution : Meta

Auteur : Ricky T. Q. Chen, Yaron Lipman

Adresse de l'article : https://openreview.net/forum?id=g7ohDlTITL

Cet article explore le problème difficile mais important de la modélisation générative sur les variétés géométriques générales et propose un algorithme pratique et efficace. L'article est parfaitement présenté et entièrement validé expérimentalement sur un large éventail de tâches.

Article : ImageNet vaut-il 1 vidéo ? Apprendre des encodeurs d'images puissants à partir d'une longue vidéo non étiquetée

Institutions : Université de Floride centrale, Google DeepMind, Université d'Amsterdam, etc.

Auteurs : Shashanka Venkataramanan, Mamshad Nayeem Rizve, Joao Carreira, Yuki M Asano, Yannis Avrithis

Adresse papier : https://openreview.net/forum?id=Yen1lGns2o

Cet article propose une nouvelle méthode de pré-formation d'images auto-supervisée , c'est-à-dire en s'entraînant à partir d'apprendre à partir de vidéos continues. Cet article apporte à la fois un nouveau type de données et une méthode pour apprendre à partir de nouvelles données.

Article : L'apprentissage continu méta revisité : amélioration implicite de l'approximation hessienne en ligne via la réduction de la variance

Institution : City University of Hong Kong, Tencent AI Lab, Xi'an Jiaotong University, etc.

Auteur : Yichen Wu, Long-Kai Huang, Renzhen Wang, Deyu Meng et Ying Wei

Adresse papier : https://openreview.net/forum?id=TpD2aG1h0D

Les auteurs ont proposé une nouvelle variante d'apprentissage méta-continu méthode de réduction. La méthode fonctionne bien et a non seulement un impact pratique, mais est également étayée par une analyse des regrets.

Papier : Le modèle vous indique ce qu'il faut supprimer : Compression adaptative du cache KV pour les LLM

Institution : Université de l'Illinois à Urbana-Champaign, Microsoft

Auteurs : Suyu Ge, Yunan Zhang, Liyuan Liu, Minjia Zhang, Jiawei Han, Jianfeng Gao

Adresse papier : https://openreview.net/forum?id=uNrFpDPMyo

Cet article se concentre sur le problème de compression du cache KV (ce problème a un grand impact sur Transformer- basé LLM), avec une idée simple qui réduit la mémoire et peut être déployée sans ajustement ni recyclage coûteux. Cette méthode est très simple et s’est avérée très efficace.

Article : Prouver la contamination des ensembles de tests dans des modèles linguistiques en boîte noire

Institution : Université de Stanford, Université de Columbia

-

Auteur : Yonatan Oren, Nicole Meister, Niladri S. Chatterji, Faisal Ladhak, Tatsunori Hashimoto

Adresse de l'article : https://openreview.net/forum?id=KS8mIvetg2

Cet article utilise une méthode simple et élégante pour tester si des ensembles de données d'apprentissage supervisé ont été inclus dans de grands modèles de langage en formation.

Article : Les agents robustes apprennent les modèles du monde causal

Institution : Google DeepMind

Auteur : Jonathan Richens, Tom Everitt

Adresse de l'article : https://openreview.net/forum?id= pOoKI3ouv1

Cet article fait de grands progrès en posant les bases théoriques pour comprendre le rôle du raisonnement causal dans la capacité d'un agent à généraliser à de nouveaux domaines, avec des implications pour une gamme de domaines connexes.

Article : La base mécanistique de la dépendance aux données et de l'apprentissage brutal dans une tâche de classification en contexte

Institution : Université de Princeton, Université Harvard, etc.

Auteur : Gautam Reddy

Adresse papier : https ://openreview.net/forum?id=aN4Jf6Cx69

Il s'agit d'une étude opportune et extrêmement systématique qui explore la relation entre l'apprentissage en contexte et l'apprentissage en poids alors que nous commençons à comprendre ces phénomènes.

Article : Vers une théorie statistique de la sélection de données sous supervision faible

Institution : Granica Computing

Auteur : Germain Kolossov, Andrea Montanari, Pulkit Tandon

Adresse de l'article : https://openreview .net/forum?id=HhfcNgQn6p

Cet article établit une base statistique pour la sélection de sous-ensembles de données et identifie les lacunes des méthodes de sélection de données populaires.

Lien de référence : https://blog.iclr.cc/2024/05/06/iclr-2024-outstanding-paper-awards/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Mais peut-être qu’il ne pourra pas vaincre le vieil homme dans le parc ? Les Jeux Olympiques de Paris battent leur plein et le tennis de table suscite beaucoup d'intérêt. Dans le même temps, les robots ont également réalisé de nouvelles avancées dans le domaine du tennis de table. DeepMind vient tout juste de proposer le premier agent robot apprenant capable d'atteindre le niveau des joueurs amateurs humains de tennis de table de compétition. Adresse papier : https://arxiv.org/pdf/2408.03906 Quelle est la capacité du robot DeepMind à jouer au tennis de table ? Probablement à égalité avec les joueurs amateurs humains : tant en coup droit qu'en revers : l'adversaire utilise une variété de styles de jeu, et le robot peut également résister : recevoir des services avec des tours différents : Cependant, l'intensité du jeu ne semble pas aussi intense que le vieil homme dans le parc. Pour les robots, le tennis de table

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

Le 21 août, la Conférence mondiale sur les robots 2024 s'est tenue en grande pompe à Pékin. La marque de robots domestiques de SenseTime, "Yuanluobot SenseRobot", a dévoilé toute sa famille de produits et a récemment lancé le robot de jeu d'échecs Yuanluobot AI - Chess Professional Edition (ci-après dénommé "Yuanluobot SenseRobot"), devenant ainsi le premier robot d'échecs au monde pour le maison. En tant que troisième produit robot jouant aux échecs de Yuanluobo, le nouveau robot Guoxiang a subi un grand nombre de mises à niveau techniques spéciales et d'innovations en matière d'IA et de machines d'ingénierie. Pour la première fois, il a réalisé la capacité de ramasser des pièces d'échecs en trois dimensions. grâce à des griffes mécaniques sur un robot domestique et effectuer des fonctions homme-machine telles que jouer aux échecs, tout le monde joue aux échecs, réviser la notation, etc.

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

La rentrée scolaire est sur le point de commencer, et ce ne sont pas seulement les étudiants qui sont sur le point de commencer le nouveau semestre qui doivent prendre soin d’eux-mêmes, mais aussi les grands modèles d’IA. Il y a quelque temps, Reddit était rempli d'internautes se plaignant de la paresse de Claude. « Son niveau a beaucoup baissé, il fait souvent des pauses et même la sortie devient très courte. Au cours de la première semaine de sortie, il pouvait traduire un document complet de 4 pages à la fois, mais maintenant il ne peut même plus produire une demi-page. !" https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/ dans un post intitulé "Totalement déçu par Claude", plein de

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference qui se tient à Pékin, l'exposition de robots humanoïdes est devenue le centre absolu de la scène. Sur le stand Stardust Intelligent, l'assistant robot IA S1 a réalisé trois performances majeures de dulcimer, d'arts martiaux et de calligraphie. un espace d'exposition, capable à la fois d'arts littéraires et martiaux, a attiré un grand nombre de publics professionnels et de médias. Le jeu élégant sur les cordes élastiques permet au S1 de démontrer un fonctionnement fin et un contrôle absolu avec vitesse, force et précision. CCTV News a réalisé un reportage spécial sur l'apprentissage par imitation et le contrôle intelligent derrière "Calligraphy". Le fondateur de la société, Lai Jie, a expliqué que derrière les mouvements soyeux, le côté matériel recherche le meilleur contrôle de la force et les indicateurs corporels les plus humains (vitesse, charge). etc.), mais du côté de l'IA, les données réelles de mouvement des personnes sont collectées, permettant au robot de devenir plus fort lorsqu'il rencontre une situation forte et d'apprendre à évoluer rapidement. Et agile

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

Intégration profonde de la vision et de l'apprentissage des robots. Lorsque deux mains de robot travaillent ensemble en douceur pour plier des vêtements, verser du thé et emballer des chaussures, associées au robot humanoïde 1X NEO qui a fait la une des journaux récemment, vous pouvez avoir le sentiment : nous semblons entrer dans l'ère des robots. En fait, ces mouvements soyeux sont le produit d’une technologie robotique avancée + d’une conception de cadre exquise + de grands modèles multimodaux. Nous savons que les robots utiles nécessitent souvent des interactions complexes et exquises avec l’environnement, et que l’environnement peut être représenté comme des contraintes dans les domaines spatial et temporel. Par exemple, si vous souhaitez qu'un robot verse du thé, le robot doit d'abord saisir la poignée de la théière et la maintenir verticalement sans renverser le thé, puis la déplacer doucement jusqu'à ce que l'embouchure de la théière soit alignée avec l'embouchure de la tasse. , puis inclinez la théière selon un certain angle. ce

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Les contributeurs ont beaucoup gagné de cette conférence ACL. L'ACL2024, d'une durée de six jours, se tient à Bangkok, en Thaïlande. ACL est la plus grande conférence internationale dans le domaine de la linguistique informatique et du traitement du langage naturel. Elle est organisée par l'Association internationale pour la linguistique informatique et a lieu chaque année. L'ACL s'est toujours classée première en termes d'influence académique dans le domaine de la PNL, et c'est également une conférence recommandée par le CCF-A. La conférence ACL de cette année est la 62e et a reçu plus de 400 travaux de pointe dans le domaine de la PNL. Hier après-midi, la conférence a annoncé le meilleur article et d'autres récompenses. Cette fois, il y a 7 Best Paper Awards (deux inédits), 1 Best Theme Paper Award et 35 Outstanding Paper Awards. La conférence a également décerné 3 Resource Paper Awards (ResourceAward) et Social Impact Award (

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Cet après-midi, Hongmeng Zhixing a officiellement accueilli de nouvelles marques et de nouvelles voitures. Le 6 août, Huawei a organisé la conférence de lancement de nouveaux produits Hongmeng Smart Xingxing S9 et Huawei, réunissant la berline phare intelligente panoramique Xiangjie S9, le nouveau M7Pro et Huawei novaFlip, MatePad Pro 12,2 pouces, le nouveau MatePad Air, Huawei Bisheng With de nombreux nouveaux produits intelligents tous scénarios, notamment la série d'imprimantes laser X1, FreeBuds6i, WATCHFIT3 et l'écran intelligent S5Pro, des voyages intelligents, du bureau intelligent aux vêtements intelligents, Huawei continue de construire un écosystème intelligent complet pour offrir aux consommateurs une expérience intelligente du Internet de tout. Hongmeng Zhixing : Autonomisation approfondie pour promouvoir la modernisation de l'industrie automobile intelligente Huawei s'associe à ses partenaires de l'industrie automobile chinoise pour fournir

Le premier grand modèle d'interface utilisateur en Chine est lancé ! Le grand modèle de Motiff crée le meilleur assistant pour les concepteurs et optimise le flux de travail de conception d'interface utilisateur

Aug 19, 2024 pm 04:48 PM

Le premier grand modèle d'interface utilisateur en Chine est lancé ! Le grand modèle de Motiff crée le meilleur assistant pour les concepteurs et optimise le flux de travail de conception d'interface utilisateur

Aug 19, 2024 pm 04:48 PM

L’intelligence artificielle se développe plus rapidement que vous ne l’imaginez. Depuis que GPT-4 a introduit la technologie multimodale aux yeux du public, les grands modèles multimodaux sont entrés dans une phase de développement rapide, passant progressivement de la recherche et du développement de modèles purs à l'exploration et à l'application dans des domaines verticaux, et sont profondément intégrés dans tous les horizons. Dans le domaine de l'interaction des interfaces, des géants internationaux de la technologie tels que Google et Apple ont investi dans la recherche et le développement de grands modèles d'interface utilisateur multimodaux, ce qui est considéré comme la seule voie à suivre pour la révolution de l'IA des téléphones mobiles. C’est dans ce contexte qu’est né le premier modèle d’assurance-chômage à grande échelle en Chine. Le 17 août, lors de la conférence internationale sur la conception d'expériences IXDC2024, Motiff, un outil de conception à l'ère de l'IA, a lancé son modèle multimodal d'interface utilisateur développé indépendamment - Motiff Model. Il s'agit du premier outil de conception d'interface utilisateur au monde