10000 contenu connexe trouvé

Entraîner des modèles de machine learning en C++ : du prétraitement des données à la validation du modèle

Présentation de l'article:La formation d'un modèle ML en C++ implique les étapes suivantes : Prétraitement des données : charger, transformer et concevoir les données. Formation de modèle : choisissez un algorithme et entraînez le modèle. Validation du modèle : partitionnez l'ensemble de données, évaluez les performances et ajustez le modèle. En suivant ces étapes, vous pouvez réussir à créer, entraîner et valider des modèles d’apprentissage automatique en C++.

2024-06-01

commentaire 0

633

La signification de Batch Size et son impact sur la formation (lié aux modèles d'apprentissage automatique)

Présentation de l'article:BatchSize fait référence à la quantité de données utilisée par le modèle d'apprentissage automatique à chaque fois pendant le processus de formation. Il divise de grandes quantités de données en petits lots de données pour la formation du modèle et la mise à jour des paramètres. Cette méthode de traitement par lots permet d'améliorer l'efficacité de la formation et l'utilisation de la mémoire. Les données de formation sont généralement divisées en lots pour la formation, et chaque lot contient plusieurs échantillons. La taille du lot (batchsize) fait référence au nombre d'échantillons contenus dans chaque lot. Lors de la formation d'un modèle, la taille du lot a un impact important sur le processus de formation. 1. Vitesse d'entraînement La taille du lot (batchsize) a un impact sur la vitesse d'entraînement du modèle. Une taille de lot plus grande peut traiter les données d'entraînement plus rapidement, car à chaque époque, une taille de lot plus grande peut traiter plus de données simultanément.

2024-01-23

commentaire 0

2211

Guide de formation du modèle ChatGPT Python : étapes pour personnaliser un chatbot

Présentation de l'article:Guide de formation du modèle ChatGPTPython : Aperçu des étapes de personnalisation des robots de chat : Ces dernières années, avec le développement croissant de la technologie NLP (traitement du langage naturel), les robots de chat ont attiré de plus en plus d'attention. ChatGPT d'OpenAI est un puissant modèle de langage pré-entraîné qui peut être utilisé pour créer des chatbots multi-domaines. Cet article présentera les étapes d'utilisation de Python pour entraîner le modèle ChatGPT, y compris la préparation des données, la formation du modèle et la génération d'échantillons de dialogue. Étape 1 : Préparation, collecte et nettoyage des données

2023-10-24

commentaire 0

1305

La bibliothèque d'extension de formation distribuée open source d'Ant, AToch, atteint un taux d'utilisation effectif de 60 % de la puissance de calcul de formation sur grands modèles.

Présentation de l'article:Ant Group a récemment annoncé le lancement d'une bibliothèque d'extension d'accélération de formation distribuée à grande échelle appelée ATorch, un outil open source. L'objectif d'ATorch est d'aider à améliorer l'intelligence de l'apprentissage profond grâce à l'optimisation dynamique automatique des ressources et à l'amélioration de la stabilité de la formation distribuée. Il est entendu que dans l'entraînement sur grand modèle, AToch peut augmenter le taux d'utilisation de la puissance de calcul d'un modèle d'entraînement de 100 milliards de kilocalories à 60 %, ce qui équivaut à l'ajout d'un moteur puissant à une voiture de sport. Il s’agira d’un outil important pour les chercheurs et les développeurs en apprentissage profond afin de les aider à former et à optimiser plus efficacement les grands modèles. Figure : ATorch s'engage à rendre la formation de grands modèles plus efficace et reproductible. Avec l'explosion des grands modèles génératifs, l'échelle des ensembles de données et des paramètres pour la formation de modèles est exponentielle.

2024-01-14

commentaire 0

1405

Comment implémenter des algorithmes distribués et une formation de modèles dans les microservices PHP

Présentation de l'article:Comment implémenter des algorithmes distribués et la formation de modèles dans les microservices PHP Introduction : Avec le développement rapide de la technologie du cloud computing et du Big Data, la demande de traitement de données et de formation de modèles augmente. Les algorithmes distribués et la formation de modèles sont essentiels pour atteindre l'efficacité, la rapidité et l'évolutivité. Cet article présentera comment implémenter des algorithmes distribués et la formation de modèles dans les microservices PHP, et fournira quelques exemples de code spécifiques. 1. Qu'est-ce que la formation d'algorithmes et de modèles distribués ? La formation d'algorithmes et de modèles distribués est des technologies qui utilisent plusieurs machines ou ressources de serveur pour effectuer simultanément le traitement des données et la formation de modèles.

2023-09-25

commentaire 0

1427

Quel est le modèle de formation PHP ?

Présentation de l'article:Le modèle de formation PHP est le suivant : 1. Un enseignement raffiné. Le modèle général est un enseignement en classe le matin et une pratique personnelle l'après-midi, avec l'assistance de professeurs expérimentés. 2. Ces formations PHP ont des projets concrets avec des entreprises et les stagiaires peuvent y participer ; en eux, profitez de ses ressources en emploi, de ses ressources de projet et des leçons apprises.

2020-02-21

commentaire 0

2394

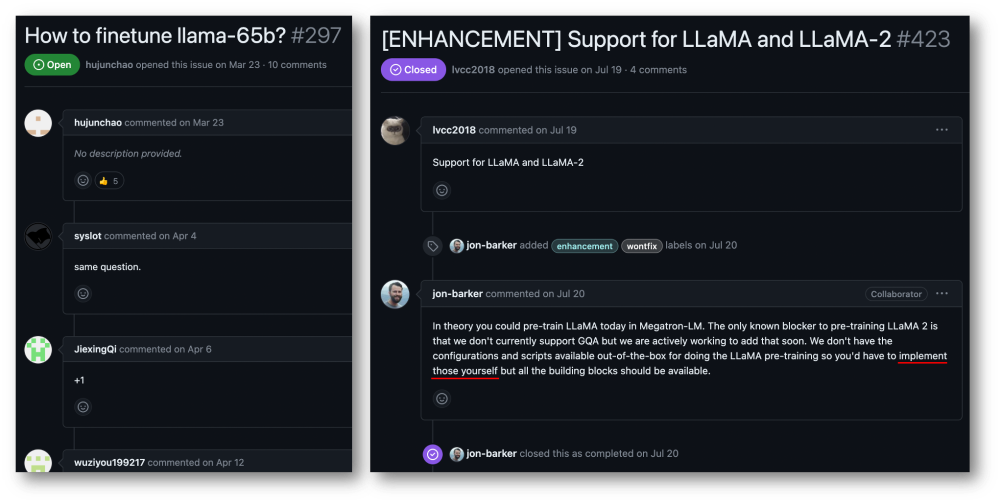

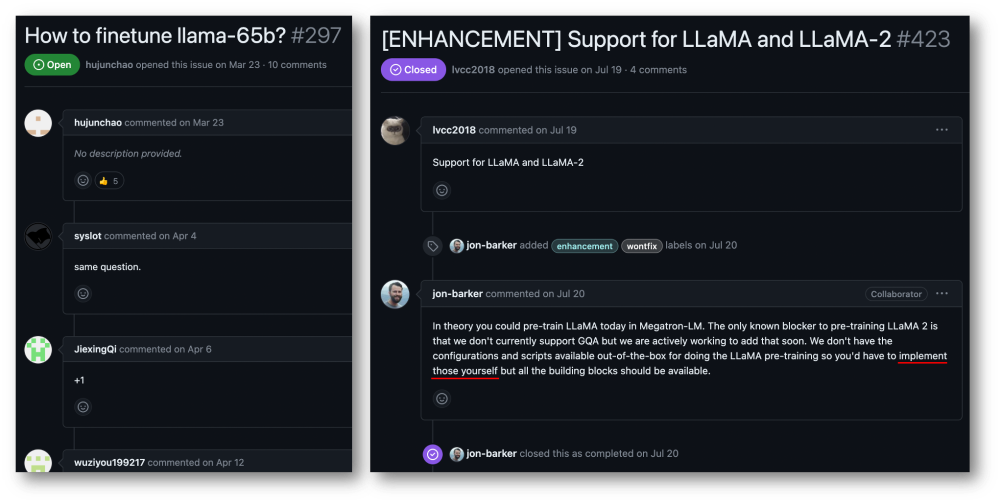

Accélération de formation de 32 cartes à 176 %, cadre de formation open source pour grands modèles Megatron-LLaMA est là

Présentation de l'article:Taotian Group et Aicheng Technology ont officiellement publié le cadre de formation open source pour grands modèles - Megatron-LLaMA le 12 septembre. L'objectif de ce cadre est de permettre aux développeurs de technologies d'améliorer plus facilement les performances de formation des grands modèles de langage, de réduire les coûts de formation et de maintenir la compatibilité avec la communauté LLaMA. Les résultats des tests montrent que sur une formation à 32 cartes, Megatron-LLaMA peut atteindre une accélération de 176 % par rapport à la version de code obtenue directement sur HuggingFace ; sur une formation à grande échelle, Megatron-LLaMA s'étend presque linéairement et est instable au réseau. niveau de tolérance. Actuellement, Megatron-LLaMA a été lancé dans la communauté open source à l'adresse open source : https :

2023-09-14

commentaire 0

614

Comment le framework Java accélère-t-il la formation des modèles d'intelligence artificielle ?

Présentation de l'article:Le framework Java peut accélérer la formation des modèles d'intelligence artificielle en : utilisant TensorFlowServing pour déployer des modèles pré-entraînés pour une inférence rapide ; en utilisant H2OAIDriverlessAI pour automatiser le processus de formation et en utilisant l'informatique distribuée pour réduire le temps de formation en utilisant SparkMLlib pour mettre en œuvre une formation distribuée et des données à grande échelle ; sur le traitement des ensembles d'architecture Apache Spark.

2024-06-04

commentaire 0

882

Guide de formation du modèle ChatGPT Python : injecter de nouvelles compétences dans votre chatbot

Présentation de l'article:Guide de formation du modèle ChatGPTPython : L'injection de nouvelles compétences dans les chatbots nécessite des exemples de code spécifiques Introduction : Ces dernières années, le développement rapide de la technologie de l'intelligence artificielle a rendu les chatbots largement utilisés dans divers domaines. Cependant, les modèles de chatbot existants ne fournissent souvent que des fonctions conversationnelles de base et ne peuvent pas disposer de compétences plus intelligentes, telles que des systèmes de réponse aux questions et de recommandation. Afin de permettre au chatbot d'avoir plus de compétences, nous pouvons utiliser le modèle ChatGPT et former le modèle via Python.

2023-10-24

commentaire 0

993

Utiliser des fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique

Présentation de l'article:Utilisation des fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique Avec le développement rapide de l'apprentissage automatique, de nombreux développeurs ont commencé à s'intéresser à la manière d'utiliser JavaScript pour implémenter la formation de modèles d'apprentissage automatique sur le front-end. Cet article explique comment utiliser les fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique et fournit des exemples de code spécifiques. Avant de commencer, nous devons comprendre quelques concepts importants. Ensemble de données : la formation du modèle d'apprentissage automatique nécessite un ensemble d'ensembles de données étiquetés en entrée. L'ensemble de données se compose de

2023-11-03

commentaire 0

1183

Transférer des applications d'apprentissage et des technologies communes dans la formation de grands modèles de langage

Présentation de l'article:Les grands modèles de langage font référence à des modèles de traitement du langage naturel comportant plus de 100 millions de paramètres. En raison de leur taille et de leur complexité, la formation d’un tel modèle nécessite des ressources informatiques et des données importantes. Par conséquent, l’apprentissage par transfert est devenu une méthode importante pour former de grands modèles de langage. En utilisant les modèles et les données existants, le processus de formation peut être accéléré et les performances améliorées. L'apprentissage par transfert peut transférer les paramètres et les connaissances des modèles formés sur d'autres tâches vers la tâche cible, réduisant ainsi les besoins en données et le temps de formation. Cette approche est largement utilisée dans la recherche et dans l’industrie, jetant les bases de la création de modèles de langage plus puissants. L'apprentissage par transfert est une méthode qui utilise un modèle déjà formé pour ajuster ses paramètres ou certains composants lors de la résolution d'autres tâches. Dans le domaine du traitement du langage naturel, l'apprentissage par transfert peut

2024-01-22

commentaire 0

922

Pour 1 890 $, vous pouvez former un modèle de diffusion de paramètres décent de 1,2 milliard à partir de zéro.

Présentation de l'article:Avec seulement 1 890 $ et 37 millions d’images, vous pouvez former un modèle de diffusion décent. Actuellement, les modèles génératifs de vision sont efficaces pour créer un contenu visuel réaliste, mais le coût et les efforts nécessaires à la formation de ces modèles à partir de zéro restent élevés. Par exemple, StableDiffusion2.1 a nécessité 200 000 heures A100GPU. Même si les chercheurs utilisent la méthode la plus avancée, il faut quand même plus d’un mois pour s’entraîner sur un GPU 8×H100. De plus, la formation de grands modèles pose également des défis pour les ensembles de données. Ces données sont essentiellement exprimées en centaines de millions, ce qui pose également des défis pour la formation des modèles. Les coûts de formation élevés et les exigences en matière d'ensembles de données créent des obstacles insurmontables au développement de modèles de diffusion à grande échelle. Maintenant, de SonyAI et plus encore

2024-07-29

commentaire 0

525

Former le modèle YOLOv7 et développer la détection d'incendie par IA

Présentation de l'article:1. Préparez l'ensemble de données. L'ensemble de données utilise des images open source, avec un total de 6 000 images d'incendie, marquées par deux catégories : fumée épaisse et incendie. Le projet Fire and Smoke utilise YOLO pour la formation. J'ai converti les données au format YOLO et les ai divisées en un ensemble de formation et un ensemble de vérification. Voir le répertoire de l'ensemble de données. 2. Pour la formation, veuillez vous référer à la documentation du site officiel de YOLOv7 pour le processus de formation. Modifiez le fichier data/coco.yaml et configurez le chemin et la catégorie des données d'entraînement. Téléchargez le modèle pré-entraîné yolov7.pt, puis vous pourrez commencer la formation. 3. Une fois la formation sur la surveillance des incendies terminée, recherchez le fichier modèle généré-best.pt dans le répertoire d'exécution sous le répertoire yolov7. je m'entraîne

2023-05-11

commentaire 0

974

Mininglamp Technology lance TensorBoard.cpp open source gratuit pour faciliter la pré-formation des grands modèles

Présentation de l'article:Récemment, Mininglamp Technology Group a implémenté l'interface C++ de TensorBoard, un outil de visualisation d'apprentissage automatique, qui enrichit encore l'ensemble d'outils de projet de grands modèles basés sur C++, rendant la surveillance du processus de pré-formation de grands modèles plus pratique et efficace, et accélérant les grands modèles. modèle de pré-formation dans le domaine du marketing. L'outil est open source sur Github. TensorBoard est un outil de visualisation d'apprentissage automatique développé par Google et est souvent utilisé pour surveiller divers indicateurs du processus d'apprentissage automatique. Zhao Liang, directeur technique principal de Mininglamp Technology, a déclaré : « Dans le processus de formation de grands modèles, la surveillance des données est une dimension importante, et TensorBoard visualise divers paramètres et résultats dans le modèle, tels que l'enregistrement des changements de perte et des ensembles de validation au cours du grand. processus de formation modèle.

2023-08-14

commentaire 0

794

Compression des connaissances : distillation de modèles et élagage de modèles

Présentation de l'article:La distillation et l'élagage de modèles sont des technologies de compression de modèles de réseaux neuronaux qui réduisent efficacement les paramètres et la complexité de calcul, et améliorent l'efficacité et les performances opérationnelles. La distillation du modèle améliore les performances en entraînant un modèle plus petit sur un modèle plus grand, transférant ainsi les connaissances. L'élagage réduit la taille du modèle en supprimant les connexions et les paramètres redondants. Ces deux techniques sont très utiles pour la compression et l'optimisation des modèles. Distillation de modèle La distillation de modèle est une technique qui reproduit le pouvoir prédictif d'un grand modèle en entraînant un modèle plus petit. Le grand modèle est appelé « modèle enseignant » et le petit modèle est appelé « modèle étudiant ». Les modèles d'enseignant ont généralement plus de paramètres et de complexité et s'adaptent donc mieux aux données de formation et de test. Dans la distillation du modèle, le modèle étudiant est entraîné à imiter le comportement prédit du modèle enseignant afin d'obtenir de meilleures performances sur un modèle plus petit.

2024-01-23

commentaire 0

744

Méthodes adaptatives pour entraîner des modèles ML

Présentation de l'article:La méthode adaptative fait référence à l'utilisation de la technologie d'ajustement dynamique dans les modèles d'apprentissage automatique pour parvenir à l'auto-adaptation et à l'amélioration du modèle. Ces méthodes permettent aux modèles de s'ajuster en fonction des données en temps réel et des changements environnementaux, améliorant ainsi les performances et s'adaptant aux nouvelles situations. Les méthodes adaptatives courantes incluent l'adaptation des paramètres, l'ajustement du taux d'apprentissage, la sélection des fonctionnalités et l'intégration de modèles. Ces méthodes peuvent aider le modèle à s'adapter à différentes tâches et environnements, améliorant ainsi la précision et la robustesse du modèle. L'apprentissage incrémentiel est une méthode qui introduit continuellement de nouveaux échantillons de formation pour mettre à jour les paramètres du modèle. Par rapport au recyclage de l’ensemble du modèle, l’apprentissage incrémentiel évite le gaspillage de ressources informatiques et de temps. En ajoutant continuellement de nouveaux échantillons, le modèle peut s'adapter progressivement aux nouvelles données et améliorer les performances tout en conservant l'efficacité des paramètres d'origine. cette méthode

2024-01-23

commentaire 0

1121

Problème de temps de formation du modèle d'apprentissage en profondeur

Présentation de l'article:Introduction à la question du temps de formation des modèles d'apprentissage profond : Avec le développement du deep learning, les modèles d'apprentissage profond ont obtenu des résultats remarquables dans divers domaines. Cependant, le temps de formation des modèles d’apprentissage profond est un problème courant. Dans le cas d’ensembles de données à grande échelle et de structures de réseau complexes, le temps de formation des modèles d’apprentissage profond augmente considérablement. Cet article abordera le problème du temps de formation des modèles d'apprentissage profond et donnera des exemples de code spécifiques. L'informatique parallèle accélère le temps de formation Le processus de formation des modèles d'apprentissage profond nécessite généralement une grande quantité de ressources informatiques et de temps. Afin d'accélérer la formation

2023-10-09

commentaire 0

1712

Modèle de pré-formation Text-to-SQL multitâche en deux étapes MIGA basé sur T5

Présentation de l'article:De plus en plus de travaux ont prouvé que les modèles linguistiques pré-entraînés (PLM) contiennent des connaissances riches. Pour différentes tâches, l'utilisation de méthodes de formation appropriées pour tirer parti du PLM peut mieux améliorer les capacités du modèle. Dans les tâches Text-to-SQL, les générateurs traditionnels actuels sont basés sur des arbres syntaxiques et doivent être conçus pour la syntaxe SQL. Récemment, NetEase Interactive Entertainment AI Lab s'est associé à l'Université des études étrangères du Guangdong et à l'Université de Columbia pour proposer un modèle de pré-formation multitâche en deux étapes MIGA basé sur la méthode de pré-formation du modèle de langage pré-entraîné T5. MIGA introduit trois tâches auxiliaires dans la phase de pré-formation et les organise dans un paradigme de tâches de génération unifiée, qui peut intégrer tous les ensembles de données Text-to-SQL

2023-04-13

commentaire 0

1297

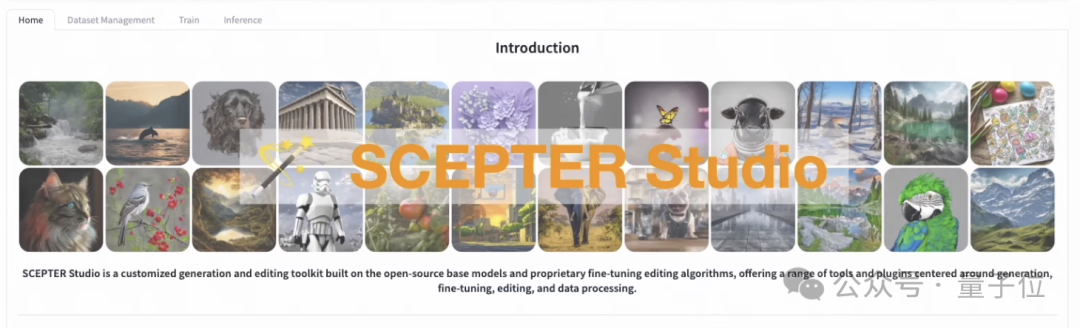

La formation au raisonnement d'un modèle de dessin d'IA peut être effectuée avec une page Web

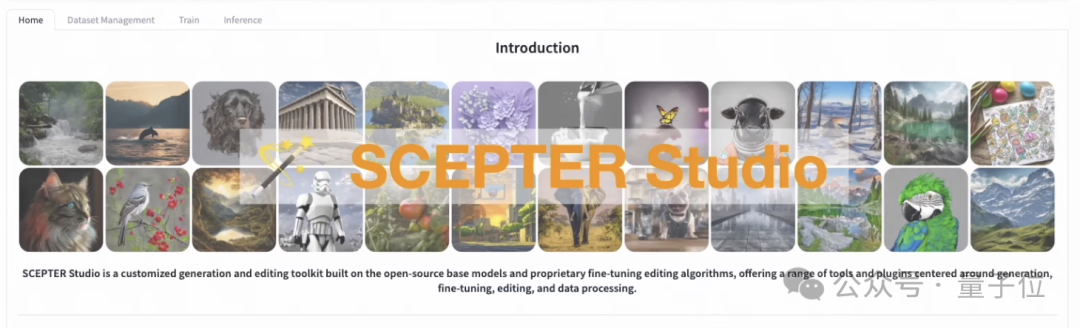

Présentation de l'article:Vous pouvez entraîner un modèle de peinture IA même si vous ne savez pas écrire du code ! Avec l'aide de ce cadre, tout, de la formation à l'inférence, peut être géré en un seul arrêt, et plusieurs modèles peuvent être gérés simultanément. L'équipe Alibaba a lancé et open source SCEPTERStudio, un atelier de génération d'images universel. Avec lui, vous pouvez effectuer la formation et le réglage du modèle directement dans l'interface Web sans codage, et gérer les données associées. L'équipe a également lancé une DEMO avec trois modèles intégrés, vous permettant de découvrir la fonction d'inférence de SCEPTER en ligne. Voyons donc ce que SCEPTER peut faire spécifiquement ! Gestion centralisée des modèles de dessin Avec SCEPTER, l'écriture de programmes devient inutile. La formation et la mise au point peuvent être effectuées simplement en sélectionnant le modèle et en ajustant les paramètres sur la page Web.

2024-02-19

commentaire 0

1093