10000 contenu connexe trouvé

Comment puis-je appeler du code C (DLL) à partir de C# ?

Présentation de l'article:Appeler du code C à partir de C#Dans un scénario typique, l'interface avec des bibliothèques externes et du code écrit dans différents langages de programmation peut poser un problème...

2025-01-14

commentaire 0

912

Développement d'une API RESTful simple avec Gin, ginvalidator et validatorgo

Présentation de l'article:Ce didacticiel vous guide tout au long de la création d'une API RESTful de base à l'aide de Go, du framework Gin et des bibliothèques open source commençant par Validator et Validator Go. Ces bibliothèques simplifient la validation des entrées, rendant votre API plus robuste. Nous créerons une API pour gérer l'inventaire des produits. L'API prendra en charge

2025-01-14

commentaire 0

717

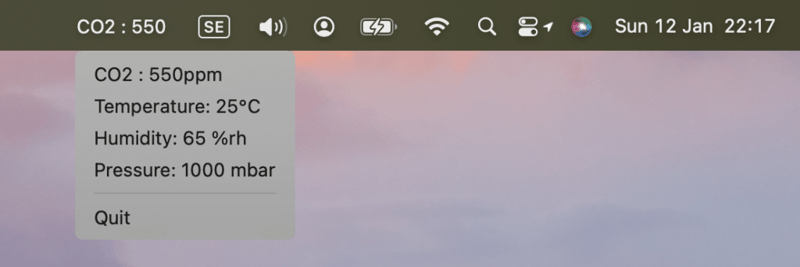

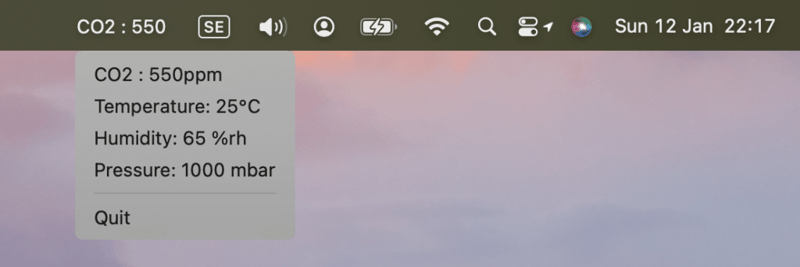

Création d'une application de barre de menus macOS en temps réel BLE

Présentation de l'article:Ce didacticiel montre la création d'une application de barre de menus MacOS en temps réel à l'aide d'un onglet contextuel BleuIOUSBBLE pour afficher les données environnementales. BleuIO simplifie le développement BLE (Bluetooth Low Energy), ce qui le rend idéal pour créer des projets innovants.Les applications de barre de menus MacOS offrent un moyen discret de surveillance.

2025-01-14

commentaire 0

710

Création de pages HTML statiques avec le rendu côté serveur JSX

Présentation de l'article:Introduction

Avez-vous déjà visité un site Web dont le chargement prenait une éternité ? Frustrant, n'est-ce pas ? Des temps de chargement rapides et une expérience utilisateur fluide ne sont pas seulement des atouts : ils sont essentiels pour fidéliser les visiteurs et obtenir un classement élevé dans les résultats de recherche.

2025-01-14

commentaire 0

816

FastHTML et Heroku

Présentation de l'article:FastHTML : ASwiftPathtoWebAppDevelopmentwithPythonLe développement de nouvelles applications nécessite souvent la maîtrise de nombreux outils et frameworks. Pour les développeurs Python, s'aventurer dans HTML, CSS et JavaScript peut constituer un obstacle important. À l'inverse, les développeurs Web peuvent trouver des outils backend Python.

2025-01-14

commentaire 0

557

Assertions au moment de la compilation dans Go (Golang)

Présentation de l'article:Le mécanisme d'assertion au moment de la compilation du langage Go est utilisé pour appliquer des conditions ou des contraintes spécifiques au stade de la compilation plutôt qu'au moment de l'exécution. Si les conditions ne sont pas remplies, le processus de compilation échouera et signalera une erreur, ce qui permettra de détecter les erreurs le plus tôt possible et de garantir que le programme satisfait certains invariants ou hypothèses avant son exécution. Les assertions au moment de la compilation sont souvent utilisées pour garantir que les structures de données sont dimensionnées comme prévu. Vérifiez que la valeur d'une constante ou d'une expression est celle attendue. Appliquez des contraintes de type ou d’autres contrôles au moment de la compilation. Assertions au moment de la compilation dans Go Le langage Go lui-même ne prend pas directement en charge les assertions au moment de la compilation comme certains autres langages. Cependant, nous pouvons obtenir des fonctionnalités similaires avec quelques techniques intelligentes. Voici quelques méthodes courantes : Affirmer qu'une expression booléenne constante est vraie (ou fausse) au moment de la compilation : Nous pouvons profiter des fonctionnalités suivantes : La spécification du langage Go est claire

2025-01-14

commentaire 0

760