10000 contenu connexe trouvé

La différence entre les grands modèles de langage et les modèles d'intégration de mots

Présentation de l'article:Les grands modèles de langage et les modèles d’intégration de mots sont deux concepts clés du traitement du langage naturel. Ils peuvent tous deux être appliqués à l’analyse et à la génération de texte, mais les principes et les scénarios d’application sont différents. Les modèles linguistiques à grande échelle sont principalement basés sur des modèles statistiques et probabilistes et conviennent à la génération continue de textes et à une compréhension sémantique. Le modèle d'intégration de mots peut capturer la relation sémantique entre les mots en mappant les mots sur un espace vectoriel, et convient à l'inférence de signification de mot et à la classification de texte. 1. Modèle d'incorporation de mots Le modèle d'incorporation de mots est une technologie qui traite les informations textuelles en mappant les mots dans un espace vectoriel de faible dimension. Il convertit les mots d'une langue sous forme vectorielle afin que les ordinateurs puissent mieux comprendre et traiter le texte. Les modèles d'intégration de mots couramment utilisés incluent Word2Vec et GloVe. Ces modèles sont largement utilisés dans les tâches de traitement du langage naturel

2024-01-23

commentaire 0

1441

Les 6 meilleurs grands modèles de langage en 2023

Présentation de l'article:C'est la saison de l'IA, et les entreprises technologiques produisent de grands modèles linguistiques comme le pain d'une boulangerie. Les nouveaux modèles sont publiés rapidement et il devient trop difficile de suivre. Mais au milieu de la vague de nouvelles versions, seuls quelques modèles sont disponibles.

2024-06-14

commentaire 0

905

Application de stratégies de décodage dans de grands modèles de langage

Présentation de l'article:Les modèles linguistiques à grande échelle constituent une technologie clé dans le domaine du traitement du langage naturel, affichant de solides performances dans diverses tâches. La stratégie de décodage est l'un des aspects importants de la génération de texte par le modèle. Cet article détaillera les stratégies de décodage dans les grands modèles de langage et discutera de leurs avantages et inconvénients. 1. Aperçu des stratégies de décodage Dans les grands modèles de langage, les stratégies de décodage sont des méthodes permettant de générer des séquences de texte. Les stratégies de décodage courantes incluent la recherche gourmande, la recherche par faisceau et la recherche aléatoire. La recherche gourmande est une méthode simple et directe qui sélectionne à chaque fois le mot avec la probabilité la plus élevée comme mot suivant, mais peut ignorer d'autres possibilités. La recherche par faisceau ajoute une restriction de largeur sur la base d'une recherche gourmande, ne conservant que les mots candidats ayant la probabilité la plus élevée, augmentant ainsi la diversité. La recherche aléatoire sélectionne au hasard le mot suivant, ce qui peut produire des résultats plus diversifiés.

2024-01-22

commentaire 0

1191

Amélioration des méthodes d'annotation de données pour les grands modèles de langage (LLM)

Présentation de l'article:Le réglage fin des modèles de langage à grande échelle (LLM) implique le recyclage d'un modèle pré-entraîné à l'aide de données spécifiques au domaine pour l'adapter à une tâche ou un domaine spécifique. L'annotation des données joue un rôle crucial dans le processus de réglage fin et implique d'étiqueter les données avec des informations spécifiques que le modèle doit comprendre. 1. Principe de l'annotation des données L'annotation des données vise à aider les modèles d'apprentissage automatique à mieux comprendre et traiter les données en ajoutant des métadonnées, telles que des balises, des balises, etc., aux données. Pour le réglage fin des grands modèles de langage, le principe de l'annotation des données est de fournir des informations directrices pour aider le modèle à mieux comprendre le langage et le contexte d'un domaine spécifique. Les méthodes courantes d'annotation de données incluent la reconnaissance d'entités, l'analyse des sentiments et l'extraction de relations. 2. Méthodes d'annotation des données 2.1 Reconnaissance d'entités La reconnaissance d'entités est une sorte d'extraction d'informations

2024-01-22

commentaire 0

1109

Métriques d'évaluation des grands modèles de langage

Présentation de l'article:Cet article examine les métriques les plus largement utilisées et les plus fiables pour évaluer les grands modèles de langage (LLM). L'article traite des différentes catégories de métriques, notamment BLEU, ROUGE, METEOR et NIST, et de la manière dont elles mesurent les performances de L.

2024-08-13

commentaire 0

1044

Transférer des applications d'apprentissage et des technologies communes dans la formation de grands modèles de langage

Présentation de l'article:Les grands modèles de langage font référence à des modèles de traitement du langage naturel comportant plus de 100 millions de paramètres. En raison de leur taille et de leur complexité, la formation d’un tel modèle nécessite des ressources informatiques et des données importantes. Par conséquent, l’apprentissage par transfert est devenu une méthode importante pour former de grands modèles de langage. En utilisant les modèles et les données existants, le processus de formation peut être accéléré et les performances améliorées. L'apprentissage par transfert peut transférer les paramètres et les connaissances des modèles formés sur d'autres tâches vers la tâche cible, réduisant ainsi les besoins en données et le temps de formation. Cette approche est largement utilisée dans la recherche et dans l’industrie, jetant les bases de la création de modèles de langage plus puissants. L'apprentissage par transfert est une méthode qui utilise un modèle déjà formé pour ajuster ses paramètres ou certains composants lors de la résolution d'autres tâches. Dans le domaine du traitement du langage naturel, l'apprentissage par transfert peut

2024-01-22

commentaire 0

877

Défi du modèle de langage étendu du périphérique NeurIPS2024 Edge

Présentation de l'article:Avec le développement rapide de l’intelligence artificielle, notamment dans le domaine du traitement du langage naturel (NLP), les grands modèles de langage (LLM) ont montré un grand potentiel de transformation. Ces modèles changent notre façon de travailler et de communiquer, et présentent un large éventail d'applications sur une variété d'appareils informatiques. Cependant, l’énorme modèle de LLM pose des défis considérables quant à son application sur des appareils de pointe tels que les smartphones, les appareils IoT et les systèmes montés sur véhicule. Notre concours vise à repousser les limites des performances, de l'efficacité et des capacités multitâches de LLM sur les appareils de périphérie aux ressources limitées. Contexte de la concurrence : bien que le LLM ait un énorme potentiel d'application, ses énormes paramètres imposent de fortes exigences aux ressources des appareils de pointe. Par exemple, un modèle LLM à paramètres 10B nécessite

2024-08-07

commentaire 0

515

Linguistique en intelligence artificielle : modèles de langage dans le traitement du langage naturel Python

Présentation de l'article:Le traitement du langage naturel (NLP) est un domaine de l'informatique qui vise à permettre aux ordinateurs de communiquer efficacement en utilisant le langage naturel. Les modèles linguistiques jouent un rôle crucial en PNL. Ils peuvent apprendre les distributions de probabilité dans le langage pour effectuer diverses tâches de traitement du texte, telles que la génération de texte, la traduction automatique et l'analyse des sentiments. Types de modèles de langage Il existe deux principaux types de modèles de langage : Modèle de langage n-gram : considère les n mots précédents pour prédire la probabilité du mot suivant, n est appelé l'ordre. Modèle de langage neuronal : utilisez les réseaux de neurones pour apprendre des relations complexes dans le langage. Modèle de langage en Python Il existe de nombreuses bibliothèques en Python qui peuvent implémenter des modèles de langage, notamment : nltk.lm : fournit l'implémentation du modèle de langage n-gram. ge

2024-03-21

commentaire 0

1195

Grand modèle de langage LLM et génération d'améliorations de récupération

Présentation de l'article:Les grands modèles de langage LLM sont généralement formés à l'aide de l'architecture Transformer pour améliorer la capacité à comprendre et à générer un langage naturel à travers de grandes quantités de données textuelles. Ces modèles sont largement utilisés dans les chatbots, la synthèse de texte, la traduction automatique et d'autres domaines. Certains grands modèles de langage LLM bien connus incluent la série GPT d'OpenAI et le BERT de Google. Dans le domaine du traitement du langage naturel, la génération améliorée par récupération est une technique qui combine récupération et génération. Il génère un texte qui répond aux exigences en récupérant les informations pertinentes à partir de corpus de textes à grande échelle et en utilisant des modèles génératifs pour recombiner et organiser ces informations. Cette technique a un large éventail d'applications, notamment le résumé de texte, la traduction automatique, la génération de dialogues et d'autres tâches. Amélioration de la récupération en tirant parti de la récupération et de la génération

2024-01-23

commentaire 0

1208

Pensée inversée : le nouveau modèle de langage de raisonnement mathématique MetaMath entraîne de grands modèles

Présentation de l'article:Le raisonnement mathématique complexe est un indicateur important pour évaluer la capacité de raisonnement des grands modèles de langage. Actuellement, les ensembles de données de raisonnement mathématique couramment utilisés ont des tailles d'échantillon limitées et une diversité de problèmes insuffisante, ce qui entraîne le phénomène de « malédiction d'inversion » dans les grands modèles de langage. c'est-à-dire une personne formée sur « A est B » « Le modèle de langage ne peut pas être généralisé à « B est A » [1]. La forme spécifique de ce phénomène dans les tâches de raisonnement mathématique est la suivante : étant donné un problème mathématique, le modèle de langage est efficace pour utiliser le raisonnement direct pour résoudre le problème, mais n'a pas la capacité de résoudre le problème avec un raisonnement inverse. Le raisonnement inverse est très courant dans les problèmes mathématiques, comme le montrent les deux exemples suivants. 1. Question classique - Raisonnement direct des poules et des lapins dans la même cage : Il y a 23 poules et 12 lapins dans la cage. Combien de têtes et combien de pieds y a-t-il dans la cage ? Raisonnement inverse : Il y a plusieurs poules et lapins dans la même cage en partant du haut, il y en a 3.

2023-10-11

commentaire 0

947

Pourquoi les grands modèles linguistiques utilisent-ils SwiGLU comme fonction d'activation ?

Présentation de l'article:Si vous avez prêté attention à l'architecture des grands modèles de langage, vous avez peut-être vu le terme « SwiGLU » dans les derniers modèles et documents de recherche. SwiGLU peut être considéré comme la fonction d'activation la plus couramment utilisée dans les grands modèles de langage. Nous la présenterons en détail dans cet article. SwiGLU est en fait une fonction d'activation proposée par Google en 2020, qui combine les caractéristiques de SWISH et de GLU. Le nom chinois complet de SwiGLU est « unité linéaire à porte bidirectionnelle ». Il optimise et combine deux fonctions d'activation, SWISH et GLU, pour améliorer la capacité d'expression non linéaire du modèle. SWISH est une fonction d'activation très courante et largement utilisée dans les grands modèles de langage, tandis que GLU a montré de bonnes performances dans les tâches de traitement du langage naturel.

2024-04-08

commentaire 0

1115

Propriétés autorégressives des modèles de langage

Présentation de l'article:Le modèle de langage autorégressif est un modèle de traitement du langage naturel basé sur la probabilité statistique. Il génère des séquences de texte continues en exploitant les séquences de mots précédentes pour prédire la distribution de probabilité du mot suivant. Ce modèle est très utile dans le traitement du langage naturel et est largement utilisé dans la génération de langage, la traduction automatique, la reconnaissance vocale et d'autres domaines. En analysant les données historiques, les modèles linguistiques autorégressifs sont capables de comprendre les lois et la structure du langage pour générer un texte cohérent et précis sémantiquement. Il peut non seulement être utilisé pour générer du texte, mais également pour prédire le mot suivant, fournissant ainsi des informations utiles pour les tâches de traitement de texte ultérieures. Par conséquent, les modèles de langage autorégressifs constituent une technique importante et pratique dans le traitement du langage naturel. 1. Le concept de modèle autorégressif Le modèle autorégressif est un modèle qui utilise des observations antérieures pour

2024-01-22

commentaire 0

682

Plus il y a de mots dans le document, plus le modèle sera excité ! KOSMOS-2.5 : grand modèle de langage multimodal pour la lecture d''images riches en texte'

Présentation de l'article:Une tendance claire est actuellement à la construction de modèles plus grands et plus complexes avec des dizaines/centaines de milliards de paramètres capables de générer des résultats linguistiques impressionnants. Cependant, les modèles linguistiques à grande échelle existants se concentrent principalement sur les informations textuelles, incapables de comprendre les informations visuelles. Les progrès dans le domaine des grands modèles de langage multimodaux (MLLM) visent à remédier à cette limitation. Les MLLM fusionnent les informations visuelles et textuelles en un seul modèle basé sur Transformer, permettant au modèle d'apprendre et de générer du contenu basé sur les deux modalités. Les MLLM montrent du potentiel dans diverses applications pratiques, notamment la compréhension d’images naturelles et la compréhension d’images textuelles. Ces modèles exploitent la modélisation du langage comme interface commune pour gérer les problèmes multimodaux, leur permettant de modéliser

2023-09-29

commentaire 0

660

Idéalement formé le plus grand ViT de l'histoire ? Google met à niveau le modèle de langage visuel PaLI : prend en charge plus de 100 langues

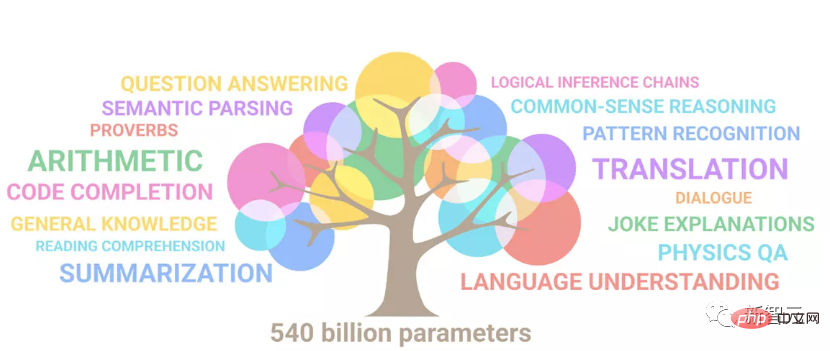

Présentation de l'article:Les progrès du traitement du langage naturel ces dernières années proviennent en grande partie de modèles de langage à grande échelle. Chaque nouveau modèle publié pousse la quantité de paramètres et de données d'entraînement vers de nouveaux sommets, et en même temps, les classements de référence existants seront abattus ! Par exemple, en avril de cette année, Google a publié le modèle de langage PaLM (Pathways Language Model) composé de 540 milliards de paramètres, qui a surpassé avec succès les humains dans une série de tests de langage et de raisonnement, en particulier ses excellentes performances dans des scénarios d'apprentissage sur petits échantillons. PaLM est considéré comme la direction de développement du modèle de langage de nouvelle génération. De la même manière, les modèles de langage visuel font des merveilles et les performances peuvent être améliorées en augmentant la taille du modèle. Bien sûr, s'il ne s'agit que d'un modèle de langage visuel multitâche

2023-04-12

commentaire 0

1322

Types et fonctions de paramètres courants : explication détaillée des paramètres des grands modèles de langage

Présentation de l'article:Les grands modèles de langage font référence à des modèles de traitement du langage naturel comportant un grand nombre de paramètres, contenant généralement des milliards de paramètres. Ces paramètres jouent un rôle clé dans la détermination des performances du modèle. Les principaux paramètres et leurs fonctions sont présentés ci-dessous. 1. Paramètres de la couche d'intégration La couche d'intégration est considérée comme un élément clé de la conversion des séquences de texte en séquences vectorielles. Il mappe chaque mot à une représentation vectorielle pour aider le modèle à comprendre la relation sémantique entre les mots. Le nombre de paramètres de la couche d'intégration est généralement lié à la taille du vocabulaire, c'est-à-dire correspondant au nombre de mots dans le vocabulaire. Le rôle de ces paramètres est d’apprendre les relations entre les mots pour une compréhension sémantique de niveau supérieur aux niveaux suivants. Les couches d'intégration jouent un rôle important dans les tâches de traitement du langage naturel telles que l'analyse des sentiments, la classification de texte et la traduction automatique. En apprenant efficacement entre les mots

2024-01-23

commentaire 0

1534

Le grand modèle de langage bat le modèle de diffusion ! Génération d'images vidéo double SOTA, la dernière recherche de Google CMU, un ancien élève de l'Université de Pékin

Présentation de l'article:Le modèle de langage bat le modèle de diffusion et réalise le double SOTA en génération de vidéo et d'image ! Il s’agit du dernier résultat de recherche de Google CMU. Selon les rapports, c'est la première fois qu'un modèle de langage bat un modèle de diffusion sur le benchmark emblématique ImageNet. Le composant clé derrière cela est le tokenizer visuel (videotokenizer), qui mappe l'entrée de l'espace de pixels en jetons adaptés à l'apprentissage LLM. L'équipe de recherche de Google CMU a proposé MAGVIT-v2, qui a surpassé le précédent meilleur segmenteur de mots visuel dans deux autres tâches. Les grands modèles de langage battent les modèles de diffusion Il existe un consensus sur le fait que les grands modèles de langage ont d'excellentes performances dans divers domaines génératifs. Tels que le texte, l'audio, la génération de code, etc. Mais historiquement en termes de génération visuelle, de langage

2023-10-16

commentaire 0

796

Affiner votre grand modèle de langage (LLM) avec Mistral : un guide étape par étape

Présentation de l'article:Salut, amis passionnés d’IA ! ? Êtes-vous prêt à libérer tout le potentiel de vos grands modèles linguistiques (LLM) ? Aujourd’hui, nous plongeons dans le monde de la mise au point en utilisant Mistral comme modèle de base. Si vous travaillez sur des tâches PNL personnalisées et souhaitez

2024-08-29

commentaire 0

386

Déployer de grands modèles de langage localement dans OpenHarmony

Présentation de l'article:Cet article ouvrira en source les résultats du « Déploiement local de grands modèles de langage dans OpenHarmony » démontrés lors de la 2e conférence technologique OpenHarmony. Adresse : https://gitee.com/openharmony-sig/tpc_c_cplusplus/blob/master/thirdparty/. InferLLM/docs/hap_integrate.md. Les idées et les étapes de mise en œuvre consistent à transplanter le cadre d'inférence de modèle LLM léger InferLLM vers le système standard OpenHarmony et à compiler un produit binaire pouvant s'exécuter sur OpenHarmony. InferLLM est un L simple et efficace

2024-06-07

commentaire 0

926

Il existe des preuves. Le MIT montre que les grands modèles de langage ≠ les perroquets aléatoires peuvent effectivement apprendre la sémantique.

Présentation de l'article:Alors que les grands modèles linguistiques pré-entraînés (LLM) ont démontré des performances considérablement améliorées dans une gamme de tâches en aval, comprennent-ils vraiment la sémantique du texte qu'ils utilisent et génèrent ? La communauté de l’IA a longtemps été profondément divisée sur cette question. On peut supposer que les modèles linguistiques formés uniquement sur la forme du langage (comme la distribution conditionnelle de jetons dans un corpus de formation) n’acquerront aucune sémantique. Au lieu de cela, ils génèrent simplement du texte basé sur des corrélations statistiques superficielles glanées à partir des données de formation, leurs fortes capacités d'émergence étant attribuées à la taille du modèle et des données de formation. Ces personnes appellent LLM le « perroquet aléatoire ». Mais certaines personnes ne sont pas d’accord avec ce point de vue. Une étude récente a montré qu'environ 51 % des personnes interrogées dans la communauté PNL conviennent que « certains

2023-05-23

commentaire 0

1015