10000 contenu connexe trouvé

Quels sont les moyens de capturer des données ?

Présentation de l'article:Façons de capturer des données : 1. Utiliser un navigateur Web ; 2. Utiliser un langage de programmation ; 3. Utiliser un robot d'exploration de données ; 4. Utiliser une API ;

2023-11-10

commentaire 0

2190

Quels sont les moyens de capturer des données en utilisant php ?

Présentation de l'article:Les méthodes de capture de données PHP incluent l'utilisation de la bibliothèque cURL, l'utilisation de la fonction file_get_contents, l'utilisation de la bibliothèque Simple HTML DOM, l'utilisation de bibliothèques tierces, etc. Introduction détaillée : 1. En utilisant la bibliothèque cURL, PHP fournit l'extension cURL, qui peut être utilisée pour capturer des données. En utilisant la bibliothèque cURL, vous pouvez facilement définir des en-têtes de requête, envoyer des requêtes POST ou GET et obtenir les données renvoyées par le serveur. 2. Utilisez la méthode de fonction file_get_contents et ainsi de suite.

2023-08-15

commentaire 0

1306

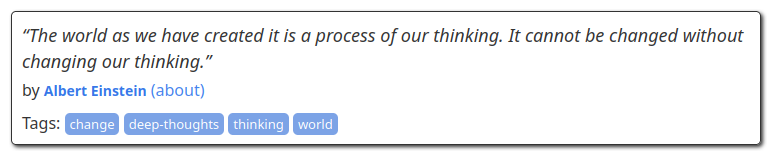

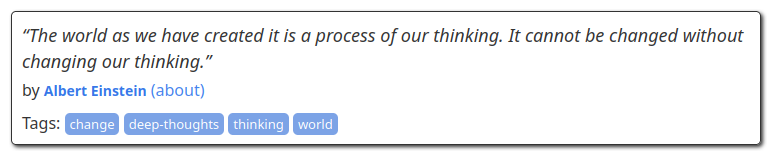

Scraper mais valider : grattage de données avec la validation Pydantic

Présentation de l'article:Remarque : il ne s'agit pas d'une sortie de chatGPT/LLM

Le grattage de données est un processus de collecte de données à partir de sources Web publiques et il est principalement effectué à l'aide d'un script de manière automatisée. En raison de l'automatisation, les données collectées comportent souvent des erreurs et doivent être filtrées et nettoyées.

2024-11-22

commentaire 0

877

Comment utiliser BeautifulSoup pour récupérer des données Web

Présentation de l'article:Comment utiliser BeautifulSoup pour explorer les données de pages Web Introduction : À l'ère de l'information sur Internet, les données de pages Web sont l'une des principales sources d'information. Pour extraire des informations utiles des pages Web, nous devons utiliser certains outils pour analyser et explorer les données des pages Web. Parmi eux, BeautifulSoup est une bibliothèque Python populaire qui peut facilement extraire des données de pages Web. Cet article explique comment utiliser BeautifulSoup pour explorer les données d'une page Web et est accompagné d'un exemple de code. 1. Installez Beau

2023-08-03

commentaire 0

2166

Intégration de PHP et Apache Nutch pour réaliser le web scraping et le data scraping

Présentation de l'article:Avec l’avènement de l’ère Internet, nous sommes confrontés chaque jour à d’énormes quantités d’informations et de données. Dans ce processus, la capture et la collecte de données sont devenues un élément très important. Pour les développeurs, trouver un excellent outil pour réaliser une exploration efficace du Web et des données est devenu un problème qu’ils doivent résoudre. Parmi les nombreux outils d'exploration, ApacheNutch est devenu un choix très populaire parmi les développeurs en raison de ses puissantes capacités et de ses excellentes performances. Dans le même temps, en tant que langage de programmation back-end mature, PHP

2023-06-25

commentaire 0

1115

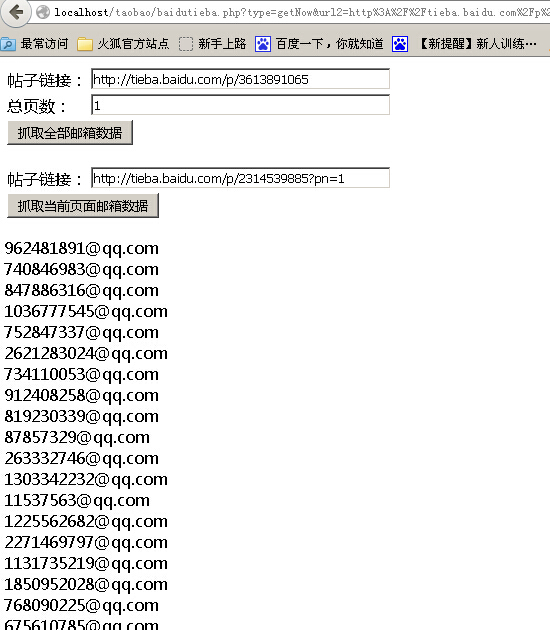

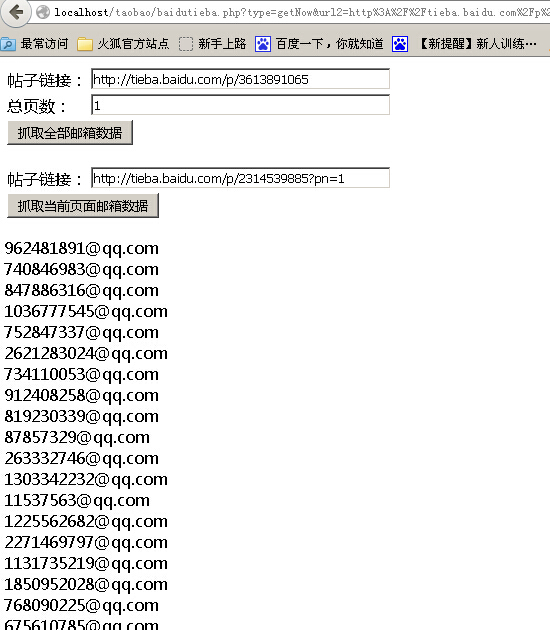

PHP网页抓取之抓取百度贴吧邮箱数据代码分享

Présentation de l'article:本文给大家介绍PHP网页抓取之抓取百度贴吧邮箱数据代码分享,程序实现了一键抓取帖子全部邮箱和分页抓取邮箱两个功能,感兴趣的朋友一起学习吧

2016-06-10

commentaire 0

1104

Comment utiliser le robot d'exploration PHP pour explorer les données de l'interface API ?

Présentation de l'article:Comment utiliser le robot d'exploration PHP pour explorer les données de l'interface API ? En tant qu'outil efficace de récupération de données, les robots d'exploration sont souvent utilisés pour extraire des données précieuses des pages Web. Dans le développement réel, nous avons souvent besoin d'obtenir des données d'interface API via des robots d'exploration pour une analyse et un traitement ultérieurs des données. Cet article explique comment utiliser les classes du robot d'exploration PHP pour analyser les données de l'interface API et joint des exemples de code correspondants. Déterminez l'interface API cible Avant de commencer, nous devons d'abord déterminer l'interface API que nous souhaitons explorer, y compris l'URL de l'interface,

2023-08-07

commentaire 0

1459

Comment utiliser PHP pour implémenter des fonctions de récupération de données et d'analyse de pages Web

Présentation de l'article:Comment utiliser PHP pour implémenter des fonctions de capture de données et d'analyse de pages Web. À l'ère moderne d'Internet, les données sont une ressource très précieuse. Être capable d'obtenir rapidement et avec précision les données requises est notre besoin fondamental pour l'analyse de données, l'exploration de données ou le développement Web. . En utilisant le langage de programmation PHP, nous pouvons facilement implémenter des fonctions de capture de données et d'analyse de pages Web. Cet article présentera comment utiliser PHP pour implémenter des fonctions de capture de données et d'analyse de pages Web, et fournira des exemples de code correspondants. 1. La capture de données utilise la bibliothèque cURL pour la capture de données

2023-09-05

commentaire 0

1124

Comment récupérer des données Web en Python

Présentation de l'article:Comment effectuer du web scraping en Python Le web scraping fait référence au processus d'obtention d'informations sur Internet. En Python, il existe de nombreuses bibliothèques puissantes qui peuvent nous aider à atteindre cet objectif. Cet article explique comment utiliser Python pour explorer les données réseau et fournit des exemples de code spécifiques. Installation des bibliothèques nécessaires Avant de commencer, nous devons installer certaines bibliothèques nécessaires. Parmi elles, les trois bibliothèques suivantes sont les plus couramment utilisées : urllib : utilisée pour obtenir des données à partir des requêtes URL : requêtes réseau plus avancées et concises

2023-10-20

commentaire 0

882

phpQuery 数据抓取疑点

Présentation de l'article:

phpQuery 数据抓取疑问我想使用phpQuery 抓取某东产品的名字和价格,能取到产品名称,不能取到价格,因为源代码的价格是使用JS输出的,如果用Chrome浏览器审查元素是有价格的,应该怎样取得审查元素里的价格?------解决方案--------------------是ajax的吧?那就得多一次请求了如果是js代码,那就要用正则去匹

2016-06-13

commentaire 0

889

Scrapy est une application de récupération de données fournie avec des modèles de robots d'exploration

Présentation de l'article:Avec le développement continu de la technologie Internet, la technologie des robots d’exploration a également été largement utilisée. La technologie Crawler peut explorer automatiquement les données sur Internet et les stocker dans une base de données, ce qui facilite l'analyse et l'exploration de données. En tant que framework d'exploration très célèbre en Python, Scrapy est livré avec des modèles d'exploration courants, qui peuvent analyser rapidement les données sur le site Web cible et les enregistrer automatiquement dans une base de données locale ou cloud. Cet article explique comment utiliser le propre modèle d'analyseur de Scrapy pour analyser les données et comment l'utiliser après l'analyse.

2023-06-22

commentaire 0

806

Comment optimiser l'exploration du Web et le grattage de données à l'aide de PHP et REDIS

Présentation de l'article:Comment utiliser PHP et REDIS pour optimiser les robots d'exploration Web et la capture de données Introduction : À l'ère du Big Data, la valeur des données est devenue de plus en plus importante. Par conséquent, les robots d’exploration Web et le grattage de données sont devenus des points chauds de la recherche et du développement. Cependant, une grande quantité d'analyse de données consomme d'énormes ressources de serveur, et les problèmes de délai d'attente et de duplication pendant le processus d'analyse doivent également être résolus. Dans cet article, nous présenterons brièvement comment utiliser la technologie PHP et REDIS pour optimiser le processus d'exploration du Web et de récupération de données, améliorant ainsi l'efficacité et les performances. 1. Qu'est-ce que REDISREDIS

2023-07-22

commentaire 0

1361

Apprenez l'exploration du Web et le grattage de données avec le langage Go

Présentation de l'article:Apprenez le robot d'exploration Web en langage Go et la capture de données. Un robot d'exploration Web est un programme automatisé qui peut parcourir des pages Web et capturer des données selon certaines règles sur Internet. Avec le développement rapide d’Internet et l’avènement de l’ère du big data, la capture de données est devenue un travail indispensable pour de nombreuses entreprises et particuliers. En tant que langage de programmation rapide et efficace, le langage Go a le potentiel d'être largement utilisé dans le domaine des robots d'exploration Web et de la capture de données. La nature simultanée du langage Go en fait un langage très approprié pour la mise en œuvre de robots d'exploration Web. En langage Go, vous pouvez utiliser

2023-11-30

commentaire 0

525

python抓取安居客小区数据的程序代码

Présentation de l'article:抓取数据不管用什么编程语言几乎都是可以实现了,今天我们需要采集安居客的小区数据,下面我们来看一个python抓取安居客小区数据的程序代码了,希望下文能够对大家有帮助。

2016-06-08

commentaire 0

1993

php使用curl和正则表达式抓取网页数据示例_PHP

Présentation de l'article:这篇文章主要介绍了php使用curl和正则表达式抓取网页数据示例,这里是抓取某网站的小说,需要的朋友可以修改一下抓取其它数据

2016-06-01

commentaire 0

964

Pratique du cadre Scrapy : exploration des données du site Web de Jianshu

Présentation de l'article:Pratique du framework Scrapy : exploration des données du site Web de Jianshu Scrapy est un framework d'exploration Python open source qui peut être utilisé pour extraire des données du World Wide Web. Dans cet article, nous présenterons le framework Scrapy et l'utiliserons pour explorer les données des sites Web de Jianshu. Installer ScrapyScrapy peut être installé à l'aide de gestionnaires de packages tels que pip ou conda. Ici, nous utilisons pip pour installer Scrapy. Entrez la commande suivante dans la ligne de commande : pipinstallscrapy Une fois l'installation terminée

2023-06-22

commentaire 0

1311

Techniques de scraping Web et d'extraction de données en Python

Présentation de l'article:Python est devenu le langage de programmation de choix pour une variété d'applications, et sa polyvalence s'étend au monde du web scraping. Avec son riche écosystème de bibliothèques et de frameworks, Python fournit une boîte à outils puissante pour extraire des données de sites Web et débloquer des informations précieuses. Que vous soyez un passionné de données, un chercheur ou un professionnel de l'industrie, le web scraping en Python peut être une compétence précieuse pour exploiter les grandes quantités d'informations disponibles en ligne. Dans ce didacticiel, nous plongerons dans le monde du web scraping et explorerons les différentes techniques et outils en Python qui peuvent être utilisés pour extraire des données de sites Web. Nous découvrirons les bases du web scraping, comprendrons les considérations juridiques et éthiques entourant cette pratique et approfondirons les aspects pratiques de l'extraction de données. Dans la prochaine partie de cet article

2023-09-16

commentaire 0

1271

Compétences en robot d'exploration Java : gérer l'exploration de données à partir de différentes pages Web

Présentation de l'article:Améliorer les compétences des robots d'exploration : la façon dont les robots d'exploration Java gèrent l'exploration des données à partir de différentes pages Web nécessite des exemples de code spécifiques. Résumé : Avec le développement rapide d'Internet et l'avènement de l'ère du Big Data, l'exploration des données est devenue de plus en plus importante. En tant que langage de programmation puissant, la technologie des robots d'exploration de Java a également attiré beaucoup d'attention. Cet article présentera les techniques du robot d'exploration Java pour gérer différentes analyses de données de pages Web et fournira des exemples de code spécifiques pour aider les lecteurs à améliorer leurs compétences en matière de robot d'exploration. Introduction Avec la popularité d'Internet, nous pouvons facilement obtenir d'énormes quantités de données. Cependant, ces chiffres

2024-01-09

commentaire 0

902