10000 contenu connexe trouvé

Entraîner des modèles de machine learning en C++ : du prétraitement des données à la validation du modèle

Présentation de l'article:La formation d'un modèle ML en C++ implique les étapes suivantes : Prétraitement des données : charger, transformer et concevoir les données. Formation de modèle : choisissez un algorithme et entraînez le modèle. Validation du modèle : partitionnez l'ensemble de données, évaluez les performances et ajustez le modèle. En suivant ces étapes, vous pouvez réussir à créer, entraîner et valider des modèles d’apprentissage automatique en C++.

2024-06-01

commentaire 0

656

Former le modèle YOLOv7 et développer la détection d'incendie par IA

Présentation de l'article:1. Préparez l'ensemble de données. L'ensemble de données utilise des images open source, avec un total de 6 000 images d'incendie, marquées par deux catégories : fumée épaisse et incendie. Le projet Fire and Smoke utilise YOLO pour la formation. J'ai converti les données au format YOLO et les ai divisées en un ensemble de formation et un ensemble de vérification. Voir le répertoire de l'ensemble de données. 2. Pour la formation, veuillez vous référer à la documentation du site officiel de YOLOv7 pour le processus de formation. Modifiez le fichier data/coco.yaml et configurez le chemin et la catégorie des données d'entraînement. Téléchargez le modèle pré-entraîné yolov7.pt, puis vous pourrez commencer la formation. 3. Une fois la formation sur la surveillance des incendies terminée, recherchez le fichier modèle généré-best.pt dans le répertoire d'exécution sous le répertoire yolov7. je m'entraîne

2023-05-11

commentaire 0

994

Explication détaillée du modèle de pré-formation d'apprentissage profond en Python

Présentation de l'article:Avec le développement de l'intelligence artificielle et de l'apprentissage profond, les modèles de pré-formation sont devenus une technologie populaire dans le traitement du langage naturel (NLP), la vision par ordinateur (CV), la reconnaissance vocale et d'autres domaines. En tant que l'un des langages de programmation les plus populaires à l'heure actuelle, Python joue naturellement un rôle important dans l'application de modèles pré-entraînés. Cet article se concentrera sur le modèle de pré-formation d'apprentissage profond en Python, y compris sa définition, ses types, ses applications et comment utiliser le modèle de pré-formation. Qu'est-ce qu'un modèle pré-entraîné ? La principale difficulté des modèles d’apprentissage profond est d’analyser un grand nombre de données de haute qualité.

2023-06-11

commentaire 0

2010

CMU s'associe à Adobe : le modèle GAN a inauguré l'ère de la pré-formation, ne nécessitant que 1 % des échantillons de formation

Présentation de l'article:Après être entrés dans l’ère de la pré-formation, les performances des modèles de reconnaissance visuelle se sont développées rapidement, mais les modèles de génération d’images, tels que les réseaux contradictoires génératifs (GAN), semblent avoir pris du retard. Habituellement, la formation GAN est effectuée à partir de zéro, de manière non supervisée, ce qui prend du temps et demande beaucoup de travail. Les « connaissances » acquises grâce au Big Data lors d'une pré-formation à grande échelle ne sont pas utilisées. De plus, la génération d'images elle-même doit être capable de capturer et de simuler des données statistiques complexes dans des phénomènes visuels du monde réel, sinon les images générées ne seront pas conformes aux lois du monde physique et seront directement identifiées comme « fausses » d'un seul coup d'œil. . Le modèle pré-entraîné fournit des connaissances et le modèle GAN fournit des capacités de génération. La combinaison des deux peut être une belle chose ! La question est de savoir quels modèles pré-entraînés et comment les combiner peuvent améliorer la capacité de génération du modèle GAN.

2023-05-11

commentaire 0

1466

Comment le framework Java accélère-t-il la formation des modèles d'intelligence artificielle ?

Présentation de l'article:Le framework Java peut accélérer la formation des modèles d'intelligence artificielle en : utilisant TensorFlowServing pour déployer des modèles pré-entraînés pour une inférence rapide ; en utilisant H2OAIDriverlessAI pour automatiser le processus de formation et en utilisant l'informatique distribuée pour réduire le temps de formation en utilisant SparkMLlib pour mettre en œuvre une formation distribuée et des données à grande échelle ; sur le traitement des ensembles d'architecture Apache Spark.

2024-06-04

commentaire 0

904

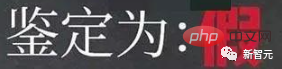

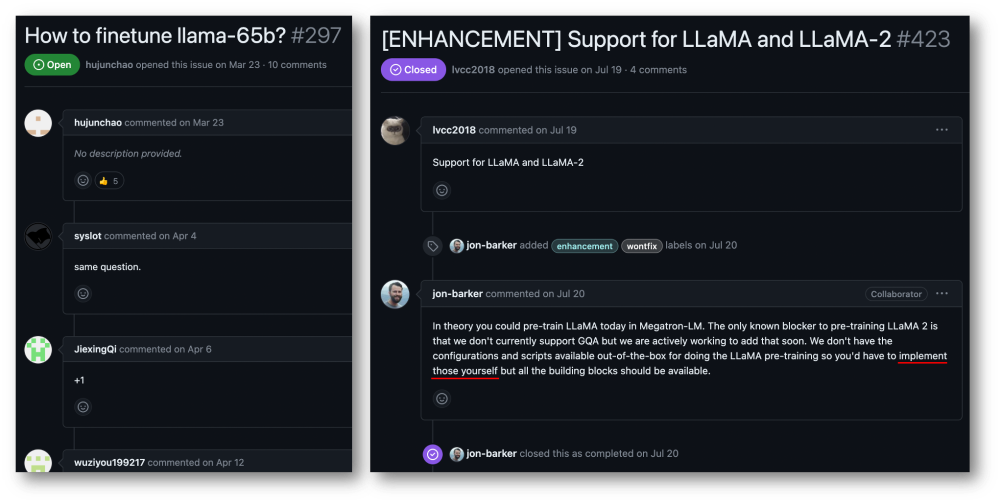

Accélération de formation de 32 cartes à 176 %, cadre de formation open source pour grands modèles Megatron-LLaMA est là

Présentation de l'article:Taotian Group et Aicheng Technology ont officiellement publié le cadre de formation open source pour grands modèles - Megatron-LLaMA le 12 septembre. L'objectif de ce cadre est de permettre aux développeurs de technologies d'améliorer plus facilement les performances de formation des grands modèles de langage, de réduire les coûts de formation et de maintenir la compatibilité avec la communauté LLaMA. Les résultats des tests montrent que sur une formation à 32 cartes, Megatron-LLaMA peut atteindre une accélération de 176 % par rapport à la version de code obtenue directement sur HuggingFace ; sur une formation à grande échelle, Megatron-LLaMA s'étend presque linéairement et est instable au réseau. niveau de tolérance. Actuellement, Megatron-LLaMA a été lancé dans la communauté open source à l'adresse open source : https :

2023-09-14

commentaire 0

633

L'impact de la rareté des données sur la formation des modèles

Présentation de l'article:L'impact de la rareté des données sur la formation des modèles nécessite des exemples de code spécifiques. Dans les domaines de l'apprentissage automatique et de l'intelligence artificielle, les données sont l'un des éléments essentiels de la formation des modèles. Cependant, un problème auquel nous sommes souvent confrontés dans la réalité est la rareté des données. La rareté des données fait référence à la quantité insuffisante de données d'entraînement ou au manque de données annotées. Dans ce cas, cela aura un certain impact sur l'entraînement du modèle. Le problème de la rareté des données se reflète principalement dans les aspects suivants : Surajustement : lorsque la quantité de données d'entraînement est insuffisante, le modèle est sujet au surajustement. Le surajustement fait référence au modèle qui s'adapte de manière excessive aux données d'entraînement.

2023-10-08

commentaire 0

1407

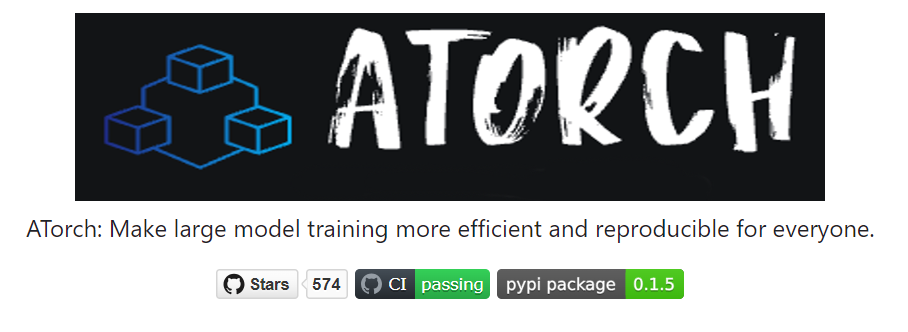

La bibliothèque d'extension de formation distribuée open source d'Ant, AToch, atteint un taux d'utilisation effectif de 60 % de la puissance de calcul de formation sur grands modèles.

Présentation de l'article:Ant Group a récemment annoncé le lancement d'une bibliothèque d'extension d'accélération de formation distribuée à grande échelle appelée ATorch, un outil open source. L'objectif d'ATorch est d'aider à améliorer l'intelligence de l'apprentissage profond grâce à l'optimisation dynamique automatique des ressources et à l'amélioration de la stabilité de la formation distribuée. Il est entendu que dans l'entraînement sur grand modèle, AToch peut augmenter le taux d'utilisation de la puissance de calcul d'un modèle d'entraînement de 100 milliards de kilocalories à 60 %, ce qui équivaut à l'ajout d'un moteur puissant à une voiture de sport. Il s’agira d’un outil important pour les chercheurs et les développeurs en apprentissage profond afin de les aider à former et à optimiser plus efficacement les grands modèles. Figure : ATorch s'engage à rendre la formation de grands modèles plus efficace et reproductible. Avec l'explosion des grands modèles génératifs, l'échelle des ensembles de données et des paramètres pour la formation de modèles est exponentielle.

2024-01-14

commentaire 0

1426

Comment implémenter des algorithmes distribués et une formation de modèles dans les microservices PHP

Présentation de l'article:Comment implémenter des algorithmes distribués et la formation de modèles dans les microservices PHP Introduction : Avec le développement rapide de la technologie du cloud computing et du Big Data, la demande de traitement de données et de formation de modèles augmente. Les algorithmes distribués et la formation de modèles sont essentiels pour atteindre l'efficacité, la rapidité et l'évolutivité. Cet article présentera comment implémenter des algorithmes distribués et la formation de modèles dans les microservices PHP, et fournira quelques exemples de code spécifiques. 1. Qu'est-ce que la formation d'algorithmes et de modèles distribués ? La formation d'algorithmes et de modèles distribués est des technologies qui utilisent plusieurs machines ou ressources de serveur pour effectuer simultanément le traitement des données et la formation de modèles.

2023-09-25

commentaire 0

1454

Utiliser des fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique

Présentation de l'article:Utilisation des fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique Avec le développement rapide de l'apprentissage automatique, de nombreux développeurs ont commencé à s'intéresser à la manière d'utiliser JavaScript pour implémenter la formation de modèles d'apprentissage automatique sur le front-end. Cet article explique comment utiliser les fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique et fournit des exemples de code spécifiques. Avant de commencer, nous devons comprendre quelques concepts importants. Ensemble de données : la formation du modèle d'apprentissage automatique nécessite un ensemble d'ensembles de données étiquetés en entrée. L'ensemble de données se compose de

2023-11-03

commentaire 0

1190

Transférer des applications d'apprentissage et des technologies communes dans la formation de grands modèles de langage

Présentation de l'article:Les grands modèles de langage font référence à des modèles de traitement du langage naturel comportant plus de 100 millions de paramètres. En raison de leur taille et de leur complexité, la formation d’un tel modèle nécessite des ressources informatiques et des données importantes. Par conséquent, l’apprentissage par transfert est devenu une méthode importante pour former de grands modèles de langage. En utilisant les modèles et les données existants, le processus de formation peut être accéléré et les performances améliorées. L'apprentissage par transfert peut transférer les paramètres et les connaissances des modèles formés sur d'autres tâches vers la tâche cible, réduisant ainsi les besoins en données et le temps de formation. Cette approche est largement utilisée dans la recherche et dans l’industrie, jetant les bases de la création de modèles de langage plus puissants. L'apprentissage par transfert est une méthode qui utilise un modèle déjà formé pour ajuster ses paramètres ou certains composants lors de la résolution d'autres tâches. Dans le domaine du traitement du langage naturel, l'apprentissage par transfert peut

2024-01-22

commentaire 0

934

La signification de Batch Size et son impact sur la formation (lié aux modèles d'apprentissage automatique)

Présentation de l'article:BatchSize fait référence à la quantité de données utilisée par le modèle d'apprentissage automatique à chaque fois pendant le processus de formation. Il divise de grandes quantités de données en petits lots de données pour la formation du modèle et la mise à jour des paramètres. Cette méthode de traitement par lots permet d'améliorer l'efficacité de la formation et l'utilisation de la mémoire. Les données de formation sont généralement divisées en lots pour la formation, et chaque lot contient plusieurs échantillons. La taille du lot (batchsize) fait référence au nombre d'échantillons contenus dans chaque lot. Lors de la formation d'un modèle, la taille du lot a un impact important sur le processus de formation. 1. Vitesse d'entraînement La taille du lot (batchsize) a un impact sur la vitesse d'entraînement du modèle. Une taille de lot plus grande peut traiter les données d'entraînement plus rapidement, car à chaque époque, une taille de lot plus grande peut traiter plus de données simultanément.

2024-01-23

commentaire 0

2241

Comment utiliser Python pour entraîner des modèles sur des images

Présentation de l'article:Présentation de l'utilisation de Python pour entraîner des modèles sur des images : dans le domaine de la vision par ordinateur, l'utilisation de modèles d'apprentissage profond pour classer les images, la détection de cibles et d'autres tâches est devenue une méthode courante. En tant que langage de programmation largement utilisé, Python fournit une multitude de bibliothèques et d'outils, ce qui rend relativement facile l'entraînement de modèles sur des images. Cet article expliquera comment utiliser Python et ses bibliothèques associées pour entraîner des modèles sur des images et fournira des exemples de code correspondants. Préparation de l'environnement : Avant de commencer, vous devez vous assurer que vous avez installé

2023-08-26

commentaire 0

1663

Guide de formation du modèle ChatGPT Python : étapes pour personnaliser un chatbot

Présentation de l'article:Guide de formation du modèle ChatGPTPython : Aperçu des étapes de personnalisation des robots de chat : Ces dernières années, avec le développement croissant de la technologie NLP (traitement du langage naturel), les robots de chat ont attiré de plus en plus d'attention. ChatGPT d'OpenAI est un puissant modèle de langage pré-entraîné qui peut être utilisé pour créer des chatbots multi-domaines. Cet article présentera les étapes d'utilisation de Python pour entraîner le modèle ChatGPT, y compris la préparation des données, la formation du modèle et la génération d'échantillons de dialogue. Étape 1 : Préparation, collecte et nettoyage des données

2023-10-24

commentaire 0

1329

L'entraînement d'un grand modèle est-il plus difficile que d'atteindre le ciel ? La bibliothèque de modèles « Li Bai » pré-entraînée, facile à utiliser et très efficace est là !

Présentation de l'article:La bibliothèque de modèles LiBai couvre les avantages de toutes les bibliothèques Transformer traditionnelles telles que Hugging Face, Megatron-LM, DeepSpeed et FairSeq, rendant la formation de grands modèles accessible aux gens ordinaires. Il y a tellement de grands modèles, dites-moi comment les accélérer ? Depuis la naissance du BERT en 2018, des modèles comportant des centaines de millions de paramètres tels que GPT-3 et ViT ont continué à émerger. Il n’est pas surprenant que le nombre de paramètres dans les modèles d’IA ait explosé, ne laissant pas le temps aux alchimistes de s’en soucier. même en me sentant engourdi. Dans le même temps, les grands modèles posent d’énormes défis en termes de ressources informatiques et de mémoire. Les coûts de formation augmentent fortement, comme l'utilisation d'un NVIDIA A très avancé

2023-04-09

commentaire 0

1378

Le principe et l'application de l'échantillonnage par rejet dans la formation de grands modèles

Présentation de l'article:L'échantillonnage par rejet est une technique courante dans la formation de grands modèles de langage. Il échantillonne en fonction de la fonction de densité de probabilité de la distribution cible pour générer des échantillons qui correspondent à la distribution cible. Le but de l'échantillonnage par rejet est d'augmenter la diversité des données d'entraînement, améliorant ainsi la capacité de généralisation du modèle. Cette méthode est particulièrement importante dans la formation de modèles linguistiques car elle peut aider le modèle à apprendre des expressions linguistiques plus riches et plus précises. En rejetant l'échantillonnage, le modèle peut générer du texte sous différentes perspectives et styles, le rendant plus adaptable et créatif. De cette manière, le modèle peut prédire avec plus de précision le mot ou la phrase suivante lors du traitement de différents types de texte, améliorant ainsi la qualité globale de la génération. L'application de l'échantillonnage par rejet peut également alléger la formation. L'échantillonnage par rejet est une base.

2024-01-22

commentaire 0

1287