10000 contenu connexe trouvé

Comment utiliser Python pour entraîner des modèles sur des images

Présentation de l'article:Présentation de l'utilisation de Python pour entraîner des modèles sur des images : dans le domaine de la vision par ordinateur, l'utilisation de modèles d'apprentissage profond pour classer les images, la détection de cibles et d'autres tâches est devenue une méthode courante. En tant que langage de programmation largement utilisé, Python fournit une multitude de bibliothèques et d'outils, ce qui rend relativement facile l'entraînement de modèles sur des images. Cet article expliquera comment utiliser Python et ses bibliothèques associées pour entraîner des modèles sur des images et fournira des exemples de code correspondants. Préparation de l'environnement : Avant de commencer, vous devez vous assurer que vous avez installé

2023-08-26

commentaire 0

1663

Problème de temps de formation du modèle d'apprentissage en profondeur

Présentation de l'article:Introduction à la question du temps de formation des modèles d'apprentissage profond : Avec le développement du deep learning, les modèles d'apprentissage profond ont obtenu des résultats remarquables dans divers domaines. Cependant, le temps de formation des modèles d’apprentissage profond est un problème courant. Dans le cas d’ensembles de données à grande échelle et de structures de réseau complexes, le temps de formation des modèles d’apprentissage profond augmente considérablement. Cet article abordera le problème du temps de formation des modèles d'apprentissage profond et donnera des exemples de code spécifiques. L'informatique parallèle accélère le temps de formation Le processus de formation des modèles d'apprentissage profond nécessite généralement une grande quantité de ressources informatiques et de temps. Afin d'accélérer la formation

2023-10-09

commentaire 0

1740

Guide de formation du modèle ChatGPT Python : étapes pour personnaliser un chatbot

Présentation de l'article:Guide de formation du modèle ChatGPTPython : Aperçu des étapes de personnalisation des robots de chat : Ces dernières années, avec le développement croissant de la technologie NLP (traitement du langage naturel), les robots de chat ont attiré de plus en plus d'attention. ChatGPT d'OpenAI est un puissant modèle de langage pré-entraîné qui peut être utilisé pour créer des chatbots multi-domaines. Cet article présentera les étapes d'utilisation de Python pour entraîner le modèle ChatGPT, y compris la préparation des données, la formation du modèle et la génération d'échantillons de dialogue. Étape 1 : Préparation, collecte et nettoyage des données

2023-10-24

commentaire 0

1329

Entraîner des modèles de machine learning en C++ : du prétraitement des données à la validation du modèle

Présentation de l'article:La formation d'un modèle ML en C++ implique les étapes suivantes : Prétraitement des données : charger, transformer et concevoir les données. Formation de modèle : choisissez un algorithme et entraînez le modèle. Validation du modèle : partitionnez l'ensemble de données, évaluez les performances et ajustez le modèle. En suivant ces étapes, vous pouvez réussir à créer, entraîner et valider des modèles d’apprentissage automatique en C++.

2024-06-01

commentaire 0

656

Comment le framework Java accélère-t-il la formation des modèles d'intelligence artificielle ?

Présentation de l'article:Le framework Java peut accélérer la formation des modèles d'intelligence artificielle en : utilisant TensorFlowServing pour déployer des modèles pré-entraînés pour une inférence rapide ; en utilisant H2OAIDriverlessAI pour automatiser le processus de formation et en utilisant l'informatique distribuée pour réduire le temps de formation en utilisant SparkMLlib pour mettre en œuvre une formation distribuée et des données à grande échelle ; sur le traitement des ensembles d'architecture Apache Spark.

2024-06-04

commentaire 0

904

L'impact de la rareté des données sur la formation des modèles

Présentation de l'article:L'impact de la rareté des données sur la formation des modèles nécessite des exemples de code spécifiques. Dans les domaines de l'apprentissage automatique et de l'intelligence artificielle, les données sont l'un des éléments essentiels de la formation des modèles. Cependant, un problème auquel nous sommes souvent confrontés dans la réalité est la rareté des données. La rareté des données fait référence à la quantité insuffisante de données d'entraînement ou au manque de données annotées. Dans ce cas, cela aura un certain impact sur l'entraînement du modèle. Le problème de la rareté des données se reflète principalement dans les aspects suivants : Surajustement : lorsque la quantité de données d'entraînement est insuffisante, le modèle est sujet au surajustement. Le surajustement fait référence au modèle qui s'adapte de manière excessive aux données d'entraînement.

2023-10-08

commentaire 0

1407

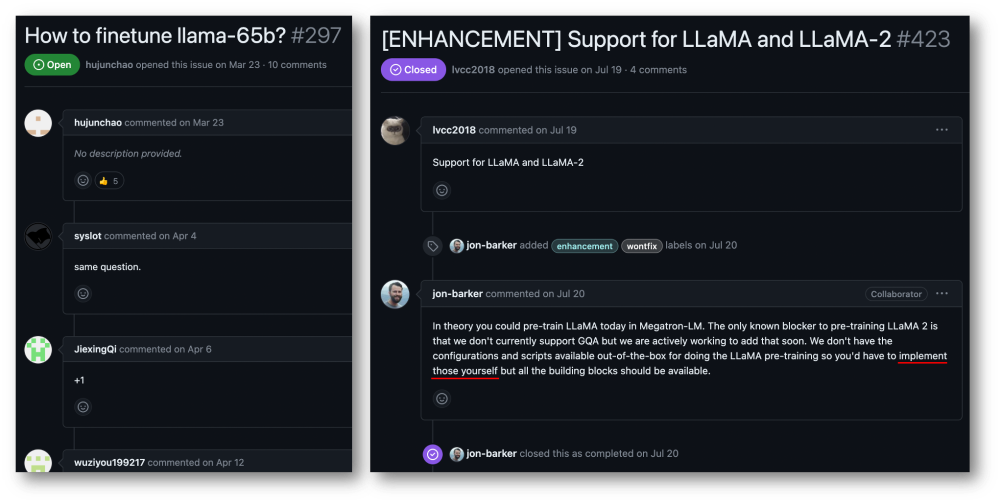

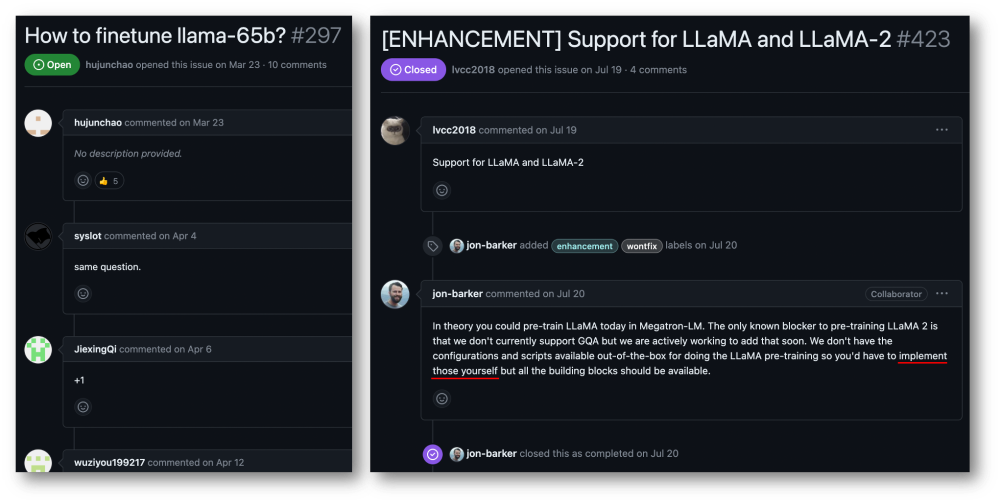

Accélération de formation de 32 cartes à 176 %, cadre de formation open source pour grands modèles Megatron-LLaMA est là

Présentation de l'article:Taotian Group et Aicheng Technology ont officiellement publié le cadre de formation open source pour grands modèles - Megatron-LLaMA le 12 septembre. L'objectif de ce cadre est de permettre aux développeurs de technologies d'améliorer plus facilement les performances de formation des grands modèles de langage, de réduire les coûts de formation et de maintenir la compatibilité avec la communauté LLaMA. Les résultats des tests montrent que sur une formation à 32 cartes, Megatron-LLaMA peut atteindre une accélération de 176 % par rapport à la version de code obtenue directement sur HuggingFace ; sur une formation à grande échelle, Megatron-LLaMA s'étend presque linéairement et est instable au réseau. niveau de tolérance. Actuellement, Megatron-LLaMA a été lancé dans la communauté open source à l'adresse open source : https :

2023-09-14

commentaire 0

633

L'entraînement Llama3 plante toutes les 3 heures ? Le modèle Big Bean Bag et l'équipe HKU améliorent l'entraînement croustillant de Wanka

Présentation de l'article:À mesure que la vitesse d'itération des grands modèles devient de plus en plus rapide, l'échelle des clusters de formation devient de plus en plus grande, et les pannes logicielles et matérielles à haute fréquence sont devenues un problème qui entrave l'amélioration continue de l'efficacité de la formation. le stockage et la récupération de l'état pendant le processus de formation sont devenus la clé pour surmonter les échecs de la formation, garantir la progression de la formation et améliorer l'efficacité de la formation. Récemment, l'équipe modèle ByteDance Beanbao et l'Université de Hong Kong ont proposé conjointement ByteCheckpoint. Il s'agit d'un grand modèle de système de point de contrôle natif de PyTorch, compatible avec plusieurs cadres de formation, et prend en charge une lecture et une écriture efficaces de Checkpoint et une re-segmentation automatique. Par rapport aux méthodes existantes, il présente des améliorations significatives en termes de performances et de facilité d'utilisation. Cet article présente la formation sur les grands modèles

2024-08-08

commentaire 0

617

Comment implémenter des algorithmes distribués et une formation de modèles dans les microservices PHP

Présentation de l'article:Comment implémenter des algorithmes distribués et la formation de modèles dans les microservices PHP Introduction : Avec le développement rapide de la technologie du cloud computing et du Big Data, la demande de traitement de données et de formation de modèles augmente. Les algorithmes distribués et la formation de modèles sont essentiels pour atteindre l'efficacité, la rapidité et l'évolutivité. Cet article présentera comment implémenter des algorithmes distribués et la formation de modèles dans les microservices PHP, et fournira quelques exemples de code spécifiques. 1. Qu'est-ce que la formation d'algorithmes et de modèles distribués ? La formation d'algorithmes et de modèles distribués est des technologies qui utilisent plusieurs machines ou ressources de serveur pour effectuer simultanément le traitement des données et la formation de modèles.

2023-09-25

commentaire 0

1454

La bibliothèque d'extension de formation distribuée open source d'Ant, AToch, atteint un taux d'utilisation effectif de 60 % de la puissance de calcul de formation sur grands modèles.

Présentation de l'article:Ant Group a récemment annoncé le lancement d'une bibliothèque d'extension d'accélération de formation distribuée à grande échelle appelée ATorch, un outil open source. L'objectif d'ATorch est d'aider à améliorer l'intelligence de l'apprentissage profond grâce à l'optimisation dynamique automatique des ressources et à l'amélioration de la stabilité de la formation distribuée. Il est entendu que dans l'entraînement sur grand modèle, AToch peut augmenter le taux d'utilisation de la puissance de calcul d'un modèle d'entraînement de 100 milliards de kilocalories à 60 %, ce qui équivaut à l'ajout d'un moteur puissant à une voiture de sport. Il s’agira d’un outil important pour les chercheurs et les développeurs en apprentissage profond afin de les aider à former et à optimiser plus efficacement les grands modèles. Figure : ATorch s'engage à rendre la formation de grands modèles plus efficace et reproductible. Avec l'explosion des grands modèles génératifs, l'échelle des ensembles de données et des paramètres pour la formation de modèles est exponentielle.

2024-01-14

commentaire 0

1426

Utiliser des fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique

Présentation de l'article:Utilisation des fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique Avec le développement rapide de l'apprentissage automatique, de nombreux développeurs ont commencé à s'intéresser à la manière d'utiliser JavaScript pour implémenter la formation de modèles d'apprentissage automatique sur le front-end. Cet article explique comment utiliser les fonctions JavaScript pour implémenter la formation de modèles d'apprentissage automatique et fournit des exemples de code spécifiques. Avant de commencer, nous devons comprendre quelques concepts importants. Ensemble de données : la formation du modèle d'apprentissage automatique nécessite un ensemble d'ensembles de données étiquetés en entrée. L'ensemble de données se compose de

2023-11-03

commentaire 0

1192

Transférer des applications d'apprentissage et des technologies communes dans la formation de grands modèles de langage

Présentation de l'article:Les grands modèles de langage font référence à des modèles de traitement du langage naturel comportant plus de 100 millions de paramètres. En raison de leur taille et de leur complexité, la formation d’un tel modèle nécessite des ressources informatiques et des données importantes. Par conséquent, l’apprentissage par transfert est devenu une méthode importante pour former de grands modèles de langage. En utilisant les modèles et les données existants, le processus de formation peut être accéléré et les performances améliorées. L'apprentissage par transfert peut transférer les paramètres et les connaissances des modèles formés sur d'autres tâches vers la tâche cible, réduisant ainsi les besoins en données et le temps de formation. Cette approche est largement utilisée dans la recherche et dans l’industrie, jetant les bases de la création de modèles de langage plus puissants. L'apprentissage par transfert est une méthode qui utilise un modèle déjà formé pour ajuster ses paramètres ou certains composants lors de la résolution d'autres tâches. Dans le domaine du traitement du langage naturel, l'apprentissage par transfert peut

2024-01-22

commentaire 0

934

La signification de Batch Size et son impact sur la formation (lié aux modèles d'apprentissage automatique)

Présentation de l'article:BatchSize fait référence à la quantité de données utilisée par le modèle d'apprentissage automatique à chaque fois pendant le processus de formation. Il divise de grandes quantités de données en petits lots de données pour la formation du modèle et la mise à jour des paramètres. Cette méthode de traitement par lots permet d'améliorer l'efficacité de la formation et l'utilisation de la mémoire. Les données de formation sont généralement divisées en lots pour la formation, et chaque lot contient plusieurs échantillons. La taille du lot (batchsize) fait référence au nombre d'échantillons contenus dans chaque lot. Lors de la formation d'un modèle, la taille du lot a un impact important sur le processus de formation. 1. Vitesse d'entraînement La taille du lot (batchsize) a un impact sur la vitesse d'entraînement du modèle. Une taille de lot plus grande peut traiter les données d'entraînement plus rapidement, car à chaque époque, une taille de lot plus grande peut traiter plus de données simultanément.

2024-01-23

commentaire 0

2241

L'importance du prétraitement des données dans la formation des modèles

Présentation de l'article:L'importance du prétraitement des données dans la formation des modèles et exemples de code spécifiques Introduction : Dans le processus de formation des modèles d'apprentissage automatique et d'apprentissage profond, le prétraitement des données est un lien très important et essentiel. Le but du prétraitement des données est de transformer les données brutes en une forme adaptée à la formation du modèle grâce à une série d'étapes de traitement visant à améliorer les performances et la précision du modèle. Cet article vise à discuter de l'importance du prétraitement des données dans la formation de modèles et à donner quelques exemples de code de prétraitement des données couramment utilisés. 1. L'importance du prétraitement des données Nettoyage des données Le nettoyage des données est la

2023-10-08

commentaire 0

1286

Pour 1 890 $, vous pouvez former un modèle de diffusion de paramètres décent de 1,2 milliard à partir de zéro.

Présentation de l'article:Avec seulement 1 890 $ et 37 millions d’images, vous pouvez former un modèle de diffusion décent. Actuellement, les modèles génératifs de vision sont efficaces pour créer un contenu visuel réaliste, mais le coût et les efforts nécessaires à la formation de ces modèles à partir de zéro restent élevés. Par exemple, StableDiffusion2.1 a nécessité 200 000 heures A100GPU. Même si les chercheurs utilisent la méthode la plus avancée, il faut quand même plus d’un mois pour s’entraîner sur un GPU 8×H100. De plus, la formation de grands modèles pose également des défis pour les ensembles de données. Ces données sont essentiellement exprimées en centaines de millions, ce qui pose également des défis pour la formation des modèles. Les coûts de formation élevés et les exigences en matière d'ensembles de données créent des obstacles insurmontables au développement de modèles de diffusion à grande échelle. Maintenant, de SonyAI et plus encore

2024-07-29

commentaire 0

537

Apple utilise des modèles de langage autorégressifs pour pré-entraîner les modèles d'image

Présentation de l'article:1. Contexte Après l'émergence de grands modèles tels que GPT, la méthode de modélisation autorégressive Transformer + du modèle de langage, qui est la tâche de pré-entraînement consistant à prédire le prochain jeton, a remporté un grand succès. Alors, cette méthode de modélisation autorégressive peut-elle obtenir de meilleurs résultats dans les modèles visuels ? L'article présenté aujourd'hui est un article récemment publié par Apple sur la formation d'un modèle visuel basé sur la pré-formation Transformer + autorégressive. Laissez-moi vous présenter ce travail. Titre de l'article : ScalablePre-trainingofLargeAutoregressiveImageModels Adresse de téléchargement : https://ar

2024-01-29

commentaire 0

1019