手动安装cloudera cdh4.2 hadoop + hbase + hive(一)

安装版本 hadoop-2.0.0-cdh4.2.0hbase-0.94.2-cdh4.2.0hive-0.10.0-cdh4.2.0jdk1.6.0_38 安装前说明 安装目录为/opt 检查hosts文件 关闭防火墙 设置时钟同步 使用说明 安装hadoop、hbase、hive成功之后启动方式为: 启动dfs和mapreduce desktop1上执行start-

安装版本

<code>hadoop-2.0.0-cdh4.2.0 hbase-0.94.2-cdh4.2.0 hive-0.10.0-cdh4.2.0 jdk1.6.0_38 </code>

安装前说明

- 安装目录为/opt

- 检查hosts文件

- 关闭防火墙

- 设置时钟同步

使用说明

安装hadoop、hbase、hive成功之后启动方式为:

- 启动dfs和mapreduce desktop1上执行start-dfs.sh和start-yarn.sh

- 启动hbase desktop3上执行start-hbase.xml

- 启动hive desktop1上执行hive

规划

<code> 192.168.0.1 NameNode、Hive、ResourceManager

192.168.0.2 SSNameNode

192.168.0.3 DataNode、HBase、NodeManager

192.168.0.4 DataNode、HBase、NodeManager

192.168.0.6 DataNode、HBase、NodeManager

192.168.0.7 DataNode、HBase、NodeManager

192.168.0.8 DataNode、HBase、NodeManager

</code>部署过程

系统和网络配置

-

修改每台机器的名称

[root@desktop1 ~]# cat /etc/sysconfig/network NETWORKING=yes HOSTNAME=desktop1

ログイン後にコピー -

在各个节点上修改/etc/hosts增加以下内容:

[root@desktop1 ~]# cat /etc/hosts 127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 192.168.0.1 desktop1 192.168.0.2 desktop2 192.168.0.3 desktop3 192.168.0.4 desktop4 192.168.0.6 desktop6 192.168.0.7 desktop7 192.168.0.8 desktop8

ログイン後にコピー -

配置ssh无密码登陆 以下是设置desktop1上可以无密码登陆到其他机器上。

[root@desktop1 ~]# ssh-keygen

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop2

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop3

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop4

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop6

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop7

[root@desktop1 ~]# ssh-copy-id -i .ssh/id_rsa.pub desktop8

- 每台机器上关闭防火墙:

<code> [root@desktop1 ~]# service iptables stop </code>

安装Hadoop

配置Hadoop

将jdk1.6.0_38.zip上传到/opt,并解压缩。 将hadoop-2.0.0-cdh4.2.0.zip上传到/opt,并解压缩。

在NameNode上配置以下文件:

<code>core-site.xml fs.defaultFS指定NameNode文件系统,开启回收站功能。

hdfs-site.xml

dfs.namenode.name.dir指定NameNode存储meta和editlog的目录,

dfs.datanode.data.dir指定DataNode存储blocks的目录,

dfs.namenode.secondary.http-address指定Secondary NameNode地址。

开启WebHDFS。

slaves 添加DataNode节点主机

</code>- core-site.xml 该文件指定fs.defaultFS连接desktop1,即NameNode节点。

<code>[root@desktop1 hadoop]# pwd

/opt/hadoop-2.0.0-cdh4.2.0/etc/hadoop

[root@desktop1 hadoop]# cat core-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!--fs.default.name for MRV1 ,fs.defaultFS for MRV2(yarn) -->

<property>

<name>fs.defaultFS</name>

<!--这个地方的值要和hdfs-site.xml文件中的dfs.federation.nameservices一致-->

<value>hdfs://desktop1</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

<property>

<name>fs.trash.checkpoint.interval</name>

<value>10080</value>

</property>

</configuration>

</code>- hdfs-site.xml 该文件主要设置数据副本保存份数,以及namenode、datanode数据保存路径以及http-address。

<code>[root@desktop1 hadoop]# cat hdfs-site.xml

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/data/hadoop-${user.name}</value>

</property>

<property>

<name>dfs.namenode.http-address</name>

<value>desktop1:50070</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>desktop2:50090</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

</configuration>

</code>- masters 设置namenode和secondary namenode节点。

<code>[root@desktop1 hadoop]# cat masters desktop1 desktop2 </code>

- slaves 设置哪些机器上安装datanode节点。

<code>[root@desktop1 hadoop]# cat slaves desktop3 desktop4 desktop6 desktop7 desktop8 </code>

配置MapReduce

- mapred-site.xml 配置使用yarn计算框架,以及jobhistory的地址。

<code>[root@desktop1 hadoop]# cat mapred-site.xml <?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapreduce.jobhistory.address</name> <value>desktop1:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>desktop1:19888</value> </property> </configuration> </code>

- yarn-site.xml 主要配置resourcemanager地址以及

yarn.application.classpath(这个路径很重要,要不然集成hive时候会提示找不到class)

<code>[root@desktop1 hadoop]# cat yarn-site.xml

<?xml version="1.0"?>

<configuration>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>desktop1:8031</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>desktop1:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>desktop1:8030</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>desktop1:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>desktop1:8088</value>

</property>

<property>

<description>Classpath for typical applications.</description>

<name>yarn.application.classpath</name>

<value>$HADOOP_CONF_DIR,$HADOOP_COMMON_HOME/share/hadoop/common/*,

$HADOOP_COMMON_HOME/share/hadoop/common/lib/*,

$HADOOP_HDFS_HOME/share/hadoop/hdfs/*,$HADOOP_HDFS_HOME/share/hadoop/hdfs/lib/*,

$YARN_HOME/share/hadoop/yarn/*,$YARN_HOME/share/hadoop/yarn/lib/*,

$YARN_HOME/share/hadoop/mapreduce/*,$YARN_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce.shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.nodemanager.local-dirs</name>

<value>/opt/data/yarn/local</value>

</property>

<property>

<name>yarn.nodemanager.log-dirs</name>

<value>/opt/data/yarn/logs</value>

</property>

<property>

<description>Where to aggregate logs</description>

<name>yarn.nodemanager.remote-app-log-dir</name>

<value>/opt/data/yarn/logs</value>

</property>

<property>

<name>yarn.app.mapreduce.am.staging-dir</name>

<value>/user</value>

</property>

</configuration>

</code>同步配置文件

修改.bashrc环境变量,并将其同步到其他几台机器,并且source .bashrc

<code>[root@desktop1 ~]# cat .bashrc

# .bashrc

alias rm='rm -i'

alias cp='cp -i'

alias mv='mv -i'

# Source global definitions

if [ -f /etc/bashrc ]; then

. /etc/bashrc

fi

# User specific environment and startup programs

export LANG=zh_CN.utf8

export JAVA_HOME=/opt/jdk1.6.0_38

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=./:$JAVA_HOME/lib:$JRE_HOME/lib:$JRE_HOME/lib/tools.jar

export HADOOP_HOME=/opt/hadoop-2.0.0-cdh4.2.0

export HIVE_HOME=/opt/hive-0.10.0-cdh4.2.0

export HBASE_HOME=/opt/hbase-0.94.2-cdh4.2.0

export HADOOP_MAPRED_HOME=${HADOOP_HOME}

export HADOOP_COMMON_HOME=${HADOOP_HOME}

export HADOOP_HDFS_HOME=${HADOOP_HOME}

export YARN_HOME=${HADOOP_HOME}

export HADOOP_YARN_HOME=${HADOOP_HOME}

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export HDFS_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export YARN_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export PATH=$PATH:$HOME/bin:$JAVA_HOME/bin:$HADOOP_HOME/sbin:$HBASE_HOME/bin:$HIVE_HOME/bin

</code>修改配置文件之后,使其生效。

<code>[root@desktop1 ~]# source .bashrc </code>

将desktop1上的/opt/hadoop-2.0.0-cdh4.2.0拷贝到其他机器上

启动脚本

第一次启动hadoop需要先格式化NameNode,该操作只做一次。当修改了配置文件时,需要重新格式化

<code>[root@desktop1 hadoop]hadoop namenode -format </code>

在desktop1上启动hdfs:

<code>[root@desktop1 hadoop]#start-dfs.sh </code>

在desktop1上启动mapreduce:

<code>[root@desktop1 hadoop]#start-yarn.sh </code>

在desktop1上启动historyserver:

<code>[root@desktop1 hadoop]#mr-jobhistory-daemon.sh start historyserver </code>

查看MapReduce:

<code>http://desktop1:8088/cluster </code>

查看节点:

<code>http://desktop2:8042/ http://desktop2:8042/node </code>

检查集群进程

<code>[root@desktop1 ~]# jps 5389 NameNode 5980 Jps 5710 ResourceManager 7032 JobHistoryServer [root@desktop2 ~]# jps 3187 Jps 3124 SecondaryNameNode [root@desktop3 ~]# jps 3187 Jps 3124 DataNode 5711 NodeManager</code>

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7642

7642

15

15

1392

1392

52

52

91

91

11

11

33

33

150

150

Win11システムに中国語言語パックをインストールできない問題の解決策

Mar 09, 2024 am 09:48 AM

Win11システムに中国語言語パックをインストールできない問題の解決策

Mar 09, 2024 am 09:48 AM

Win11 システムに中国語言語パックをインストールできない問題の解決策 Windows 11 システムの発売に伴い、多くのユーザーは新しい機能やインターフェイスを体験するためにオペレーティング システムをアップグレードし始めました。ただし、一部のユーザーは、アップグレード後に中国語の言語パックをインストールできず、エクスペリエンスに問題が発生したことに気づきました。この記事では、Win11 システムに中国語言語パックをインストールできない理由について説明し、ユーザーがこの問題を解決するのに役立ついくつかの解決策を提供します。原因分析 まず、Win11 システムの機能不全を分析しましょう。

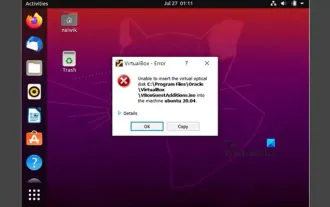

VirtualBox にゲスト追加機能をインストールできない

Mar 10, 2024 am 09:34 AM

VirtualBox にゲスト追加機能をインストールできない

Mar 10, 2024 am 09:34 AM

OracleVirtualBox の仮想マシンにゲスト追加をインストールできない場合があります。 [デバイス] > [InstallGuestAdditionsCDImage] をクリックすると、以下に示すようなエラーがスローされます。 VirtualBox - エラー: 仮想ディスク C: プログラミング ファイルOracleVirtualBoxVBoxGuestAdditions.iso を ubuntu マシンに挿入できません この投稿では、次の場合に何が起こるかを理解します。 VirtualBox にゲスト追加機能をインストールできません。 VirtualBox にゲスト追加機能をインストールできない Virtua にインストールできない場合

Baidu Netdisk は正常にダウンロードされたものの、インストールできない場合はどうすればよいですか?

Mar 13, 2024 pm 10:22 PM

Baidu Netdisk は正常にダウンロードされたものの、インストールできない場合はどうすればよいですか?

Mar 13, 2024 pm 10:22 PM

Baidu Netdisk のインストール ファイルを正常にダウンロードしたにもかかわらず、正常にインストールできない場合は、ソフトウェア ファイルの整合性にエラーがあるか、残っているファイルとレジストリ エントリに問題がある可能性があります。 Baidu Netdisk はダウンロードできましたが、インストールできない問題の分析を紹介します。 Baidu Netdisk は正常にダウンロードされたがインストールできない問題の分析 1. インストール ファイルの整合性を確認します。ダウンロードしたインストール ファイルが完全で、破損していないことを確認します。再度ダウンロードするか、別の信頼できるソースからインストール ファイルをダウンロードしてみてください。 2. ウイルス対策ソフトウェアとファイアウォールをオフにする: ウイルス対策ソフトウェアやファイアウォール プログラムによっては、インストール プログラムが正常に実行されない場合があります。ウイルス対策ソフトウェアとファイアウォールを無効にするか終了してから、インストールを再実行してください。

Android アプリを Linux にインストールするにはどうすればよいですか?

Mar 19, 2024 am 11:15 AM

Android アプリを Linux にインストールするにはどうすればよいですか?

Mar 19, 2024 am 11:15 AM

Linux への Android アプリケーションのインストールは、多くのユーザーにとって常に懸念事項であり、特に Android アプリケーションを使用したい Linux ユーザーにとって、Android アプリケーションを Linux システムにインストールする方法をマスターすることは非常に重要です。 Linux 上で Android アプリケーションを直接実行するのは Android プラットフォームほど簡単ではありませんが、エミュレータやサードパーティのツールを使用すれば、Linux 上で Android アプリケーションを快適に楽しむことができます。ここでは、Linux システムに Android アプリケーションをインストールする方法を紹介します。

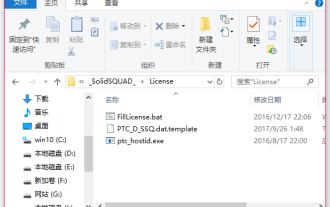

creo のインストール方法-creo インストール チュートリアル

Mar 04, 2024 pm 10:30 PM

creo のインストール方法-creo インストール チュートリアル

Mar 04, 2024 pm 10:30 PM

多くの初心者の友人はまだ creo のインストール方法を知りません。そのため、以下のエディターが creo のインストールに関する関連チュートリアルを提供します。必要な友人はそれを参照してください。お役に立てれば幸いです。 1. ダウンロードしたインストール パッケージを開き、次の図に示すように、License フォルダーを見つけます。 2. 次に、次の図に示すように、それを C ドライブ上のディレクトリにコピーします。 3. ダブルクリックして入力し、以下の図に示すように、ライセンス ファイルがあります。 図に示すように、4. 次に、次の図に示すように、ライセンス ファイルをこのファイルにコピーします。 5. C ドライブの PROGRAMFILES ファイルに、新しい PLC フォルダを作成します。次の図に示すように、ライセンス ファイルもコピーします。 次の図に示すように、クリックします。 7. メイン プログラムのインストール ファイルをダブルクリックします。インストールするには、新しいソフトウェアをインストールするボックスにチェックを入れます。

Ubuntu 24.04 に Podman をインストールする方法

Mar 22, 2024 am 11:26 AM

Ubuntu 24.04 に Podman をインストールする方法

Mar 22, 2024 am 11:26 AM

Docker を使用したことがある場合は、デーモン、コンテナー、およびそれらの機能を理解する必要があります。デーモンは、コンテナがシステムですでに使用されているときにバックグラウンドで実行されるサービスです。 Podman は、Docker などのデーモンに依存せずにコンテナーを管理および作成するための無料の管理ツールです。したがって、長期的なバックエンド サービスを必要とせずにコンテナーを管理できるという利点があります。さらに、Podman を使用するにはルートレベルの権限は必要ありません。このガイドでは、Ubuntu24 に Podman をインストールする方法について詳しく説明します。システムを更新するには、まずシステムを更新し、Ubuntu24 のターミナル シェルを開く必要があります。インストールプロセスとアップグレードプロセスの両方で、コマンドラインを使用する必要があります。シンプルな

Ubuntu 24.04 に Ubuntu Notes アプリをインストールして実行する方法

Mar 22, 2024 pm 04:40 PM

Ubuntu 24.04 に Ubuntu Notes アプリをインストールして実行する方法

Mar 22, 2024 pm 04:40 PM

高校で勉強しているときに、同じクラスの他の生徒よりも多くのメモを取る、非常に明確で正確なメモを取る生徒もいます。メモをとることが趣味である人もいますが、重要なことについての小さな情報をすぐに忘れてしまうため、メモをとることが必需品である人もいます。 Microsoft の NTFS アプリケーションは、通常の講義以外にも重要なメモを保存したい学生にとって特に役立ちます。この記事では、Ubuntu24へのUbuntuアプリケーションのインストールについて説明します。 Ubuntu システムの更新 Ubuntu インストーラーをインストールする前に、Ubuntu24 では、新しく構成されたシステムが更新されていることを確認する必要があります。 Ubuntu システムでは最も有名な「a」を使用できます

Win7 コンピューターに Go 言語をインストールする詳細な手順

Mar 27, 2024 pm 02:00 PM

Win7 コンピューターに Go 言語をインストールする詳細な手順

Mar 27, 2024 pm 02:00 PM

Win7 コンピュータに Go 言語をインストールする詳細な手順 Go (Golang とも呼ばれます) は、Google によって開発されたオープン ソース プログラミング言語です。シンプルで効率的で、優れた同時実行パフォーマンスを備えています。クラウド サービス、ネットワーク アプリケーション、およびアプリケーションの開発に適しています。バックエンド システムです。 Win7 コンピューターに Go 言語をインストールすると、その言語をすぐに使い始めて、Go プログラムの作成を開始できるようになります。以下では、Win7 コンピューターに Go 言語をインストールする手順を詳しく紹介し、具体的なコード例を添付します。ステップ 1: Go 言語インストール パッケージをダウンロードし、Go 公式 Web サイトにアクセスします。