Hadoop1.1.2 Eclipse 插件编译

可以直接下载我编译好的插件 hadoop-eclipse-plugin-1.1.2 http://download.csdn.net/detail/wind520/5784389 1:方法一: copy src\contrib\build-contrib.xml 到src\contrib\eclipse-plugin目录下,然后修改 ?xml version=1.0?!-- Licensed to the Apache S

可以直接下载我编译好的插件

hadoop-eclipse-plugin-1.1.2

http://download.csdn.net/detail/wind520/5784389

1:方法一:

copy src\contrib\build-contrib.xml 到src\contrib\eclipse-plugin目录下,然后修改

<?xml version="1.0"?>

<!--

Licensed to the Apache Software Foundation (ASF) under one or more

contributor license agreements. See the NOTICE file distributed with

this work for additional information regarding copyright ownership.

The ASF licenses this file to You under the Apache License, Version 2.0

(the "License"); you may not use this file except in compliance with

the License. You may obtain a copy of the License at

http://www.apache.org/licenses/LICENSE-2.0

Unless required by applicable law or agreed to in writing, software

distributed under the License is distributed on an "AS IS" BASIS,

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

See the License for the specific language governing permissions and

limitations under the License.

-->

<!-- Imported by contrib/*/build.xml files to share generic targets. -->

<project name="hadoopbuildcontrib" xmlns:ivy="antlib:org.apache.ivy.ant">

<property name="name" value="${ant.project.name}"></property>

<property name="eclipse.home" location="D:/oracle/get/eclipse"></property>

<property name="version" value="1.1.2"></property>

<property name="root" value="${basedir}"></property>

<property name="hadoop.root" location="${root}/../../../"></property>

<!-- Load all the default properties, and any the user wants -->

<!-- to contribute (without having to type -D or edit this file -->

<property file="${user.home}/${name}.build.properties"></property>

<property file="${root}/build.properties"></property>

<property file="${hadoop.root}/build.properties"></property>

<property name="src.dir" location="${root}/src/java"></property>

<property name="src.test" location="${root}/src/test"></property>

<property name="src.test.data" location="${root}/src/test/data"></property>

<!-- Property added for contrib system tests -->

<property name="build-fi.dir" location="${hadoop.root}/build-fi"></property>

<property name="system-test-build-dir" location="${build-fi.dir}/system"></property>

<property name="src.test.system" location="${root}/src/test/system"></property>

<property name="src.examples" location="${root}/src/examples"></property>

<available file="${src.examples}" type="dir" property="examples.available"></available>

<available file="${src.test}" type="dir" property="test.available"></available>

<!-- Property added for contrib system tests -->

<available file="${src.test.system}" type="dir" property="test.system.available"></available>

<property name="conf.dir" location="${hadoop.root}/conf"></property>

<property name="test.junit.output.format" value="plain"></property>

<property name="test.output" value="no"></property>

<property name="test.timeout" value="900000"></property>

<property name="build.contrib.dir" location="${hadoop.root}/build/contrib"></property>

<property name="build.dir" location="${hadoop.root}/build/contrib/${name}"></property>

<property name="build.classes" location="${build.dir}/classes"></property>

<property name="build.test" location="${build.dir}/test"></property>

<property name="build.examples" location="${build.dir}/examples"></property>

<property name="hadoop.log.dir" location="${build.dir}/test/logs"></property>

<!-- all jars together -->

<property name="javac.deprecation" value="off"></property>

<property name="javac.debug" value="on"></property>

<property name="build.ivy.lib.dir" value="${hadoop.root}/build/ivy/lib"></property>

<property name="javadoc.link" value="http://java.sun.com/j2se/1.4/docs/api/"></property>

<property name="build.encoding" value="ISO-8859-1"></property>

<fileset id="lib.jars" dir="${root}" includes="lib/*.jar"></fileset>

<!-- Property added for contrib system tests -->

<property name="build.test.system" location="${build.dir}/system"></property>

<property name="build.system.classes" location="${build.test.system}/classes"></property>

<!-- IVY properties set here -->

<property name="ivy.dir" location="ivy"></property>

<property name="ivysettings.xml" location="${hadoop.root}/ivy/ivysettings.xml"></property>

<loadproperties srcfile="${ivy.dir}/libraries.properties"></loadproperties>

<loadproperties srcfile="${hadoop.root}/ivy/libraries.properties"></loadproperties>

<property name="ivy.jar" location="${hadoop.root}/ivy/ivy-${ivy.version}.jar"></property>

<property name="ivy_repo_url" value="http://repo2.maven.org/maven2/org/apache/ivy/ivy/${ivy.version}/ivy-${ivy.version}.jar"></property>

<property name="build.dir" location="build"></property>

<property name="build.ivy.dir" location="${build.dir}/ivy"></property>

<property name="build.ivy.lib.dir" location="${build.ivy.dir}/lib"></property>

<property name="build.ivy.report.dir" location="${build.ivy.dir}/report"></property>

<property name="common.ivy.lib.dir" location="${build.ivy.lib.dir}/${ant.project.name}/common"></property>

<!--this is the naming policy for artifacts we want pulled down-->

<property name="ivy.artifact.retrieve.pattern" value="${ant.project.name}/[conf]/[artifact]-[revision].[ext]"></property>

<!-- the normal classpath -->

<path id="contrib-classpath">

<pathelement location="${build.classes}"></pathelement>

<pathelement location="${hadoop.root}/build/tools"></pathelement>

<fileset refid="lib.jars"></fileset>

<pathelement location="${hadoop.root}/build/classes"></pathelement>

<fileset dir="${hadoop.root}/lib">

<include name="**/*.jar"></include>

</fileset>

<path refid="${ant.project.name}.common-classpath"></path>

<pathelement path="${clover.jar}"></pathelement>

</path>

<!-- the unit test classpath -->

<path id="test.classpath">

<pathelement location="${build.test}"></pathelement>

<pathelement location="${hadoop.root}/build/test/classes"></pathelement>

<pathelement location="${hadoop.root}/src/contrib/test"></pathelement>

<pathelement location="${conf.dir}"></pathelement>

<pathelement location="${hadoop.root}/build"></pathelement>

<pathelement location="${build.examples}"></pathelement>

<pathelement location="${hadoop.root}/build/examples"></pathelement>

<path refid="contrib-classpath"></path>

</path>

<!-- The system test classpath -->

<path id="test.system.classpath">

<pathelement location="${hadoop.root}/src/contrib/${name}/src/test/system"></pathelement>

<pathelement location="${build.test.system}"></pathelement>

<pathelement location="${build.test.system}/classes"></pathelement>

<pathelement location="${build.examples}"></pathelement>

<pathelement location="${hadoop.root}/build-fi/system/classes"></pathelement>

<pathelement location="${hadoop.root}/build-fi/system/test/classes"></pathelement>

<pathelement location="${hadoop.root}/build-fi"></pathelement>

<pathelement location="${hadoop.root}/build-fi/tools"></pathelement>

<pathelement location="${hadoop.home}"></pathelement>

<pathelement location="${hadoop.conf.dir}"></pathelement>

<pathelement location="${hadoop.conf.dir.deployed}"></pathelement>

<pathelement location="${hadoop.root}/build"></pathelement>

<pathelement location="${hadoop.root}/build/examples"></pathelement>

<pathelement location="${hadoop.root}/build-fi/test/classes"></pathelement>

<path refid="contrib-classpath"></path>

<fileset dir="${hadoop.root}/src/test/lib">

<include name="**/*.jar"></include>

<exclude name="**/excluded/"></exclude>

</fileset>

<fileset dir="${hadoop.root}/build-fi/system">

<include name="**/*.jar"></include>

<exclude name="**/excluded/"></exclude>

</fileset>

<fileset dir="${hadoop.root}/build-fi/test/testjar">

<include name="**/*.jar"></include>

<exclude name="**/excluded/"></exclude>

</fileset>

<fileset dir="${hadoop.root}/build/contrib/${name}">

<include name="**/*.jar"></include>

<exclude name="**/excluded/"></exclude>

</fileset>

</path>

<!-- to be overridden by sub-projects -->

<target name="check-contrib"></target>

<target name="init-contrib"></target>

<!-- ====================================================== -->

<!-- Stuff needed by all targets -->

<!-- ====================================================== -->

<target name="init" depends="check-contrib" unless="skip.contrib">

<echo message="contrib: ${name}"></echo>

<mkdir dir="${build.dir}"></mkdir>

<mkdir dir="${build.classes}"></mkdir>

<mkdir dir="${build.test}"></mkdir>

<!-- The below two tags added for contrib system tests -->

<mkdir dir="${build.test.system}"></mkdir>

<mkdir dir="${build.system.classes}"></mkdir>

<mkdir dir="${build.examples}"></mkdir>

<mkdir dir="${hadoop.log.dir}"></mkdir>

<antcall target="init-contrib"></antcall>

</target>

<!-- ====================================================== -->

<!-- Compile a Hadoop contrib's files -->

<!-- ====================================================== -->

<target name="compile" depends="init, ivy-retrieve-common" unless="skip.contrib">

<echo message="contrib: ${name}"></echo>

<javac encoding="${build.encoding}" srcdir="${src.dir}" includes="**/*.java" destdir="${build.classes}" debug="${javac.debug}" deprecation="${javac.deprecation}">

<classpath refid="contrib-classpath"></classpath>

</javac>

</target>

<!-- ======================================================= -->

<!-- Compile a Hadoop contrib's example files (if available) -->

<!-- ======================================================= -->

<target name="compile-examples" depends="compile" if="examples.available">

<echo message="contrib: ${name}"></echo>

<javac encoding="${build.encoding}" srcdir="${src.examples}" includes="**/*.java" destdir="${build.examples}" debug="${javac.debug}">

<classpath refid="contrib-classpath"></classpath>

</javac>

</target>

<!-- ================================================================== -->

<!-- Compile test code -->

<!-- ================================================================== -->

<target name="compile-test" depends="compile-examples" if="test.available">

<echo message="contrib: ${name}"></echo>

<javac encoding="${build.encoding}" srcdir="${src.test}" includes="**/*.java" excludes="system/**/*.java" destdir="${build.test}" debug="${javac.debug}">

<classpath refid="test.classpath"></classpath>

</javac>

</target>

<!-- ================================================================== -->

<!-- Compile system test code -->

<!-- ================================================================== -->

<target name="compile-test-system" depends="compile-examples" if="test.system.available">

<echo message="contrib: ${name}"></echo>

<javac encoding="${build.encoding}" srcdir="${src.test.system}" includes="**/*.java" destdir="${build.system.classes}" debug="${javac.debug}">

<classpath refid="test.system.classpath"></classpath>

</javac>

</target>

<!-- ====================================================== -->

<!-- Make a Hadoop contrib's jar -->

<!-- ====================================================== -->

<target name="jar" depends="compile" unless="skip.contrib">

<echo message="contrib: ${name}"></echo>

<jar jarfile="${build.dir}/hadoop-${name}-${version}.jar" basedir="${build.classes}"></jar>

</target>

<!-- ====================================================== -->

<!-- Make a Hadoop contrib's examples jar -->

<!-- ====================================================== -->

<target name="jar-examples" depends="compile-examples" if="examples.available" unless="skip.contrib">

<echo message="contrib: ${name}"></echo>

<jar jarfile="${build.dir}/hadoop-${name}-examples-${version}.jar">

<fileset dir="${build.classes}">

</fileset>

<fileset dir="${build.examples}">

</fileset>

</jar>

</target>

<!-- ====================================================== -->

<!-- Package a Hadoop contrib -->

<!-- ====================================================== -->

<target name="package" depends="jar, jar-examples" unless="skip.contrib">

<mkdir dir="${dist.dir}/contrib/${name}"></mkdir>

<copy todir="${dist.dir}/contrib/${name}" includeemptydirs="false" flatten="true">

<fileset dir="${build.dir}">

<include name="hadoop-${name}-${version}.jar"></include>

</fileset>

</copy>

</target>

<!-- ================================================================== -->

<!-- Run unit tests -->

<!-- ================================================================== -->

<target name="test" depends="compile-test, compile" if="test.available">

<echo message="contrib: ${name}"></echo>

<delete dir="${hadoop.log.dir}"></delete>

<mkdir dir="${hadoop.log.dir}"></mkdir>

<junit printsummary="yes" showoutput="${test.output}" haltonfailure="no" fork="yes" maxmemory="512m" errorproperty="tests.failed" failureproperty="tests.failed" timeout="${test.timeout}">

<sysproperty key="test.build.data" value="${build.test}/data"></sysproperty>

<sysproperty key="build.test" value="${build.test}"></sysproperty>

<sysproperty key="src.test.data" value="${src.test.data}"></sysproperty>

<sysproperty key="contrib.name" value="${name}"></sysproperty>

<!-- requires fork=yes for:

relative File paths to use the specified user.dir

classpath to use build/contrib/*.jar

-->

<sysproperty key="user.dir" value="${build.test}/data"></sysproperty>

<sysproperty key="fs.default.name" value="${fs.default.name}"></sysproperty>

<sysproperty key="hadoop.test.localoutputfile" value="${hadoop.test.localoutputfile}"></sysproperty>

<sysproperty key="hadoop.log.dir" value="${hadoop.log.dir}"></sysproperty>

<sysproperty key="taskcontroller-path" value="${taskcontroller-path}"></sysproperty>

<sysproperty key="taskcontroller-ugi" value="${taskcontroller-ugi}"></sysproperty>

<classpath refid="test.classpath"></classpath>

<formatter type="${test.junit.output.format}"></formatter>

<batchtest todir="${build.test}" unless="testcase">

<fileset dir="${src.test}" includes="**/Test*.java" excludes="**/${test.exclude}.java, system/**/*.java"></fileset>

</batchtest>

<batchtest todir="${build.test}" if="testcase">

<fileset dir="${src.test}" includes="**/${testcase}.java" excludes="system/**/*.java"></fileset>

</batchtest>

</junit>

<antcall target="checkfailure"></antcall>

</target>

<!-- ================================================================== -->

<!-- Run system tests -->

<!-- ================================================================== -->

<target name="test-system" depends="compile, compile-test-system, jar" if="test.system.available">

<delete dir="${build.test.system}/extraconf"></delete>

<mkdir dir="${build.test.system}/extraconf"></mkdir>

<property name="test.src.dir" location="${hadoop.root}/src/test"></property>

<property name="test.junit.printsummary" value="yes"></property>

<property name="test.junit.haltonfailure" value="no"></property>

<property name="test.junit.maxmemory" value="512m"></property>

<property name="test.junit.fork.mode" value="perTest"></property>

<property name="test.all.tests.file" value="${test.src.dir}/all-tests"></property>

<property name="test.build.dir" value="${hadoop.root}/build/test"></property>

<property name="basedir" value="${hadoop.root}"></property>

<property name="test.timeout" value="900000"></property>

<property name="test.junit.output.format" value="plain"></property>

<property name="test.tools.input.dir" value="${basedir}/src/test/tools/data"></property>

<property name="c++.src" value="${basedir}/src/c++"></property>

<property name="test.include" value="Test*"></property>

<property name="c++.libhdfs.src" value="${c++.src}/libhdfs"></property>

<property name="test.build.data" value="${build.test.system}/data"></property>

<property name="test.cache.data" value="${build.test.system}/cache"></property>

<property name="test.debug.data" value="${build.test.system}/debug"></property>

<property name="test.log.dir" value="${build.test.system}/logs"></property>

<patternset id="empty.exclude.list.id"></patternset>

<exec executable="sed" inputstring="${os.name}" outputproperty="nonspace.os">

<arg value="s/ /_/g"></arg>

</exec>

<property name="build.platform" value="${nonspace.os}-${os.arch}-${sun.arch.data.model}"></property>

<property name="build.native" value="${hadoop.root}/build/native/${build.platform}"></property>

<property name="lib.dir" value="${hadoop.root}/lib"></property>

<property name="install.c++.examples" value="${hadoop.root}/build/c++-examples/${build.platform}"></property>

<condition property="tests.testcase">

<and>

<isset property="testcase"></isset>

</and>

</condition>

<property name="test.junit.jvmargs" value="-ea"></property>

<macro-system-test-runner test.file="${test.all.tests.file}" classpath="test.system.classpath" test.dir="${build.test.system}" fileset.dir="${hadoop.root}/src/contrib/${name}/src/test/system" hadoop.conf.dir.deployed="${hadoop.conf.dir.deployed}">

</macro-system-test-runner>

</target>

<macrodef name="macro-system-test-runner">

<attribute name="test.file"></attribute>

<attribute name="classpath"></attribute>

<attribute name="test.dir"></attribute>

<attribute name="fileset.dir"></attribute>

<attribute name="hadoop.conf.dir.deployed" default=""></attribute>

<sequential>

<delete dir="@{test.dir}/data"></delete>

<mkdir dir="@{test.dir}/data"></mkdir>

<delete dir="@{test.dir}/logs"></delete>

<mkdir dir="@{test.dir}/logs"></mkdir>

<copy file="${test.src.dir}/hadoop-policy.xml" todir="@{test.dir}/extraconf"></copy>

<copy file="${test.src.dir}/fi-site.xml" todir="@{test.dir}/extraconf"></copy>

<junit showoutput="${test.output}" printsummary="${test.junit.printsummary}" haltonfailure="${test.junit.haltonfailure}" fork="yes" forkmode="${test.junit.fork.mode}" maxmemory="${test.junit.maxmemory}" dir="${basedir}" timeout="${test.timeout}" errorproperty="tests.failed" failureproperty="tests.failed">

<jvmarg value="${test.junit.jvmargs}"></jvmarg>

<sysproperty key="java.net.preferIPv4Stack" value="true"></sysproperty>

<sysproperty key="test.build.data" value="@{test.dir}/data"></sysproperty>

<sysproperty key="test.tools.input.dir" value="${test.tools.input.dir}"></sysproperty>

<sysproperty key="test.cache.data" value="${test.cache.data}"></sysproperty>

<sysproperty key="test.debug.data" value="${test.debug.data}"></sysproperty>

<sysproperty key="hadoop.log.dir" value="@{test.dir}/logs"></sysproperty>

<sysproperty key="test.src.dir" value="@{fileset.dir}"></sysproperty>

<sysproperty key="taskcontroller-path" value="${taskcontroller-path}"></sysproperty>

<sysproperty key="taskcontroller-ugi" value="${taskcontroller-ugi}"></sysproperty>

<sysproperty key="test.build.extraconf" value="@{test.dir}/extraconf"></sysproperty>

<sysproperty key="hadoop.policy.file" value="hadoop-policy.xml"></sysproperty>

<sysproperty key="java.library.path" value="${build.native}/lib:${lib.dir}/native/${build.platform}"></sysproperty>

<sysproperty key="install.c++.examples" value="${install.c++.examples}"></sysproperty>

<syspropertyset dynamic="no">

<propertyref name="hadoop.tmp.dir"></propertyref>

</syspropertyset>

<!-- set compile.c++ in the child jvm only if it is set -->

<syspropertyset dynamic="no">

<propertyref name="compile.c++"></propertyref>

</syspropertyset>

<!-- Pass probability specifications to the spawn JVM -->

<syspropertyset id="FaultProbabilityProperties">

<propertyref regex="fi.*"></propertyref>

</syspropertyset>

<sysproperty key="test.system.hdrc.deployed.hadoopconfdir" value="@{hadoop.conf.dir.deployed}"></sysproperty>

<classpath refid="@{classpath}"></classpath>

<formatter type="${test.junit.output.format}"></formatter>

<batchtest todir="@{test.dir}" unless="testcase">

<fileset dir="@{fileset.dir}" excludes="**/${test.exclude}.java aop/** system/**">

<patternset>

<includesfile name="@{test.file}"></includesfile>

</patternset>

</fileset>

</batchtest>

<batchtest todir="@{test.dir}" if="testcase">

<fileset dir="@{fileset.dir}" includes="**/${testcase}.java"></fileset>

</batchtest>

</junit>

<antcall target="checkfailure"></antcall>

</sequential>

</macrodef>

<target name="checkfailure" if="tests.failed">

<touch file="${build.contrib.dir}/testsfailed"></touch>

<fail unless="continueOnFailure">Contrib Tests failed!</fail>

</target>

<!-- ================================================================== -->

<!-- Clean. Delete the build files, and their directories -->

<!-- ================================================================== -->

<target name="clean">

<echo message="contrib: ${name}"></echo>

<delete dir="${build.dir}"></delete>

</target>

<target name="ivy-probe-antlib">

<condition property="ivy.found">

<typefound uri="antlib:org.apache.ivy.ant" name="cleancache"></typefound>

</condition>

</target>

<target name="ivy-download" description="To download ivy " unless="offline">

<get src="%24%7Bivy_repo_url%7D" dest="${ivy.jar}" usetimestamp="true"></get>

</target>

<target name="ivy-init-antlib" depends="ivy-download,ivy-probe-antlib" unless="ivy.found">

<typedef uri="antlib:org.apache.ivy.ant" onerror="fail" loaderref="ivyLoader">

<classpath>

<pathelement location="${ivy.jar}"></pathelement>

</classpath>

</typedef>

<fail>

<condition>

<not>

<typefound uri="antlib:org.apache.ivy.ant" name="cleancache"></typefound>

</not>

</condition>

You need Apache Ivy 2.0 or later from http://ant.apache.org/

It could not be loaded from ${ivy_repo_url}

</fail>

</target>

<target name="ivy-init" depends="ivy-init-antlib">

<configure settingsid="${ant.project.name}.ivy.settings" file="${ivysettings.xml}"></configure>

</target>

<target name="ivy-resolve-common" depends="ivy-init">

<resolve settingsref="${ant.project.name}.ivy.settings" conf="common"></resolve>

</target>

<target name="ivy-retrieve-common" depends="ivy-resolve-common" description="Retrieve Ivy-managed artifacts for the compile/test configurations">

<retrieve settingsref="${ant.project.name}.ivy.settings" pattern="${build.ivy.lib.dir}/${ivy.artifact.retrieve.pattern}" sync="true"></retrieve>

<cachepath pathid="${ant.project.name}.common-classpath" conf="common"></cachepath>

</target>

</project>

修改 eclipse-plugin目录下的build.xml 文件

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<!--

Licensed to the Apache Software Foundation (ASF) under one or more

contributor license agreements. See the NOTICE file distributed with

this work for additional information regarding copyright ownership.

The ASF licenses this file to You under the Apache License, Version 2.0

(the "License"); you may not use this file except in compliance with

the License. You may obtain a copy of the License at

http://www.apache.org/licenses/LICENSE-2.0

Unless required by applicable law or agreed to in writing, software

distributed under the License is distributed on an "AS IS" BASIS,

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

See the License for the specific language governing permissions and

limitations under the License.

-->

<project default="jar" name="eclipse-plugin">

<import file="build-contrib.xml"></import>

<path id="eclipse-sdk-jars">

<fileset dir="${eclipse.home}/plugins/">

<include name="org.eclipse.ui*.jar"></include>

<include name="org.eclipse.jdt*.jar"></include>

<include name="org.eclipse.core*.jar"></include>

<include name="org.eclipse.equinox*.jar"></include>

<include name="org.eclipse.debug*.jar"></include>

<include name="org.eclipse.osgi*.jar"></include>

<include name="org.eclipse.swt*.jar"></include>

<include name="org.eclipse.jface*.jar"></include>

<include name="org.eclipse.team.cvs.ssh2*.jar"></include>

<include name="com.jcraft.jsch*.jar"></include>

</fileset>

</path>

<!-- Override classpath to include Eclipse SDK jars -->

<path id="classpath">

<pathelement location="${build.classes}"></pathelement>

<pathelement location="${hadoop.root}/hadoop-core-1.1.2.jar"></pathelement>

<pathelement location="${hadoop.root}/build/classes"></pathelement>

<path refid="eclipse-sdk-jars"></path>

</path>

<!-- Skip building if eclipse.home is unset. -->

<target name="check-contrib" unless="eclipse.home">

<property name="skip.contrib" value="yes"></property>

<echo message="eclipse.home unset: skipping eclipse plugin"></echo>

</target>

<target name="compile" depends="init, ivy-retrieve-common" unless="skip.contrib">

<echo message="contrib: ${name}"></echo>

<javac encoding="${build.encoding}" srcdir="${src.dir}" includes="**/*.java" destdir="${build.classes}" debug="${javac.debug}" deprecation="${javac.deprecation}">

<classpath refid="classpath"></classpath>

</javac>

</target>

<!-- Override jar target to specify manifest -->

<target name="jar" depends="compile" unless="skip.contrib">

<mkdir dir="${build.dir}/lib"></mkdir>

<copy file="${hadoop.root}/hadoop-core-${version}.jar" tofile="${build.dir}/lib/hadoop-core.jar" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-cli-1.2.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-configuration-1.6.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-httpclient-3.0.1.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/jackson-core-asl-1.8.8.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-lang-2.4.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/jackson-mapper-asl-1.8.8.jar" todir="${build.dir}/lib" verbose="true"></copy>

<jar jarfile="${build.dir}/hadoop-${name}-${version}.jar" manifest="${root}/META-INF/MANIFEST.MF">

<fileset dir="${build.dir}" includes="classes/ lib/"></fileset>

<fileset dir="${root}" includes="resources/ plugin.xml"></fileset>

</jar>

</target>

</project>

修改src\contrib\eclipse-plugin\META-INF下的MANIFEST.MF

Manifest-Version: 1.0 Bundle-ManifestVersion: 2 Bundle-Name: MapReduce Tools for Eclipse Bundle-SymbolicName: org.apache.hadoop.eclipse;singleton:=true Bundle-Version: 0.18 Bundle-Activator: org.apache.hadoop.eclipse.Activator Bundle-Localization: plugin Require-Bundle: org.eclipse.ui, org.eclipse.core.runtime, org.eclipse.jdt.launching, org.eclipse.debug.core, org.eclipse.jdt, org.eclipse.jdt.core, org.eclipse.core.resources, org.eclipse.ui.ide, org.eclipse.jdt.ui, org.eclipse.debug.ui, org.eclipse.jdt.debug.ui, org.eclipse.core.expressions, org.eclipse.ui.cheatsheets, org.eclipse.ui.console, org.eclipse.ui.navigator, org.eclipse.core.filesystem, org.apache.commons.logging Eclipse-LazyStart: true Bundle-ClassPath: classes/,lib/hadoop-core.jar,lib/commons-cli-1.2.jar,lib/commons-configuration-1.6.jar,lib/commons-httpclient-3.0.1.jar,lib/commons-lang-2.4.jar,lib/jackson-core-asl-1.8.8.jar,lib/jackson-mapper-asl-1.8.8.jar Bundle-Vendor: Apache Hadoop

编译:

Buildfile: E:\big\Hadoop\hadoop-1.1.2\src\contrib\eclipse-plugin\build.xml

check-contrib:

init:

[echo] contrib: eclipse-plugin

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\classes

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\test

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\system

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\system\classes

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\examples

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\test\logs

init-contrib:

ivy-download:

[get] Getting: http://repo2.maven.org/maven2/org/apache/ivy/ivy/2.1.0/ivy-2.1.0.jar

[get] To: E:\big\Hadoop\hadoop-1.1.2\ivy\ivy-2.1.0.jar

[get] Not modified - so not downloaded

ivy-probe-antlib:

ivy-init-antlib:

ivy-init:

[ivy:configure] :: Ivy 2.1.0 - 20090925235825 :: http://ant.apache.org/ivy/ ::

[ivy:configure] :: loading settings :: file = E:\big\Hadoop\hadoop-1.1.2\ivy\ivysettings.xml

ivy-resolve-common:

[ivy:resolve] :: resolving dependencies :: org.apache.hadoop#eclipse-plugin;working@lenovo-PC

[ivy:resolve] confs: [common]

[ivy:resolve] found commons-logging#commons-logging;1.0.4 in maven2

[ivy:resolve] found log4j#log4j;1.2.15 in maven2

[ivy:resolve] :: resolution report :: resolve 335ms :: artifacts dl 8ms

---------------------------------------------------------------------

| | modules || artifacts |

| conf | number| search|dwnlded|evicted|| number|dwnlded|

---------------------------------------------------------------------

| common | 2 | 0 | 0 | 0 || 2 | 0 |

---------------------------------------------------------------------

ivy-retrieve-common:

[ivy:retrieve] :: retrieving :: org.apache.hadoop#eclipse-plugin [sync]

[ivy:retrieve] confs: [common]

[ivy:retrieve] 2 artifacts copied, 0 already retrieved (419kB/114ms)

[ivy:cachepath] DEPRECATED: 'ivy.conf.file' is deprecated, use 'ivy.settings.file' instead

[ivy:cachepath] :: loading settings :: file = E:\big\Hadoop\hadoop-1.1.2\ivy\ivysettings.xml

compile:

[echo] contrib: eclipse-plugin

[javac] E:\big\Hadoop\hadoop-1.1.2\src\contrib\eclipse-plugin\build.xml:62: warning: 'includeantruntime' was not set, defaulting to build.sysclasspath=last; set to false for repeatable builds

[javac] Compiling 45 source files to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\classes

[javac] 注意:某些输入文件使用或覆盖了已过时的 API。

[javac] 注意:要了解详细信息,请使用 -Xlint:deprecation 重新编译。

[javac] 注意:某些输入文件使用了未经检查或不安全的操作。

[javac] 注意:要了解详细信息,请使用 -Xlint:unchecked 重新编译。

jar:

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\hadoop-core-1.1.2.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\hadoop-core.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-cli-1.2.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-cli-1.2.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-configuration-1.6.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-configuration-1.6.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-httpclient-3.0.1.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-httpclient-3.0.1.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\jackson-core-asl-1.8.8.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\jackson-core-asl-1.8.8.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-lang-2.4.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-lang-2.4.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\jackson-mapper-asl-1.8.8.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\jackson-mapper-asl-1.8.8.jar

[jar] Building jar: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\hadoop-eclipse-plugin-1.1.2.jar

BUILD SUCCESSFUL

Total time: 10 seconds

方法2:

修改 eclipse-plugin目录下的build.xml 文件

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<project default="jar" name="eclipse-plugin">

<property name="name" value="${ant.project.name}"></property>

<property name="root" value="${basedir}"></property>

<property name="hadoop.root" location="E:/big/Hadoop/hadoop-1.1.2"></property>

<property name="version" value="1.1.2"></property>

<property name="eclipse.home" location="D:/oracle/get/eclipse"></property>

<property name="build.dir" location="${hadoop.root}/build/contrib/${name}"></property>

<property name="build.classes" location="${build.dir}/classes"></property>

<property name="src.dir" location="${root}/src/java"></property>

<path id="eclipse-sdk-jars">

<fileset dir="${eclipse.home}/plugins/">

<include name="org.eclipse.ui*.jar"></include>

<include name="org.eclipse.jdt*.jar"></include>

<include name="org.eclipse.core*.jar"></include>

<include name="org.eclipse.equinox*.jar"></include>

<include name="org.eclipse.debug*.jar"></include>

<include name="org.eclipse.osgi*.jar"></include>

<include name="org.eclipse.swt*.jar"></include>

<include name="org.eclipse.jface*.jar"></include>

<include name="org.eclipse.team.cvs.ssh2*.jar"></include>

<include name="com.jcraft.jsch*.jar"></include>

</fileset>

</path>

<!-- Override classpath to include Eclipse SDK jars -->

<path id="classpath">

<fileset dir="${hadoop.root}">

<include name="*.jar"></include>

</fileset>

<path refid="eclipse-sdk-jars"></path>

</path>

<target name="compile">

<mkdir dir="${build.dir}/classes"></mkdir>

<javac encoding="ISO-8859-1" srcdir="${src.dir}" includes="**/*.java" destdir="${build.classes}" debug="on" deprecation="off">

<classpath refid="classpath"></classpath>

</javac>

</target>

<!-- Override jar target to specify manifest-->

<target name="jar" depends="compile">

<mkdir dir="${build.dir}/lib"></mkdir>

<copy file="${hadoop.root}/hadoop-core-${version}.jar" tofile="${build.dir}/lib/hadoop-core.jar" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-cli-1.2.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-configuration-1.6.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-httpclient-3.0.1.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/jackson-core-asl-1.8.8.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/commons-lang-2.4.jar" todir="${build.dir}/lib" verbose="true"></copy>

<copy file="${hadoop.root}/lib/jackson-mapper-asl-1.8.8.jar" todir="${build.dir}/lib" verbose="true"></copy>

<jar jarfile="${build.dir}/hadoop-${name}-${version}.jar" manifest="${root}/META-INF/MANIFEST.MF">

<fileset dir="${build.dir}" includes="classes/ lib/"></fileset>

<fileset dir="${root}" includes="resources/ plugin.xml"></fileset>

</jar>

</target>

</project>修改src\contrib\eclipse-plugin\META-INF下的MANIFEST.MF

同方法一的

为了和方法一步冲突,我修改buildOK.xml

编译:

Buildfile: E:\big\Hadoop\hadoop-1.1.2\src\contrib\eclipse-plugin\buildOK.xml

compile:

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\classes

[javac] E:\big\Hadoop\hadoop-1.1.2\src\contrib\eclipse-plugin\buildOK.xml:42: warning: 'includeantruntime' was not set, defaulting to build.sysclasspath=last; set to false for repeatable builds

[javac] Compiling 45 source files to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\classes

[javac] 注意:某些输入文件使用或覆盖了已过时的 API。

[javac] 注意:要了解详细信息,请使用 -Xlint:deprecation 重新编译。

[javac] 注意:某些输入文件使用了未经检查或不安全的操作。

[javac] 注意:要了解详细信息,请使用 -Xlint:unchecked 重新编译。

jar:

[mkdir] Created dir: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\hadoop-core-1.1.2.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\hadoop-core.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-cli-1.2.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-cli-1.2.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-configuration-1.6.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-configuration-1.6.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-httpclient-3.0.1.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-httpclient-3.0.1.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\jackson-core-asl-1.8.8.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\jackson-core-asl-1.8.8.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\commons-lang-2.4.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\commons-lang-2.4.jar

[copy] Copying 1 file to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib

[copy] Copying E:\big\Hadoop\hadoop-1.1.2\lib\jackson-mapper-asl-1.8.8.jar to E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\lib\jackson-mapper-asl-1.8.8.jar

[jar] Building jar: E:\big\Hadoop\hadoop-1.1.2\build\contrib\eclipse-plugin\hadoop-eclipse-plugin-1.1.2.jar

BUILD SUCCESSFUL

Total time: 2 seconds

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7328

7328

9

9

1626

1626

14

14

1350

1350

46

46

1262

1262

25

25

1209

1209

29

29

Eclipse で背景色の設定を調整する方法

Jan 28, 2024 am 09:08 AM

Eclipse で背景色の設定を調整する方法

Jan 28, 2024 am 09:08 AM

Eclipseで背景色を設定するにはどうすればよいですか? Eclipse は開発者の間で人気のある統合開発環境 (IDE) であり、さまざまなプログラミング言語での開発に使用できます。非常に強力かつ柔軟で、設定を通じてインターフェースとエディターの外観をカスタマイズできます。この記事では、Eclipseで背景色を設定する方法と具体的なコード例を紹介します。 1. エディタの背景色を変更する Eclipse を開き、「Windows」メニューに入ります。 「設定」を選択します。左側に移動します

PyCharm 初心者ガイド: プラグインのインストールを徹底理解!

Feb 25, 2024 pm 11:57 PM

PyCharm 初心者ガイド: プラグインのインストールを徹底理解!

Feb 25, 2024 pm 11:57 PM

PyCharm は、開発者がより効率的にコードを記述できるようにする豊富な機能とツールを提供する、強力で人気のある Python 統合開発環境 (IDE) です。 PyCharm のプラグイン機構は、機能を拡張するための強力なツールであり、さまざまなプラグインをインストールすることで、PyCharm にさまざまな機能やカスタマイズ機能を追加できます。したがって、PyCharm の初心者にとって、プラグインのインストールを理解し、習熟することが重要です。この記事では、PyCharm プラグインの完全なインストールについて詳しく説明します。

![Illustrator でのプラグインの読み込みエラー [修正]](https://img.php.cn/upload/article/000/465/014/170831522770626.jpg?x-oss-process=image/resize,m_fill,h_207,w_330) Illustrator でのプラグインの読み込みエラー [修正]

Feb 19, 2024 pm 12:00 PM

Illustrator でのプラグインの読み込みエラー [修正]

Feb 19, 2024 pm 12:00 PM

Adobe Illustrator を起動すると、プラグインの読み込みエラーに関するメッセージが表示されますか?一部の Illustrator ユーザーは、アプリケーションを開いたときにこのエラーに遭遇しました。メッセージの後には、問題のあるプラグインのリストが続きます。このエラー メッセージは、インストールされているプラグインに問題があることを示していますが、Visual C++ DLL ファイルの破損や環境設定ファイルの破損など、他の理由によって発生する可能性もあります。このエラーが発生した場合は、この記事で問題を解決する方法を説明しますので、以下を読み続けてください。 Illustrator でのプラグインの読み込みエラー Adobe Illustrator を起動しようとしたときに「プラグインの読み込みエラー」エラー メッセージが表示された場合は、次の操作を行うことができます。 管理者として

プロによるガイダンス: Eclipse Lombok プラグインを正常にインストールする方法に関する専門家のアドバイスと手順

Jan 28, 2024 am 09:15 AM

プロによるガイダンス: Eclipse Lombok プラグインを正常にインストールする方法に関する専門家のアドバイスと手順

Jan 28, 2024 am 09:15 AM

専門的なガイダンス: Lombok プラグインを Eclipse にインストールするための専門家のアドバイスと手順。特定のコード例が必要です。 概要: Lombok は、アノテーションを通じて Java コードの作成を簡素化し、いくつかの強力なツールを提供する Java ライブラリです。この記事では、Eclipse で Lombok プラグインをインストールして構成する方法の手順を読者に紹介し、読者が Lombok プラグインをよりよく理解して使用できるように、いくつかの具体的なコード例を示します。まず Lombok プラグインをダウンロードします。

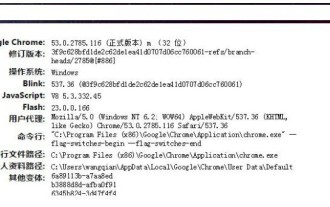

Chrome プラグイン拡張機能のインストール ディレクトリとは何ですか?

Mar 08, 2024 am 08:55 AM

Chrome プラグイン拡張機能のインストール ディレクトリとは何ですか?

Mar 08, 2024 am 08:55 AM

Chrome プラグイン拡張機能のインストール ディレクトリとは何ですか?通常の状況では、Chrome プラグイン拡張機能のデフォルトのインストール ディレクトリは次のとおりです。 1. WindowsXP での Chrome プラグインのデフォルトのインストール ディレクトリの場所: C:\DocumentsandSettings\username\LocalSettings\ApplicationData\Google\Chrome\UserData\ Default\Extensions2. Windows7 の chrome プラグインのデフォルトのインストール ディレクトリの場所: C:\Users\username\AppData\Local\Google\Chrome\User

Edge ブラウザがこのプラグインをサポートしない理由に対する 3 つの解決策を共有します

Mar 13, 2024 pm 04:34 PM

Edge ブラウザがこのプラグインをサポートしない理由に対する 3 つの解決策を共有します

Mar 13, 2024 pm 04:34 PM

ユーザーが Edge ブラウザを使用する場合、より多くのニーズを満たすためにいくつかのプラグインを追加する場合があります。しかし、プラグインを追加すると、このプラグインはサポートされていないと表示されます。この問題を解決するにはどうすればよいですか?今日は編集者が 3 つの解決策を紹介しますので、ぜひ試してみてください。方法 1: 別のブラウザを使用してみてください。方法 2: ブラウザ上の Flash Player が古いか見つからないため、プラグインがサポートされていない可能性があり、公式 Web サイトから最新バージョンをダウンロードできます。方法3:「Ctrl+Shift+Delete」キーを同時に押します。 「データを消去」をクリックしてブラウザを再度開きます。

Eclipse コードの実行時の問題に対する解決策を明らかにする: さまざまな実行時エラーのトラブルシューティングを支援します。

Jan 28, 2024 am 09:22 AM

Eclipse コードの実行時の問題に対する解決策を明らかにする: さまざまな実行時エラーのトラブルシューティングを支援します。

Jan 28, 2024 am 09:22 AM

Eclipse コード実行の問題の解決策が明らかになります: これは、さまざまなコード実行エラーを排除するのに役立ち、特定のコード サンプルが必要です はじめに: Eclipse は、一般的に使用される統合開発環境 (IDE) であり、Java 開発で広く使用されています。 Eclipse は強力な機能とフレンドリーなユーザー インターフェイスを備えていますが、コードを作成およびデバッグする際には、実行中にさまざまな問題が発生することは避けられません。この記事では、Eclipse コードの実行に関する一般的な問題をいくつか明らかにし、解決策を提供します。読者の理解を助けるために、これは

Eclipseでショートカットキー設定をカスタマイズする方法

Jan 28, 2024 am 10:01 AM

Eclipseでショートカットキー設定をカスタマイズする方法

Jan 28, 2024 am 10:01 AM

Eclipse でショートカット キーの設定をカスタマイズするにはどうすればよいですか?開発者にとって、ショートカット キーをマスターすることは、Eclipse でコーディングする際の効率を向上させるための鍵の 1 つです。強力な統合開発環境として、Eclipse は多くのデフォルトのショートカット キーを提供するだけでなく、ユーザーが独自の好みに応じてショートカット キーをカスタマイズすることもできます。この記事では、Eclipseでショートカットキーの設定をカスタマイズする方法と具体的なコード例を紹介します。 Eclipseを開く まず、Eclipseを開いて次のように入力します。