搭建Hadoop环境的详细过程

即上一篇《初步了解Hadoop》已经过去好多天了,今天继续hadoop学习之旅。大体了解hadoop原理,我们想先搭建hadoop环境,在这个过程中慢慢体会一下hadoop。 我在这里说的是hadoop伪分布式模式(Pseudo-Distributed Mode),其实网上已经有很多教程,在这里我

即上一篇《初步了解Hadoop》已经过去好多天了,今天继续hadoop学习之旅。大体了解hadoop原理,我们想先搭建hadoop环境,在这个过程中慢慢体会一下hadoop。

我在这里说的是hadoop伪分布式模式(Pseudo-Distributed Mode),其实网上已经有很多教程,在这里我详详细细的描述整个搭建过程,也算是自己重新回忆一下。

准备阶段(下载地址我这里就不给出了):

Win7旗舰版 Vmware-9.0.2

ubuntu-12.04 hadoop-0.20.2 jdk-8u5-linux-i586-demos

搭建流程:

1、装机阶段:

一、安装Ubuntu操作系统

二、在Ubuntu下创建hadoop用户组和用户

三、在Ubuntu下安装JDK

四、修改机器名

五、安装ssh服务

六、建立ssh无密码登录本机

七、安装hadoop

八、在单机上运行hadoop

一、安装Ubuntu操作系统

略……

二、在Ubuntu下创建hadoop用户组和用户

(1)安装Ubuntu时已经建立了一个用户,但是为了以后Hadoop操作,专门渐建立一个hadoop用户组和hadoop用户。

(2)给hadoop用户添加权限,打开/etc/sudoers文件。

sudo gedit /etc/sudoers

打开/etc/sudoers文件了,给hadoop用户赋予root用户同样的权限。在

root ALL=(ALL:ALL) ALL

下添加:

hadoop ALL=(ALL:ALL) ALL

三、在Ubuntu下安装JDK

1、创建JDK安装目录

(1)由于我使用的是VMware安装的Ubuntu系统,设置本地thisceshi文件夹共享到Ubuntu系统,指定的安装目录是:/usr/local/java。可是系统安装后在/usr/local下并没有java目录,这需要我们去创建一个java文件夹,

进入/usr/local文件夹

cd /usr/local

创建java文件夹,

sudo mkdir /usr/local/java

(2)解压JDK到目标目录

进入共享文件夹thisceshi,

cd /mnt/hgfs/thisceshi

然后进入到共享文件夹中,继续我们解压JDK到之前建好的java文件夹中,

sudo cp jdk-8u5-linux-i586-demos.tar.gz /usr/local/java

2、安装jdk

(1)切换到root用户下,

hadoop@s15:/mnt/hgfs/thisceshi$ su 密码:

(2)解压jdk-8u5-linux-i586-demos.tar.gz

sudo tar -zxf jdk-8u5-linux-i586-demos.tar.gz

此时java目录中多了一个jdk1.6.0_30文件夹。

3、配置环境变量

(1)打开/etc/profile文件,

sudo gedit /etc/profile

(2)添加变量,

#set java environment export JAVA_HOME=/usr/local/java/jdk1.6.0_30 export JRE_HOME=/usr/local/java/jdk1.6.0_30/jre export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$JAVA_HOME:$PATH

一般更改/etc/profile文件后,需要重启机器才能生效,在这里我们可以使用如下指令可使配置文件立即生效,

source /etc/profile

(3)查看java环境变量是否配置成功,

java -version

显示如下:

java version "1.6.0_30" Java(TM) SE Runtime Environment (build 1.6.0_30-b12) Java HotSpot(TM) Client VM (build 20.5-b03, mixed mode, sharing)

但是在root下一切正常,在hadoop用户下就出现了问题,

程序“java”已包含在下列软件包中: * gcj-4.4-jre-headless * openjdk-6-jre-headless * cacao * gij-4.3 * jamvm

在终端中我们分别运行下面指令,

sudo update-alternatives --install /usr/bin/java java /usr/local/java/jdk1.6.0_30/bin/java 300 sudo update-alternatives --install /usr/bin/javac javac /usr/local/java/jdk1.6.0_30/bin/javac 300

问题解决。

四、修改机器名

当ubuntu安装成功时,我们的机器名都默认为:ubuntu ,但为了以后集群中能够容易分辨各台服务器,需要给每台机器取个不同的名字。机器名由 /etc/hostname文件决定。这是我开始是根据网上教程也给修改了,其实伪分布式搭建的时候,可以省了,不然还造成一些不必要的麻烦。

1、打开/etc/hostname文件,运行指令,

sudo gedit /etc/hostname

2、然后hostname中添加s15五、安装ssh服务保存退出,即s15是当前用户别名。在这里需要重启系统后才会生效。

hadoop@s15:~$

五、安装ssh服务

1、安装openssh-server

sudo apt-get install openssh-server

2、等待安装,即可。

六、 建立ssh无密码登录本机

在这里,我自己还是模模糊糊的。

ssh生成密钥有rsa和dsa两种生成方式,默认情况下采用rsa方式。

1、创建ssh-key,,这里我们采用rsa方式,

ssh-keygen -t rsa -P ''

网上教程中后面是双引号,我在执行出现错误,换成单引号,则可以执行。

进入ssh,查看里面文件

hadoop@s15:~$ cd .ssh hadoop@s15:~/.ssh$ ls id_rsa id_rsa.pub

2、进入~/.ssh/目录下,将idrsa.pub追加到authorizedkeys授权文件中,开始是没有authorized_keys文件的,

cat id_rsa.pub >> authorized_keys

3、登录localhost,

hadoop@s15:~/.ssh$ ssh localhost Welcome to Ubuntu 12.04 LTS (GNU/Linux 3.2.0-61-generic-pae i686) * Documentation: https://help.ubuntu.com/ 663 packages can be updated. 266 updates are security updates. Last login: Sat May 10 13:08:03 2014 from localhost

4、执行退出命令,

hadoop@s15:~$ exit 登出 Connection to localhost closed.

七、安装hadoop

1、从共享文件夹thisceshi中将hadoop-0.20.2.tar.gz复制到安装目录 /usr/local/下

2、解压hadoop-0.20.203.tar.gz,

3、将解压出的文件夹改名为hadoop,

4、将该hadoop文件夹的属主用户设为hadoop,

sudo chown -R hadoop:hadoop hadoop

5、打开hadoop/conf/hadoop-env.sh文件,

6、配置conf/hadoop-env.sh(找到#export JAVA_HOME=…,去掉#,然后加上本机jdk的路径)

# The java implementation to use. Required. export JAVA_HOME=/usr/local/java/jdk1.6.0_30 export HADOOP_HOME=/usr/local/hadoop export PATH=$PATH:/usr/local/hadoop/bin

让环境立即生效,

source /usr/local/hadoop/conf/hadoop-env.sh

7、打开conf/core-site.xml文件,编辑如下:

<?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="http://www.cndwzone.com/archives/configuration.xsl"?> <!-- Put site-specific property overrides in this file. --> fs.default.name hdfs://localhost:9000

8、打开conf/mapred-site.xml文件,编辑如下:

<?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="http://www.cndwzone.com/archives/configuration.xsl"?> <!-- Put site-specific property overrides in this file. --> mapred.job.tracker localhost:9001

9、打开conf/hdfs-site.xml文件,编辑如下:

<?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="http://www.cndwzone.com/archives/configuration.xsl"?> <!-- Put site-specific property overrides in this file. --> dfs.name.dir /usr/local/hadoop/datalog1,/usr/local/hadoop/datalog2 dfs.data.dir /usr/local/hadoop/data1,/usr/local/hadoop/data2 dfs.replication 2

10、打开conf/masters文件,添加作为secondarynamenode的主机名,因为是伪分布式,只有一个节点,这里只需填写localhost就可以。

11、打开conf/slaves文件,添加作为slave的主机名,一行一个。因为是伪分布式,只有一个节点,这里也只需填写localhost就可以。

八、在单机上运行hadoop

1、进入hadoop目录下,格式化hdfs文件系统,初次运行hadoop时一定要有该操作,当你看到下图时,就说明你的hdfs文件系统格式化成功了。

3、进入bin目录启动start-all.sh,

4、检测hadoop是否启动成功,

到此,hadoop伪分布式环境搭建完成。

在搭建过程中可能会遇到各种问题,到时大家不用着急,可以谷歌,百度一下。解决问题的过程就是加深学习的过程。我当时都忘了花了多久才将环境搭建好,最初的时候,连最基本的指令也不懂,也不知道怎么运行。我在这里说出来就是想说,开始的一无所知不要害怕,慢慢来就好,在那么一刻你就会有所知,有所明白。之后的文章中会介绍在hadoop环境下运行WordCount,hadoop中的HelloWorld。

即上一篇《初步了解Hadoop》已经过去好多天了,今天继续hadoop学习之旅。大体了解hadoop原理,我们 […]

即上一篇《初步了解Hadoop》已经过去好多天了,今天继续hadoop学习之旅。大体了解hadoop原理,我们 […]

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7530

7530

15

15

1378

1378

52

52

82

82

11

11

21

21

76

76

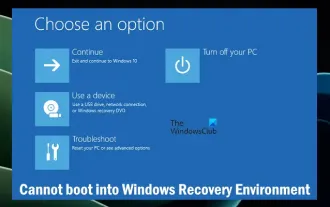

Windows 回復環境を起動できない

Feb 19, 2024 pm 11:12 PM

Windows 回復環境を起動できない

Feb 19, 2024 pm 11:12 PM

Windows 回復環境 (WinRE) は、Windows オペレーティング システムのエラーを修復するために使用される環境です。 WinRE に入ると、システムの復元、出荷時設定へのリセット、アップデートのアンインストールなどを実行できます。 WinRE を起動できない場合、この記事では問題を解決するための修正方法を説明します。 Windows 回復環境を起動できない Windows 回復環境を起動できない場合は、以下の修正プログラムを使用してください。 Windows 回復環境のステータスを確認する 他の方法を使用して Windows 回復環境に入る Windows 回復パーティションを誤って削除しましたか?以下の Windows のインプレース アップグレードまたはクリーン インストールを実行します。これらすべての修正については詳しく説明しています。 1]Wiをチェックする

Python と Anaconda の違いは何ですか?

Sep 06, 2023 pm 08:37 PM

Python と Anaconda の違いは何ですか?

Sep 06, 2023 pm 08:37 PM

この記事では、Python と Anaconda の違いについて学びます。パイソンとは何ですか? Python は、行をインデントし空白を入れることでコードを読みやすく理解しやすくすることに重点を置いたオープンソース言語です。 Python は柔軟性と使いやすさを備えているため、オンライン アプリケーションの作成や開発だけでなく、科学コンピューティング、人工知能、データ サイエンスなどのさまざまなアプリケーションに最適です。 Python はインタープリタ言語であるため、テストされるとすぐに機械語に翻訳されます。 C++ などの一部の言語は、理解するためにコンパイルが必要です。 Python は理解、開発、実行、読み取りが非常に簡単であるため、Python の習熟度は重要な利点となります。これにより Python が作成されます

Java エラー: Hadoop エラー、処理方法と回避方法

Jun 24, 2023 pm 01:06 PM

Java エラー: Hadoop エラー、処理方法と回避方法

Jun 24, 2023 pm 01:06 PM

Java エラー: Hadoop エラー、対処方法と回避方法 Hadoop を使用してビッグ データを処理する場合、タスクの実行に影響を与え、データ処理の失敗を引き起こす可能性のある Java 例外エラーが頻繁に発生します。この記事では、一般的な Hadoop エラーをいくつか紹介し、それらに対処および回避する方法を示します。 Java.lang.OutOfMemoryErrorOutOfMemoryError は、Java 仮想マシンのメモリ不足によって発生するエラーです。 Hadoop の場合

Vue フレームワークで統計グラフ システムを迅速に構築する方法

Aug 21, 2023 pm 05:48 PM

Vue フレームワークで統計グラフ システムを迅速に構築する方法

Aug 21, 2023 pm 05:48 PM

Vue フレームワークで統計グラフ システムを迅速に構築する方法 最新の Web アプリケーションでは、統計グラフは不可欠なコンポーネントです。人気のあるフロントエンド フレームワークとして、Vue.js は、統計グラフ システムを迅速に構築するのに役立つ便利なツールとコンポーネントを多数提供します。この記事では、Vue フレームワークといくつかのプラグインを使用して、簡単な統計グラフ システムを構築する方法を紹介します。まず、Vue スキャフォールディングといくつかの関連プラグインのインストールなど、Vue.js 開発環境を準備する必要があります。コマンドラインで次のコマンドを実行します

ミストロック王国の自然の中に建物を建てることはできますか?

Mar 07, 2024 pm 08:28 PM

ミストロック王国の自然の中に建物を建てることはできますか?

Mar 07, 2024 pm 08:28 PM

ミストロック王国でプレイするとき、プレイヤーはさまざまな材料を集めて建物を建てることができます。多くのプレイヤーは、野生で建物を建てるべきかどうか知りたいと考えています。ミストロック王国では、建物は野生で建てることはできません。祭壇の範囲内になければなりません。 。ミストロック王国の自然の中に建物を建てることはできますか? 答え: いいえ。 1. ミストロックキングダムの荒野には建物を建てることができません。 2. 建物は祭壇の範囲内に建てなければなりません。 3. プレイヤーは自分で精霊の火の祭壇を設置できますが、範囲を離れると建物を建設できなくなります。 4. 山に直接穴を掘って家にすることもできるので、建築資材を消費する必要がありません。 5. プレイヤー自身が建てた建物には快適性のメカニズムがあり、内装が良いほど快適性が高くなります。 6. 高い快適性により、プレイヤーに属性ボーナスがもたらされます。

Beego で Hadoop と HBase を使用してビッグ データ ストレージとクエリを実行する

Jun 22, 2023 am 10:21 AM

Beego で Hadoop と HBase を使用してビッグ データ ストレージとクエリを実行する

Jun 22, 2023 am 10:21 AM

ビッグデータ時代の到来に伴い、データの処理と保存の重要性がますます高まっており、大量のデータをいかに効率的に管理、分析するかが企業にとっての課題となっています。 Apache Foundation の 2 つのプロジェクトである Hadoop と HBase は、ビッグ データのストレージと分析のためのソリューションを提供します。この記事では、ビッグデータのストレージとクエリのために Beego で Hadoop と HBase を使用する方法を紹介します。 1. Hadoop と HBase の概要 Hadoop は、オープンソースの分散ストレージおよびコンピューティング システムです。

PHP統合環境パッケージとは何ですか?

Jul 24, 2023 am 09:36 AM

PHP統合環境パッケージとは何ですか?

Jul 24, 2023 am 09:36 AM

PHP 統合環境パッケージには次のものが含まれます: 1. PhpStorm (強力な PHP 統合環境)、2. Eclipse (オープンソース統合開発環境)、3. Visual Studio Code (軽量のオープンソース コード エディター)、4. Sublime Text (人気のあるテキスト エディター)さまざまなプログラミング言語で広く使用されている; 5. NetBeans、Apache Software Foundation によって開発された統合開発環境; 6. Zend Studio、PHP 開発者向けに設計された統合開発環境。

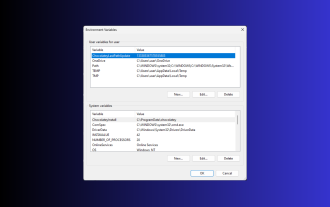

Windows 3 で環境変数を設定する 11 の方法

Sep 15, 2023 pm 12:21 PM

Windows 3 で環境変数を設定する 11 の方法

Sep 15, 2023 pm 12:21 PM

Windows 11 で環境変数を設定すると、システムのカスタマイズ、スクリプトの実行、アプリケーションの構成に役立ちます。このガイドでは、好みに合わせてシステムを構成できるように、3 つの方法と段階的な手順について説明します。環境変数には 3 つのタイプがあります。 システム環境変数 – グローバル変数は優先順位が最も低く、Windows 上のすべてのユーザーとアプリケーションがアクセスでき、通常はシステム全体の設定を定義するために使用されます。ユーザー環境変数 – 優先度が高く、これらの変数は現在のユーザーとそのアカウントで実行されているプロセスにのみ適用され、そのアカウントで実行されているユーザーまたはアプリケーションによって設定されます。プロセス環境変数 – 最も高い優先順位があり、一時的なもので、現在のプロセスとそのサブプロセスに適用され、プログラムを提供します。