複数の形態とタスクに適応する、最も強力なオープンソースロボット学習システム「Octopus」が誕生

ロボット学習の観点から見ると、一般的なアプローチは、特定のロボットとタスクに固有のデータセットを収集し、それをポリシーのトレーニングに使用することです。ただし、この方法を使用してゼロから学習する場合、タスクごとに十分なデータを収集する必要があり、結果として得られるポリシーの一般化能力は通常不十分です。

「原則として、他のロボットやタスクから収集された経験は可能な解決策を提供し、モデルがロボット制御のさまざまな問題を認識できるようになり、これらの問題によって下流のタスクでのロボットの全体的なパフォーマンスが向上する可能性があります。さまざまな自然言語やコンピュータビジョンのタスクを処理できる一般的なモデルですが、ロボットの統一的な制御戦略を訓練するための「ユニバーサルロボットモデル」を構築することは依然として困難であり、異なるロボット本体の操作を含む多くの困難を伴います。センサー構成、アクションスペース、タスク仕様、環境、および計算予算。

この目標を達成するために、ロボットの観察をアクションに直接マッピングし、ゼロサンプルソリューションを通じて新しい分野や新しいロボットに一般化するというアプローチの「ロボット基本モデル」に関連するいくつかの研究結果が現れています。これらのモデルは、「ジェネラリスト ロボット ポリシー」 (GRP) と呼ばれることが多く、さまざまなタスク、環境、ロボット システムにわたって低レベルの視覚運動制御を実行するロボットの能力を強調します。

GNM (汎用ナビゲーション モデル) は、さまざまなロボット ナビゲーション シナリオに適しています。RT-X は、言語を通じて 5 つの異なるロボット本体を操作できます。これらのモデルは確かに重要な進歩ですが、複数の制限もあります。入力観測は事前に定義されていることが多く、(単一カメラ入力ビデオ ストリームなど)、新しい領域に合わせて効果的に微調整することが困難です。モデル 最大のバージョンは人々が使用できるものではありません (これは重要です)。

最近、カリフォルニア大学バークレー校、スタンフォード大学、カーネギーメロン大学、Google DeepMind の 18 人の研究者で構成される Octo モデル チームが、画期的な研究結果である Octo モデルを発表しました。このプロジェクトは上記の制限を効果的に克服します。

- 論文アドレス: https://arxiv.org/pdf/2405.12213

- オープンソース プロジェクト: https://octo-models.github.io/

- 彼らは、GRP が下流のロボット アプリケーションのインターフェイス多様化の問題により簡単に対処できるシステムを設計しました。

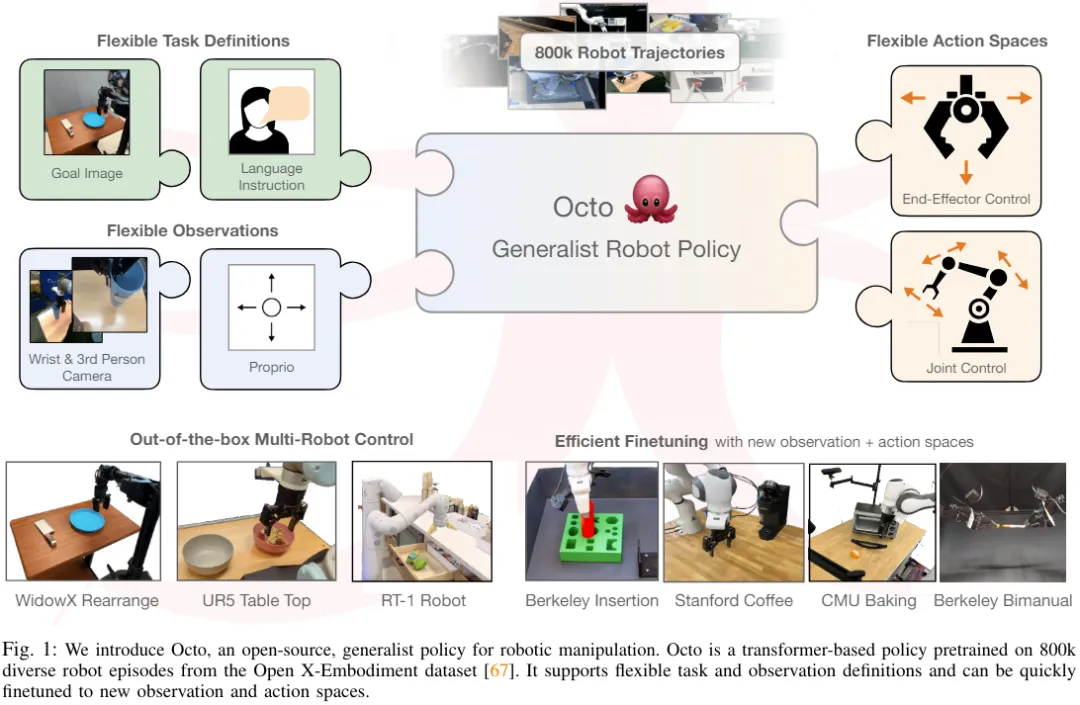

モデルの中核は、任意の入力トークン (観察とタスクに基づいて作成された) を出力トークン (その後、アクションにエンコード) にマッピングする Transformer アーキテクチャであり、このアーキテクチャは、さまざまなロボットおよびタスクのデータセットで使用できます。電車。このポリシーは、モデルに入力するトークンを変更するだけで、追加のトレーニングなしでさまざまなカメラ構成を受け入れたり、さまざまなロボットを制御したり、口頭コマンドやターゲット画像によってガイドしたりできます。

最も重要なことは、モデルは、異なるセンサー入力、動作空間、またはロボットの形態を備えた新しいロボット構成にも適応できることです。必要なのは、適切なアダプターを採用し、小さなターゲット ドメイン データ セットと少量のデータを使用することだけです。データを微調整するための予算を計算します。

それだけでなく、Octo はこれまでで最大のロボット操作データセット、Open X-Embodiment データセットからの 800,000 台のロボット デモンストレーションでも事前トレーニングされています。 Octo は、新しい観察およびアクション空間に合わせて効率的に微調整された初の GRP であるだけでなく、完全にオープンソースである初のジェネラリスト ロボット操作戦略 (トレーニング ワークフロー、モデル チェックポイント、およびデータ) でもあります。チームは論文の中で、結合された Octo コンポーネントのユニークで革新的な性質も強調しました。

Octoモデル

オープンソースのジェネラリストロボット戦略であるOctoがどのように構築されているかを見てみましょう。全体として、Octo は、さまざまな下流のロボット工学アプリケーションや研究プロジェクトで使用できる、柔軟で幅広く適用可能なジェネラリスト ロボット工学戦略となるように設計されています。

アーキテクチャ

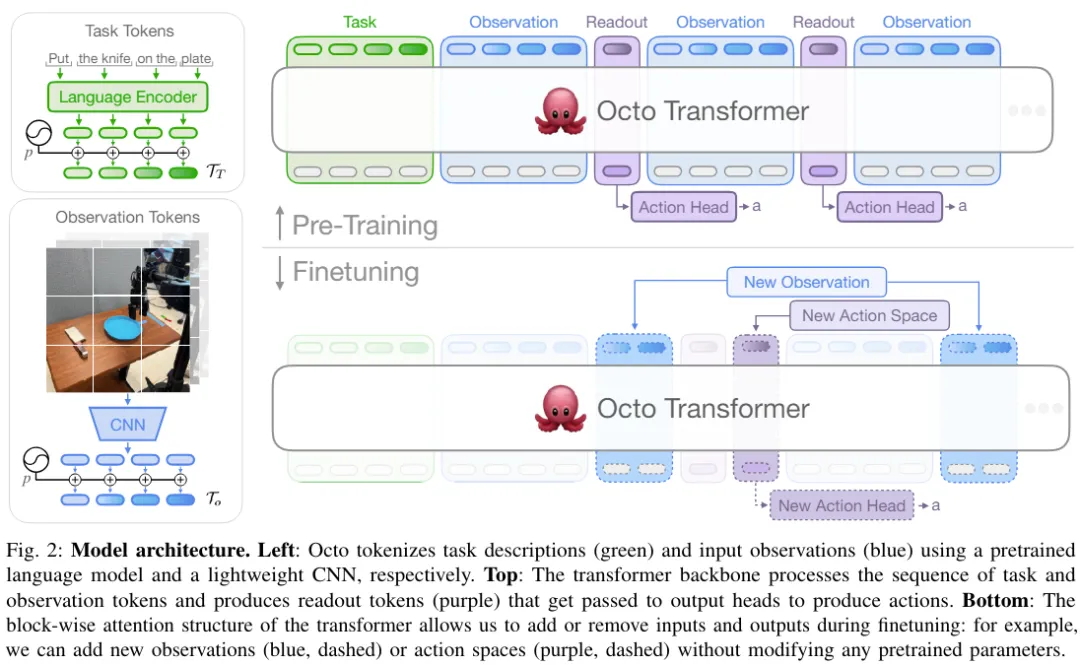

Octo のコアは、Transformer の戦略 π に基づいています。これには、入力トークナイザー、Transformer バックボーン ネットワーク、および読み取りヘッドという 3 つの主要な部分が含まれています。

図 2 に示すように、入力トークナイザーの機能は、言語命令、ターゲット、および観測シーケンスをトークンに変換することであり、Transformer バックボーンはこれらのトークンを処理して埋め込みを行い、読み出しヘッドが必要な出力を取得します。つまり行動です。

タスクと観察トークナイザー

タスク定義 (言語命令やターゲット画像など) と観察 (カメラビデオストリームなど) を一般的に使用されるトークン化された形式に変換するために、チームは目標を達成しました。トークナイザー:

言語入力の場合、最初にトークン化され、その後、事前にトレーニングされた Transformer を通じて、言語埋め込みトークン シーケンスに処理されます。具体的には、使用したモデルは t5-base (111M) です。

画像の観測とターゲットの場合、浅い畳み込みスタックを通じて処理され、一連の平坦化されたタイルに分割されます。

最後に、学習可能な位置埋め込みをタスクトークンと観察トークンに追加し、それらを特定の順序で配置することによって、Transformer の入力シーケンスが構築されます。

Transformer バックボーンと読み出しヘッド

入力を統合トークン シーケンスに処理した後、処理のために Transformer に渡すことができます。これは、観察とアクション シーケンスに基づいて Transformer ベースのポリシーをトレーニングするという以前の研究作業に似ています。

Octo のアテンション モードはブロックごとのマスキングです。観察トークンは、因果関係に従って、同じまたは前のタイム ステップからのトークンとタスク トークンにのみ注意を払うことができます。存在しない観測値に対応するトークンは完全にマスクされます (言語命令のないデータセットなど)。このモジュール設計により、微調整フェーズ中に観察やタスクを簡単に追加または削除できます。

これらの入力トークン モジュールに加えて、チームは学習された読み出しトークンも挿入しました。読み出しトークンは、以前の観察トークンとタスク トークンに注意を払いますが、観察トークンやタスク トークンには注意を払いません。したがって、読み出しトークンは内部埋め込みの読み取りと処理のみが可能ですが、内部埋め込みに影響を与えることはできません。読み出しトークンは BERT の [CLS] トークンと同様に機能し、これまでの一連の観測を埋め込んだコンパクトなベクトルとして機能します。読み取りトークンの埋め込みには、拡散処理を実装した軽量の「アクションヘッダー」が使用されます。このアクション ヘッダーは、複数の連続するアクションの「チャンク」を予測します。

この設計により、ユーザーはダウンストリームの微調整中に、新しいタスクと観測入力またはアクション出力ヘッダーをモデルに柔軟に追加できます。新しいタスク、観測値、または損失関数をダウンストリームに追加する場合、Transformer の事前トレーニングされた重みを全体として保持し、新しい位置埋め込み、新しい軽量エンコーダー、または仕様パラメーターの変更により必要な新しいヘッダーのみを追加できます。これは、画像入力が追加または削除された場合、またはタスク仕様が変更された場合に、事前トレーニング済みモデルの多数のコンポーネントの再初期化または再トレーニングが必要だった以前のアーキテクチャとは異なります。

Octo を真の「ジェネラリスト」モデルにするためには、この柔軟性が非常に重要です。Octo を微調整できれば、トレーニング前の段階で考えられるロボットのセンサーとアクションの構成をすべてカバーすることは不可能であるためです。チューニング ステージ その入力と出力により、ロボット工学コミュニティにとって多用途のツールになります。さらに、標準の Transformer バックボーンを使用したり、ビジュアル エンコーダと MLP 出力ヘッドを融合した以前のモデル設計では、モデル入力のタイプと順序が固定されていました。対照的に、Octo の観測やタスクを切り替える場合、モデルの大部分を再初期化する必要はありません。

トレーニング データ

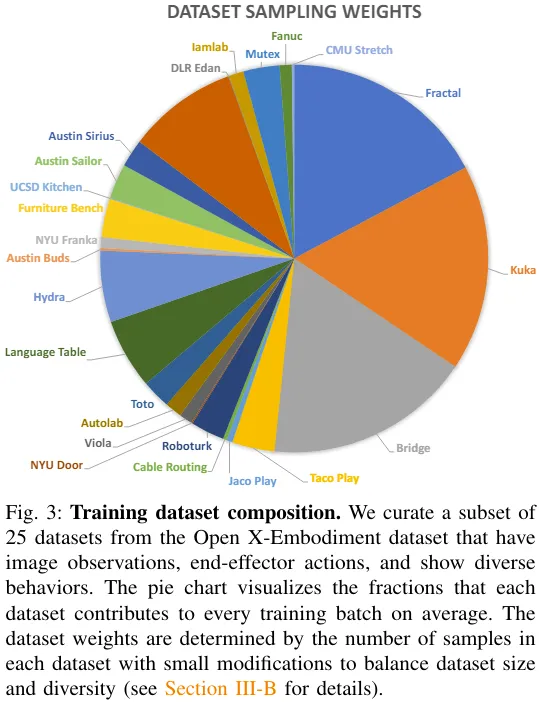

チームは、Open X-Embodiment から 25 個のデータセットの混合データセットを取得しました。図 3 にデータセットの構成を示します。

トレーニングの目的とトレーニングハードウェア構成の詳細については、元の論文を参照してください。

モデルのチェックポイントとコード

ここからがポイントです!チームは Octo の論文をリリースしただけでなく、以下を含むすべてのリソースを完全にオープンソース化しました:

- 事前トレーニングされた Octo チェックポイント。これには、2,700 万個のパラメータを持つ Octo-Small と 9,300 万個のパラメータを持つ Octo-Base が含まれます。

- JAX に基づいた Octo モデルの微調整スクリプト。

- JAX に基づいて、Open X-Embodiment データセットで Octo を事前トレーニングするためのモデル事前トレーニング ワークフロー。 Open X-Embodiment データ用のデータ ローダー。JAX および PyTorch と互換性があります。

実験

チームはまた、実験を通じてOctoの実証分析を実施し、基本的なロボットモデルとしてのパフォーマンスを多次元で評価しました:

- Octoを複数のロボットの制御に直接使用できますか?体を動かし、言語とターゲットタスクを解決しますか?

- Octo の重みは、新しいタスクやロボットのデータ効率の高い微調整をサポートする優れた初期化の基礎として機能しますか? また、Octo の重みは、スクラッチからトレーニングする方法や一般的に使用される事前トレーニングされた表現よりも優れていますか?

- ジェネラリストロボット戦略を構築する場合、Octo での設計上のどの決定が最も重要ですか?

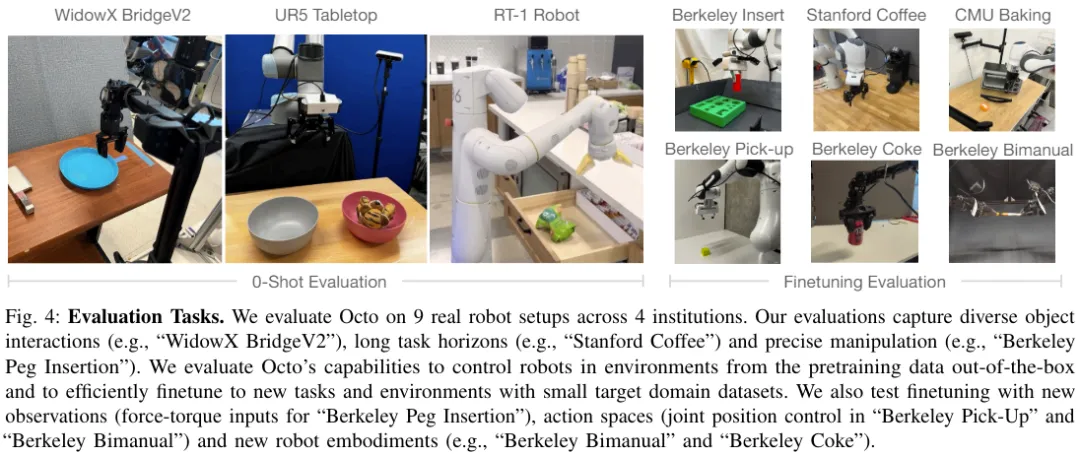

図 4 は、Octo を評価するための 9 つのタスクを示しています。

Octoを直接使用して複数のロボットを制御します

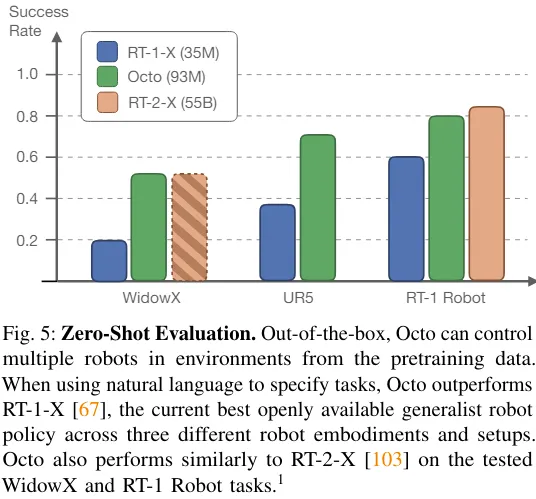

チームは、Octo、RT-1-X、およびRT-2-Xのゼロサンプル制御機能を比較しました。結果は次のとおりです。図5.

Octo の成功率は RT-1-X (3,500 万パラメータ) よりも 29% 高いことがわかります。 WidowX と RT-1 Robot の評価では、Octo のパフォーマンスは 550 億のパラメーターを備えた RT-2-X のパフォーマンスと同等です。

さらに、RT-1-X と RT-2-X は言語コマンドのみをサポートしますが、Octo はターゲット画像の条件付きもサポートします。チームはまた、WidowX タスクでは、言語に条件付けした場合よりもターゲット画像に条件付けした方が成功率が 25% 高いことも発見しました。これは、ターゲット画像がタスクの完了に関するより多くの情報を提供するためである可能性があります。

Octo はデータを効率的に使用して新しいフィールドに適応できます

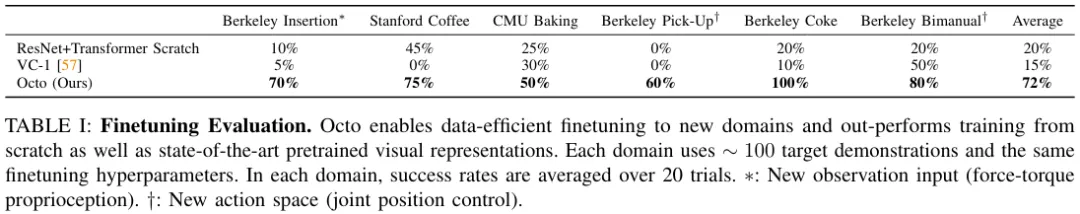

表 1 は、データ効率の高い微調整の実験結果を示しています。

Octo を微調整すると、最初からトレーニングしたり、事前トレーニングされた VC-1 重みを使用して事前トレーニングしたりするよりも良い結果が得られることがわかります。 6 つの評価設定全体で、2 位のベースラインに対する Octo の平均アドバンテージは 52% です。

そして、これらすべての評価タスクで、Octo を微調整するときに使用されたレシピとハイパーパラメーターはすべて同じであったことにも言及しなければなりません。これは、チームが非常に優れたデフォルト構成を見つけたことを示しています。

ジェネラリストロボットポリシートレーニングのための設計上の決定

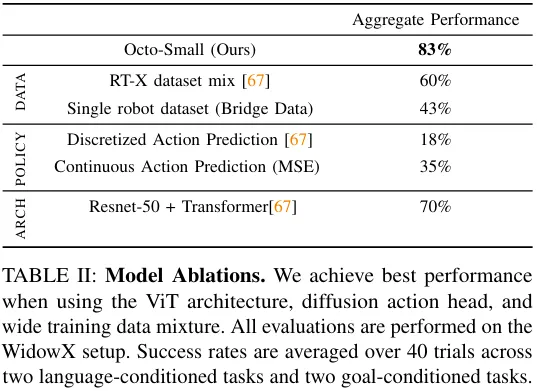

上記の結果は、Octoが実際にゼロショットマルチロボットコントローラーとして使用でき、ポリシー微調整の初期化ベースとしても使用できることを示しています。 。次に、チームは、さまざまな設計上の決定が Octo 戦略のパフォーマンスに与える影響を分析しました。具体的には、モデルのアーキテクチャ、トレーニング データ、トレーニングの目的、モデルのサイズといった側面に焦点を当てています。これを行うために、彼らはアブレーション研究を実施しました。

表 2 は、モデルのアーキテクチャ、トレーニング データ、トレーニング目標に関するアブレーション 研究の結果を示しています。

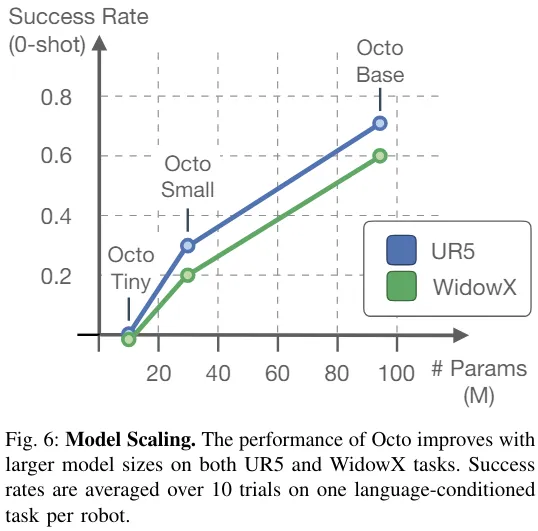

図 6 は、ゼロサンプルの成功率に対するモデル サイズの影響を示しています。モデルが大きいほど、視覚的なシーンの認識能力が優れていることがわかります。

全体的に、Octo のコンポーネントの有効性は証明されています。

以上が複数の形態とタスクに適応する、最も強力なオープンソースロボット学習システム「Octopus」が誕生の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1664

1664

14

14

1423

1423

52

52

1317

1317

25

25

1268

1268

29

29

1246

1246

24

24

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

オックスフォード大学の最新情報!ミッキー:2D画像を3D SOTAでマッチング! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

オックスフォード大学の最新情報!ミッキー:2D画像を3D SOTAでマッチング! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

前に書かれたプロジェクトのリンク: https://nianticlabs.github.io/mickey/ 2 枚の写真が与えられた場合、それらの写真間の対応関係を確立することで、それらの間のカメラのポーズを推定できます。通常、これらの対応は 2D 対 2D であり、推定されたポーズはスケール不定です。いつでもどこでもインスタント拡張現実などの一部のアプリケーションでは、スケール メトリクスの姿勢推定が必要なため、スケールを回復するために外部深度推定器に依存します。この論文では、3D カメラ空間でのメトリックの対応を予測できるキーポイント マッチング プロセスである MicKey を提案します。画像全体の 3D 座標マッチングを学習することで、相対的なメトリックを推測できるようになります。