テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

一度に38万語の入力に対応! Tencent Hunyuan が、Tencent Cloud を通じて企業および個人開発者に公開される 256,000 の長い記事モデルを開始

一度に38万語の入力に対応! Tencent Hunyuan が、Tencent Cloud を通じて企業および個人開発者に公開される 256,000 の長い記事モデルを開始

一度に38万語の入力に対応! Tencent Hunyuan が、Tencent Cloud を通じて企業および個人開発者に公開される 256,000 の長い記事モデルを開始

AI大型モデルテクノロジーは、高品質の生産性の開発を促進する重要な力となり、何千もの産業との統合において重要な役割を果たしています。 Tencent の Hunyuan 大型モデルは、ハイブリッド エキスパート モデル (MoE) 構造を採用することで、モデルを数兆パラメータ規模に拡張し、「脳」 の容量を増加させながら、予測パフォーマンスを向上させ、コストの向上を促進しました。推理力が減ります。一般的なモデルとして、Tencent Hunyuan は中国語のパフォーマンス、特にテキスト生成、数理論理学、マルチターン対話において業界をリードしています。

最近、Tencent Hunyuan Large Model は 256k長文モデルを正式にリリースし、Tencent Cloud を通じて大多数の企業と個人開発者に公開され、より広範囲のイノベーションとアプリケーションをサポートしています。 Tencent Hunyuan 256kモデルバージョンでは、380000文字を超える超長文を処理する能力があります。会話アプリケーションのシナリオでは、このモデルは、「覚えておいてください」より多くの会話コンテンツを作成し、「忘れてください」情報やその他の問題を効果的に回避できます。さらに、優れたコンテキスト分析機能を備えており、会話の参加者により正確で関連性の高いフィードバックを提供し、より多くの情報に基づいた意思決定を支援します。

また、このモデルバージョンは、長い文書の読解や大規模なデータ分析にも高いパフォーマンスを発揮します。金融、医療、教育、旅行などのプロフェッショナルの業務を強力にサポートし、業務効率を大幅に向上します。このモデルは推論パフォーマンスの面でも徹底的に最適化されており、ユーザーは Tencent Cloud などのプラットフォーム上の実際のアプリケーションでよりスムーズで効率的なエクスペリエンスを楽しむことができます。

「物忘れ」を軽減し、大型モデルをよりスマートにします

大型モデル製品では、会話要件の処理が中心的な機能です。ただし、長いテキスト処理機能の制限により、従来の大規模なモデルでは、会話中に「方向を失った」、または長さとして「記憶が欠けています」が表示される傾向があります。会話の量が増え、忘れる情報も増えます。

Tencent Hunyuan256kモデルは、この課題のために特別に最適化されています。高度な「Expert Hybrid」 (MoE) アーキテクチャを採用し、RoPE-NTKやFlash Attendant V2などの革新的なテクノロジーを組み込んでいます。それは持っています一般的な短いテキスト (4,000 文字未満) を効率的に処理すると同時に、長いテキスト処理の深さと幅においてブレークスルーを達成する機能。

現在、Tencent Hunyuan の大規模モデルはすでに 256k という超長時間のコンテキスト理解能力を備えており、厳密に処理した後、一度に処理される文字数は を超えています。」 干し草の山から針を見つける」このタスクでテストした結果、長いテキスト処理におけるモデルの精度は 99.99% に達し、これは国際的にも主導的な地位にあります。

継続的かつ安定した反復により、大規模モデル適用の効率が向上します

Tencent Hunyuan大型モデルは業界初のハイブリッドエキスパートモデル(MoE)を採用しています)の構造を持ち、その過程で数多くの自社開発技術が蓄積されてきました。前のバージョン 32K では、このモデルは市場の同様のオープンソース モデルを大幅に上回り、さまざまなアプリケーション シナリオで優れたパフォーマンスを実証しました。

新しい反復の後、Tencent Hunyuan256k一般分野のGSB評価では、以前のバージョンと比較して、勝率は50.72%です。同時に、Tencent Hunyuan 256kのトレーニングセットは、医療や金融分野などの複数の分野における長文データ、翻訳データ、マルチドキュメントQ&Aなどの高品質の注釈付きデータを統合し、モデルを作成します特に大量の長文データを頻繁に分析・処理する必要がある医療業界や金融業界などにおいて、より実践的で正確かつ効率的な業務支援を実現します。

たとえば、中央銀行が発行した財務レポートを Tencent Hunyuan256k モデルに入力すると、モデルはレポートの重要なポイントを迅速に洗練して要約することができ、驚くべき処理速度と精度を実現します。満足できるレベル。

推論パフォーマンスの最適化により、より強力な大規模モデル理解機能を実現 同時に、Tencent Hunyuan 256k は推論パフォーマンスが徹底的に最適化されています。 INT8精度モードでは、FP16精度と比較して、モデルのQPM(1秒あたりのクエリレート)は23.9%の大幅な向上を達成しましたが、最初のワード消費量はわずかでした5.7%増加しました。これらの改善により、実際のアプリケーションにおけるモデルの応答性と全体的な効率が大幅に向上しました。 「三国志」の分析を例に挙げると、Tencent Hunyuan 256k は、数十万語からなるこの古典的な小説を素早く読んで検索することができ、キーを正確に特定できるだけではありません。小説の登場人物や出来事、天気や登場人物の服装などの詳細な説明でも、正確な情報が得られます。 AI新しい生産性の重要なコンポーネントとして、大型モデルは産業のアップグレードを促進し、高品質の開発を達成する上で重要な役割を果たします。 Tencent Hunyuan 256k モデルの発売により、業界全体に新たな活力が注入され、より幅広いアプリケーションの可能性が開かれました。 現在、Tencent Hunyuan 256k長い記事モデルは、Tencent Cloud を通じて大部分の企業と個人開発者に公開されており、ユーザーは 標準バージョン256kの長い記事にアクセスできます。モデルが入ります。これにより、より多くの開発者とユーザーが Tencent の Hunyuan モデルの強力な機能に簡単にアクセスして使用できるようになり、あらゆる階層にインテリジェントなソリューションを提供し、より革新的なアプリケーション シナリオの実現を促進します。

以上が一度に38万語の入力に対応! Tencent Hunyuan が、Tencent Cloud を通じて企業および個人開発者に公開される 256,000 の長い記事モデルを開始の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1667

1667

14

14

1426

1426

52

52

1328

1328

25

25

1273

1273

29

29

1255

1255

24

24

Tencent Hunyuanの大型モデルが大幅値下げされました! Hunyuan-lite は今後無料です

Jun 02, 2024 pm 08:07 PM

Tencent Hunyuanの大型モデルが大幅値下げされました! Hunyuan-lite は今後無料です

Jun 02, 2024 pm 08:07 PM

5月22日、テンセントクラウドは新たな大規模モデルアップグレード計画を発表した。主要モデルの 1 つである Hunyuan-lite モデルは、API 入出力の合計長が現在の 4k から 256k にアップグレードされる予定で、価格は 0.008 元/千トークンから完全無料に調整されます。渾源標準 API の入力価格は 0.01 元/千トークンから 0.0045 元/千トークンに 55% 下落し、API 出力価格は 0.01 元/千トークンから 0.005 元/千トークンに下落し、55% 減少しました。 50%。新しく発売されたHunyuan-standard-256kは38万文字を超える超長文を処理する能力があり、API入力価格は0.015元/千トークンに値下げされた。

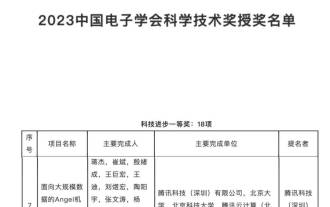

科学技術進歩賞の最優秀賞の受賞: Tencent は、数兆のパラメータを持つ大規模モデルのトレーニングの問題を解決しました

Mar 27, 2024 pm 09:41 PM

科学技術進歩賞の最優秀賞の受賞: Tencent は、数兆のパラメータを持つ大規模モデルのトレーニングの問題を解決しました

Mar 27, 2024 pm 09:41 PM

中国電子協会の 2023 年科学技術賞の受賞者リストが発表されましたが、今回はおなじみの人物、テンセントの Angel 機械学習プラットフォームを発見しました。大規模モデルの開発が急速に進んでいる現在の時代において、科学技術賞は機械学習プラットフォームの研究および応用プロジェクトに授与され、モデル トレーニング プラットフォームの価値と重要性が全面的に認められています。科学技術賞は、機械学習プラットフォーム プロジェクトの研究と応用を表彰するもので、特に大規模モデルの急速な開発という状況において、モデル トレーニング プラットフォームの価値と重要性を十分に認識しています。ディープラーニングの台頭により、大手企業は人工知能技術の開発における機械学習プラットフォームの重要性を認識し始めています。 Google、Microsoft、Nvidia などの企業は、加速するために独自の機械学習プラットフォームを立ち上げています。

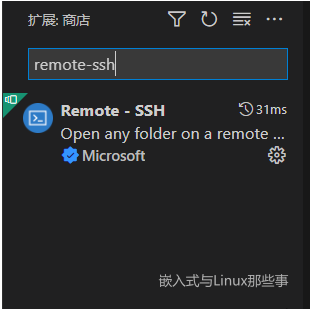

vscode を使用して Linux カーネルをリモートでデバッグする

Feb 05, 2024 pm 12:30 PM

vscode を使用して Linux カーネルをリモートでデバッグする

Feb 05, 2024 pm 12:30 PM

はじめに 前回の記事では、QEMU+GDB を使用して Linux カーネルをデバッグする方法を紹介しました。ただし、GDB を直接使用してコードをデバッグしたり表示したりするのはあまり便利ではない場合があるため、このような重要な機会に vscode のアーティファクトが失われることがあります。この記事では、vscode を使用してカーネルをリモートでデバッグする方法を紹介します。この記事の環境:Windows 10 vs Code Ubuntu 20.04. 私は個人的に Tencent Cloud Server を使用しているので、仮想マシンをインストールするプロセスを保存します。 vscode 設定から直接開始します。 vscode プラグインのリモート ssh をインストールする プラグイン ライブラリで Remote-SSH プラグインを見つけてインストールします。インストールが完了すると、右側のツールバーに追加機能が表示されるので、F1 キーを押してペアを呼び出します。

GPT ストアはオープンすることさえできません。なぜこの国内プラットフォームがこのような道を歩むのでしょうか? ?

Apr 19, 2024 pm 09:30 PM

GPT ストアはオープンすることさえできません。なぜこの国内プラットフォームがこのような道を歩むのでしょうか? ?

Apr 19, 2024 pm 09:30 PM

この男性は 1,000 を超える大型モデルを接続し、シームレスに接続して切り替えることができることに注目してください。最近、ビジュアル AI ワークフローが開始されました。直感的なドラッグ アンド ドロップ インターフェイスを提供し、ドラッグ、プル、ドラッグして、無限のキャンバス上に独自のワークフローを配置できます。ことわざにあるように、戦争にはスピードがかかります。Qubit は、この AIWorkflow がオンラインになってから 48 時間以内に、ユーザーがすでに 100 ノードを超える個人ワークフローを構成したと聞きました。早速ですが、今日私が話したいのは、LLMOps 企業である Dify とその CEO の Zhang Luyu についてです。 Zhang Luyu は Dify の創設者でもあります。ビジネスに入社する前は、インターネット業界で 11 年の経験がありました。私は製品設計に携わっており、プロジェクト管理を理解しており、SaaS について独自の洞察を持っています。その後彼は

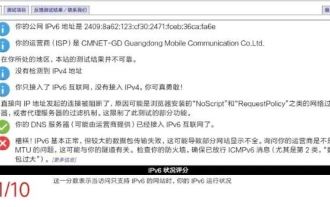

ホーム ルーターで IPv6 を有効にする必要がありますか? 「必見: ホーム ルーターで IPv6 を有効にするメリット」

Feb 07, 2024 am 09:03 AM

ホーム ルーターで IPv6 を有効にする必要がありますか? 「必見: ホーム ルーターで IPv6 を有効にするメリット」

Feb 07, 2024 am 09:03 AM

IPv4 は枯渇しており、IPv6 が早急に必要とされていますが、このアップグレードは単なる消極的な変更でしょうか?一般の人にとって IPv6 は何を意味しますか? IPv6 の包括的なアップグレードはネットワークにどの程度の変化をもたらすでしょうか? 01 大規模な IPv6 移行が実現しようとしている 最近、工業情報化省総局と国家ラジオテレビ総局は、インターネット TV の IPv6 化を促進するための要件を提案する通知を発行しました。サービス。 China Mobile、Alibaba Cloud、Tencent Cloud、Baidu Cloud、JD Cloud、Huawei Cloud、Wangsu Technology は、インターネット TV ビジネスに関連するコンテンツ配信ネットワーク (CDN) の IPv6 変換を実行する必要があります。 2020 年末までに、IPv6 プロトコルに基づくインターネット TV サービスの機能は IPv4 の 85% に達すると予想されます。

Tencent Hunyuan がモデル マトリックスをアップグレードし、256,000 の長い記事モデルをクラウド上で開始

Jun 01, 2024 pm 01:46 PM

Tencent Hunyuan がモデル マトリックスをアップグレードし、256,000 の長い記事モデルをクラウド上で開始

Jun 01, 2024 pm 01:46 PM

大型モデルの実装が加速しており、「産業上の実用性」が開発のコンセンサスとなっています。 2024 年 5 月 17 日、Tencent Cloud Generative AI Industry Application Summit が北京で開催され、大規模モデル開発とアプリケーション製品における一連の進歩が発表されました。 Tencent の Hunyuan ラージ モデル機能はアップグレードを続けており、モデル hunyuan-pro、hunyuan-standard、および hunyuan-lite の複数のバージョンが Tencent Cloud を通じて外部に公開されており、さまざまなシナリオで企業顧客や開発者のモデル ニーズを満たし、実装されています。最適なコスト効率の高いモデル ソリューション。 Tencent Cloud は、大規模モデル用のナレッジ エンジン、画像作成エンジン、ビデオ作成エンジンの 3 つの主要ツールをリリースし、大規模モデル時代のネイティブ ツール チェーンを作成し、PaaS サービスを通じてデータ アクセス、モデルの微調整、およびアプリケーション開発プロセスを簡素化します。企業を助けるために

WeChatリンクを作成するにはどうすればよいですか? WeChat リンクの作成方法を共有する

Mar 09, 2024 pm 09:37 PM

WeChatリンクを作成するにはどうすればよいですか? WeChat リンクの作成方法を共有する

Mar 09, 2024 pm 09:37 PM

WeChat は人気のあるソーシャル ソフトウェアとして、人々にインスタント メッセージングの利便性を提供するだけでなく、ユーザーのソーシャル エクスペリエンスを豊かにするさまざまな機能を統合しています。その中でも、WeChat リンクの作成と共有は WeChat 機能の重要な部分です。 WeChat リンクの作成は、主に WeChat パブリック プラットフォームとその関連機能、およびサードパーティ ツールに依存しています。 WeChat リンクを作成する一般的な方法をいくつか次に示します。 WeChatリンクを作成するにはどうすればよいですか? WeChat リンクを作成する最初の方法は、WeChat パブリック プラットフォームの画像エディターとテキスト エディターを使用することです。 1. WeChat パブリック プラットフォームにログインし、画像とテキストの編集インターフェイスに入ります。 2. エディターでテキストまたは画像を追加し、リンク ボタンを使用して必要なリンクを追加します。この方法は、単純なテキストまたは画像のリンクに適しています。 2 番目の方法は HTML コードを使用することです

ワードプレスの登録は必要ですか?

Apr 16, 2024 pm 12:07 PM

ワードプレスの登録は必要ですか?

Apr 16, 2024 pm 12:07 PM

WordPressは登録が必要です。私の国の「インターネットセキュリティ管理措置」によれば、国内でインターネット情報サービスを提供するウェブサイトは、WordPress を含め、地方のインターネット情報局に登録する必要があります。登録プロセスには、サービスプロバイダーの選択、情報の準備、申請の送信、審査と公開、登録番号の取得などのステップが含まれます。申請の利点には、法令順守、信頼性の向上、アクセス要件の満たし、通常のアクセスの確保などが含まれます。申請情報は真実かつ有効である必要があり、申請後は定期的に更新する必要があります。