テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

シンプルかつユニバーサル: Visual Basic ネットワークの 3 倍のロスレス トレーニング アクセラレーション、Tsinghua EfficientTrain++ が TPAMI 2024 に選ばれました

シンプルかつユニバーサル: Visual Basic ネットワークの 3 倍のロスレス トレーニング アクセラレーション、Tsinghua EfficientTrain++ が TPAMI 2024 に選ばれました

シンプルかつユニバーサル: Visual Basic ネットワークの 3 倍のロスレス トレーニング アクセラレーション、Tsinghua EfficientTrain++ が TPAMI 2024 に選ばれました

このディスカッション ペーパーの著者である Wang Yulin は、清華大学オートメーション学科の 2019 年度直接博士課程の学生であり、学者の Wu Cheng と准教授の Huang Gao の下で学びました。彼の主な研究方向は、効率的な深層学習です。コンピュータビジョンなど彼は、TPAMI、NeurIPS、ICLR、ICCV、CVPR、ECCV などのジャーナルや会議で筆頭著者としてディスカッション論文を発表し、Baidu Scholarship、Microsoft Scholar、CCF-CV Academic Emerging Award、ByteDance Scholarship などを受賞しています。名誉。個人ホームページ:wyl.cool。

この記事は、IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI) に採択されたばかりの論文「EfficientTrain++: Generalized Curriculum Learning for Efficient Visual Backbone Training」を中心に紹介します。

- ペーパーリンク: https://arxiv.org/pdf/2405.08768

- コードと事前トレーニングされたモデルはオープンソースです: https://github.com/LeapLabTHU /EfficientTrain

- 会議バージョン論文 (ICCV 2023): https://arxiv.org/pdf/2211.09703

近年、「スケーリング」はコンピューター ビジョン研究の主役の 1 つとなっています。 。モデルサイズや学習データ規模の増大、学習アルゴリズムの高度化、正則化やデータ拡張などの技術の応用の広がりに伴い、大規模学習で得られるビジュアルベーシックネットワーク(ImageNet1Kで学習されたVision TransformerやMAEなど)は、 22K 、DINOv2 など) は、視覚認識、ターゲット検出、セマンティック セグメンテーションなどの多くの重要な視覚タスクで驚くべきパフォーマンスを達成しました。

しかし、「スケーリング」は多くの場合、法外な高いモデルトレーニングオーバーヘッドをもたらし、基本的なビジョンモデルのさらなる開発と産業応用を著しく妨げます。

この問題を解決するために、清華大学の研究チームは、一般化されたカリキュラム学習アルゴリズム EfficientTrain++ を提案しました。中心的なアイデアは、「簡単なデータから難しいデータまでスクリーニングして使用し、モデルを段階的にトレーニングする」という従来のコース学習パラダイムを、「データの次元をフィルタリングせず、常にすべてのトレーニング データを使用するが、トレーニング プロセス中に徐々に各特徴を明らかにする」に推進することです。 「各データサンプルの簡単なものから難しいものまでの特徴やパターン(パターン)」

EfficientTrain++ にはいくつかの重要なハイライトがあります:

- Visual Basic ネットワークのプラグ アンド プレイ実装 1.5-3.0 倍のロスレス トレーニング アクセラレーション。上流モデルも下流モデルもパフォーマンスが失われることはありません。測定された速度は理論上の結果と一致しています。

- さまざまなトレーニング データ サイズ に普遍的に適用できます (ImageNet-1K/22K など、22K の効果はさらに明白です)。教師あり学習と自己教師あり学習 (MAE など) によく使用されます。さまざまなトレーニング コストに共通です (たとえば、0 ~ 300 またはそれ以上のエポックに対応します)。

- ViT、ConvNet、その他のネットワーク構造 で一般的に使用されます (この記事では、さまざまなサイズとタイプの 20 を超えるモデルがテストされており、それらは一貫性があり、効果的です)。

- 小規模なモデルの場合、トレーニングの高速化に加えて、パフォーマンスも大幅に向上させることができます (たとえば、追加情報の助けや追加のトレーニング オーバーヘッドなしで、ImageNet-1K で 81.3% DeiT-S が取得されました 、オリジナルの Swin-Tiny に相当します)。

- 私たちは、2つの困難な一般的な実際の状況のために、特化した実際の効率最適化技術を開発しました: 1) CPU/ハードディスクの能力が十分ではなく、データの前処理効率がGPUに追いつけない; 2) 64 個以上の GPU を使用して ImageNet-22K で大規模なモデルをトレーニングするなど、大規模な並列トレーニング。

次に、研究の詳細を見てみましょう。

1つ。研究動機

近年、大規模基礎モデルの精力的な開発により、人工知能とディープラーニングの進歩が促進されています。コンピューター ビジョンの分野では、Vision Transformer (ViT)、CLIP、SAM、DINOv2 などの代表的な研究により、ニューラル ネットワークとトレーニング データのサイズをスケールアップすると、認知、検出、セグメンテーションなどの重要な視覚タスクが大幅に拡張できることが証明されています。 . パフォーマンスの限界。

ただし、大規模な基本モデルではトレーニングのオーバーヘッドが高くなることが多く、図 1 に 2 つの典型的な例を示します。 8 つの NVIDIA V100 以上のパフォーマンスの GPU を例にとると、GPT-3 と ViT-G の 1 つのトレーニング セッションを完了するのに数年、さらには数十年かかることもあります。このような高額なトレーニング費用は学界と産業界の両方にとって負担が困難な巨額の費用であり、多くの場合、深層学習の進歩を促進するために大量のリソースを消費しているのは少数の高レベルの機関だけです。したがって、解決すべき緊急の課題は、大規模な深層学習モデルの学習効率を効果的に向上させるにはどうすればよいかということです。

図 1 例: 大規模な深層学習基本モデルの高いトレーニング オーバーヘッド

図 1 例: 大規模な深層学習基本モデルの高いトレーニング オーバーヘッド

コンピューター ビジョン モデルの場合、図 2 に示すように、古典的なアイデアはカリキュラム学習、つまり人間を模倣することです。モデルのトレーニング プロセスでは、「最も単純な」トレーニング データから始めて、簡単なデータから難しいデータまで徐々に導入します。

図 2 古典的なカリキュラム学習パラダイム (画像出典:「カリキュラム学習に関する調査」、TPAMI'22)

図 2 古典的なカリキュラム学習パラダイム (画像出典:「カリキュラム学習に関する調査」、TPAMI'22)

しかし、自然な動機にもかかわらず、カリキュラム学習は訓練のために大規模に適用されていません。視覚的な基礎 このモデルが一般的な方法である主な理由は、図 3 に示すように、2 つの主要なボトルネックがあることです。まず、効果的な研修カリキュラム(カリキュラム)を設計するのは簡単ではありません。 「単純な」サンプルと「難しい」サンプルを区別するには、多くの場合、追加の事前トレーニング モデルの支援、より複雑な AutoML アルゴリズムの設計、強化学習の導入などが必要となり、汎用性が低くなります。第二に、コース学習のモデル化自体にやや無理があります。自然分布の視覚データは、多くの場合、高度な多様性を持っています。その例を以下の図 3 に示します (ImageNet からランダムに選択されたオウムの写真)。モデルのトレーニング データには、異なる動きをする多数のオウム、異なる距離にあるオウムが含まれています。カメラ、視点や背景の異なるオウム、オウムと人や物との多様なインタラクションなど、多様なデータを「簡単」「難しい」という一元的な指標だけで区別するのは、実は比較的乱暴な方法です。 」と突飛なモデリング手法。

図 3 ビジュアルベーシックモデルのトレーニングにおけるコース学習の大規模な適用を妨げる 2 つの主要なボトルネック

図 3 ビジュアルベーシックモデルのトレーニングにおけるコース学習の大規模な適用を妨げる 2 つの主要なボトルネック

2.方法の紹介

この記事は、上記の課題に触発されて、一般化されたカリキュラム学習パラダイムを提案します。その中心となるアイデアは、「簡単なデータから難しいデータまでスクリーニングして使用し、徐々にモデルをトレーニングする」です。従来のコース学習パラダイムは拡張されています。 「データ次元のフィルタリングはなく、すべてのトレーニング データが常に使用されますが、各データ サンプルの簡単なものから難しいものまでの特性やパターンがトレーニング プロセス中に徐々に明らかになります」。これにより、図 4 に示すように、データ スクリーニング パラダイムは排除されます。

図 4 従来のカリキュラム学習 (サンプル次元) と一般化されたカリキュラム学習 (特徴次元)

図 4 従来のカリキュラム学習 (サンプル次元) と一般化されたカリキュラム学習 (特徴次元)

このパラダイムの提案は、主に興味深い現象に基づいています: 自然な視覚モデルのトレーニング プロセスにおいてただし、モデルはいつでもデータに含まれるすべての情報を取得できますが、モデルは常に、データに含まれるいくつかのより単純な判別特徴 (パターン) を認識することを自然に学習し、その後、これに関するより難しい判別式を徐々に認識することを学習します。基本的な機能。さらに、この規則は比較的普遍的であり、「比較的単純な」判別特徴は周波数領域と空間領域の両方で簡単に見つけることができます。この論文では、以下に説明するように、上記の発見を実証するために一連の興味深い実験を計画しました。 周波数領域の観点から見ると、モデルの「低周波数特徴」は「比較的単純」です。図 5 では、この記事の著者が標準の ImageNet-1K トレーニング データを使用して DeiT-S モデルをトレーニングし、異なる帯域幅のローパス フィルターを使用して検証セットをフィルター処理し、検証画像の低周波成分のみを保持しました。これに基づいて、トレーニング プロセス中に得られたローパス フィルター処理された検証データに対する DeiT-S の精度の曲線が図 5 の右側に示されています。 興味深い現象が見られます。トレーニングの初期段階では、ローパス フィルター処理された検証データのみを使用しても精度は大幅に低下せず、曲線と通常の検証セットの精度の間の分離点はフィルター帯域幅とともに増加します。増加し、徐々に右に移動します。この現象は、モデルがトレーニング データの低周波部分と高周波部分に常にアクセスしているにもかかわらず、その学習プロセスは自然に低周波情報のみに焦点を当てることから始まり、高周波の特徴を識別する能力が徐々に獲得されることを示しています。トレーニングの後半で (この現象についての詳細な証拠については、原文を参照してください)。 この発見は興味深い疑問を引き起こします:モデルは最初に低周波情報を視覚的に入力し、その後徐々に高周波情報を導入しますか? 図 6 は、トレーニング プロセスの残りの部分を変更せずに、特定の長さの初期トレーニング フェーズ中にのみトレーニング データに対してローパス フィルター処理を実行するというアイデアを調査しています。この結果から、最終的なパフォーマンスの向上は限られているものの、興味深いことに、かなりの期間にわたって低周波成分のみがモデルに提供された場合でも、モデルの最終的な精度が大幅に維持されることがわかります。これは、「モデルは主にトレーニングの初期段階で低周波の特徴を識別する学習に焦点を当てている」という図 5 の観察とも一致します。 この発見は、この記事の著者にトレーニングの効率について考えるきっかけを与えました。モデルはトレーニングの初期段階でデータ内の低周波成分のみを必要とし、低周波成分には元のデータよりも少ない情報が含まれているためです。 、モデルは、より少ない計算コストで低周波数成分のみから効率的に学習するよりも速い速度で元の入力を処理できますか? 実際、このアイデアは完全に実現可能です。図 7 の左側に示すように、この記事の著者は、画像のフーリエ スペクトルにクロッピング操作を導入して、低周波部分を切り取ってピクセル空間にマッピングし直します。この低周波トリミング操作では、画像入力のサイズを削減しながらすべての低周波情報を正確に保存するため、入力から学習するモデルの計算コストを大幅に削減できます。 この低頻度クロッピング操作を使用してトレーニングの初期段階でモデル入力を処理すると、全体のトレーニング コストを大幅に節約できますが、それでもパフォーマンスはほとんど低下しません。これは、モデルの学習に必要な情報がすべて含まれているためです。最終モデルの実験結果を図 7 の右下隅に示します。 周波数領域の操作に加えて、空間領域変換の観点から、モデルは次のようにも見られます。 「比較的シンプルな」機能の条件。たとえば、強力なデータ強調や歪み処理を受けていない生の視覚入力に含まれる自然な画像情報は、多くの場合、モデルにとって「単純」であり、実世界の分布から派生しているため、モデルの学習が容易です。データ拡張などの前処理技術によって導入される情報、不変性などは、多くの場合、モデルの学習が困難です (典型的な例を図 8 の左側に示します)。 実際、既存の研究では、データ拡張が主にトレーニングの後期段階で役割を果たすことも観察されています (「拡張に適した重み共有による自動拡張の改善」、NeurIPS’20 など)。 この次元では、一般化されたコース学習のパラダイムを達成するには、データ拡張の強度を変更するだけで、トレーニング データで学習しやすい自然な画像情報のみをモデルに提供するだけで簡単に達成できます。トレーニングの初期段階。図 8 の右側は、代表的な例として RandAugment を使用してこのアイデアを示しています。RandAugment には、一連の一般的な空間データ強調変換 (ランダムな回転、シャープネスの変更、アフィン変換、露出の変更など) が含まれています。 弱いデータ拡張から開始してモデルをトレーニングすると、モデルの最終パフォーマンスを効果的に向上させることができ、この手法は低周波数クロッピングと互換性があることがわかります。 ここまで、この記事では、一般化されたコースの中核となるフレームワークと前提を提案してきました。周波数領域と空間領域における 2 つの重要な現象は、一般化されたコース学習の合理性と有効性を証明しています。これに基づいて、この文書はさらに以下に挙げる一連の体系的な作業を完了します。スペースの制限があるため、研究の詳細については元の論文を参照してください。 この記事で最終的に得られた EfficientTrain++ の一般化されたコース学習計画を図 9 に示します。 EfficientTrain++ は、モデル トレーニングの合計コンピューティング オーバーヘッドの消費パーセンテージに基づいて、周波数領域の低周波数クロッピングの帯域幅と空間領域データ拡張の強度を動的に調整します。 プラグアンドプレイ手法として、EfficientTrain++ は、ハイパーパラメーターの調整や検索を行うことなく、さまざまなビジュアルベーシックネットワークや多様なモデルトレーニングシナリオに直接適用でき、その効果は比較的安定していることに注目する価値があります。 。 プラグアンドプレイ手法として、EfficientTrain++ は、基本的にパフォーマンスを低下または向上させることなく、ImageNet-1K 上でさまざまなビジュアルベーシックネットワークの実際のトレーニング オーバーヘッドを約 1.5 倍削減します。 EfficientTrain++ のゲインは、異なるトレーニング オーバーヘッド バジェットに対して普遍的であり、厳密に同じパフォーマンスの下では、DeiT/Swin のパフォーマンスが向上します。 ImageNet 上 -1K でのトレーニング加速率は約 2 ~ 3 倍です。 EfficientTrain++ は、ImageNet-22k 上で 2 ~ 3 倍のパフォーマンスのロスレス事前トレーニング アクセラレーションを達成できます。 小規模なモデルの場合、EfficientTrain++ は大幅なパフォーマンス上限の向上を達成できます。 EfficientTrain++ は、自己教師あり学習アルゴリズム (MAE など) にも効果的です。 EfficientTrain++ トレーニングされたモデルは、ターゲット検出、インスタンス セグメンテーション、セマンティック セグメンテーションなどの下流タスクでもパフォーマンスを失いません。  図 5 周波数領域の観点から見ると、モデルは自然に低周波の特徴を最初に識別することを学習する傾向があります

図 5 周波数領域の観点から見ると、モデルは自然に低周波の特徴を最初に識別することを学習する傾向があります 図 6 初期トレーニングの長期間にわたってモデルに低周波成分のみを提供しても、最終的なパフォーマンスには大きな影響はありません

図 6 初期トレーニングの長期間にわたってモデルに低周波成分のみを提供しても、最終的なパフォーマンスには大きな影響はありません 図 7 低周波クロッピング: 低周波情報のみからモデルを効率的に学習させる

図 7 低周波クロッピング: 低周波情報のみからモデルを効率的に学習させる 図 8 空域の観点からモデルの「学習しやすい」特徴を探す: データ強化の観点

図 8 空域の観点からモデルの「学習しやすい」特徴を探す: データ強化の観点

図 9 統合および統合された一般化されたコース学習計画: EfficientTrain++

図 9 統合および統合された一般化されたコース学習計画: EfficientTrain++ III.実験結果

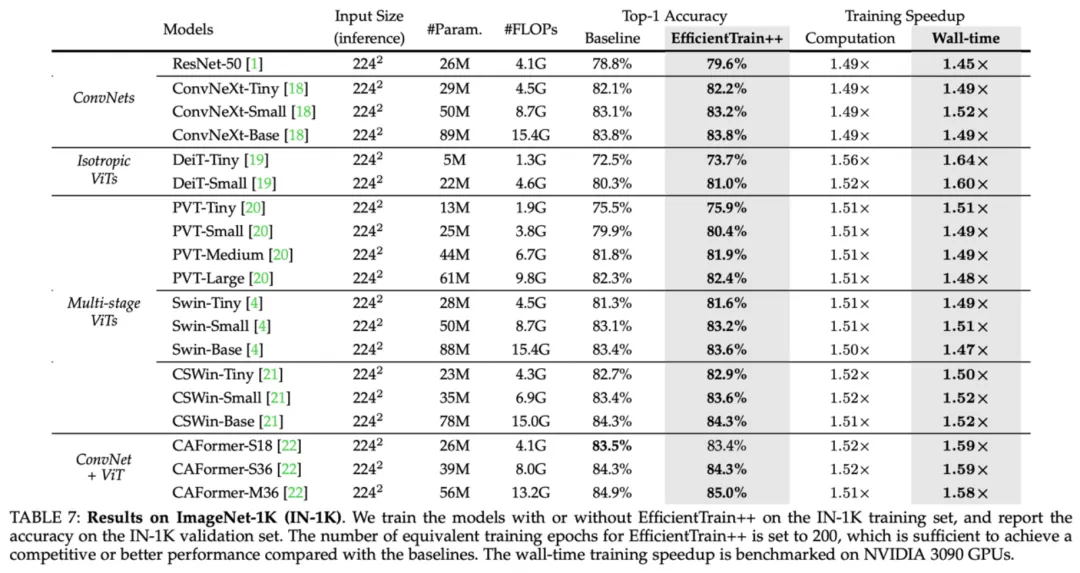

図 10 ImageNet-1K の実験結果: さまざまなビジュアル ベーシック ネットワークでの EfficientTrain++ のパフォーマンス

図 10 ImageNet-1K の実験結果: さまざまなビジュアル ベーシック ネットワークでの EfficientTrain++ のパフォーマンス 図 11 ImageNet-1K の実験結果: さまざまなトレーニング オーバーヘッド バジェットの下での EfficientTrain++ のパフォーマンス

図 11 ImageNet-1K の実験結果: さまざまなトレーニング オーバーヘッド バジェットの下での EfficientTrain++ のパフォーマンス  図 12 ImageNet-22K の実験結果: 大規模なトレーニング データに対する EfficientTrain++ のパフォーマンス

図 12 ImageNet-22K の実験結果: 大規模なトレーニング データに対する EfficientTrain++ のパフォーマンス 図 13 ImageNet-1K の実験結果: EfficientTrain++ は、より小さいモデルのパフォーマンスの上限を大幅に改善できます

図 13 ImageNet-1K の実験結果: EfficientTrain++ は、より小さいモデルのパフォーマンスの上限を大幅に改善できます  図 14 EfficientTrain++ は自己教師あり学習 (MAE など) に適用可能

図 14 EfficientTrain++ は自己教師あり学習 (MAE など) に適用可能 図15 COCOターゲット検出、COCOインスタンスセグメンテーション、ADE20Kセマンティックセグメンテーションの実験結果

図15 COCOターゲット検出、COCOインスタンスセグメンテーション、ADE20Kセマンティックセグメンテーションの実験結果

以上がシンプルかつユニバーサル: Visual Basic ネットワークの 3 倍のロスレス トレーニング アクセラレーション、Tsinghua EfficientTrain++ が TPAMI 2024 に選ばれましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1676

1676

14

14

1429

1429

52

52

1333

1333

25

25

1278

1278

29

29

1257

1257

24

24

WordPress Cookieを設定、取得、削除する方法(専門家のように)

May 12, 2025 pm 08:57 PM

WordPress Cookieを設定、取得、削除する方法(専門家のように)

May 12, 2025 pm 08:57 PM

WordPress WebサイトでCookieの使用方法を知りたいですか? Cookieは、ユーザーのブラウザに一時情報を保存するための便利なツールです。この情報を使用して、パーソナライズと行動ターゲティングを通じてユーザーエクスペリエンスを強化できます。この究極のガイドでは、プロフェッショナルのようにWordPressCookiesを設定、取得、削除する方法を紹介します。注:これは高度なチュートリアルです。 HTML、CSS、WordPress Webサイト、PHPに習熟する必要があります。クッキーとは何ですか?ユーザーがWebサイトにアクセスすると、Cookieが作成および保存されます。

2025 HUOBI APKV10.50.0ダウンロードガイドのダウンロード方法

May 12, 2025 pm 08:48 PM

2025 HUOBI APKV10.50.0ダウンロードガイドのダウンロード方法

May 12, 2025 pm 08:48 PM

Huobi APKV10.50.0ダウンロードガイド:1。記事の直接リンクをクリックします。 2.正しいダウンロードパッケージを選択します。 3。登録情報を入力します。 4. Huobi取引プロセスを開始します。

2025 HUOBI APKV10.50.0のダウンロードアドレス

May 12, 2025 pm 08:42 PM

2025 HUOBI APKV10.50.0のダウンロードアドレス

May 12, 2025 pm 08:42 PM

Huobi APKV10.50.0ダウンロードガイド:1。記事の直接リンクをクリックします。 2.正しいダウンロードパッケージを選択します。 3。登録情報を入力します。 4. Huobi取引プロセスを開始します。

2025 HUOBI APKV10.50.0インストール方法APKガイド

May 12, 2025 pm 08:27 PM

2025 HUOBI APKV10.50.0インストール方法APKガイド

May 12, 2025 pm 08:27 PM

Huobi APKV10.50.0ダウンロードガイド:1。記事の直接リンクをクリックします。 2.正しいダウンロードパッケージを選択します。 3。登録情報を入力します。 4. Huobi取引プロセスを開始します。

2025 HUOBI APKV10.50.0のダウンロードWebサイト

May 12, 2025 pm 08:39 PM

2025 HUOBI APKV10.50.0のダウンロードWebサイト

May 12, 2025 pm 08:39 PM

Huobi APKV10.50.0ダウンロードガイド:1。記事の直接リンクをクリックします。 2.正しいダウンロードパッケージを選択します。 3。登録情報を入力します。 4. Huobi取引プロセスを開始します。

トップ10のデジタル通貨交換アプリの最新のランキングがトップ10のデジタル通貨交換アプリを推奨しました

May 12, 2025 pm 08:15 PM

トップ10のデジタル通貨交換アプリの最新のランキングがトップ10のデジタル通貨交換アプリを推奨しました

May 12, 2025 pm 08:15 PM

トップ10のデジタル通貨交換アプリの最新のランキングは次のとおりです。1。Okx、2。Binance、3。Huobi、4。Coinbase、5。Kraken、6。Kucoin、7。Bitfinex、8。Gemini、9。Bitstamp、10。Poloniex。これらのアプリを使用するための手順には、アプリのダウンロードとインストール、アカウントの登録、KYC認定の完了、トップアップ、トランザクションの開始などがあります。

2025年のトップ10仮想通貨交換アプリのランキング、デジタル通貨取引アプリのトップ10の最新ランキング

May 12, 2025 pm 08:18 PM

2025年のトップ10仮想通貨交換アプリのランキング、デジタル通貨取引アプリのトップ10の最新ランキング

May 12, 2025 pm 08:18 PM

2025年の上位10の仮想通貨交換アプリは、次のようにランク付けされています。1。Okx、2。Binance、3。Huobi、4。Coinbase、5。Kraken、6。Kucoin、7。Bybit、8。ftx、9。Bitfinex、10。Gate.io。これらの交換は、ユーザーエクスペリエンス、セキュリティ、トランザクションのボリュームなどのディメンションに基づいて選択されます。各プラットフォームは、異なるユーザーのニーズを満たすためのユニークな機能とサービスを提供します。

Huobi APKV10.50.0バージョンインストールチュートリアル

May 12, 2025 pm 08:33 PM

Huobi APKV10.50.0バージョンインストールチュートリアル

May 12, 2025 pm 08:33 PM

Huobi APKV10.50.0ダウンロードガイド:1。記事の直接リンクをクリックします。 2.正しいダウンロードパッケージを選択します。 3。登録情報を入力します。 4. Huobi取引プロセスを開始します。