限られた臨床データに基づいて、何百もの医療アルゴリズムが承認されています。科学者たちは、誰がツールをテストすべきか、そしてどのようにテストするのが最善かについて議論しています。

医療 AI システムをテストしているのは誰ですか?

シン氏が開発しているような AI ベースの医療アプリケーションは、米国 FDA や英国医薬品・ヘルスケア製品規制庁などの医薬品規制当局によって医療機器とみなされることがよくあります。したがって、使用の審査および承認の基準は、一般に医薬品の基準よりも厳しくありません。承認のために臨床試験データを必要とするのは、患者に高いリスクをもたらす可能性のある一部の機器のみです。

多くの人は敷居が低すぎると考えています。ペンシルバニア大学フィラデルフィアの救命救急医であるゲイリー・ワイズマン氏が、自身の分野でFDAが承認したAIデバイスを調査したところ、同氏が特定した10台のデバイスのうち、認可に公表データを引用しているのは3台だけであることが判明した。安全性評価に言及したのは 4 社のみで、ツールの結果がさまざまな患者グループにとって公平かどうかを分析するバイアス評価は含まれていませんでした。 「懸念されるのは、これらの機器がベッドサイドケアに影響を与える可能性があり、実際に影響を及ぼしているということです。

データが不足しているため、病院や医療システムがこれらの技術を使用するかどうかを決定することが困難になっています。」困難な状況にあります。場合によっては、金銭的なインセンティブが作用することもあります。たとえば、米国ではすでに健康保険プランにより特定の医療 AI デバイスの使用に対する病院の払い戻しが行われており、病院は財政的に魅力的となっています。これらの施設は、必ずしも患者ケアを改善しない場合でも、コスト削減を約束する AI ツールを導入する傾向にある可能性があります。

欧陽氏は、こうしたインセンティブがAI企業の臨床試験への投資を妨げる可能性があると述べた。 「多くの営利企業にとって、自社の AI ツールが確実に償還されるよう、さらに努力することは想像できるでしょう」と彼は言いました。

市場によって状況が異なる場合があります。例えば英国では、政府が資金提供する国民医療計画により、医療センターが特定の製品を購入できるようになる前に、より高い証拠基準が設定される可能性があると、人工知能における責任あるイノベーションを研究するバーミンガム大学の臨床研究者シャオシュアン・リウ氏は述べた。臨床試験を実施するインセンティブ。「

病院は AI 製品を購入すると、さらなるテストを行う必要がなく、他のソフトウェアと同様にすぐに使用できます。ただし、一部の政府機関は、規制当局の承認がそのデバイスが実際に有益であることを保証するものではないことを認識しています。そこで彼らは自分たちでテストすることにしました。現在、こうした取り組みの多くは学術医療センターによって実施され、資金提供されていると欧陽氏は述べた。

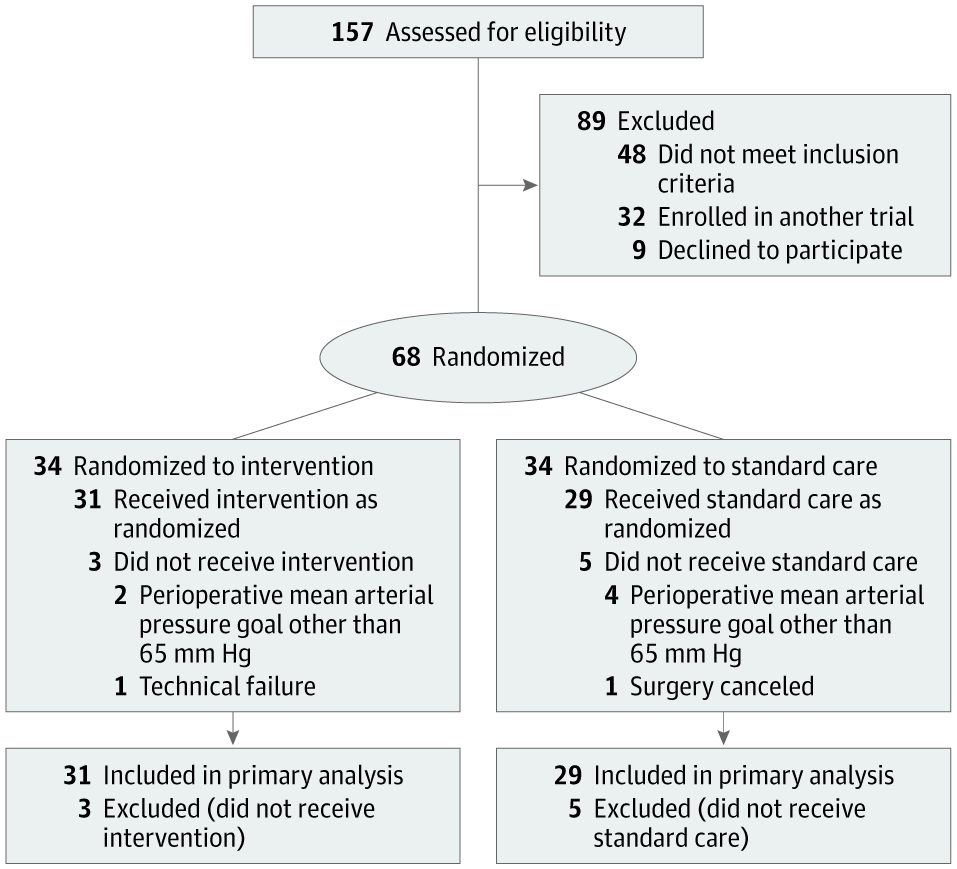

アムステルダム大学医療センターの集中治療部長であるアレクサンダー・ヴラール氏と、同施設の麻酔科医デニス・ヴェーロ氏は、2017年にそのような取り組みを始めた。彼らの目標は、手術中の低血圧の発生を予測するように設計されたアルゴリズムをテストすることでした。術中低血圧として知られるこの状態は、心筋損傷、心臓発作、急性腎不全などの生命を脅かす合併症を引き起こし、場合によっては死に至る可能性があります。

カリフォルニアに本拠を置くエドワーズ ライフサイエンス社が開発したアルゴリズムは、動脈波形データ、つまり救急科や集中治療室のモニターに表示される山と谷を伴う赤い線を使用します。この方法により、低血圧が発生する数分前に予測できるため、早期介入が可能になります。

現在、ほとんどの医療 AI ツールは、医療従事者によるスクリーニング、診断、治療計画の作成に役立ちます。患者は、これらのテクノロジーが自分の治療でテストされたり、日常的に使用されていることに気づいていない可能性があり、現在、医療提供者にこれを開示することを義務付けている国はありません。

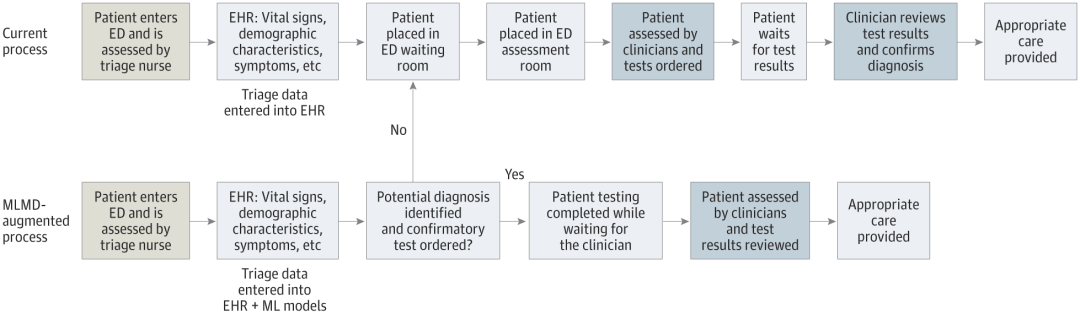

人工知能技術について患者に何を伝えるべきかをめぐって議論が続いています。これらのアプリの中には、開発者にとって患者の同意の問題がクローズアップされているものもあります。これは、SickKids 緊急治療室の子供たちのケアを合理化するためにシン氏のチームが開発中の人工知能デバイスの場合に当てはまります。

このテクノロジーの著しく異なる点は、プロセス全体から臨床医を排除し、子供 (またはその親や保護者) がエンドユーザーになれることです。

「このツールが行うことは、緊急トリアージ データを取得し、予測を立て、子供が検査を受けられるかどうかを親に直接承認 (はいまたはいいえ) することです」とシン氏は語った。これにより、臨床医の負担が軽減され、プロセス全体が高速化されます。しかし、それは同時に多くの前例のない問題をもたらします。患者に何か問題が起こった場合、誰が責任を負いますか?不必要な検査が行われた場合、誰がお金を払うのでしょうか?

「私たちは自動的な方法で家族からインフォームド・コンセントを得る必要があり、その同意は信頼できるものでなければなりません。」とシン氏は言いました。 「これは、ソーシャル メディアにサインアップして 20 ページの細字が書かれていて、ただ承認をクリックするだけのようなものではありません。

シン氏と彼の同僚が患者の治験を開始するための資金を待っている間、チームは法的な協力を行っています。」専門家とその提案を検討し、規制上の影響を検討するために、国の規制当局であるカナダ保健省に関与してもらいます。現在、「規制の状況は西部開拓時代に似ています」とコンピューター科学者であり、シックキッズ児童医療人工知能イニシアチブの共同議長であるアンナ・ゴールデンバーグ氏は言う。

医療機関は AI ツールを慎重に導入し、自律的な検査を実施しています。

コスト要因により、研究者や医療機関は代替手段を模索しています。

大規模な医療機関はそれほど困難はありませんが、小規模な医療機関はより大きな課題に直面しています。

メイヨー クリニックは、地域医療現場で使用する AI ツールをテストしています。

Health AI Alliance は、モデルを評価するための保証ラボを設立しました。

デューク大学は、AI モデルをローカルで検証するための内部テスト機能を提案しています。

放射線科医のニーナ・コトラーは、現地での検証の重要性を強調します。

人工知能とエンドユーザーの精度を確保するには、人的要因に注意を払う必要があります。

参考内容:https://www.nature.com/articles/d41586-024-02675-0

以上が自然の視点: 医療における人工知能のテストは混乱に陥っています。何をすべきでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。