編集 | ScienceAI

最近、上海交通大学、上海 AI 研究所、チャイナモバイルなどの共同研究チームが「医学向け多用途大言語モデルの評価と構築に向けて》では、データ、評価、モデルの複数の観点から臨床医学における大規模言語モデルの適用を包括的に分析し、議論しています。

この記事に含まれるすべてのデータ、コード、モデルはオープンソースです。

概要

近年、医療分野において大規模言語モデル(LLM)は大きな進歩を遂げ、一定の成果をあげています。これらのモデルは、Medical Multiple Choice Question Answering (MCQA) ベンチマークで効率的な機能を実証し、UMLS などの専門試験でエキスパート レベルに達しているか、それを超えています。 しかし、LLM は実際の臨床シナリオでの応用にはまだ程遠いです。主な問題は、ICD コードの解釈、臨床手順の予測、電子医療記録 (EHR) データの解析におけるエラーなど、基本的な医療知識の処理におけるモデルの不十分さに集中しています。

これらの問題は重要な点を示しています。現在の評価ベンチマークは主に医療試験の多肢選択式質問に焦点を当てており、実際の臨床シナリオでの LLM の適用を適切に反映していません。 この研究は、新しい評価ベンチマークである MedS-Bench を提案しています。このベンチマークには、多肢選択式の質問が含まれるだけでなく、臨床レポートの要約、治療の推奨、診断、固有表現の認識などの 11 の高度な臨床タスクもカバーされています。 。 研究チームは、このベンチマークを通じて複数の主流の医療モデルを評価したところ、GPT-4、Claude などの最先端のモデルは、数ショットのプロンプトでも、これらの複雑な臨床業務を処理するのは困難に直面しています。

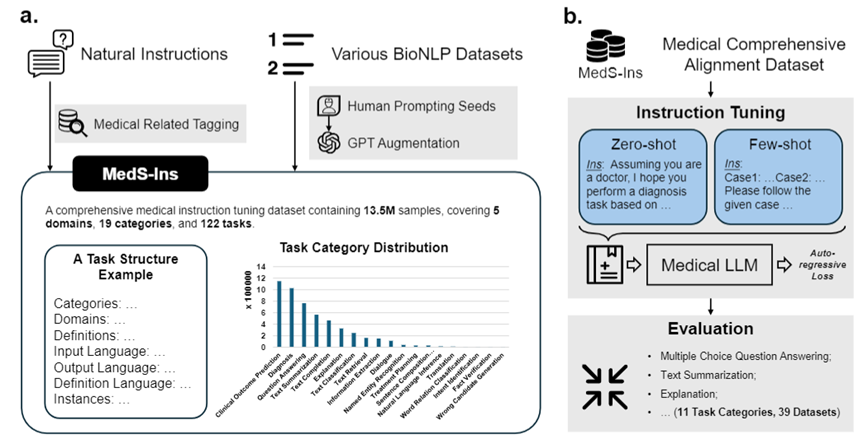

この問題を解決するために、研究チームは Super-NaturalHandling に触発されて、検査、臨床テキスト、学術論文、58 の生物医学テキストからのデータを統合する初の包括的な医療指導微調整データセット MedS-Ins を構築しました。医療知識ベースと日常会話のデータ セットには、122 の臨床タスクをカバーする 1,350 万以上のサンプルが含まれています。 これに基づいて、研究チームはオープンソースの医療言語モデルの指示を調整し、コンテキスト内学習環境におけるモデルの効果を調査しました。 この研究で開発された医療大規模言語モデル MMedIns-Llama 3 は、さまざまな臨床タスクにおいて、GPT-4 や Claude-3.5 などの既存の主要なクローズドソース モデルを上回ります。 MedS-Ins の構築により、実際の臨床シナリオにおける医療大規模言語モデルの機能が大幅に向上し、その適用範囲はオンライン チャットや多肢選択式の質疑応答の制限をはるかに超えています。 私たちは、この進歩が医療言語モデルの開発を促進するだけでなく、将来の臨床現場での人工知能の応用に新たな可能性をもたらすと信じています。テストベンチマークデータセット (MedS-Bench)

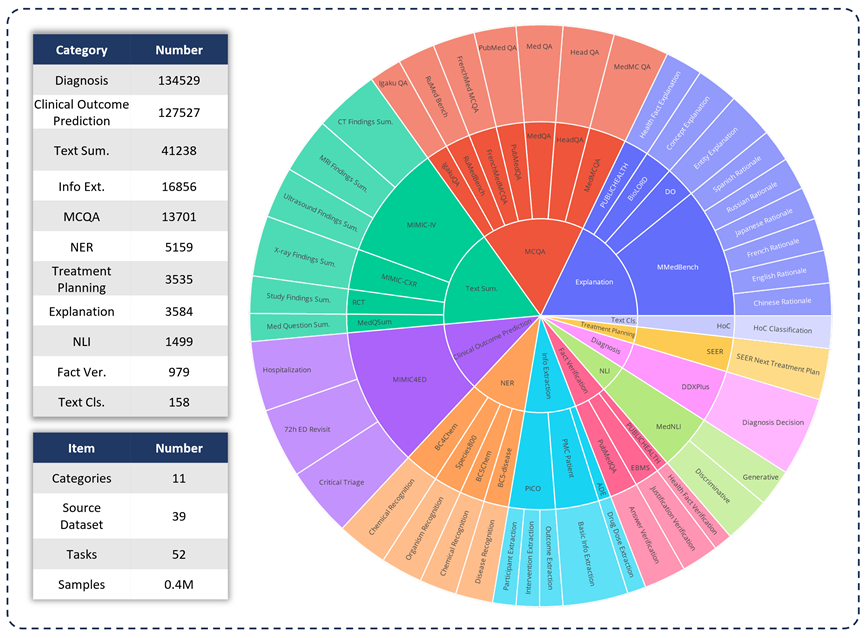

臨床応用におけるさまざまな LLM の機能を評価するために、研究チームは MedS-Bench を開発しました。は、従来の多肢選択式の質問を超えた包括的な医療ベンチマークです。以下の図に示すように、MedS-Bench は 39 の既存のデータセットから派生しており、11 のカテゴリをカバーし、合計 52 のタスクが含まれています。 MedS-Bench では、データは微調整を必要とする構造に再フォーマットされます。さらに、各タスクには手動で注釈が付けられたタスク定義が付属しています。関連する 11 のカテゴリは次のとおりです: 多肢選択式質問応答 (MCQA)、テキスト要約、情報抽出 (情報抽出)、説明と根拠、固有表現認識 (NER)、診断、治療計画、臨床転帰予測、テキスト分類、事実検証、および自然言語推論 (NLI)。

これらのタスク カテゴリの定義に加えて、研究チームは MedS-Bench のテキスト長に関する詳細な統計も実施し、以下の表に示すように、さまざまなタスクを処理するために LLM に必要な機能を識別しました。 LLM 処理タスクに必要な機能は、(i) モデルの内部知識に基づく推論、(ii) 提供されたコンテキストからの事実の取得の 2 つのカテゴリに分類されます。

大まかに言うと、前者には大規模な事前トレーニングからモデルの重みにエンコードされた知識を取得する必要があるタスクが含まれ、後者には要約や情報抽出など、提供されたコンテキストから情報を抽出する必要があるタスクが含まれます。 。表 1 に示すように、モデルがモデルから知識を呼び出すことを必要とするタスクのカテゴリは合計 8 つあり、残りの 3 つのカテゴリのタスクは、特定のコンテキストから事実を取得することを必要とします。

表 1: 使用されたテスト タスクの詳細な統計。

指示微調整データセット (MedS-Ins)

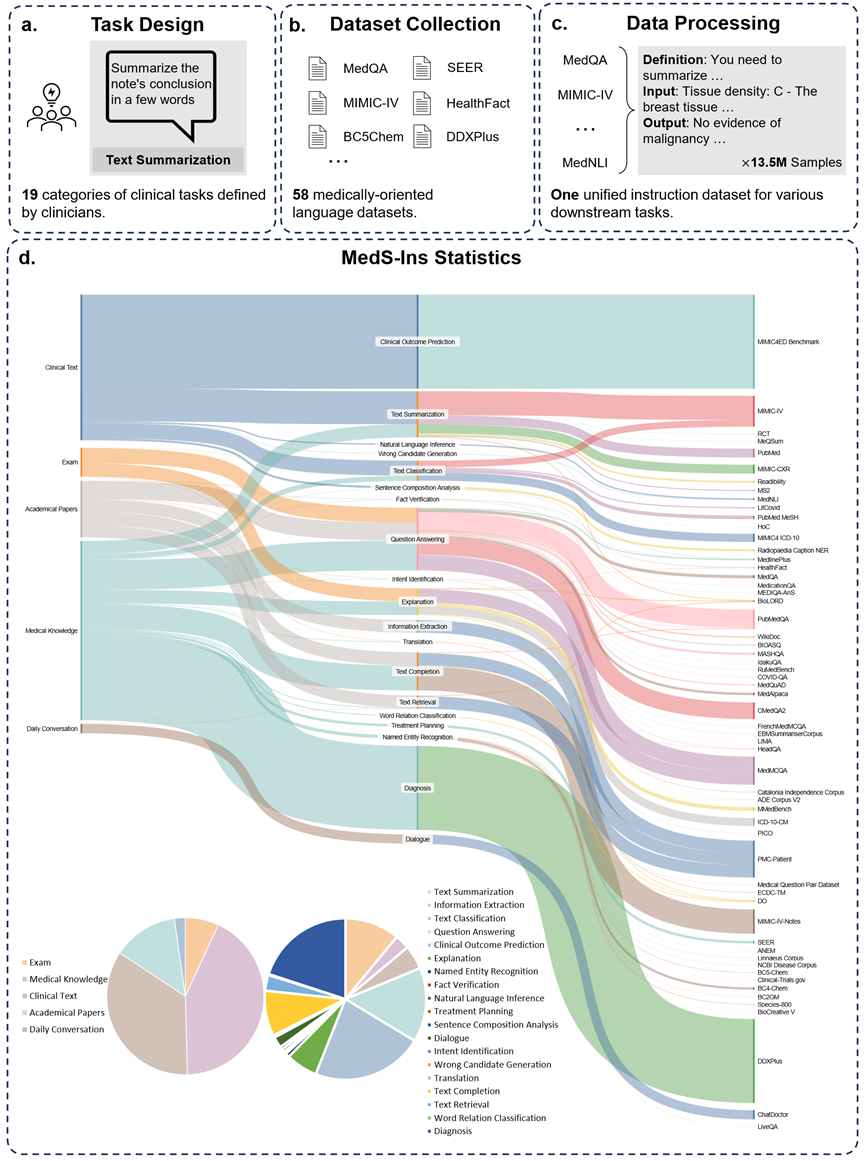

さらに、研究チームはデータセット MedS-Ins の微調整命令もオープンソース化しました。このデータセットは、5 つの異なるテキスト ソースと 19 のタスク カテゴリ、合計 122 の異なる臨床タスクをカバーしています。以下の図は、MedS-Ins の構築プロセスと統計情報をまとめたものです。

テキストソース

この論文で提案されている指示微調整データセットは、検査、臨床テキスト、学術論文、医学知識ベース、そして日常会話。

検査: このカテゴリには、さまざまな国の健康診断の問題のデータが含まれています。基礎的な医学知識から複雑な臨床手順まで、幅広い医学知識をカバーします。試験問題は医学教育のレベルを理解し評価する重要な手段ですが、試験の高度な標準化により、実際の臨床課題と比較してケースが過度に単純化されることが多いことに注意してください。データセット内のデータの 7% は試験からのものです。

臨床テキスト: このカテゴリのテキストは、病院や臨床センターでの診断、治療、予防のプロセスを含む日常的な臨床実践で作成されます。このようなテキストには、電子健康記録 (EHR)、放射線医学レポート、検査結果、フォローアップの指示、投薬の推奨事項などが含まれます。これらのテキストは疾患の診断と患者管理に不可欠であるため、LLM を効果的に臨床に応用するには正確な分析と理解が不可欠です。データセット内のデータの 35% は臨床テキストからのものです。

学術論文: このカテゴリのデータは医学研究論文からのものであり、医学研究分野における最新の発見と発展をカバーしています。アクセスが容易で構造化されているため、学術論文からのデータの抽出は比較的簡単です。これらのデータは、モデルが最先端の医学研究情報を習得し、現代医学の発展をより深く理解できるようにモデルを導くのに役立ちます。データセット内のデータの 13% は学術論文からのものです。

医学知識ベース: このカテゴリのデータは、医学百科事典、ナレッジ グラフ、医学用語集など、よく整理された包括的な医学知識で構成されています。これらのデータは医学知識ベースの中核を形成し、医学教育と臨床現場での LLM の応用をサポートします。データセット内のデータの 43% は医学知識から得られています。

日常会話: このカテゴリのデータは、主にオンライン プラットフォームやその他の対話型シナリオからの、医師と患者の間の日常的な相談を指します。これらのデータは医療スタッフと患者の間の実際のやりとりを反映しており、患者のニーズを理解し、医療サービス全体のエクスペリエンスを向上させる上で重要な役割を果たします。データセット内のデータの 2% は日常会話から得られます。

タスクの種類

テキストに含まれる分野の分類に加えて、研究チームは MedS-Ins のサンプルのタスク カテゴリをさらに細分化しました。19 のタスク カテゴリが特定され、各カテゴリは医療大規模言語モデルが持つべき重要な機能を表しています。 。データセットを微調整し、それに応じてモデルを微調整するこの命令を構築することにより、図 2 に示すように、大規模言語モデルは医療アプリケーションを処理するために必要な機能を備えます。

MedS-Ins の 19 のタスク カテゴリには、MedS-Bench ベンチマークの 11 のカテゴリが含まれますが、これらに限定されません。追加のタスク カテゴリは、意図認識、翻訳、単語関係分類、テキスト検索、文構成要素分析、誤り候補生成、対話およびテキスト補完など、医療分野で必要なさまざまな言語および分析タスクをカバーします。一方、MCQA は一般的な Q&A 用です。一般的な Q&A や会話からさまざまな下流の臨床タスクまで、タスク カテゴリの多様性により、医療アプリケーションの包括的な理解を確実にします。

定量的比較

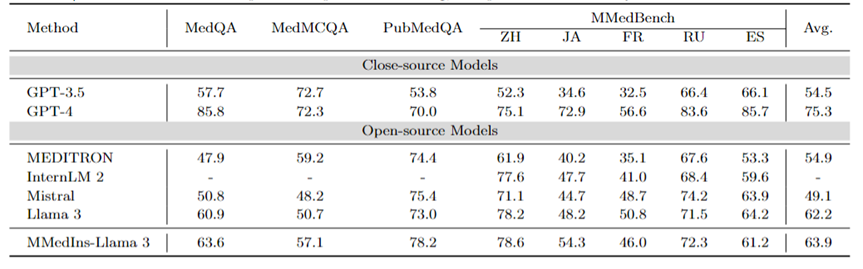

研究チームは、6 つの既存の主流モデル (MEDITRON、Mistral、InternLM 2、Llama 3、GPT-4、および Claude-3.5) のパフォーマンスを広範囲にテストしました。各タスク タイプについて、さまざまな既存の LLM のパフォーマンスが最初に議論され、次に提案された最終モデルである MMedIns-Llama 3 と比較されます。この記事では、すべての結果は 3 ショット プロンプトを使用して取得されています。ただし、以前の研究と一致するように、MCQA タスクではゼロショット プロンプトが使用されます。 GPT-4 や Claude 3.5 などのクローズドソース モデルには費用がかかり、コストによって制限されるため、実験ではタスクごとに 50 ~ 100 のテスト ケースのみがサンプリングされました。包括的なテストの定量化結果は表 2-8 に示されています。

多言語 MCQA: 表 2 に、広く使用されている MCQA ベンチマークの「精度」の評価結果を示します。これらの多肢選択式質問回答データセットでは、既存の大規模言語モデルは非常に高い精度を示しています。たとえば、MedQA では、GPT-4 は人間の専門家とほぼ同等の 85.8 点に達し、Llama 3 も試験に合格できます。スコアは60.9。同様に、英語以外の言語でも、LLM は MMedBench の複数選択の精度において優れた結果を示しています。

結果は、多肢選択式の質問は既存の研究で広く考慮されているため、さまざまな LLM がそのようなタスクに特化して最適化されており、結果としてパフォーマンスが向上している可能性があることを示しています。したがって、LLM の臨床応用をさらに促進するには、より包括的なベンチマークを確立する必要があります。

表 2: 多肢選択式質問の定量的結果は、選択精度 ACC によって測定されます。

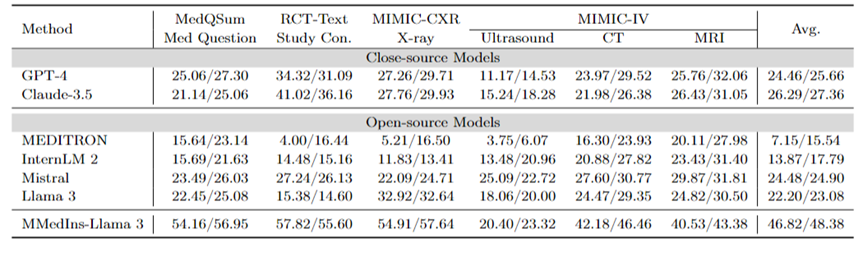

テキスト要約: 表 3 は、テキスト要約タスクにおけるさまざまな言語モデルのパフォーマンスを「BLEU/ROUGE」スコアの形式で報告します。検査は、X 線、CT、MRI、超音波、その他の医療問題など、さまざまな種類のレポートを対象としています。実験結果は、GPT-4 や Claude-3.5 などのクローズドソースの大規模言語モデルが、すべてのオープンソースの大規模言語モデルよりも優れたパフォーマンスを発揮することを示しています。

オープンソース モデルの中で、Mistral が最高の結果を示し、BLEU/ROUGE がそれぞれ 24.48/24.90 で、次に Llama 3 が 22.20/23.08 でした。

この記事で提案されている MMedIns-Llama 3 は、特定の医療教育データセット (MedS-Ins) でトレーニングされており、そのパフォーマンスは、高度なクローズドソース モデル GPT-4 や GPT-4 などの他のモデルよりも大幅に優れています。クロード - 3.5、平均スコア 46.82/48.38。

表 3: テキスト要約タスクの定量的結果。

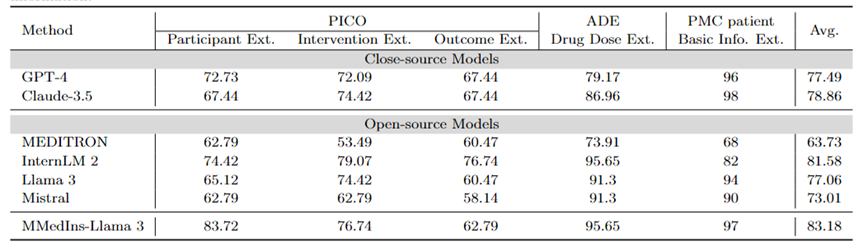

情報抽出: 表 4 は、「精度」によるさまざまなモデルの情報抽出のパフォーマンスを示しています。 InternLM 2 は、平均スコア 81.58 でこのタスクで良好なパフォーマンスを示し、GPT-4 や Claude-3.5 などのクローズドソース モデルは、平均スコアがそれぞれ 77.49 と 78.86 で他のすべてのオープンソース モデルを上回りました。

個々のタスクの結果を分析すると、ほとんどの大規模な言語モデルは、特殊な医療データと比較して、基本的な患者情報などのそれほど複雑ではない医療情報を抽出する際に優れたパフォーマンスを発揮することがわかります。たとえば、PMC 患者から基本情報を抽出する場合、ほとんどの大規模言語モデルは 90 ポイントを超えるスコアを獲得し、Claude-3.5 は 98.02 ポイントの最高スコアを達成しました。対照的に、PICO における臨床転帰抽出タスクのパフォーマンスは比較的低かった。この記事で提案されているモデル MMedIns-Llama 3 は、全体的なパフォーマンスが最も高く、平均スコアは 83.18 で、InternLM 2 モデルを 1.6 ポイント上回っています。

表 4: 情報抽出タスクの定量的結果 各指標は精度 (ACC) によって測定されます。 「Ext.」は抽出を意味し、「Info.」は情報を意味します。

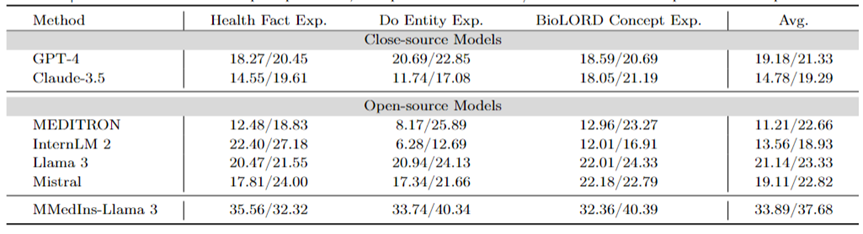

医療概念の説明: 表 5 は、「BLEU/ROUGE」スコア、GPT-4 の形式でのさまざまなモデルの医療概念の説明能力を示しています。 、ラマ 3 とミストラルはこのタスクで優れたパフォーマンスを発揮します。

対照的に、Claude-3.5、InternLM 2、MEDITRON のスコアは比較的低いです。 MEDITRON のパフォーマンスが比較的低いのは、そのトレーニング コーパスが学術論文やガイドラインに重点を置いているため、医学的概念を説明する能力が欠けていることが原因である可能性があります。

最終モデル MMedIns-Llama 3 は、すべての概念説明タスクにおいて他のモデルよりも大幅に優れたパフォーマンスを発揮します。

表 5: 医学概念の説明に関する定量的結果、各指標は BLEU-1/ROUGE-1 によって測定されます。

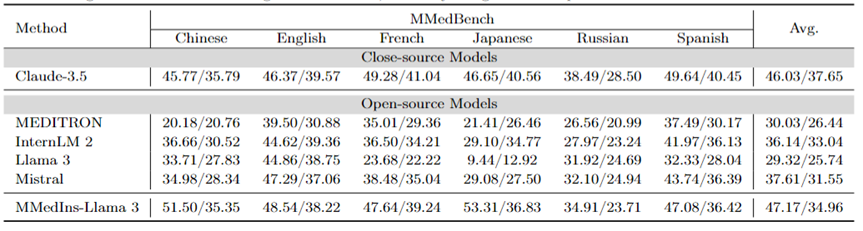

アトリビューション分析 (根拠): 表 6 は、アトリビューション分析タスクにおける各モデルのパフォーマンスを「BLEU/ROUGE」スコアの形式で評価します。 MMedBench データセットを使用して、6 つの言語におけるさまざまなモデルのパフォーマンス、推論機能を比較しました。

テストされたモデルの中で、クローズドソース モデルの Claude-3.5 が最も強力なパフォーマンスを示し、平均スコアは 46.03/37.65 でした。この優れたパフォーマンスは、多くの汎用 LLM で特に強化されている COT の生成とタスクの類似性によるものと考えられます。

オープンソース モデルの中で、Mistral と InternLM 2 は同等のパフォーマンスを示し、平均スコアはそれぞれ 37.61/31.55 と 30.03/26.44 でした。特に、MMedBench データセットのアトリビューション分析部分では主に GPT-4 を使用してビルドを生成するため、GPT-4 がこの評価から除外されました。これにより、テストのバイアスが生じ、不公平な比較につながる可能性があります。

概念説明タスクのパフォーマンスと一致して、最終モデル MMedIns-Llama 3 も全体として最高のパフォーマンスを示し、すべての言語の平均スコアは 47.17/34.96 でした。この優れたパフォーマンスは、選択された基本言語モデル (MMed-Llama 3) が元々複数の言語用に開発されたという事実によるものと考えられます。したがって、命令チューニングが明示的に多言語データをターゲットにしていない場合でも、最終モデルは依然として複数言語の他のモデルよりも優れたパフォーマンスを発揮します。

表 6: アトリビューション分析の定量的結果 (根拠)。各指標は BLEU-1/ROUGE-1 によって測定されます。元のデータは GPT-4 の生成結果に基づいて構築されており、公平性バイアスがあるため、GPT-4 は比較されません。

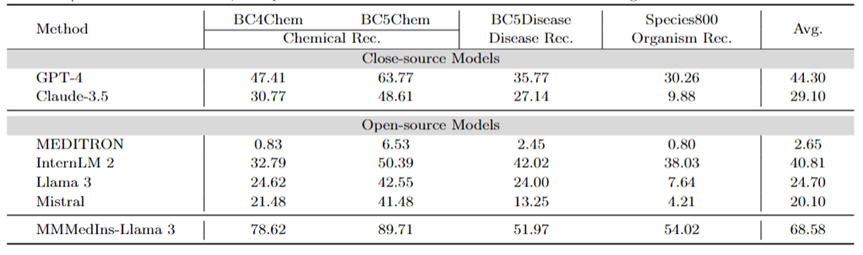

医療エンティティ抽出 (NER): 表 7 は、NER タスクの既存の 6 つのモデルを「F1」スコア パフォーマンスの形式でテストします。 GPT-4 は、すべての固有表現認識 (NER) タスクにわたって良好なパフォーマンスを発揮する唯一のモデルであり、平均 F1 スコアは 44.30 です。

BC5Chem 化学物質認識タスクで特に優れたパフォーマンスを示し、スコアは 63.77 でした。 InternLM 2 は平均 F1 スコア 40.81 でそれに続き、BC5Chem タスクと BC5Disease タスクの両方で良好なパフォーマンスを示しました。ラマ 3 とミストラルの平均 F1 スコアはそれぞれ 24.70 と 20.10 で、平均的なパフォーマンスです。 MEDITRON は NER タスク用に最適化されていないため、この分野ではパフォーマンスが低くなります。 MMedIns-Llama 3 は他のすべてのモデルよりも大幅に優れたパフォーマンスを示し、平均 F1 スコアは 68.58 でした。

表 7: NER タスクの定量的結果。各指標は F1 スコアによって測定されます。「Rec.」は「認識」を表します。

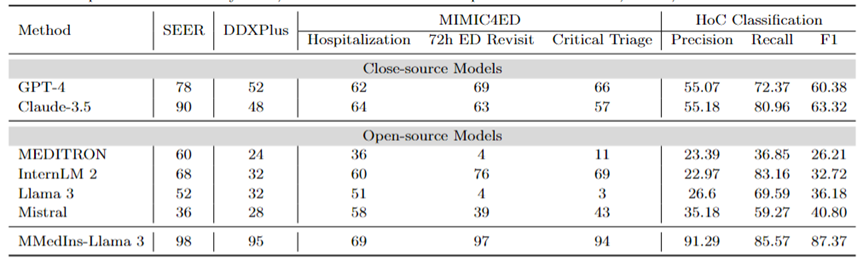

診断、治療推奨、および臨床転帰予測: 表 8 診断ベンチマークとして DDXPlus データセット、治療推奨ベンチマークとして SEER データセット、および臨床転帰予測タスク ベンチマークとして MIMIC4ED データを使用した診断、治療推奨、および臨床転帰の評価表 8 に示すように、3 つの主要なタスクのモデルのパフォーマンスが予測され、結果が精度によって測定されます。

ここでは、これらのデータセットのそれぞれが元の問題を閉集合上の選択問題に還元するため、精度メトリクスを使用して生成された予測を評価できます。具体的には、DDXPlus は事前定義された疾患のリストを使用し、モデルは提供された患者の背景に基づいて疾患を選択する必要があります。 SEER では、推奨される治療法は 8 つの高レベルのカテゴリに分類されますが、MIMIC4ED では、最終的な臨床転帰の決定は常に 2 値 (True または False) で行われます。

全体的に、オープン ソース LLM は、これらのタスクに関してクローズ ソース LLM よりもパフォーマンスが悪く、場合によっては意味のある予測を提供できないこともあります。たとえば、Llama 3 は重大なトリアージの予測においてパフォーマンスが悪くなります。 DDXPlus 診断タスクでは、InternLM 2 と Llama 3 のパフォーマンスがわずかに向上し、精度は 32 でした。ただし、GPT-4 や Claude-3.5 などのクローズドソース モデルは、大幅に優れたパフォーマンスを示します。たとえば、Claude-3.5 は SEER で 90 の精度を達成できますが、GPT-4 は DDXPlus でより高い診断精度を持ち、スコアは 52 であり、オープン ソースとクローズド ソースの LLM の間に大きなギャップがあることが強調されています。

これらの結果にもかかわらず、これらのスコアは臨床使用に十分な信頼性がまだありません。対照的に、MMedIns-Llama 3 は、SEER で 98、DDXPlus で 95 など、臨床意思決定支援タスクで優れた精度を示し、臨床転帰予測タスク (入院、救急外来再診の 72 時間平均、重要トリアージ スコア) で平均精度 86.67 を示しました。 )。

テキスト分類: 表 8 には、HoC マルチラベル分類タスクの評価も示されており、マクロ精度、マクロ再現率、およびマクロ F1 スコアが報告されています。このタイプのタスクでは、すべての候補ラベルがリストの形式で言語モデルに入力され、モデルは対応する回答を選択するよう求められます (複数の選択肢が許可されています)。次に、モデルの最終選択出力に基づいて精度メトリクスが計算されます。

GPT-4 と Claude-3.5 はこのタスクで優れたパフォーマンスを示し、GPT-4 の Macro-F1 スコアは 60.38 で、Claude-3.5 はさらに優れており、63.32 を達成しています。どちらのモデルも強力なリコール能力を示しており、特に Claude-3.5 のマクロリコールは 80.96 です。 Mistral は、Macro-F1 スコア 40.8 で中程度のパフォーマンスを示し、精度と再現率のバランスをとりました。

対照的に、Llama 3 と InternLM 2 の全体的なパフォーマンスは低く、Macro-F1 スコアはそれぞれ 36.18 と 32.72 です。これらのモデル (特に InternLM 2) は高い再現率を示しますが、精度が低いため、Macro-F1 スコアが低くなります。

MEDITRON は、マクロ F1 スコア 26.21 で、このタスクでは最下位にランクされています。 MMedIns-Llama 3 は他のすべてのモデルを大幅に上回り、マクロ精度 91.29、マクロ再現率 85.57、マクロ F1 スコア 87.37 というすべての指標で最高のスコアを達成しました。これらの結果は、テキストを正確に分類する MMedIns-Llama 3 の機能を強調しており、MMedIns-Llama 3 がこのタイプの複雑なタスクにとって最も効果的なモデルとなっています。

表 8: 4 つのカテゴリのタスクの結果: 治療計画 (SEER)、診断 (DDXPlus)、臨床転帰予測 (MIMIC4ED)、およびテキスト分類 (HoC 分類)。最初の 3 つのタスクの結果は精度に基づいており、テキスト分類の結果は適合率、再現率、および F1 スコアに基づいています。

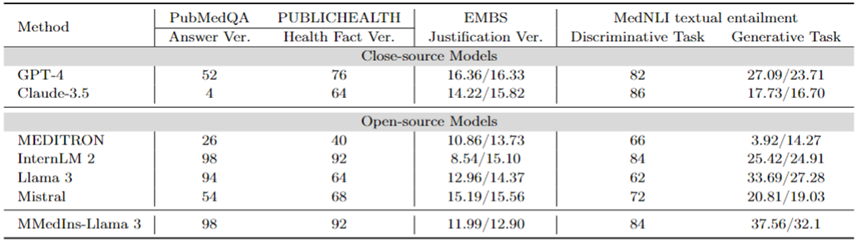

事実修正: 表 9 は、事実検証タスクのモデル評価結果を示しています。 PubMedQA 回答検証と HealthFact 検証では、LLM は提供された候補リストから回答を選択する必要があるため、精度が評価指標として使用されます。

対照的に、EBMS 位置揃え検証により、タスクには、BLEU-1 および ROUGE-1 スコアを使用してパフォーマンスを評価する自由形式のテキストの生成が含まれます。 InternLM 2 は、PubMedQA 回答検証と HealthFact 検証で最高の精度を達成し、それぞれ 98 と 92 のスコアを獲得しました。

EBMS ベンチマークでは、GPT-4 が最も強力なパフォーマンスを示し、BLEU-1/ROUGE-1 スコアはそれぞれ 16.36/16.33 でした。 Claude-3.5 は 14.22/15.82 のスコアで僅差で 2 番目ですが、PubMedQA の回答検証ではパフォーマンスが悪くなります。

Llama 3 の PubMedQA と HealthFact Verification の精度はそれぞれ 94 と 64、BLEU-1/ROUGE-1 スコアは 12.96/14.37 です。 MMedIns-Llama 3 は引き続き既存のモデルを上回っており、PubMedQA 回答検証タスクで InternLM 2 と並んで最高の精度スコアを達成しています。一方、EMBS では、MMedIns-Llama 3 は BLEU-1 および ROUGE-1 で 11.99/12.90 を達成しています。その結果は次のとおりです。 GPT-4よりわずかに遅れています。

医用テキスト含意 (NLI): 表 9 には、主に MedNLI を中心とした医用テキスト含意 (NLI) の評価結果も示します。テスト方法は 2 つあり、1 つは精度によって測定される識別タスク (候補リストから正しい答えを選択する) で、もう 1 つは BLEU/ROUGE メトリクスによって測定される生成タスク (自由形式のテキストの回答を生成する) です。

InternLM 2 は、オープンソース LLM の中で最高のスコア 84 を持っています。クローズドソース LLM の場合、GPT-4 と Claude-3.5 は両方とも、精度がそれぞれ 82 と 86 という比較的高いスコアを示しています。生成タスクでは、Llama 3 がグラウンド トゥルースとの一貫性が最も高く、BLEU および ROUGE スコアは 33.69/27.28 でした。ミストラルとラマ 3 は平均的なレベルでパフォーマンスを発揮しました。 GPT-4 は 27.09/23.71 のスコアで僅差で続きますが、Claude-3.5 は生成タスクで十分なパフォーマンスを発揮しません。

MMedIns-Llama 3 は、スコア 84 で識別タスクの精度が最も高くなりますが、Claude-3.5 にはわずかに遅れます。 MMedIns-Llama 3 は生成タスクでも良好なパフォーマンスを示し、BLEU/ROUGE スコアは 37.56/32.17 で、他のモデルよりも大幅に優れています。

表 9: 事実検証およびテキスト含意タスクの定量的結果 結果は、精度 (ACC) および BLEU/ROUGE によって測定されます。表中の「Ver.」は「検証」の略です。

一般に、研究チームはさまざまなタスクの側面で 6 つの主流モデルを評価しましたが、その研究結果は、現在の主流の LLM が臨床タスクを扱う場合には依然として非常に脆弱であることを示しています。多様で複雑な臨床シナリオにおいて深刻なパフォーマンスの欠陥を引き起こす可能性があります。

同時に、実験結果は、指示データセットに臨床タスクテキストを追加してLLMと実際の臨床応用との一致を強化することで、LLMのパフォーマンスを大幅に向上できることも示しています。

データ収集方法と学習プロセス

このセクションでは、図 3b に示すトレーニング プロセスを詳しく紹介します。具体的な方法は、以前の研究である MMedLM および PMC-LLaMA と同じであり、どちらも医療関連コーパスに対するさらなる自己回帰トレーニングを通じて、対応する医療知識をモデルに注入することができ、それにより、さまざまな下流タスクでのパフォーマンスを向上させることができます。

具体的には、研究チームは多言語 LLM ベース モデル (MMed-Llama 3) から開始し、MedS-Ins からの指導微調整データを使用してさらにトレーニングしました。

命令微調整用のデータには主に 2 つの側面が含まれます:

医学的にフィルタリングされた自然な命令データ: まず、スーパーナチュラル命令から。自然界 医療関連のタスクを除外します。 Super-NaturalInstructions は一般分野のさまざまな自然言語処理タスクに重点を置いているため、医療分野の分類粒度は比較的粗くなっています。

まず、「ヘルスケア」と「医療」カテゴリのすべての指示が抽出され、タスク カテゴリは変更されないまま、より詳細なドメイン ラベルが手動で追加されました。さらに、多くの一般的なドメイン構成の指示微調整データセットは、LIMA や ShareGPT などの一部の医療関連データもカバーしています。

これらのデータの医療部分を除外するために、研究チームは InsTag を使用して各指示の領域の大まかな分類を実行しました。具体的には、InsTag は、さまざまな命令サンプルにタグを付けるために設計された LLM です。指示クエリが与えられると、その指示がどのドメインとタスクに属しているかを分析し、これに基づいてヘルスケア、医療、または生物医学のラベルが付けられたサンプルをフィルタリングします。

最後に、一般ドメインで設定された命令データをフィルタリングすることにより、37 個のタスク、合計 75373 個のサンプルが収集されました。

既存の BioNLP データセットを構築するためのヒント: 既存のデータセットの中には、臨床シナリオでのテキスト分析に適した優れたデータセットが多数あります。ただし、ほとんどのデータセットはさまざまな目的で収集されるため、大規模な言語モデルのトレーニングに直接使用することはできません。ただし、これらの既存の医療 NLP タスクは、生成モデルのトレーニングに使用できる形式に変換することで、指導適応に組み込むことができます。

具体的には、研究チームは MIMIC-IV-Note を例に挙げました。 MIMIC-IV-Note は、所見と結論の両方を含む高品質で構造化されたレポートを提供します。所見から結論までの生成は、古典的な臨床文書の要約タスクと考えられています。まず、タスクを定義するためのプロンプトを手動で作成します。たとえば、「超音波画像診断の詳細な結果を踏まえて、その結果をいくつかの単語で要約してください」というもので、指導調整の多様性のニーズを考慮して、研究チームは 5 人の被験者に 3 つの異なる方法を個別に使用するよう依頼しました。特定のタスクについて説明するよう求められます。

これにより、タスクごとに 15 個の自由テキスト プロンプトが作成され、同様のセマンティクスを確保しながらも可能な限り多様な文言と書式が確保されました。次に、Self-Instruct に触発されて、これらの手動で書かれた命令がシード命令として使用され、GPT-4 はそれらに従って命令を書き換えて、より多様な命令を取得するように求められます。

上記のプロセスを通じて、追加の 85 のタスクが統一された自由質問と回答形式にプロンプトされ、フィルター処理されたデータと組み合わせることで、122 のタスクをカバーする合計 1,350 万の高品質のサンプルが取得されました。 MedS-Ins は、指導の微調整を通じて、新しい 8B サイズの医療 LLM をトレーニングしました。その結果、この方法が臨床タスクのパフォーマンスを大幅に向上させることが示されました。

命令の微調整において、研究チームは 2 つの命令形式に焦点を当てました:

ゼロサンプル プロンプト: ここでは、タスクの命令には意味論的なタスクの説明が含まれていますしたがって、モデルは内部モデルの知識に基づいて質問に直接答える必要があります。収集された MedS-In では、各タスクの「定義」内容がゼロポイントの指示入力として当然利用できます。さまざまな異なる医療タスクの定義がカバーされるため、モデルはさまざまなタスクの説明の意味的理解を学習することが期待されます。

いくつかのヒント: ここで、手順には、モデルがコンテキストからタスクのおおよその要件を学習できるようにする少数の例が含まれています。このような指示は、同じタスクのトレーニング セットから他のケースをランダムにサンプリングし、次の単純なテンプレートを使用して整理するだけで取得できます:

Case1: 入力: {CASE1_INPUT}、出力: {CASE1_OUTPUT} ... CaseN: 入力: {CASEN_INPUT}、出力: {CASEN_OUTPUT} {INSTRUCTION} 数ショットのケースから学習してください。出力する必要があるコンテンツを確認してください。 入力: {INPUT}

Discussion

全体として、この論文はいくつかの重要な貢献をしています :

包括的な評価ベンチマーク - MedS-Bench

医療 LLM の開発は、多肢選択質問回答 (MCQA) ベンチマーク テストに大きく依存しています。ただし、この狭い評価枠組みでは、さまざまな複雑な臨床シナリオにおける LLM の真の機能が無視されます。

したがって、この研究では、研究チームは、さまざまな臨床タスクにおけるクローズドソースおよびオープンソースの LLM のパフォーマンスを評価するために設計された包括的なベンチマークである MedS-Bench を導入します。モデル 事前にトレーニングされたコーパスから事実を思い出したり、与えられたコンテキストから推論したりするタスク。

今回の調査結果は、既存の LLM は MCQA ベンチマークでは良好なパフォーマンスを示しているものの、特に治療の推奨や説明などのタスクにおいて、臨床実践と一致させるのに苦労していることを示しています。この発見は、より広範囲の臨床および医療シナリオに適応する医療用大規模言語モデルのさらなる開発の必要性を強調しています。

包括的な指導調整データセット -- MedS-Ins

研究チームは既存の BioNLP データセットからデータを広範囲に取得し、これらのサンプルを統一フォーマットに変換しました。同時に、半自動プロンプト戦略を使用して、新しい医療オーダー調整データセットである MedS-Ins を構築および開発しました。指導の微調整データセットに関するこれまでの研究は、主に日常会話、試験、または学術論文から質問と回答のペアを構築することに焦点を当てており、多くの場合、実際の臨床実践から生成されたテキストは無視されていました。

対照的に、MedS-Ins は、5 つの主要なテキスト領域と 19 のタスク カテゴリを含む、より広範囲の医療テキスト リソースを統合しています。このデータ構成の体系的な分析は、ユーザーが LLM の臨床応用の境界を理解するのに役立ちます。

医療用大規模言語モデル -- MMedIns-Llama 3

モデルに関して、研究チームは MedS-Ins で指示の微調整トレーニングを実行することでそれを証明しました。オープンソースの医療 LLM と臨床ニーズとの調整を大幅に改善できます。

最終モデル MMedIns-Llama 3 は、どちらかというと「概念実証」モデルであることを強調する必要があります。最終モデルは、8B の中程度のパラメーター スケールを使用しています。臨床タスクをサポートし、タスク固有のトレーニングをさらに必要とせずに、ゼロまたは少数の指示プロンプトを通じてさまざまな医療シナリオに柔軟に適応できます。

結果は、特定の臨床タスクの種類において、MMedIns-Llama 3 が GPT-4、Claude-3.5 などの既存の LLM よりも優れていることを示しています。

既存の制限

ここで、研究チームはこの記事の制限と将来の改善の可能性についても強調したいと考えています。

まず第一に、MedS-Bench は現在 11 の臨床タスクのみをカバーしており、すべての臨床シナリオの複雑さを完全にはカバーしていません。さらに、6 つの主流 LLM が評価されましたが、最新の LLM の一部は依然として分析に含まれていませんでした。これらの制限に対処するために、研究チームは、より多くの研究者が医療 LLM の包括的な評価ベンチマークを継続的に拡張および改善することを奨励することを目的として、この記事の公開と同時に Medical LLM Leaderboard をリリースする予定です。評価プロセスにさまざまなテキスト ソースからのより多くのタスク カテゴリを含めることで、医療における LLM の開発と使用の境界についてより深い理解が得られることが期待されます。

第二に、MedS-Ins は現在、幅広い医療業務をカバーしていますが、まだ不完全で、いくつかの実践的な医療シナリオが欠けています。この問題を解決するために、研究チームは収集したすべてのデータとリソースを GitHub 上でオープンソース化しました。私は、より多くの臨床医や研究者が協力して、一般分野の Super-NaturalInstructs と同様に、この指示調整データセットを維持および拡張できることを心から願っています。研究チームは、GitHub ページで詳細なアップロード手順を提供しており、論文の反復更新でデータセットの更新に参加したすべての貢献者に書面で感謝の意を表します。

第三に、研究チームは、より強力な多言語医療 LLM の開発をサポートするために、MedS-Bench と MedS-Ins にさらに多くの言語を追加する予定です。現在、これらのリソースは主に英語中心ですが、MedS-Bench および MedS-Ins にはいくつかの多言語タスクが含まれています。これをより広範囲の言語に拡張することは、医療 AI の最近の進歩がより広範囲でより多様な地域に公平に利益をもたらすことを確実にするために、有望な将来の方向性となるでしょう。

ついに、研究チームはすべてのコード、データ、評価プロセスをオープンソース化しました。この研究により、医療 LLM の開発が、これらの強力な言語モデルを実際の臨床アプリケーションと統合する方法にさらに重点を置くようになることが期待されています。

以上が「オールラウンダー」医療モデルを目指して、上海交通大学チームが大規模なコマンド微調整データ、オープンソース モデル、包括的なベンチマーク テストをリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。