コーヒー買ってきて☕

*メモ:

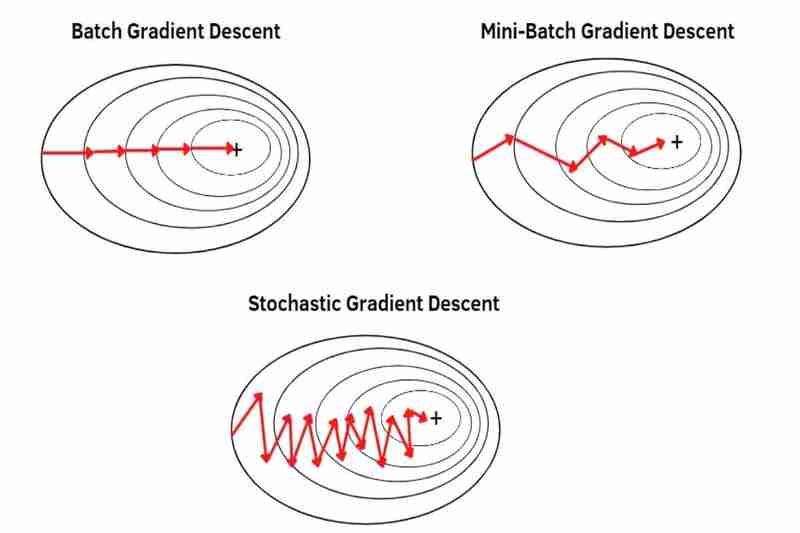

バッチ勾配降下法(BGD)、ミニバッチ勾配降下法(MBGD)、確率的勾配降下法(SGD)があり、これらはデータセットからデータを取得する方法を使用して勾配降下法を実行する方法です。 Adam()、SGD()、RMSprop()、Adadelta()、Adagrad() などのオプティマイザPyTorch.

*メモ:

(1) バッチ勾配降下法(BGD):

(2) ミニバッチ勾配降下法(MBGD):

は、データセット全体から分割された各小さなバッチの平均を使用するため、BDG よりも各サンプルがより目立つ(より強調される)ようになります。 *データセット全体を小さなバッチに分割すると、各サンプルがますます目立つようになります (ますます強調されます)。その結果、BGD よりも収束が安定せず (変動が多く)、BGD よりもノイズ (ノイズの多いデータ) に強くないため、BGD よりもオーバーシュートが発生し、極小値にはまらなかったとしても BGD よりも精度の低いモデルが作成されます。前に述べたように、MBGD は BGD よりも収束が安定していない (変動が大きい) ため、BGD よりも局所最小値または鞍点から脱出しやすく、MBGD は BGD よりも過学習を引き起こしにくいためです。先ほども言いましたが、サンプルはBGDよりも目立ちます(強調されます)。

の長所:

の短所:

(3) 確率的勾配降下法(SGD):

はデータセット全体のすべての単一サンプルを1サンプルずつ使用しますが、平均は使用しないため、MBGDよりも各サンプルがより際立っています(より強調されています)。結果として、MBGD よりも収束が安定せず (変動が多く)、MBGD よりもノイズ (ノイズの多いデータ) に強くないため、MBGD よりもオーバーシュートが発生し、極小値に引っかかっていない場合でも MBGD より精度の低いモデルが作成されます。 SGD は、MBGD よりも局所最小値または鞍点から容易に脱出できます。これは、前に述べたように、収束が MBGD よりも安定していない (変動が大きい) ためであり、SGD は MBGD よりも過学習を引き起こしにくいためです。先ほども言いましたが、サンプルはMBGDよりも目立ちます(強調されます)。

の長所:

の短所:

以上がバッチ、ミニバッチ、確率的勾配降下法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。