Node.js で Web クローラーを構築して、GitHub 上で AI を活用した JavaScript リポジトリを検出する

GitHub は、特に進化し続ける人工知能の世界において、革新的なプロジェクトの宝庫です。しかし、無数のリポジトリをふるいにかけて、AI と JavaScript を組み合わせたリポジトリを見つけますか?それは広大なコードの海から宝石を見つけるようなものです。 Node.js Web クローラーを入力します。これは、検索を自動化し、名前、URL、説明などのリポジトリの詳細を抽出するスクリプトです。

このチュートリアルでは、GitHub を利用するクローラーを構築し、AI と JavaScript で動作するリポジトリを探し出します。コードを詳しく見て、これらの宝石のマイニングを開始しましょう。

パート 1: プロジェクトのセットアップ

Node.js プロジェクトを初期化する

まず、プロジェクト用に新しいディレクトリを作成し、npm で初期化します。

1 2 3 |

|

次に、必要な依存関係をインストールします。

1 |

|

- axios : GitHub への HTTP リクエストを行うため。

- cheerio : jQuery に似た HTML の解析と操作用。

パート 2: GitHub の検索を理解する

GitHub は、URL クエリ経由でアクセスできる強力な検索機能を提供します。たとえば、次のクエリを使用して AI に関連する JavaScript リポジトリを検索できます:

1 |

|

当社のクローラーはこの検索を模倣し、結果を解析し、関連する詳細を抽出します。

パート 3: クローラー スクリプトの作成

プロジェクト ディレクトリにcrawler.jsという名前のファイルを作成し、コーディングを開始します。

ステップ 1: 依存関係をインポートする

1 2 |

|

GitHub の検索結果を取得するために axios を使用し、HTML を解析するために Cherio を使用しています。

ステップ 2: 検索 URL を定義する

1 |

|

この URL は、JavaScript で記述された AI 関連のリポジトリを対象としています。

2,220 無料 リソース 開発者向け!! ❤️ ?? (毎日更新)

1400 の無料 HTML テンプレート

351 の無料ニュース記事

67 個の無料 AI プロンプト

315 の無料コード ライブラリ

Node、Nuxt、Vue などの 52 の無料コード スニペットとボイラープレート!

25 の無料のオープンソース アイコン ライブラリ

dailysandbox.pro にアクセスして、リソースの宝庫に無料でアクセスしてください!

ステップ 3: HTML を取得して解析する

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 |

|

何が起こっているかは次のとおりです:

- HTML の取得 : axios.get メソッドは検索結果ページを取得します。

- Cheerio を使用した解析 : Cheerio を使用して DOM をナビゲートし、.repo-list-item. のようなクラスを持つ要素をターゲットにします。

- 詳細の抽出 : リポジトリごとに、名前、URL、説明を抽出します。

ステップ 4: 結果を表示する

最後に、関数を呼び出して結果をログに記録します。

1 2 3 |

|

パート 4: クローラーの実行

スクリプトを保存し、Node.js で実行します。

1 |

|

AI 関連の JavaScript リポジトリのリストが、それぞれ名前、URL、説明とともにターミナルにきちんと表示されます。

パート 5: クローラーの強化

さらに進化してみませんか?以下にいくつかのアイデアを示します:

- ページネーション : &p=2、&p=3 などで URL を変更することにより、検索結果の複数ページを取得するためのサポートを追加します。

- フィルタリング : スターまたはフォークでリポジトリをフィルタリングし、人気のあるプロジェクトを優先します。

- データの保存 : さらに分析するために結果をファイルまたはデータベースに保存します。

JSON ファイルに保存する例:

1 |

|

自動化の美しさ

このクローラを使用すると、GitHub で関連するリポジトリを見つけるという面倒なタスクを自動化できます。手動でブラウズしたり、延々とクリックしたりする必要はもうありません。スクリプトが難しい作業を実行し、数秒で結果を表示します。

Web 開発に関するその他のヒントについては、DailySandbox をチェックし、無料のニュースレターに登録して時代の先を行きましょう!

以上がNode.js で Web クローラーを構築して、GitHub 上で AI を活用した JavaScript リポジトリを検出するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7326

7326

9

9

1625

1625

14

14

1350

1350

46

46

1262

1262

25

25

1209

1209

29

29

JavaScriptの文字列文字を交換します

Mar 11, 2025 am 12:07 AM

JavaScriptの文字列文字を交換します

Mar 11, 2025 am 12:07 AM

JavaScript文字列置換法とFAQの詳細な説明 この記事では、javaScriptの文字列文字を置き換える2つの方法について説明します:内部JavaScriptコードとWebページの内部HTML。 JavaScriptコード内の文字列を交換します 最も直接的な方法は、置換()メソッドを使用することです。 str = str.replace( "find"、 "置換"); この方法は、最初の一致のみを置き換えます。すべての一致を置き換えるには、正規表現を使用して、グローバルフラグGを追加します。 str = str.replace(/fi

カスタムGoogle検索APIセットアップチュートリアル

Mar 04, 2025 am 01:06 AM

カスタムGoogle検索APIセットアップチュートリアル

Mar 04, 2025 am 01:06 AM

このチュートリアルでは、カスタムGoogle検索APIをブログまたはWebサイトに統合する方法を示し、標準のWordPressテーマ検索関数よりも洗練された検索エクスペリエンスを提供します。 驚くほど簡単です!検索をyに制限することができます

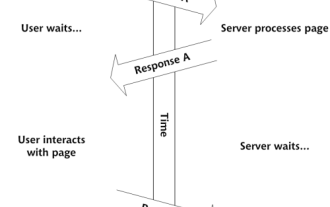

独自のAjax Webアプリケーションを構築します

Mar 09, 2025 am 12:11 AM

独自のAjax Webアプリケーションを構築します

Mar 09, 2025 am 12:11 AM

それで、あなたはここで、Ajaxと呼ばれるこのことについてすべてを学ぶ準備ができています。しかし、それは正確には何ですか? Ajaxという用語は、動的でインタラクティブなWebコンテンツを作成するために使用されるテクノロジーのゆるいグループ化を指します。 Ajaxという用語は、もともとJesse Jによって造られました

例JSONファイルの例

Mar 03, 2025 am 12:35 AM

例JSONファイルの例

Mar 03, 2025 am 12:35 AM

この記事シリーズは、2017年半ばに最新の情報と新鮮な例で書き直されました。 このJSONの例では、JSON形式を使用してファイルに単純な値を保存する方法について説明します。 キー価値ペア表記を使用して、あらゆる種類を保存できます

10 jQuery構文蛍光物

Mar 02, 2025 am 12:32 AM

10 jQuery構文蛍光物

Mar 02, 2025 am 12:32 AM

コードプレゼンテーションを強化する:開発者向けの10個の構文蛍光物 ウェブサイトやブログでコードスニペットを共有することは、開発者にとって一般的な慣行です。 適切な構文ハイライターを選択すると、読みやすさと視覚的な魅力を大幅に改善できます。 t

8見事なjQueryページレイアウトプラグイン

Mar 06, 2025 am 12:48 AM

8見事なjQueryページレイアウトプラグイン

Mar 06, 2025 am 12:48 AM

楽なWebページレイアウトのためにjQueryを活用する:8本質的なプラグイン jQueryは、Webページのレイアウトを大幅に簡素化します。 この記事では、プロセスを合理化する8つの強力なjQueryプラグイン、特に手動のウェブサイトの作成に役立ちます

10 JavaScript&JQuery MVCチュートリアル

Mar 02, 2025 am 01:16 AM

10 JavaScript&JQuery MVCチュートリアル

Mar 02, 2025 am 01:16 AM

この記事では、JavaScriptとJQuery Model-View-Controller(MVC)フレームワークに関する10を超えるチュートリアルの厳選された選択を紹介します。これは、新年にWeb開発スキルを向上させるのに最適です。 これらのチュートリアルは、Foundatioのさまざまなトピックをカバーしています

' this' JavaScriptで?

Mar 04, 2025 am 01:15 AM

' this' JavaScriptで?

Mar 04, 2025 am 01:15 AM

コアポイント これは通常、メソッドを「所有」するオブジェクトを指しますが、関数がどのように呼び出されるかに依存します。 現在のオブジェクトがない場合、これはグローバルオブジェクトを指します。 Webブラウザでは、ウィンドウで表されます。 関数を呼び出すと、これはグローバルオブジェクトを維持しますが、オブジェクトコンストラクターまたはそのメソッドを呼び出すとき、これはオブジェクトのインスタンスを指します。 call()、apply()、bind()などのメソッドを使用して、このコンテキストを変更できます。これらのメソッドは、与えられたこの値とパラメーターを使用して関数を呼び出します。 JavaScriptは優れたプログラミング言語です。数年前、この文はそうでした