# | PDF データ抽出を自動化する: ビルド

概要

PDF データ抽出のビジネス ロジックを動作するコードに変換する Python スクリプトを作成しました。

スクリプトは、10 か月間 (2024 年 1 月から 10 月まで) にわたる保管者声明 PDF の 71 ページ でテストされました。 PDF の処理は完了するまでに約 4 秒かかり、手動で行うよりも大幅に速くなりました。

見たところ、出力は正しいように見え、コードにはエラーは発生していません。

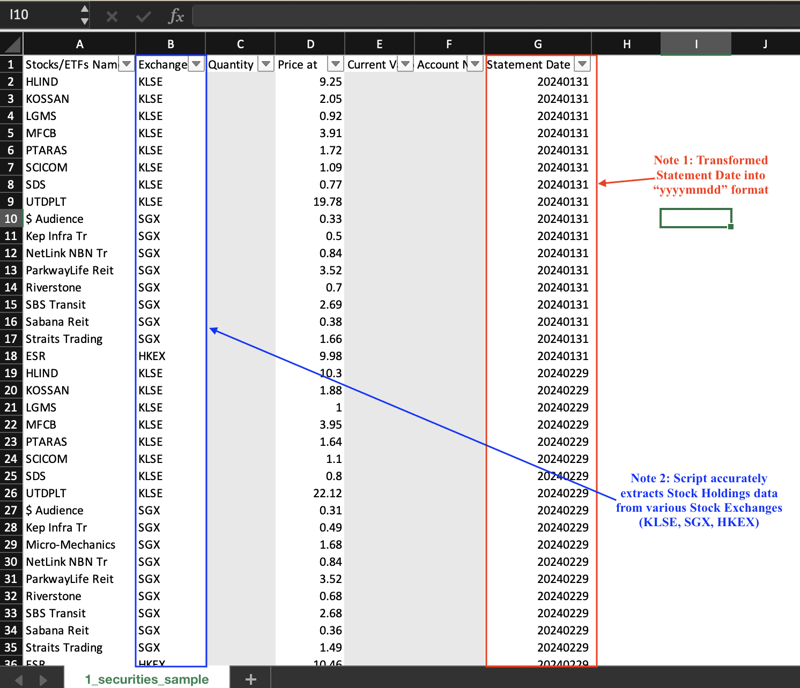

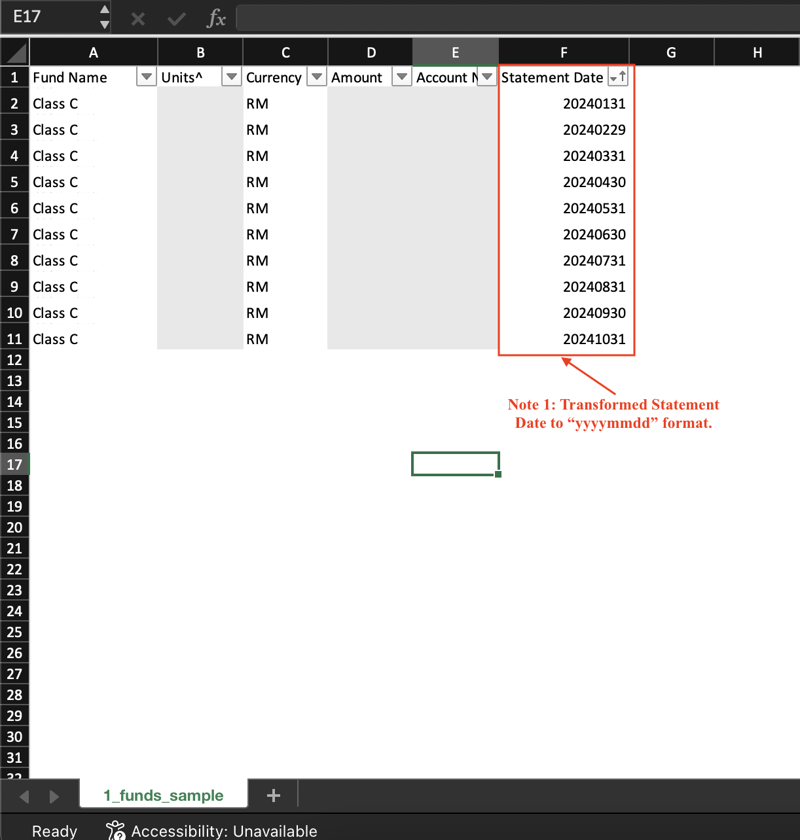

3 つの CSV 出力のスナップショットを以下に示します。機密データはグレー表示されていることに注意してください。

スナップショット 1: 株式保有

スナップショット 2: ファンド保有

スナップショット 3: 現金保有

このワークフローは、CSV ファイルを生成するために行った大まかな手順を示しています。

ここで、ビジネス ロジックを Python のコードに変換する方法を詳しく説明します。

ステップ 1: PDF ドキュメントを読む

pdfplumber の open() 関数を使用しました。

# Open the PDF file with pdfplumber.open(file_path) as pdf:

file_path は、pdfplumber にどのファイルを開くかを指示する宣言された変数です。

ステップ 2.0: 各ページからテーブルを抽出およびフィルタリングする

extract_tables() 関数は、各ページからすべてのテーブルを抽出するという大変な作業を行います。

私は基礎となるロジックには詳しくありませんが、この関数はかなり良い仕事をしたと思います。たとえば、以下の 2 つのスナップショットは、抽出されたテーブルと元の (PDF からの) テーブルを示しています

スナップショット A: VS Code ターミナルからの出力

スナップショット B: PDF の表

その後、後で特定のテーブルからデータを「選択」できるように、各テーブルに一意のラベルを付ける必要がありました。

理想的なオプションは、各テーブルのタイトルを使用することでした。しかし、タイトルの座標を決定することは私の能力を超えていました。

回避策として、最初の 3 つの列のヘッダーを連結して各テーブルを識別しました。たとえば、スナップショット B の 株式保有 テーブルには、Stocks/ETFsnNameExchangeQuantity.

というラベルが付いています。⚠️このアプローチには重大な欠点があります。最初の 3 つのヘッダー名ではすべてのテーブルが一意になるわけではありません。幸いなことに、これは無関係なテーブルにのみ影響します。

ステップ 2.1: 表以外のテキストを抽出、フィルター、変換する

私が必要とした特定の値 (口座番号と明細書日付) は、各 PDF のページ 1 の部分文字列でした。

たとえば、「口座番号 M1234567」には口座番号「M1234567」が含まれます。

私は Python の re ライブラリを使用し、ChatGPT に適切な正規表現 (「regex」) を提案してもらいました。正規表現は各文字列を 2 つのグループに分割し、2 番目のグループに必要なデータを入れます。

明細書日付および口座番号文字列の正規表現

# Open the PDF file with pdfplumber.open(file_path) as pdf:

次に、明細書日付を「yyyymmdd」形式に変換しました。これにより、データのクエリと並べ替えが簡単になります。

regex_date=r'Statement for \b([A-Za-z]{3}-\d{4})\b'

regex_acc_no=r'Account Number ([A-Za-z]\d{7})'

match_date は、正規表現に一致する文字列が見つかったときに宣言される変数です。

ステップ 3: 表形式のデータを作成する

関連するデータポイントの抽出という難しい作業は、この時点でほぼ完了しました。

次に、pandas の DataFrame() 関数を使用して、ステップ 2 と ステップ 3 の出力に基づいて表形式のデータを作成しました。また、この関数を使用して不要な列と行を削除しました。

最終結果は、CSV に簡単に書き込んだり、データベースに保存したりできます。

ステップ 4: データを CSV ファイルに書き込む

Python の write_to_csv() 関数を使用して、各データフレームを CSV ファイルに書き込みました。

if match_date:

# Convert string to a mmm-yyyy date

date_obj=datetime.strptime(match_date.group(1),"%b-%Y")

# Get last day of the month

last_day=calendar.monthrange(date_obj.year,date_obj.month[1]

# Replace day with last day of month

last_day_of_month=date_obj.replace(day=last_day)

statement_date=last_day_of_month.strftime("%Y%m%d")

df_cash_selected は現金保有データフレームであり、file_cash_holdings は現金保有 CSV のファイル名です。

➡️ データベースのノウハウを習得したら、適切なデータベースにデータを書き込みます。

次のステップ

カストディアンステートメント PDF から表とテキストデータを抽出するための作業スクリプトが用意されました。

先に進む前に、いくつかのテストを実行して、スクリプトが期待どおりに動作するかどうかを確認します。

--終了

以上が# | PDF データ抽出を自動化する: ビルドの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1672

1672

14

14

1428

1428

52

52

1332

1332

25

25

1276

1276

29

29

1256

1256

24

24

Python vs. C:曲線と使いやすさの学習

Apr 19, 2025 am 12:20 AM

Python vs. C:曲線と使いやすさの学習

Apr 19, 2025 am 12:20 AM

Pythonは学習と使用が簡単ですが、Cはより強力ですが複雑です。 1。Python構文は簡潔で初心者に適しています。動的なタイピングと自動メモリ管理により、使いやすくなりますが、ランタイムエラーを引き起こす可能性があります。 2.Cは、高性能アプリケーションに適した低レベルの制御と高度な機能を提供しますが、学習しきい値が高く、手動メモリとタイプの安全管理が必要です。

Pythonと時間:勉強時間を最大限に活用する

Apr 14, 2025 am 12:02 AM

Pythonと時間:勉強時間を最大限に活用する

Apr 14, 2025 am 12:02 AM

限られた時間でPythonの学習効率を最大化するには、PythonのDateTime、時間、およびスケジュールモジュールを使用できます。 1. DateTimeモジュールは、学習時間を記録および計画するために使用されます。 2。時間モジュールは、勉強と休息の時間を設定するのに役立ちます。 3.スケジュールモジュールは、毎週の学習タスクを自動的に配置します。

Python vs. C:パフォーマンスと効率の探索

Apr 18, 2025 am 12:20 AM

Python vs. C:パフォーマンスと効率の探索

Apr 18, 2025 am 12:20 AM

Pythonは開発効率でCよりも優れていますが、Cは実行パフォーマンスが高くなっています。 1。Pythonの簡潔な構文とリッチライブラリは、開発効率を向上させます。 2.Cのコンピレーションタイプの特性とハードウェア制御により、実行パフォーマンスが向上します。選択を行うときは、プロジェクトのニーズに基づいて開発速度と実行効率を比較検討する必要があります。

Pythonの学習:2時間の毎日の研究で十分ですか?

Apr 18, 2025 am 12:22 AM

Pythonの学習:2時間の毎日の研究で十分ですか?

Apr 18, 2025 am 12:22 AM

Pythonを1日2時間学ぶだけで十分ですか?それはあなたの目標と学習方法に依存します。 1)明確な学習計画を策定し、2)適切な学習リソースと方法を選択します。3)実践的な実践とレビューとレビューと統合を練習および統合し、統合すると、この期間中にPythonの基本的な知識と高度な機能を徐々に習得できます。

Python vs. C:重要な違いを理解します

Apr 21, 2025 am 12:18 AM

Python vs. C:重要な違いを理解します

Apr 21, 2025 am 12:18 AM

PythonとCにはそれぞれ独自の利点があり、選択はプロジェクトの要件に基づいている必要があります。 1)Pythonは、簡潔な構文と動的タイピングのため、迅速な開発とデータ処理に適しています。 2)Cは、静的なタイピングと手動メモリ管理により、高性能およびシステムプログラミングに適しています。

Python Standard Libraryの一部はどれですか:リストまたは配列はどれですか?

Apr 27, 2025 am 12:03 AM

Python Standard Libraryの一部はどれですか:リストまたは配列はどれですか?

Apr 27, 2025 am 12:03 AM

PythonListSarePartOfThestAndardarenot.liestareBuilting-in、versatile、forStoringCollectionsのpythonlistarepart。

Python:自動化、スクリプト、およびタスク管理

Apr 16, 2025 am 12:14 AM

Python:自動化、スクリプト、およびタスク管理

Apr 16, 2025 am 12:14 AM

Pythonは、自動化、スクリプト、およびタスク管理に優れています。 1)自動化:OSやShutilなどの標準ライブラリを介してファイルバックアップが実現されます。 2)スクリプトの書き込み:Psutilライブラリを使用してシステムリソースを監視します。 3)タスク管理:スケジュールライブラリを使用してタスクをスケジュールします。 Pythonの使いやすさと豊富なライブラリサポートにより、これらの分野で優先ツールになります。

科学コンピューティングのためのPython:詳細な外観

Apr 19, 2025 am 12:15 AM

科学コンピューティングのためのPython:詳細な外観

Apr 19, 2025 am 12:15 AM

科学コンピューティングにおけるPythonのアプリケーションには、データ分析、機械学習、数値シミュレーション、視覚化が含まれます。 1.numpyは、効率的な多次元配列と数学的関数を提供します。 2。ScipyはNumpy機能を拡張し、最適化と線形代数ツールを提供します。 3. Pandasは、データ処理と分析に使用されます。 4.matplotlibは、さまざまなグラフと視覚的な結果を生成するために使用されます。